特征提取学习

通过正交变换将一组可能存在相关性的变量转换为一组线性不相关的变量,转换后的这组变量叫主成分。

PCA思想

-

将n维特征映射到k维上(k<n),这k维是全新的正交特征。 这k维特征称为主成分,是重新构造出来的k维特征,而不是简单地从n维特征中去除其余n-k维特征。

-

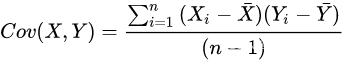

协方差:

协方差为正说明X和Y为正相关关系,为负代表X和Y为负相关关系,为0时代表X和Y独立。协方差绝对值越大,两者对彼此的影响越大,反之越小。

PCA过程

- 特征中心化: 即每一维的数据都减去该维的均值,每一维代表一个特征。

代表每一维的均值。

-

求特征协方差矩阵,如果数据为三维(x,y,z),(有三个特征值)

-

计算协方差矩阵的特征值 (特征向量均归一化为单位向量)

-

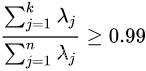

将特征值按照从大到小的顺序排列,选择其中最大的k个,将其对应的k个特征向量分别作为列向量组成特征向量矩阵。其中k的选择标准一般情况下为:

-

将样本点投影到选取的特征向量上。假设样例为m,特征数为n。

这样就将原始样例的n维特征变为了k维,这k维就是原始特征在k维上的投影。

对DryBeans进行预分析

X_digits = x_train

y_digits = y_train

estimator = PCA(n_components=3)

X_pca = estimator.fit_transform(X_digits)

for i in range(len(colors)):

px = X_pca[:, 0][y_digits.as_matrix() == i

默认值为保留所有特征值维度,即不进行主成分降维。取大于等于1的整数时,即指定我们希望降维后的维数。取0-1的浮点数时,即指定降维后的方差和占比,比例越大,保留的信息越多。系统会自行计算保留的维度个数。PCA的优点能够大幅减少特征空间维度,降低了数据复杂度,并且方便模型拟合,大大减少训练时间。PCA的缺点可能会降低模型精度,因为会丢弃一些信息;转换过程复杂,结果难以解释;可能对异常值敏感,后续处理相关数据集再继续完善。httpshttpshttpshttpshttpshttps。...

默认值为保留所有特征值维度,即不进行主成分降维。取大于等于1的整数时,即指定我们希望降维后的维数。取0-1的浮点数时,即指定降维后的方差和占比,比例越大,保留的信息越多。系统会自行计算保留的维度个数。PCA的优点能够大幅减少特征空间维度,降低了数据复杂度,并且方便模型拟合,大大减少训练时间。PCA的缺点可能会降低模型精度,因为会丢弃一些信息;转换过程复杂,结果难以解释;可能对异常值敏感,后续处理相关数据集再继续完善。httpshttpshttpshttpshttpshttps。...

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?