伪分布式:具有分布式的配置,但是其节点只有一个。

准备:

linux服务器一台。(也可是虚拟机)

jdk的tar包一个(本服务采用1.8)。可以在官网下载。

hadoop的tar包一个(本服务采用2.7.3)。可以在官网下载。

配置主机名

vim /etc/sysconfig/network

hadoop101

修改/etc/hosts文件

ip hadoop101

在/opt 下创建module包用来放解压的文件包

在/opt下穿件software包用来放解压的文件包。

查看当前linux是否装有jdk或hadoop

如果有默认的jdk,可以通过rpm -qa | grep java 查看下。

然后用 rpm -e --nodeps 查看的文件名 卸载

解压 jdk和hadoop 到 /opt/moudle下

tar -zxvf 压缩包目录 -C 解压到的目录

配置jdk和hadoop的环境变量

vim /etc/profile

export JAVA_HOME=jdk的解压目录

export PATH=

P

A

T

H

:

PATH:

PATH:JAVA_HOME/bin

export HADOOP_HOME=hadoop的解压目录

export PATH=

P

A

T

H

:

PATH:

PATH:HADOOP_HOME/bin

export PATH=

P

A

T

H

:

PATH:

PATH:HADOOP_HOME/sbin

保存退出

source /etc/profile 让修改生效

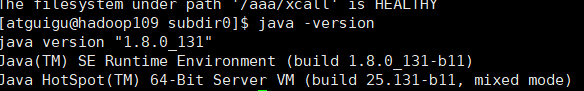

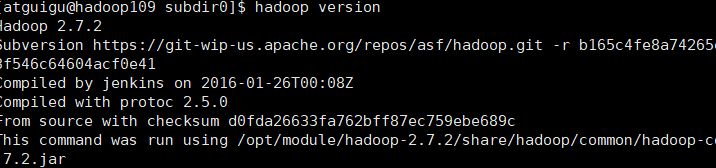

查看配置效果

java -version

hadoop version

下面开始修改hadoop的配置

在hadoop下的etc下的hadoop目录下

hadoop-env.sh 修改JAVA_HOME的路径

export JAVA_HOME=/opt/module/jdk1.7.0_79

修改core-site.xml

fs.defaultFS hdfs://hadoop101:8020 hadoop.tmp.dir /opt/module/hadoop-2.7.2/data/tmp修改hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

修改yarn-env.sh

export JAVA_HOME=/opt/module/jdk1.7.0_79

修改mapred-env.sh

export JAVA_HOME=/opt/module/jdk1.7.0_79

修改mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

配置完成,准备启动

在hadoop目录下

格式化namenode

bin/hdfs namenode -format(第一次启动需要,其它时间启动会把数据也清掉,造成那么node和datanode不匹配)

启动namenode

sbin/hadoop-daemon.sh start namenode

启动datanode

sbin/hadoop-daemon.sh start datanode

查看日志hadoop下的logs

jps查看进程是否有namenode和datanode

web端查看http://ip:50070/dfshealth.html#tab-overview

操作

(a)在hdfs文件系统上创建一个input文件夹

bin/hdfs dfs -mkdir -p /user/atguigu/mapreduce/wordcount/input

(b)将测试文件内容上传到文件系统上

bin/hdfs dfs -put wcinput/wc.input /user/atguigu/mapreduce/wordcount/input/

(c)查看上传的文件是否正确

bin/hdfs dfs -ls /user/atguigu/mapreduce/wordcount/input/

bin/hdfs dfs –cat /user/atguigu/mapreduce/wordcount/input/wc.input

(d)在Hdfs上运行mapreduce程序

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /user/atguigu/mapreduce/wordcount/input/ /user/atguigu/mapreduce/wordcount/output

(e)查看输出结果

命令行查看:bin/hdfs dfs -cat /user/atguigu/mapreduce/wordcount/output/*

浏览器查看

716

716

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?