1.找目标网页

这个网站首页就有一堆图片,而且往下拉时还会自动刷新,很明显是个ajax加载,但不怕,动态加载这东西我们之前讲过了,所以打开开发者工具看下是怎样的请求吧。

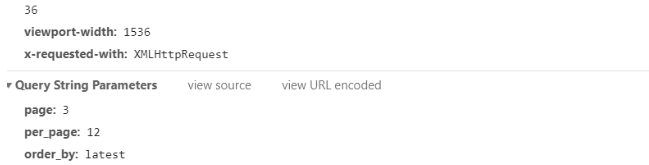

往下拉的时候很容易看到这个请求,这个是一个get请求,状态码为200,网址为

https://unsplash.com/napi/photos?page=3&per_page=12&order_by=latest

有三个参数,很容易知道page参数就是页,这个参数是变化的,其他的参数都是不变的。

返回来的内容是个json类型,里面的links下的download就是我们图片下载的链接,现在所有东西都清楚了,那下面就是代码了。

2.代码部分

async def __get_content(self, link):

async with aiohttp.ClientSession() as session:

response = await session.get(link)

content = await response.read()

return content

这个是获取图片的内容的方法,aiohttpClientSession和requests.session的用法是差不多,只不过获取unicode编码的方法变成了read()。

下面是完整代码

import requests, os, time

import aiohttp, asyncio

'''

更多Python学习资料以及源码教程资料,可以在群1136201545免费获取

'''

class Spider(object):

def __init__(self):

self.headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'}

self.num = 1

if '图片' not in os.listdir('.'):

os.mkdir('图片')

self.path = os.path.join(os.path.abspath('.'), '图片')

os.chdir(self.path) # 进入文件下载路径

async def __get_content(self, link):

async with aiohttp.ClientSession() as session:

response = await session.get(link)

content = await response.read()

return content

def __get_img_links(self, page):

url = 'https://unsplash.com/napi/photos'

data = {

'page': page,

'per_page': 12,

'order_by': 'latest'

}

response = requests.get(url, params=data)

if response.status_code == 200:

return response.json()

else:

print('请求失败,状态码为%s' % response.status_code)

async def __download_img(self, img):

content = await self.__get_content(img[1])

with open(img[0]+'.jpg', 'wb') as f:

f.write(content)

print('下载第%s张图片成功' % self.num)

self.num += 1

def run(self):

start = time.time()

for x in range(1, 101): # 下载一百页的图片就可以了,或者自己更改页数

links = self.__get_img_links(x)

tasks = [asyncio.ensure_future(self.__download_img((link['id'], link['links']['download']))) for link in links]

loop = asyncio.get_event_loop()

loop.run_until_complete(asyncio.wait(tasks))

if self.num >= 10: # 测试速度使用,如需要下载多张图片可以注释这段代码

break

end = time.time()

print('共运行了%s秒' % (end-start))

def main():

spider = Spider()

spider.run()

if __name__ == '__main__':

main()

可以看到不到50行的代码就可以把整个网网站的图片下载下来了,不得不吹一下python的强大~~~

4285

4285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?