前言

在4-19左右,Meta 宣布正式推出下一代开源大语言模型 Llama 3;共包括 80 亿和 700 亿参数两种版本,号称 “是 Llama 2 的重大飞跃”,并为这些规模的 LLM 确立了新的标准。实际上笔者早就体验过,只不过自己电脑没什么显卡(核显),所以一直没跑llama,但是最近听说m2芯片可以运行,就体验了一下。

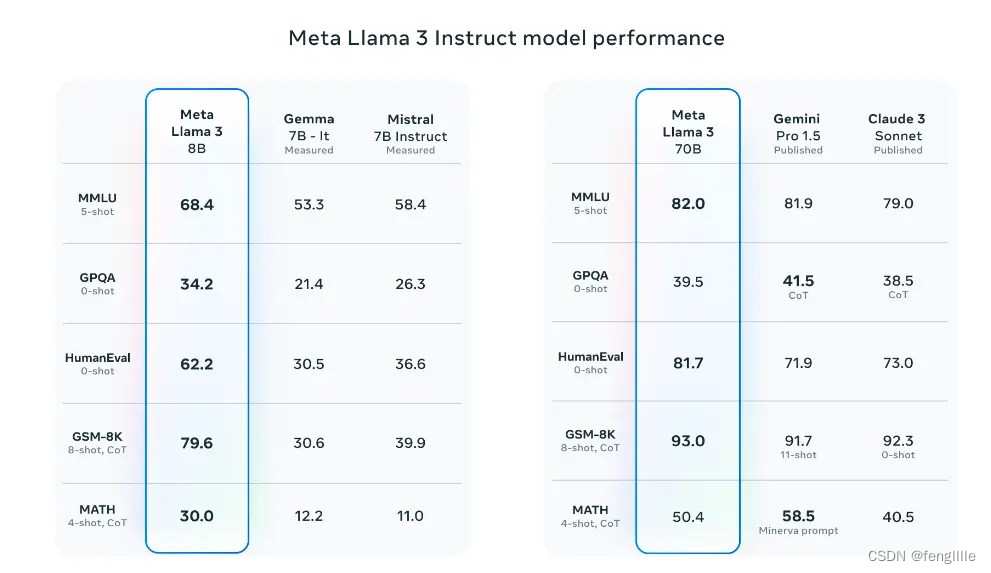

看图表8B的数据可以在本地运行,70B就不用想了。试了一下真的可行。

使用Ollama

ollama:Get up and running with large language models.实际上就是封装已经训练的模型数据,提供运行程序

分为ollama的安装,拉取模型数据,运行模型

安装很简单:Download Ollama on macOS

mac直接解压app,放在applications下,运行后点击install,输入密码即可,实际上是安装ollama指令。

模型文件:https://ollama.com/library

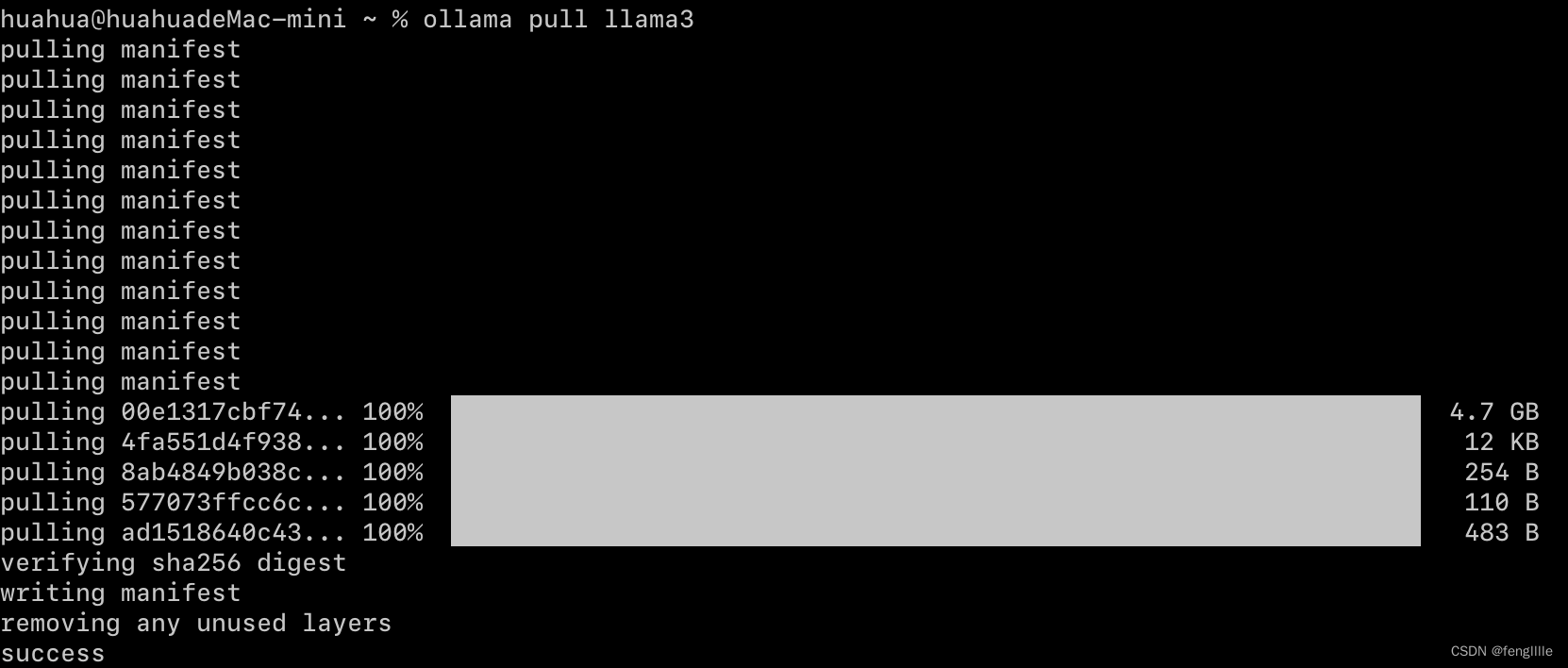

ollama pull llama3

根据电脑的配置情况,默认llama即8B模型,如果要运行70B:ollama run llama3:70b,估计需要64G内存,没这么大的,所以只跑了8B

然后执行run,有点docker的设计思想

ollama run llama3

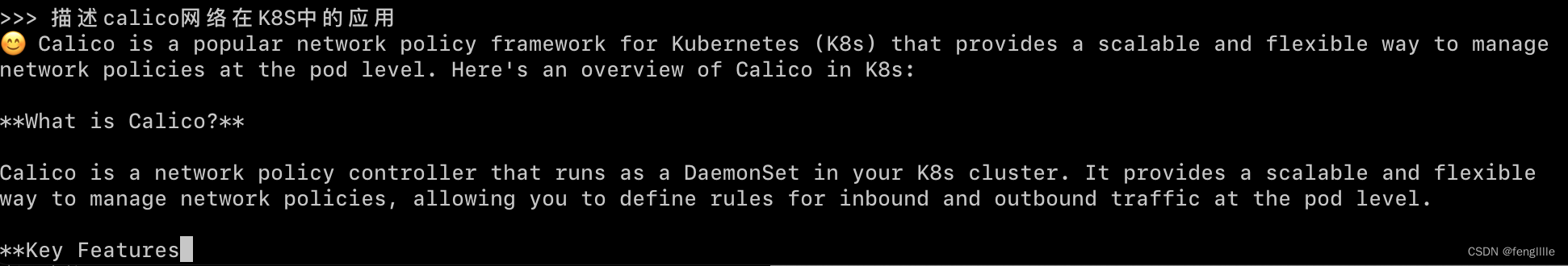

基本上问答是英文,训练的语料估计主要是国外的,毕竟meta开源

总结

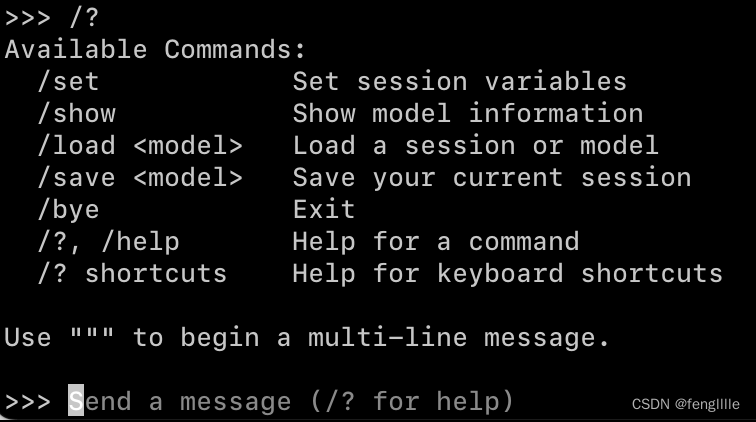

实际上就是本地体验一下,如果要调模型还是相对难一些,体验发现llama3主要是英文答复,不过8B模型在mac mini运行还是很快的,另外可以根据提示做一些Ollama的指令,关键的是load model和save model,可以载入和存储模型。

![]()

500

500

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?