当前我们可以通过Ollama 来优化提示词效果,在这里 我们需要下载Ollama 相关程序,当前下载Windows 版本用于安装。

https://ollama.com/download

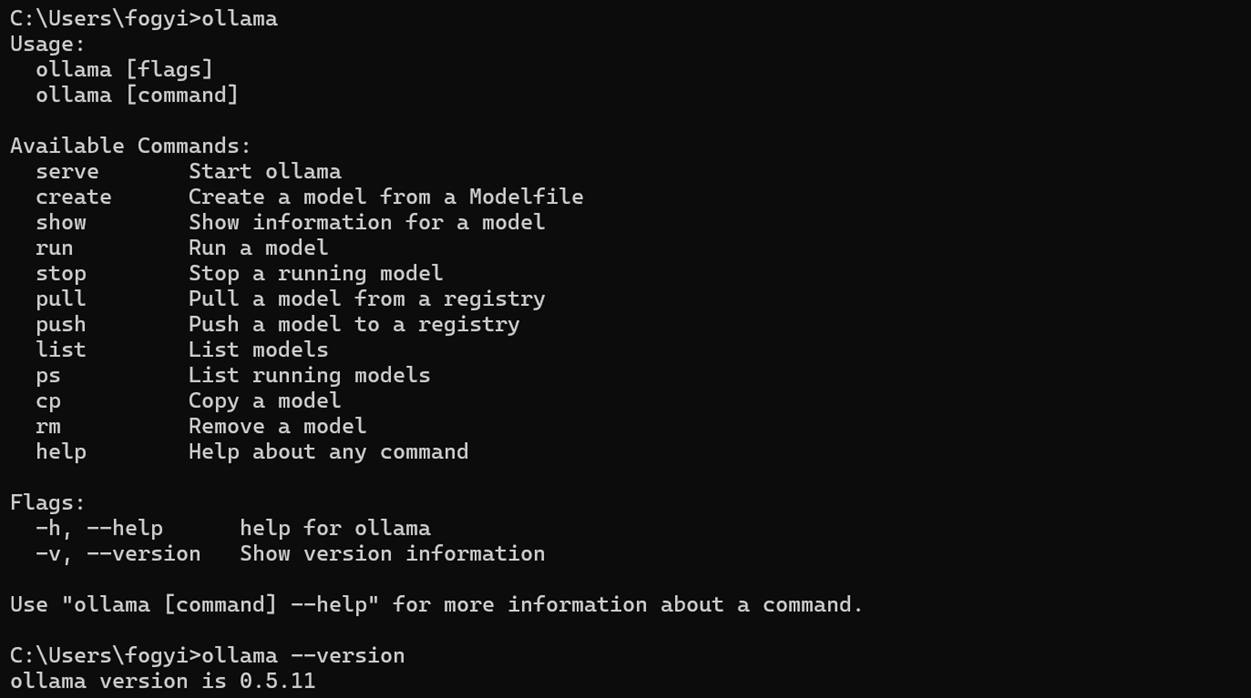

安装OllaMa程序相对比较简单,直接通过点击下一步可以完成安装。我们在命令行模式下执行Ollama –version 获取当前的执行版本,成功后证明安装成功。

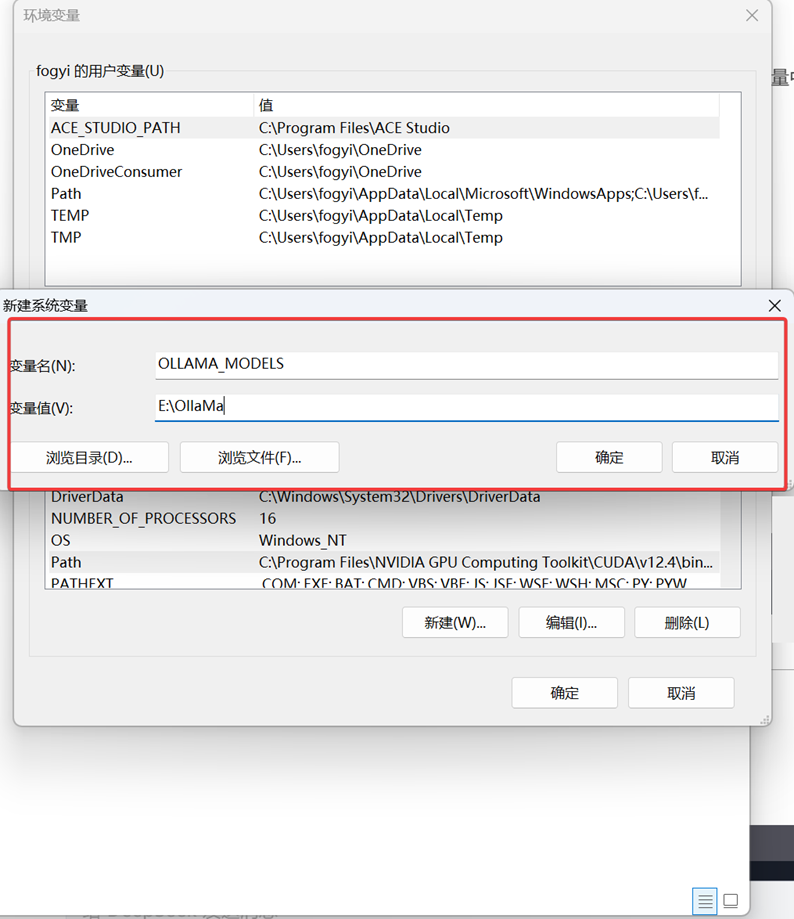

安装完成后我们需要定义OllaMa的环境配置,我们可以通过系统配置或者Env的方式来进行设置。

Mistral、qwen、llama2 OllaMa为我们的常用模型,我们通过执行如下命令进行模型下载:

ollama run llama2(模型)

订阅专栏 解锁全文

订阅专栏 解锁全文

246

246

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?