为什么Shannon信息论在解决通信系统的问题方面非常有效,但是在涉及人工智能理论研究的问题是就无能为力?

信息论只关注信号(信息的载体)的波形,不关心它的内容和价值。通信系统的设计可以只关心信号的波形。

人工智能却必须“理解信息的内容和价值”。

提出和建立了“全信息理论”--能够统一考虑信息的形式因素(称为语法信息)、内容因素(称为语义信息)和价值因素(称为语用信息)的全新的信息理论。

通信系统的基本任务要求:可靠性、有效性。

可靠: 要使信源发出的消息经过传输后,尽可能准确地、不失真或限定失真地再现在接收端。

有效: 用尽可能短的时间和尽可能少的设备来传输最大的消息

概率空间能表征离散信源的统计特性,因此也称概率空间为信源空间。

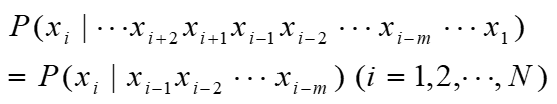

m阶马尔可夫信源:不同时刻发出的符号间的依赖关系

记忆信源的记忆长度为m+1时,称这种有记忆信源为m阶马尔可夫信源

若上述条件概率与时间起点 i 无关,信源输出的符号序列可看成为时齐马尔可夫链,则此信源称为时齐(平稳)马尔可夫信源

自信息量I(x1 )和I(x2 )只是表征信源中各个符号的不确定度。一个信源总是包含着多个符号消息,各个符号消息又按概率空间的先验概率分布,因而各个符号的自信息量就不同。所以自信息量不能作为信源总体的信息量。

熵是从整个集合的统计特性来考虑的,它从平均意义上来表征信源的总体特征。

在信源输出后,信息熵H(X)表示每个消息提供的平均信息量;

在信源输出前,信息熵H(X) 表示信源的平均不确定性;

信息熵H(X) 表征了变量X的随机性。

熵函数的性质:对称性(H(P) 的取值与分量 p1, p2 , ··· , pq的顺序无关)、确定性、非负性、扩展性、可加性(统计独立信源X和Y的联合信源的熵等于信源X和Y各自的熵之和)、强可加性(两个互相关联的信源X和Y的联合信源的熵等于信源X的熵加上在X已知条件下信源Y的条件熵)、递增性、上凸性、极值性

最大离散熵定理

3244

3244

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?