在socket的网络编程中常常采用多线程的方法来进行与多个客户端的通信,使服务器与多个客户端的通信并发、并行地进行。相比于多进程,多线程的好处是共用一块内存空间,下面我们来看一个简单的例子,就是多个客户端将字符串发送给服务器,服务器再将字符串反转后回复给客户端

服务器 server.c

#include <stdio.h>

#include <string.h>

#include <strings.h>

#include <stdlib.h>

#include <unistd.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include<pthread.h>

#define PORT 1234

#define BACKLOG 1

void *start_routine( void *ptr)

{

int fd = *(int *)ptr;

char buf[100];

int numbytes;

int i,c=0;

printf("this is a new thread,you got connected\n");

printf("fd=%d\n",fd);

if ((numbytes=recv(fd,buf,100,0)) == -1){

printf("recv() error\n");

exit(1);

}

char str[numbytes];

char buffer[numbytes];

//将收到的字符串反转

for(c=0;c<(numbytes-1);c++)

{

buffer[c]=buf[c];

}

printf("receive message:%s\n",buf);

printf("numbytes=%d\n",numbytes);

for(i=0;i<numbytes;i++)

{

str[i]=buf[numbytes-1-i];

}

printf("server will send:%s\n",str);

numbytes=send(fd,str,sizeof(str),0);

printf("send numbytes=%d\n",numbytes);

close(fd);

}

int main()

{

int listenfd, connectfd;

struct sockaddr_in server;

struct sockaddr_in client;

int sin_size;

sin_size=sizeof(struct sockaddr_in);

pthread_t thread; //定义一个线程号

if ((listenfd = socket(AF_INET, SOCK_STREAM, 0)) == -1)

{

perror("Creating socket failed.");

exit(1);

}

int opt = SO_REUSEADDR;

setsockopt(listenfd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof(opt));

bzero(&server,sizeof(server));

server.sin_family=AF_INET;

server.sin_port=htons(PORT);

server.sin_addr.s_addr = htonl (INADDR_ANY);

// 绑定

if (bind(listenfd, (struct sockaddr *)&server, sizeof(struct sockaddr)) == -1) {

perror("Bind error.");

exit(1);

}

// 监听

if(listen(listenfd,BACKLOG) == -1){ /* calls listen() */

perror("listen() error\n");

exit(1);

}

while(1)

{

// accept

if ((connectfd = accept(listenfd,(struct sockaddr *)&client,&sin_size))==-1) {

perror("accept() error\n");

exit(1);

}

printf("You got a connection from %s\n",inet_ntoa(client.sin_addr) );

pthread_create(&thread,NULL,start_routine,(void *)&connectfd);

}

close(listenfd);

}

客户端 client.c

#include <stdio.h>

#include <unistd.h>

#include <strings.h>

#include<string.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <stdlib.h>

#include <netinet/in.h>

#include <netdb.h>

#define PORT 1234

#define MAXDATASIZE 100

char receiveM[100];

char sendM[100];

int main(int argc, char *argv[])

{

int fd, numbytes;

struct hostent *he;

struct sockaddr_in server;

//检查用户输入,如果用户输入不正确,提示用户正确的输入方法

if (argc !=2) { printf("Usage: %s <IP Address>\n",argv[0]);

exit(1);

}

// 通过函数 gethostbyname()获得字符串形式的ip地址,并赋给he

if ((he=gethostbyname(argv[1]))==NULL){

printf("gethostbyname() error\n");

exit(1);

}

// 产生套接字fd

if ((fd=socket(AF_INET, SOCK_STREAM, 0))==-1){

printf("socket() error\n");

exit(1);

}

bzero(&server,sizeof(server));

server.sin_family = AF_INET;

server.sin_port = htons(PORT);

server.sin_addr = *((struct in_addr *)he->h_addr);

if(connect(fd, (struct sockaddr *)&server,sizeof(struct sockaddr))==-1){

printf("connect() error\n");

exit(1);

}

// 向服务器发送数据

printf("send message to server:");

fgets(sendM,100,stdin);

int send_le;

send_le=strlen(sendM);

sendM[send_le-1]='\0';

send(fd,sendM,strlen(sendM),0);

// 从服务器接收数据

if ((numbytes=recv(fd,receiveM,MAXDATASIZE,0)) == -1){

printf("recv() error\n");

exit(1);

}

printf("receive message from server:%s\n",receiveM);

close(fd);

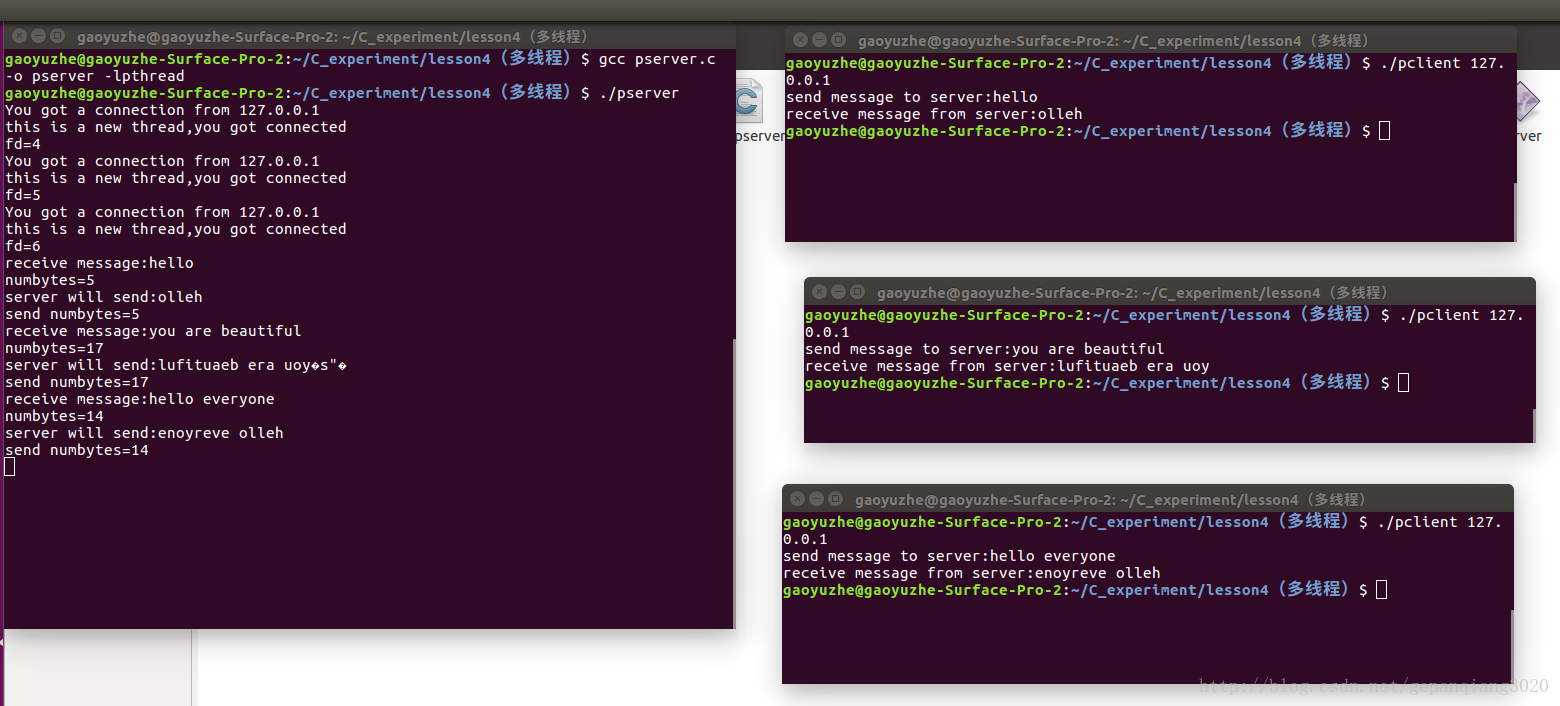

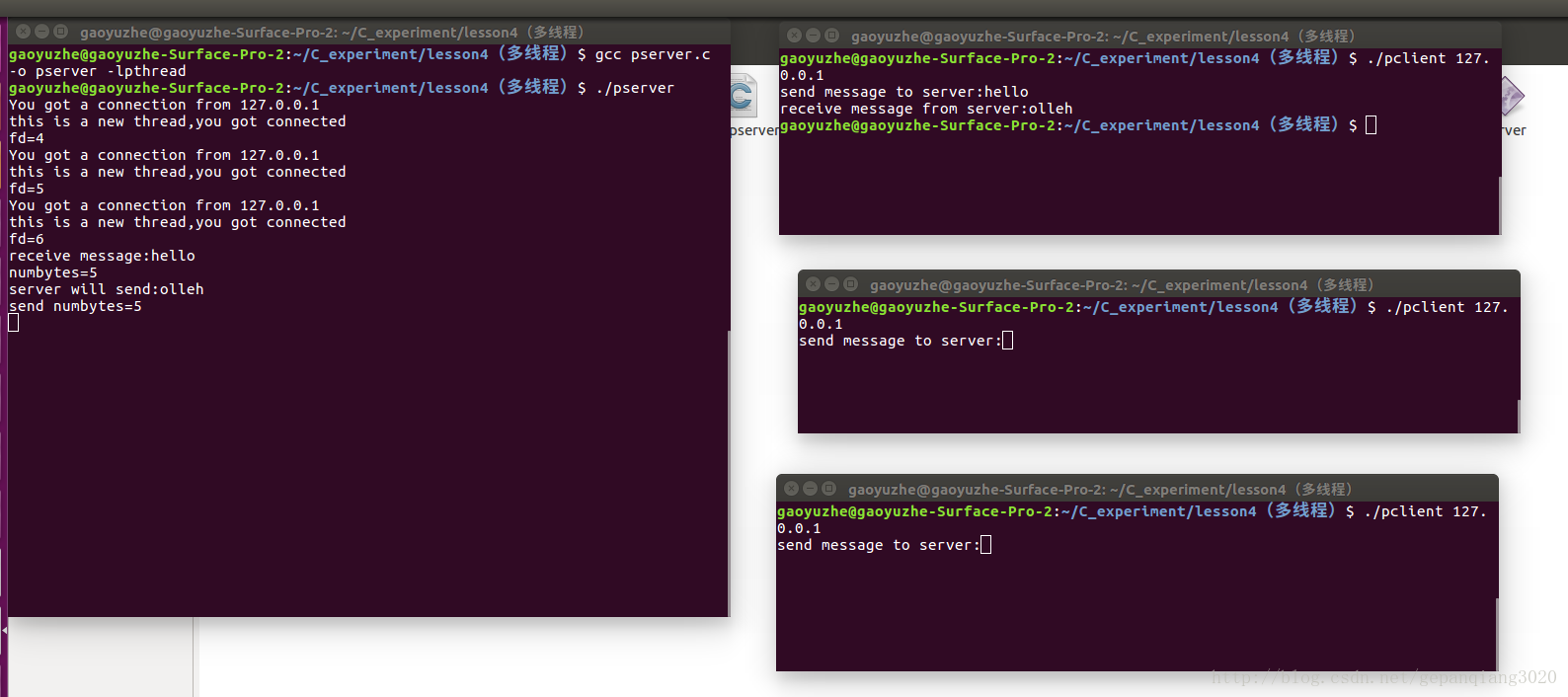

}运行结果如图,这里以本机中开三个终端当作三个客户端:

从运行结果来看,每一个客户端都分配给了一个fd值,即每一个客户端的线程都有各自的socket连接套接字。

在服务器程序中,我们可以看到,主程序中仅定义了一个线程标识符,而且仅创建了一个线程,这样就可以进行多个客户端的连接。个人理解:由于 socket的accept在while循环中,所以每有一个客户端请求连接服务器,都会生成一个新的连接套接字connectfd,而多个客户端连接上服务器后,共享一个线程的内存,各个客户端的线程之间并不是真正的并发、并行,而是线程的转换速度非常快,不断在多个客户端之间切换,(类比数码管的动态显示)。这样以来,就可以看做多个线程并行地和服务器进行通信。

所以说,在创建线程的函数pthread_create(&thread,NULL,start_routine,(void *)&connectfd) 中,我们要传递的参数只有socket的连接套接字connectfd就够了,因为数据的发送和接收函数recv/send只需要连接套接字connectfd,当然,也可以直接将客户端的地址结构体struct sockaddr_in client传递给线程,因为该结构体里面还包含着 协议族、ip地址、端口号等其他信息。要实现这个,服务器的程序可以仿照下面的程序:

#include <stdio.h>

#include <strings.h>

#include<string.h>

#include <stdlib.h>

#include <unistd.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include<pthread.h>

#define PORT 1234

#define BACKLOG 1 // 队列数,即可以排队的最大连接数

void *start_routine(void *arg); // 函数声明

// 定义一个ARG结构体,每一个线程都会定义一个ARG结构体,相当于一块内存

struct ARG {

struct sockaddr_in client;

int connfd;

} ;

void *start_routine(void *arg)

{

struct ARG *info;

info=(struct ARG *)arg;

int fd =(*info).connfd;

send(fd,"Welcome to my server.\n",22,0);

printf("this is a new thread\n");

// 发现了一个很奇怪的现象:线程中printf不加换行符\n就打印不出信息

close(fd);

free(arg);

}

int main()

{

int listenfd, connectfd;

struct sockaddr_in server;

struct sockaddr_in client;

int sin_size;

sin_size=sizeof(struct sockaddr_in);

struct ARG *arg; //事实证明:ARG结构体放主函数里和放全局变量里并没有区别

pthread_t thread; //定义一个线程号

if ((listenfd = socket(AF_INET, SOCK_STREAM, 0)) == -1)

{

perror("Creating socket failed.");

exit(1);

}

int opt = SO_REUSEADDR;

setsockopt(listenfd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof(opt));

bzero(&server,sizeof(server));

server.sin_family=AF_INET;

server.sin_port=htons(PORT);

server.sin_addr.s_addr = htonl (INADDR_ANY);

// 绑定

if (bind(listenfd, (struct sockaddr *)&server, sizeof(struct sockaddr)) == -1) {

perror("Bind error.");

exit(1);

}

// 监听

if(listen(listenfd,BACKLOG) == -1){ /* calls listen() */

perror("listen() error\n");

exit(1);

}

while(1)

{

// accept

if ((connectfd = accept(listenfd,(struct sockaddr *)&client,&sin_size))==-1) {

perror("accept() error\n");

exit(1);

}

//printf("You got a connection from %s\n",inet_ntoa(client.sin_addr) );

arg=malloc(sizeof(struct ARG));

arg->connfd=connectfd; // 连接描述符

//这里注意:一定要指明结构体内部变量的指针!!!

//不能直接指明结构体本身的指针

memcpy((void *)&arg->client,&client,sizeof(client));

pthread_create(&thread,NULL,start_routine,(void*)arg);

}

close(listenfd);

}

我们可以看,定义了一个结构体并分配一块内存,结构体里面包含连接套接字connectfd和户端的地址结构体struct sockaddr_in client,然后再用内存拷贝函数memcpy将各种信息拷贝至该结构体的对应地址处,用这种方法来传递给线程各个客户端的信息。

本文介绍了一种使用多线程实现服务器与多个客户端并发通信的方法。服务器为每个新连接的客户端创建一个线程,线程负责处理客户端发送的数据并将处理后的结果返回。文章提供了服务器和客户端的代码示例。

本文介绍了一种使用多线程实现服务器与多个客户端并发通信的方法。服务器为每个新连接的客户端创建一个线程,线程负责处理客户端发送的数据并将处理后的结果返回。文章提供了服务器和客户端的代码示例。

847

847

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?