一、获取端口流量

要自定义端口流量监控到普罗再到grafana,第一步就是需要获取到各个端口的流量,网上有很多工具可以获取到(比如iftop,nethogs等等),但都需要工具一直在后台运行,并且这些工具输出的数据不方便提取出来,所以我使用的是iptables统计端口流量,方法如下:

1.添加端口监控

#流量又分为上行和下行流量,所以需要分别在INPUT表和OUTPUT表添加端口监控,后续只针对INPUT表演示,OUTPUT表同理的

#根据自己的需求添加对应的端口

iptables -A INPUT -p tcp --dport 3306

iptables -A OUTPUT -p tcp --sport 3306

iptables -A INPUT -p tcp --dport 22

iptables -A OUTPUT -p tcp --sport 22

查看效果

iptables -nL INPUT -v -x

iptables -nL OUTPUT -v -x如下图,输出了各个端口的下行流量,单位是byte

2.提取流量

代码如下,就不细说了,

for i in $(iptables -nL INPUT -v -x -w 5 | sed -nr '/pkts|INPUT/!p' | awk '{print $NF}')

do

T=$(printf "%.2f" $(echo "scale=3;$(iptables -nL INPUT -v -x -w 5 | sed -n "/$i/p" | awk 'END{print $2}') / 1000000" | bc))

echo "node_port_input_traffic{port=\"$i\"}" $T

A=$(printf "%.2f" $(echo "$A+$T" | bc))

done

echo "node_port_input_traffic{port=\"all\"}" $A

以上提取出了各个端口的下行流量及总流量,并将单位换算成MB。

二、自定义node-exporter监控项

1.打印监控数据到prom文件

上面提取出了各个端口的流量使用量,还需要通过node-exporter将数据传递到普罗,所以需要先学会如何自定义node-exporter的监控项。

想要详细了解可以看:

Node Exporter textfile 自定义指标收集器 https://blog.csdn.net/qq_34556414/article/details/123478015?spm=1001.2014.3001.5506也可以直接使用一下脚本,得到node-exporter想要的 .prom文件

https://blog.csdn.net/qq_34556414/article/details/123478015?spm=1001.2014.3001.5506也可以直接使用一下脚本,得到node-exporter想要的 .prom文件

脚本名称路径为:/opt/node-exporter/input_traffic.sh

#!/bin/bash

source /etc/profile

echo "# HELP node_port_input_traffic some ports use traffic"

echo "# TYPE node_port_input_traffic gauge"

A=0

for i in $(iptables -nL INPUT -v -x -w 5 | sed -nr '/pkts|INPUT/!p' | awk '{print $NF}')

do

T=$(printf "%.2f" $(echo "scale=3;$(iptables -nL INPUT -v -x -w 5 | sed -n "/$i/p" | awk 'END{print $2}') / 1000000" | bc))

echo "node_port_input_traffic{port=\"$i\"}" $T

A=$(printf "%.2f" $(echo "$A+$T" | bc))

done

echo "node_port_input_traffic{port=\"all\"}" $A

将该脚本做成计划任务,我这里设置成每隔一分钟统计一次数据,并输出到相应目录的

计划任务如下:

* * * * * /usr/bin/bash /opt/node-exporter/input_traffic.sh > /opt/node-exporter/input_traffic.prom讲监控指标及数据打印到/opt/node-exporter/input_traffic.prom

2.容器部署node-exporter

部署如下:

docker run -d --name node-exporter -p 9100:9100 -v /opt/node-exporter:/opt/node-exporter --restart always -e TZ=Asia/Shanghai prom/node-exporter --collector.textfile.directory /opt/node-exporter以上部署了node-exporter,并指定了监控指标目录

3.验证结果

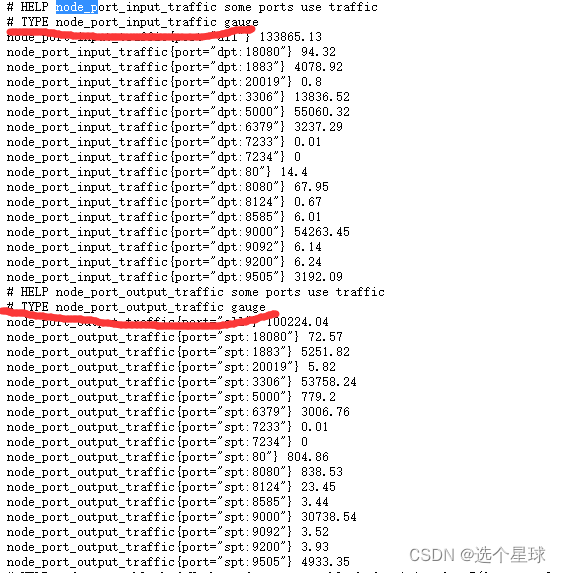

访问node-exporter web界面可以看到自定义输出的监控指标

三、自定义grafana面板

执行这一步之前,需要先部署grafana和prometheus,网上也有很多部署教程,就也不细说了。

1.导入面板

登录grafana,导入面板,也可以直接自定义面板。我这里导入的是ID为11206的面板

2.修改面板

导入的面板并不能直接使用,需要修改成上面自定义的监控指标,还有指标单位。

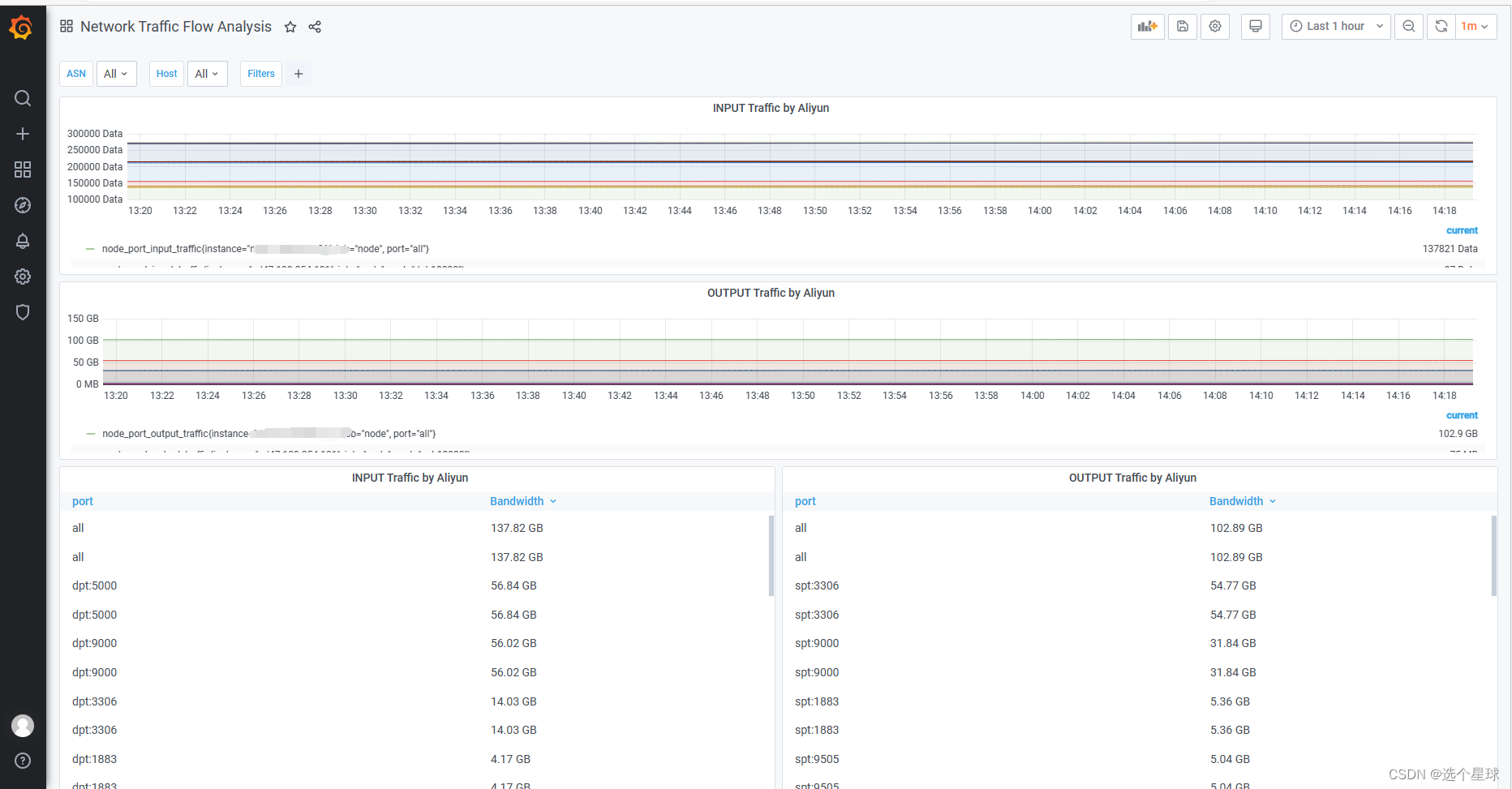

同理,将其余三个面板的指标和单位修改了,效果如下:

至此,自定义流量监控指标就完成了。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?