文章目录

JAVA操作HDFS

JAVA直接操作

利用maven 导入Jar包pom.xml:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0-cdh5.14.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.6.0-cdh5.14.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.6.0-cdh5.14.2</version>

</dependency>

将本地文件上传到hdfs服务器:

/**

* 上传文件到hdfs上

*/

@Test

public void upload() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS","hdfs://192.168.146.2:9000")

FileSystem fs = FileSystem.get(conf);

fs.copyFromLocalFile(new Path("E:/照片/20201031/IMG_6404.JPG" ),new Path("/testHDFS/java/hello"));

}

解析:

在开发中我没有引入“core-site.xml”配置文件,所以在本地调用时使用conf进行配置“conf.set(“fs.defaultFS”,“hdfs://hzq:9000”);“,下面雷同。

将hdfs上文件下载到本地:

/**

* 将hdfs上文件下载到本地

*/

@Test

public void download() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS","hdfs://192.168.146.2:9000")

FileSystem fs = FileSystem.newInstance(conf);

fs.copyToLocalFile(new Path("/testHDFS/java/hello/IMG_6404.JPG"),new Path("./"));

}

删除hdfs上指定文件:

/**

* 删除hdfs上的文件

* @throws IOException

*/

@Test

public void removeFile() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS","hdfs://192.168.146.2:9000")

FileSystem fs = FileSystem.newInstance(conf);

fs.delete(new Path("/testHDFS/java/hello/IMG_6404.JPG"),true);

}

在hdfs上创建文件夹:

/**

* 在hdfs更目录下面创建test1文件夹

* @throws IOException

*/

@Test

public void mkdir() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS","hdfs://192.168.146.2:9000")

FileSystem fs = FileSystem.newInstance(conf);

fs.mkdirs(new Path("/test1"));

}

列出hdfs上所有的文件或文件夹:

@Test

public void listFiles() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS","hdfs://192.168.146.2:9000")

FileSystem fs = FileSystem.newInstance(conf);

// true 表示递归查找 false 不进行递归查找

RemoteIterator<LocatedFileStatus> iterator = fs.listFiles(new Path("/"), true);

while (iterator.hasNext()){

LocatedFileStatus next = iterator.next();

System.out.println(next.getPath());

}

System.out.println("----------------------------------------------------------");

FileStatus[] fileStatuses = fs.listStatus(new Path("/"));

for (int i = 0; i < fileStatuses.length; i++) {

FileStatus fileStatus = fileStatuses[i];

System.out.println(fileStatus.getPath());

}

}

运行结果:

与实际情况对比完全一致:

结果分析:

“listFiles“列出的是hdfs上所有文件的路径,不包括文件夹。根据你的设置,支持递归查找。

”listStatus“列出的是所有的文件和文件夹,不支持递归查找。如许递归,需要自己实现。

Liunx系统调用java jar包操作

传参代码如下:

只是为了演示功能,所以只做了一个新建文件夹的功能

public class TestHDFS {

FileSystem fs;

public void initFS(String fsPath,String user){

Configuration conf=new Configuration();

try {

fs=FileSystem.get(new URI(fsPath),conf,user);

} catch (IOException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (URISyntaxException e) {

e.printStackTrace();

}

}

public void createDir(String path){

try {

fs.mkdirs(new Path(path));

} catch (IOException e) {

e.printStackTrace();

}

}

public static void main(String[] args) throws IOException {

TestHDFS test=new TestHDFS();

test.initFS(args[0],args[1]);

test.createDir(args[2]);

}

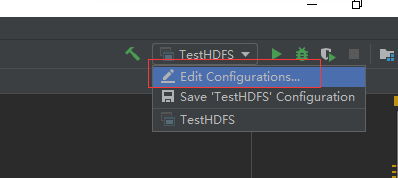

设置需要传递的参数

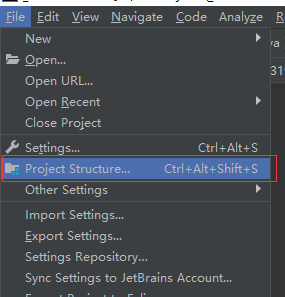

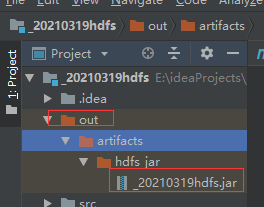

生成jar包

linux系统调用jar包

linux系统进入对应的放jar包的文件路径后,输入命令:

hadoop jar _20210319hdfs.jar cn.kgc.kb11.test.TestHDFS hdfs://hadoop100:9000 root /testHDFS/java/abc/dfs

hadoop jar 表示hadoop调用jar包

_20210319hdfs.jar 为jar的名称

cn.kgc.kb11.test.TestHDFS 为指定jar内的哪一个类

hdfs://hadoop100:9000 为指定hdfs路径

root 为用户名

/testHDFS/java/abc/dfs 为调用方法后需要创建的目录路径

总结:

熟能生巧,加油!!!

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?