探索视觉与逻辑的融合:Neural-Symbolic Visual Question Answering(NS-VQA)

去发现同类优质开源项目:https://gitcode.com/

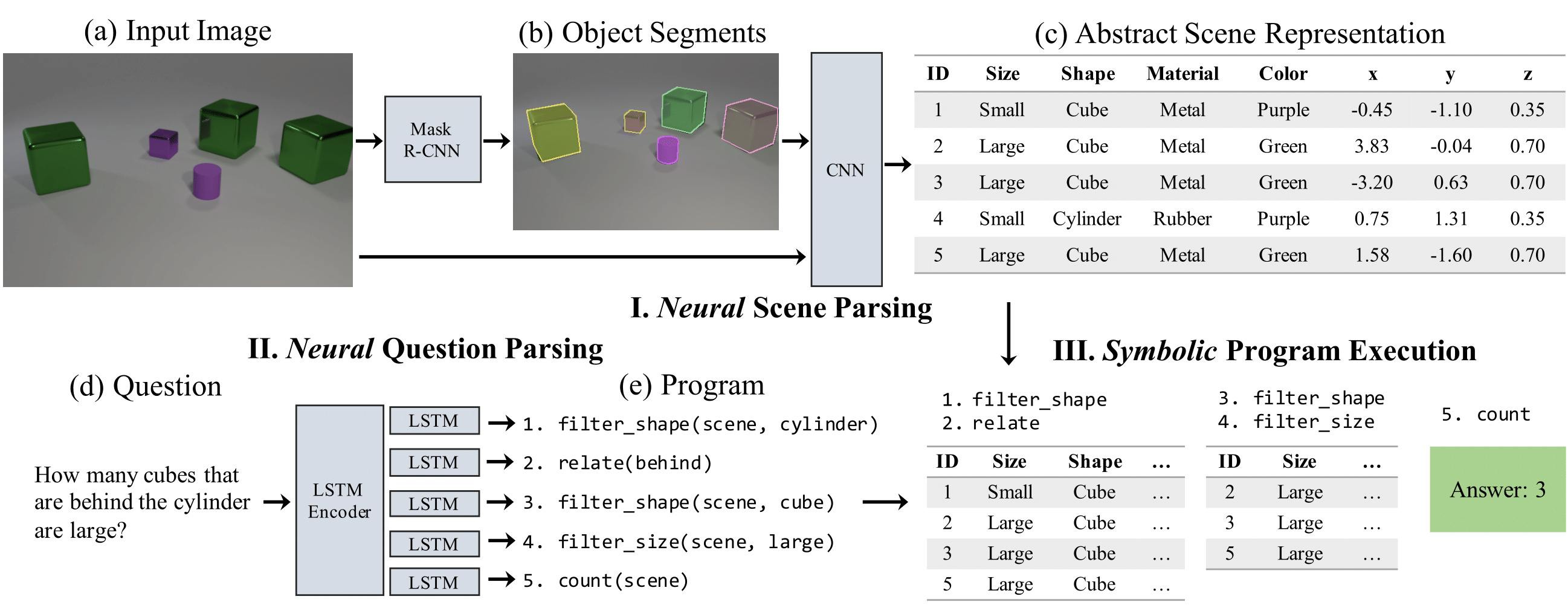

在人工智能领域中,深度学习和符号计算的结合一直是研究的热点。NS-VQA,一个基于PyTorch的实现,为这一领域的探索提供了强大的工具。该项目专注于解决基于图像的问题回答(Visual Question Answering, VQA),并引入了神经符号推理来提升模型的理解和推理能力。

项目介绍

NS-VQA 是针对CLEVR数据集的一个解决方案,该数据集是一个用于理解图像、语言和推理的挑战性平台。通过将深度学习与符号计算相结合,NS-VQA不仅能够理解复杂的视觉场景,还能进行逻辑推理以准确地回答问题。

项目技术分析

NS-VQA由三个关键组件构成:

- 对象检测网络:基于Mask R-CNN,提取图像中的对象。

- 属性提取网络:从检测到的对象中提取属性,形成抽象的场景表示。

- 神经问句解析器:将问题转化为可执行的程序,并在抽象的场景表示上执行逻辑。

应用场景

NS-VQA适合于需要高级理解和逻辑推理的应用,例如智能家居的人机交互系统,自动驾驶车辆的环境感知,甚至是辅助残障人士的智能助视器。它能处理涉及复杂场景理解、物体识别和逻辑推理的问题。

项目特点

- 集成的推理机制:模型不仅能识别物体,还能理解它们之间的关系,并执行逻辑操作,如比较、计数和分类。

- 端到端训练:整个系统可以从原始图像和问题直接学习,无需预先标注的逻辑程序。

- 高效性能:预训练模型在CLEVR测试集上的准确率高达99.8%,证明了其强大而精确的回答能力。

- 易于使用:基于Python和PyTorch的实现,提供详细的教程和脚本,方便快速接入和使用。

想要进一步了解或使用NS-VQA,请确保你的环境满足项目要求,并遵循提供的安装和运行指南。这个项目不仅是学术研究的理想选择,也是任何寻求在视觉理解和推理领域创新的开发者的重要资源。现在就加入,开启你的神经符号VQA之旅吧!

git clone https://github.com/kexinyi/ns-vqa.git

# ...后续按照readme指引进行设置和运行

去发现同类优质开源项目:https://gitcode.com/

2320

2320

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?