第八章 线性回归

先从定义说起:

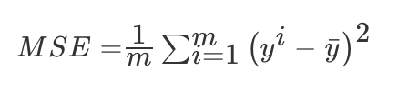

误差大小:

######sklearn线性回归正规方程、梯度下降API:

sklearn.linear_model.LinearRegression

正规方程

普通最小二乘线性回归

coef_:回归系数

sklearn.linear_model.SGDRegressor

梯度下降

通过使用SGD最小化线性模型

coef_:回归系数

回归性能评估:MSE

两种方法的比较:

特点:线性回归器是最为简单、易用的回归模型。从某种程度上限制了使用,尽管如此,在不知道特征之间关系的前提下,我们仍然使用线性回归器作为大多数系统的首要选择。

小规模数据:LinearRegression(不能解决拟合问题)以及其它

大规模数据:SGDRegressor

过拟合与欠拟合:

过拟合:一个假设在训练数据上能够获得比其他假设更好的拟合, 但是在训练数据外的数据集上却不能很好地拟合数据,此时认为这个假设出现了过拟合的现象。(模型过于复杂)

过拟合原因以及解决办法:

原因:

原始特征过多,存在一些嘈杂特征, 模型过于复杂是因为模型尝试去兼顾各个测试数据点

解决办法:

进行特征选择,消除关联性大的特征(很难做)

交叉验证(让所有数据都有过训练)

正则化(了解)

欠拟合:一个假设在训练数据上不能获得更好的拟合, 但是在训练数据外的数据集上也不能很好地拟合数据,此时认为这个假设出现了欠拟合的现象。(模型过于简单)

欠拟合原因以及解决办法:

原因:

学习到数据的特征过少

解决办法:

增加数据的特征数量

在线性回归容易出现过拟合,使用L2正则化解决:

作用:可以使得W的每个元素都很小,都接近于0

优点:越小的参数说明模型越简单,越简单的模型则越不容易产生过拟合现象

######带有正则化的线性回归-Ridge:sklearn.linear_model.Ridge

sklearn.linear_model.Ridge(alpha=1.0)

具有l2正则化的线性最小二乘法

alpha:正则化力度

coef_:回归系数

线性回归 LinearRegression与Ridge对比:

岭回归:回归得到的回归系数更符合实际,更可靠。另外,能让估计参数的波动范围变小,变的更稳定。在存在病态数据偏多的研究中有较大的实用价值。

def mylinear():

"""

线性回归直接预测房子价格

:return: None

"""

#获取数据

lb=load_boston()

#分割数据

x_train,x_test,y_train,y_test =train_test_split(lb.data,lb.target,test_size=0.25)

print(y_train,y_test)

#特征值和目标值都需要标准化处理

std_x=StandardScaler()

x_train=std_x.fit_transform(x_train)

x_test=std_x.transform(x_test)

std_y = StandardScaler()

y_train = std_y.fit_transform(y_train.reshape(-1,1))

y_test = std_y.transform(y_test.reshape(-1,1))

#estimator预测

#正规方程求解

lr =LinearRegression()

lr.fit(x_train,y_train)

print(lr.coef_)

#预测价格

y_predict=std_y.inverse_transform(lr.predict(x_test))

print("测试结果:",y_predict)

print("正规方程的均方误差:", mean_squared_error(std_y.inverse_transform(y_test), y_predict))

#SGD求解

SGD = SGDRegressor()

SGD.fit(x_train, y_train)

print(SGD.coef_)

# 预测价格

y_predict = std_y.inverse_transform(SGD.predict(x_test))

print("测试结果:", y_predict)

print("SGD的均方误差:", mean_squared_error(std_y.inverse_transform(y_test), y_predict))

# Rideg求解

rid = Ridge(alpha=1.0)

rid.fit(x_train, y_train)

print(rid.coef_)

# 预测价格

y_predict = std_y.inverse_transform(rid.predict(x_test))

print("测试结果:", y_predict)

print("岭回归的均方误差:", mean_squared_error(std_y.inverse_transform(y_test), y_predict))

return None

if __name__=="__main__":

mylinear()

189

189

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?