点击蓝字

关注我们

关注并星标

从此不迷路

计算机视觉研究院

公众号ID|计算机视觉研究院

学习群|扫码在主页获取加入方式

论文:SAPT: A Shared Attention Framework for Parameter-Efficient Continual Learning of Large Language Models

论文地址:https://arxiv.org/abs/2401.08295

计算机视觉研究院专栏

Column of Computer Vision Institute

在大模型实际部署落地的过程中,如何赋予大模型持续学习的能力是一个至关重要的挑战。这使其能够动态适应新的任务并不断获得新的知识。大模型的持续学习主要面临两个重大挑战,分别是灾难性遗忘和知识迁移。灾难性遗忘是指模型在学习新任务时,会忘记其已掌握的旧任务。知识迁移则涉及到如何在学习新任务时有效地应用旧任务的知识来提升新任务学习的效果。

为了有效应对以上难题,哈工大联合度小满推出针对大模型的共享注意力持续学习框架 SAPT,相应论文已被自然语言处理顶级会议 ACL 2024 接收。

研究动机

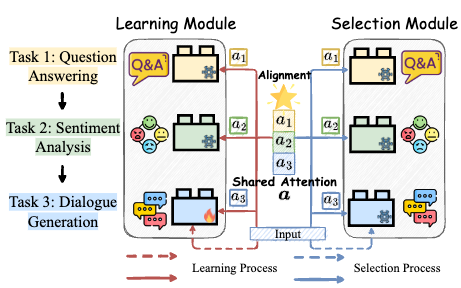

现有面向大模型的持续学习的工作大都基于参数高效微调 (Parameter-Efficient Tuning, PET) 而开展,并且可以被抽象为由学习模块和选择模块组成的工作框架。如图 1 中虚线所示,当新任务对话生成到达时,学习模块会为其分配一个单独的 PET 块来学习任务特定的知识,然后将其保存在 PET 资源池中,以供后续在测试样本到来时(任务序号在测试阶段无法获取),选择模块能够自动地为其选择所属的 PET 块,得到测试输入的结果。然而,当前工作中每个模块的设计在有效应对灾难性遗忘和知识迁移挑战方面都表现出一定的局限性。

一方面,学习模块的设计旨在促进不同任务之间的知识迁移。不幸的是,学习模块分配的 PET 只学习当前任务特定知识的现状阻断了存储在已习得的 PET 块中的来自先前任务知识的潜在迁移,并阻碍它们协助当前新任务知识的获取。

另一方面,选择模块在缓解灾难性遗忘方面发挥着关键作用,因为只有当它能够自动选择当前输入所属的 PET 块时,大模型基座才能成功完成当前任务。然而,当前工作中基于拼接或相加来自所有任务的 PET 块的设计无法有效缓解灾难性遗忘。

更重要的是,他们忽略了将这两个模块进行对齐来同时解决灾难性遗忘和知识迁移。直觉上来看(如图 1 中的实线所示),为了促进新任务学习时的知识迁移,学习模块应该依靠任务相关性来利用先前 PET 块中最相关的知识。而后选择模块可以自然地重复这一注意力过程,通过寻找属于每个测试输入的相应 PET 块的组合来抵抗灾难性遗忘。在本工作中,这种注意力过程被称为共享注意力。由此,这两个模块的端到端对齐能够通过这种共享注意力而建立。

问题定义和设定

持续学习旨在解决学习连续而来的任务序列中的挑战。形式上,任务序列中 每个任务依次而来。每个任务

每个任务依次而来。每个任务 包含一个单独的目标数据集,其大小为

包含一个单独的目标数据集,其大小为 。在任意时间步 t,模型不仅需要掌握第 t 个任务,而且还要保持其在之前所有任务上的性能不发生明显衰减。

。在任意时间步 t,模型不仅需要掌握第 t 个任务,而且还要保持其在之前所有任务上的性能不发生明显衰减。

在本工作中,我们深入研究更具挑战性和实用性的持续学习设定,即不同任务的任务序号不可获取:在测试阶段,模型面对输入样本时不知道它们属于哪个特定任务。

图 1 当前基于学习模块和选择模块进行大模型持续学习的概念化框架。其中,虚线表示现有工作的流程,实现表示本工作提出方法的工作流程。

方法介绍

本文提出了针对大语言模型的共享注意力持续学习框架 SAPT,为同时应对灾难性遗忘和知识迁移的挑战提供了有效的解决方案。SAPT 的整体架构由两个关键组件组成,如图 2 所示:共享注意力学习与选择模块(SALS)和注意力反思模块(ARM)。在 SALS 中,注意力学习(实线)和注意力选择(虚线)通过共享注意力操作对齐。然后在 ARM 中,我们通过生成的伪样本帮助 SALS 回忆来自以前任务输入对应的正确的注意力权重。

图 2 我们提出的 SAPT 的整体架构,有共享注意力学习与选择模块(左)和注意力反思模块构成(右)。

共享注意力学习与选择模块(SALS):

注意力学习:为了获取来自先前任务的相关知识,当第 t 个任务到达时,通过 Query Projection 层生成查询向量和可学习的键值

进行注意力运算,将所有之前的 PET 块的参数

进行注意力运算,将所有之前的 PET 块的参数 和当前

和当前 通过加权组合进行聚合,用于第 t 个任务的学习。

通过加权组合进行聚合,用于第 t 个任务的学习。注意力选择:该部分通过重复注意力学习时的相同的注意力过程,得到现有 PET 块在每个输入样本上的最佳组合,并结合到 LLM 上,完成对当前样本的测试。

注意力反思模块(ARM):

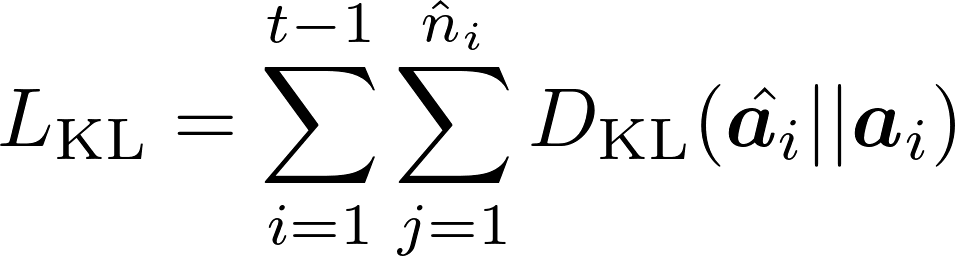

然而,随着依次而来的新任务不断更新 SALS 会导致该模块仅针对最新任务进行最佳注意力组合,从而导致忘记以前任务相应的注意力组合系数。由此,ARM 模块确保来自先前任务的输入仍然可以正确地执行相应的共享注意力操作,以识别每个任务特定的 PET 块的组合。具体方法基于生成式回放得到伪样本,用来对 Query Projection 层进行约束。

实验结果

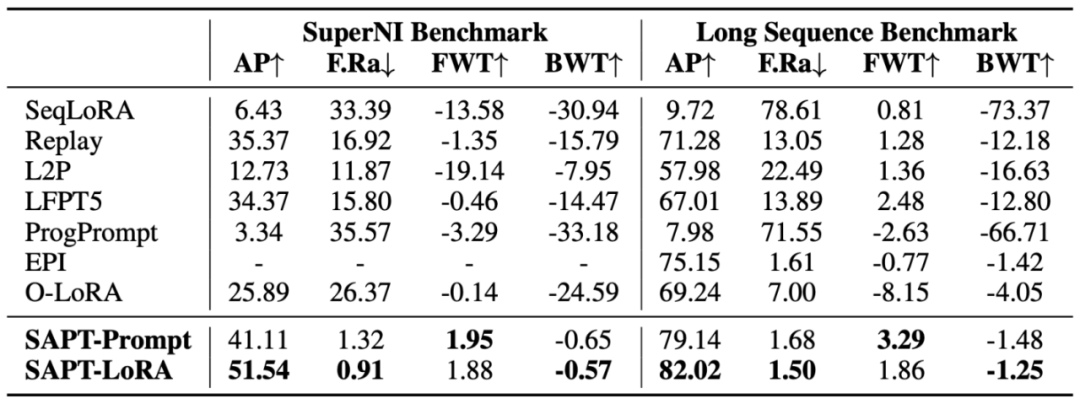

我们基于 Prompt Tuning 和 LoRA 这两个具有代表性的参数高效微调方法,在 SuperNI Benchmark,Long Sequence Benchmark 两个评测基准上进行了实验,评价指标为:平均性能(AP)、遗忘率(F.Ra)、前向迁移 (FWT) 以及反向迁移 (BWT)。如表 1 中结果所示,SAPT 具有最高的 AP 和最低的 F.Ra,表明其能够有效应对灾难性遗忘。与此同时,其在 FWT 和 BWT 上也具有最优的表现,体现出 SAPT 能够实现有效的知识迁移。

表 1 基于 T5-Large 模型在两个持续学习基准的总体结果

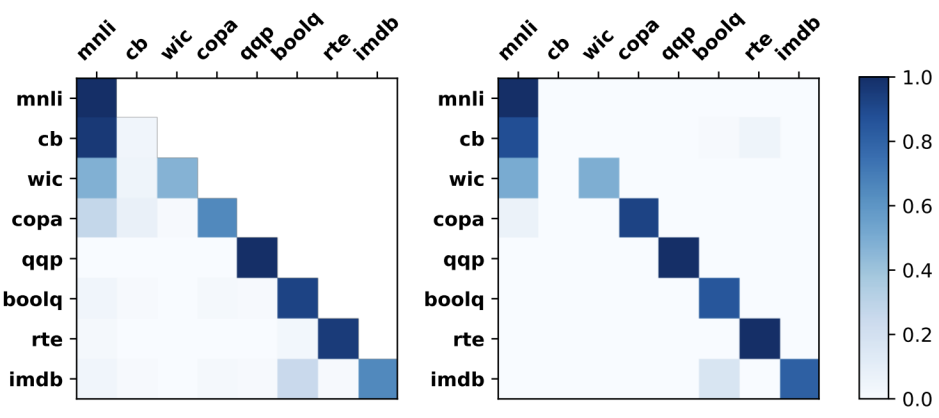

图 3 展示了在训练(左图)和测试(右图)期间共享注意力的分布示意图。我们可以观察到:(1)PET 块的学习和选择过程是完全对齐的,两个热力图几乎具有相同的布局。(2)知识迁移确实发生在注意力学习过程中,以帮助 SAPT 获取新知识。这些进一步验证了 SAPT 处理灾难性遗忘和知识迁移的有效性。

图 3 共享注意力的可视化结果。

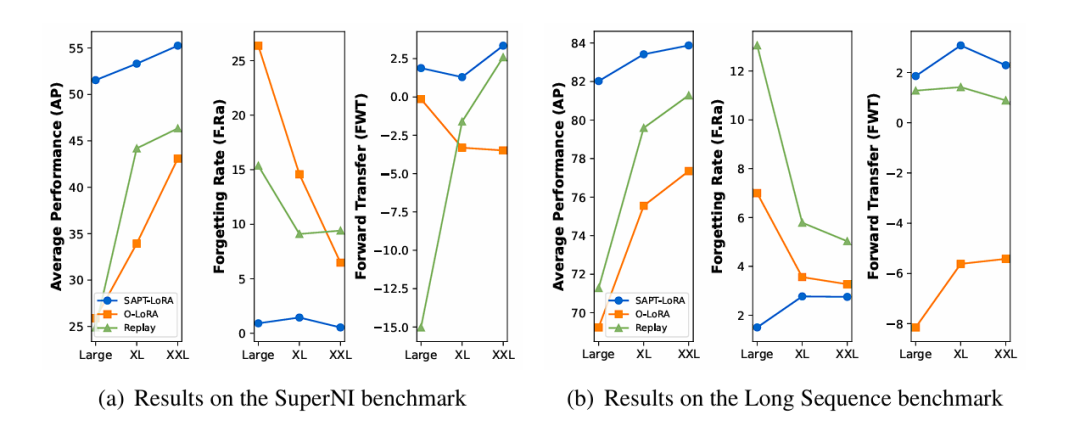

我们将实验采用的基础大模型拓展到了不同的规模,我们实验分析了 T5 模型大小如何影响 SAPT 的性能。图 4 显示了随着逐渐增大的基础模型大小,即 Large(770M)、XL(3B)和 XXL(11B),SAPT、O-LoRA 和 Replay 在 AP、F.Ra 和 FWT 方面的表现。总体而言,随着基础模型大小的增加,在抵抗灾难性遗忘和促进知识迁移方面,SAPT 始终能够展现出比基线方法更优越的性能。

图 4 SAPT 基于不同规模的 T5 模块的实验结果

我们也将基础大模型拓展到了不同的架构。图 5 展示了基于不同大小的 T5 和 LLaMA-2 在 SuperNI 基准上的 SAPT 和基线方法的结果。可以观察到,SAPT 依旧能够有效地缓解灾难性遗忘并促进不同模型架构间的知识迁移。此外,平均性能随着模型基础能力的增强而提高(LLaMA-2 > T5),这进一步证明了我们提出的 SAPT 的通用性。

图 5 SAPT 基于不同架构的大模型的实验结果。

更多详细内容可以参考论文原文。论文提出的方法未来将结合到度小满轩辕大模型中,欢迎大家访问!

大模型项目地址:https://github.com/Duxiaoman-DI/XuanYuan

END

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

ABOUT

计算机视觉研究院

计算机视觉研究院主要涉及深度学习领域,主要致力于目标检测、目标跟踪、图像分割、OCR、模型量化、模型部署等研究方向。研究院每日分享最新的论文算法新框架,提供论文一键下载,并分享实战项目。研究院主要着重”技术研究“和“实践落地”。研究院会针对不同领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

往期推荐

🔗

204

204

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?