点击蓝字 关注我们

关注并星标

从此不迷路

计算机视觉研究院

公众号ID|计算机视觉研究院

学习群|扫码在主页获取加入方式

论文地址:https://arxiv.org/pdf/2306.11087.pdf

计算机视觉研究院专栏

Column of Computer Vision Institute

今天分享研究了通用的零样本分割,在不需要任何训练样本的情况下,实现新类别的全景、实例和语义分割。

01

概要简介

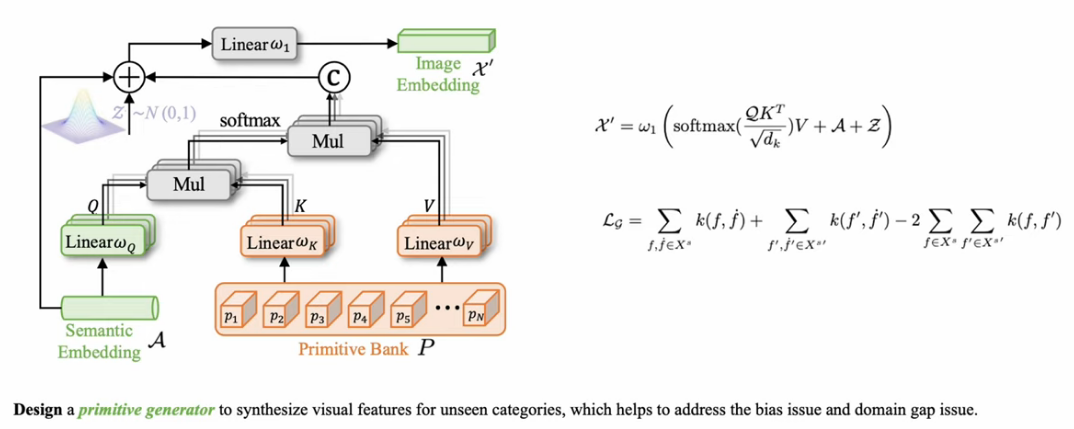

这种零样本分割能力依赖于语义空间中的类间关系,将从可见类别中学习到的视觉知识转移到不可见类别中。因此,希望很好地桥接语义视觉空间,并将语义关系应用于视觉特征学习。

研究者引入了一个生成模型来合成不可见类别的特征,该模型连接了语义和视觉空间,并解决了缺乏不可见训练数据的问题。此外,为了缓解语义空间和视觉空间之间的领域差距。首先,通过学习primitives增强vanilla generator,每个都包含与类别相关的细粒度属性,并通过选择性地组装这些指令来合成看不见的特征。其次,提出将视觉特征分为语义相关部分和语义无关部分,语义相关部分包含有用的视觉分类线索,但与语义表示不太相关。然后,与语义相关的视觉特征的类间关系需要与语义空间中的那些类间关系对齐,从而将语义知识转移到视觉特征学习中。该方法在零样本全景分割、姿态分割和语义分割方面取得了令人印象深刻的先进性能。

02

背景分析

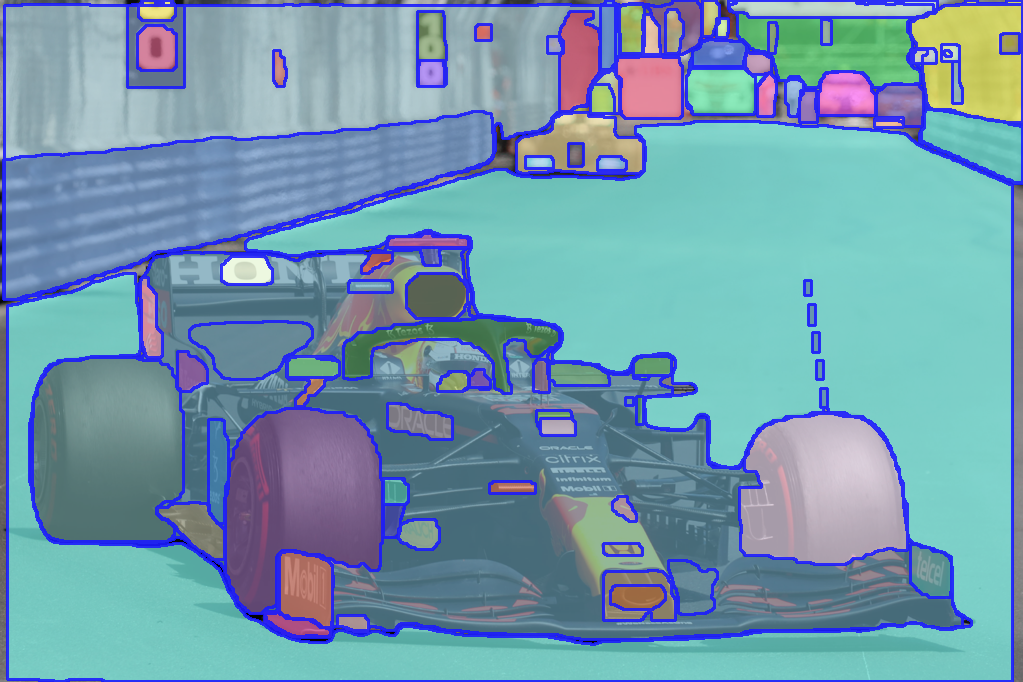

图像分割旨在将具有不同语义的像素分组,例如类别或实例。深度学习方法凭借CNNs和Transformer强大的学习能力,极大地提高了图像分割的性能。然而,由于深度学习方法是数据驱动的,对大规模标记训练样本的强烈需求带来了巨大的挑战,这是劳动密集型和耗时的。为了解决这个问题,提出了零样本学习(ZSL)来对无训练样本的新对象进行分类。最近,ZSL被扩展到零样本语义分割(ZSS)和零样本实例分割(ZSI)等分割任务。在此,研究者进一步介绍了零样本全景分割(ZSP),旨在借助语义知识构建一个通用的零样本全景/语义/实例分割框架,如下图所示。

然而,目前基于生成模型的方法通常是以每像素级生成的形式,在更复杂的场景中不够鲁棒。最近,一些工作提出将分割解耦为类不可知的掩码预测和对象级分类。研究者遵循这一策略,并将像素级生成退化为更稳健的对象级生成。

此外,先前的生成作品通常学习从语义嵌入到视觉特征的直接映射。这样的生成器没有考虑特征粒度的视觉语义差距,即图像包含比语言丰富得多的信息。从粗粒度信息到细粒度信息的直接映射导致低质量的合成特征。为了解决这个问题,研究者提出利用具有非常细粒度语义属性的丰富原语来组成视觉表示。这些指令的不同集合构造不同的类表示,其中集合由指令和语义嵌入之间的相关性决定。极大地增强了生成器的表达多样性和有效性,特别是在丰富的细粒度属性方面,使不同类别的合成特征更加可靠和具有鉴别性。

03

新框架介绍

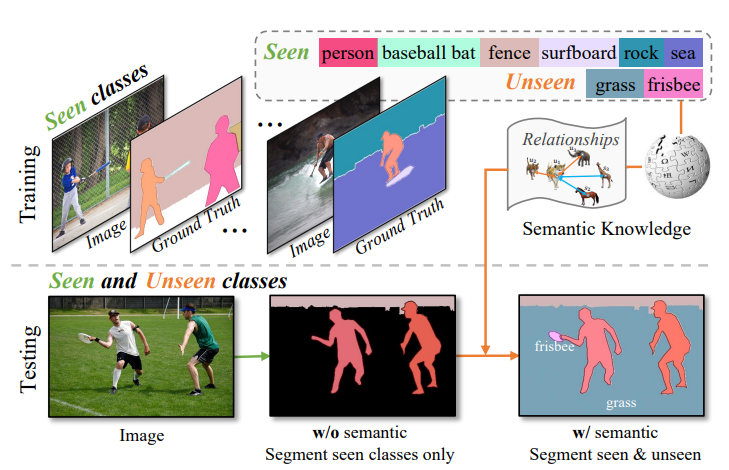

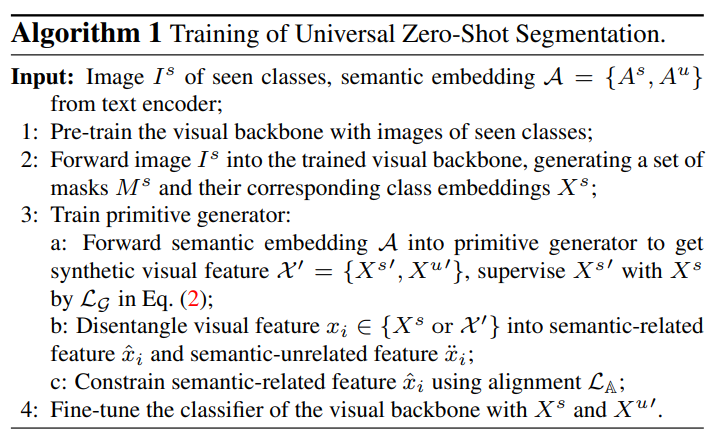

下图说明了提出的方法的总体架构,具有协作关系对齐和特征去纠缠学习(PADing)的原始生成。主干预测了一组类不可知掩码及其相应的类嵌入。Primitive生成器被训练为从语义嵌入中合成类嵌入。真实的和合成的类嵌入被分解为语义相关和语义无关的特征。对语义相关特征进行关系对齐学习。使用合成的不可见类嵌入,用可见类别的真实类嵌入和不可见类别的合成类嵌入来重新训练分类器。训练过程在下算法1中进行了演示。

算法1

Primitive Cross-Modal Generation

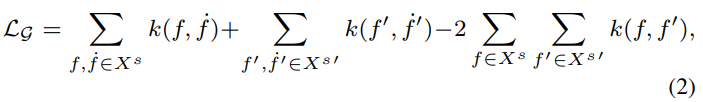

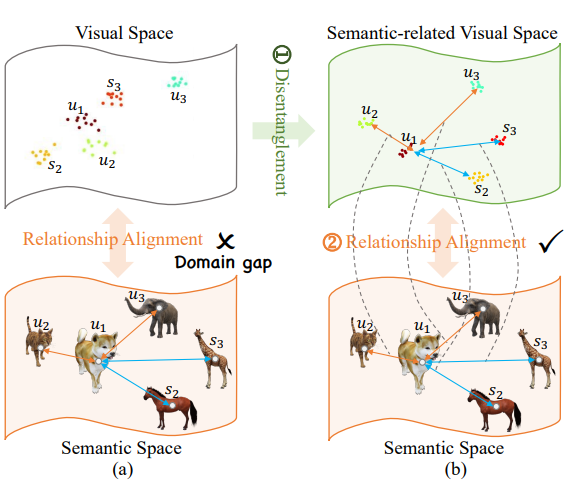

由于缺乏看不见的样本,分类器无法使用看不见类的特征进行优化。因此,在可见类上训练的分类器倾向于为所有对象/材料分配可见组的标签,这被称为偏差问题。为了解决这个问题,以前的方法提出利用生成模型来合成看不见类的虚假视觉特征。然而,以往的零样本分割工作通常采用生成矩匹配网络(Generative Moment Matching Network,GMMN)或GAN,它们由多个线性层组成,作为特征生成器。

这样的生成器虽然取得了良好的性能,但没有考虑特征粒度的视觉语义差异。众所周知,图像通常比语言包含更丰富的信息。视觉信息提供对象的细粒度属性,而文本信息通常提供抽象和高级属性。这种差异导致视觉特征和语义特征之间的不一致。为了应对这一挑战,提出了一种Primitive Cross Modal Generator,该生成器使用大量可学习的Primitiv属性来构建视觉表示。

如上图所示,使用Transformer架构构建Primitive Generator。

Semantic-Visual Relationship Alignment

众所周知,类别之间的关系自然是不同的。例如,有三个对象:苹果、橙子和奶牛。显然,苹果和桔子的关系比苹果和奶牛的关系更密切。语义空间中的类关系是强大的先验知识,而特定于类别的特征生成并没有明确地利用这些关系。如下图所示,用语义嵌入建立了这样的关系,并探索将这些知识转移到视觉空间,根据类关系进行语义视觉对齐。通过考虑这种关系,对看不见的类别的特征生成有更多的限制,以拉或推他们与看到的类别的距离。

04

实验及分析

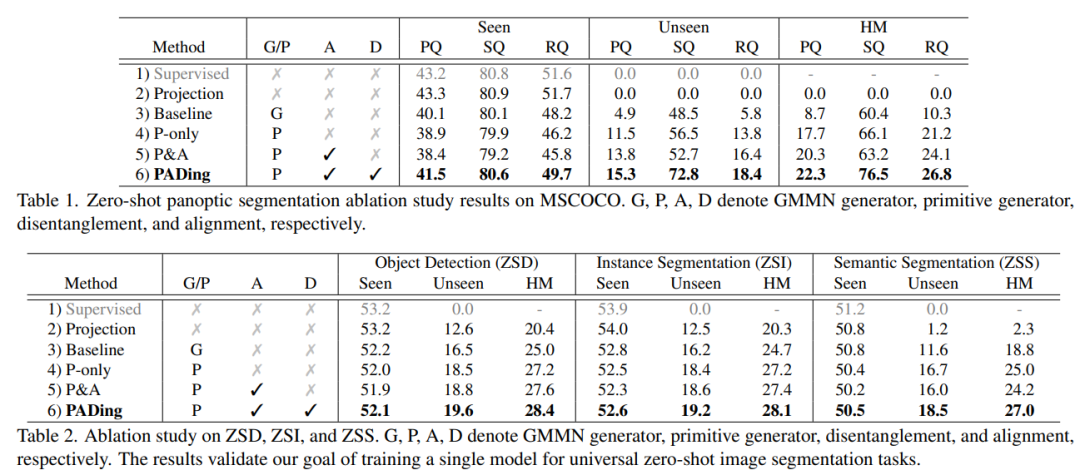

为了验证新提出方法的有效性,在COCO数据上针对全景分割、实例分割、语义分割上进行了对比实验,见表1、2、3。实验结果表明,本文方法PADing取得先进的性能。

Installation:

The code is tested under CUDA 11.2, Pytorch 1.9.0 and Detectron2 0.6.

Install Detectron2 following the manual

Run

sh make.shunderPADing/modeling/pixel_decoder/ops(Note: 1-2 steps you can also follow the installation process of Mask2Former)Install other required packages:

pip install -r requirements.txtPrepare the dataset following

datasets/README.md

Training

Firstly, download the pretrained weights here or you can train vanilla mask2former backbone using seen classes and convert it using the following command:

python train_net_pretrain.py --config-file configs/panoptic-segmentation/pretrain.yaml --num-gpus 8

python tools/preprocess_pretrained_weight.py --task_name panoptic --input_file panoptic_pretrain/model_final.pthThen train PADing and finetune the last class embedding layer of the trained mask2former model:

CUDA_VISIBLE_DEVICES=0 python train_net.py --config-file configs/panoptic-segmentation/PADing.yaml --num-gpus 1 MODEL.WEIGHTS pretrained_weight_panoptic.pth© THE END

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

ABOUT

计算机视觉研究院

计算机视觉研究院主要涉及深度学习领域,主要致力于目标检测、目标跟踪、图像分割、OCR、模型量化、模型部署等研究方向。研究院每日分享最新的论文算法新框架,提供论文一键下载,并分享实战项目。研究院主要着重”技术研究“和“实践落地”。研究院会针对不同领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

往期推荐

🔗

208

208

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?