《从菜鸟到大师之路 Redis 篇》

(一):Redis 基础理论与安装配置

Nosql 数据库介绍

是一种 非关系型 数据库服务,它能 解决常规数据库的并发能力 ,比如 传统的数据库的IO与性能的瓶颈 ,同样它是关系型数据库的一个补充,有着比较好的高效率与高性能。专注于key-value查询的redis、memcached、ttserver。

解决以下问题

对数据库的高并发读写需求

大数据的高效存储和访问需求

高可扩展性和高可用性的需求

什么是 Redis

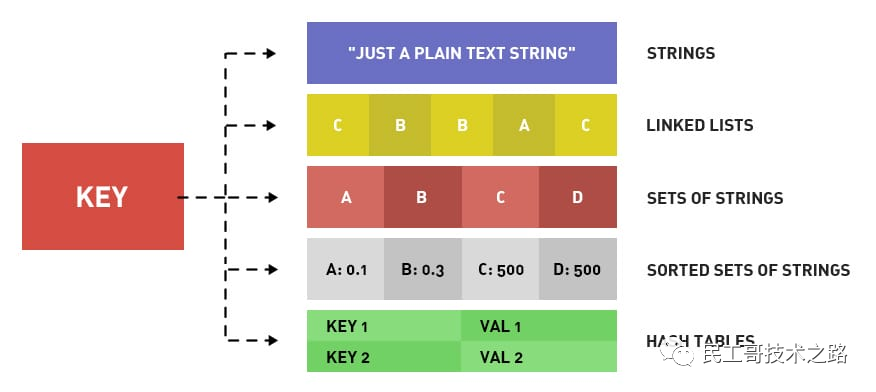

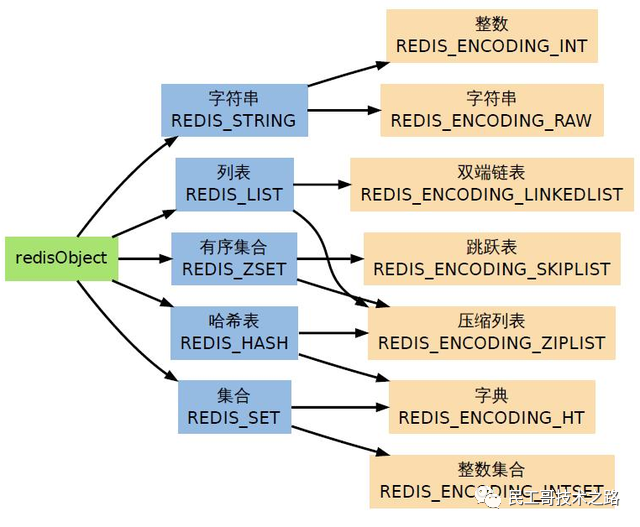

Redis 是一款 内存高速缓存 数据库。Redis全称为: Remote Dictionary Server(远程数据服务) ,使用C语言编写,Redis是一个key-value存储系统(键值存储系统),支持丰富的数据类型,如:String、list、set、zset、hash。

Redis是一种支持key-value等多种数据结构的存储系统。可用于缓存,事件发布或订阅,高速队列等场景。支持网络,提供字符串,哈希,列表,队列,集合结构直接存取,基于内存,可持久化。

官方资料

Redis官网:http://redis.io/

Redis官方文档:http://redis.io/documentation

Redis教程:http://www.w3cschool.cn/redis/redis-intro.html

Redis下载:http://redis.io/download

为什么要使用 Redis

一个产品的使用场景肯定是需要根据产品的特性,先列举一下

Redis的特点

读写性能优异

- Redis能读的速度是110000次/s,写的速度是81000次/s (测试条件见下一节)。

数据类型丰富

- Redis支持二进制案例的 Strings, Lists, Hashes, Sets 及 Ordered Sets 数据类型操作。

原子性

- Redis的所有操作都是原子性的,同时Redis还支持对几个操作全并后的原子性执行。

丰富的特性

- Redis支持 publish/subscribe, 通知, key 过期等特性。

持久化

- Redis支持RDB, AOF等持久化方式

发布订阅

- Redis支持发布/订阅模式

分布式

- Redis Cluster

所以,无论是运维还是开发、测试,对于 NoSQL 数据库之一的 Redis 也是必学知识体系之一。

下面是官方的bench-mark根据如下条件获得的性能测试(读的速度是110000次/s,写的速度是81000次/s)

- 测试完成了50个并发执行100000个请求。

- 设置和获取的值是一个256字节字符串。

- Linux box是运行Linux 2.6,这是X3320 Xeon 2.5 ghz。

- 文本执行使用loopback接口(127.0.0.1)。

Redis有哪些优缺点

优点

- 读写性能优异 , Redis能读的速度是110000次/s,写的速度是81000次/s。

- 支持数据持久化 ,支持AOF和RDB两种持久化方式。

- 支持事务 ,Redis的所有操作都是原子性的,同时Redis还支持对几个操作合并后的原子性执行。

- 数据结构丰富 ,除了支持string类型的value外还支持hash、set、zset、list等数据结构。

- 支持主从复制 ,主机会自动将数据同步到从机,可以进行读写分离。

缺点

- 数据库容量受到物理内存的限制,不能用作海量数据的高性能读写 ,因此Redis适合的场景主要 局限在较小数据量 的高性能操作和运算上。

- Redis 不具备自动容错和恢复功能 ,主机从机的宕机都会导致前端部分读写请求失败,需要等待机器重启或者手动切换前端的IP才能恢复。

- 主机宕机,宕机前有部分数据未能及时同步到从机,切换IP后还会引入数据不一致的问题 ,降低了系统的可用性。

- Redis 较难支持在线扩容,在集群容量达到上限时在线扩容会变得很复杂。 为避免这一问题,运维人员在系统上线时必须确保有足够的空间,这对资源造成了很大的浪费。

Redis的使用场景

redis 应用场景总结 redis 平时我们用到的地方蛮多的,下面就了解的应用场景做个总结:

热点数据的缓存

缓存是Redis最常见的应用场景,之所有这么使用,主要是因为Redis读写性能优异。而且逐渐有取代memcached,成为首选服务端缓存的组件。而且,Redis内部是支持事务的,在使用时候能有效保证数据的一致性。

有两种方式保存数据

作为缓存使用时,一般 有两种方式保存数据 :

方案一:读取前,先去读Redis,如果没有数据,读取数据库,将数据拉入Redis

实施起来简单,但是有两个需要注意的地方:

- 避免缓存击穿。(数据库没有就需要命中的数据,导致Redis一直没有数据,而一直命中数据库。)

- 数据的实时性相对会差一点。

方案二:插入数据时,同时写入Redis

- 数据实时性强,但是开发时不便于统一处理。

当然,两种方式根据实际情况来适用。如: 方案一适用于对于数据实时性要求不是特别高的场景。方案二适用于字典表、数据量不大的数据存储。

限时业务的运用

redis中可以使用 expire 命令设置一个键的生存时间,到时间后redis会删除它。利用这一特性可以 运用在限时的优惠活动信息、手机验证码 等业务场景。

计数器相关问题

redis由于 incrby 命令可以实现 原子性的递增 ,所以可以 运用于高并发的秒杀活动、分布式序列号的生成、具体业务还体现在比如限制一个手机号发多少条短信、一个接口一分钟限制多少请求、一个接口一天限制调用多少次 等等。

int类型,incr方法

例如: 文章的阅读量、微博点赞数、允许一定的延迟,先写入Redis再定时同步到数据库 。

分布式锁

这个主要利用redis的 setnx 命令进行,setnx:"set if not exists"就是如果不存在则成功设置缓存同时返回1,否则返回0 ,这个特性在很多后台中都有所运用,因为我们服务器是集群的,定时任务可能在两台机器上都会运行,所以在定时任务中首先 通过setnx设置一个lock, 如果成功设置则执行,如果没有成功设置,则表明该定时任务已执行。当然结合具体业务,我们可以给这个lock加一个过期时间,比如说30分钟执行一次的定时任务,那么这个过期时间设置为小于30分钟的一个时间就可以,这个与定时任务的周期以及定时任务执行消耗时间相关。

String 类型setnx方法,只有不存在时才能添加成功,返回true

public static boolean getLock(String key) {

Long flag = jedis.setnx(key, "1");

if (flag == 1) {

jedis.expire(key, 10);

}

return flag == 1;

}

public static void releaseLock(String key) {

jedis.del(key);

}

在分布式锁的场景中,主要用在比如秒杀系统等。

延时操作

比如 在订单生产后我们占用了库存,10分钟后去检验用户是否真正购买,如果没有购买将该单据设置无效,同时还原库存。 由于redis自2.8.0之后版本提供Keyspace Notifications功能,允许客户订阅Pub/Sub频道,以便以某种方式接收影响Redis数据集的事件。所以我们对于上面的需求就可以用以下解决方案,我们 在订单生产时,设置一个key,同时设置10分钟后过期, 我们在后台实现一个监听器,监听key的实效,监听到key失效时将后续逻辑加上。

当然我们也可以利用 rabbitmq、activemq 等消息中间件的 延迟队列服务 实现该需求。

排行榜相关问题

关系型数据库在排行榜方面查询速度普遍偏慢,所以可以借助redis的 SortedSet 进行热点数据的排序。

比如点赞排行榜,做一个SortedSet, 然后以用户的openid作为上面的username, 以用户的点赞数作为上面的score, 然后针对每个用户做一个hash, 通过zrangebyscore就可以按照点赞数获取排行榜,然后再根据username获取用户的hash信息,这个当时在实际运用中性能体验也蛮不错的。

点赞、好友等相互关系的存储

Redis 利用集合的一些命令,比如 求交集、并集、差集 等。

在微博应用中,每个用户关注的人存在一个集合中,就很容易实现求两个人的共同好友功能。

假如上面的微博ID是t1001,用户ID是u3001

用 like:t1001 来维护 t1001 这条微博的所有点赞用户

点赞了这条微博:sadd like:t1001 u3001

取消点赞:srem like:t1001 u3001

是否点赞:sismember like:t1001 u3001

点赞的所有用户:smembers like:t1001

点赞数:scard like:t1001

是不是比数据库简单多了。 7000字 Redis 超详细总结笔记 !建议收藏

简单队列

由于Redis有 list push和list pop 这样的命令,所以能够很方便的执行队列操作。

List提供了两个阻塞的弹出操作:blpop/brpop,可以设置超时时间

- blpop:blpop key1 timeout 移除并获取列表的第一个元素,如果列表没有元素会阻塞列表直到等待超时或发现可弹出元素为止。

- brpop:brpop key1 timeout 移除并获取列表的最后一个元素,如果列表没有元素会阻塞列表直到等待超时或发现可弹出元素为止。

上面的操作。其实就是java的阻塞队列。学习的东西越多。学习成本越低

队列:先进先除:rpush blpop,左头右尾,右边进入队列,左边出队列

栈:先进后出:rpush brpop

更多关于Redis的应用场景解析请参阅: Redis 16 大应用场景

Redis为什么这么快

1、 完全基于内存,绝大部分请求是纯粹的内存操作 ,非常快速。数据存在内存中,类似于 HashMap,HashMap 的优势就是查找和操作的时间复杂度都是O(1);

2、 数据结构简单,对数据操作也简单 ,Redis 中的数据结构是专门进行设计的;

3、 采用单线程 ,避免了不必要的上下文切换和竞争条件,也不存在多进程或者多线程导致的切换而消耗 CPU,不用去考虑各种锁的问题,不存在加锁释放锁操作,没有因为可能出现死锁而导致的性能消耗;

4、 使用多路 I/O 复用模型,非阻塞 IO ;

5、使用底层模型不同,它们之间底层实现方式以及与客户端之间通信的应用协议不一样, Redis 直接自己构建了 VM 机制 ,因为一般的系统调用系统函数的话,会浪费一定的时间去移动和请求;

Redis 为什么是单线程的?

- 代码更清晰,处理逻辑更简单;

- 不用考虑各种锁的问题,不存在加锁和释放锁的操作,没有因为可能出现死锁而导致的性能问题;

- 不存在多线程切换而消耗CPU;

- 无法发挥多核CPU的优势,但可以采用多开几个Redis实例来完善;

Redis真的是单线程的吗?

- Redis6.0之前是单线程的,Redis6.0之后开始支持多线程;

- Redis内部使用了基于epoll的多路复用,也可以多部署几个Redis服务器解决单线程的问题;

- Redis主要的性能瓶颈是内存和网络;

- 内存好说,加内存条就行了,而网络才是大麻烦,所以Redis6内存好说,加内存条就行了;

- 而网络才是大麻烦,所以Redis6.0引入了多线程的概念;

- Redis6.0在网络IO处理方面引入了多线程,如网络数据的读写和协议解析等,需要注意的是,执行命令的核心模块还是单线程的;

Redis 安装

Linux下安装Redis

下载安装

# 安装gcc

yum install gcc

# 下载redis wget下载或者直接去 http://redis.io/download 官网下载

wget http://download.redis.io/releases/redis-7.0.0.tar.gz

# 把下载好的redis解压

tar xzf redis-7.0.0.tar.gz

# 进入到解压好的redis-7.0.0.tar.gz目录下,进行编译与安装

cd redis-7.0.0.tar.gz

make

make install

修改配置文件

按需修改自己想要的redis配置。

# 编辑redis.conf配置文件

vim redis.conf

# Redis使用后台模式

daemonize yes

# 关闭保护模式

protected-mode no

# 注释以下内容开启远程访问

# bind 127.0.0.1

# 修改启动端口为6381

port 6381

启动Redis

# 启动并指定配置文件

src/redis‐server redis.conf(注意要使用后台启动,所以修改redis.conf里的daemonize改为yes)

# 验证启动是否成功

ps -ef|grep redis

# 进入redis客户端

src/redis-cli

redis-cli -h 192.168.239.131 -p 6379 (指定ip 端口连接redis)

# 退出客户端

quit

# 退出redis服务

pkill redis‐server

kill 进程号

src/redis‐cli shutdown

# 设置redis密码

config set requirepass 123456

# 验证密码

auth 123456

# 查看密码

config get requirepass

Windows 下安装 Redis

下载安装

下载地址:https://github.com/MicrosoftArchive/redis/tags

直接下载 Redis-x64-3.2.100.msi 版本即可,双击安装:

都选择默认即可,下一步、下一步安装就行了,非常的简单。

然后可以去连接一下,cmd窗口输入命令telnet 127.0.0.1 6379

正常连接,也可以正常操作

Redis.conf 详解

找到启动时指定的配置文件(redis.conf):

单位

# Redis configuration file example.

#

# Note that in order to read the configuration file, Redis must be

# started with the file path as first argument:

#

# ./redis-server /path/to/redis.conf

# Note on units: when memory size is needed, it is possible to specify

# it in the usual form of 1k 5GB 4M and so forth:

#

# 1k => 1000 bytes

# 1kb => 1024 bytes

# 1m => 1000000 bytes

# 1mb => 1024*1024 bytes

# 1g => 1000000000 bytes

# 1gb => 1024*1024*1024 bytes

#

# units are case insensitive so 1GB 1Gb 1gB are all the same.

配置文件中 unit 单位对大小写不敏感。

包含

################################## INCLUDES ###################################

# Include one or more other config files here. This is useful if you

# have a standard template that goes to all Redis servers but also need

# to customize a few per-server settings. Include files can include

# other files, so use this wisely.

#

# Notice option "include" won't be rewritten by command "CONFIG REWRITE"

# from admin or Redis Sentinel. Since Redis always uses the last processed

# line as value of a configuration directive, you'd better put includes

# at the beginning of this file to avoid overwriting config change at runtime.

#

# If instead you are interested in using includes to override configuration

# options, it is better to use include as the last line.

#

# include /path/to/local.conf

# include /path/to/other.conf

配置文件可以将多个配置文件合起来使用。

NETWORK 网络

bind 127.0.0.1 #绑定的 IP

protected-mode no #保护模式

port 6379 #端口设置

GENERAL 通用

daemonize yes # 以守护进程的方式运行,默认是 no ,我们需要自己开启为 yes

pidfile /var/run/redis_6379.pid # 如果是后台启动,我们需要指定一个pid 文件

# 日志级别

# Specify the server verbosity level.

# This can be one of:

# debug (a lot of information, useful for development/testing)

# verbose (many rarely useful info, but not a mess like the debug level)

# notice (moderately verbose, what you want in production probably)

# warning (only very important / critical messages are logged)

loglevel notice

logfile "" # 日志文件的位置

databases 16 # 数据库的数量,默认是 16

always-show-logo yes # 是否总是显示 LOGO

快照 SNAPSHOTTING

持久化, 在规定的时间内,执行了多少次操作则会持久化到文件 。

Redis 是内存数据库, 如果没有持久化,那么数据断电即失 。

################################ SNAPSHOTTING ################################

#

# Save the DB on disk:

#

# save <seconds> <changes>

#

# Will save the DB if both the given number of seconds and the given

# number of write operations against the DB occurred.

#

# In the example below the behaviour will be to save:

# after 900 sec (15 min) if at least 1 key changed

# after 300 sec (5 min) if at least 10 keys changed

# after 60 sec if at least 10000 keys changed

#

# Note: you can disable saving completely by commenting out all "save" lines.

#

# It is also possible to remove all the previously configured save

# points by adding a save directive with a single empty string argument

# like in the following example:

#

# save ""

# 如果 900s 内,至少有 1 个 key 进行了修改,进行持久化操作

save 900 1

# 如果 300s 内,至少有 10 个 key 进行了修改,进行持久化操作

save 300 10

save 60 10000

stop-writes-on-bgsave-error yes # 如果持久化出错,是否还要继续工作

rdbcompression yes # 是否压缩 rdb 文件,需要消耗一些 cpu 资源

rdbchecksum yes # 保存 rdb 文件的时候,进行错误的检查校验

dir ./ # rdb 文件保存的目录

SECURITY 安全

可以 设置 Redis 的密码 ,默认是没有密码的。

[root@xxx bin]# redis-cli -p 6379

127.0.0.1:6379> ping

PONG

127.0.0.1:6379> config get requirepass # 获取 redis 密码

1) "requirepass"

2) ""

127.0.0.1:6379> config set requirepass "123456" # 设置 redis 密码

OK

127.0.0.1:6379> ping

(error) NOAUTH Authentication required. # 发现所有的命令都没有权限了

127.0.0.1:6379> auth 123456 # 使用密码登录

OK

127.0.0.1:6379> config get requirepass

1) "requirepass"

2) "123456"

127.0.0.1:6379>

CLIENTS 限制

################################### CLIENTS ####################################

# Set the max number of connected clients at the same time. By default

# this limit is set to 10000 clients, however if the Redis server is not

# able to configure the process file limit to allow for the specified limit

# the max number of allowed clients is set to the current file limit

# minus 32 (as Redis reserves a few file descriptors for internal uses).

#

# Once the limit is reached Redis will close all the new connections sending

# an error 'max number of clients reached'.

#

# maxclients 10000 # 设置能链接上 redis 的最大客户端数量

# maxmemory <bytes> # redis 设置最大的内存容量

maxmemory-policy noeviction # 内存达到上限之后的处理策略

- noeviction:当内存使用达到阈值的时候,所有引起申请内存的命令会报错。

- allkeys-lru:在所有键中采用lru算法删除键,直到腾出足够内存为止。

- volatile-lru:在设置了过期时间的键中采用lru算法删除键,直到腾出足够内存为止。

- allkeys-random:在所有键中采用随机删除键,直到腾出足够内存为止。

- volatile-random:在设置了过期时间的键中随机删除键,直到腾出足够内存为止。

- volatile-ttl:在设置了过期时间的键空间中,具有更早过期时间的key优先移除。

APPEND ONLY 模式 AOF 配置

appendonly no # 默认是不开启 AOF 模式的,默认使用 rdb 方式持久化,大部分情况下,rdb 完全够用

appendfilename "appendonly.aof" # 持久化的文件的名字

# appendfsync always # 每次修改都会 sync 消耗性能

appendfsync everysec # 每秒执行一次 sync 可能会丢失这 1s 的数据。

# appendfsync no # 不执行 sync 这个时候操作系统自己同步数据,速度最快。

参考来源:

https://www.pdai.tech/md/db/nosql-redis/db-redis-overview.html

https://www.cnblogs.com/itzhouq/p/redis4.html

拓展

(二):Redis 9 种数据类型和应用场景

Redis 数据结构简介

Redis 基础文章非常多,关于 基础数据结构类型 ,我推荐你先看下官方网站内容,然后再看下面的小结。

首先对 redis 来说,所有的 key(键)都是字符串。我们在谈基础数据结构时,讨论的是存储值的数据类型,主要包括常见的5种数据类型,分别是:String、List、Set、Zset、Hash。

5 种基础数据类型

内容其实比较简单,我觉得理解的重点在于这个结构怎么用,能够用来做什么?所以我在梳理时,围绕图例,命令,执行和场景来阐述。

String 字符串

String是redis中最基本的数据类型,一个key对应一个value。

String 类型是 二进制安全的 ,意思是 redis 的 string 可以包含任何数据。如数字,字符串,jpg图片或者序列化的对象。

图例

下图是一个String类型的实例,其中键为hello,值为world图片

命令使用

命令执行

127.0.0.1:6379> set hello world

OK

127.0.0.1:6379> get hello

"world"

127.0.0.1:6379> del hello

(integer) 1

127.0.0.1:6379> get hello

(nil)

127.0.0.1:6379> set counter 2

OK

127.0.0.1:6379> get counter

"2"

127.0.0.1:6379> incr counter

(integer) 3

127.0.0.1:6379> get counter

"3"

127.0.0.1:6379> incrby counter 100

(integer) 103

127.0.0.1:6379> get counter

"103"

127.0.0.1:6379> decr counter

(integer) 102

127.0.0.1:6379> get counter

"102"

实战场景

- 缓存 :经典使用场景,把常用信息,字符串,图片或者视频等信息放到redis中,redis 作为缓存层,mysql做持久化层,降低mysql的读写压力。

- 计数器 :redis是单线程模型,一个命令执行完才会执行下一个,同时数据可以一步落地到其他的数据源。

- session :常见方案spring session + redis实现session共享。

List列表

Redis 中的 List 其实就是 链表 (Redis 用 双端链表 实现 List )。

使用 List 结构,我们可以轻松地实现 最新消息排队功能 (比如新浪微博的TimeLine)。List 的另一个应用就是消息队列,可以利用List的 PUSH 操作,将任务存放在 List 中,然后工作线程再用 POP 操作将任务取出进行执行。

图例

命令使用

使用列表的技巧

- lpush+lpop=Stack(栈)

- lpush+rpop=Queue(队列)

- lpush+ltrim=Capped Collection(有限集合)

- lpush+brpop=Message Queue(消息队列)

命令执行

127.0.0.1:6379> lpush mylist 1 2 ll ls mem

(integer) 5

127.0.0.1:6379> lrange mylist 0 -1

1) "mem"

2) "ls"

3) "ll"

4) "2"

5) "1"

127.0.0.1:6379> lindex mylist -1

"1"

127.0.0.1:6379> lindex mylist 10 # index不在 mylist 的区间范围内

(nil)

实战场景

- 微博TimeLine : 有人发布微博,用lpush加入时间轴,展示新的列表信息。

- 消息队列

Set集合

Redis 的 Set 是 String 类型的 无序集合 。集合成员是唯一的,这就意味着 集合中不能出现重复的数据。

Redis 中集合是通过 哈希表 实现的,所以 添加,删除,查找的复杂度都是 O(1) 。

图例

命令使用

命令执行

127.0.0.1:6379> sadd myset hao hao1 xiaohao hao

(integer) 3

127.0.0.1:6379> smembers myset

1) "xiaohao"

2) "hao1"

3) "hao"

127.0.0.1:6379> sismember myset hao

(integer) 1

实战场景

- 标签(tag) ,给用户添加标签,或者用户给消息添加标签,这样有同一标签或者类似标签的可以给推荐关注的事或者关注的人。

- 点赞,或点踩,收藏等 ,可以放到set中实现

Hash散列

Redis hash 是一个 string 类型的 field(字段) 和 value(值) 的映射表 ,hash 特别适合用于 存储对象 。

图例

命令使用

命令执行

127.0.0.1:6379> hset user name1 hao

(integer) 1

127.0.0.1:6379> hset user email1 hao@163.com

(integer) 1

127.0.0.1:6379> hgetall user

1) "name1"

2) "hao"

3) "email1"

4) "hao@163.com"

127.0.0.1:6379> hget user user

(nil)

127.0.0.1:6379> hget user name1

"hao"

127.0.0.1:6379> hset user name2 xiaohao

(integer) 1

127.0.0.1:6379> hset user email2 xiaohao@163.com

(integer) 1

127.0.0.1:6379> hgetall user

1) "name1"

2) "hao"

3) "email1"

4) "hao@163.com"

5) "name2"

6) "xiaohao"

7) "email2"

8) "xiaohao@163.com"

实战场景

- 缓存 :能直观,相比string更节省空间,的维护缓存信息,如用户信息,视频信息等。

Zset有序集合

Redis 有序集合和集合一样也是 string 类型元素的集合,且 不允许重复的成员 。 不同的是每个元素都会关联一个 double 类型的分数 。redis 正是通过分数来为集合中的成员进行从小到大的排序。

有序集合的成员是唯一的, 但分数(score)却可以重复。 有序集合是通过 两种数据结构 实现:

- 压缩列表(ziplist) : ziplist是为了提高存储效率而设计的一种特殊编码的双向链表。它可以存储字符串或者整数,存储整数时是采用整数的二进制而不是字符串形式存储。它能在O(1)的时间复杂度下完成list两端的push和pop操作。但是因为每次操作都需要重新分配ziplist的内存,所以实际复杂度和ziplist的内存使用量相关

- 跳跃表(zSkiplist) : 跳跃表的性能可以保证在查找,删除,添加等操作的时候在对数期望时间内完成,这个性能是可以和平衡树来相比较的,而且在实现方面比平衡树要优雅,这是采用跳跃表的主要原因。跳跃表的复杂度是O(log(n))。

图例

命令使用

命令执行

127.0.0.1:6379> zadd myscoreset 100 hao 90 xiaohao

(integer) 2

127.0.0.1:6379> ZRANGE myscoreset 0 -1

1) "xiaohao"

2) "hao"

127.0.0.1:6379> ZSCORE myscoreset hao

"100"

实战场景

- 排行榜 :有序集合经典使用场景。例如小说视频等网站需要对用户上传的小说视频做排行榜,榜单可以按照用户关注数,更新时间,字数等打分,做排行。

3 种特殊类型

Redis 除了上文中 5 种基础数据类型 ,还有 3 种特殊的数据类型 ,分别是 HyperLogLogs(基数统计), Bitmaps (位图) 和 geospatial (地理位置) 。

HyperLogLogs(基数统计)

Redis 2.8.9 版本更新了 Hyperloglog 数据结构!

什么是基数?

举个例子, A = {1, 2, 3, 4, 5}, B = {3, 5, 6, 7, 9};那么 基数(不重复的元素)= 1, 2, 4, 6, 7, 9 ;( 允许容错,即可以接受一定误差 )

HyperLogLogs 基数统计用来解决什么问题?

这个结构可以 非常省内存的去统计各种计数 ,比如 注册 IP 数、每日访问 IP 数、页面实时UV、在线用户数,共同好友数 等。

它的优势体现在哪?

一个大型的网站,每天 IP 比如有 100 万,粗算一个 IP 消耗 15 字节,那么 100 万个 IP 就是 15M。而 HyperLogLog 在 Redis 中每个键占用的内容都是 12K,理论存储近似接近 2^64 个值,不管存储的内容是什么,它一个基于基数估算的算法,只能比较准确的估算出基数,可以使用少量固定的内存去存储并识别集合中的唯一元素。而且这个估算的基数并不一定准确,是一个带有 0.81% 标准错误的近似值(对于可以接受一定容错的业务场景,比如IP数统计,UV 等,是可以忽略不计的)。

相关命令使用

127.0.0.1:6379> pfadd key1 a b c d e f g h i # 创建第一组元素

(integer) 1

127.0.0.1:6379> pfcount key1 # 统计元素的基数数量

(integer) 9

127.0.0.1:6379> pfadd key2 c j k l m e g a # 创建第二组元素

(integer) 1

127.0.0.1:6379> pfcount key2

(integer) 8

127.0.0.1:6379> pfmerge key3 key1 key2 # 合并两组:key1 key2 -> key3 并集

OK

127.0.0.1:6379> pfcount key3

(integer) 13

Bitmap (位存储)

Bitmap 即 位图数据结构 ,都是 操作二进制位 来进行记录,只有 0 和 1 两个状态。

用来解决什么问题?

比如: 两个状态统计用户信息,活跃,不活跃!登录,未登录!打卡,不打卡! 的,都可以使用 Bitmaps!

如果存储一年的打卡状态需要多少内存呢?365 天 = 365 bit 1字节 = 8bit 46 个字节左右!

相关命令使用

使用bitmap 来记录 周一到周日的打卡 !周一:1 周二:0 周三:0 周四:1 …

127.0.0.1:6379> setbit sign 0 1

(integer) 0

127.0.0.1:6379> setbit sign 1 1

(integer) 0

127.0.0.1:6379> setbit sign 2 0

(integer) 0

127.0.0.1:6379> setbit sign 3 1

(integer) 0

127.0.0.1:6379> setbit sign 4 0

(integer) 0

127.0.0.1:6379> setbit sign 5 0

(integer) 0

127.0.0.1:6379> setbit sign 6 1

(integer) 0

查看某一天是否有打卡!

127.0.0.1:6379> getbit sign 3

(integer) 1

127.0.0.1:6379> getbit sign 5

(integer) 0

统计操作,统计 打卡的天数!

127.0.0.1:6379> bitcount sign # 统计这周的打卡记录,就可以看到是否有全勤!

(integer) 3

geospatial (地理位置)

Redis 的 Geo 在 Redis 3.2 版本就推出了! 这个功能可以推算地理位置的信息: 两地之间的距离, 方圆几里的人

geoadd 添加地理位置

127.0.0.1:6379> geoadd china:city 118.76 32.04 manjing 112.55 37.86 taiyuan 123.43 41.80 shenyang

(integer) 3

127.0.0.1:6379> geoadd china:city 144.05 22.52 shengzhen 120.16 30.24 hangzhou 108.96 34.26 xian

(integer) 3

规则

两级无法直接添加,我们一般会下载城市数据(这个网址可以查询 GEO:http://www.jsons.cn/lngcode)!

- 有效的经度从-180度到180度。

- 有效的纬度从-85.05112878度到85.05112878度。

# 当坐标位置超出上述指定范围时,该命令将会返回一个错误。

127.0.0.1:6379> geoadd china:city 39.90 116.40 beijin

(error) ERR invalid longitude,latitude pair 39.900000,116.400000

geopos 获取指定的成员的经度和纬度

127.0.0.1:6379> geopos china:city taiyuan manjing

1) 1) "112.54999905824661255"

1) "37.86000073876942196"

2) 1) "118.75999957323074341"

1) "32.03999960287850968"

获得当前定位, 一定是一个坐标值!

geodist

如果不存在, 返回空。

单位如下:

- m

- km

- mi 英里

- ft 英尺

127.0.0.1:6379> geodist china:city taiyuan shenyang m

"1026439.1070"

127.0.0.1:6379> geodist china:city taiyuan shenyang km

"1026.4391"

georadius

附近的人 ==> 获得所有附近的人的地址, 定位, 通过半径来查询。

获得指定数量的人

127.0.0.1:6379> georadius china:city 110 30 1000 km 以 100,30 这个坐标为中心, 寻找半径为1000km的城市

1) "xian"

2) "hangzhou"

3) "manjing"

4) "taiyuan"

127.0.0.1:6379> georadius china:city 110 30 500 km

1) "xian"

127.0.0.1:6379> georadius china:city 110 30 500 km withdist

1) 1) "xian"

2) "483.8340"

127.0.0.1:6379> georadius china:city 110 30 1000 km withcoord withdist count 2

1) 1) "xian"

2) "483.8340"

3) 1) "108.96000176668167114"

2) "34.25999964418929977"

2) 1) "manjing"

2) "864.9816"

3) 1) "118.75999957323074341"

2) "32.03999960287850968"

参数:key 经度 纬度 半径 单位 [显示结果的经度和纬度] [显示结果的距离] [显示的结果的数量]

georadiusbymember

显示与指定成员一定半径范围内的其他成员

127.0.0.1:6379> georadiusbymember china:city taiyuan 1000 km

1) "manjing"

2) "taiyuan"

3) "xian"

127.0.0.1:6379> georadiusbymember china:city taiyuan 1000 km withcoord withdist count 2

1) 1) "taiyuan"

2) "0.0000"

3) 1) "112.54999905824661255"

2) "37.86000073876942196"

2) 1) "xian"

2) "514.2264"

3) 1) "108.96000176668167114"

2) "34.25999964418929977"

参数与 georadius 一样

geohash(较少使用)

该命令返回11个字符的hash字符串

127.0.0.1:6379> geohash china:city taiyuan shenyang

1) "ww8p3hhqmp0"

2) "wxrvb9qyxk0"

将二维的经纬度转换为一维的字符串, 如果两个字符串越接近, 则距离越近

底层

geo 底层的实现原理 实际上就是 Zset , 我们可以通过 Zset命令来操作 geo。

127.0.0.1:6379> type china:city

zset

查看全部元素 删除指定的元素

127.0.0.1:6379> zrange china:city 0 -1 withscores

1) "xian"

2) "4040115445396757"

3) "hangzhou"

4) "4054133997236782"

5) "manjing"

6) "4066006694128997"

7) "taiyuan"

8) "4068216047500484"

9) "shenyang"

1) "4072519231994779"

2) "shengzhen"

3) "4154606886655324"

127.0.0.1:6379> zrem china:city manjing

(integer) 1

127.0.0.1:6379> zrange china:city 0 -1

1) "xian"

2) "hangzhou"

3) "taiyuan"

4) "shenyang"

5) "shengzhen"

Stream 类型

为什么会设计Stream

Redis5.0 中还增加了一个数据结构 Stream,从字面上看是 流类型 ,但其实从功能上看,应该是 Redis 对消息队列(MQ,Message Queue)的完善实现 。

Reids 的消息队列

用过 Redis 做消息队列的都了解,基于 Reids 的消息队列实现有很多种,例如:

PUB/SUB,订阅/发布模式

- 但是发布订阅模式是无法持久化的,如果出现网络断开、Redis 宕机等,消息就会被丢弃;

基于List LPUSH+BRPOP 或者 基于Sorted-Set的实现

- 支持了持久化,但是不支持多播,分组消费等

设计一个消息队列需要考虑什么?

为什么上面的结构无法满足广泛的MQ场景? 这里便引出一个核心的问题:如果我们期望设计一种数据结构来实现消息队列,最重要的就是要理解设计一个消息队列需要考虑什么?初步的我们很容易想到

- 消息的生产

- 消息的消费

- 单播和多播(多对多)

- 阻塞和非阻塞读取

- 消息有序性

- 消息的持久化

其它还要考虑啥嗯?借助美团技术团队的一篇文章,消息队列设计精要中的图片

我们不妨看看Redis考虑了哪些设计?

- 消息ID的序列化生成

- 消息遍历

- 消息的阻塞和非阻塞读取

- 消息的分组消费

- 未完成消息的处理

- 消息队列监控

- …

这也是我们需要理解Stream的点,但是结合上面的图,我们也应该理解 Redis Stream也是一种超轻量MQ并没有完全实现消息队列所有设计要点,这决定着它适用的场景。

Stream详解

经过梳理总结,我认为从以下几个大的方面去理解Stream是比较合适的,总结如下:

- Stream的结构设计

- 生产和消费

- 基本的增删查改

- 单一消费者的消费

- 消费组的消费

- 监控状态

Stream的结构

每个 Stream 都有唯一的名称,它就是 Redis 的 key,在我们首次使用 xadd 指令追加消息时自动创建。

上图解析:

- Consumer Group :消费组 ,使用 XGROUP CREATE 命令创建,一个消费组有多个消费者(Consumer), 这些消费者之间是竞争关系。

- last_delivered_id :游标 ,每个消费组会有个游标 last_delivered_id,任意一个消费者读取了消息都会使游标 last_delivered_id 往前移动。

- pending_ids :消费者(Consumer)的状态变量 ,作用是维护消费者的未确认的 id。 pending_ids 记录了当前已经被客户端读取的消息,但是还没有 ack (Acknowledge character:确认字符)。如果客户端没有ack,这个变量里面的消息ID会越来越多,一旦某个消息被ack,它就开始减少。这个pending_ids变量在Redis官方被称之为PEL,也就是Pending Entries List,这是一个很核心的数据结构,它用来确保客户端至少消费了消息一次,而不会在网络传输的中途丢失了没处理。

此外我们 还需要理解两点 :

- 消息ID : 消息ID的形式是timestampInMillis-sequence,例如1527846880572-5,它表示当前的消息在毫米时间戳1527846880572时产生,并且是该毫秒内产生的第5条消息。消息ID可以由服务器自动生成,也可以由客户端自己指定,但是形式必须是整数-整数,而且必须是后面加入的消息的ID要大于前面的消息ID。

- 消息内容 : 消息内容就是键值对,形如hash结构的键值对,这没什么特别之处。

增删改查

消息队列相关命令:

XADD #添加消息到末尾

XTRIM # 对流进行修剪,限制长度

XDEL #删除消息

XLEN #获取流包含的元素数量,即消息长度

XRANGE #获取消息列表,会自动过滤已经删除的消息

XREVRANGE #反向获取消息列表,ID 从大到小

XREAD #以阻塞或非阻塞方式获取消息列表

# *号表示服务器自动生成ID,后面顺序跟着一堆key/value

127.0.0.1:6379> xadd codehole * name laoqian age 30 # 名字叫laoqian,年龄30岁

1527849609889-0 # 生成的消息ID

127.0.0.1:6379> xadd codehole * name xiaoyu age 29

1527849629172-0

127.0.0.1:6379> xadd codehole * name xiaoqian age 1

1527849637634-0

127.0.0.1:6379> xlen codehole

(integer) 3

127.0.0.1:6379> xrange codehole - + # -表示最小值, +表示最大值

127.0.0.1:6379> xrange codehole - +

1) 1) 1527849609889-0

1) 1) "name"

1) "laoqian"

2) "age"

3) "30"

2) 1) 1527849629172-0

1) 1) "name"

1) "xiaoyu"

2) "age"

3) "29"

3) 1) 1527849637634-0

1) 1) "name"

1) "xiaoqian"

2) "age"

3) "1"

127.0.0.1:6379> xrange codehole 1527849629172-0 + # 指定最小消息ID的列表

1) 1) 1527849629172-0

2) 1) "name"

2) "xiaoyu"

3) "age"

4) "29"

2) 1) 1527849637634-0

2) 1) "name"

2) "xiaoqian"

3) "age"

4) "1"

127.0.0.1:6379> xrange codehole - 1527849629172-0 # 指定最大消息ID的列表

1) 1) 1527849609889-0

2) 1) "name"

2) "laoqian"

3) "age"

4) "30"

2) 1) 1527849629172-0

2) 1) "name"

2) "xiaoyu"

3) "age"

4) "29"

127.0.0.1:6379> xdel codehole 1527849609889-0

(integer) 1

127.0.0.1:6379> xlen codehole # 长度不受影响

(integer) 3

127.0.0.1:6379> xrange codehole - + # 被删除的消息没了

1) 1) 1527849629172-0

2) 1) "name"

2) "xiaoyu"

3) "age"

4) "29"

2) 1) 1527849637634-0

2) 1) "name"

2) "xiaoqian"

3) "age"

4) "1"

127.0.0.1:6379> del codehole # 删除整个Stream

(integer) 1

独立消费

我们可以在不定义消费组的情况下进行Stream消息的独立消费,当Stream没有新消息时,甚至可以阻塞等待。 Redis设计了一个单独的消费指令 xread ,可以将Stream当成普通的消息队列(list)来使用。使用xread时,我们可以完全忽略消费组(Consumer Group)的存在,就好比Stream就是一个普通的列表(list)。

# 从Stream头部读取两条消息

127.0.0.1:6379> xread count 2 streams codehole 0-0

1) 1) "codehole"

2) 1) 1) 1527851486781-0

2) 1) "name"

2) "laoqian"

3) "age"

4) "30"

2) 1) 1527851493405-0

2) 1) "name"

2) "yurui"

3) "age"

4) "29"

# 从Stream尾部读取一条消息,毫无疑问,这里不会返回任何消息

127.0.0.1:6379> xread count 1 streams codehole $

(nil)

# 从尾部阻塞等待新消息到来,下面的指令会堵住,直到新消息到来

127.0.0.1:6379> xread block 0 count 1 streams codehole $

# 我们从新打开一个窗口,在这个窗口往Stream里塞消息

127.0.0.1:6379> xadd codehole * name youming age 60

1527852774092-0

# 再切换到前面的窗口,我们可以看到阻塞解除了,返回了新的消息内容

# 而且还显示了一个等待时间,这里我们等待了93s

127.0.0.1:6379> xread block 0 count 1 streams codehole $

1) 1) "codehole"

2) 1) 1) 1527852774092-0

2) 1) "name"

2) "youming"

3) "age"

4) "60"

(93.11s)

客户端如果想要使用xread进行顺序消费,一定要记住当前消费到哪里了,也就是返回的消息ID。 下次继续调用xread时,将上次返回的最后一个消息ID作为参数传递进去,就可以继续消费后续的消息。

block 0表示永远阻塞,直到消息到来,block 1000表示阻塞1s,如果1s内没有任何消息到来,就返回nil

127.0.0.1:6379> xread block 1000 count 1 streams codehole $

(nil)

(1.07s)

消费组消费

消费组消费图

相关命令:

XGROUP CREATE #创建消费者组

XREADGROUP GROUP #读取消费者组中的消息

XACK - #将消息标记为"已处理"

XGROUP SETID #为消费者组设置新的最后递送消息ID

XGROUP DELCONSUMER #删除消费者

XGROUP DESTROY #删除消费者组

XPENDING #显示待处理消息的相关信息

XCLAIM #转移消息的归属权

XINFO #查看流和消费者组的相关信息;

XINFO GROUPS #打印消费者组的信息;

XINFO STREAM #打印流信息

创建消费组

Stream通过xgroup create指令创建消费组(Consumer Group),需要传递起始消息ID参数用来初始化last_delivered_id变量。

127.0.0.1:6379> xgroup create codehole cg1 0-0 # 表示从头开始消费

OK

# $表示从尾部开始消费,只接受新消息,当前Stream消息会全部忽略

127.0.0.1:6379> xgroup create codehole cg2 $

OK

127.0.0.1:6379> xinfo stream codehole # 获取Stream信息

1) length

2) (integer) 3 # 共3个消息

3) radix-tree-keys

4) (integer) 1

5) radix-tree-nodes

6) (integer) 2

7) groups

8) (integer) 2 # 两个消费组

9) first-entry # 第一个消息

10) 1) 1527851486781-0

2) 1) "name"

2) "laoqian"

3) "age"

4) "30"

11) last-entry # 最后一个消息

12) 1) 1527851498956-0

2) 1) "name"

2) "xiaoqian"

3) "age"

4) "1"

127.0.0.1:6379> xinfo groups codehole # 获取Stream的消费组信息

1) 1) name

2) "cg1"

3) consumers

4) (integer) 0 # 该消费组还没有消费者

5) pending

6) (integer) 0 # 该消费组没有正在处理的消息

2) 1) name

2) "cg2"

3) consumers # 该消费组还没有消费者

4) (integer) 0

5) pending

6) (integer) 0 # 该消费组没有正在处理的消息

消费组消费

Stream提供了xreadgroup指令可以进行消费组的组内消费,需要提供消费组名称、消费者名称和起始消息ID。它同xread一样,也可以阻塞等待新消息。读到新消息后,对应的消息ID就会进入消费者的PEL(正在处理的消息)结构里,客户端处理完毕后使用xack指令通知服务器,本条消息已经处理完毕,该消息ID就会从PEL中移除。

# >号表示从当前消费组的last_delivered_id后面开始读

# 每当消费者读取一条消息,last_delivered_id变量就会前进

127.0.0.1:6379> xreadgroup GROUP cg1 c1 count 1 streams codehole >

1) 1) "codehole"

2) 1) 1) 1527851486781-0

2) 1) "name"

2) "laoqian"

3) "age"

4) "30"

127.0.0.1:6379> xreadgroup GROUP cg1 c1 count 1 streams codehole >

1) 1) "codehole"

2) 1) 1) 1527851493405-0

2) 1) "name"

2) "yurui"

3) "age"

4) "29"

127.0.0.1:6379> xreadgroup GROUP cg1 c1 count 2 streams codehole >

1) 1) "codehole"

2) 1) 1) 1527851498956-0

2) 1) "name"

2) "xiaoqian"

3) "age"

4) "1"

2) 1) 1527852774092-0

2) 1) "name"

2) "youming"

3) "age"

4) "60"

# 再继续读取,就没有新消息了

127.0.0.1:6379> xreadgroup GROUP cg1 c1 count 1 streams codehole >

(nil)

# 那就阻塞等待吧

127.0.0.1:6379> xreadgroup GROUP cg1 c1 block 0 count 1 streams codehole >

# 开启另一个窗口,往里塞消息

127.0.0.1:6379> xadd codehole * name lanying age 61

1527854062442-0

# 回到前一个窗口,发现阻塞解除,收到新消息了

127.0.0.1:6379> xreadgroup GROUP cg1 c1 block 0 count 1 streams codehole >

1) 1) "codehole"

2) 1) 1) 1527854062442-0

2) 1) "name"

2) "lanying"

3) "age"

4) "61"

(36.54s)

127.0.0.1:6379> xinfo groups codehole # 观察消费组信息

1) 1) name

2) "cg1"

3) consumers

4) (integer) 1 # 一个消费者

5) pending

6) (integer) 5 # 共5条正在处理的信息还有没有ack

2) 1) name

2) "cg2"

3) consumers

4) (integer) 0 # 消费组cg2没有任何变化,因为前面我们一直在操纵cg1

5) pending

6) (integer) 0

# 如果同一个消费组有多个消费者,我们可以通过xinfo consumers指令观察每个消费者的状态

127.0.0.1:6379> xinfo consumers codehole cg1 # 目前还有1个消费者

1) 1) name

2) "c1"

3) pending

4) (integer) 5 # 共5条待处理消息

5) idle

6) (integer) 418715 # 空闲了多长时间ms没有读取消息了

# 接下来我们ack一条消息

127.0.0.1:6379> xack codehole cg1 1527851486781-0

(integer) 1

127.0.0.1:6379> xinfo consumers codehole cg1

1) 1) name

2) "c1"

3) pending

4) (integer) 4 # 变成了5条

5) idle

6) (integer) 668504

# 下面ack所有消息

127.0.0.1:6379> xack codehole cg1 1527851493405-0 1527851498956-0 1527852774092-0 1527854062442-0

(integer) 4

127.0.0.1:6379> xinfo consumers codehole cg1

1) 1) name

2) "c1"

3) pending

4) (integer) 0 # pel空了

5) idle

6) (integer) 745505

信息监控

Stream 提供了XINFO来实现对服务器信息的监控,可以查询:

查看队列信息

127.0.0.1:6379> Xinfo stream mq

1) "length"

2) (integer) 7

3) "radix-tree-keys"

4) (integer) 1

5) "radix-tree-nodes"

6) (integer) 2

7) "groups"

8) (integer) 1

9) "last-generated-id"

10) "1553585533795-9"

11) "first-entry"

12) 1) "1553585533795-3"

2) 1) "msg"

2) "4"

13) "last-entry"

14) 1) "1553585533795-9"

2) 1) "msg"

2) "10"

消费组信息

127.0.0.1:6379> Xinfo groups mq

1) 1) "name"

2) "mqGroup"

3) "consumers"

4) (integer) 3

5) "pending"

6) (integer) 3

7) "last-delivered-id"

8) "1553585533795-4"

消费者组成员信息

127.0.0.1:6379> XINFO CONSUMERS mq mqGroup

1) 1) "name"

2) "consumerA"

3) "pending"

4) (integer) 1

5) "idle"

6) (integer) 18949894

2) 1) "name"

2) "consumerB"

3) "pending"

4) (integer) 1

5) "idle"

6) (integer) 3092719

3) 1) "name"

2) "consumerC"

3) "pending"

4) (integer) 1

5) "idle"

6) (integer) 23683256

至此,消息队列的操作说明大体结束!

Stream用在什么样场景

可用作 即时通信,大数据分析,异地数据备份 等

客户端可以平滑扩展,提高处理能力

消息ID的设计是否考虑了时间回拨的问题?

在分布式算法 - ID算法设计中, 一个常见的问题就是时间回拨问题,那么Redis的消息ID设计中是否考虑到这个问题呢?

XADD生成的1553439850328-0,就是Redis生成的消息ID,由两部分组成:时间戳-序号。时间戳是毫秒级单位,是生成消息的Redis服务器时间,它是个64位整型(int64)。序号是在这个毫秒时间点内的消息序号,它也是个64位整型。

可以通过multi批处理,来验证序号的递增:

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> XADD memberMessage * msg one

QUEUED

127.0.0.1:6379> XADD memberMessage * msg two

QUEUED

127.0.0.1:6379> XADD memberMessage * msg three

QUEUED

127.0.0.1:6379> XADD memberMessage * msg four

QUEUED

127.0.0.1:6379> XADD memberMessage * msg five

QUEUED

127.0.0.1:6379> EXEC

1) "1553441006884-0"

2) "1553441006884-1"

3) "1553441006884-2"

4) "1553441006884-3"

5) "1553441006884-4"

由于一个redis命令的执行很快,所以可以看到在同一时间戳内,是通过序号递增来表示消息的。

为了保证消息是有序的,因此 Redis 生成的 ID 是单调递增有序的。由于 ID 中包含时间戳部分,为了避免服务器时间错误而带来的问题(例如服务器时间延后了),Redis 的每个 Stream 类型数据都维护一个 latest_generated_id属性,用于记录最后一个消息的ID。 若发现当前时间戳退后(小于latest_generated_id所记录的),则采用时间戳不变而序号递增的方案来作为新消息ID(这也是序号为什么使用int64的原因,保证有足够多的的序号),从而保证ID的单调递增性质。

强烈建议使用Redis的方案生成消息ID,因为这种时间戳+序号的单调递增的ID方案,几乎可以满足你全部的需求。但同时,记住ID是支持自定义的,别忘了!

消费者崩溃带来的会不会消息丢失问题?

为了解决组内消息读取但处理期间消费者崩溃带来的消息丢失问题 ,STREAM 设计了 Pending 列表,用于记录读取但并未处理完毕的消息。命令XPENDIING 用来获消费组或消费内消费者的未处理完毕的消息。演示如下:

127.0.0.1:6379> XPENDING mq mqGroup # mpGroup的Pending情况

1) (integer) 5 # 5个已读取但未处理的消息

2) "1553585533795-0" # 起始ID

3) "1553585533795-4" # 结束ID

4) 1) 1) "consumerA" # 消费者A有3个

2) "3"

2) 1) "consumerB" # 消费者B有1个

2) "1"

3) 1) "consumerC" # 消费者C有1个

2) "1"

127.0.0.1:6379> XPENDING mq mqGroup - + 10 # 使用 start end count 选项可以获取详细信息

1) 1) "1553585533795-0" # 消息ID

2) "consumerA" # 消费者

3) (integer) 1654355 # 从读取到现在经历了1654355ms,IDLE

4) (integer) 5 # 消息被读取了5次,delivery counter

2) 1) "1553585533795-1"

2) "consumerA"

3) (integer) 1654355

4) (integer) 4

# 共5个,余下3个省略 ...

127.0.0.1:6379> XPENDING mq mqGroup - + 10 consumerA # 在加上消费者参数,获取具体某个消费者的Pending列表

1) 1) "1553585533795-0"

2) "consumerA"

3) (integer) 1641083

4) (integer) 5

# 共3个,余下2个省略 ...

**** 每个Pending的消息有4个属性:

- 消息ID

- 所属消费者

- IDLE,已读取时长

- delivery counter,消息被读取次数

上面的结果我们可以看到,我们之前读取的消息,都被记录在Pending列表中,说明全部读到的消息都没有处理,仅仅是读取了。 那如何表示消费者处理完毕了消息呢?使用命令 XACK 完成告知消息处理完成 ,演示如下:

127.0.0.1:6379> XACK mq mqGroup 1553585533795-0 # 通知消息处理结束,用消息ID标识

(integer) 1

127.0.0.1:6379> XPENDING mq mqGroup # 再次查看Pending列表

1) (integer) 4 # 已读取但未处理的消息已经变为4个

2) "1553585533795-1"

3) "1553585533795-4"

4) 1) 1) "consumerA" # 消费者A,还有2个消息处理

2) "2"

2) 1) "consumerB"

2) "1"

3) 1) "consumerC"

2) "1"

127.0.0.1:6379>

有了这样一个Pending机制,就意味着在某个消费者读取消息但未处理后,消息是不会丢失的。等待消费者再次上线后,可以读取该Pending列表,就可以继续处理该消息了,保证消息的有序和不丢失。

消费者彻底宕机后如何转移给其它消费者处理?

还有一个问题,就是若某个消费者宕机之后,没有办法再上线了,那么就需要将该消费者Pending的消息,转义给其他的消费者处理,就是消息转移。

消息转移的操作时将某个消息转移到自己的Pending列表中。使用语法 XCLAIM 来实现,需要设置组、转移的目标消费者和消息ID,同时需要提供IDLE(已被读取时长),只有超过这个时长,才能被转移。演示如下:

# 当前属于消费者A的消息1553585533795-1,已经15907,787ms未处理了

127.0.0.1:6379> XPENDING mq mqGroup - + 10

1) 1) "1553585533795-1"

2) "consumerA"

3) (integer) 15907787

4) (integer) 4

# 转移超过3600s的消息1553585533795-1到消费者B的Pending列表

127.0.0.1:6379> XCLAIM mq mqGroup consumerB 3600000 1553585533795-1

1) 1) "1553585533795-1"

2) 1) "msg"

2) "2"

# 消息1553585533795-1已经转移到消费者B的Pending中。

127.0.0.1:6379> XPENDING mq mqGroup - + 10

1) 1) "1553585533795-1"

2) "consumerB"

3) (integer) 84404 # 注意IDLE,被重置了

4) (integer) 5 # 注意,读取次数也累加了1次

以上代码,完成了一次消息转移。转移除了要指定ID外,还需要指定IDLE,保证是长时间未处理的才被转移。被转移的消息的IDLE会被重置,用以保证不会被重复转移,以为可能会出现将过期的消息同时转移给多个消费者的并发操作,设置了IDLE,则可以避免后面的转移不会成功,因为IDLE不满足条件。例如下面的连续两条转移,第二条不会成功。

127.0.0.1:6379> XCLAIM mq mqGroup consumerB 3600000 1553585533795-1

127.0.0.1:6379> XCLAIM mq mqGroup consumerC 3600000 1553585533795-1

这就是消息转移。至此我们使用了一个 Pending 消息的 ID,所属消费者和IDLE 的属性,还有一个属性就是消息被读取次数,delivery counter,该属性的作用由于统计消息被读取的次数,包括被转移也算。这个属性主要用在判定是否为错误数据上。

坏消息问题,Dead Letter,死信问题

正如上面所说,如果某个消息,不能被消费者处理,也就是不能被XACK,这是要长时间处于Pending列表中,即使被反复的转移给各个消费者也是如此。此时该消息的delivery counter就会累加(上一节的例子可以看到),当累加到某个我们预设的临界值时,我们就认为是坏消息(也叫死信,DeadLetter,无法投递的消息),由于有了判定条件,我们将坏消息处理掉即可,删除即可。删除一个消息,使用XDEL语法,演示如下:

# 删除队列中的消息

127.0.0.1:6379> XDEL mq 1553585533795-1

(integer) 1

# 查看队列中再无此消息

127.0.0.1:6379> XRANGE mq - +

1) 1) "1553585533795-0"

2) 1) "msg"

2) "1"

2) 1) "1553585533795-2"

2) 1) "msg"

2) "3"

注意本例中,并没有删除 Pending 中的消息因此你查看Pending,消息还会在。可以执行 XACK 标识其处理完毕!

参考文章:

https://pdai.tech/md/db/nosql-redis/db-redis-data-type-stream.html

https://pdai.tech/md/db/nosql-redis/db-redis-data-type-special.html

(三):Redis 常用管理命令

redis set key

Redis SET 命令用于给键(key)设置值的。如果 key 已经存储其他值,SET 就覆写旧值。

语法结构如下:

set keyname 值

返回值:设置成功时,返回OK。

实例:

set freekey free;

结果:

redis get

Redis get命令用于获取键(key)中的值的。如果key不存在,返回 nil。

语法结构如下:

get keyname

返回值:返回keyname对应的值,如果key不存在,则返回nil。假如key中存的值不是字符串类型那么返回错误。

实例:

get freekey

结果:

redis -cli

Redis 命令是在redis 服务上执行的。那么要连接redis服务器需要一个redis客户端。Redis 客户端在我们之前下载的的 redis的安装包中。

我们要启动redis客户端,可以在DOS进入redis安装目录,然后通过执行redis -cli来启动客户端,该命令会连接本地的 redis 服务。如下图:

连接远程redis服务器

另起一个cmd,执行客户端连接到redis服务器,即服务端,进行测试,命令如下:

redis-cli.exe -h 127.0.0.1 -p 6379 -a 123456

其中127.0.01是redis的服务器地址,6379是端口,-a 123456是设置的密码。结果如下:

Redis setnx

Redis setnx命令也是用于设置key的值,但是它 和redis set命令有点不一样 。 只在key不存在的情况下, 给key设置,假如key已经存在,那么 redis setnx将啥都不做。

语法结构如下:

setnx keyname value

返回值:命令设置成功返回1,失败返回0。

实例:

setnx nxkey hello

结果:

redis setex

redis setex命令也是用于设置key的值,但是它 和redis set命令有点不一样,它可以额外设置key值的生存周期。

语法结构如下

SETEX key seconds value

返回值:命令成功时返回 OK 。当 seconds 参数不合法时, 命令将返回一个错误。如果key已经存在那么覆盖旧值。

实例

SETEX setexkey 100 hello

–指的是设定setexkey键的生存周期为100秒。

ttl setexkey

–查看setexkey键的剩余时间。

结果:

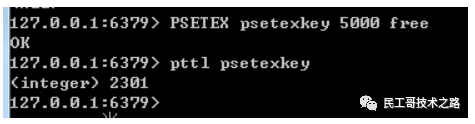

redis psetex

redis psetex命令:用于给redis设置key的值, 并且附带上值的生存时间,不同于setex命令,它设置值的生存时间为毫秒。

语法结构如下:

PSETEX key seconds value

返回值:命令成功时返回 OK 。当 seconds 参数不合法时, 命令将返回一个错误。如果key已经存在那么覆盖旧值。

实例:

PSETEX psetexkey 5000 free

–指的是设定setexkey键的生存周期为1000毫秒。

pttl psetexkey

–查看psetexkey键的剩余时间。

结果:

redis getset

redis getset命令:用于给redis设置key的新值,返回之前旧的key值。如果key值之前不存在,那会报错。

语法结构如下:

getset key value

实例:

–给key设置值

set getsetkey “free”

–给key设置新值

getset getsetkey “free1”

–获取key值

get getsetkey

结果:

redis append

redis append 命令是 用于对redis字符串进行追加,当键值已经存在的情况下,在键值的末尾追加上提供的value值。

语法结构:

append key value

返回值:如果key存在并且是一个字符串,append命令会把value的值追加到原来的键值末尾,并返回现有的字符串长度。

如果key不存在,那么他就直接对key值进行赋值,和set key命令一样。

实例:

–给key设值

set mykey “free”

–在key值后面追加字符

append mykey " redis "

–获取key值

get mykey

结果:

redis mset

redis mset命令用于给redis的键(key)赋值命令。 不同于redis set,它可以一次给多个键同时进行赋值。

语法结构:

mset key1 value1 key2 value2 …

返回值:总是返回OK。和redis set命令一样,当key值存在时,对其值进行覆盖。

实例:

–给key设值

mset mykey1 “free” mykey2 "free redis "

–获取键值

get mykey1

get mykey2

结果:

redis mget

redis mget命令 用于批量获取给定的多个键(key)的值,它是redis mset命令的逆过程。

语法结构:

redis mget key1 key2…

返回值:返回给定的一个或者多个键(key)的值。如果给定的键不存在,那么这个键返回的值将是nil。

实例:

–给key设值

mset mykey1 “free” mykey2 "free redis "

–获取键值

mget mykey1 mykey2

结果:

redis incr

redis incr命令 用于对数值类型的键(key)值进行加1操作,然后返回加1之后的数值。

语法结构:

redis incr key

返回值:

如果key值存在,并为数值类型,那么对其加1进行返回。

如果key值不存在,那么当做0处理,返回1。

如果key值不是数值类型,那么会返回错误。

实例:

–给key设值

set key 2

–给key加1

incr key

–获取key的值

get key

–对不是数值的执行incr结果

set key “free”

incr key

结果:

redis decr

redis decr命令 用于对数值类型的键(key)值进行递减操作(即减1操作),然后返回递减之后的结果值。

语法结构:

decr key

返回值:

如果key值存在,并为数值类型,那么对其递减1,然后返回结果值。

如果key值不存在,那么当做0处理,返回-1。

如果key值不是数值类型,那么会返回错误。

实例:

–给key设值

set key 2

–给key进行递减1

decr key

–获取key的值

get key

–对不是数值的执行decr结果

set key “free”

decr key

结果:

redis lindex key index

redis lindex key index命令主要 用于获取链表类型中指定下标的数据。

语法结构:

lindex key index

#返回链表类型key中下标为index的数据。index表示链表的下标,0表示链表头第一个元素,-1表示链表尾最后一个元素。

返回值:指定链表下标index的元素。如果index指定的下标大于链表的长度,就会报下标越界。

实例:

–给链表插入数据

rpush mylist10 “hello” “free” “redis” “hello”

–获取链表数据

lindex mylist10 0

lindex mylist10 1

lindex mylist10 -1

结果:

redis ltrim

redis ltrim命令主要 用于截取redis链表类型的指定下标区间内的元素,不在指定区间内的元素都会被删除。

语法结构:

ltrim key start end

key:#指定要截取的链表键。

start/end:#指定要截取的区间,start是开始,end是结尾。如ltrim key 0,1表示保留前两个元素,其它元素都删除掉。

start(end)都是表示链表的下标,链表下标是从0开始表示链表头,第一个元素。-1表示链表尾,最后一个元素。

返回值:命令执行成功返回OK,当key不是链表类型时,返回错误。下标区间不能超过链表的长度,会报下标越界错误。

实例:

–给链表插入数据

rpush mylist “hello” “free” “redis” “ok”

–截取中间两个元素

ltrim mylist 1 2

–查看截取后的链表元素

lrange mylist 0 -1

结果:

redis hget

redis hget命令主要用 获取redis哈希表中域(field)的值。

语法结构:

hget key field

获取哈希表key中域(field)的值。

返回值:正常返回给定域的值,如果给定的域不存在,那么返回nil错误。

实例:

–创建一个哈希表

hset myhash field1 “free”

–获取指定域的值

hget myhash field1

结果:

redis hdel

redis hdel命令 用于删除哈希表中指定的域(field),只可以批量移除多个域,不存在的域会被忽略。

语法结构:

hdel hash field field1 …

hash #指定哈希表的键,field是哈希表的域。

返回值:返回被成功移除域的数量,不存在的域不计算在内。

实例:

–创建一个哈希表

hset myhash field1 “free”

hset myhash field2 “redis”

–判断指定的域是否存在

hdel myhash field1 field2 field3

结果:

节选自:https://www.wenjiangs.com/doc/q3km1de9s1t7

(四):Redis 发布与订阅(pub/sub)

什么是发布订阅?

Redis 发布订阅(pub/sub)是一种消息通信模式:发送者(pub)发送消息,订阅者(sub)接收消息。

Redis 的 subscribe 命令可以 让客户端订阅任意数量的频道, 每当有新信息发送到被订阅的频道时, 信息就会被发送给所有订阅指定频道的客户端。

☛ 下图展示了频道 channel1 , 以及订阅这个频道的三个客户端 —— client2 、 client5 和 client1 之间的关系:

☛ 当有新消息通过 publish 命令发送给频道 channel1 时, 这个消息就会被发送给订阅它的三个客户端:

为什么要用发布订阅?

熟悉消息中间件 的同学都知道,针对 消息订阅发布 功能,市面上很多大厂使用的是 kafka、RabbitMQ、ActiveMQ, RocketMQ 等这几种,redis的订阅发布功能跟这三者相比, 相对轻量,针对数据准确和安全性要求没有那么高可以直接使用,适用于小公司。

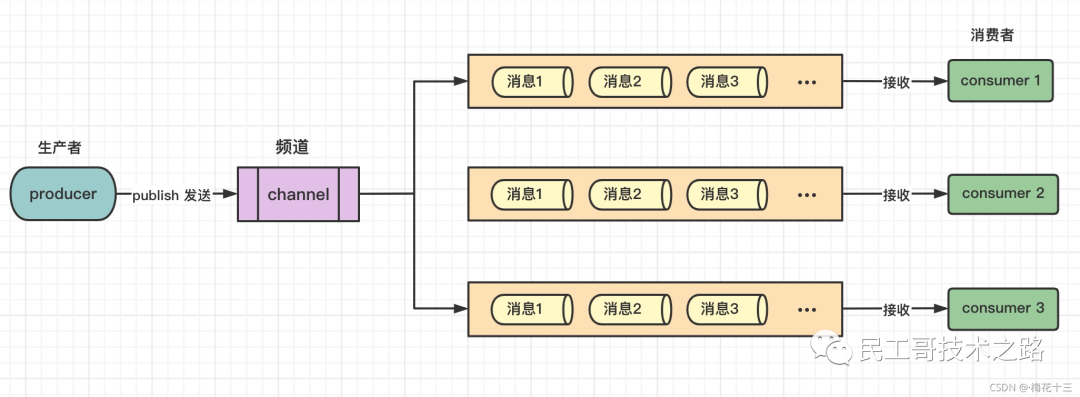

redis 的List数据类型结构提供了 blpop 、brpop 命令结合 rpush、lpush 命令可以实现消息队列机制,基于双端链表实现的发布与订阅功能

这种方式存在 两个局限性 :

- 不能支持一对多的消息分发。

- 如果生产者生成的速度远远大于消费者消费的速度,易堆积大量未消费的消息

◇ 双端队列图解 如下:

✦ 解析:双端队列模式只能有一个或多个消费者轮着去消费,却不能将消息同时发给其他消费者

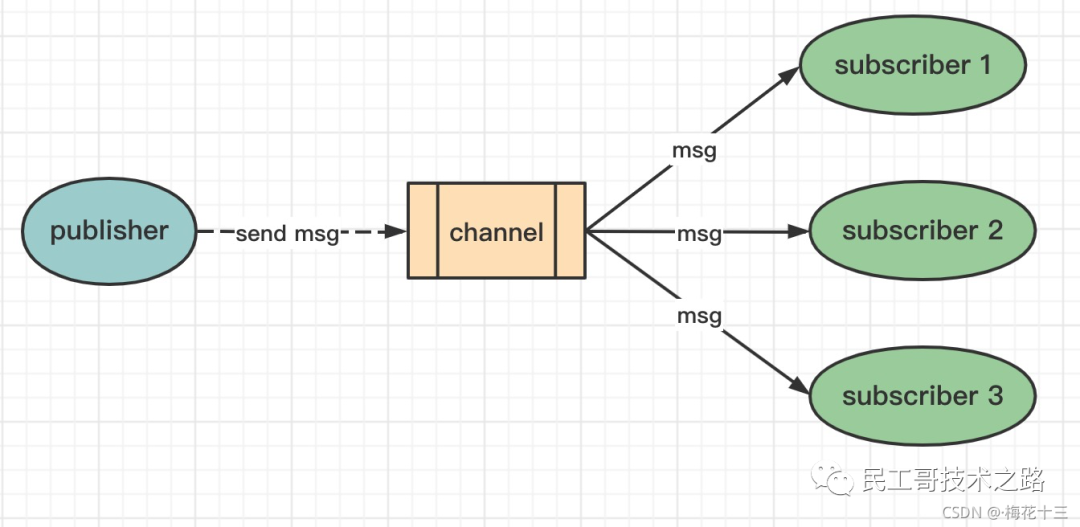

◇ 发布/订阅模式图解如下 :

✦ 解析:redis订阅发布模式,生产者生产完消息通过频道分发消息,给订阅了该频道的所有消费

发布/订阅如何使用?

Redis 有两种发布/订阅模式 :

- 基于频道(Channel)的发布/订阅

- 基于模式(pattern)的发布/订阅

操作命令 如下

基于频道(Channel)的发布/订阅

“发布/订阅” 包含2种角色:发布者和订阅者。发布者可以向指定的频道(channel)发送消息;订阅者可以订阅一个或者多个频道(channel),所有订阅此频道的订阅者都会收到此消息。

订阅者订阅频道 subscribe channel [channel …]

--------------------------客户端1(订阅者) :订阅频道 ---------------------

# 订阅 “meihuashisan” 和 “csdn” 频道(如果不存在则会创建频道)

127.0.0.1:6379> subscribe meihuashisan csdn

Reading messages... (press Ctrl-C to quit)

1) "subscribe" -- 返回值类型:表示订阅成功!

2) "meihuashisan" -- 订阅频道的名称

3) (integer) 1 -- 当前客户端已订阅频道的数量

1) "subscribe"

2) "csdn"

3) (integer) 2

#注意:订阅后,该客户端会一直监听消息,如果发送者有消息发给频道,这里会立刻接收到消息

发布者发布消息 publish channel message

-----------------------客户端2(发布者):发布消息给频道 -------------------

# 给“meihuashisan”这个频道 发送一条消息:“I am meihuashisan”

127.0.0.1:6379> publish meihuashisan "I am meihuashisan"

(integer) 1 # 接收到信息的订阅者数量,无订阅者返回0

客户端2(发布者)发布消息给频道后,此时我们再来观察 客户端1(订阅者)的客户端窗口变化:

--------------------------客户端1(订阅者) :订阅频道 -----------------

127.0.0.1:6379> subscribe meihuashisan csdn

Reading messages... (press Ctrl-C to quit)

1) "subscribe" -- 返回值类型:表示订阅成功!

2) "meihuashisan" -- 订阅频道的名称

3) (integer) 1 -- 当前客户端已订阅频道的数量

1) "subscribe"

2) "csdn"

3) (integer) 2

--------------------变化如下:(实时接收到了该频道的发布者的消息)------------

1) "message" -- 返回值类型:消息

2) "meihuashisan" -- 来源(从哪个频道发过来的)

3) "I am meihuashisan" -- 消息内容

命令操作图解 如下:

注意: 如果是先发布消息,再订阅频道,不会收到订阅之前就发布到该频道的消息!

注意:进入订阅状态的客户端,不能使用除了 subscribe、unsubscribe、psubscribe 和 punsubscribe 这四个属于"发布/订阅"之外的命令,否则会报错!

这里的客户端指的是 jedis、lettuce的客户端,redis-cli是无法退出订阅状态的!

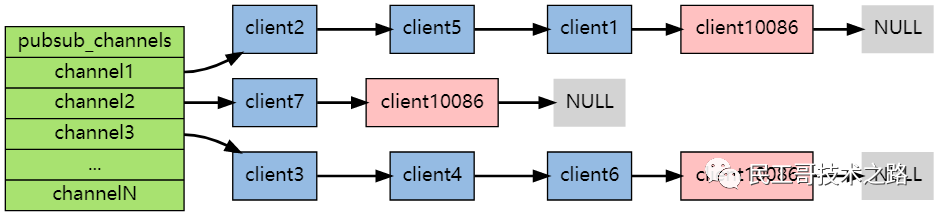

实现原理

底层通过字典实现。pubsub_channels 是一个字典类型,保存订阅频道的信息:字典的key为订阅的频道, 字典的value是一个链表, 链表中保存了所有订阅该频道的客户端

struct redisServer {

/* General */

pid_t pid;

//省略百十行

// 将频道映射到已订阅客户端的列表(就是保存客户端和订阅的频道信息)

dict *pubsub_channels; /* Map channels to list of subscribed clients */

}

实现图如下:

-

频道订阅 :订阅频道时先检查字段内部是否存在;不存在则为当前频道创建一个字典且创建一个链表存储客户端id;否则直接将客户端id插入到链表中。

-

取消频道订阅 :取消时将客户端id从对应的链表中删除;如果删除之后链表已经是空链表了,则将会把这个频道从字典中删除。

-

发布 :首先根据 channel 定位到字典的键, 然后将信息发送给字典值链表中的所有客户端

基于模式(pattern)的发布/订阅

如果有某个/某些模式和该频道匹配,所有订阅这个/这些频道的客户端也同样会收到信息。

图解

下图展示了一个带有频道和模式的例子, 其中 com.ahead.* 频道匹配了 com.ahead.juc 频道和 com.ahead.thread 频道, 并且有不同的客户端分别订阅它们三个,如下图:

当有信息发送到com.ahead.thread 频道时, 信息除了发送给 client 4 和 client 5 之外, 还会发送给订阅 com.ahead.* 频道模式的 client x 和 client y

✦ 解析 :反之也是,如果当有消息发送给 com.ahead.juc 频道,消息发送给订阅了 juc 频道的客户端之外,还会发送给订阅了 com.ahead.* 频道的客户端: client x 、client y

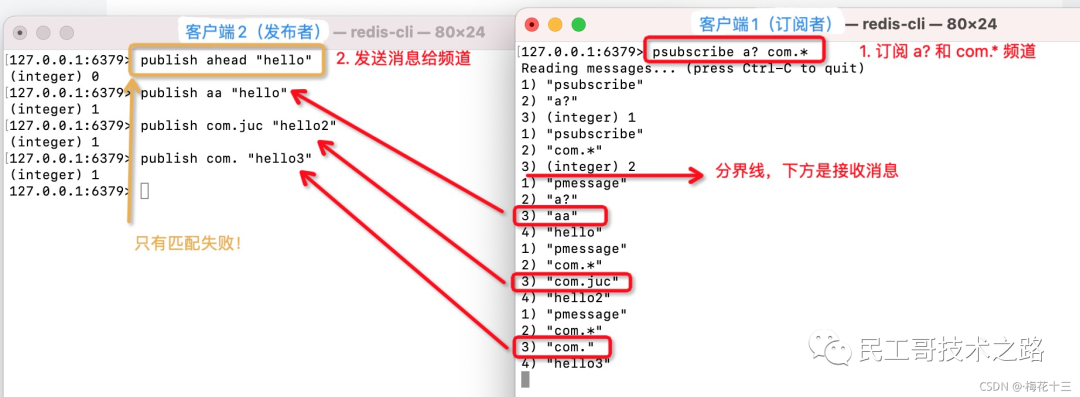

通配符中?表示1个占位符,*表示任意个占位符(包括0),?*表示1个以上占位符。

订阅者订阅频道 psubscribe pattern [pattern …]

--------------------------客户端1(订阅者) :订阅频道 --------------------

# 1. ------------订阅 “a?” "com.*" 2种模式频道--------------

127.0.0.1:6379> psubscribe a? com.*

# 进入订阅状态后处于阻塞,可以按Ctrl+C键退出订阅状态

Reading messages... (press Ctrl-C to quit)

---------------订阅成功-------------------

1) "psubscribe" -- 返回值的类型:显示订阅成功

2) "a?" -- 订阅的模式

3) (integer) 1 -- 目前已订阅的模式的数量

1) "psubscribe"

2) "com.*"

3) (integer) 2

---------------接收消息 (已订阅 “a?” "com.*" 两种模式!)-----------------

# ---- 发布者第1条命令:publish ahead "hello"

结果:没有接收到消息,匹配失败,不满足 “a?” ,“?”表示一个占位符, a后面的head有4个占位符

# ---- 发布者第2条命令: publish aa "hello" (满足 “a?”)

1) "pmessage" -- 返回值的类型:信息

2) "a?" -- 信息匹配的模式:a?

3) "aa" -- 信息本身的目标频道:aa

4) "hello" -- 信息的内容:"hello"

# ---- 发布者第3条命令:publish com.juc "hello2"(满足 “com.*”, *表示任意个占位符)

1) "pmessage" -- 返回值的类型:信息

2) "com.*" -- 匹配模式:com.*

3) "com.juc" -- 实际频道:com.juc

4) "hello2" -- 信息:"hello2"

---- 发布者第4条命令:publish com. "hello3"(满足 “com.*”, *表示任意个占位符)

1) "pmessage" -- 返回值的类型:信息

2) "com.*" -- 匹配模式:com.*

3) "com." -- 实际频道:com.

4) "hello3" -- 信息:"hello3"

发布者发布消息 publish channel message

------------------------客户端2(发布者):发布消息给频道 ------------------

注意:订阅者已订阅 “a?” "com.*" 两种模式!

# 1. ahead 不符合“a?”模式,?表示1个占位符

127.0.0.1:6379> publish ahead "hello"

(integer) 0 -- 匹配失败,0:无订阅者

# 2. aa 符合“a?”模式,?表示1个占位符

127.0.0.1:6379> publish aa "hello"

(integer) 1

# 3. 符合“com.*”模式,*表示任意个占位符

127.0.0.1:6379> publish com.juc "hello2"

(integer) 1

# 4. 符合“com.*”模式,*表示任意个占位符

127.0.0.1:6379> publish com. "hello3"

(integer) 1

命令操作图解 如下:

实现原理

底层是pubsubPattern节点的链表。

struct redisServer {

//...

list *pubsub_patterns;

// ...

}

// 1303行订阅模式列表结构:

typedef struct pubsubPattern {

client *client; -- 订阅模式客户端

robj *pattern; -- 被订阅的模式

} pubsubPattern;

实现图 如下:

-

模式订阅 :新增一个pubsub_pattern数据结构添加到链表的最后尾部,同时保存客户端ID。

-

取消模式订阅 :从当前的链表pubsub_pattern结构中删除需要取消的pubsubPattern结构。

使用小结

订阅者(listener)负责订阅频道(channel);发送者(publisher)负责向频道发送二进制的字符串消息,然后频道收到消息时,推送给订阅者。

使用场景

- 电商中,用户下单成功之后向指定频道发送消息,下游业务订阅支付结果这个频道处理自己相关业务逻辑

- 粉丝关注功能

- 文章推送

使用注意

- 客户端需要及时消费和处理消息。

- 客户端订阅了channel之后,如果接收消息不及时,可能导致DCS实例消息堆积,当达到消息堆积阈值(默认值为32MB),或者达到某种程度(默认8MB)一段时间(默认为1分钟)后,服务器端会自动断开该客户端连接,避免导致内部内存耗尽。

- 客户端需要支持重连。

- 当连接断开之后,客户端需要使用subscribe或者psubscribe重新进行订阅,否则无法继续接收消息。

- 不建议用于消息可靠性要求高的场景中。

- Redis的pubsub不是一种可靠的消息系统。当出现客户端连接退出,或者极端情况下服务端发生主备切换时,未消费的消息会被丢弃。

深入理解

我们通过几个问题,来深入理解Redis的订阅发布机制

基于频道(Channel)的发布/订阅如何实现的?

底层是通过字典(图中的pubsub_channels)实现的 ,这个字典就用于保存订阅频道的信息:字典的键为正在被订阅的频道, 而字典的值则是一个链表, 链表中保存了所有订阅这个频道的客户端。

数据结构

比如说,在下图展示的这个 pubsub_channels 示例中, client2 、 client5 和 client1 就订阅了 channel1 , 而其他频道也分别被别的客户端所订阅:

订阅

当客户端调用 SUBSCRIBE 命令时, 程序就将客户端和要订阅的频道在 pubsub_channels 字典中关联起来。

举个例子,如果客户端 client10086 执行命令 SUBSCRIBE channel1 channel2 channel3 ,那么前面展示的 pubsub_channels 将变成下面这个样子:

发布

当调用 PUBLISH channel message 命令, 程序首先根据 channel 定位到字典的键, 然后将信息发送给字典值链表中的所有客户端。

比如说,对于以下这个 pubsub_channels 实例, 如果某个客户端执行命令 PUBLISH channel1 “hello moto” ,那么 client2 、 client5 和 client1 三个客户端都将接收到 “hello moto” 信息:

退订

使用 UNSUBSCRIBE 命令可以退订指定的频道, 这个命令执行的是订阅的反操作:它从 pubsub_channels 字典的给定频道(键)中, 删除关于当前客户端的信息, 这样被退订频道的信息就不会再发送给这个客户端。

基于模式(Pattern)的发布/订阅如何实现的?

底层是pubsubPattern节点的链表。

数据结构

redisServer.pubsub_patterns 属性是一个链表,链表中保存着所有和模式相关的信息:

struct redisServer {

// ...

list *pubsub_patterns;

// ...

};

链表中的每个节点都包含一个 redis.h/pubsubPattern 结构:

typedef struct pubsubPattern {

redisClient *client;

robj *pattern;

} pubsubPattern;

client 属性保存着订阅模式的客户端,而 pattern 属性则保存着被订阅的模式。

每当调用 PSUBSCRIBE 命令订阅一个模式时, 程序就创建一个包含客户端信息和被订阅模式的 pubsubPattern 结构, 并将该结构添加到 redisServer.pubsub_patterns 链表中。

作为例子,下图展示了一个包含两个模式的 pubsub_patterns 链表, 其中 client123 和 client256 都正在订阅 tweet.shop.* 模式:

订阅

如果这时客户端 client10086 执行 PSUBSCRIBE broadcast.list.* , 那么 pubsub_patterns 链表将被更新成这样:

通过遍历整个 pubsub_patterns 链表,程序可以检查所有正在被订阅的模式,以及订阅这些模式的客户端。

发布

发送信息到模式的工作也是由 PUBLISH 命令进行的, 显然就是匹配模式获得Channels,然后再把消息发给客户端。

退订

使用 PUNSUBSCRIBE 命令可以退订指定的模式, 这个命令执行的是订阅模式的反操作:程序会删除 redisServer.pubsub_patterns 链表中, 所有和被退订模式相关联的 pubsubPattern 结构, 这样客户端就不会再收到和模式相匹配的频道发来的信息。

SpringBoot结合Redis发布/订阅实例?

最佳实践是通过RedisTemplate,关键代码如下:

// 发布

redisTemplate.convertAndSend("my_topic_name", "message_content");

// 配置订阅

RedisMessageListenerContainer container = new RedisMessageListenerContainer();

container.setConnectionFactory(connectionFactory);

container.addMessageListener(xxxMessageListenerAdapter, "my_topic_name");

总结

1、redis的订阅频道的信息是redis服务器进程自己维持在pubsub_channels链表字典当中。字典的KEY为被订阅的频道,值为订阅的客户端。

2、当发送者发送消息时,redis服务器遍历频道对应的所有客户端,然后将消息发送到所订阅的客户端上。

3、当有信息发送时,除了订阅该频道的客户端会收到消息,以及和订阅了匹配频道的客户端,其它客户端是收不到该信息的。

4、退订频道、退订模式和订阅频道、订阅模式是两组反操作。

应用场景

俗话说的好,知识学得好不好,还得看用到哪。反正笔者看到redis的发布与订阅的模式的特点后,第一时间想到的是可以用来做一个实时聊天系统,还可以用来做分布式架构中写的过程,利用redis的实时发布功能,把要写入的值及时快速的分发到各个写入程序当中,保证分布式架构中数据的完整一致性。再比如博客系统和自媒体平台中,粉丝关注功能,就比当我发布文章时,就可以及时推送文章到粉丝的客户端上。总而言之,应用的场景比较多,需要大家多思考,多交流。

参考来源:

https://blog.csdn.net/w15558056319/article/details/121490953 pdai.tech/md/db/nosql-redis/db-redis-x-pub-sub.html https://www.wenjiangs.com/doc/mt0ueji7b8sc

(五):Redis 事件机制详解

前言

Redis 采用事件驱动机制来处理大量的网络 IO。 它并没有使用 libevent 或者 libev 这样的成熟开源方案,而是自己实现一个非常简洁的事件驱动库 ae_event 。

什么是事件驱动?

所谓事件驱动,简单地说就是你点什么按钮(即产生什么事件),电脑执行什么操作(即调用什么函数) .当然事件不仅限于用户的操作. 事件驱动的核心自然是事件。

从事件角度说,事件驱动程序的 基本结构是由一个事件收集器、一个事件发送器和一个事件处理器组成。

- 事件收集器专门负责收集所有事件,包括来自用户的(如鼠标、键盘事件等)、来自硬件的(如时钟事件等)和来自软件的(如操作系统、应用程序本身等)。

- 事件发送器负责将收集器收集到的事件分发到目标对象中。

- 事件处理器做具体的事件响应工作。

事件驱动库的代码主要是在src/ae.c中实现的,其示用意如下所示。

Redis 服务器就是一个事件驱动程序,服务器需要处理以下 两类事件 :

-

文件事件(file event) :Redis服务器通过套接字与客户端(或者其他Redis服务器)进行连接,而文件事件就是服务器对套接字操作的抽象,服务器与客户端(或者是其他服务器)通信会产生相应的文件事件,而服务器则通过监听并处理这些事件来完成一系列网络通信操作。

-

时间事件(time event) :Redis服务器中的一些操作需要在给定的时间点执行,而时间事件就是服务器对这类定时操作的抽象。

文件事件

Redis基于Reactor模式开发了自己的网络事件处理器:这个处理器被称为文件事件处理器(file event handler):

- 文件事件处理器使用I/O多路复用(multiplexing)程序来同时监听多个套接字,并且根据套接字目前执行的任务来为套接字关联不同的所时间处理器

- 当被监听的套接字准备好执行连接应答(accept),读取(read),写入(write),关闭(close)等操作时,与操作相对应的文件事件就会产生,这时文件处理器就会调用套接字之前关联好的事件处理器来处理这些事件

虽然文件事件处理器以单线程的方式运行,但通过使用I/O多路复用程序来监听多个套接字,文件时间处理器既能实现高性能的网络通信模型,又可以很好的与Redis服务器中的其他同样以单线程方式运行的模块进行对接,这就保持了Redis内部单线程设计的简单性。

文件事件处理器的构成

文件事件处理器主要有 四部分组成 ,他们分别是 套接字,I.O多路复用程序,文件事件分派器,以及事件处理程序 。

- 文件事件是对套接字操作的抽象,每当一个套接字准备好执行连接应答(accept),写入,读取,关闭等操作时,就会产生一个文件事件。因为一个服务器通常会连接多个套接字,所以多个文件事件可能会并发出现

- I/O多路复用程序负责监听多个套接字,并向文件事件分派器传送那些产生了事件的套接字

- 尽管多个文件事件可能会并发地产生地出现,但是I/O多路复用程序总是会将所有产生事件的套接字都会放到一个队列里面,然后通过这个队列,以有序(sequentially),同步(synchronously),每次一个套接字的方式向文件事件分派器传送套接字。当上一个套接字产生的事件被处理完毕后,I/O多路服用程序才会继续向文件事件分派器传送下一个套接字

- 文件事件分派器接受一个I/O多路复用程序传送来的套接字,并且根据套接字产生的事件的类型,调用相应的时间处理程序

I/O多路服用程序的实现

Redis的I/O多路复用程序的所有功能都是通过包装常见的select,epoll,evport和kqueue这些I/O多路复用函数库实现的,每个I/O多路复用函数库在Redis源码中都对应一个单独的文件。

下图就是基于多路复用的 Redis IO 模型。

因为Redis为每个I/O多路复用函数库实现了相同的API,所以I/O多路复用程序的底层实现是可以互换的。

事件的类型

I/O多路复用程序可以监听多个套接字的READABLE事件和WRITEABLE事件,这两个事件和套接字操作之间的对应关系如下:

- 当套接字变得可读时(客户端对套接字执行write操作,或者执行close操作),或者有新的可应答(acceptable)套接字出现时(客户端对服务器的监听套接字主席那个connect操作),套接字产生READABLE事件

- 当套接字变得可写(客户端对套接字执行read操作),套接字产生WRITEABLE事件

I/O多路复用程序允许服务器同时监听套接字的READABLE事件和WRITEABLE事件,如果套接字同时产生这两种事件,那么文件事件分派器会优先处理READABLE事件,READABLE事件处理完之后,才会处理WRITEABLE事件。更多关于 Redis 学习的文章,请参阅:NoSQL 数据库系列之 Redis ,本系列持续更新中。

API

aeCreteFileEvent函数接受一个套接字描述符,一个事件类型,以及一个时间处理器作为参数,将套接字的给定事件加入到I/O多路复用程序的监听范围之内,并对事件和时间处理器进行关联。

aeDeleteFileEvent函数接受一个套接字描述符和监听事件类型作为参数,让I/O多路复用程序取消给定套接字的给定事件监听,并且取消事件和时间处理器之间的联系。

aeGetFileEvents函数接受一个套接字描述符,返回该套接字正在监听的事件类型:

- 如果套接字没有任务事件被监听,那么函数返回AE_NONE。

- 如果套接字的读事件正在被监听,那么函数返回AE_READABLE。

- 如果套接字的写事件正在被监听,那么函数返回AE_WRITABLE

- 如果套接字的读事件和写事件正在被监听,那么函数返回AE_READABLE|AE_WRITEABLE。

文件事件处理器

Redis为文件事件编写了多个处理器,这些事件处理器分别用于实现不同的网络通信需求:

- 为了对连接服务器的各个客户端进行应答,服务器要为监听套接字关联应答处理器。

- 为了接受客户端传来的命令请求,服务器要为客户端套接字关联命令请求处理器。

- 为了向客户端返回命令的执行结果,服务器要为客户端套接字关联命令回复处理器

- 当主服务器和从服务器进行复制操作时,朱从服务器都需要关联特别为复制功能编写的复制处理器

连接应答处理器

networking.c/accpetTcpHandler函数是Redis连接应答处理器,这个处理器用于对连接服务器监听套接字的客户端进行应答,具体实现为sys/socket.h/accpet函数的包装。

当Redis服务器进行初始化的时候,程序会将这个连接应答处理器和服务器监听套接字的AE_READABLE事件进行关联,当有客户端用sys/socketh/connect函数连接服务器监听套接字的时候,套接字就会产生AE_READABLE事件,引发连接应答处理器执行。

命令请求处理器

networking.c/readQueryFromClient函数是Redis命令处理器,这个命令处理器负责从套接字中读入客户端发送的命令请求内容,具体实现为unistd.h/read函数的包装。

当一个客户端通过连接应答处理器成功连接到服务器之后,服务器就会将客户端套接字的AE_READABLE事件和命令请求处理器关联起来,当客户端向服务器发送命令请求时,套接字就会产生AE_READABLE事件,引发命令请求处理器执行,并执行相应的套接字读入操作。

在客户端连接服务器的整个过程,服务器都会一直为客户端套接字的AE_READABLE事件关联命令请求处理器。

命令回复处理器

sendReplyToClient函数是Redis命令回复处理器,这个处理器负责将服务器执行命令后得到的回复命令通过套接字返回给客户端。

当服务器有命令回复需要传送给客户端时,服务器会将客户端套接字的AE_WRITEABLE事件和命令处理器关联起来,当客户端准备好接受服务器传回的命令回复时,就会产生AE_WRITABLE事件,引发命令回复处理器执行,并执行相应的套接字写入操作。

当命令回复处理器发送完毕后,服务器就会解除命令回复处理器与套接字得AE_WRITABLE事件之间的关联。更多关于 Redis 学习的文章,请参阅:NoSQL 数据库系列之 Redis,本系列持续更新中。

一次完整的客户端与服务器连接事件

当一个 Redis 服务器正在运作,那么这个服务器的舰艇套接字得 AE_READABLE事件应该正处于监听状态下,而事件所对应的处理器为连接应答处理器。

当 Redis 客户端向服务器发起连接,那么舰艇套接字将产生 AE_READABLE 事件,触发连接应答处理器执行。处理器会对客户端的连接应答请求进行应答,然后创建客户端套接字,以及客户端状态,并将客户端套接字的 AE_RAEDABLE事件与命令请求处理器进行关联,使得客户端可以主动向服务器发送命令请求。

之后,假设客户端向主服务器发送一个命令请求,那么客户端套接字将产生一个 AE_READABLE 事件,引发命令请求处理器执行,处理器读取客户端的命令内容,然后传给相关程序去执行。

执行命令将产生相应的命令回复,为了将这些命令回复传送给客户端,服务器会将客户端套接字的 AE_WRITABLE 事件与命令回复处理器进行关联。当客户端尝试读取命令回复的时候,客户端套接字将产生 AE_WRITABLE 事件,触发命令回复处理器执行,当命令回复处理器将命令回复全部写入套接字之后,服务器就会解除客户端套接字的 AE_WRITABLE 事件与命令回复处理器之间的关联。

时间事件

Redis 时间事件可以分为 两类 :

- 定时时间:让一段程序在指定的时间之后执行

- 周期性时间:让一段程序每隔指定时间就执行一次

一个时间事件主要有三个属性组成

- id:服务器为时间事件创建的全局唯一ID(标识号)。ID号按从小到大的顺序递增11,新事件的ID号比旧事件的ID号要大

- when:毫秒精度的UNIX时间戳,记录了时间事件到达时间

- timeProc:时间事件处理器,一个函数。当时间事件到达时,服务器就会调用相应的处理器来处理事件

一个定时事件是定时事件还是周期事件取决于时间事件处理器的返回值。

- 如果事件处理器返回ae.h/AE_NOMORE,那么这个事件为定时事件:该事件在到达一次之后就会被删除,之后不再到达

- 如果事件处理器返回一个非AE_NOMORE得整数值,那么这个事件为周期性事件:当一个时间事件到达之后,服务器会根据事件处理器返回的值,对时间事件的when属性进行更新,让这个事件在一段时间之后再次到达,并以这种方式一直更新并运行下去。

Redis中时间事件使用场景

时间事件的最主要应用是在redis服务器需要对自身的资源与配置进行定期的调度,从而确保服务器的长久运行。这些操作都是由serverCron函数实现。该函数做了以下操作。

1、更新redis服务器各类统计信息,包括时间,内存占用,数据库占用等

2、清理数据库中过期的key(过期删除)

3、关闭和清理连接失败的客户端

4、尝试进行aof个rdb的持久化操作(数据持久化)

5、如果服务器是主服务器,会定期将数据向从服务器做同步操作(主从复制)。

6、如果是集群模式,对集群定期进行同步和连接测试等操作(健康检查)。

Redis启动后,会定期执行serverCron函数,直到redis关闭为止,默认每秒执行10次,也就是100ms执行一次。

可以在redis配置文件(redis.conf)中的hz选项调整执行频率。

#redis执行任务的频率为1s除以hz, 一秒钟执行多少次

hz 10

实现

服务器将所有时间事件都放在一个无序链表中,每当时间事件执行器被运行时,它就遍历整个链表,查找所有已经达到的时间事件,并且调用相应的事件处理器

时间事件的链表为无序链表,指的不是链表不按ID排序,而是说该丽娜表不按when属性的大小排序。正因为链表没有按照when属性进行排序,所以当时间事件执行器运行时,它必须遍历链表中的所有时间事件,这样才能确保服务器中所有时间事件都被处理。更多关于 Redis 学习的文章,请参阅:NoSQL 数据库系列之 Redis ,本系列持续更新中。

时间事件的应用实例:serverCron函数

持续运行的Redis服务器需要定期对自身的资源和状态进行检查和调整,从而确保服务器可以长期,稳定的运行,这些定期操作有redis.c/serverCron函数负责执行,它的主要工作:

- 更新服务器的各类统计信息,比如时间,内存占用,数据库占用情况

- 清理数据库中的过期键值对

- 关闭和清理连接失效的客户端

- 尝试进行AOF或者RDB持久化操作

- 如果服务器时主服务器,那么对从服务器定期同步和连接测试

- 如果处于集群模式,那么对集群进行定期同步和连接测试

Redis服务器以周期性事件的方式运行serverCron函数,在服务器运行期间,每隔一段时间,serverCron就会执行一次,直到服务器关闭

事件的调度与执行

因为服务器中同时存在文件事件和时间事件,所以服务器必须对这两种事件进行调度,决定何时处理文件事件,何时处理时间事件,已经花费多少事件处理事件。

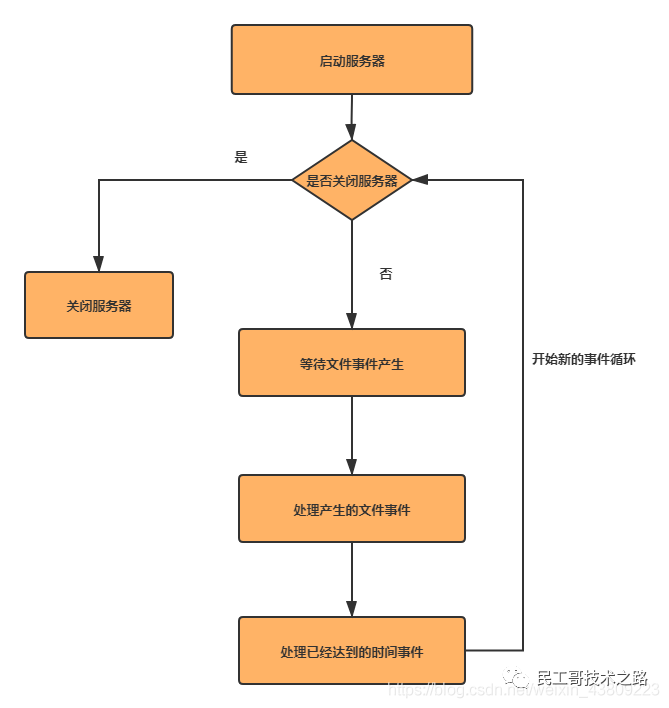

事件的调度和执行由ae.c/aeProcessEvents函数负责。将aeProcessEvents函数置于一个循环里面,加上初始化和清理函数,这就构成了Redis服务器的主函数,一下是该函数的伪代码:

def main():

#初始化服务器

init_server()

#一直处理事件,知道服务器关闭

while server_is_not_shutdown():

aeProcessEvents()

#服务器关闭,执行清理操作

clean_server()

从事件处理的角度,Redis服务器的运行流程可以用下图表示:

总结

Redis的高性能为什么是单线程也可以性能这么高。它的事件处理机制起着非常重要的一个作用。选用的模型为reactor模型。让单线程去做了多线程可以做的事情,并且还没有线程安全问题。

来源:

https://blog.csdn.net/weixin_43809223/article/details/109631305

(六):Redis 事务详解

什么是Redis事务

Redis 事务的 本质是一组命令的集合。事务支持一次执行多个命令,一个事务中所有命令都会被序列化。 在事务执行过程,会按照顺序串行化执行队列中的命令,其他客户端提交的命令请求不会插入到事务执行命令序列中。

总结说: redis 事务就是一次性、顺序性、排他性的执行一个队列中的一系列命令。

Redis事务相关命令和使用

MULTI、EXEC、DISCARD 和 WATCH 是 Redis 事务相关的命令。

- MULTI :开启事务,redis会将后续的命令逐个放入队列中,然后使用EXEC命令来原子化执行这个命令系列。

- EXEC:执行事务中的所有操作命令。

- DISCARD:取消事务,放弃执行事务块中的所有命令。

- WATCH:监视一个或多个key,如果事务在执行前,这个key(或多个key)被其他命令修改,则事务被中断,不会执行事务中的任何命令。

- UNWATCH:取消WATCH对所有key的监视。

标准的事务执行

给k1、k2分别赋值,在事务中修改k1、k2,执行事务后,查看k1、k2值都被修改。

127.0.0.1:6379> set k1 v1

OK

127.0.0.1:6379> set k2 v2

OK

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 11

QUEUED

127.0.0.1:6379> set k2 22

QUEUED

127.0.0.1:6379> EXEC

1) OK

2) OK

127.0.0.1:6379> get k1

"11"

127.0.0.1:6379> get k2

"22"

127.0.0.1:6379>

事务取消

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 33

QUEUED

127.0.0.1:6379> set k2 34

QUEUED

127.0.0.1:6379> DISCARD

OK

事务出现错误的处理

语法错误(编译器错误)

在开启事务后,修改k1值为11,k2值为22,但k2语法错误,最终导致事务提交失败, k1、k2保留原值。

127.0.0.1:6379> set k1 v1

OK

127.0.0.1:6379> set k2 v2

OK

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 11

QUEUED

127.0.0.1:6379> sets k2 22

(error) ERR unknown command `sets`, with args beginning with: `k2`, `22`,

127.0.0.1:6379> exec

(error) EXECABORT Transaction discarded because of previous errors.

127.0.0.1:6379> get k1

"v1"

127.0.0.1:6379> get k2

"v2"

127.0.0.1:6379>

Redis类型错误(运行时错误)

在开启事务后,修改k1值为11,k2值为22,但将k2的类型作为List, 在运行时检测类型错误,最终导致事务提交失败,此时事务并没有回滚,而是跳过错误命令继续执行, 结果k1值改变、k2保留原值。

127.0.0.1:6379> set k1 v1

OK

127.0.0.1:6379> set k1 v2

OK

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 11

QUEUED

127.0.0.1:6379> lpush k2 22

QUEUED

127.0.0.1:6379> EXEC

1) OK

2) (error) WRONGTYPE Operation against a key holding the wrong kind of value

127.0.0.1:6379> get k1

"11"

127.0.0.1:6379> get k2

"v2"

127.0.0.1:6379>

CAS操作实现乐观锁

WATCH 命令可以为 Redis 事务提供 check-and-set (CAS)行为。

CAS? 乐观锁? Redis官方的例子帮你理解

被 WATCH 的键会被监视,并会发觉这些键是否被改动过了。如果有至少一个被监视的键在 EXEC 执行之前被修改了, 那么整个事务都会被取消, EXEC 返回nil-reply来表示事务已经失败。

举个例子, 假设我们需要原子性地为某个值进行增 1 操作(假设 INCR 不存在)。

首先我们可能会这样做:

val = GET mykey

val = val + 1

SET mykey $val

上面的这个实现在只有一个客户端的时候可以执行得很好。但是, 当多个客户端同时对同一个键进行这样的操作时, 就会产生竞争条件。举个例子, 如果客户端 A 和 B 都读取了键原来的值, 比如 10 , 那么两个客户端都会将键的值设为 11 , 但正确的结果应该是 12 才对。

有了 WATCH ,我们就可以轻松地解决这类问题了:

WATCH mykey

val = GET mykey

val = val + 1

MULTI

SET mykey $val

EXEC

使用上面的代码, 如果在 WATCH 执行之后, EXEC 执行之前, 有其他客户端修改了 mykey 的值, 那么当前客户端的事务就会失败。程序需要做的, 就是不断重试这个操作, 直到没有发生碰撞为止。

这种形式的锁被称作乐观锁 , 它是一种非常强大的锁机制。并且因为大多数情况下, 不同的客户端会访问不同的键, 碰撞的情况一般都很少, 所以通常并不需要进行重试。

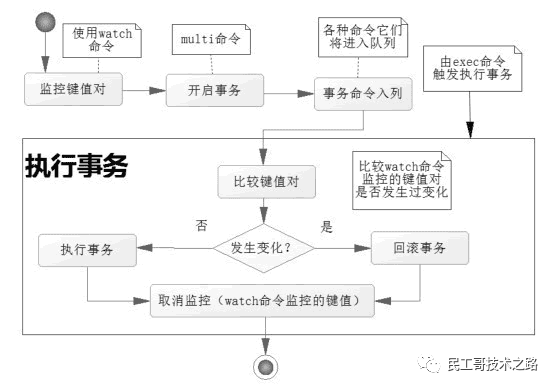

watch是如何监视实现的呢?

Redis使用WATCH命令来决定事务是继续执行还是回滚,那就需要在MULTI之前使用WATCH来监控某些键值对,然后使用MULTI命令来开启事务,执行对数据结构操作的各种命令,此时这些命令入队列。

当使用EXEC执行事务时,首先会比对WATCH所监控的键值对,如果没发生改变,它会执行事务队列中的命令,提交事务;如果发生变化,将不会执行事务中的任何命令,同时事务回滚。当然无论是否回滚,Redis都会取消执行事务前的WATCH命令。

watch 命令实现监视

在事务开始前用WATCH监控k1,之后修改k1为11,说明事务开始前k1值被改变,MULTI开始事务,修改k1值为12,k2为22,执行EXEC,发回nil,说明事务回滚;查看下k1、k2的值都没有被事务中的命令所改变。

127.0.0.1:6379> set k1 v1

OK

127.0.0.1:6379> set k2 v2

OK

127.0.0.1:6379> WATCH k1

OK

127.0.0.1:6379> set k1 11

OK

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 12

QUEUED

127.0.0.1:6379> set k2 22

QUEUED

127.0.0.1:6379> EXEC

(nil)

127.0.0.1:6379> get k1

"11"

127.0.0.1:6379> get k2

"v2"

127.0.0.1:6379>

UNWATCH取消监视

127.0.0.1:6379> set k1 v1

OK

127.0.0.1:6379> set k2 v2

OK

127.0.0.1:6379> WATCH k1

OK

127.0.0.1:6379> set k1 11

OK

127.0.0.1:6379> UNWATCH

OK

127.0.0.1:6379> MULTI

OK

127.0.0.1:6379> set k1 12

QUEUED

127.0.0.1:6379> set k2 22

QUEUED

127.0.0.1:6379> exec

1) OK

2) OK

127.0.0.1:6379> get k1

"12"

127.0.0.1:6379> get k2

"22"

Redis事务执行步骤

通过上文命令执行,很显然 Redis事务执行是三个阶段 :

- 开启 :以MULTI开始一个事务

- 入队 :将多个命令入队到事务中,接到这些命令并不会立即执行,而是放到等待执行的事务队列里面

- 执行 :由EXEC命令触发事务

当一个客户端切换到事务状态之后, 服务器会根据这个客户端发来的不同命令执行不同的操作:

- 如果客户端发送的命令为 EXEC 、 DISCARD 、 WATCH 、 MULTI 四个命令的其中一个, 那么服务器立即执行这个命令。

- 与此相反, 如果客户端发送的命令是 EXEC 、 DISCARD 、 WATCH 、 MULTI 四个命令以外的其他命令, 那么服务器并不立即执行这个命令, 而是将这个命令放入一个事务队列里面, 然后向客户端返回 QUEUED 回复。

更深入的理解

我们再通过几个问题来深入理解Redis事务。

为什么 Redis 不支持回滚?

如果你有使用关系式数据库的经验,那么“ Redis 在事务失败时不进行回滚,而是继续执行余下的命令 ”这种做法可能会让你觉得有点奇怪。

以下是这种做法的优点:

- Redis 命令只会因为错误的语法而失败(并且这些问题不能在入队时发现),或是命令用在了错误类型的键上面:这也就是说,从实用性的角度来说,失败的命令是由编程错误造成的,而这些错误应该在开发的过程中被发现,而不应该出现在生产环境中。

- 因为不需要对回滚进行支持,所以 Redis 的内部可以保持简单且快速。

有种观点认为 Redis 处理事务的做法会产生 bug , 然而需要注意的是, 在通常情况下, 回滚并不能解决编程错误带来的问题 。举个例子, 如果你本来想通过 INCR 命令将键的值加上 1 , 却不小心加上了 2 , 又或者对错误类型的键执行了 INCR , 回滚是没有办法处理这些情况的。

如何理解Redis与事务的ACID?

一般来说, 事务有四个性质称为ACID,分别是原子性,一致性,隔离性和持久性 。这是基础,但是很多文章对Redis 是否支持ACID有一些异议,我觉的有必要梳理下:

原子性atomicity

首先通过上文知道 运行期的错误是不会回滚的,很多文章由此说Redis事务违背原子性的;而官方文档认为是遵从原子性的。

Redis官方文档给的理解是, Redis的事务是原子性的:所有的命令,要么全部执行,要么全部不执行。 而不是完全成功。

一致性consistency

redis事务可以保证命令失败的情况下得以回滚,数据能恢复到没有执行之前的样子,是保证一致性的,除非redis进程意外终结。

隔离性Isolation

redis事务是严格遵守隔离性的,原因是redis是单进程单线程模式(v6.0之前),可以保证命令执行过程中不会被其他客户端命令打断。

但是,Redis不像其它结构化数据库有隔离级别这种设计。

持久性Durability

redis事务是不保证持久性的 ,这是因为redis持久化策略中不管是RDB还是AOF都是异步执行的,不保证持久性是出于对性能的考虑。

Redis事务其它实现

-

基于Lua脚本,Redis可以保证脚本内的命令一次性、按顺序地执行,其同时也不提供事务运行错误的回滚,执行过程中如果部分命令运行错误,剩下的命令还是会继续运行完

-

基于中间标记变量,通过另外的标记变量来标识事务是否执行完成,读取数据时先读取该标记变量判断是否事务执行完成。但这样会需要额外写代码实现,比较繁琐

来源:https://www.pdai.tech/md/db/nosql-redis/db-redis-x-trans.html

(七):Redis 持久化(RDB和AOF)

Redis 持久化介绍

为了防止数据丢失以及服务重启时能够恢复数据,Redis支持数据的持久化,主要分为两种方式,分别是RDB和AOF; 当然实际场景下还会使用这两种的混合模式。

为什么需要持久化?

Redis是个基于内存的数据库。那服务一旦宕机,内存中的数据将全部丢失。通常的解决方案是从后端数据库恢复这些数据,但后端数据库有性能瓶颈,如果是大数据量的恢复:

1、会对数据库带来巨大的压力

2、数据库的性能不如Redis。导致程序响应慢

所以对Redis来说,实现数据的持久化,避免从后端数据库中恢复数据,是至关重要的。

Redis持久化有哪些方式呢?为什么我们需要重点学RDB和AOF?

从严格意义上说, Redis服务提供四种持久化存储方案:RDB、AOF、虚拟内存(VM)和 DISKSTORE。 虚拟内存(VM)方式,从Redis Version 2.4开始就被官方明确表示不再建议使用,Version 3.2版本中更找不到关于虚拟内存(VM)的任何配置范例,Redis的主要作者Salvatore Sanfilippo还专门写了一篇论文,来反思Redis对虚拟内存(VM)存储技术的支持问题。

至于DISKSTORE方式,是从Redis Version 2.8版本开始提出的一个存储设想,到目前为止Redis官方也没有在任何stable版本中明确建议使用这用方式。在Version 3.2版本中同样找不到对于这种存储方式的明确支持。从网络上能够收集到的各种资料来看,DISKSTORE方式和RDB方式还有着一些千丝万缕的联系,不过各位读者也知道,除了官方文档以外网络资料很多就是大抄。

最关键的是目前官方文档上能够看到的Redis对持久化存储的支持明确的就只有两种方案(https://redis.io/topics/persistence):RDB和AOF。所以本文也只会具体介绍这两种持久化存储方案的工作特定和配置要点。

RDB(Redis DataBase)持久化

RDB 就是 Redis DataBase 的缩写,中文名为 快照/内存快照 , RDB持久化是把当前进程数据生成快照保存到磁盘上的过程,由于是某一时刻的快照,那么快照中的值要早于或者等于内存中的值。

Redis 会单独创建(fork)一个子进程进行持久化,会先将数据写入一个临时文件中,待持久化过程结束了,再用这个临时文件替换上次持久化好的文件。整个过程中,主进程不进行任何 IO 操作,这就确保的极高的性能。如果需要大规模的数据的恢复,且对数据恢复的完整性不是非常敏感,那 RDB 方式要比 AOF 方式更加高效。RDB 唯一的缺点是最后一次持久化的数据可能会丢失。

触发rdb持久化的方式有2种,分别是 手动触发 和 自动触发 。

手动触发

手动触发分别对应 save和bgsave命令

- save命令 :阻塞当前Redis服务器,直到RDB过程完成为止,对于内存 比较大的实例会造成长时间阻塞, 线上环境不建议使用

- bgsave命令 :Redis进程执行fork操作创建子进程,RDB持久化过程由子 进程负责,完成后自动结束。阻塞只发生在fork阶段,一般时间很短

bgsave流程图如下所示

具体流程如下

- redis客户端执行bgsave命令或者自动触发bgsave命令;

- 主进程判断当前是否已经存在正在执行的子进程,如果存在,那么主进程直接返回;

- 如果不存在正在执行的子进程,那么就fork一个新的子进程进行持久化数据,fork过程是阻塞的,fork操作完成后主进程即可执行其他操作;

- 子进程先将数据写入到临时的rdb文件中,待快照数据写入完成后再原子替换旧的rdb文件;

- 同时发送信号给主进程,通知主进程rdb持久化完成,主进程更新相关的统计信息(info Persitence下的rdb_*相关选项)。

自动触发

在以下 4种情况时会自动触发 :

- redis.conf中配置save m n,即在m秒内有n次修改时,自动触发bgsave生成rdb文件;

- 主从复制时,从节点要从主节点进行全量复制时也会触发bgsave操作,生成当时的快照发送到从节点;

- 执行debug reload命令重新加载redis时也会触发bgsave操作;

- 默认情况下执行shutdown命令时,如果没有开启aof持久化,那么也会触发bgsave操作;

redis.conf中配置RDB

快照周期:内存快照虽然可以通过技术人员手动执行SAVE或BGSAVE命令来进行,但生产环境下多数情况都会设置其周期性执行条件。

Redis中默认的周期新设置

# 周期性执行条件的设置格式为

save <seconds> <changes>

# 默认的设置为:

save 900 1

save 300 10

save 60 10000

# 以下设置方式为关闭RDB快照功能

save ""

以上三项默认信息设置代表的意义是:

-

如果900秒内有1条Key信息发生变化,则进行快照;

-

如果300秒内有10条Key信息发生变化,则进行快照;

-

如果60秒内有10000条Key信息发生变化,则进行快照。读者可以按照这个规则,根据自己的实际请求压力进行设置调整。

其它相关配置

# 文件名称

dbfilename dump.rdb

# 文件保存路径

dir /home/work/app/redis/data/

# 如果持久化出错,主进程是否停止写入

stop-writes-on-bgsave-error yes

# 是否压缩

rdbcompression yes

# 导入时是否检查

rdbchecksum yes

-

dbfilename :RDB文件在磁盘上的名称。

-

dir :RDB文件的存储路径。默认设置为“./”,也就是Redis服务的主目录。

-

stop-writes-on-bgsave-error :上文提到的在快照进行过程中,主进程照样可以接受客户端的任何写操作的特性,是指在快照操作正常的情况下。如果快照操作出现异常(例如操作系统用户权限不够、磁盘空间写满等等)时,Redis就会禁止写操作。这个特性的主要目的是使运维人员在第一时间就发现Redis的运行错误,并进行解决。一些特定的场景下,您可能需要对这个特性进行配置,这时就可以调整这个参数项。该参数项默认情况下值为yes,如果要关闭这个特性,指定即使出现快照错误Redis一样允许写操作,则可以将该值更改为no。

-

rdbcompression :该属性将在字符串类型的数据被快照到磁盘文件时,启用LZF压缩算法。Redis官方的建议是请保持该选项设置为yes,因为“it’s almost always a win”。

-

rdbchecksum :从RDB快照功能的 version 5 版本开始,一个64位的CRC冗余校验编码会被放置在RDB文件的末尾,以便对整个RDB文件的完整性进行验证。这个功能大概会多损失10%左右的性能,但获得了更高的数据可靠性。所以如果您的 Redis 服务需要追求极致的性能,就可以将这个选项设置为no。更多关于 Redis 学习的文章,请参阅:NoSQL 数据库系列之 Redis ,本系列持续更新中。

RDB 更深入理解

我们通过几个实战问题来深入理解RDB

由于生产环境中我们为Redis开辟的内存区域都比较大(例如6GB),那么将内存中的数据同步到硬盘的过程可能就会持续比较长的时间,而实际情况是这段时间Redis服务一般都会收到数据写操作请求。 那么如何保证数据一致性呢?

RDB中的核心思路是Copy-on-Write,来保证在进行快照操作的这段时间,需要压缩写入磁盘上的数据在内存中不会发生变化。在正常的快照操作中,一方面Redis主进程会fork一个新的快照进程专门来做这个事情,这样保证了Redis服务不会停止对客户端包括写请求在内的任何响应。另一方面这段时间发生的数据变化会以副本的方式存放在另一个新的内存区域,待快照操作结束后才会同步到原来的内存区域。

举个例子:如果主线程对这些数据也都是读操作(例如图中的键值对 A),那么,主线程和 bgsave 子进程相互不影响。但是,如果主线程要修改一块数据(例如图中的键值对 C),那么,这块数据就会被复制一份,生成该数据的副本。然后,bgsave 子进程会把这个副本数据写入 RDB 文件,而在这个过程中,主线程仍然可以直接修改原来的数据。

在进行快照操作的这段时间,如果发生服务崩溃怎么办?

很简单,在没有将数据全部写入到磁盘前,这次快照操作都不算成功。如果出现了服务崩溃的情况,将以上一次完整的RDB快照文件作为恢复内存数据的参考。也就是说,在快照操作过程中不能影响上一次的备份数据。Redis服务会在磁盘上创建一个临时文件进行数据操作,待操作成功后才会用这个临时文件替换掉上一次的备份。

可以每秒做一次快照吗?

对于快照来说,所谓“连拍”就是指连续地做快照。这样一来,快照的间隔时间变得很短,即使某一时刻发生宕机了,因为上一时刻快照刚执行,丢失的数据也不会太多。但是,这其中的快照间隔时间就很关键了。

如下图所示,我们先在 T0 时刻做了一次快照,然后又在 T0+t 时刻做了一次快照,在这期间,数据块 5 和 9 被修改了。如果在 t 这段时间内,机器宕机了,那么,只能按照 T0 时刻的快照进行恢复。此时,数据块 5 和 9 的修改值因为没有快照记录,就无法恢复了。

所以,要想尽可能恢复数据,t 值就要尽可能小,t 越小,就越像“连拍”。那么,t 值可以小到什么程度呢,比如说 是不是可以每秒做一次快照?毕竟,每次快照都是由 bgsave 子进程在后台执行,也不会阻塞主线程。

这种想法其实是错误的。虽然 bgsave 执行时不阻塞主线程,但是, 如果频繁地执行全量快照,也会带来两方面的开销:

- 一方面,频繁将全量数据写入磁盘,会给磁盘带来很大压力,多个快照竞争有限的磁盘带宽,前一个快照还没有做完,后一个又开始做了,容易造成恶性循环。

- 另一方面,bgsave 子进程需要通过 fork 操作从主线程创建出来。虽然,子进程在创建后不会再阻塞主线程,但是,fork 这个创建过程本身会阻塞主线程,而且主线程的内存越大,阻塞时间越长。如果频繁 fork 出 bgsave 子进程,这就会频繁阻塞主线程了。

那么,有什么其他好方法吗?此时,我们可以做 增量快照,就是指做了一次全量快照后,后续的快照只对修改的数据进行快照记录,这样可以避免每次全量快照的开销。 这个比较好理解。

但是它需要我们使用额外的元数据信息去记录哪些数据被修改了,这会带来额外的空间开销问题。那么,还有什么方法既能利用 RDB 的快速恢复,又能以较小的开销做到尽量少丢数据呢?且看后文中 4.0版本中引入的RDB和AOF的混合方式 。

RDB优缺点

优点

- RDB文件是某个时间节点的快照,默认使用LZF算法进行压缩,压缩后的文件体积远远小于内存大小,适用于备份、全量复制等场景;

- Redis加载RDB文件恢复数据要远远快于AOF方式;

缺点

- RDB方式实时性不够,无法做到秒级的持久化;

- 每次调用bgsave都需要fork子进程,fork子进程属于重量级操作,频繁执行成本较高;

- RDB文件是二进制的,没有可读性,AOF文件在了解其结构的情况下可以手动修改或者补全;

- 版本兼容RDB文件问题;

针对RDB不适合实时持久化的问题,Redis提供了AOF持久化方式来解决。

AOF(Append Only File)持久化

Redis是 “写后”日志,Redis先执行命令,把数据写入内存,然后才记录日志。 日志里记录的是Redis收到的每一条命令,这些命令是以文本形式保存。PS: 大多数的数据库采用的是写前日志(WAL),例如MySQL,通过写前日志和两阶段提交,实现数据和逻辑的一致性。

而AOF日志采用写后日志,即 先写内存,后写日志 。

为什么采用写后日志?

Redis要求高性能,采用写日志有两方面好处:

- 避免额外的检查开销 :Redis 在向 AOF 里面记录日志的时候,并不会先去对这些命令进行语法检查。所以,如果先记日志再执行命令的话,日志中就有可能记录了错误的命令,Redis 在使用日志恢复数据时,就可能会出错。

- 不会阻塞当前的写操作

但这种方式存在 潜在风险 :

- 如果命令执行完成,写日志之前宕机了,会丢失数据。

- 主线程写磁盘压力大,导致写盘慢,阻塞后续操作。

如何实现AOF

AOF日志记录Redis的每个写命令,步骤分为: 命令追加(append)、文件写入(write)和文件同步(sync)。

- 命令追加 :当AOF持久化功能打开了,服务器在执行完一个写命令之后,会以协议格式将被执行的写命令追加到服务器的 aof_buf 缓冲区。

- 文件写入和同步 :关于何时将 aof_buf 缓冲区的内容写入AOF文件中,Redis提供了 三种写回策略:

Always ,同步写回:每个写命令执行完,立马同步地将日志写回磁盘;

Everysec ,每秒写回:每个写命令执行完,只是先把日志写到AOF文件的内存缓冲区,每隔一秒把缓冲区中的内容写入磁盘;

No ,操作系统控制的写回:每个写命令执行完,只是先把日志写到AOF文件的内存缓冲区,由操作系统决定何时将缓冲区内容写回磁盘。

三种写回策略的优缺点

上面的三种写回策略体现了一个重要原则: **** trade-off,取舍,指在性能和可靠性保证之间做取舍。

关于AOF的同步策略是涉及到操作系统的 write 函数和 fsync 函数的,在《Redis设计与实现》中是这样说明的:

为了提高文件写入效率,在现代操作系统中,当用户调用write函数,将一些数据写入文件时,操作系统通常会将数据暂存到一个内存缓冲区里,当缓冲区的空间被填满或超过了指定时限后,才真正将缓冲区的数据写入到磁盘里。

这样的操作虽然提高了效率,但也为数据写入带来了安全问题:如果计算机停机,内存缓冲区中的数据会丢失。为此,系统提供了fsync、fdatasync同步函数,可以强制操作系统立刻将缓冲区中的数据写入到硬盘里,从而确保写入数据的安全性。

redis.conf中配置AOF

默认情况下,Redis是没有开启AOF的 ,可以通过配置redis.conf文件来开启AOF持久化,关于AOF的配置如下:

# appendonly参数开启AOF持久化

appendonly no

# AOF持久化的文件名,默认是appendonly.aof

appendfilename "appendonly.aof"

# AOF文件的保存位置和RDB文件的位置相同,都是通过dir参数设置的

dir ./

# 同步策略

# appendfsync always

appendfsync everysec

# appendfsync no

# aof重写期间是否同步

no-appendfsync-on-rewrite no

# 重写触发配置

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

# 加载aof出错如何处理

aof-load-truncated yes

# 文件重写策略

aof-rewrite-incremental-fsync yes

code here...

以下是Redis中关于AOF的主要配置信息:

appendonly #默认情况下AOF功能是关闭的,将该选项改为yes以便打开Redis的AOF功能。

appendfilename #这个参数项很好理解了,就是AOF文件的名字。

appendfsync #这个参数项是AOF功能最重要的设置项之一,主要用于设置“真正执行”操作命令向AOF文件中同步的策略。

什么叫“真正执行”呢?还记得Linux操作系统对磁盘设备的操作方式吗?为了保证操作系统中I/O队列的操作效率,应用程序提交的I/O操作请求一般是被放置在linux Page Cache中的,然后再由Linux操作系统中的策略自行决定正在写到磁盘上的时机。而Redis中有一个fsync()函数,可以将Page Cache中待写的数据真正写入到物理设备上,而缺点是频繁调用这个fsync()函数干预操作系统的既定策略,可能导致I/O卡顿的现象频繁 。

与上节对应,appendfsync参数项可以设置三个值,分别是:always、everysec、no,默认的值为everysec。

-

no-appendfsync-on-rewrite:always和everysec的设置会使真正的I/O操作高频度的出现,甚至会出现长时间的卡顿情况,这个问题出现在操作系统层面上,所有靠工作在操作系统之上的Redis是没法解决的。为了尽量缓解这个情况,Redis提供了这个设置项,保证在完成fsync函数调用时,不会将这段时间内发生的命令操作放入操作系统的Page Cache(这段时间Redis还在接受客户端的各种写操作命令)。

-

auto-aof-rewrite-percentage:上文说到在生产环境下,技术人员不可能随时随地使用“BGREWRITEAOF”命令去重写AOF文件。所以更多时候我们需要依靠Redis中对AOF文件的自动重写策略。Redis中对触发自动重写AOF文件的操作提供了两个设置:auto-aof-rewrite-percentage表示如果当前AOF文件的大小超过了上次重写后AOF文件的百分之多少后,就再次开始重写AOF文件。例如该参数值的默认设置值为100,意思就是如果AOF文件的大小超过上次AOF文件重写后的1倍,就启动重写操作。

-

auto-aof-rewrite-min-size:参考auto-aof-rewrite-percentage选项的介绍,auto-aof-rewrite-min-size设置项表示启动AOF文件重写操作的AOF文件最小大小。如果AOF文件大小低于这个值,则不会触发重写操作。注意,auto-aof-rewrite-percentage和auto-aof-rewrite-min-size只是用来控制Redis中自动对AOF文件进行重写的情况,如果是技术人员手动调用“BGREWRITEAOF”命令,则不受这两个限制条件左右。

深入理解AOF重写

AOF会记录每个写命令到AOF文件,随着时间越来越长,AOF文件会变得越来越大。如果不加以控制,会对Redis服务器,甚至对操作系统造成影响,而且AOF文件越大,数据恢复也越慢。 为了解决AOF文件体积膨胀的问题,Redis提供AOF文件重写机制来对AOF文件进行“瘦身”。

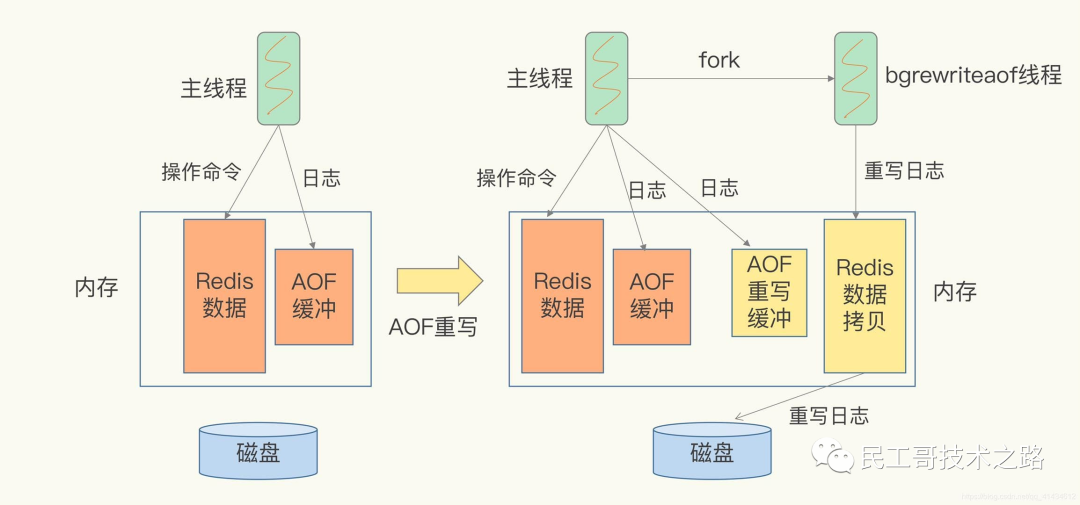

图例解释AOF重写

Redis通过创建一个新的AOF文件来替换现有的AOF,新旧两个AOF文件保存的数据相同,但新AOF文件没有了冗余命令。

AOF重写会阻塞吗?

AOF重写过程是由后台进程bgrewriteaof来完成的。主线程fork出后台的bgrewriteaof子进程,fork会把主线程的内存拷贝一份给bgrewriteaof子进程,这里面就包含了数据库的最新数据。然后,bgrewriteaof子进程就可以在不影响主线程的情况下,逐一把拷贝的数据写成操作,记入重写日志。

所以aof在重写时,在fork进程时是会阻塞住主线程的。

AOF日志何时会重写?

有两个配置项控制AOF重写的触发:

-

auto-aof-rewrite-min-size :表示运行AOF重写时文件的最小大小,默认为64MB。

-

auto-aof-rewrite-percentage :这个值的计算方式是,当前aof文件大小和上一次重写后aof文件大小的差值,再除以上一次重写后aof文件大小。也就是当前aof文件比上一次重写后aof文件的增量大小,和上一次重写后aof文件大小的比值。

重写日志时,有新数据写入咋整?

重写过程总结为:“一个拷贝,两处日志”。在fork出子进程时的拷贝,以及在重写时,如果有新数据写入,主线程就会将命令记录到两个aof日志内存缓冲区中。如果AOF写回策略配置的是always,则直接将命令写回旧的日志文件,并且保存一份命令至AOF重写缓冲区,这些操作对新的日志文件是不存在影响的。(旧的日志文件:主线程使用的日志文件,新的日志文件:bgrewriteaof进程使用的日志文件)

而在bgrewriteaof子进程完成会日志文件的重写操作后,会提示主线程已经完成重写操作,主线程会将AOF重写缓冲中的命令追加到新的日志文件后面。这时候在高并发的情况下,AOF重写缓冲区积累可能会很大,这样就会造成阻塞,Redis后来通过Linux管道技术让aof重写期间就能同时进行回放,这样aof重写结束后只需回放少量剩余的数据即可。

最后通过修改文件名的方式,保证文件切换的原子性。

在AOF重写日志期间发生宕机的话,因为日志文件还没切换,所以恢复数据时,用的还是旧的日志文件。

总结操作:

- 主线程fork出子进程重写aof日志

- 子进程重写日志完成后,主线程追加aof日志缓冲

- 替换日志文件

温馨提示:这里的进程和线程的概念有点混乱。因为后台的bgreweiteaof进程就只有一个线程在操作,而主线程是Redis的操作进程,也是单独一个线程。这里想表达的是Redis主进程在fork出一个后台进程之后,后台进程的操作和主进程是没有任何关联的,也不会阻塞主线程。

主线程fork出子进程的是如何复制内存数据的?

fork采用操作系统提供的写时复制(copy on write)机制,就是为了避免一次性拷贝大量内存数据给子进程造成阻塞。fork子进程时,子进程时会拷贝父进程的页表,即虚实映射关系(虚拟内存和物理内存的映射索引表),而不会拷贝物理内存。这个拷贝会消耗大量cpu资源,并且拷贝完成前会阻塞主线程,阻塞时间取决于内存中的数据量,数据量越大,则内存页表越大。拷贝完成后,父子进程使用相同的内存地址空间。

但主进程是可以有数据写入的,这时候就会拷贝物理内存中的数据。如下图(进程1看做是主进程,进程2看做是子进程):

在主进程有数据写入时,而这个数据刚好在页c中,操作系统会创建这个页面的副本(页c的副本),即拷贝当前页的物理数据,将其映射到主进程中,而子进程还是使用原来的的页c。

在重写日志整个过程时,主线程有哪些地方会被阻塞?

- fork子进程时,需要拷贝虚拟页表,会对主线程阻塞。

- 主进程有bigkey写入时,操作系统会创建页面的副本,并拷贝原有的数据,会对主线程阻塞。

- 子进程重写日志完成后,主进程追加aof重写缓冲区时可能会对主线程阻塞。

为什么AOF重写不复用原AOF日志?

两方面原因:

- 父子进程写同一个文件会产生竞争问题,影响父进程的性能。

- 如果AOF重写过程中失败了,相当于污染了原本的AOF文件,无法做恢复数据使用。

RDB和AOF混合方式(4.0版本)

Redis 4.0 中提出了一个混合使用 AOF 日志和内存快照的方法。简单来说,内存快照以一定的频率执行,在两次快照之间,使用 AOF 日志记录这期间的所有命令操作。

这样一来,快照不用很频繁地执行,这就避免了频繁 fork 对主线程的影响。而且,AOF 日志也只用记录两次快照间的操作,也就是说,不需要记录所有操作了,因此,就不会出现文件过大的情况了,也可以避免重写开销。

如下图所示,T1 和 T2 时刻的修改,用 AOF 日志记录,等到第二次做全量快照时,就可以清空 AOF 日志,因为此时的修改都已经记录到快照中了,恢复时就不再用日志了。

这个方法既能享受到 RDB 文件快速恢复的好处,又能享受到 AOF 只记录操作命令的简单优势, 实际环境中用的很多。

从持久化中恢复数据

数据的备份、持久化做完了,我们如何从这些持久化文件中恢复数据呢?如果一台服务器上有既有RDB文件,又有AOF文件,该加载谁呢?

其实想要从这些文件中恢复数据,只需要重新启动Redis即可。我们还是通过图来了解这个流程:

- redis重启时判断是否开启aof,如果开启了aof,那么就优先加载aof文件;

- 如果aof存在,那么就去加载aof文件,加载成功的话redis重启成功,如果aof文件加载失败,那么会打印日志表示启动失败,此时可以去修复aof文件后重新启动;

- 若aof文件不存在,那么redis就会转而去加载rdb文件,如果rdb文件不存在,redis直接启动成功;

- 如果rdb文件存在就会去加载rdb文件恢复数据,如加载失败则打印日志提示启动失败,如加载成功,那么redis重启成功,且使用rdb文件恢复数据;

那么为什么会优先加载AOF呢?因为AOF保存的数据更完整,通过上面的分析我们知道AOF基本上最多损失1s的数据。

性能与实践

通过上面的分析,我们都知道RDB的快照、AOF的重写都需要fork,这是一个重量级操作,会对Redis造成阻塞。因此为了不影响Redis主进程响应,我们需要尽可能降低阻塞。

- 降低fork的频率,比如可以手动来触发RDB生成快照、与AOF重写;

- 控制Redis最大使用内存,防止fork耗时过长;

- 使用更牛逼的硬件;

- 合理配置Linux的内存分配策略,避免因为物理内存不足导致fork失败。

在线上我们到底该怎么做?我提供一些自己的实践经验。

- 如果Redis中的数据并不是特别敏感或者可以通过其它方式重写生成数据,可以关闭持久化,如果丢失数据可以通过其它途径补回;

- 自己制定策略定期检查Redis的情况,然后可以手动触发备份、重写数据;

- 单机如果部署多个实例,要防止多个机器同时运行持久化、重写操作,防止出现内存、CPU、IO资源竞争,让持久化变为串行;

- 可以加入主从机器,利用一台从机器进行备份处理,其它机器正常响应客户端的命令;

- RDB持久化与AOF持久化可以同时存在,配合使用。

来源:https://www.pdai.tech/md/db/nosql-redis/db-redis-x-rdb-aof.html

(八):Redis 主从复制及数据恢复实践

概念

主从复制,是指将一台 Redis 服务器的数据,复制到其他的 Redis 服务器。前者称之为主节点(master/leader),后者称之为从节点(slave/flower);数据的复制都是单向的,只能从主节点到从节点。Master 以写为主,Slave 以读为主。

默认情况下,每台 Redis 服务器都是主节点。且一个主节点可以有多个从节点或者没有从节点,但是一个从节点只能有一个主节点。

主从复制的作用

1、数据冗余 :主从复制实现了数据的热备份,是持久化的之外的一种数据冗余方式。

2、故障恢复 :当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复。实际也是一种服务的冗余。

3、负载均衡 :在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写 Redis 数据时应用连接主节点,读 Redis 的时候应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个节点分担读负载,可以大大提高 Redis 服务器的并发量。

4、高可用(集群)的基石 :除了上述作用以外,主从复制还是哨兵模式和集群能够实施的基础,因此说主从复制是 Redis 高可用的基础。

一般来说,要将Redis 运用于工程项目中, 只使用一台 Redis 是万万不能的(可能会宕机),原因如下:

1、从结构上,单个 Redis 服务器会发生单点故障,并且一台服务器需要处理所有的请求负载,压力很大;

2、从容量上,单个 Redis 服务器内存容量有限,就算一台 Redis 服务器内存容量为 265G, 也不能将所有的内存用作 Redis 存储内存,一般来说, 单台 Redis最大使用内存不应该超过 20G。

电商网站上的商品,一般都是一次上传,无数次浏览的,说专业点就是“ 多读少写 ”。

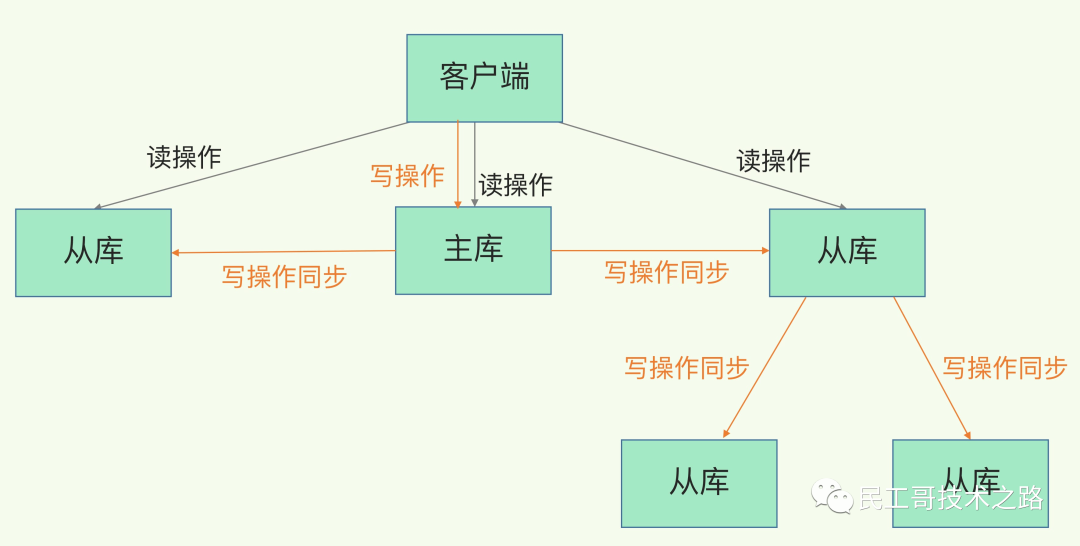

对于这种场景,我们可以使用如下这种架构:

主从复制,读写分离 !80% 的情况下,都是在进行读操作。这种架构可以减少服务器压力,经常使用实际生产环境中, 最少是“一主二从”的配置 。真实环境中不可能使用单机 Redis。

主从复制原理

注意:在2.8版本之前只有全量复制,而2.8版本后有全量和增量复制:

- 全量(同步)复制 :比如第一次同步时

- 增量(同步)复制 :只会把主从库网络断连期间主库收到的命令,同步给从库

全量复制

当我们启动多个 Redis 实例的时候,它们相互之间就可以通过 replicaof(Redis 5.0 之前使用 slaveof)命令形成主库和从库的关系,之后会按照三个阶段完成数据的第一次同步。

确立主从关系

例如,现在有实例 1(ip:172.16.19.3)和实例 2(ip:172.16.19.5),我们在实例 2 上执行以下这个命令后,实例 2 就变成了实例 1 的从库,并从实例 1 上复制数据:

replicaof 172.16.19.3 6379

全量复制的三个阶段

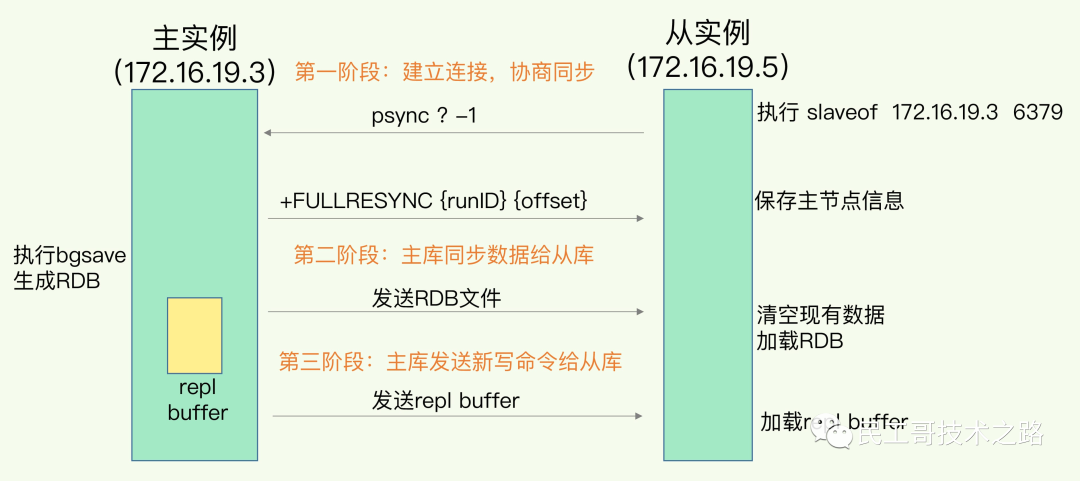

你可以先看一下下面这张图,有个整体感知,接下来我再具体介绍。

第一阶段是主从库间建立连接、协商同步的过程 ,主要是为全量复制做准备。在这一步,从库和主库建立起连接,并告诉主库即将进行同步,主库确认回复后,主从库间就可以开始同步了。

具体来说,从库给主库发送 psync 命令,表示要进行数据同步,主库根据这个命令的参数来启动复制。psync 命令包含了主库的 runID 和复制进度 offset 两个参数。runID,是每个 Redis 实例启动时都会自动生成的一个随机 ID,用来唯一标记这个实例。当从库和主库第一次复制时,因为不知道主库的 runID,所以将 runID 设为“?”。offset,此时设为 -1,表示第一次复制。主库收到 psync 命令后,会用 FULLRESYNC 响应命令带上两个参数:主库 runID 和主库目前的复制进度 offset,返回给从库。从库收到响应后,会记录下这两个参数。这里有个地方需要注意,FULLRESYNC 响应表示第一次复制采用的全量复制,也就是说,主库会把当前所有的数据都复制给从库。更多关于 Redis 学习的文章,请参阅:NoSQL 数据库系列之 Redis ,本系列持续更新中。