先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

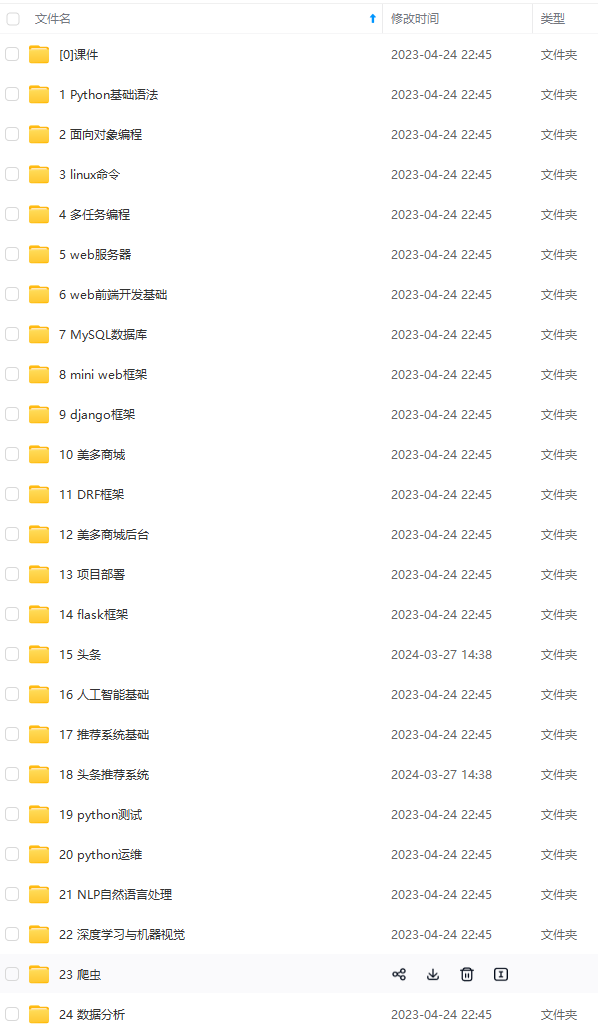

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

分析(x0)

======

登录篇

谈谈selenium与requests的区别:

selenium:操控网页元素,模拟人去控制浏览器,放弃与底层协议的交互,控制于客户端表面(速度慢)

requests:模拟客户端像服务器发送协议请求,处于底层协议的交互。(速度快)

既然是模拟人去控制浏览器就好说了,想要采集某个网站第一步是做什么?

实例化一款需要被控制的浏览器,然后打开该网址:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get(‘http://www.taobao.com’)

然后在输入框中输入咱们需要查找的商品,再点击搜索即可。

咱们今天重点利用到的为xpath网页元素定位法,通过xpath语法去定位元素的位置,因为程序不是人,人可以肉眼知道哪里是输入框,哪里是按钮。而程序需要咱们去告诉它,给它制定位置。

输入Python

driver.find_element_by_id(‘q’).send_keys(‘python’)

点击搜索

driver.find_element_by_class_name(‘btn-search’).click()

定位的方法很多,我这里两句代码用到的是为id定位和类名定位。

最后在停留在登录界面:

咱们采用扫码登录。

既然是这样子做的话,势必会需要一个时间供给你去登录,有人会采用延迟的方式,但是我不建议这样做。

因为延迟的时间不一定就能保证你刚好可以登录完,多了时间少了时间对咱们都不友好。少了时间还没登录上,程序就跑到别的地方去了报错了。多了时间你也懒得等。

所以在此之前咱们程序加上一行

input(‘扫码完成后请按Enter键’)

这样子做的话,咱们可以人为的控制时间。最终登录完成。

分析(x1)

======

数据的提取

登录上去后可以看到很多的商品信息,咱们要采集的就是…都采集下来吧,什么图片、销量、地址、标题啥的

前面咱们提到了通过元素进行输入框自动输入、按钮点击。那么现在要做的就是通过元素定位去采集咱们想要的数据。

分析(x2)

======

通过元素分析我们可以发现,这里的每一个DIV标签都保存了一个商品的信息,而前面三个class属性略有不同。应该是他们自费的一个广告商品吧,排名指定的那种。

简单分析了一下可以看到第三个商品的图片地址在img标签的src中:

然后第47个商品的信息却不完善:

可以很清楚的发现这个商品的src的图片链接是不正常的,是没有图片的。

这个是为什么呢?还记得我前面文章(某音视频采集)讲到过的动态加载、瀑布流吗?当我们的滑动条往下滑的时候下面的数据才会加载出来,像瀑布一样的流出来。

所以如果我们想要采集到所有的商品图片,那么咱们就需要把这个下滑条往下面拉动 ,如何利用selenium控制这个下滑条往下面拉动呢?

for x in range(1, 11, 2):

time.sleep(0.5)

j = x/10

js = ‘document.documentElement.scrollTop = document.documentElement.scrollHeight * %f’ % j

driver.execute_script(js)

每停顿0.5S的时间,拉动下滑条的十分之三的位置。

登录成功后按一下enter键,代码就会跳到下拉滑块的位置,执行下拉。

分析(x3)

======

数据都加载出来了后,咱们只管采集就好啦。采集的规则利用的是xpath定位法,这里我不做过多讲解。看我代码然后自己分析一下。

lis = driver.find_elements_by_xpath(‘//div[@class=“items”]/div[@class="item J_MouserOnverReq "]’)

for li in lis:

info = li.find_element_by_xpath(‘.//div[@class=“row row-2 title”]’).text

price = li.find_element_by_xpath(‘.//a[@class=“J_ClickStat”]’).get_attribute(‘trace-price’) + ‘元’

deal = li.find_element_by_xpath(‘.//div[@class=“deal-cnt”]’).text

image = li.find_element_by_xpath(‘.//div[@class=“pic”]/a/img’).get_attribute(‘src’)

name = li.find_element_by_xpath(‘.//div[@class=“shop”]/a/span[2]’).text

position = li.find_element_by_xpath(‘.//div[@class=“row row-3 g-clearfix”]/div[@class=“location”]’).text

print(info + ‘|’ + price + ‘|’ + deal + ‘|’ + name + ‘|’ + image + ‘|’ + position)

效果:

到此为止咱们第一页的商品数据已经采集下来了,那么如何采集所有页码的数据呢?

分析(x4)

======

在采集所有页码数据之前咱们先需要考虑的是什么?是这个商品总共有多少页吧?也许这个商品三十页,另一个商品100页,对不对?

而这个商品总页码在哪里看?

在哪里看咱们知道了,那么什么时候去采集到这个页码数呢?是不是当我们登录了之后就可以看到这个页码数了呀?那么咱们登录之后先把页码数采集下来!

token = driver.find_element_by_xpath(‘//*[@id=“mainsrp-pager”]/div/div/div/div[1]’)

token = token.text

token = int(re.compile(‘(\d+)’).search(token).group(1))

最后就剩下如何进入下一页了,我经常提到的,看网页的url是否会发生什么变化。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

最后就剩下如何进入下一页了,我经常提到的,看网页的url是否会发生什么变化。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-5QhHUjF8-1713426391177)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

516

516

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?