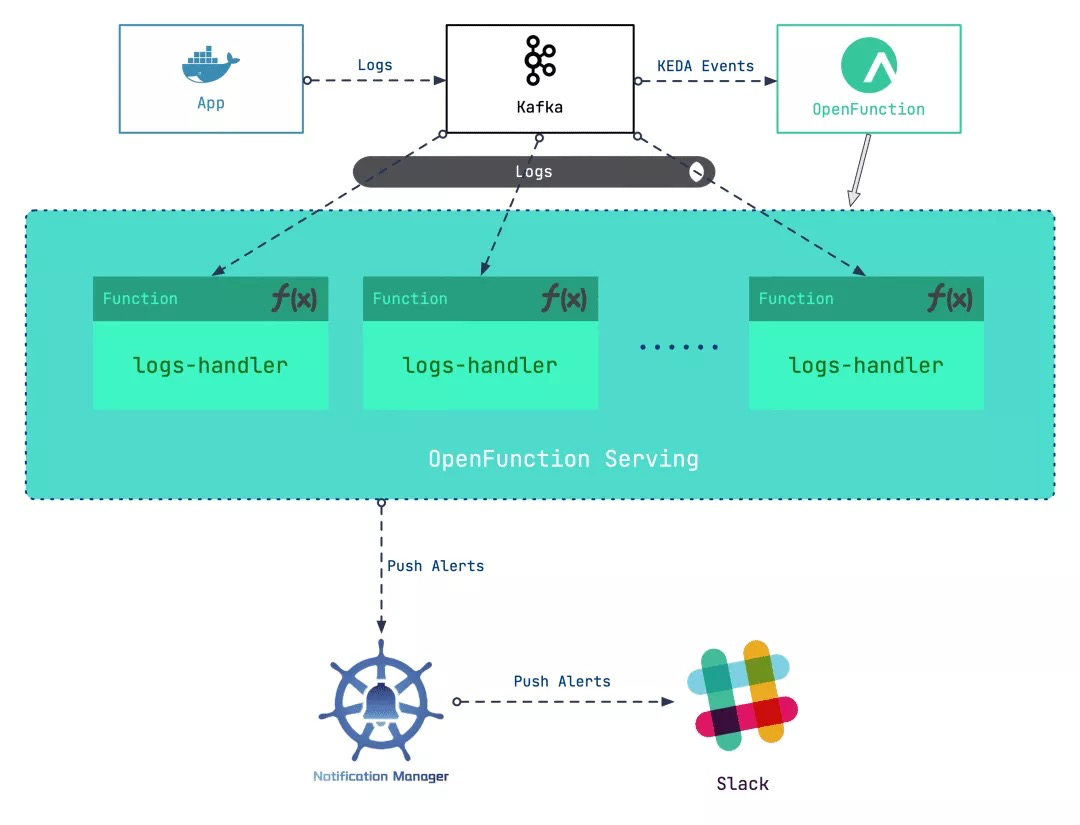

当我们将容器的日志收集到消息服务器之后,我们该如何处理这些日志?部署一个专用的日志处理工作负载可能会耗费多余的成本,而当日志体量骤增、骤降时亦难以评估日志处理工作负载的待机数量。本文提供了一种基于 Serverless 的日志处理思路,可以在降低该任务链路成本的同时提高其灵活性。

我们的大体设计是使用 Kafka 服务器作为日志的接收器,之后以输入 Kafka 服务器的日志作为事件,驱动 Serverless 工作负载对日志进行处理。据此的大致步骤为:

-

搭建 Kafka 服务器作为 Kubernetes 集群的日志接收器

-

部署 OpenFunction 为日志处理工作负载提供 Serverless 能力

-

编写日志处理函数,抓取特定的日志生成告警消息

-

配置 <b>Notification Manager[1]</b> 将告警发送至 Slack

在这个场景中,我们会利用到 <b>OpenFunction[2]</b> 带来的 Serverless 能力。

OpenFunction[3] 是 KubeSphere 社区开源的一个 FaaS(Serverless)项目,旨在让用户专注于他们的业务逻辑,而不必关心底层运行环境和基础设施。该项目当前具备以下关键能力:

- 支持通过 dockerfile 或 buildpacks 方式构建 OCI 镜像

- 支持使用 Knative Serving 或 OpenFunctionAsync ( KEDA + Dapr ) 作为 runtime 运行 Serverless 工作负载

- 自带事件驱动框架

使用 Kafka 作为日志接收器

首先,我们为 KubeSphere 平台开启 <b>logging</b> 组件(可以参考 <b>启用可插拔组件[3]</b> 获取更多信息)。然后我们使用 <b>strimzi-kafka-operator[5]</b> 搭建一个最小化的 Kafka 服务器。

-

在 default 命名空间中安装 <b>strimzi-kafka-operator[6]</b> :

helm repo add strimzi https://strimzi.io/charts/ helm install kafka-operator -n default strimzi/strimzi-kafka-operator -

运行以下命令在 default 命名空间中创建 Kafka 集群和 Kafka Topic,该命令所创建的 Kafka 和 Zookeeper 集群的存储类型为 <b>ephemeral</b>,使用 emptyDir 进行演示。

注意,我们此时创建了一个名为 “logs” 的 topic,后续会用到它

cat <<EOF | kubectl apply -f -

apiVersion: kafka.strimzi.io/v1beta2

kind: Kafka

metadata:

name: kafka-logs-receiver

namespace: default

spec:

kafka:

version: 2.8.0

replicas: 1

listeners:

- name: plain

port: 9092

type: internal

tls: false

- name: tls

port: 9093

type: internal

tls: true

config:

offsets.topic.replication.factor: 1

transaction.state.log.replication.factor: 1

transaction.state.log.min.isr: 1

log.message.format.version: '2.8'

inter.broker.protocol.version: "2.8"

storage:

type: ephemeral

zookeeper:

replicas: 1

storage:

type: ephemeral

entityOperator:

topicOperator: {}

userOperator: {}

---

apiVersion: kafka.strimzi.io/v1beta1

kind: KafkaTopic

metadata:

name: logs

namespace: default

labels:

strimzi.io/cluster: kafka-logs-receiver

spec:

partitions: 10

replicas: 3

config:

retention.ms: 7200000

segment.bytes: 1073741824

EOF

-

运行以下命令查看 Pod 状态,并等待 Kafka 和 Zookeeper 运行并启动。

$ kubectl get po NAME READY STATUS RESTARTS AGE kafka-logs-receiver-entity-operator-568957ff84-nmtlw 3/3 Running 0 8m42s kafka-logs-receiver-kafka-0 1/1 Running 0 9m13s kafka-logs-receiver-zookeeper-0 1/1 Running 0 9m46s strimzi-cluster-operator-687fdd6f77-cwmgm

当我们将容器的日志收集到消息服务器之后,我们该如何处理这些日志?部署一个专用的日志处理工作负载可能会耗费多余的成本,而当日志体量骤增、骤降时亦难以评估日志处理工作负载的待机数量。本文提供了一种基于 Serverless 的日志处理思路,可以在降低该任务链路成本的同时提高其灵活性。我们的大体设计是使用 Kafka 服务器作为日志的接收器,之后以输入 Kafka 服务器的日志作为事件,驱动 Serverless 工作负载对日志进行处理。据此的大致步骤为: 搭建 Kafka 服务器作为 Kubernet

当我们将容器的日志收集到消息服务器之后,我们该如何处理这些日志?部署一个专用的日志处理工作负载可能会耗费多余的成本,而当日志体量骤增、骤降时亦难以评估日志处理工作负载的待机数量。本文提供了一种基于 Serverless 的日志处理思路,可以在降低该任务链路成本的同时提高其灵活性。我们的大体设计是使用 Kafka 服务器作为日志的接收器,之后以输入 Kafka 服务器的日志作为事件,驱动 Serverless 工作负载对日志进行处理。据此的大致步骤为: 搭建 Kafka 服务器作为 Kubernet

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1091

1091

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?