一、处理问题

对于给定的每个样本的一系列特征(x1, x2, ...xm)及其结果y,之间的关系可以用这种形式表示y=θ_1*x1+θ_2*x2+...θ_m*xm,那么可以建立这样的模型:

h_θ(x)=θx 用来对新的样本结果进行预测,θ和x都是m+1维向量,并且令x0=1。

二、参数求解

对于以上模型,需要对参数θ进行求解。

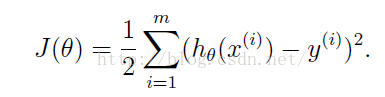

直觉上,我们期望得到的θ的解应当满足条件——对所有训练样本,使以下代价函数的值最小

该函数表示的含义是,使用模型根据样本的特征计算得到的假设结果值与样本实际结果的差的平方和最小,这样保证了对于训练样本整体而言,选择的参数θ是最优的。

而为了计算满足条件的θ,需要使用梯度下降法

J(θ)对θ_j求偏导数的结果,当只有一个样本时为(θx-y)x_j,当有m个样本时为

∑(i=1,...m) (θx(i)-y(i))x(i)_j

梯度下降执行如下过程

这种方法在每次迭代中,对于每个θ_j,都要使用所有的样本数据对其进行更新,称为批梯度下降(batch gradient descent),当训练样本的数据集很大的,执行该算法的代价较大,可以选择另一种随机梯度下降:

这种方法,在每次更新时只考虑一个样本数据,这使得该方法的速度比批梯度下降快得多,但是该方法不能精确下降到全局最小值,而是会在最小值附近徘徊。

262

262

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?