目录

Hadoop平台安装

实验一 Linux操作系统环境设置

实验任务一:配置 Linux 系统基础环境

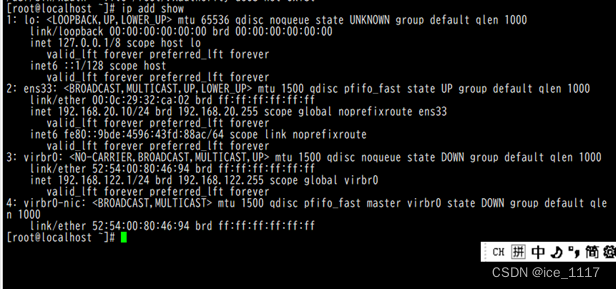

步骤一:查看服务器的 IP 地址:ip add show

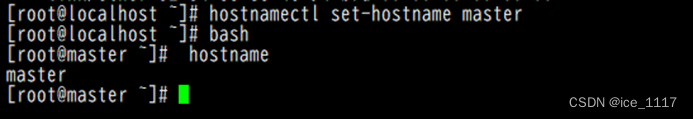

步骤二:设置服务器的主机名称

[root@localhost ~]# hostnamectl set-hostname master

[root@localhost ~]# bash

[root@master ~]# hostname

master

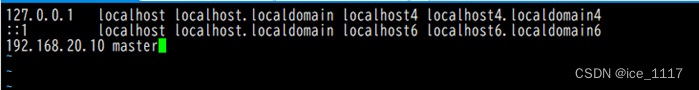

步骤三:绑定主机名与 IP 地址

[root@master ~]# vi /etc/hosts

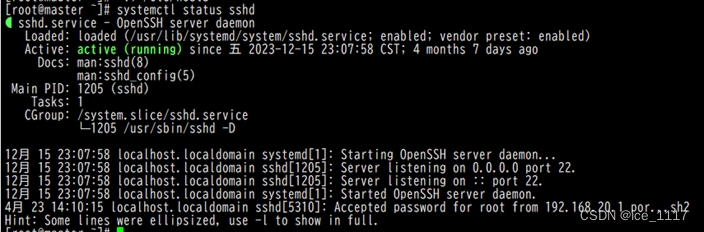

步骤四:查看 SSH 服务状态

[root@master ~]# systemctl status sshd

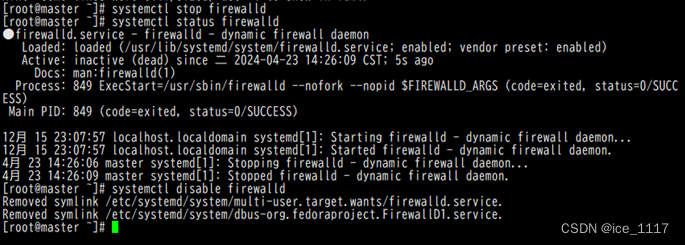

步骤五:关闭防火墙

[root@master ~]# systemctl stop firewalld

[root@master ~]# systemctl status firewalld

[root@master ~]# systemctl disable firewalld

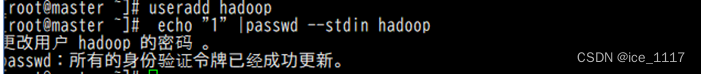

步骤六:创建 hadoop 用户

[root@master ~]# useradd Hadoop

[root@master ~]# echo "1" |passwd --stdin hadoop

实验任务二:安装 JAVA 环境

步骤一:下载 JDK 安装包(jdk-8u152-linuxx64.tar.gz)

官网地址:https://www.oracle.com/java /technologies /javase-jdk8-downloads.html

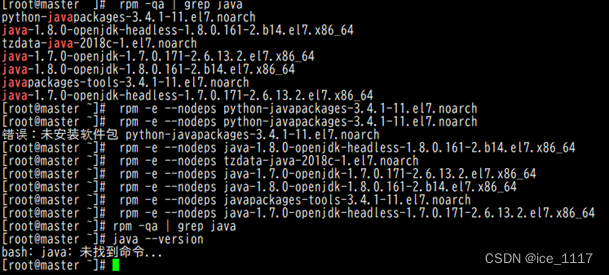

步骤二:卸载自带 OpenJDK

[root@master ~]# rpm -qa | grep java

卸载相关服务,键入命令 rpm –e –nodeps 删除的包

[root@master ~]# rpm -qa | grep java

[root@master ~]# java --version

bash: java: 未找到命令

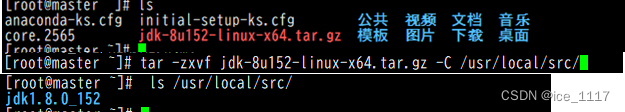

步骤三:安装 JDK

安装命令如下,将安装包解压到/usr/local/src 目录下,将安装包放在了root目录下

[root@master ~]# tar -zxvf jdk-8u152-linux-x64.tar.gz -C /usr/local/src/

[root@master ~]# ls /usr/local/src/

jdk1.8.0_152

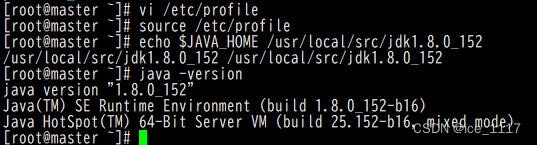

步骤四:设置 JAVA 环境变量

[root@master ~]# vi /etc/profile

在文件的最后增加如下两行:

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

执行 source 使设置生效:

[root@master ~]# source /etc/profile

检查 JAVA 是否可用。

[root@master ~]# echo $JAVA_HOME /usr/local/src/jdk1.8.0_152

[root@master ~]# java -version

java version "1.8.0_152"

Java(TM) SE Runtime Environment (build 1.8.0_152-b16)

Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

能够正常显示 Java 版本则说明 JDK 安装并配置成功。

实验二 安装 Hadoop 软件

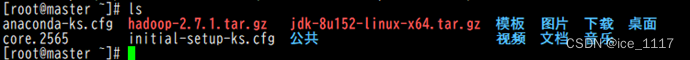

实验任务一:获取 Hadoop 安装包

安装包为 hadoop-2.7.1.tar.gz。需要先下载 Hadoop 安装包,再上传到 Linux 系统的/opt/software 目录。

实验任务二:安装 Hadoop 软件

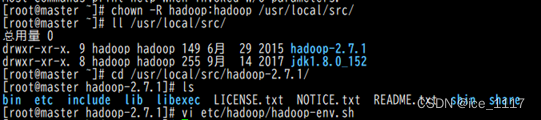

步骤一:安装 Hadoop 软件

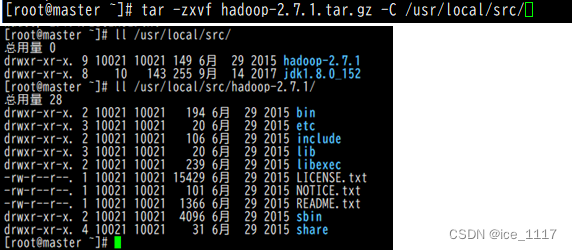

[root@master ~]# tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local/src/

[root@master ~]# ll /usr/local/src/

总用量 0

drwxr-xr-x. 9 10021 10021 149 6月 29 2015 hadoop-2.7.1

drwxr-xr-x. 8 10 143 255 9月 14 2017 jdk1.8.0_152

查看 Hadoop 目录,得知 Hadoop 目录内容如下:

[root@master ~]# ll /usr/local/src/hadoop-2.7.1/

总用量 28

drwxr-xr-x. 2 10021 10021 194 6月 29 2015 bin

drwxr-xr-x. 3 10021 10021 20 6月 29 2015 etc

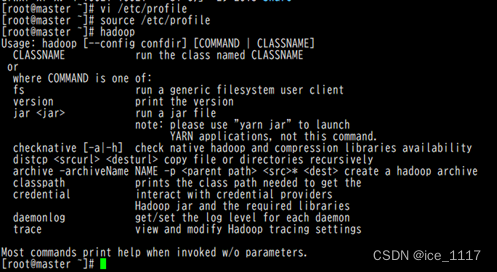

步骤二:配置 Hadoop 环境变量

[root@master ~]# vi /etc/profile

在文件的最后增加如下两行:

export HADOOP_HOME=/usr/local/src/hadoop-2.7.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

执行 source 使用设置生效:

[root@master ~]# source /etc/profile

检查设置是否生效:

[root@master ~]# hadoop

Usage: hadoop [--config confdir] [COMMAND | CLASSNAME]

CLASSNAME run the class named CLASSNAME

……

步骤三:修改目录所有者和所有者组

[root@master ~]# chown -R hadoop:hadoop /usr/local/src/

[root@master ~]# ll /usr/local/src/

总用量 0

drwxr-xr-x. 9 hadoop hadoop 149 6月 29 2015 hadoop-2.7.1

drwxr-xr-x. 8 hadoop hadoop 255 9月 14 2017 jdk1.8.0_152

/usr/local/src 目录的所有者已经改为 hadoop 了。

实验任务一:配置 Hadoop 配置文件

[root@master ~]# cd /usr/local/src/hadoop-2.7.1/

[root@master hadoop-2.7.1]# ls

bin etc include lib libexec LICENSE.txt NOTICE.txt README.txt sbin share

[root@master hadoop-2.7.1]# vi etc/hadoop/hadoop-env.sh

在文件中查找 export JAVA_HOME 这行,将其改为如下所示内容:

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

实验任务二:测试 Hadoop 本地模式的运行

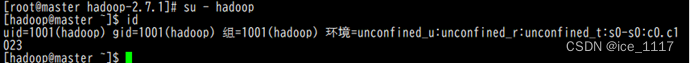

步骤一: 切换到 hadoop 用户

[root@master hadoop-2.7.1]# su - hadoop

[hadoop@master ~]$ id

uid=1001(hadoop) gid=1001(hadoop) 组=1001(hadoop) 环境

=unconfined_u:unconfined_r:unconfined_t:s0-s0:c0.c1023

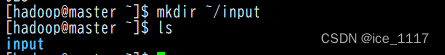

步骤二: 创建输入数据存放目录

将输入数据存放在~/input 目录(hadoop 用户主目录下的 input 目录中)。

[hadoop@master ~]$ mkdir ~/input

[hadoop@master ~]$ ls

Input

步骤三: 创建数据输入文件

创建数据文件 data.txt,将要测试的数据内容输入到 data.txt 文件中。

[hadoop@master ~]$ vi input/data.txt

输入如下内容,保存退出。

Hello World

Hello Hadoop

Hello Husan

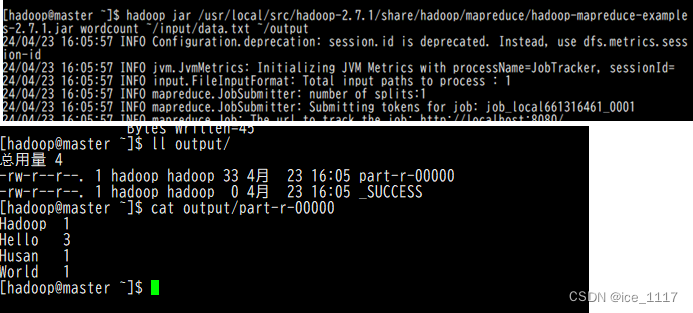

步骤四: 测试 MapReduce 运行

[hadoop@master ~]$ hadoop jar /usr/local/src/hadoop-2.7.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount ~/input/data.txt ~/output

[hadoop@master ~]$ ll output/

总用量 4

-rw-r--r--. 1 hadoop hadoop 33 11月 10 23:50 part-r-00000

-rw-r--r--. 1 hadoop hadoop 0 11月 10 23:50 _SUCCESS

[hadoop@master ~]$ cat output/part-r-00000

实验三 Hadoop平台环境配置

实验任务一:实验环境下集群网络配置

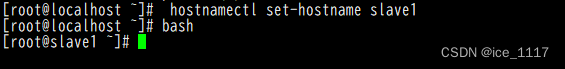

修改 slave1 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave1

[root@localhost ~]# bash

[root@slave1 ~]#

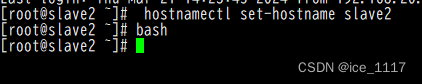

修改 slave2 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave2

[root@localhost ~]# bash

[root@slave2 ~]#

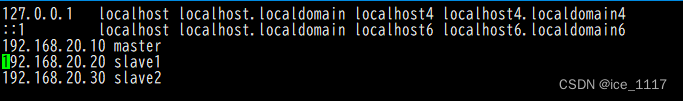

[root@master ~]# vi /etc/hosts

[root@slave1 ~]# vi /etc/hosts

[root@slave2 ~]# vi /etc/hosts

192.168.20.10 master

192.168.20.20 slave1

192.168.20.30 slave2

实验任务二:SSH 无密码验证配置

实验任务2.1:生成 SSH 密钥

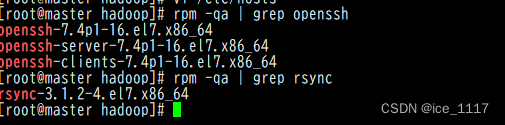

步骤一:每个节点安装和启动 SSH 协议

[root@master ~]# rpm -qa | grep openssh

openssh-server-7.4p1-11.el7.x86_64

openssh-7.4p1-11.el7.x86_64

openssh-clients-7.4p1-11.el7.x86_64

[root@master ~]# rpm -qa | grep rsync

rsync-3.1.2-11.el7_9.x86_64

步骤二:切换到 hadoop 用户

[root@master ~]# su - hadoop

[hadoop@master ~]$

[root@slave1 ~]# useradd hadoop

[root@slave1 ~]# su - hadoop

[hadoop@slave1 ~]$

[root@slave2 ~]# useradd hadoop

[root@slave2 ~]# su - hadoop

[hadoop@slave2 ~]$

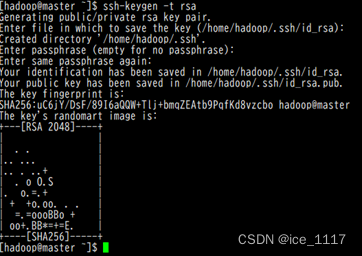

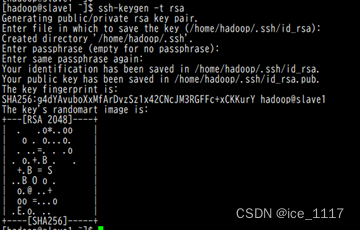

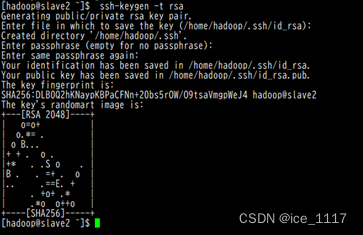

步骤三:每个节点生成秘钥对

#在 master 上生成密钥

[hadoop@master ~]$ ssh-keygen -t rsa

#slave1 生成密钥

[hadoop@slave1 ~]$ ssh-keygen -t rsa

#slave2 生成密钥

[hadoop@slave2 ~]$ ssh-keygen -t rsa

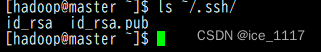

步骤四:查看"/home/hadoop/"下是否有".ssh"文件夹

".ssh"文件下是否有两个刚生产的无密码密钥对。

[hadoop@master ~]$ ls ~/.ssh/

id_rsa id_rsa.pub

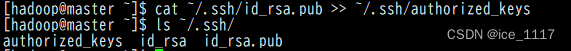

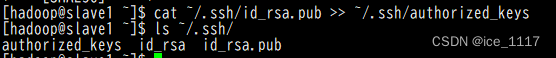

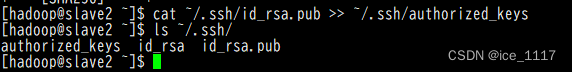

步骤五:将 id_rsa.pub 追加到授权 key 文件中

#master

[hadoop@master ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@master ~]$ ls ~/.ssh/

authorized_keys id_rsa id_rsa.pub

#slave1

[hadoop@slave1 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ls ~/.ssh/

authorized_keys id_rsa id_rsa.pub

#slave2

[hadoop@slave2 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ls ~/.ssh/

authorized_keys id_rsa id_rsa.pub

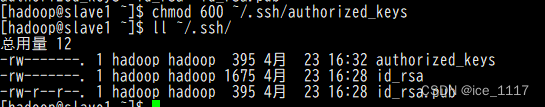

步骤六:修改文件"authorized_keys"权限

#master

[hadoop@master ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@master ~]$ ll ~/.ssh/

总用量 12

-rw-------. 1 hadoop hadoop 395 11月 14 16:18 authorized_keys

-rw-------. 1 hadoop hadoop 1679 11月 14 16:14 id_rsa

-rw-r--r--. 1 hadoop hadoop 395 11月 14 16:14 id_rsa.pub

#slave1

[hadoop@slave1 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ll ~/.ssh/

总用量 12

-rw-------. 1 hadoop hadoop 395 11月 14 16:18 authorized_keys

-rw-------. 1 hadoop hadoop 1675 11月 14 16:14 id_rsa

-rw-r--r--. 1 hadoop hadoop 395 11月 14 16:14 id_rsa.pub

#slave2

[hadoop@slave2 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ll ~/.ssh/

总用量 12

-rw-------. 1 hadoop hadoop 395 11月 14 16:19 authorized_keys

-rw-------. 1 hadoop hadoop 1679 11月 14 16:15 id_rsa

-rw-r--r--. 1 hadoop hadoop 395 11月 14 16:15 id_rsa.pub

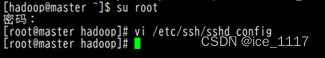

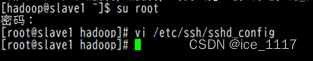

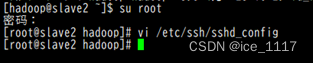

步骤七:配置 SSH 服务

#master

[hadoop@master ~]$ su - root

密码:

上一次登录:一 11月 14 15:48:10 CST 2022从 192.168.47.1pts/1 上

[root@master ~]# vi /etc/ssh/sshd_config

PubkeyAuthentication yes #找到此行,并把#号注释删除。

#slave1

[hadoop@ slave1 ~]$ su - root

密码:

上一次登录:一 11月 14 15:48:10 CST 2022从 192.168.47.1pts/1 上

[root@ slave1 ~]# vi /etc/ssh/sshd_config

PubkeyAuthentication yes #找到此行,并把#号注释删除。

#slave2

[hadoop@ slave2 ~]$ su - root

密码:

上一次登录:一 11月 14 15:48:10 CST 2022从 192.168.47.1pts/1 上

[root@ slave2 ~]# vi /etc/ssh/sshd_config

PubkeyAuthentication yes #找到此行,并把#号注释删除。

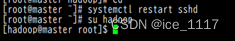

步骤八:重启 SSH 服务

设置完后需要重启 SSH 服务,才能使配置生效。

[root@master ~]# systemctl restart sshd

步骤九:切换到 hadoop 用户

[root@master ~]# su - hadoop

上一次登录:一 11月 14 16:11:14 CST 2022pts/1 上

[hadoop@master ~]$

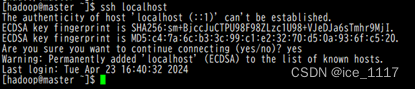

步骤十:验证 SSH 登录本机

[hadoop@master ~]$ ssh localhost

实验任务三:交换 SSH 密钥

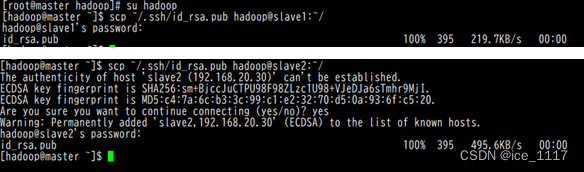

步骤一:将 Master 节点的公钥 id_rsa.pub 复制到每个 Slave 点

[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave1:~/

修改了hadoop用户密码为1[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave2:~/

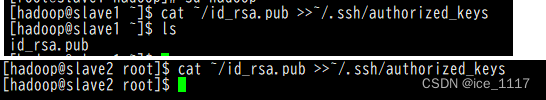

步骤二:在每个 Slave 节点把 Master 节点复制的公钥复制到authorized_keys 文件

hadoop 用户登录 slave1 和 slave2 节点,执行命令。

[hadoop@slave1 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

步骤三:在每个 Slave 节点删除 id_rsa.pub 文件

[hadoop@slave1 ~]$ rm -rf ~/id_rsa.pub

[hadoop@slave2 ~]$ rm -rf ~/id_rsa.pub

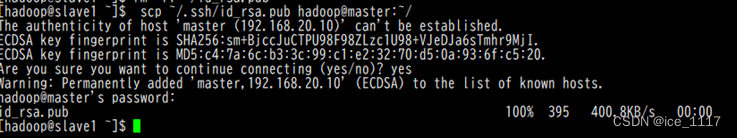

步骤四:将每个 Slave 节点的公钥保存到 Master

(1)将 Slave1 节点的公钥复制到 Master 34

[hadoop@slave1 ~]$ scp ~/.ssh/id_rsa.pub hadoop@master:~/

(2)在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

![]()

(3)在 Master 节点删除 id_rsa.pub 文件

[hadoop@master ~]$ rm -rf ~/id_rsa.pub

![]()

(4)将 Slave2 节点的公钥复制到 Master

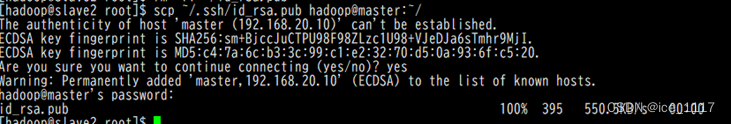

[hadoop@slave2 ~]$ scp ~/.ssh/id_rsa.pub hadoop@master:~/

(5)在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

![]()

(6)在 Master 节点删除 id_rsa.pub 文件

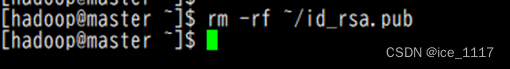

[hadoop@master ~]$ rm -rf ~/id_rsa.pub

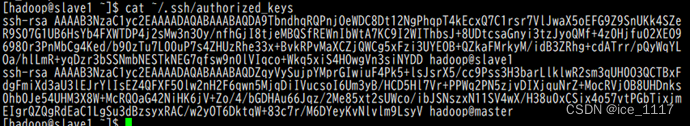

实验任务四:验证 SSH 无密码登录

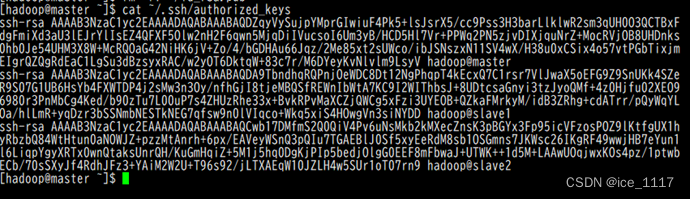

步骤一:查看 Master 节点 authorized_keys 文件

[hadoop@master ~]$ cat ~/.ssh/authorized_keys

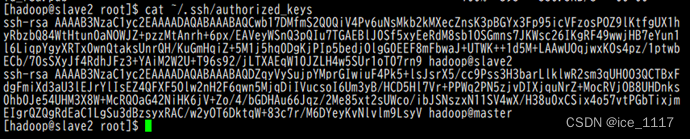

步骤二:查看 Slave 节点 authorized_keys 文件

[hadoop@slave1 ~]$ cat ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/.ssh/authorized_keys

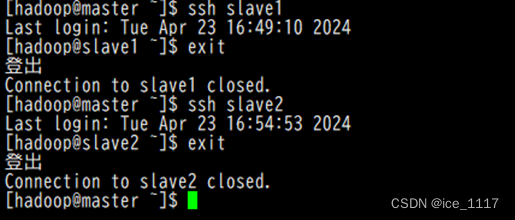

步骤三:验证 Master 到每个 Slave 节点无密码登录

[hadoop@master ~]$ ssh slave1

Last login: Mon Nov 14 16:34:56 2022

[hadoop@slave1 ~]$

[hadoop@master ~]$ ssh slave2

Last login: Mon Nov 14 16:49:34 2022 from 192.168.47.140

[hadoop@slave2 ~]$

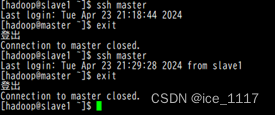

步骤四:验证两个 Slave 节点到 Master 节点无密码登录

[hadoop@slave1 ~]$ ssh master

Last login: Mon Nov 14 16:30:45 2022 from ::1

[hadoop@master ~]$

[hadoop@slave2 ~]$ ssh master

Last login: Mon Nov 14 16:50:49 2022 from 192.168.47.141

[hadoop@master ~]$

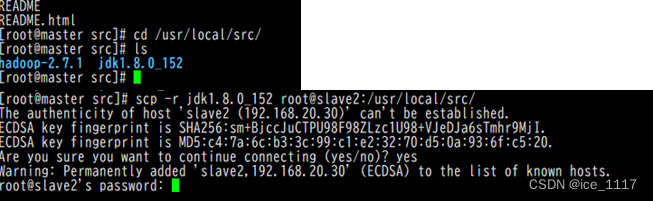

步骤五:配置两个子节点slave1、slave2的JDK环境。

[root@master ~]# cd /usr/local/src/

[root@master src]# ls

hadoop-2.7.1 jdk1.8.0_152

[root@master src]# scp -r jdk1.8.0_152 root@slave1:/usr/local/src/

[root@master src]# scp -r jdk1.8.0_152 root@slave2:/usr/local/src/

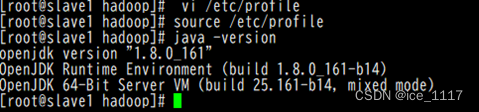

#slave1

[root@slave1 ~]# ls /usr/local/src/

jdk1.8.0_152

[root@slave1 ~]# vi /etc/profile #此文件最后添加下面两行

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

[root@slave1 ~]# source /etc/profile

[root@slave1 ~]# java -version

java version "1.8.0_152"

Java(TM) SE Runtime Environment (build 1.8.0_152-b16)

Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

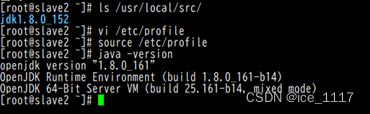

#slave2

[root@slave2 ~]# ls /usr/local/src/

jdk1.8.0_152

[root@slave2 ~]# vi /etc/profile #此文件最后添加下面两行

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

[root@slave2 ~]# source /etc/profile、

[root@slave2 ~]# java -version

java version "1.8.0_152"

Java(TM) SE Runtime Environment (build 1.8.0_152-b16)

Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

Hadoop集群运行

实验一:hadoop 全分布配置

任务一:在 Master 节点上安装 Hadoop

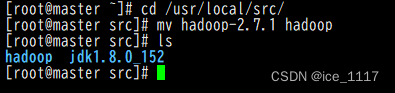

步骤一:将 hadoop-2.7.1 文件夹重命名为 Hadoop

[root@master ~]# cd /usr/local/src/

[root@master src]# mv hadoop-2.7.1 hadoop

[root@master src]# ls

hadoop jdk1.8.0_152

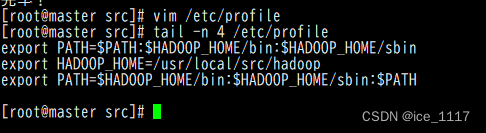

步骤二:配置 Hadoop 环境变量

[root@master src]# yum install -y vim

[root@master src]# vim /etc/profile

[root@master src]# tail -n 4 /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

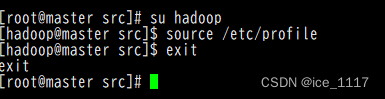

步骤三:使配置的 Hadoop 的环境变量生效

[root@master src]# su - hadoop

上一次登录:一 2 月 28 15:55:37 CST 2022 从 192.168.41.143pts/1 上

[hadoop@master ~]$ source /etc/profile

[hadoop@master ~]$ exit

登出

步骤四:执行以下命令修改 hadoop-env.sh 配置文件

[root@master src]# cd /usr/local/src/hadoop/etc/hadoop/

[root@master hadoop]# vim hadoop-env.sh #修改以下配置

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

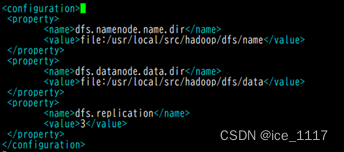

任务二:配置 hdfs-site.xml 文件参数

[root@master hadoop]# vim hdfs-site.xml #编辑以下内容

[root@master hadoop]# tail -n 14 hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/src/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/src/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

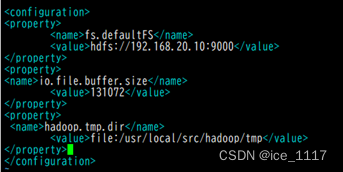

任务三:配置 core-site.xml 文件参数

[root@master hadoop]# vim core-site.xml #编辑以下内容

[root@master hadoop]# tail -n 14 core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.20.10:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/src/hadoop/tmp</value>

</property>

</configuration>

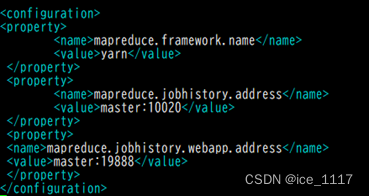

任务四:配置 mapred-site.xml

[root@master hadoop]# pwd

/usr/local/src/hadoop/etc/hadoop

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@master hadoop]# vim mapred-site.xml #添加以下配置

[root@master hadoop]# tail -n 14 mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

任务五:配置 yarn-site.xml

[root@master hadoop]# vim yarn-site.xml #添加以下配置

[root@master hadoop]# tail -n 32 yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:8088</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

任务六:Hadoop 其他相关配置

步骤一:配置 masters 文件

[root@master hadoop]# vim masters

[root@master hadoop]# cat masters

192.168.20.10

![]()

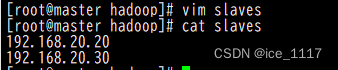

步骤二:配置 slaves 文件

[root@master hadoop]# vim slaves

[root@master hadoop]# cat slaves

192.168.20.20

192.168.20.30

步骤三:新建目录

[root@master hadoop]# mkdir /usr/local/src/hadoop/tmp

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/name -p

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/data -p

步骤四:修改目录权限

[root@master hadoop]# chown -R hadoop:hadoop /usr/local/src/hadoop/

步骤五: 同步配置文件到 Slave 节点

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave1:/usr/local/src/

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave2:/usr/local/src/

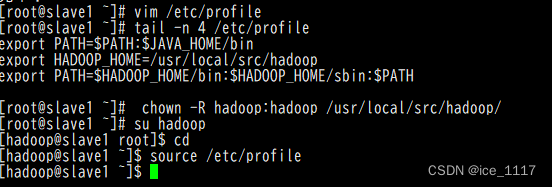

#slave1 配置

[root@slave1 ~]# yum install -y vim

[root@slave1 ~]# vim /etc/profile

[root@slave1 ~]# tail -n 4 /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

[root@slave1 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave1 ~]# su - hadoop

上一次登录:四 2 月 24 11:29:00 CST 2022 从 192.168.41.148pts/1 上

[hadoop@slave1 ~]$ source /etc/profile

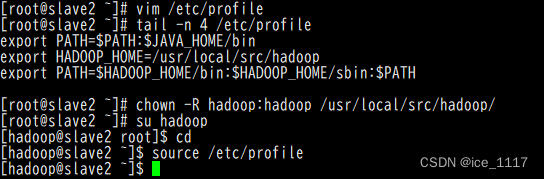

#slave2 配置

[root@slave2 ~]# yum install -y vim

[root@slave2 ~]# vim /etc/profile

[root@slave2 ~]# tail -n 4 /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

[root@slave2 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave2 ~]# su - hadoop

上一次登录:四 2 月 24 11:29:19 CST 2022 从 192.168.41.148pts/1 上

[hadoop@slave2 ~]$ source /etc/profile

实验一:hadoop 集群运行

实验任务一:配置 Hadoop 格式化

步骤一:NameNode 格式化

将 NameNode 上的数据清零,第一次启动 HDFS 时要进行格式化,以后启动无需再格式化,否则会缺失 DataNode 进程。另外,只要运行过 HDFS,Hadoop 的工作目录(本书设置为/usr/local/src/hadoop/tmp)就会有数据,如果需要重新格式化,则在格式化之前一定要先删除工作目录下的数据,否则格式化时会出问题。

执行如下命令,格式化 NameNode

[root@master ~]# su – hadoop

[hadoop@master ~]# cd /usr/local/src/hadoop/

[hadoop@master hadoop]$ bin/hdfs namenode –format

结果:

20/05/02 16:21:50 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at master/192.168.1.6

************************************************************/

步骤二:启动 NameNode

执行如下命令,启动 NameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start namenode

![]()

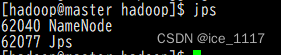

实验任务二:查看 Java 进程

[hadoop@master hadoop]$ jps

3557 NameNode

3624 Jps

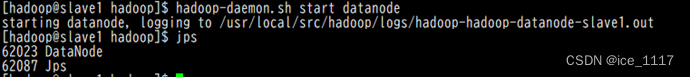

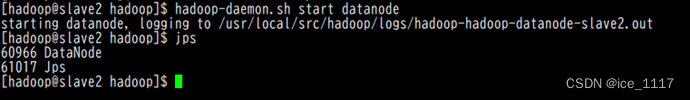

步骤一:slave节点 启动 DataNode

执行如下命令,启动 DataNode:

[hadoop@slave1 hadoop]$ hadoop-daemon.sh start datanode

[hadoop@slave2 hadoop]$ hadoop-daemon.sh start datanode

[hadoop@slave1 hadoop]$ jps

3557 DataNode

3725 Jps

[hadoop@slave2 hadoop]$ jps

3557 DataNode

3725 Jps

步骤二:启动 SecondaryNameNode

执行如下命令,启动 SecondaryNameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start secondarynamenode

starting secondarynamenode, logging to /opt/module/hadoop2.7.1/logs/hadoop-hadoop-secondarynamenode-master.out

[hadoop@master hadoop]$ jps

34257 NameNode

34449 SecondaryNameNode

34494 Jps

查看到有 NameNode 和 SecondaryNameNode 两个进程,就表明 HDFS 启动成功。

![]()

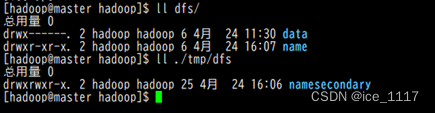

步骤三:查看 HDFS 数据存放位置:

执行如下命令,查看 Hadoop 工作目录:

[hadoop@master hadoop]$ ll dfs/

总用量 0

drwx------ 3 hadoop hadoop 21 8 月 14 15:26 data

drwxr-xr-x 3 hadoop hadoop 40 8 月 14 14:57 name

[hadoop@master hadoop]$ ll ./tmp/dfs

总用量 0

drwxrwxr-x. 3 hadoop hadoop 21 5 月 2 16:34 namesecondary

实验任务三:查看 HDFS 的报告

[hadoop@master sbin]$ hdfs dfsadmin -report

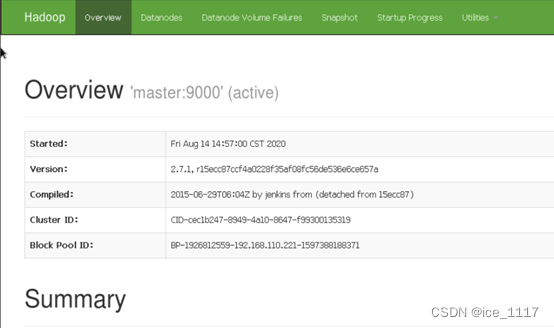

实验任务四:使用浏览器查看节点状态

在浏览器的地址栏输入http://master:50070,进入页面可以查看NameNode和DataNode信息,如图 5-2 所示。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?