智能体终于突破了对话的局限,它们正在解决多步骤问题、协调工作流并实现自主运作。而推动这些突破的背后,正是MCP技术。

MCP正在迅速走红。但如果您被那些专业术语搞得晕头转向,别担心,这再正常不过。

今天,我们将深入探讨:现有AI工具为何力不从心,而MCP如何破解这些难题。内容涵盖核心组件解析、技术价值阐释、三层架构体系及其局限性,更配有真实用例的实操演示。

这正是我入门时梦寐以求的指南。

内容概览

简而言之,我们将深入探讨以下核心议题:

1.现有AI工具的痛点剖析

2.MCP技术架构与核心组件解析

3.MCP底层运行机制揭秘

4.MCP的革新价值与行业意义

5.MCP三层架构体系

6.快速接入100+托管MCP服务的认证方案

7.三大实战案例演示

8.MCP当前的技术局限

1.现有AI工具的痛点剖析

如果您曾尝试构建能真正执行任务的AI智能体(比如根据工作流查收邮件或发送Slack消息),定能体会这种切肤之痛:整个流程混乱不堪,且大多数输出结果根本不值一提。

虽然我们拥有出色的API接口、各类工具层出不穷。但实用性和可靠性始终差强人意。

就连Cursor这样曾在Twitter上红极一时的工具,近期也频频因性能问题遭用户诟病。

1)API泛滥而上下文严重不足

每当需要AI调用工具时,本质上都是在进行微型的API集成。试想用户提问:“Anmol有没有发邮件讨论昨天的会议报告?”

要让大语言模型准确回答,它必须:

- 准确识别这是邮件检索任务(而非Slack或Notion查询)

- 选择正确的API端点(比如search_email_messages)

- 将结果解析并提炼为自然语言摘要

这一切都必须在有限的上下文窗口内完成。负担过重导致模型常常出现:记忆丢失、盲目猜测甚至虚构答案。

最棘手的是,若无法验证准确性,您甚至意识不到问题所在。

2)API基于步骤执行,而大语言模型却不擅记忆步骤

以CRM系统的基本操作为例:

- 首先获取联系人ID → get_contact_id

- 接着读取当前数据 → read_contact

- 最后提交更新 → patch_contact

在传统编程中,您可以将这一流程抽象为函数一次性完成。但大语言模型呢?每一步都可能因以下问题出错:参数错误、字段遗漏或执行链断裂。最终,您的"AI助手"只会用自然语言不断道歉,而非完成实际更新。

3)脆弱的提示工程高塔

API会迭代升级,文档时常变更,认证流程也不断更新。某天清晨您可能突然发现,原本运行完美的智能体因第三方改动而崩溃。

与传统应用不同,这里没有可依赖的共享框架或抽象层,每个AI工具集成都是一座由提示工程和JSON手工打造的脆弱高塔,随时可能摧毁您AI智能体形成的"肌肉记忆"。

4)供应商锁定陷阱

为GPT-4打造的工具链?确实不错。但若您想切换到Claude或Gemini等其他平台,就不得不从头重写所有函数描述和系统提示。

这虽然不算致命问题,但当前确实缺乏通用解决方案。

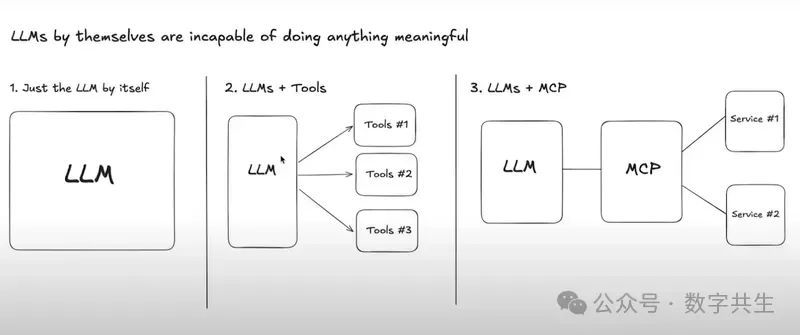

工具与模型之间亟需一种简洁的通信机制,而不是把所有逻辑都塞进臃肿的提示词中。这正是MCP的用武之地。

2.MCP技术架构与核心组件解析

Model Context Protocol(MCP)作为一种全新的开放协议,标准化了应用程序向大语言模型(LLMs)提供上下文与工具的方式。

您可以将它理解为AI领域的"万能连接器"。在Cursor生态中,MCP以插件系统形式运作,通过连接各类数据源与工具,显著扩展智能体(Agent)的能力边界。

MCP赋能开发者在大语言模型(LLMs)之上构建智能体与复杂工作流。

例如,专为Obsidian设计的MCP服务器,可使AI助手直接检索并读取您的知识库笔记。

通过标准化接口发送自然语言指令,您的智能体即可实现:

-

经Gmail发送邮件

-

在Linear创建任务

-

从Notion检索文档

-

往Slack发布消息

-

更新Salesforce记录

这种革新意味着:原本需要切换5+个应用才能完成的任务,现在仅需与智能体对话即可一气呵成。

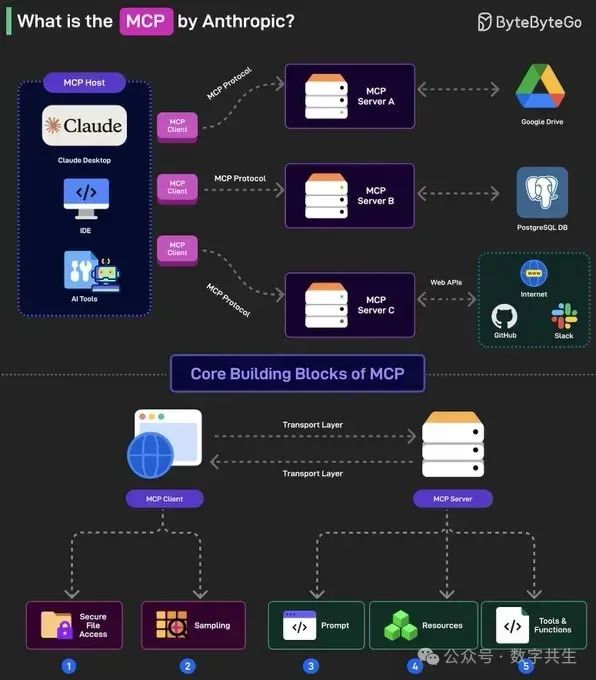

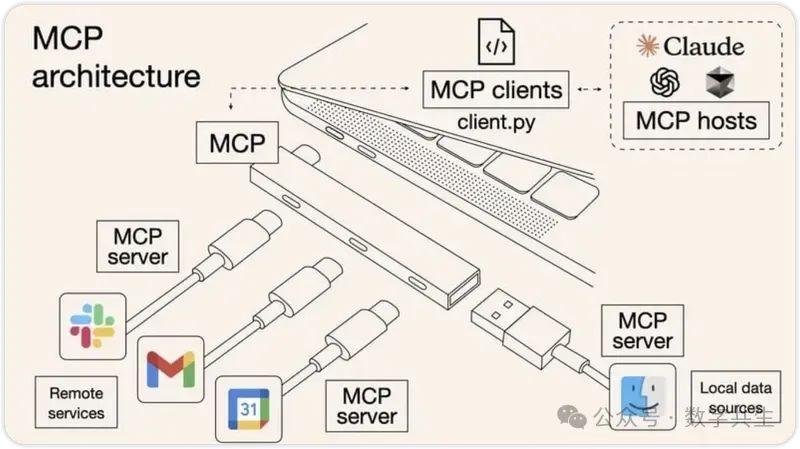

MCP采用客户端-服务器架构,支持宿主应用同时连接多个服务端。

核心组件解析

一个标准的MCP服务器包含以下核心模块:

- MCP hosts:如Claude Desktop、Cursor、Windsurf等AI工具,通过MCP协议访问数据的终端应用

- MCP Clients:协议客户端程序,与MCP服务器保持1:1连接,充当通信桥梁角色

- MCP Servers:轻量级服务程序,通过标准化Model Context Protocol暴露特定能力。典型功能-文件读取、数据库查询等

- Local Data Sources:计算机本地的文件/数据库/服务,示例:浏览器自动化MCP需访问本地浏览器

- Remote Services:外部API及云端系统接口,MCP服务器可连接的外部资源

如需了解详细架构设计,请参阅官方文档:

https://modelcontextprotocol.io/docs/concepts/architecture

内容涵盖协议分层、连接生命周期、错误处理及完整实现方案。

3.MCP底层运行机制揭秘

整个MCP生态系统由几个关键组件协同运作。下面我们简要解析这些核心模块:

客户端(Clients)

客户端即您实际使用的应用程序(如Cursor、Claude Desktop等),其核心职能包括:

- 能力发现:向MCP服务器请求可用功能

- 功能呈现:将工具、资源及提示词提供给AI模型

- 请求中继:将AI的工具使用请求转发至服务器并返回结果

- 协议适配:为模型提供标准化的MCP协议框架,确保交互一致性

客户端承担着用户、AI模型与MCP服务器之间的三重通信枢纽角色。

服务端(Servers)

MCP服务器作为用户/AI与外部服务的中介层,主要实现:

- 标准化接口:提供JSON-RPC规范的工具访问接口

- 无缝适配:将现有API转换为MCP兼容功能(无需修改原API)

- 安全管控:处理认证、能力定义及通信标准化

服务器本质上是能力供给中心,向客户端提供上下文、工具和提示词。

服务提供商(Service Providers)

即实际执行任务的外部系统(如Discord/Notion/Figma),其特点在于:

- 零改造:无需为MCP调整原有API

- 即插即用:保持自身服务架构不变

该架构的革命性在于,开发者可将任何兼容API接入支持MCP的客户端,彻底摆脱对大型AI厂商中心化集成方案的依赖。

MCP核心构建模块:工具、资源与提示词

工具(Tools)

工具代表AI可执行的具体操作(如search_emails邮件搜索或create_issue_linear创建Linear任务),它们构成了模型通过MCP实现现实功能的基础能力集。

资源(Resources)

资源是MCP服务器向客户端开放的任何数据类型,包括但不限于:

- 文件内容

- 数据库记录

- API响应数据

- 实时系统信息

- 屏幕截图与图像

- 日志文件

- 其他自定义数据类型

每个资源通过唯一URI标识(如file://user/prefs.json),可指向项目笔记、编码偏好等个性化内容,支持文本或二进制格式。资源URI严格遵循以下规范格式:

[protocol]://[host]/[path]

例如:

- file:///home/user/documents/report.pdf

- postgres://database/customers/schema

- screen://localhost/display1

服务器还可自定义URI方案(详见官方文档)。

提示词(Prompts)

工具赋予AI执行能力,而提示词则规范其行为模式。

它们如同实时操作指南,在工具使用时向模型传递:特定风格要求、工作流约束、安全协议(如执行delete_everything前必须完成安全检查清单)。

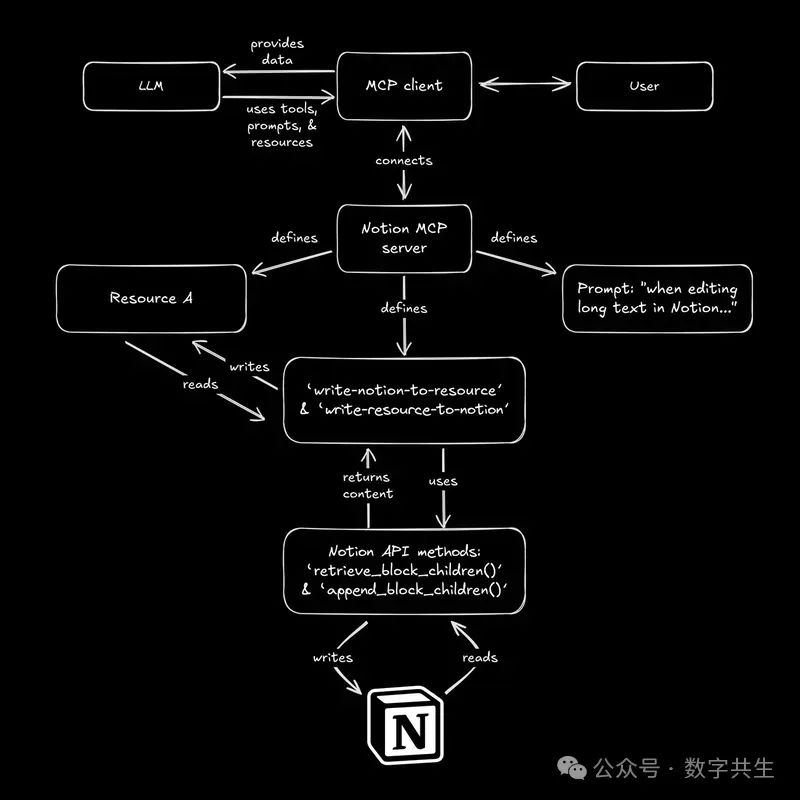

🔍 实战场景演示:

假设存在Google Calendar的MCP服务器。虽然日历API功能强大但数据冗杂(每项事件包含参会人、时区、提醒、附件等字段)。若要求AI"重排下周与Alice的所有会议",模型很难从噪声中提取有效信息。

此时提示词与资源的组合方案如下:

- 指令规范:“处理日历时,仅修改标题或参会人匹配的事件。通过list-events工具提取目标事件至临时资源(Resource B)”

- 安全操作:“在Resource B中完成修改后,通过update-events-from-resource同步变更”

该模式实现三重保障:

✅ 数据净化:在受控资源中处理清洁数据

✅ 流程标准化:通过可复用的提示词规范操作

✅ 行为可控:严格限定工具使用边界

您还可以参考Builder.io上的Notion示例,该案例详细阐释了MCP提示词的应用场景。

当客户端连接MCP服务器时,首先会请求获取可用的工具、资源和提示词列表。根据用户输入内容,客户端会动态筛选并决定向AI模型展示哪些功能。当模型选择某项操作时,客户端会通过服务器执行该操作,并确保整个数据流都经过正确的授权验证。

4. MCP的革新价值与行业意义

一个通用协议 = 数千种工具

这一通用协议意味着只要工具具备MCP接口,单个AI就能集成数千种工具,无需为每个新应用定制集成方案。服务通过标准化的JSON-RPC格式描述功能(如"发送Discord消息"、“创建Linear工单”)及实现方式(参数、认证方法)。

清晰的职责分离:模型思考,工具执行

它在AI模型(思考者)与外部工具(执行者)之间建立明确界限。当Slack调整API时,智能体不会因此崩溃。

切换AI模型无需重构

从GPT切换到Claude或Gemini时,无需重写所有工具描述。工具逻辑保持稳定。

支持记忆与多步工作流

代理可跨任务记忆信息,并智能串联多个操作。

减少幻觉输出

MCP采用清晰的结构化工具定义,帮助AI保持准确性和现实锚定。

MCP重要是因为:

• 它将开发者通用AI助手的梦想变为现实

• 通过AI逻辑组合这些操作,将开启智能自动化新时代

MCP极大降低了开发者利用AI实现复杂功能的门槛。

5. MCP三层架构体系

以下是我对这个概念的详细理解,我会附上一个常见示例,帮助你快速理解。

1)模型 ↔ 上下文:“用大语言模型能理解的方式与其对话”

将模型想象成机器人(大语言模型)的大脑,它能够处理信息,但需要清晰的指令。而上下文(Context)正是为其提供正确执行任务所需的指令。

举例来说:如果你对机器人说 “给我做个三明治”,这个指令太过模糊。但如果说 “用这片面包、火腿和奶酪做一个三明治”,这就为机器人提供了可理解和执行的上下文。

- 模型是机器人(大语言模型)

- 上下文是你提供的具体指令(如制作三明治的食材)

2)上下文 ↔ 协议:“为大语言模型提供结构化记忆、工具和状态”

一旦机器人获得了指令(上下文),它需要一种方式来遵循指令、记忆细节并使用工具,这就是协议(Protocol)的作用-它是让机器人能够利用记忆和工具完成任务的系统。

继续用三明治的例子:为机器人设定协议,能帮助它记住食材、知道如何使用刀具等。

- 上下文告诉机器人 “做什么”

- 协议为其提供完成任务的工具和记忆

这是推动任务完成的结构。

3)协议 ↔ 运行时:“实际运行人工智能代理”

当机器人知道 “做什么”(上下文)和 “如何做”(协议)后,需要实际执行任务,这依赖于运行时(Runtime)。

回到三明治的例子,运行时就是机器人开始执行任务的时刻,类似任务落地的环境(如厨房)。

- 协议为机器人提供执行方法

- 运行时是机器人实际工作的环境

现在,我们用餐厅场景将三个层级结合起来理解:

- 模型是厨师:他们具备制作食物的知识和技能。

- 上下文是菜单:告诉厨师需要哪些食材,以及菜品的外观和口味要求。

- 协议是服务员:服务员将订单传达给厨师,精确说明菜品的制作方式,甚至记住顾客的过敏情况。

- 运行时是厨房:厨师实际烹饪的场所,是所有工具、热源和准备工作发生的地方。

一旦你理解了服务器和客户端等核心组件(详见 “MCP底层运行机制揭秘” 部分),这一切就会变得清晰易懂。

每一层相互配合,共同驱动整个系统运行。

6. 快速接入100+托管MCP服务的认证方案

这里我们将探索Cursor连接MCP服务器的最简方法。自定义服务器配置请参阅官方文档。

步骤1:准备环境

安装Node.js并确保npx可用。

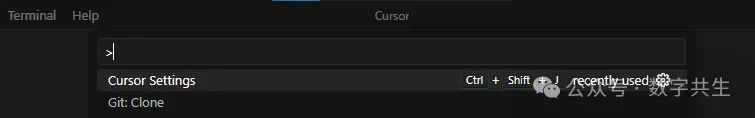

步骤2:启用Cursor的MCP功能

通过Ctrl+Shift+P打开命令面板,搜索cursor settings:

侧边栏可找到MCP选项:

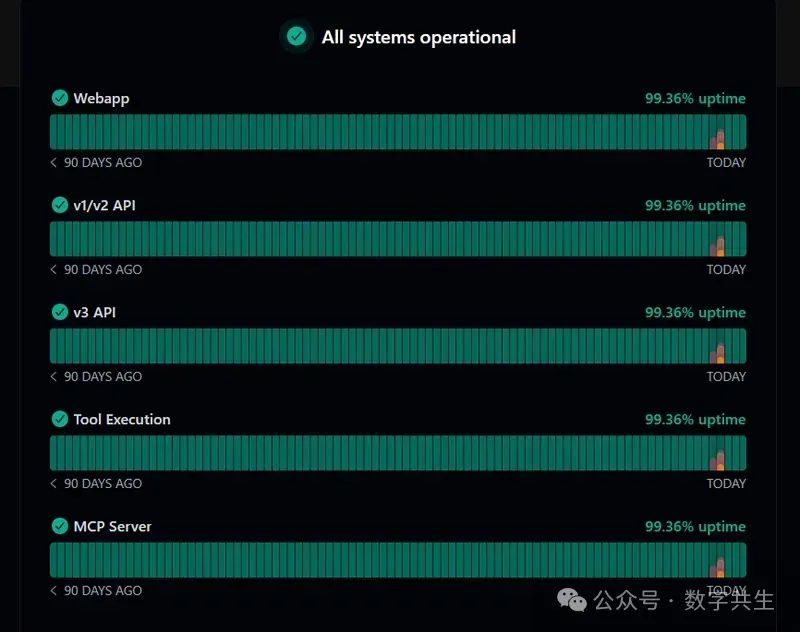

步骤3:使用预配置服务器

虽然可以自建服务器,但为简化流程我们使用Composio托管方案(mcp.composio.dev),其优势包括:

- 内置OAuth/API密钥/JWT/Basic认证

- 完全托管的服务器无需复杂设置,可轻松将 AI 代理与 Gmail、Slack、Notion、Linear 等 250+工具集成

- 20,000+开箱即用API操作

- 支持本地/远程部署

- 更高的工具调用准确性使 AI 代理能够与集成应用流畅交互

- 与 AI 代理兼容,意味着它可以将 AI 代理与工具连接,在单次对话中完成发送邮件、创建任务或管理工单等任务

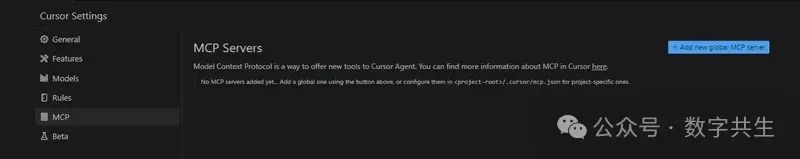

这也意味着更少的停机时间和维护问题。您可以通过 status.composio.dev 查看运行状态。

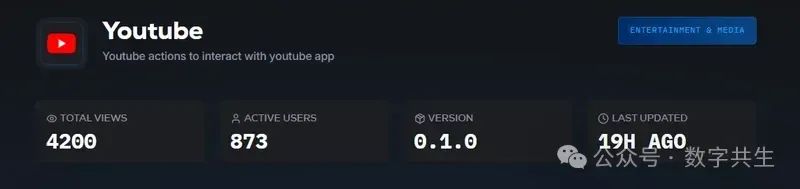

无需编码即可集成多种MCP服务器:

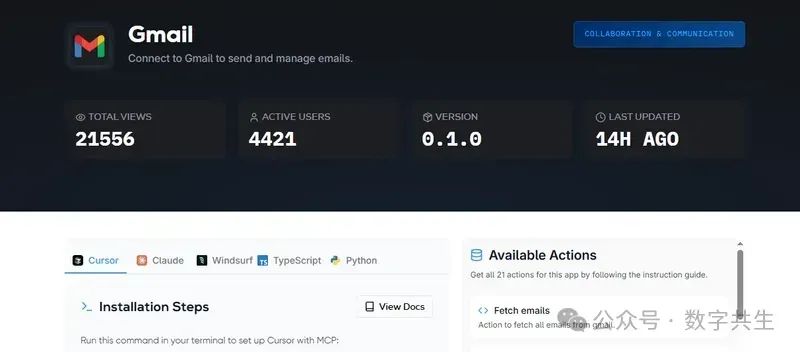

每个服务显示活跃用户数、版本号、更新日期和可用操作。

支持TypeScript/Python,兼容Claude(MacOS)/Windsurf(MacOS)/Cursor。

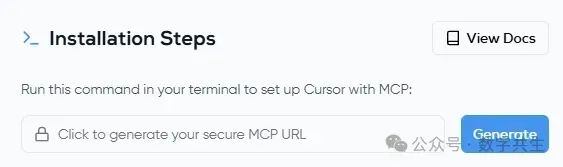

步骤4:集成MCP服务器

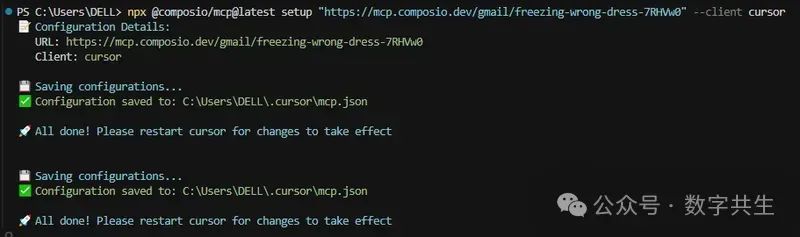

以Gmail服务器为例。Cursor近期将SSE方案改为npx命令,需生成终端指令(参见生成页面)。

示例命令:

npx @composio/mcp@latest setup "https://mcp.composio.dev/gmail/xyzxyz..." --client cursor

运行后重启Cursor生效。

Python用户安装composio-toolset:

pip install composio_openai

from composio_openai import ComposioToolSet, Appfrom openai import OpenAI

openai_client = OpenAI()composio_toolset = ComposioToolSet(entity_id="default")tools = composio_toolset.get_tools(apps=[App.GMAIL])

配置文件可存放于:

- 项目级:.cursor/mcp.json(仅当前项目可用)

- 全局级:~/.cursor/mcp.json(所有工作区可用)

终端通常强制全局配置。

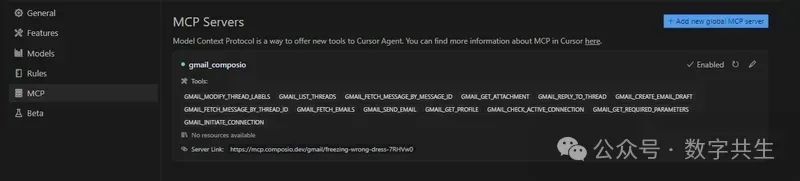

成功集成后显示绿色状态点。

mcp.json示例:

{ "mcpServers": { "gmail_composio": { "url": "https://mcp.composio.dev/gmail/freezing-wrong-dress-7RHVw0" } }}

您可以查看示例服务器和实现的列表,按照以下结构(根据您的偏好选择)集成社区服务器。

✅ SSE 服务器配置

此配置在 Cursor 中受支持,可以通过指定 url字段连接到您的 SSE 服务器。

// This example demonstrated an MCP server using the SSE format// The user should manually set and run the server// This could be networked, to allow others to access it too{ "mcpServers": { "server-name": { "url": "http://localhost:3000/sse", "env": { "API_KEY": "value" } } }}

✅ STDIO 服务器配置(Python)

这是通过 Python 脚本使用标准输入 / 输出(STDIO)传输协议搭建 MCP 服务器的方法,主要用于本地开发。

// if you're using CLI server Python// This example demonstrated an MCP server using the stdio format// Cursor automatically runs this process for you// This uses a Python server, run with `python`{ "mcpServers": { "server-name": { "command": "python", "args": ["mcp-server.py"], "env": { "API_KEY": "value" } } }}

✅ STDIO服务器配置(Node.js)

// if you're using CLI server Node.js// This example demonstrated an MCP server using the stdio format// Cursor automatically runs this process for you// This uses a Node.js server, ran with `npx`{ "mcpServers": { "server-name": { "command": "npx", "args": ["-y", "mcp-server"], "env": { "API_KEY": "value" } } }}

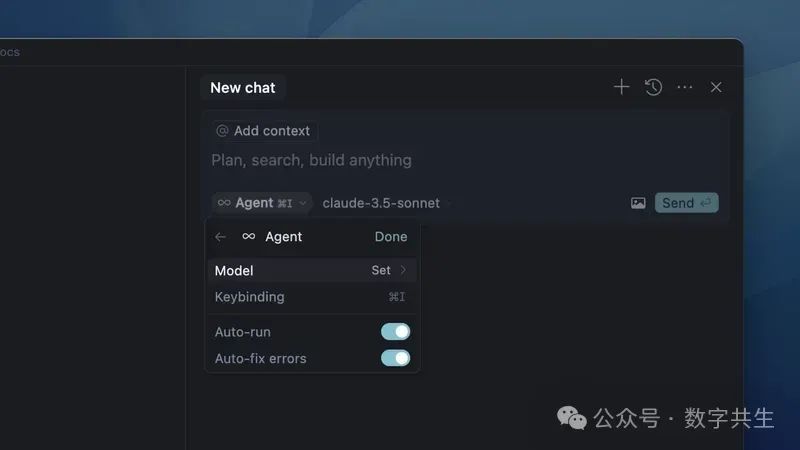

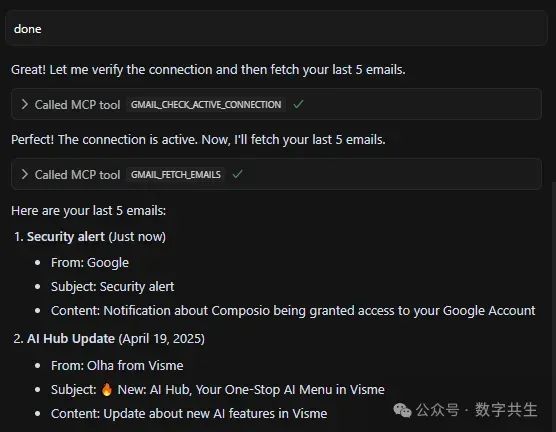

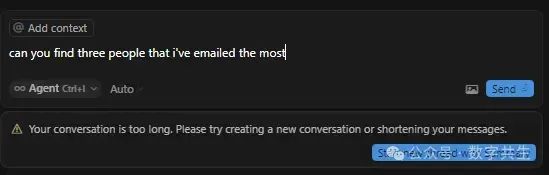

步骤5:在Agent中直接使用

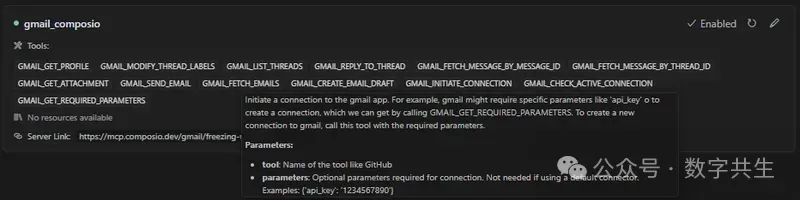

使用前请确认composio服务器上的可用操作。

通过Ctrl+I打开聊天界面,启用Agent Mode(自主处理复杂任务):

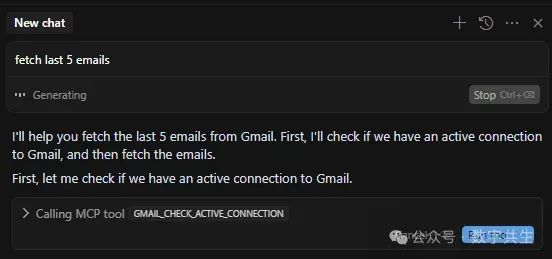

输入查询后点击run tool按钮,系统自动路由到对应MCP服务器执行:

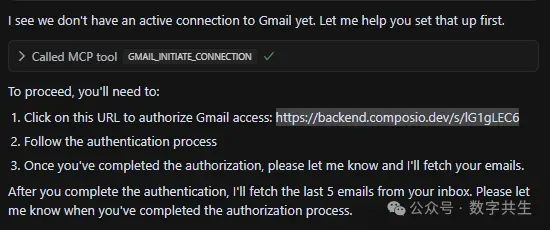

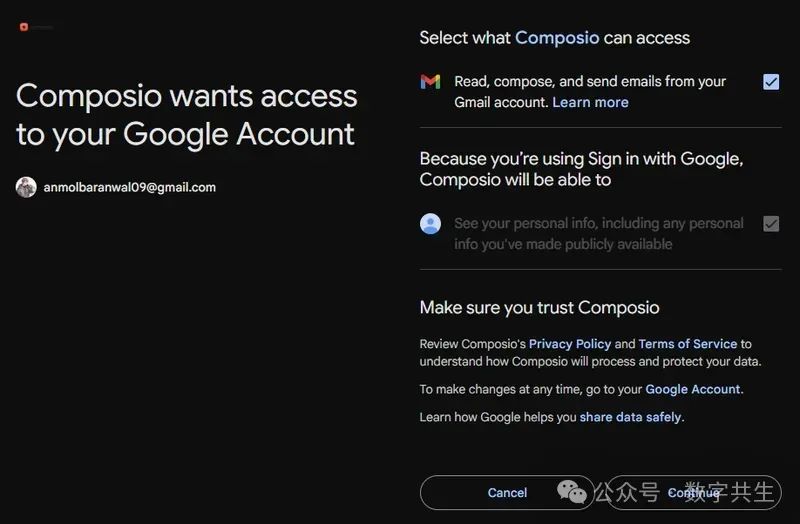

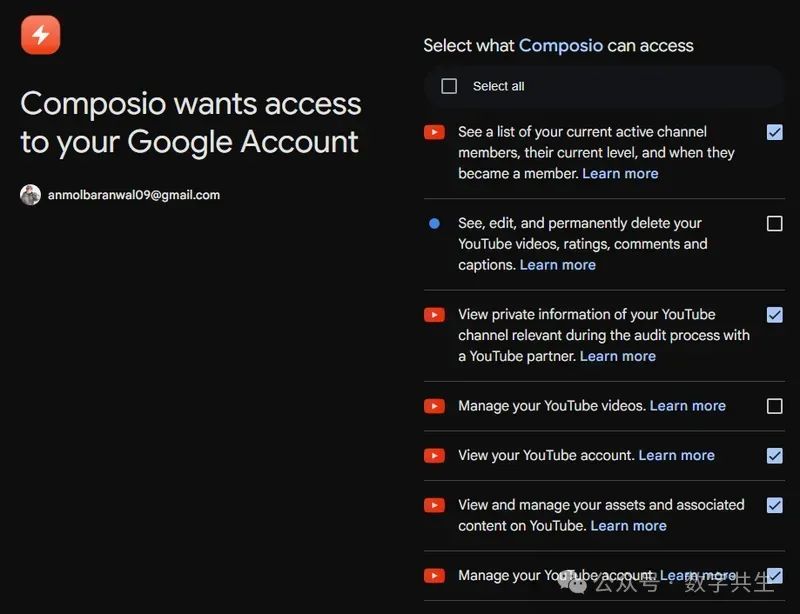

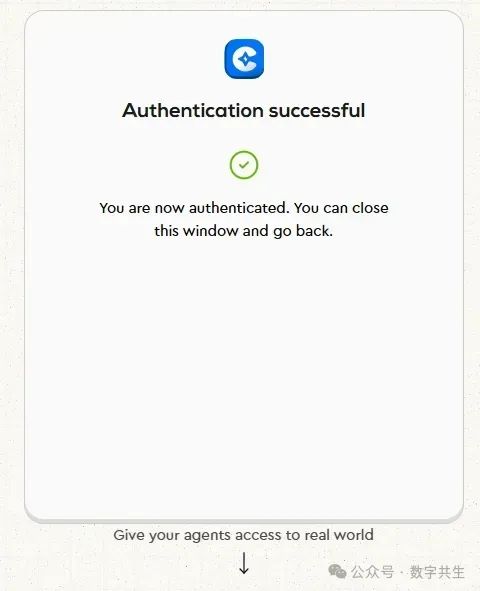

首次连接需授权:

建议使用测试账号验证,确认无误后再切回主账号。

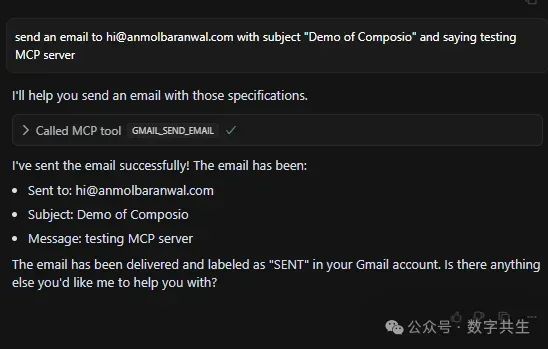

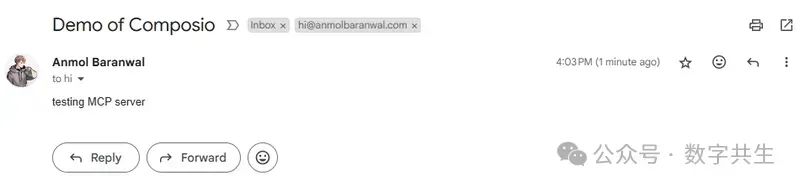

测试发送邮件至hi@anmolbaranwal.com,主题"Composio演示",正文"测试MCP服务器"。

成功接收测试邮件:

有了这个 MCP 服务器,你可以完成许多强大的操作,例如:获取附件、创建邮件草稿、修改线程标签、回复线程、获取联系人、删除邮件、移至垃圾箱、搜索联系人、发送邮件以及更多功能。

但请始终注意,操作存在限制。我已经通过 15 + 条提示测试了边缘情况,确保功能在合理范围内稳定运行。

7. 三大实战案例演示

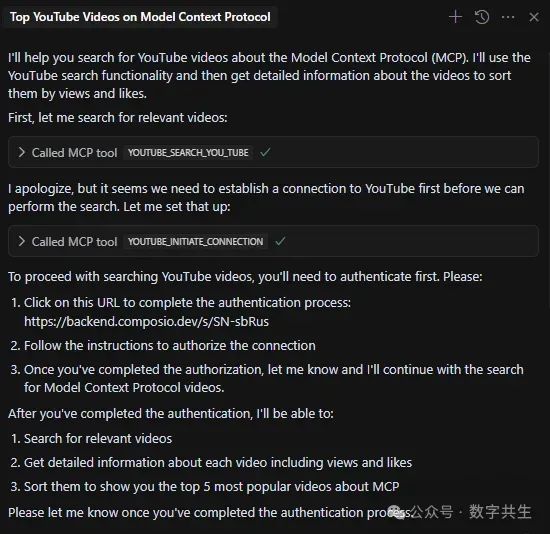

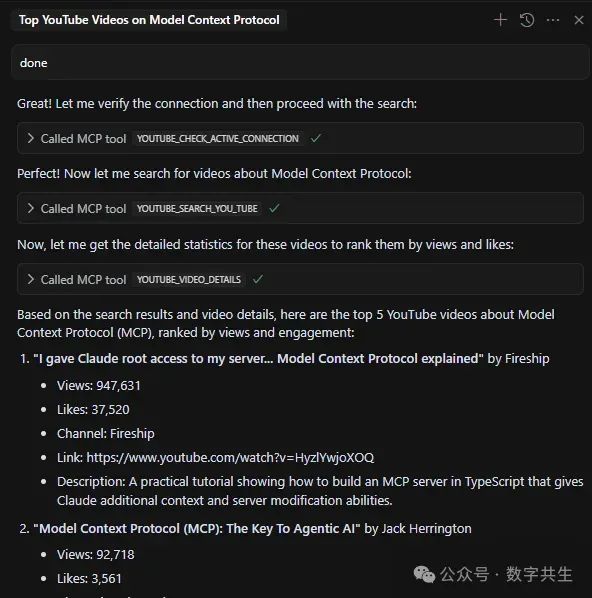

✅ YouTube服务器

我们将采用前文讨论的相同流程进行操作,您可以通过Composio的YouTube服务器生成所需URL。

生成连接命令:

npx @composio/mcp@latest setup "https://mcp.composio.dev/youtube/freezing-wrong-dress-xyz" --client cursor

mcp.json新增条目:

{ "mcpServers": { "youtube_composio": { "url": "https://mcp.composio.dev/youtube/freezing-wrong-dress-7RHVw0" }}

首次连接需OAuth认证:

需要授予服务器访问权限,使其能够根据指令执行相应操作。

示例:获取"Model Context Protocol"相关播放量最高的5个视频。

通过该MCP服务器,您可以实现以下强大功能:搜索YouTube视频/频道/播放列表、获取视频统计数据、加载字幕文件、订阅指定频道、更新视频元数据、修改视频缩略图、以及其他多项视频管理操作。

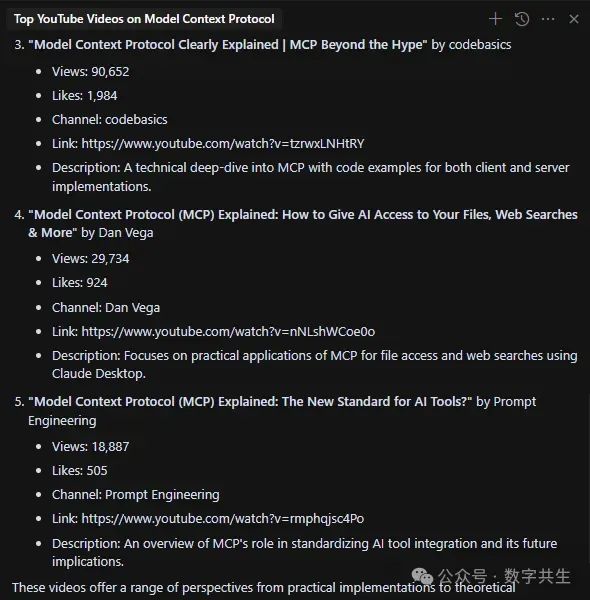

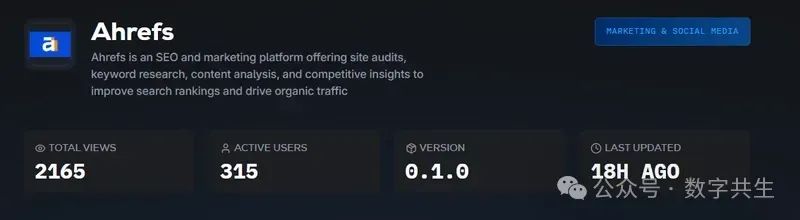

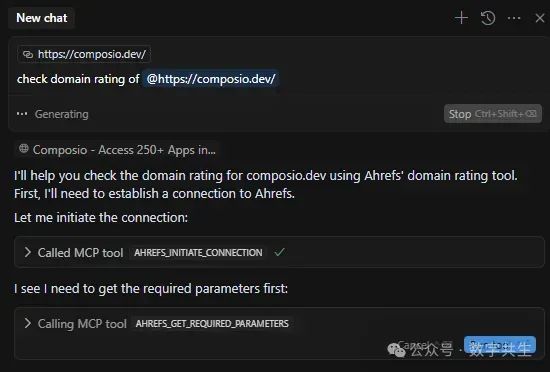

✅ Ahrefs服务器

我们将按照之前讨论的流程操作,您可以通过Composio服务器接入Ahrefs平台。

(注:Ahrefs是专业的SEO与营销分析平台,提供网站诊断、关键词研究、内容分析和竞品洞察等功能,帮助提升搜索排名并增加自然流量。)

mcp.json配置:

"ahrefs_composio": { "url": "https://mcp.composio.dev/ahrefs/freezing-wrong-xyz"}

首次连接:

完成配置后,您将能执行以下操作:获取自然搜索关键词、查询所有反向链接、查看域名评级历史、按流量排序的页面概览、检索公开爬虫IP列表、获取竞争对手分析概览、列出外链最佳页面、查询搜索量总历史数据等多项功能。(注意:需使用Ahrefs高级计划中的API密钥才能完成集成)

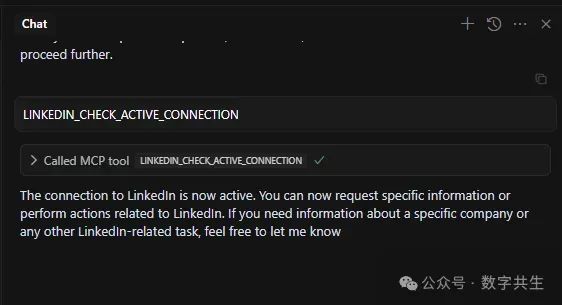

✅ LinkedIn服务器

您可以按照相同流程生成URL并在终端运行,随后需要在浏览器中复制OAuth URL进行连接建立和身份验证,操作完成后您将收到确认消息。

可以通过服务器的操作状态进行确认。如图所示,当前已建立有效连接。

我通常不建议在正式账户上使用它,因为再怎么谨慎都不为过。

通过这个MCP服务器,可以执行以下操作:获取个人资料信息、创建帖子、获取公司信息以及删除帖子。

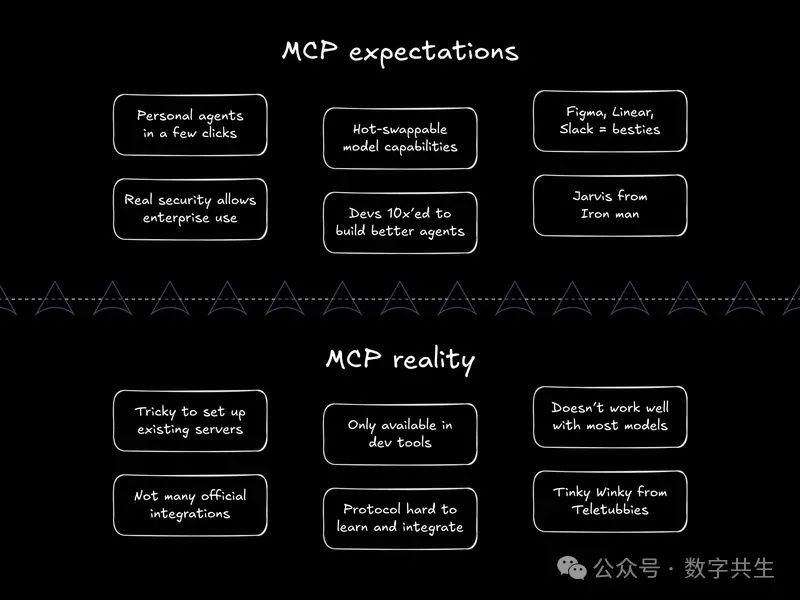

8. MCP当前的技术局限

MCP的预期与现实可能存在显著差异。随着您逐步了解以下要点,就会明白我的意思了。

不要误会,MCP潜力巨大,但必须了解其当前局限性:

⚡ 平台兼容性有限

Claude(尤其是其桌面应用程序)以及 Cursor、Windsurf 等工具直接支持 MCP。但如果你使用的是 ChatGPT 或本地 LLaMA 模型等工具,可能无法直接开箱即用。

目前有一些开源工具正尝试解决这一问题,但在 MCP 获得更广泛普及之前,实现所有 AI 助手的兼容性仍存在难度。

⚡ 智能体判断力并不完美

MCP(模型能力平台)赋予了 AI 执行操作的能力,但其判断能力仍非尽善尽美。

例如,工具的使用效果取决于模型对工具描述和使用场景的理解程度。通常需要通过提示词调优或代理端逻辑优化来提升可靠性。

这意味着,即使技术上支持工具调用,AI 仍可能因对任务语境的误判或工具参数理解偏差,导致操作结果不符合预期。因此,持续优化人机协同机制(如增加用户审核节点、动态调整提示策略)仍是提升代理可靠性的关键。

⚡ 性能损耗

通过 MCP(模型能力平台)使用工具会增加开销。每次调用都是外部操作,其速度可能比人工智能直接自行回答慢得多。例如,通过 MCP 工具从网页抓取数据可能需要数秒时间,而模型本可以利用训练数据在几毫秒内推测出答案。

现在,如果你需要协调多个工具,延迟会累积起来。例如,按顺序调用 5 个不同的 MCP 服务器来执行以下操作:

- 从 Google Drive 获取文件

- 使用 LLM 工具总结内容

- 翻译总结内容

- 根据翻译内容生成推文

- 使用 Buffer 等社交媒体工具安排发布

根据服务器响应时间,这个链条可能需要 10-15 秒。某些代理可以处理工具的并行使用,因此你可以进一步优化流程。

⚡ 信任机制缺失

让人工智能执行真实操作可能会让人感到有风险。即使 AI 通常能正确完成任务,用户往往仍希望在操作执行前进行审核。

目前,大多数工具要么完全自主运行,要么完全不具备自主能力。很少存在中间状态-即 AI 既能利用自主性提高效率,又能在关键节点将控制权交还给用户。我们都需要 “人为介入” 机制。

❌ 糟糕的方式:AI 未经询问直接发送电子邮件。

✅ 更好的方式:AI 先提示 “我即将向 X 发送以下内容的邮件,是否允许发送?”,并在获得用户批准后再执行操作。

⚡ 扩展性挑战

如今,大多数 MCP(多智能体协作平台,Multi-Agent Cooperation Platform)服务器是为单用户构建的,通常仅在开发者的笔记本电脑上运行。

而让单个 MCP 服务器为多个独立代理或用户提供服务的场景尚未得到充分探索。要实现这一点,企业需要处理更复杂的问题,例如并发请求、数据上下文隔离和执行速率限制等。

这是当前生态系统仍有发展空间的领域,尤其是在MCP 网关或企业级 MCP 服务器框架等概念的推动下,相关技术和解决方案亟待完善。

⚡ 安全标准问题

MCP(多智能体协作平台)本身不具备内置的身份验证或授权机制。

1)身份验证与授权

- MCP 未内置用户或代理的身份验证支持。若通过网络公开 MCP 服务器,需自行添加安全措施。

- 部分实现通过OAuth 2.1添加权限范围(如只读或只写访问),但目前尚无统一标准,导致不同服务器的认证方式各异。

2)权限管控

- 理想场景:代理应仅使用所需工具。但如果有多个强大工具可用(如浏览器访问、终端操作),除非手动禁用,否则无法阻止 AI 误用工具。

- 风险示例:若 AI 获得终端操作权限,可能被错误调用或滥用,引发安全隐患。

3)提示注入攻击

- 常规风险:AI 可能因误解提示而执行错误操作。

- 恶意风险:攻击者可能构造恶意提示,诱使 AI 执行有害行为(如数据泄露、系统破坏),而防护措施依赖于各 MCP 服务器的具体设计。

未来发展方向

- MCP 生态完善:随着需求的发现,将有更多针对边缘案例的安全解决方案落地,例如标准化的身份验证框架、细粒度权限管理等。

- 模型优化:AI 模型可能针对工具使用和 MCP 场景进行专门微调。例如,Anthropic 已提及未来将推出针对 MCP 交互优化的 AI 模型,从底层提升安全性和可控性。

扩展资源

以下是计划构建 MCP(多智能体协作平台)时值得参考的优质资源:

1)开发与测试工具mcp-chat

用途:基于命令行界面(CLI)的 MCP 服务器聊天客户端,用于测试和评估 MCP 服务器及代理的功能。

场景:开发者可通过交互式对话验证代理与工具的交互逻辑,快速定位调试问题。

2)服务器与工具集成平台mastra registry

定位:MCP 服务器目录集合,旨在将 AI 与用户常用工具连接。

价值:提供标准化的服务器索引,降低工具集成门槛,加速 AI 与外部应用(如数据库、API 服务)的对接效率。

3)能力扩展与市场平台smithery.ai

核心功能:通过 MCP 服务器为代理扩展4,630+ 功能,覆盖工具调用、API 集成等场景。

细节支持:提供每月工具调用量统计、本地部署选项、工具文档、API 说明及不同客户端的安装指南,适合企业级场景的精细化管理。

4)官方与社区资源库

Popular MCP Servers directory(官方团队维护)

影响力:GitHub 星标数达 20k,是社区认可的主流 MCP 服务器目录。

内容:收录各类开源及商用服务器,涵盖开发、数据处理、自动化等多领域工具,适合快速查找成熟解决方案。

Cursor directory of 1,800+ MCP servers

规模:集成 1,800+ MCP 服务器,与 Cursor(代码编辑器)生态深度整合。

优势:开发者可直接在 Cursor 中调用服务器能力,无缝衔接代码开发与 AI 工具协作,提升工作流效率。

MCP(多智能体协作平台)仍在不断发展,但它的核心理念已扎根落地。我已尽我所能阐释相关概念,希望你能从中有所收获。

与智能体的一次对话,就能帮你实现复杂工作流的自动化。

平台)时值得参考的优质资源:

1)开发与测试工具mcp-chat

用途:基于命令行界面(CLI)的 MCP 服务器聊天客户端,用于测试和评估 MCP 服务器及代理的功能。

场景:开发者可通过交互式对话验证代理与工具的交互逻辑,快速定位调试问题。

2)服务器与工具集成平台mastra registry

定位:MCP 服务器目录集合,旨在将 AI 与用户常用工具连接。

价值:提供标准化的服务器索引,降低工具集成门槛,加速 AI 与外部应用(如数据库、API 服务)的对接效率。

3)能力扩展与市场平台smithery.ai

核心功能:通过 MCP 服务器为代理扩展4,630+ 功能,覆盖工具调用、API 集成等场景。

细节支持:提供每月工具调用量统计、本地部署选项、工具文档、API 说明及不同客户端的安装指南,适合企业级场景的精细化管理。

4)官方与社区资源库

Popular MCP Servers directory(官方团队维护)

影响力:GitHub 星标数达 20k,是社区认可的主流 MCP 服务器目录。

内容:收录各类开源及商用服务器,涵盖开发、数据处理、自动化等多领域工具,适合快速查找成熟解决方案。

Cursor directory of 1,800+ MCP servers

规模:集成 1,800+ MCP 服务器,与 Cursor(代码编辑器)生态深度整合。

优势:开发者可直接在 Cursor 中调用服务器能力,无缝衔接代码开发与 AI 工具协作,提升工作流效率。

MCP(多智能体协作平台)仍在不断发展,但它的核心理念已扎根落地。我已尽我所能阐释相关概念,希望你能从中有所收获。

与智能体的一次对话,就能帮你实现复杂工作流的自动化。

现在,就用 MCP 去创造一些了不起的东西,让世界看到吧!

大模型岗位需求

大模型时代,企业对人才的需求变了,AIGC相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把全套AI技术和大模型入门资料、操作变现玩法都打包整理好,希望能够真正帮助到大家。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

内容包括:项目实战、面试招聘、源码解析、学习路线。

如果大家想领取完整的学习路线及大模型学习资料包,可以扫下方二维码获取

👉2.大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。(篇幅有限,仅展示部分)

大模型教程

👉3.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(篇幅有限,仅展示部分,公众号内领取)

电子书

👉4.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(篇幅有限,仅展示部分,公众号内领取)

大模型面试

**因篇幅有限,仅展示部分资料,**有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

**或扫描下方二维码领取 **

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?