传感器

自动驾驶的汽车要眼观六耳听八方,那么就需要使用多种传感器,常用的传感器如下:

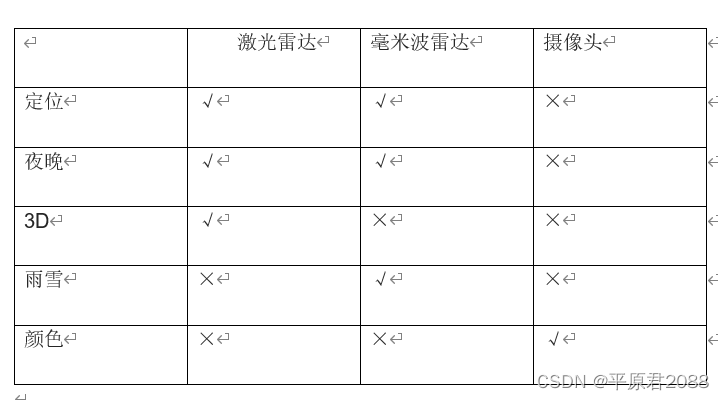

激光雷达:根据发射和接收激光的时间差,按照光速计算出距离。因为激光的波长短,所以能够构造出被扫描物体的表面。但是因为激光不断发射,则需要有源,功耗大。激光雷达分为机械式:不断360度旋转扫描;另外就是多探头相控雷达:靠不同相位的变换扫描,也能达到360度角度的扫描效果,这种雷达寿命更长,是未来发展趋势。

毫米波雷达:发射的毫米波,例如超声波。因为波长稍长,所以无法构造物体表面。

摄像头:最常用的传感器,不必发射,只是接收光信号。晚上不好用,并且遇到雨雪天则效果不好,一般无法探测深度,但是现在的RGB-D双目深度摄像头可以弥补不足。

导航和定位

汽车在行驶过程中可以根据电子地图(例如百度地图)和GPS接收器的结合,就能知道当前的位置。这种方式能达到米的精度。但是有时无法区分主路和辅道,无法区分高架桥的上下车道,所以还需要达到分米和厘米的精度。“千寻定位”能达到分米级别。而高德高精度地图,使用摄像机拍摄街景,然后汽车定位时候根据传感器得到的图像和高德高精度地图进行比较,找到差别,能达到更高精度。当然也可以在道路两侧安装一些探测和定位设备,通过5G技术让汽车和周围的网络环境进行交互得到位置和定位,这样精度更高。但是这种方式投入成本高,属于基础设施建设。

当前最流行的就是SLAM(simultaneous localization and mapping),全称即时定位与地图构建或并发建图与定位。现在的扫地机器人和无人飞机上得到广泛应用,能达到很高的精度,可到厘米级别。

多传感器融合

剩下一个问题就是多信息源的融合。自动驾驶汽车上安装了多种类的传感器,并且每种传感器有多个,这些传感器安装在不同的位置和角度,那么如何把这些传感器的信息融合呢?

1:首先不同传感器得到的信息不一样,所以需要进行整合,变成统一的空间信息才能处理。

2:其次就是感知到的信息位于不同的位置和角度,需要图像3D重构,这里需要用到图像的特征值进行三维重构。这里也比较复杂,我在前面的文章中提到了三维重构,现在使用AI技术能进行特征值匹配的3D空间重构。

3:不同传感器采样的频率不一样,所以要进行时间校准。

4:即使完成了空间校准和时间校准,那么不同传感器得到的信息可能出现矛盾,例如摄像头发现前面出现一堵墙,而激光雷达发现是一个斜坡。这就是各种传感器的精度不一样。这个时候就涉及到把不同精度的传感器进行融合的问题,这里要采用卡尔曼滤波技术,这里不详述。

总之通过以上多种传感器的结合,自动驾驶汽车就能得到周围的环境,后续把这些信息交付给中央处理器进行计算,然后决策,控制行驶路线和道路规划。

本文参考了李永乐老师的视频,在此感谢!

自动驾驶汽车依赖多种传感器,如激光雷达、毫米波雷达和摄像头,进行环境感知。激光雷达提供高精度距离信息,但功耗大,毫米波雷达无法构建物体表面。摄像头则用于接收光信号,但在恶劣天气下效果不佳。SLAM技术用于即时定位与地图构建,实现厘米级精度。多传感器融合通过统一空间信息、3D重构、时间校准和卡尔曼滤波解决信息矛盾,确保定位和环境感知的准确性。

自动驾驶汽车依赖多种传感器,如激光雷达、毫米波雷达和摄像头,进行环境感知。激光雷达提供高精度距离信息,但功耗大,毫米波雷达无法构建物体表面。摄像头则用于接收光信号,但在恶劣天气下效果不佳。SLAM技术用于即时定位与地图构建,实现厘米级精度。多传感器融合通过统一空间信息、3D重构、时间校准和卡尔曼滤波解决信息矛盾,确保定位和环境感知的准确性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?