🎓作者简介:科技自媒体优质创作者

🌐个人主页:莱歌数字-CSDN博客

💌公众号:莱歌数字

📱个人微信:yanshanYH

211、985硕士,职场15年+

从事结构设计、热设计、售前、产品设计、项目管理等工作,涉足消费电子、新能源、医疗设备、制药信息化、核工业等领域

涵盖新能源车载与非车载系统、医疗设备软硬件、智能工厂等业务,带领团队进行多个0-1的产品开发,并推广到多个企业客户现场落地实施。

专题课程

每日篇行业发展资讯,让大家更及时了解外面的世界。

更多资讯,请关注B站/公众号【莱歌数字】,有视频教程~~

数据中心是指容纳许多计算机系统的设施,通常安装在一排排的电子机架中。

数据中心的大小各不相同,最高可容纳数千个机架,每个机架通常消耗10-30 KW的功率。

它们就像信息经济的骨干,对大学和政府机构、金融服务、医疗、媒体和高科技行业至关重要。

数据中心包括企业服务器、服务器通信设备、冷却和电力设备。

由于通信和数据存储行业的持续增长,数据中心在国家能源消耗和碳足迹中占有重要的份额,这导致了数据中心的能源消耗的快速增长。

仅在美国,数据中心的能源消耗就约占美国总能源消耗的2%,而且还将继续稳步增长。下面的图1显示了数据中心的典型能量分布。

能源消耗最多的部件是IT设备和冷却系统,总功耗占总能量的70%以上。一般来说,冷却设备使用的能量几乎与IT设备相同。

看看上述事实,数据中心的效率近年来受到了比以往更多的审查。运营成本和资本支出的急剧增加,推动了数据中心设计和热管理的变革需求。

为了提高数据中心的冷却效率,我们已经做了大量的工作,包括设备的正确布局、动态监控、局部空调设备、软件改进,如虚拟化和放置多余的硬件,目前正在实施中。

名称定义

-

IT =信息技术空调=空调

-

CPU =中央处理单元

-

PUE =用电效率

-

NWS =国家气象局

-

CRAC =机房空调

-

CRAH =机房空气处理器

-

APC =美国电力转换

数据中心气冷和混合动力(气液)冷却

数据中心级热管理最常用的方法是空冷。空调被放置在整个数据中心,为IT设备的机架提供冷空气。

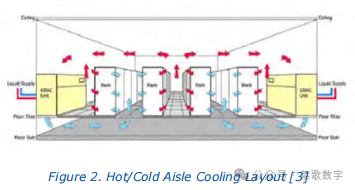

通常,如图2所示,机架排列排列,在“冷通道”完成冷空气进风,热空气排出到“热岛”。

鼓风机将热空气从IT硬件中抽出。然后,冷空气通过升高的地板上的穿孔瓷砖返回“冷通道”,架子安装。

随着数据中心规模的增加,目前的空气冷却系统达到其局限性,冷却技术不可避免地转向空气-液体(混合)或液体冷却系统。

混合冷却系统的典型热交换器设计从现有的风冷系统开始。为了提供具有最小体积和输入功率的最佳冷却,使用了一个雷诺数刚好高于层流极限的螺旋冷却通道。

这提供了最佳的冷却与一个合理的大小的通道,可以通过污染。下面的图3显示了这种热交换器。

上述液体冷却结构是对现有的风冷热交换器的补充。来自cpu的热量,占服务器总功率的50%,可以直接输送到外部的冷却塔,没有冷却机、房间风扇或空气处理器。

绕过空调系统可以节省数据中心的冷却功率,并为冷却系统增加了冗余量。

液体-空气散热器的性能可以根据数据中心温度、冷却剂温度、CPU功率和热阻来预测其性能。例如,考虑从水对散热器的热阻为0.04oC/W,对空气的热阻为0.2oC/W。

现在,如果CPU功率为100瓦,水温为59华氏度(15摄氏度),空气温度为77华氏度(25摄氏度),散热器除了去除100瓦的CPU功率外,还将从空气中去除25瓦。

如果使用相同的散热器,CPU功率为50瓦,采用86oF(30℃)数据中心温度,则将从数据中心空气中提取55瓦的热量。

这意味着,如果数据中心被允许热身在低入住率,电脑在低功率和湿球温度低然后暖通空调系统将保持和色调下降到接近1无需建立一个定制的建筑。

可以使用上述方法来计算给定数据中心一年以上的精确节能,并结合可用的每小时湿球温度与时间的数据。

一个典型的数据中心空气冷回路

如图风冷子系统下面的图4所示,热量被强制通过外壳的空气所吸收。然后将其转移到冷室空调(CRAC)单元。

由于空气系统不一定是密封的,因此存在允许的热空气对冷空气的再循环,以及冷空气对热空气的短路。这有助于降低CRAC入口和提高机架进气温度。

从crac开始,热量通过一个水回路交换到冷却器,这被假定是在数据中心之外的。冷水机然后有一个热交换器,排斥热量到冷却塔。

一个典型的数据中心液体冷却回路

图5显示了液体冷却子系统的总布局。来自系统的热量通过液体在内部输送到机架上的热交换器中。

热量通过热交换器将水输送到设施中。然后它被带到冷却塔的热交换器,在那里热量被转移到设施冷却塔。然后,冷却塔通过蒸发冷却来处理热量。

基于对各种冷却安排和设置的简要介绍,下一节将讨论一个分析案例研究,这将有助于确定空气冷却和混合冷却之间的区别,并将有助于确定混合冷却的好处。

分析案例研究

本研究使用了一个5000平方英尺的数据中心,它具有以下属性:

-

系统功耗100W/平方英尺(平均3千瓦/机架)

-

热岛/冷岛冷却方案

-

没有空气密封

-

提高地板冷却

-

CRAC-冷却器冷却塔冷却

-

设施20摄氏度入口计算机设备水冷却环境架

该型号是一个没有内部制冷的水/空气热交换器。冷水机模型为热护理,型号为TCR180。该模型中使用的单个冷却塔使用了SAC 15146。

该模型主要关注室外环境的变化参数和IT热的百分比被液体系统除去。

为了验证,我们将100%风冷数据中心模型与实际数据中心收集的数据进行了比较。

与IT设备的负载相比,衡量数据中心的总功耗的常用指标之一是功率使用效率值或PUE(PUE =总设施功率/ IT设备功率)。

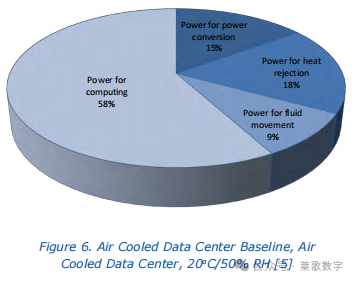

图6显示了所调查的各种数据中心系统的功耗百分比。

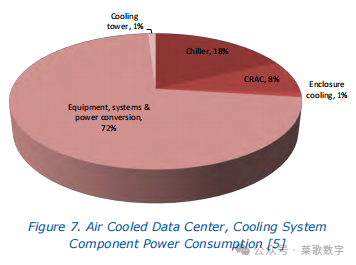

下面的图7显示了冷却系统使用的电源故障。冷水机消耗最大功率,其次是CRACs。这两个组件都支持空气冷却系统,但液体冷却系统不需要。

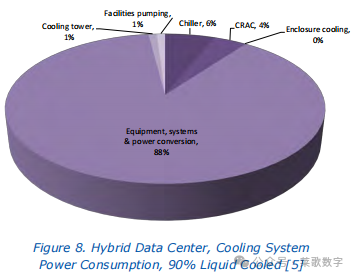

图8显示了与图7的直接比较。由IT系统和电力调节设备所抽取的总电力保持不变。

它显示了相同的功耗信息,但混合数据中心通过液体消耗了90%的IT负载。因此,冷却系统的功耗从空冷数据中心的27%下降到12%。

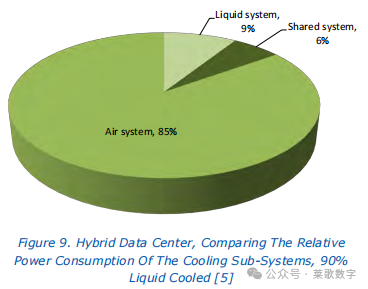

从图9可以看出,对于混合数据中心,数据中心热管理系统消耗的总功率中,有85%仍被空冷子系统消耗。

这意味着冷水机和混凝土仍然是主要的消费者,即使90%的IT设备是由液体回路冷却的。

表1显示了混合系统的比较。该模型表明,在US$0.10/kW-hr,在风冷数据中心运行评估系统的年成本为75.8万美元。

其中20.6万美元是专门用于冷却系统的。90%的混合动力系统的成本63万美元,冷却系统成本为7.9万美元,每年节省12.8万美元,或每年的能源消耗和运营成本减少16.6%。

该模型的成本分析

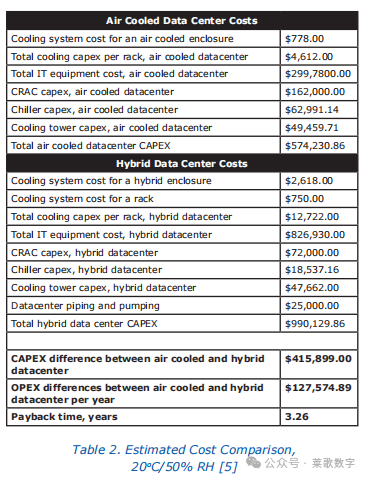

混合冷却的实现表明了操作费用的成本节约。表2显示了分析的计算成本。

混合数据中心不需要那么多的crac,它可以使用较低容量的冷却器或冷却器。因此,混合数据中心的CRAC/CRAHs和冷水机(s)的成本较低。

总之,在混合数据中心冷却系统中有一个巨大的运营费用节省潜力。对于该模型中使用的5000平方英尺的数据中心,在20oC/50% RH运行条件下,90%液体冷却数据中心的节省估计超过12.5万美元,50%液体冷却数据中心的节省估计超过75000美元。

通过结合CRAC/CRAH和冷水机尺寸的减少以及所涉及的运营费用,混合数据中心的超额成本将在3-6年内根据配置和环境进行抵消。

考虑到该数据中心的使用寿命为15年,在20oC/50%的RH环境下,预计总共可节省72.7万美元至144万美元。

结论

数据中心的设计人员和管理人员在决定混合数据中心是否是一个很好的解决方案时,需要考虑到能源节约、增长潜力、环境影响和成本。

随着当今加速的电力消耗和密度需求与环境问题和能源成本的平衡,混合数据中心可以为数据中心用户提供一个可行的选择,以减少能源消耗,同时保留一些现有的IT设备。

获得一个体面的投资回报率的关键是水和风冷散热器,逆转系统热力学,这样散热器消除热量从cpu和服务器内部和数据中心一般为了减少暖通空调负荷和风扇功率。

说以上数字可以放大是合乎逻辑的,所以对于一个更大的数据中心,比如10万平方英尺,15年的冷却节省可以超过2500万美元。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?