本人是在windows8下用virtualbox 虚拟的ubuntu server14.04

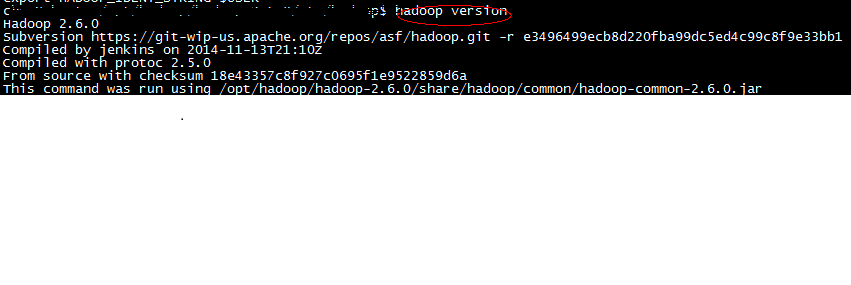

hadoop 版本为 2.6.0,模式是伪分布模式。jdk版本为jdk 1.7.0_79

安装过程中总是碰到教程上不会出现的问题,下面就总结下主要步骤,以及安装配置过程中遇到的问题。

安装jdk,配置JAVA_HOME,最好直接配置在/etc/profile 或其他shell启动文件里,这样可以后面不用更改hadoop安装目录/etc/hadoop/hadoop-env.sh文件里的JAVA_HOME配置

配置hadoop 安装目录

最好也配置在etc/profile或其他shell启动文件里export HADOOP_INSTALL=/opt/hadoop-2.6.0(你自己的安装目录)

export PATH= PATH: HADOOP_INSTALL/bin:$HADOOP_INSTALL/sbin这时用hadoop version就可以看一下hadoop是否可用了

二 、配置

hadoop 的各个组件均可利用xml文件进行配置。

core-site.xml文件用于配置通过属性

hdfs-site.xml文件用于配置HDFS属性

mapred-site.xml文件则用于配置MapReduce属性

这些文件在hadoop2.6.0中位于etc/hadoop/ 子目录下(2.0以后版本运行在YARN上,有一个额外的配置文件yarn-site.xml, 2.0之前在conf子目录下)

Hadoop 有三种运行模式:

1. 独立(或本地) 模式

2. 伪分布模式

3. 全分布模式

这里就主要讲下伪分布模式的配置:

分别配置上述提到4 个文件

core-site.xml

> <?xml version="1.0" encoding="UTF-8"?> <configuration>

> <property>

> <name>fs.default.name</name>

> <value>hdfs://localhost/</value>

> </property> </configuration>hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>mapred-site.xml(这个暂时不忒确定要不要,etc/hadoop/下面本只有mapred-site.xml.template,需要自己copy一下改成mapred-site.xml)

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:8021</value>

</property>

</configuration>因为要运行YARN,所以也要配置一下

yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.address</name>

<value>localhost:8032</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce.shuffle</value>

</property>

</configuration>xml配置完毕

——————————-华丽分隔线———————————————

为了在windows下SSH到 virtualbox里的虚拟机,要配置下虚拟机的网卡,

虚拟机的网络配置里,

网卡1

连接方式:桥接网卡

混杂模式:全部允许

在虚拟机里ifconfig,查看eth0的 inet addr,例如192.168.0.219

在windows 里如果能ping通,如果SSH服务已安装启动,刚就可以通过putty,secureCRT等 SSH到虚拟机了。具体SSH的安装可自行搜索

格式化HDFS系统

hadoop namenode -format

在这个过程中遇到了hadoop2.6.0/logs no such file or directory之类的错误,去hadoop安装目录下新建一个logs文件夹,并chmod 一下,保证有写权限

启动守护进程(mapreduce2)

start-dfs.sh

start-yarn.sh

这两个命令将启动HDFS守护进程和YARN的资源管理器和节点管理器

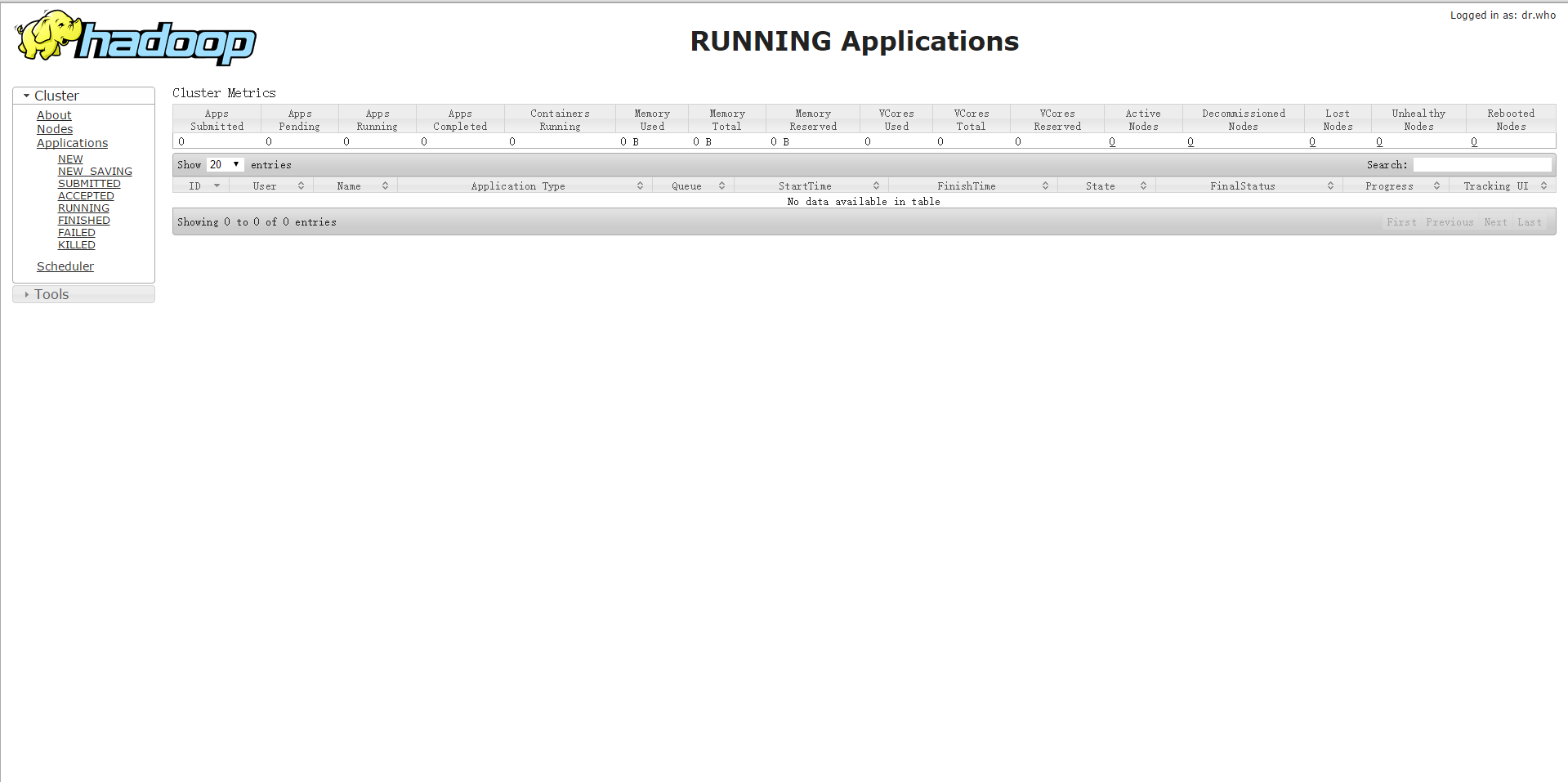

资源管理器的web地址是http://localhost:8088

如果在执行start-dfs.sh的时候好像报找不到JAVA_HOME

这个时候去hadoop安装目录/libexec/hadoop-config.sh

找到

if [[ -z $JAVA_HOME ]]; then

这一行

在这一行前面加上

export JAVA_HOME=/home/jdk1.7.0_79(jdk目录)

if [[ -z $JAVA_HOME ]]; then

。。。。。。

。。。

如果前面你的网卡已经配置好,在windows的浏览器里输入192.168.0.219:8088将会看到

大功告成,可以开始研究如何编写map reduce程序 以及其他组件了

初次安装,难免会出现疏漏,欢迎大家批评指正,共同学习。

4108

4108

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?