一篇之前看的时候蛮顺但现在实在看不明白的文章=-=目前为止物理可实现攻击一般是指在实物上动手脚,让分类器对实物的图片误分类。

摘要

最近的研究表明,最先进的深度神经网络(DNNs)很容易受到来自输入的小幅度扰动的攻击。鉴于新兴物理系统在安全关键情况下使用DNN,对抗性示例可能误导这些系统并导致危险情况。因此,理解物理世界中的对抗性例子是开发弹性学习算法的重要一步。我们提出了一种通用的攻击算法,鲁棒物理扰动(RP2),在不同的物理条件下产生鲁棒的视觉对抗扰动。利用道路标志分类的实际案例,我们表明,在各种环境条件下(包括视点),使用RP2生成的对抗性示例与物理世界中的标准建筑道路标志分类器相比实现了高目标误分类率。由于目前缺乏一种标准化的测试方法,我们提出了一种由实验室测试和现场测试组成的两阶段评估方法。利用这种方法,我们评估了在真实物体上进行物理对抗性操作的有效性。利用黑白标签形式的扰动,我们攻击了一个真正的停车标志,在实验室环境中获得的100%的图像中造成了有针对性的错误分类,在目标分类器的移动车辆(现场测试)上获得的84.8%的捕获视频帧中造成了有针对性的错误分类。

两个重点:1、攻击算法RP2 2、两阶段评估方法(实验方法)

3. Adversarial Examples for Physical Objects

3.1. Physical World Challenges

小小的总结了一下物理可实现攻击需要面对的挑战。

环境条件 相机会拍摄不同距离不同角度的照片,且光照、天气等因素都可能会影响到攻击效果。

空间限制 向数字图片添加扰动时可以把扰动添加到图片的任何位置,但对于物理可实现攻击来说,背景图像并不是攻击者所能控制的(不同角度距离背景都会变)

对不可察觉性的物理限制 这里的描述是说数字图像中的扰动通常很细微,但放到现实世界中,你需要确保攻击可以被相机给保留下来。同时在别的文章里有提到你的攻击不能太明显,比如说化了很夸张的妆之类的哈哈哈哈

制造错误 你必须保证你制造的扰动能被打印或者通过其他手段能被制造出来。开始也说了,物理可实现攻击一般是指在实物上动手脚,别在最开始扰动就被搞掉了=-=

第一次看这篇文章的时候觉得这里说的非常有道理!

3.2. Robust Physical Perturbation

现在来到算法部分!首先是最基本的扰动描述:

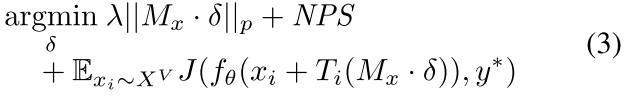

在这里用的都是有目标攻击,主要原因是无目标攻击很容易就会被干掉!因为自动驾驶系统里系统的判断都是根据几张图片的结果投票判断的。然后把上述式子化为拉格朗日松弛形式:(这个说法第一次见,但形式非常常见。。。

λ

\lambda

λ是用来正则化的超参,J是loss function就不用多讲啦。这里补充了最开始H函数表征的就是扰动的p范数。啊这里其实不是重点啦=-=

现在把第一部分提到的环境条件考虑进来!这里作者的方法大致是定义了一个变换集合 X V X^V XV,然后上面的最优化问题不仅要保证在原图的基础上实现攻击,也要保证当 X V X^V XV的元素 x i x_i xi加到原图上去的时候也能实现攻击。。。但是问题是, X V X^V XV是怎么生成的啊=-=

对于路标物理条件,这涉及在各种条件下拍摄路标图像,例如改变距离、角度和闪电。这种方法旨在更接近物理世界的动力学。对于合成变化,我们随机裁剪图像中的对象,改变亮度,并添加空间变换来模拟其他可能的条件。

原文这么说但总觉得这是个庞大的工程?没这么简单?

第二部分是确保扰动落在目标上,以此解决空间限制和不可查觉性的物理限制。。。具体做法是,先设定一块方块,大概就像是被糊死的小广告=-=然后再确定方块的大小、位置。具体做法:1) 使用L1正则化和占据符号整个表面积的遮罩计算扰动。L1使优化器倾向于稀疏扰动向量,因此将扰动集中在最脆弱的区域。可视化产生的扰动提供了掩模放置的指导。(2) 使用L2重新计算扰动,并将遮罩放置在前面步骤中确定的脆弱区域上。

大概是1范数定位2范数放置?把图片想成矩阵或者张量的话感觉会比较好考虑这个问题?L2范数是为了确保算的没错再算一次还是有别的理由?

制造错误是引用了另一篇论文的结论,看了老半天以至于还没看到这里用的部分就弃了好在找到了这篇文章的另一版本,里面描述了这个。。。:

大致意思是把扰动需要的颜色组和能打印的颜色组进行比对运算得到不可制造性。

综上所述,总体公式如下:

T函数是为了保证图片受到什么影响,扰动也跟着受什么影响。比如说如果图片转,扰动也会跟着转。

Experiments

数据集分类器这些就不细讲了,从两种试验方法开始。

** Stationary (Lab) Tests** 实验室测试,保持照相机高度不变,改变相机相对于目标(这篇文章的目标都是路牌)的距离和角度,拍摄干净样本和加扰动样本,然后计算成功率。

这个实验统一使用有目标攻击,也就是分类到目标类别才算攻击成功,这样做的目的也是为了避免由其他因素导致攻击成功的情况。

Drive-By (Field) Tests 上路测试,把手机固定在车上,然后在250ft远的地方录制视频,走直线,一过路牌就停止录像。速度从0到20都有。然后和上面差不多,录制干净样本的和对抗样本的视频,计算成功率。

在这里有一点不太一样,就是对于视频来说,是每 x x x帧做分类然后少数服从多数。然后作者去的 x = 10 x=10 x=10。是间隔10帧取图像做分类的意思。。重新翻译了一下。这里作者也考虑了15帧的情况,没啥区别。(其实应该多考虑几种情况?)

That’s all.新年快乐:)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?