1.ELK概述

E:Elasticsearch

L:Logstash

K:Kibana

日志服务器

提高安全性

集中存放日志

缺陷:对日志的分析困难

日志处理步骤

1)将日志进行集中化管理

2)Logstash将日志格式化并输出到ES数据库

3)在ES数据库中对格式化后的数据进行索引和存储

4)在Kibana中进行前端数据的展示

Elasticsearch数据库

概述

提供了一个分布式多用户能力的全文搜索引擎

核心概念

接近实时

集群

节点

索引

索引(库)—>类型(表)—>文档(记录)

分片和副本

四、Kibana介绍

Kibana

概述

一个针对ELasticsearch的开源分析及可视化平台

搜索、查看存储在Elasticsearch索引中的数据

通过各种图表进行高级数据分析及展示

Kibana主要功能

Elasticsearch无缝之集成

整合数据,复杂数据分析

让更多团队成员受益

接口灵活,分享更容易

配置简单,可视化多数据源

简单数据导出

部署ELK

环境:

esnode1(Kibana):20.0.0.13

esnode2:20.0.0.14

webserver:20.0.0.15

1.配置node1,node2

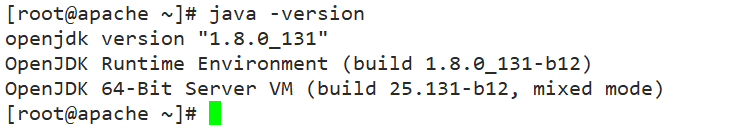

java -version

//解压安装ES

rpm -ivh elasticsearch-5.5.0.rpm

systemctl daemon-reload //重启守护进程

systemctl enable elasticsearch.service

//备份修改配置文件

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak //备份配置文件

vi /etc/elasticsearch/elasticsearch.yml

cluster.name: es //集群名(集群内所有节点的集群名要一致)

node.name: node1 //node1节点名

#node.name:node2 //node2节点名

path.data: /data/elk_data //数据存放路径

path.logs: /var/log/elasticsearch //日志路径

bootstrap.memory_lock: false

network.host: 0.0.0.0

http.port: 9200

discovery.zen.ping.unicast.hosts: ["node1","node2"] //集群各个节点,若使用主机名需添加解析映射,也可直接写IP地址

grep -v "^#" /etc/elasticsearch/elasticsearch.yml //反向过滤显示配置内容

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

安装elasticsearch-head

// 1.安装node组件

tar -zxvf node-v8.2.1.tar.gz

cd node-v8.2.1/

./configure

make -j2 && make install

// 2.安装phantomjs

tar -jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/local/src

cp /usr/local/src/phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin

// 3.安装elasticsearch-head

tar -zxvf elasticsearch-head.tar.gz -C /usr/local/src

cd elasticsearch-head/

npm install

// 4.修改elasticsearch配置文件

vi /etc/elasticsearch/elasticsearch.yml

http.cors.enabled: true //在末尾添加

http.cors.allow-origin: "*"

systemctl restart elasticsearch

// 5.

cd /usr/local/src/elasticsearch-head/

npm run start &

配置WebServer

yum -y install httpd

systemctl start httpd

// 安装logstatsh

rpm -ivh logstash-5.5.1.rpm

systemctl start logstash

systemctl enable logstash

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

收集Apache日志到ES数据库

vi /etc/logstash/conf.d/http_logs.conf

input {

file{

path => "/var/log/httpd/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/var/log/httpd/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" { //把access日志输出到es数据库

elasticsearch {

hosts => ["20.0.0.14:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["20.0.0.14:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

systemctl restart logstash

在一台node节点上配置Kibana

mv kibana-5.5.1-x86_64.rpm /usr/local/src

rpm -ivh kibana-5.5.1-x86_64.rpm

cd /etc/kibana/

cp kibana.yml kibana.yml.bak

vi kibana.yml

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://20.0.0.14:9200"

kibana.index: ".kibana"

systemctl start kibana

systemctl enable kibana

569

569

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?