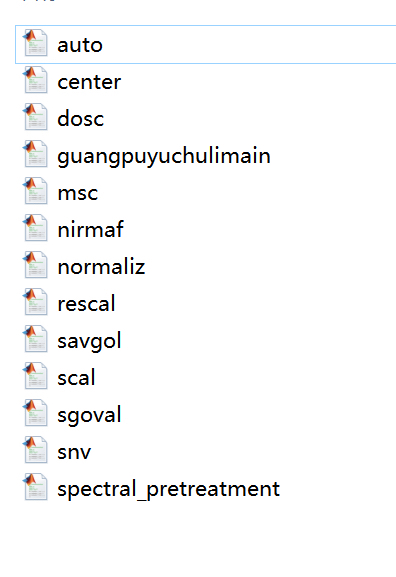

该算法主要用于处理高光谱和近红外光谱的原始数据,主要包括标准正态变量交化(SNV)、标准化(Autoscales)、SavitZky一Golay卷积平滑法(SG-平滑)、一阶求导(1st derivative)、归一化(normalization)、移动平均平滑(moving average,MA)等光谱预处理方法,替换数据就可以直接使用,代码注释都已经写好。

ID:8560656409604272

Matlab建模

标题:高光谱和近红外光谱数据处理算法研究

摘要:本文主要介绍了针对高光谱和近红外光谱原始数据的处理算法,包括标准正态变量交换(SNV)、标准化(Autoscales)、SavitZky-Golay卷积平滑法(SG-平滑)、一阶求导(1st derivative)、归一化(normalization)和移动平均平滑(moving average, MA)等预处理方法。这些算法可以直接应用于数据替换,同时我们提供了代码注释以供参考。

-

引言

高光谱和近红外光谱技术在许多领域都有广泛应用,如农业、环境监测、药物研发等。然而,由于原始光谱数据存在噪声、背景干扰等问题,需要进行预处理以提高数据质量和信息提取效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?