Python是一门强大的编程语言,在网络爬虫方面也有着广泛的应用。本文将介绍如何使用Python爬取网络小说,并将其保存到数据库中。

首先,我们需要了解要爬取的网站的结构和数据格式。以笔者熟悉的笔趣阁(https://www.biquge5200.cc/)为例,每本小说的章节都以一个链接的形式呈现在小说目录页面上。

我们可以从小说目录页面获取每个章节的链接,然后通过这些链接访问每个章节的内容,并将其保存到数据库中。

接下来,我们需要安装所需的Python库。本文使用的是requests、BeautifulSoup和pymysql库。

requests库用于发送HTTP请求和获取响应,BeautifulSoup库用于解析HTML页面,pymysql库用于连接和操作MySQL数据库。

pip install requests

pip install beautifulsoup4

pip install pymysql

然后我们编写Python代码。首先,我们需要导入所需的库:

import requests

from bs4 import BeautifulSoup

import pymysql

接下来,我们需要连接到MySQL数据库。在本地环境中,我们可以使用XAMPP或MAMP等软件来创建和管理数据库。

在连接到数据库之前,我们需要创建一个数据库和一个数据表来存储小说数据。在MySQL命令行中输入以下命令:

CREATE DATABASE novel;

USE novel;

CREATE TABLE IF NOT EXISTS chapters (

id INT NOT NULL AUTO_INCREMENT,

title VARCHAR(255) NOT NULL,

content TEXT NOT NULL,

PRIMARY KEY (id)

);

这将创建一个名为novel的数据库,以及一个名为chapters的数据表,其中包含id、title和content三个字段。

id字段是一个自增的整数,title和content字段分别用于存储章节标题和内容。

接下来,我们需要定义一个函数来获取小说目录页面的HTML代码,并从中提取每个章节的链接。

对于笔趣阁网站,每个小说的目录页面的URL格式为“https://www.biquge5200.cc/xiaoshuodaquan/”,其中xiaoshuodaquan是小说的ID。

因此,我们可以使用格式化字符串来构造目录页面的URL。该函数的代码如下:

def get_chapter_urls(novel_id):

url = f'https://www.biquge5200.cc/{novel_id}/'

res = requests.get(url)

soup = BeautifulSoup(res.text, 'html.parser')

links = soup.select('#list a')

urls = []

for link in links:

url = link.get('href')

if url.startswith('/'):

url = f'https://www.biquge5200.cc{url}'

urls.append(url)

return urls

在这个函数中,我们首先构造目录页面的URL,然后使用requests库向服务器发送HTTP请求,并使用BeautifulSoup库解析HTML代码。

我们可以使用CSS选择器“#list a”来选择所有章节链接的元素。

然后,我们从每个链接中提取URL,并将其添加到一个列表中。最后,我们返回该列表。

接下来,我们需要定义一个函数来获取每个章节的HTML代码,并从中提取章节标题和内容。该函数的代码如下:

def get_chapter_content(url):

res = requests.get(url)

soup = BeautifulSoup(res.text, 'html.parser')

title = soup.select_one('.bookname h1').text

content = soup.select_one('#content').text

return title, content

在这个函数中,我们首先使用requests库向服务器发送HTTP请求,并使用BeautifulSoup库解析HTML代码。

然后,我们使用CSS选择器“.bookname h1”和“#content”来选择章节标题和内容的元素,并从中提取文本。最后,我们返回标题和内容。

最后,我们需要定义一个主函数来连接到数据库、获取章节链接、获取章节内容,并将其保存到数据库中。该函数的代码如下:

def main(novel_id):

conn = pymysql.connect(

host='localhost',

user='root',

password='',

database='novel'

)

urls = get_chapter_urls(novel_id)

for url in urls:

title, content = get_chapter_content(url)

with conn.cursor() as cursor:

sql = 'INSERT INTO chapters (title, content) VALUES (%s, %s)'

cursor.execute(sql, (title, content))

conn.commit()

conn.close()

在这个函数中,我们首先使用pymysql库连接到数据库。然后,我们获取小说的所有章节链接,并使用for循环遍历每个链接。

对于每个链接,我们使用get_chapter_content函数获取章节标题和内容,并使用pymysql库将它们插入到数据表中。最后,我们关闭数据库连接。

现在我们已经编写了Python代码,可以使用以下命令来运行它:

main('123456')

其中,123456是小说的ID,可以替换为任何其他小说的ID。运行代码后,我们可以在MySQL命令行中执行以下命令,来查看数据表中的数据:

SELECT * FROM chapters;

以上就是使用Python爬取网络小说并保存到数据库的完整过程。需要注意的是,爬取网络小说可能涉及版权问题,请在合法授权的情况下进行。

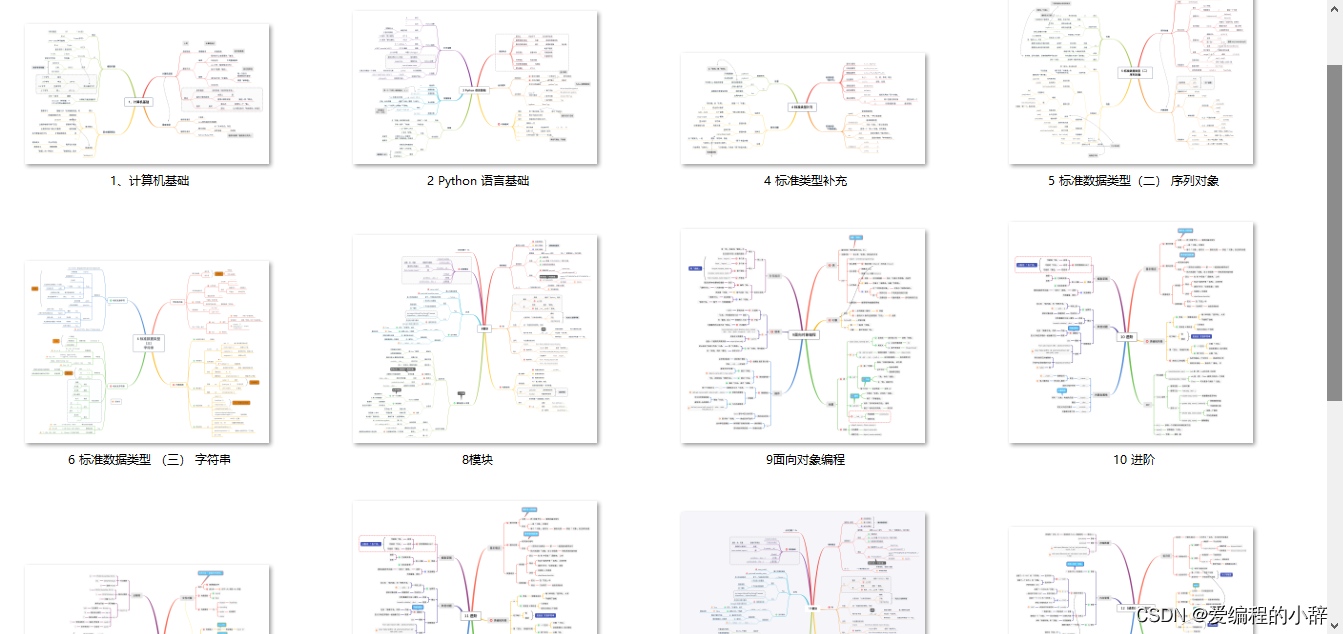

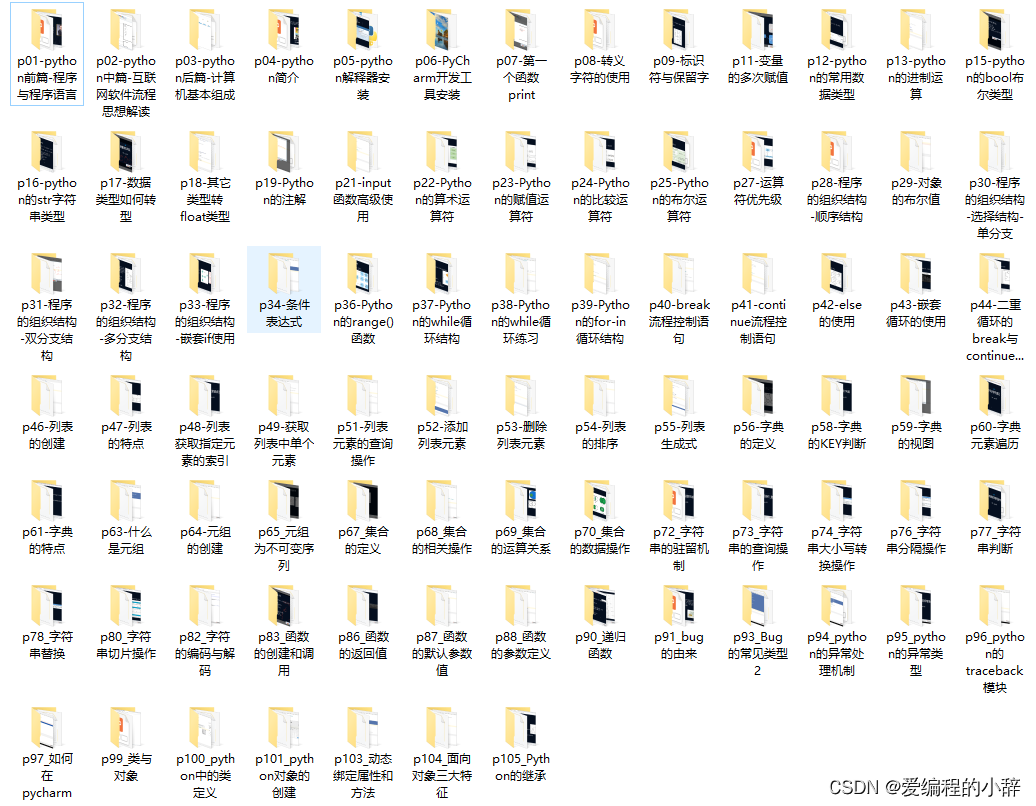

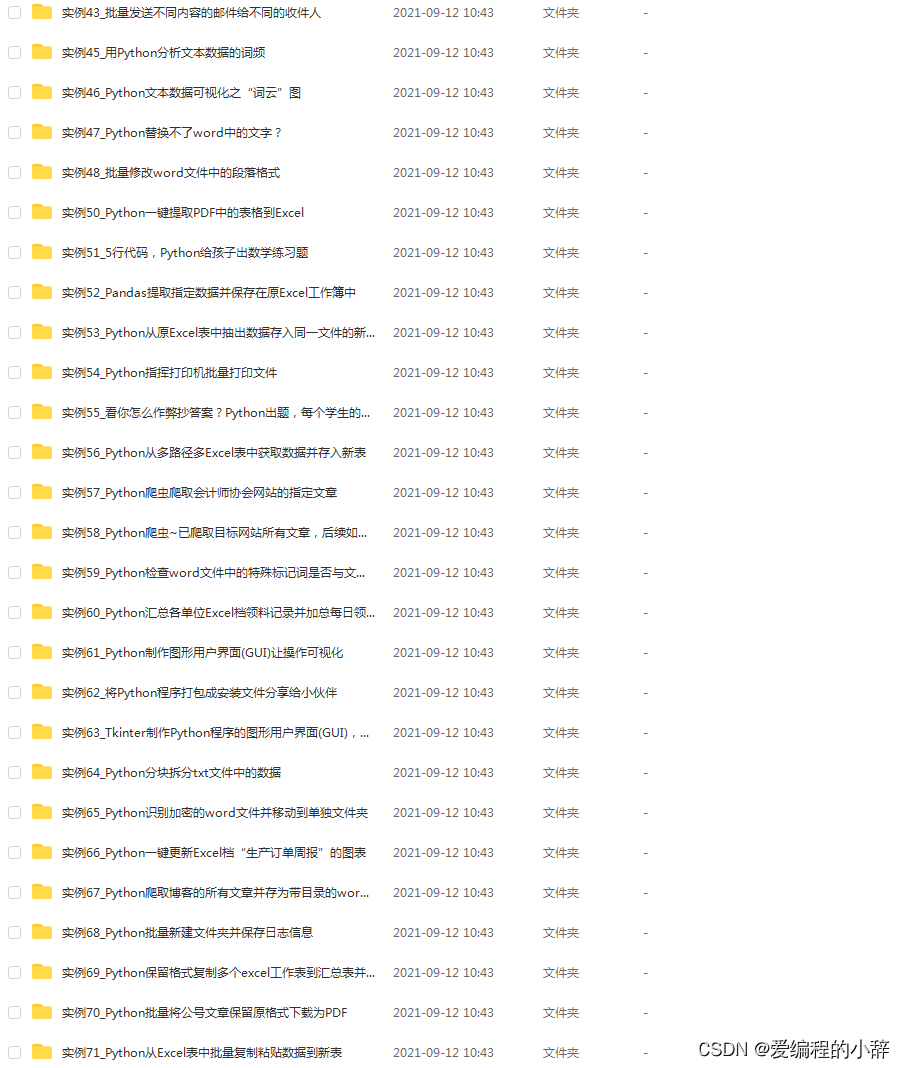

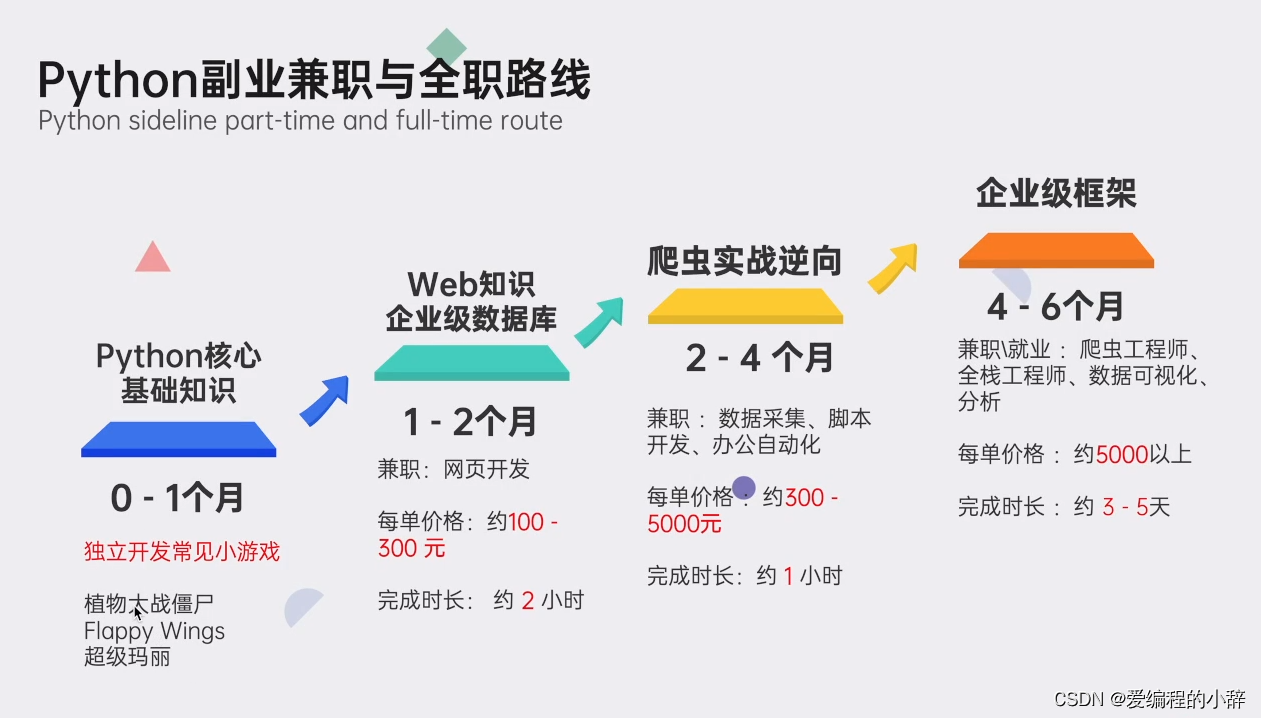

此外我这里准备了详细的Python资料,除了为你提供一条清晰的学习路径,我甄选了最实用的学习资源以及庞大的实例库。短时间的学习,你就能够很好地掌握爬虫这个技能,获取你想得到的数据。

01 专为0基础设置,小白也能轻松学会

我们把Python的所有知识点,都穿插在了漫画里面。

在Python小课中,你可以通过漫画的方式学到知识点,难懂的专业知识瞬间变得有趣易懂。

你就像漫画的主人公一样,穿越在剧情中,通关过坎,不知不觉完成知识的学习。

02 无需自己下载安装包,提供详细安装教程

03 规划详细学习路线,提供学习视频

04 提供实战资料,更好巩固知识

05 提供面试资料以及副业资料,便于更好就业

这份完整版的Python全套学习资料已经上传CSDN,朋友们如果需要也可以扫描下方csdn官方二维码或者点击主页和文章下方的微信卡片获取领取方式,【保证100%免费】

169

169

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?