版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

官方网址:https://flink.apache.org/

学习资料:https://flink-learning.org.cn/

目录

Flink基石

Flink之所以能这么流行,离不开它最重要的四个基石:Checkpoint、State、Time、Window。

Flink运行时的组件

- JobManager

- TaskManager

- ResourceManager

- Dispatcher

Flink运行时架构主要包括四个不同的组件,它们会在运行流处理应用程序时协同工作:

- 作业管理器(JobManager):分配任务、调度checkpoint做快照

- 任务管理器(TaskManager):主要干活的

- 资源管理器(ResourceManager):管理分配资源

- 分发器(Dispatcher):方便递交任务的接口,WebUI

因为Flink是用Java和Scala实现的,所以所有组件都会运行在Java虚拟机上。每个组件的职责如下:

作业管理器(JobManager)

- 控制一个应用程序执行的主进程,也就是说,每个应用程序都会被一个不同的JobManager 所控制执行。

- JobManager 会先接收到要执行的应用程序,这个应用程序会包括:作业图(JobGraph)、逻辑数据流图(logical dataflow graph)和打包了所有的类、库和其它资源的JAR包。

- JobManager 会把JobGraph转换成一个物理层面的数据流图,这个图被叫做“执行图”(ExecutionGraph),包含了所有可以并发执行的任务。

- JobManager 会向资源管理器(ResourceManager)请求执行任务必要的资源,也就是任务管理器(TaskManager)上的插槽(slot)。一旦它获取到了足够的资源,就会将执行图分发到真正运行它们的TaskManager上。而在运行过程中,JobManager会负责所有需要中央协调的操作,比如说检查点(checkpoints)的协调。

任务管理器(TaskManager)

- Flink中的工作进程。通常在Flink中会有多个TaskManager运行,每一个TaskManager都包含了一定数量的插槽(slots)。插槽的数量限制了TaskManager能够执行的任务数量。

- 启动之后,TaskManager会向资源管理器注册它的插槽;收到资源管理器的指令后,TaskManager就会将一个或者多个插槽提供给JobManager调用。JobManager就可以向插槽分配任务(tasks)来执行了。

- 在执行过程中,一个TaskManager可以跟其它运行同一应用程序的TaskManager交换数据。

资源管理器(ResourceManager)

- 主要负责管理任务管理器(TaskManager)的插槽(slot),TaskManger 插槽是Flink中定义的处理资源单元。

- Flink为不同的环境和资源管理工具提供了不同资源管理器,比如YARN、Mesos、K8s,以及standalone部署。

- 当JobManager申请插槽资源时,ResourceManager会将有空闲插槽的TaskManager分配给JobManager。如果ResourceManager没有足够的插槽来满足JobManager的请求,它还可以向资源提供平台发起会话,以提供启动TaskManager进程的容器。

分发器(Dispatcher)

- 可以跨作业运行,它为应用提交提供了REST接口。

- 当一个应用被提交执行时,分发器就会启动并将应用移交给一个JobManager。

- Dispatcher也会启动一个Web UI,用来方便地展示和监控作业执行的信息。

- Dispatcher在架构中可能并不是必需的,这取决于应用提交运行的方式。

任务提交流程

执行步骤

- Flink任务提交后,Client向HDFS上传Flink的Jar包和配置

- 向Yarn ResourceManager提交任务

- ResourceManager分配Container资源并通知对应的NodeManager启动ApplicationMaster

- ApplicationMaster启动后加载Flink的Jar包和配置构建环境

- 启动JobManager之后ApplicationMaster向ResourceManager申请资源启动TaskManager

- ResourceManager分配Container资源后,由ApplicationMaster通知资源所在节点的NodeManager启动TaskManager

- NodeManager加载Flink的Jar包和配置构建环境并启动TaskManager

- TaskManager启动后向JobManager发送心跳包,并等待JobManager向其分配任务。

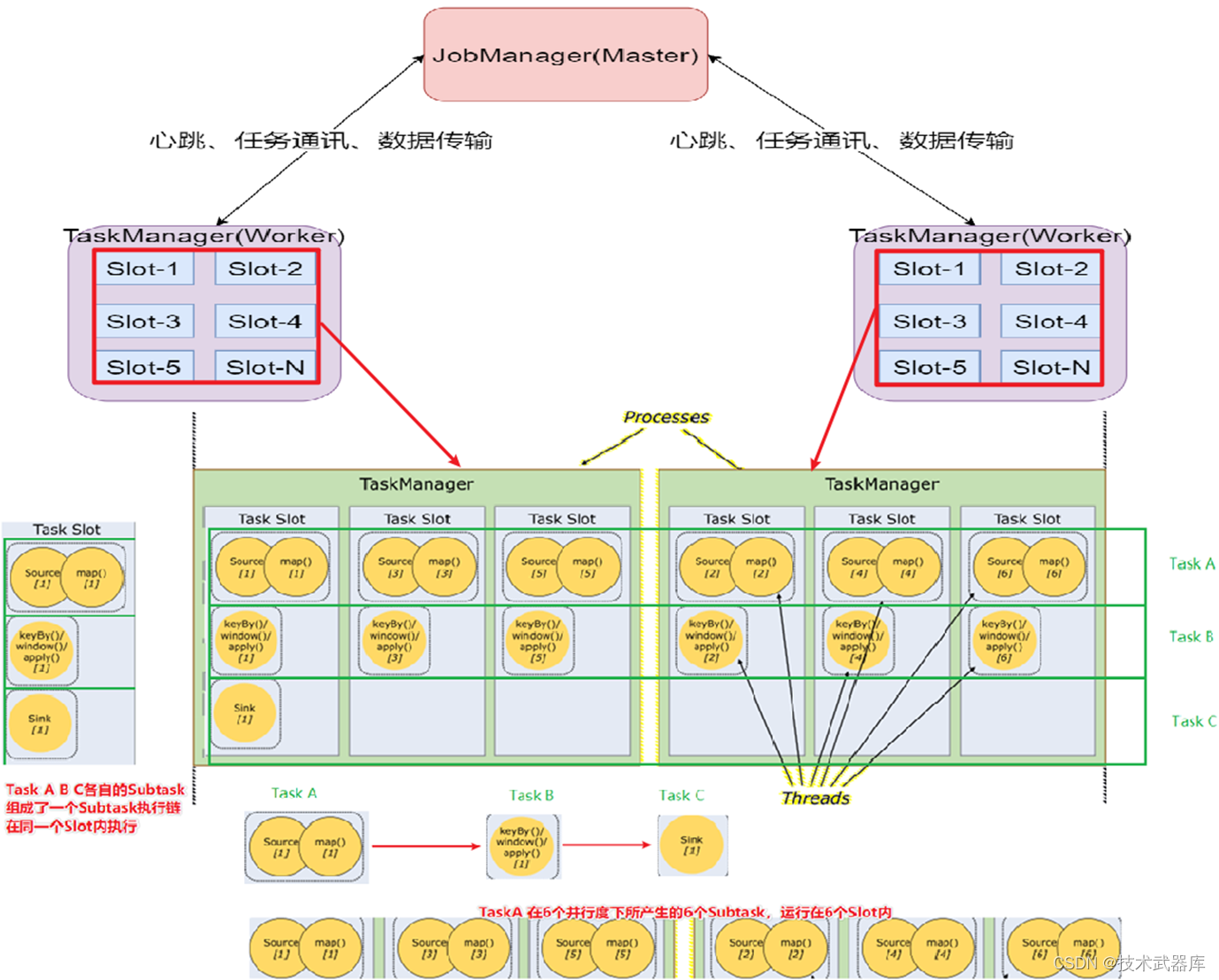

任务调度原理

客户端不是运行时和程序执行的一部分,但它用于准备并发送dataflow(JobGraph)给Master(JobManager),然后,客户端断开连接或者维持连接以等待接收计算结果。

- 当 Flink 集群启动后,首先会启动一个 JobManger 和一个或多个的TaskManager。由 Client 提交任务给 JobManager,JobManager 再调度任务到各个 TaskManager 去执行,然后 TaskManager 将心跳和统计信息汇报给 JobManager。TaskManager 之间以流的形式进行数据的传输。上述三者均为独立的 JVM 进程。

- Client 为提交 Job 的客户端,可以是运行在任何机器上(与 JobManager 环境连通即可)。提交 Job 后,Client 可以结束进程(Streaming的任务),也可以不结束并等待结果返回。

- JobManager 主要负责调度 Job 并协调 Task 做 checkpoint,从 Client 处接收到 Job 和 JAR 包等资源后,会生成优化后的执行计划,并以 Task 的单元调度到各个 TaskManager 去执行。

- TaskManager 在启动的时候就设置好了槽位数(Slot),每个 slot 能启动一个 Task,Task 为线程。从 JobManager 处接收需要部署的 Task,部署启动后,与自己的上游建立 Netty 连接,接收数据并处理。

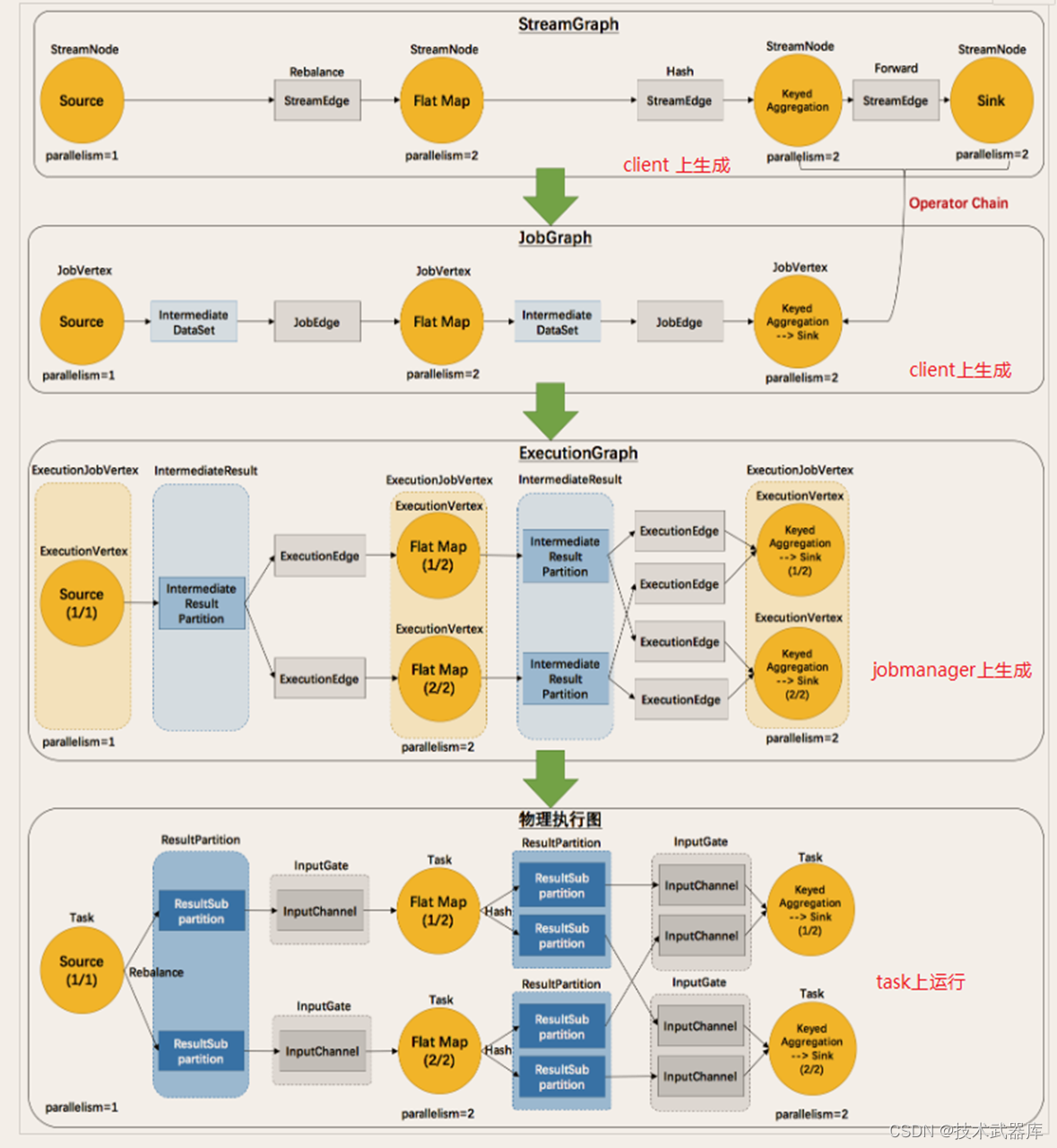

执行图(ExecutionGraph)

由Flink程序直接映射成的数据流图是StreamGraph,也被称为逻辑流图,因为它们表示的是计算逻辑的高级视图。为了执行一个流处理程序,Flink需要将逻辑流图转换为物理数据流图(也叫执行图),详细说明程序的执行方式。

Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph -> 物理执行图。

原理介绍

- Flink执行executor会自动根据程序代码生成DAG数据流图

- Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph -> 物理执行图

StreamGraph:是根据用户通过 Stream API 编写的代码生成的最初的图。表示程序的拓扑结构。

JobGraph:StreamGraph经过优化后生成了 JobGraph,提交给 JobManager 的数据结构。主要的优化为,将多个符合条件的节点 chain 在一起作为一个节点,这样可以减少数据在节点之间流动所需要的序列化/反序列化/传输消耗。

ExecutionGraph:JobManager 根据 JobGraph 生成ExecutionGraph。ExecutionGraph是JobGraph的并行化版本,是调度层最核心的数据结构。

物理执行图:JobManager 根据 ExecutionGraph 对 Job 进行调度后,在各个TaskManager 上部署 Task 后形成的“图”,并不是一个具体的数据结构。

可以简单理解为:

- StreamGraph:最初的程序执行逻辑流程,也就是算子之间的前后顺序(全部都是task)

- JobGraph:将部分可以合并的合并成一个Task, 目的是减少DAG的节点,让程序尽量简洁

- ExecutionGraph:为Task赋予并行度,也就是将TASK级别的DAG,拉宽为Subtask级别的DAG

- 物理执行图:确定具体的Subtask在哪个机器的哪个Slot上运行,以及通过图确定slot之间的通讯的流程

程序与数据流

所有的Flink程序都是由三部分组成的:

- Source

- Transformation

- Sink

Source负责读取数据源,Transformation利用各种算子进行处理加工,Sink负责输出。需要注意的是,Flink的DataSet API所使用的DataSets其内部也是stream。

- 在运行时,Flink上运行的程序会被映射成streaming dataflows,它包含了streams和transformations operators。

- 每一个dataflow以一个或多个sources开始以一个或多个sinks结束。

- dataflow类似于任意的有向无环图(DAG),当然特定形式的环可以通过iteration构建。

- 在大部分情况下,程序中的transformations跟dataflow中的operator是一一对应的关系,但有时候,一个transformation可能对应多个operator。

并行数据流

Flink程序的执行具有并行、分布式的特性。在执行过程中,一个 stream 包含一个或多个 stream partition ,而每一个 operator 包含一个或多个operator subtask,这些operator subtasks在不同的线程、不同的物理机或不同的容器中彼此互不依赖得执行。

一个特定operator的subtask的个数被称之为其parallelism(并行度)。一stream的并行度总是等同于其producing operator的并行度。一个程序中,不同的operator可能具有不同的并行度。

应用程序中,不同的算子可能有不同的并行度

Stream在operator之间传输数据的形式可以是one-to-one(forwarding)的模式也可以是redistributing的模式,具体是哪一种形式,取决于算子的种类。

- One-to-one:stream(比如在source和map operator之间)维护着分区以及元素的顺序。那意味着map operator的subtask看到的元素的个数以及顺序跟source operator的subtask生产的元素的个数、顺序相同,map、fliter、flatMap等算子都是one-to-one的对应关系。

- Redistributing:stream(map()跟keyBy/window之间或者keyBy/window跟sink之间)的分区会发生改变。每一个operator subtask依据所选择的transformation发送数据到不同的目标subtask。例如,keyBy() 基于hashCode重分区、broadcast和rebalance会随机重新分区,这些算子都会引起redistribute过程,而redistribute过程就类似于Spark中的shuffle过程。

任务链(operator chains)

出于分布式执行的目的,Flink将operator的subtask链接在一起形成task,每个task在一个线程中执行。将operators链接成task是非常有效的优化:它能减少线程之间的切换和基于缓存区的数据交换,在减少时延的同时提升吞吐量。链接的行为可以在编程API中进行指定。

下面这幅图,展示了5个subtask以5个并行的线程来执行:

- Flink 采用了一种称为任务链的优化技术,可以在特定条件下减少本地通信的开销。为了满足任务链的要求,必须将两个或多个算子设为相同的并行度,并通过本地转发(local forward)的方式进行连接

- 相同并行度的 one-to-one 操作,Flink 这样相连的算子链接在一起形成一个 task,原来的算子成为里面的 subtask

- 并行度相同、并且是 one-to-one 操作,两个条件缺一不可

槽共享(Slot Sharing,执行链)

默认情况下,Flink 允许subtasks共享slot,条件是它们都来自同一个Job的不同task的subtask。

结果可能一个slot持有该job的整个pipeline。

- Flink集群需要的任务槽与作业中使用的最高并行度正好相同

- 更容易获得更充分的资源利用

- 有了任务槽共享,可以提高分槽资源的利用率。槽共享可以获得如下好处:

经验上讲Slot的数量与CPU-core的数量一致为好。但考虑到超线程,可以让slotNumber=2*cpuCore

Flink 概念小结

1392

1392

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?