这一篇主要是CART,有几个重点的词语先写下来,重点哦:基尼指数(Gini index)、最小二乘回归树(least squares regression tree)

CART:classification and regression tree。分类回归树。

简单的说呢,CART就是个二叉树(广义的决策树并不一定就是二叉树,可能好几叉。。。哈哈),所以内部节点的取值就是“是”“否”的了。

直接介绍算法吧,CART的基本原理和广义的决策树是一样的,就相当于二叉树都有普通树的特征。

下面直接介绍回归树的算法:

1. 回归树的生成:基于训练数据集生成决策树,尽量大点。

2. 回归树剪枝:用验证数据集对已生成的树进行剪枝并选择最优子树,这时用损失函数最小作为剪枝的标准。

完了,,,很简单的。哈哈

下面介绍一下详细的算法,重点还是大多参考了统计学习方法的:

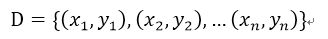

简单介绍一下理论:给定数据集

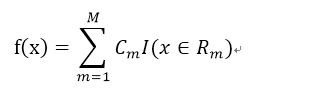

假设已经将输入空间划分为M个单元R_1、R_2、…R_M,并且每个单元都有一个固定的输出值C_m,则回归树的模型为:

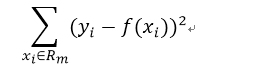

训练数据集的预测误差为:平方误差

平方误差是用来球每个单元上的最优输出值

本文介绍了CART(Classification and Regression Tree)算法,包括基尼指数、最小二乘回归树的概念。CART是一种二叉决策树,用于分类和回归任务。生成算法主要涉及最小化基尼指数或平方误差,而剪枝则通过验证数据集进行,以减少过拟合。

本文介绍了CART(Classification and Regression Tree)算法,包括基尼指数、最小二乘回归树的概念。CART是一种二叉决策树,用于分类和回归任务。生成算法主要涉及最小化基尼指数或平方误差,而剪枝则通过验证数据集进行,以减少过拟合。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?