监控一个文件实时采集新增的数据输出到控制台

Agent选型: exec source +memory channel + logger sink

文章目录

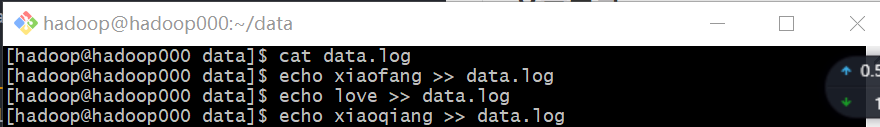

(1)在/home/hadoop/data目录下新建data.log文件

(2)到$FLUME_HOME/conf目录下创建配置文件exec-memory-logger.conf

# example.conf: A single-node Flume configuration

# Name the components on this agent

# 解析:a1代表agent的名称,r1代表source的名称,k1代表sink的名称,c1代表channel的名称

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

# 详见官网 Exec Source配置说明

a1.sources.r1.type = exec

a1.sources.r1.command = tail -F /home/hadoop/data/data.log

a1.sources.r1.shell = /bin/sh -c

# Describe the sink

# 详见官网 logger sink配置说明

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

# 详见官网 memory channel

a1.channels.c1.type = memory

#a1.channels.c1.capacity = 1000

#a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

# source-channel-sink 一个source可以输出到多个channel,一个channel只能输出到一个sink

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

(3)启动agent

flume-ng agent \

--name a1 \

--conf $FLUME_HOME/conf \

--conf-file $FLUME_HOME/conf/exec-memory-logger.conf \

-Dflume.root.logger=INFO,console

(4)通过往监控文件追加数据进行测试

1194

1194

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?