近日,由阿里、复旦大学、南京大学联合发布的可控人体视频生成工作 Champ 火爆全网。该模型仅开源 5 天 GitHub 即收获 1k 星,在 Twitter 更是「火出圈」,吸引了大量博主二创,浏览量总量达到 300K。

目前 Champ 已经开源推理代码与权重,用户可以直接从 Github 上下载使用。官方 Hugging Face 的 Demo 已经上线,封装的 Champ-ComfyUI 也正在同步推进中。GitHub 主页显示团队将会在近期开源训练代码及数据集,感兴趣的小伙伴可以持续关注项目动态。

- 项目主页:https://fudan-generative-vision.github.io/champ/

- 论文链接:https://arxiv.org/abs/2403.14781

- Github 链接:https://github.com/fudan-generative-vision/champ

- Hugging Face 链接:https://huggingface.co/fudan-generative-ai/champ

先来看下 Champ 在真实世界人像上的视频效果,以下图左上角的动作视频为输入,Champ 能让不同的人像「复制」相同的动作:

虽然 Champ 仅用真实的人体视频训练,但它在不同类型的图像上展现了强大的泛化能力:

黑白照片,油画,水彩画等效果拔群,在不同文生图模型生成的真实感图像,虚拟人物也不在话下:

技术概览

Champ 利用先进的人体网格恢复模型,从输入的人体视频中提取出对应的参数化三维人体网格模型 SMPL 序列(Skinned Multi-Person Linear Model),进一步从中渲染出对应的深度图,法线图,人体姿态与人体语义图,作为对应的运动控制条件去指导视频生成,将动作迁移到输入的参考人像上,能够显著地提升人体运动视频的质量,以及几何和外观一致性。

针对不同的运动条件,Champ 采用了一个多层运动融合模块(MLMF),利用自注意力机制充分融合不同条件之间的特性,实现更为精细化的运动控制。下图中展示了该模块不同条件的注意力可视化结果:深度图关注人物形态的几何轮廓信息,法线图指示了人体的朝向,语义图控制人体不同的部分的外观对应关系,而人体姿态骨架则仅关注于人脸与手部的关键点细节。

另一方面,Champ 发现并解决了人体视频生成中一直被忽略的体型迁移的问题。此前的工作或是基于人体骨骼模型,或是基于输入的视频得到的其他几何信息来驱动人像的运动,但这些方法都无法将运动与人体体型解耦,导致生成的结果无法与参考图像的人体体型匹配。

例如,给定一个大胖作为参考图像得到的如下图 7 所示的对比结果:

可以看到,Animate Anyone 与 MagicAnimate 的生成结果中,大胖的大肚子被抹平,甚至骨架也有一些缩水。而 Champ 利用 SMPL 中体型参数,来将其与驱动视频的 SMPL 序列进行参数化的体型对齐,从而在体型,动作上都取得了最佳的一致性(图中 with PST)。

实验结果

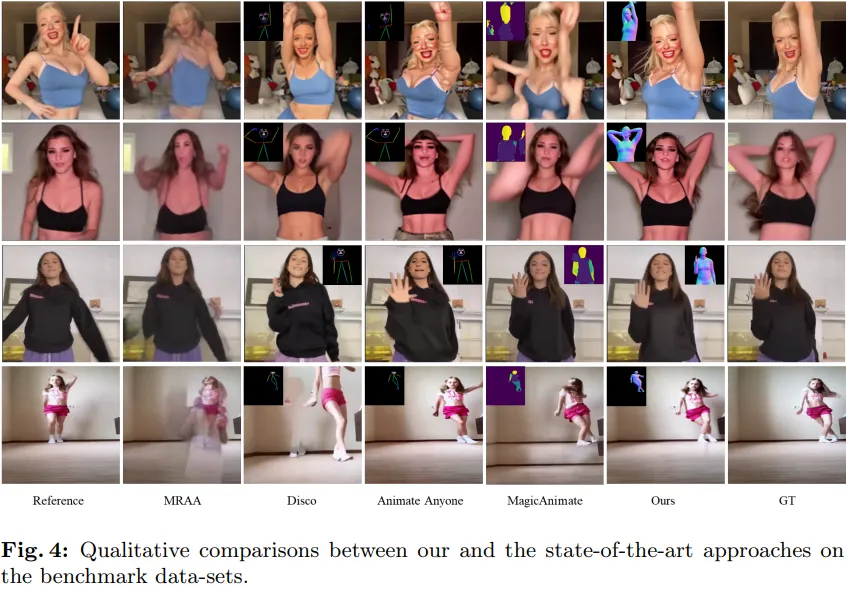

如下表 4 所示,与其他的 SOTA 工作相比,Champ 具有更好的运动控制以及更少的伪影:

同时,Champ 还展现了其优越的泛化性能与外观匹配上的稳定性:

在 TikTok Dance 数据集,Champ 评估了图像生成与视频生成的量化效果,它在多个评估指标上均有较大的提升,如下表 1 所示。

阿里、复旦大学和南京大学联合发布的Champ人体视频生成模型因其开源和出色的效果在社交媒体上走红。模型提供强大的泛化能力和精细的运动控制,通过SMPL和MLMF技术解决体型迁移问题,实验结果显示优于现有SOTA技术。

阿里、复旦大学和南京大学联合发布的Champ人体视频生成模型因其开源和出色的效果在社交媒体上走红。模型提供强大的泛化能力和精细的运动控制,通过SMPL和MLMF技术解决体型迁移问题,实验结果显示优于现有SOTA技术。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?