CVPR 2024 | 绝!diffusion 扩散模型100+篇论文、40+方向

在最新的视觉顶会 ECCV 2024 会议中,涌现出大量基于生成式AIGC的CV论文,尤其是扩散模型diffusion为代表!

除直接生成,还广泛应用在其它各类 low-level、high-level 视觉任务!本文集齐和梳理ECCV 2024里共30+方向的AIGC+扩散模型论文!下述论文均已分类打包好!

关注公众号【机器学习与AI生成创作】公众号,在后台回复 ECCV2024 (长按红字、选中复制)获取分类、按文件夹汇总好的论文集!!!

文章很长,梳理不易,越到后面的方向越有趣!麻烦各位看官,转发、分享、在看三连,多多鼓励小编!!!

本文系本公众号首发原创

目录

一、扩散模型改进

二、数据增广

三、数据挖局

四、数据蒸馏

五、图像增强与恢复

六、布局生成

七、动作预测

八、深度估计

九、自动驾驶

十、可解释性

十一、对抗攻击

十二、增量学习持续学习

十三、虚拟试衣

十四、虚拟试鞋

十五、分布外检测

十六、强化学习

十七、deepfake

十八、医学图像

十九、超分

二十、去模糊

二十一、人像生成

二十二、视频生成

二十三、视图生成

二十四、图像编辑

二十五、图像分割

二十六、图像组合

二十七、异常检测

二十八、字体生成

二十九、3D

三十、风格迁移

三十一、图像插值

一、扩散模型改进

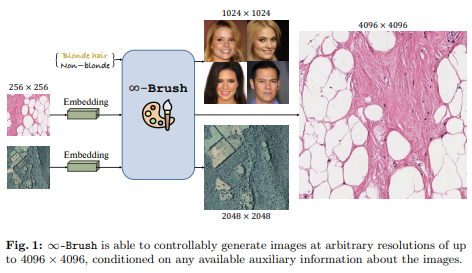

1、∞-Brush : Controllable Large Image Synthesis with Diffusion Models in Infinite Dimensions

从错综复杂的领域特定信息中合成高分辨率图像仍是生成建模中的一个重大挑战,尤其适用于大图像域(如数字组织病理学和遥感)中的应用。现有方法面临着关键限制:像素空间或潜在空间中的条件扩散模型在超出它们训练的分辨率时就会失去保真度,并且对于更大的图像尺寸,计算需求会显著增加。

基于patch方法提供了计算效率,但由于过度依赖局部信息,无法捕捉长距离空间关系。本文引入一种新无限维条件扩散模型,∞-Brush,用于可控大图像合成。提出交叉注意力神经操作器,以实现函数空间中的条件化。模型克服了传统有限维扩散模型和基于patch方法的约束,提供可扩展性和在保持全局图像结构的前提下保持细节的卓越能力。∞-Brush 可控合成高达 4096 × 4096 像素分辨率图像的条件扩散模型。https://github.com/cvlab-stonybrook/infinity-brush

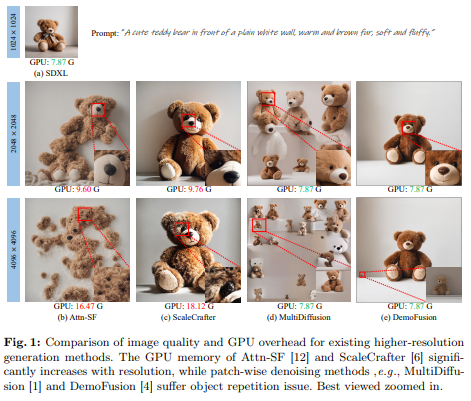

2、AccDiffusion: An Accurate Method for Higher-Resolution Image Generation

本文试图解决基于patch更高分辨率图像生成中的对象重复(object repetition)问题。提出AccDiffusion,无需训练,深入分析揭示了重复的对象生成,而没有提示会损害图像的细节。因此,AccDiffusion首次提出将图像内容感知提示解耦为一组分区内容感知提示,每个提示作为对图像分区的更准确描述。

AccDiffusion还引入了带窗口交互的dilated sampling,以更好提高更高分辨率图像生成中的全局一致性。与现有方法的实验比较表明,AccDiffusion有效解决了重复对象生成的问题,并在更高分辨率图像生成方面表现更好。

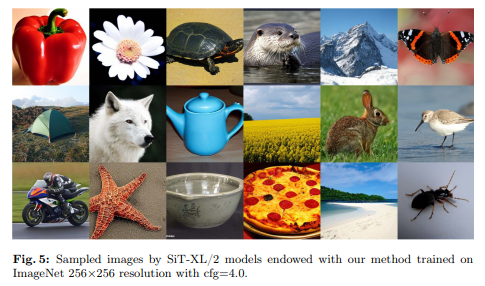

3、Efficient Diffusion Transformer with Step-wise Dynamic Attention Mediators

本文指出扩散Transformer模型的自注意机制中存在与查询-键交互的显著冗余,特别是在去噪扩散步骤的早期阶段。针对这一观察结果,提出一个新的扩散Transformer框架,包括一个额外的中介token集,用于分开处理查询和键。通过在去噪生成阶段调节中介token的数量,模型通过准确、明确的阶段开始去噪过程,并逐渐过渡到丰富细节的阶段。同时,整合中介token简化了注意模块的复杂度至线性尺度,增强了全局注意过程的效率。

此外,提出一个时间步动态中介token调整机制,进一步减少了生成所需的计算 FLOPs,同时促进了在各种推断预算的约束下生成高质量图像。实验证明,方法改善生成图像的质量,同时降低推断成本。与最近的 SiT 工作集成后,方法实现了 2.01 的最先进 FID 分数。等待开源在:https://github.com/LeapLabTHU/Attention-Mediators

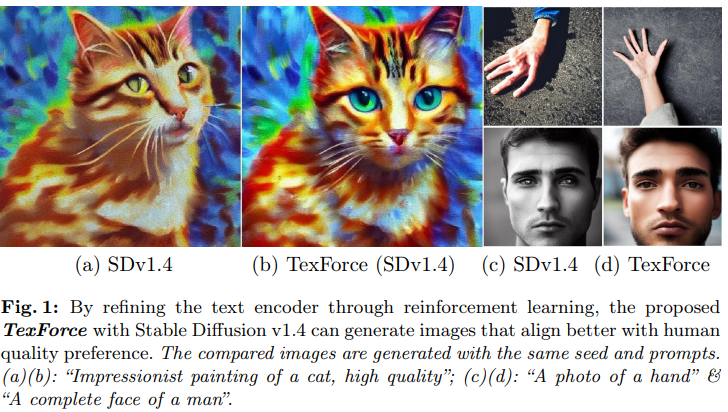

4、Enhancing Diffusion Models with Text-Encoder Reinforcement Learning

文生图扩散模型通常被训练以优化对数似然目标,这在满足下游任务的特定要求,如图像美学和图像-文本对齐方面存在挑战。最近的研究通过强化学习或直接反向传播优化扩散 U-Net,利用人类奖励来解决这一问题。然而,许多研究忽视了文本编码器的重要性,该编码器通常在训练期间是预训练的且固定的。

本文证明通过强化学习微调文本编码器,可增强结果的文本-图像对齐,从而提高视觉质量。主要动机来自于观察到当前文本编码器并不是最佳的,通常需要仔细的提示调整。虽然微调 U-Net 可以部分改善性能,但仍受制于次优的文本编码器。因此,提出用低秩调整的强化学习来微调文本编码器,基于任务特定的奖励进行微调,称为 TexForce。首先展示微调文本编码器可以提高扩散模型的性能。然后,说明 TexForce 可简单地与现有微调模型结合,以获得更好的结果,无需额外训练。最后,展示了方法在各种应用中的适应性,包括生成高质量的人脸和手部图像。https://github.com/chaofengc/TexForce

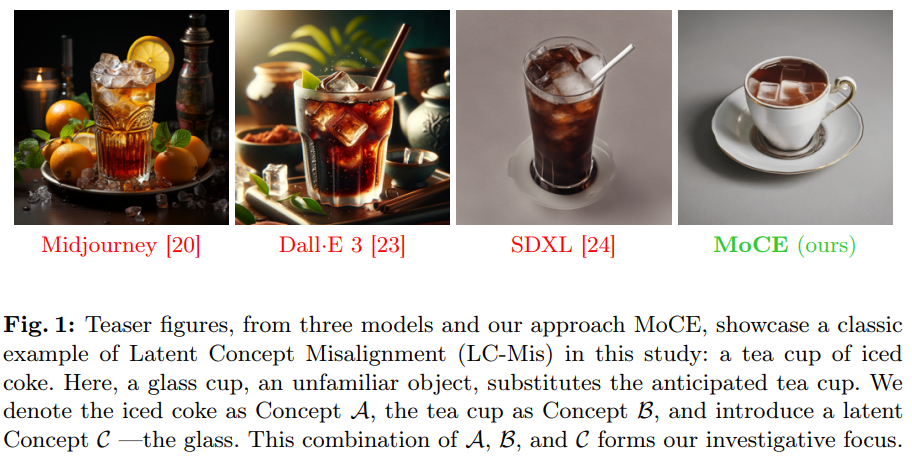

5、Lost in Translation: Latent Concept Misalignment in Text-to-Image Diffusion Models

文生图扩散模型拓展了下游实际应用,但这些模型常在文本和图像之间遇到对齐问题。以生成两个解耦概念的组合为例,比如给定提示“一杯冰可乐”,现有模型通常会生成一个玻璃杯中的冰可乐,因为冰可乐通常在模型训练中与玻璃杯共现,而不是茶杯。这种对齐问题的根源在于文本到图像扩散模型在潜在语义空间中存在混淆,因此将“一杯冰可乐”现象称为潜在概念对齐失误(LC-Mis)。

利用大型语言模型(LLMs)彻底调查 LC-Mis 的范围,并开发一个自动化流程,用于将扩散模型的潜在语义与文本提示对齐。实证评估证实方法有效性,显著减少 LC-Mis 错误,增强了文本到图像扩散模型的韧性和通用性。https://github.com/RossoneriZhao/iced_coke

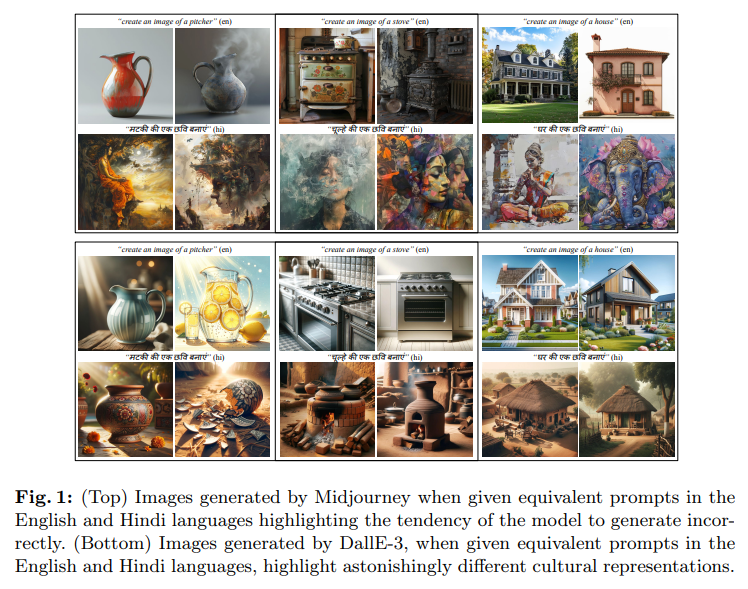

6、Navigating Text-to-Image Generative Bias across Indic Languages

本研究调查了针对印度广泛使用的印地语言的文生图(TTI)模型中的偏见。它评估并比较了这些语言中领先的 TTI 模型在生成性能和文化相关性方面与其在英语中的表现。利用提出的 IndicTTI 基准测试,全面评估了30种印地语言的两个开源扩散模型和两个商业生成 API 的性能。

该基准测试的主要目标是评估这些模型在这些语言中支持的程度,并确定需要改进的领域。鉴于印度使用的30种语言被14亿人口说着,该基准测试旨在提供对 TTI 模型在印地语言环境中效果的详细而独到的分析。IndicTTI 基准测试的数据和代码:https://iab-rubric.org/resources/other-databases/indictti

7、Post-training Quantization with Progressive Calibration and Activation Relaxing for Text-to-Image Diffusion Models

高计算负担是扩散模型面临的一个棘手问题。最近研究利用后训练量化(PTQ)来压缩扩散模型。然而,大多数研究仅集中在无条件模型上,未探索广泛使用的预训练文本到图像模型,如 Stable Diffusion 的量化。

本文提出一种扩散模型后训练量化方法 PCR(Progressive Calibration and Relaxing),该方法包括一个考虑跨时间步积累的量化误差的渐进校准策略,以及一个通过激活放松策略来提高性能而成本微乎其微的传动。此外,证明先前用于文本到图像扩散模型量化的指标并不准确,因为存在分布差异。为解决这个问题,提出一个新的 QDiffBench 基准测试,该基准测试利用相同领域的数据进行更准确的评估。

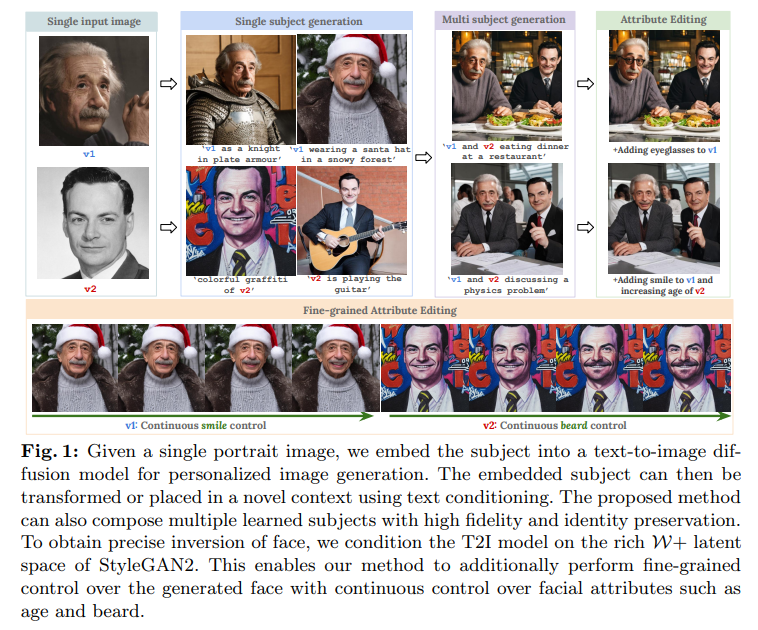

8、PreciseControl: Enhancing Text-To-Image Diffusion Models with Fine-Grained Attribute Control

文生图(T2I)扩散模型个性化方法的激增,用少量图像学习概念。现有方法在面部个性化领域受到困扰,很难实现带有身份保留的令人信服的逆映射生成,并依赖于生成的面部的基于语义文本的编辑。然而,对于面部属性编辑,更精细的控制是需要的,仅仅通过文本提示是具有挑战性的。

StyleGAN 模型学习了丰富的面部先验,并通过潜在操纵实现了朝着精细特征编辑的平滑控制。本文使用 StyleGAN 的 W+ 空间来对 T2I 模型进行条件设置。这种方法精确操纵面部属性,例如平滑地引入微笑,同时保留 T2I 模型中固有的基于文本的粗略控制。为使 T2I 模型在 W+ 空间上具有条件设置,训练了一个潜在映射器,将 W+ 空间的潜在代码转换为 T2I 模型的token嵌入空间。

方法在面部图像的inversion和属性保留方面表现出色,并有助于实现对精细特征编辑的持续控制。此外,方法可以方便地扩展到生成涉及多个个体的组合。大量实验证明方法对于面部个性化和精细特征编辑的验证。https://rishubhpar.github.io/PreciseControl.home/

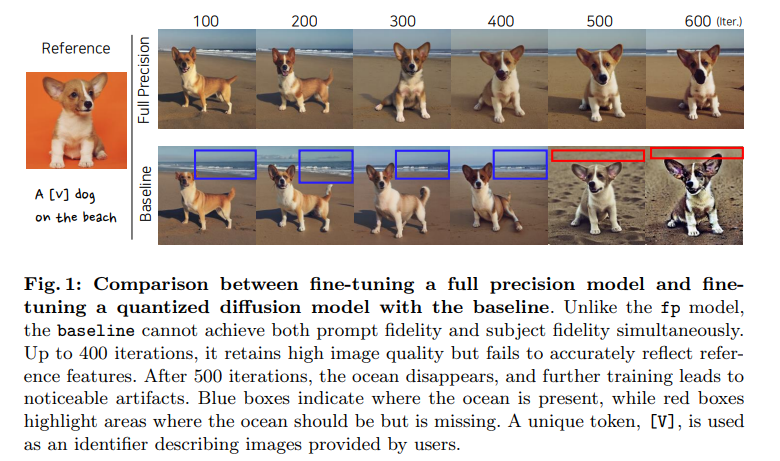

9、Memory-Efficient Fine-Tuning for Quantized Diffusion Model

十亿参数扩散模型,如Stable Diffusion XL,Imagen和DALL-E 3,推动生成式人工智能领域。然而,大规模架构在微调和部署中存在挑战,因为资源需求高,推断速度慢。本文探讨相对未被探索但极具潜力的量化扩散模型微调领域。

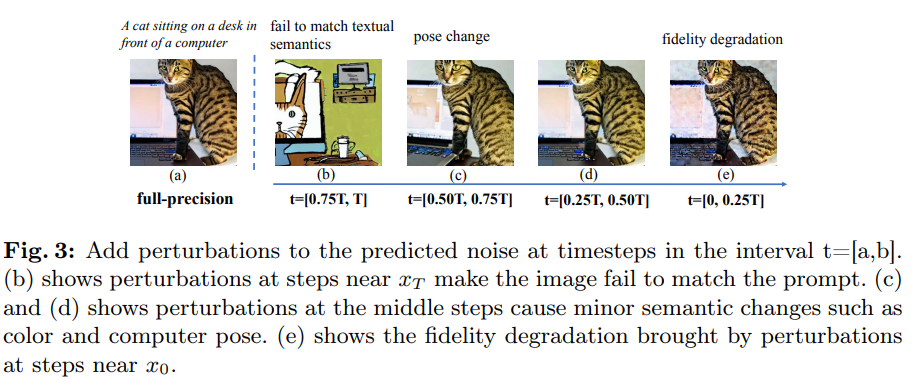

分析显示,基线忽略了模型权重中的不同模式以及在微调扩散模型时各个时间步骤的不同角色。为解决这些限制,引入一种专门为量化扩散模型设计的新型内存高效微调方法,称为TuneQDM。方法引入量化比例作为可分离函数,以考虑通道间的权重模式。然后,它以时间步特定的方式优化这些比例,以有效反映每个时间步骤的作用。TuneQDM在与其全精度对应物相媲美的性能同时,还提供显著的内存效率。

实验结果表明,方法在单个/多个主体生成方面始终优于基线,表现出高主体忠实度和与全精度模型相媲prompt忠实度。

10、Reliable and Efficient Concept Erasure of Text-to-Image Diffusion Models

文生图模型面临安全问题,包括与版权和NSFW(不安全内容)相关的担忧。尽管已提出几种方法来从扩散模型中消除不合适的概念,但它们往往表现出不完全消除、消耗大量计算资源,并无意中损害了生成能力。

这项工作介绍一种名为可靠高效概念消除(RECE)的新方法,可在3秒内修改模型而无需额外微调。具体而言,RECE高效利用闭合形式解来推导出新的目标嵌入,能够在未学习的模型中重新生成已消除的概念。为了缓解由推导出的嵌入表示可能具有的不当内容,RECE进一步将它们与交叉注意力层中的无害概念对齐。为了保留模型的生成能力,RECE在推导过程中引入了额外的正则化项,从而最小化了消除过程中对不相关概念的影响。

保证仅需3秒极其高效的消除。与之前的方法进行基准测试,方法实现更高效和彻底的消除。https://github.com/CharlesGong12/RECE

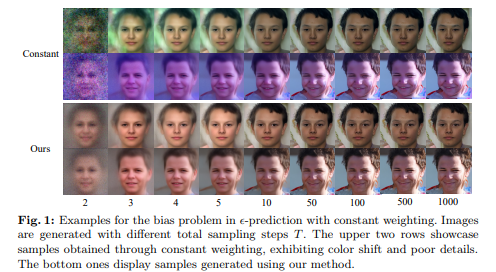

11、Unmasking Bias in Diffusion Model Training

去噪扩散模型已成为图像生成的主要方法,然而它们在训练中收敛速度缓慢,采样中存在颜色偏移问题。这项工作发现这些障碍主要归因于扩散模型默认训练范式中固有的偏差和次优性。具体而言,提供理论见解,即扩散模型Ɛ-预测中普遍存在的恒定损失权重策略导致训练阶段估计偏见,阻碍了对原始图像的准确估计。

为解决这个问题,提出一个简单有效的加权策略,从解锁的偏置部分中推导而来。此外,进行了全面系统的探究,揭示了偏差问题在存在、影响和潜在原因方面的内在原因。这些分析有助于推动对扩散模型的理解。实证结果表明,方法显著提高样本质量,并且在训练和采样过程中提高了效率,仅通过调整损失加权策略。https://github.com/yuhuUSTC/Debias

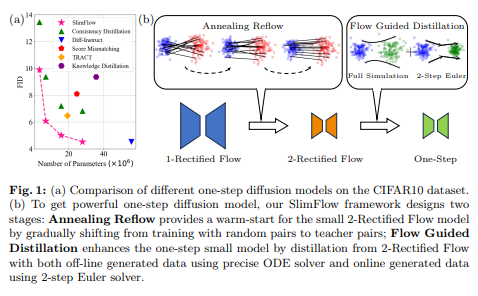

12、SlimFlow: Training Smaller One-Step Diffusion Models with Rectified Flow

扩散模型在生成高质量方面表现出色,但由于迭代采样而导致推断速度缓慢。尽管最近的方法已成功将扩散模型转化为一步生成器,但它们忽略了模型尺寸的缩减,限制了在计算受限场景中的适用性。

本文旨在基于强大的矫正流框架,通过探索推断步骤和模型尺寸的联合压缩,开发小而高效的一步扩散模型。矫正流框架使用回流和蒸馏两种操作来训练一步生成模型。与原始框架相比,缩小模型尺寸带来了两个新挑战:(1)在回流过程中大型教师和小型学生之间的初始化不匹配;(2)小型学生模型上天真蒸馏的表现不佳。为克服这些问题,提出渐变回流和流引导蒸馏,二者共同构成我们的SlimFlow框架。

新框架训练了一个具有FID为5.02和15.7M参数的一步扩散模型,在CIFAR10上胜过了以前的最先进一步扩散模型(FID=6.47,19.4M参数)。在ImageNet 64×64和FFHQ 64×64上,方法得到了小型一步扩散模型,与较大模型相媲美,展示方法在创建紧凑、高效的一步扩散模型方面的有效性。

13、Optimizing Resource Consumption in Diffusion Models through Hallucination Early Detection

扩散模型在生成AI方面取得显著进展,但在生成多个对象的复杂组合时遇到困难。由于最终结果严重依赖于初始种子,在确保所需输出准确性方面可能需要生成过程的多次迭代。这种重复不仅会导致时间浪费,还会增加能源消耗,反映出在复杂生成任务中效率和准确性的挑战。

为解决这个问题,引入 HEaD(幻觉早期检测),一种旨在在扩散过程开始时迅速检测不正确生成的新范例。HEaD流水线结合了交叉注意力图和预测的最终图像这一新指标,通过利用生成过程早期阶段可用信息来预测最终结果。

证明用HEaD可以节省计算资源并加速生成过程以获取完整图像,即所有请求的物体都准确呈现在图像中。研究结果显示,HEaD可在双物体情景下节约高达12%的生成时间,并强调生成模型中早期检测机制的重要性。

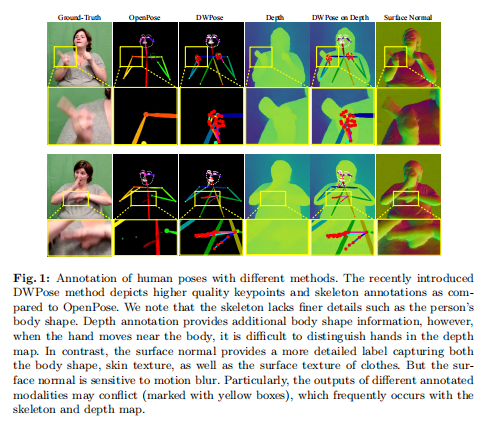

14、Adaptive Multi-Modal Control of Digital Human Hand Synthesis Using a Region-Aware Cycle Loss

扩散模型已证明了其合成图像的能力,包括在特定姿势中生成人物。然而,当前模型在为详细的手部姿势生成提供条件控制方面面临挑战,导致手部区域的显著失真。为解决这个问题,首先整理了How2Sign数据集,提供更丰富和准确的手部姿势标注。此外,引入自适应多模态融合,以整合在骨架、深度和表面法线等不同模态中表达的字符物理特征。

提出了一种新的区域感知循环损失(RACL),使扩散模型训练着重于改进手部区域,从而提高生成手势的质量。具体而言,RACL计算生成图像中全身姿势关键点与真值之间的加权关键点距离,以在平衡整体姿势准确性的同时生成更高质量的手部姿势。此外用两个手部区域度量标准,分别为手部PSNR和手部距离,用于手部姿势生成评估。实验展示方法在利用扩散模型改善数字人体姿势生成质量方面的有效性,尤其是手部区域的质量。https://github.com/fuqifan/Region-Aware-Cycle-Loss

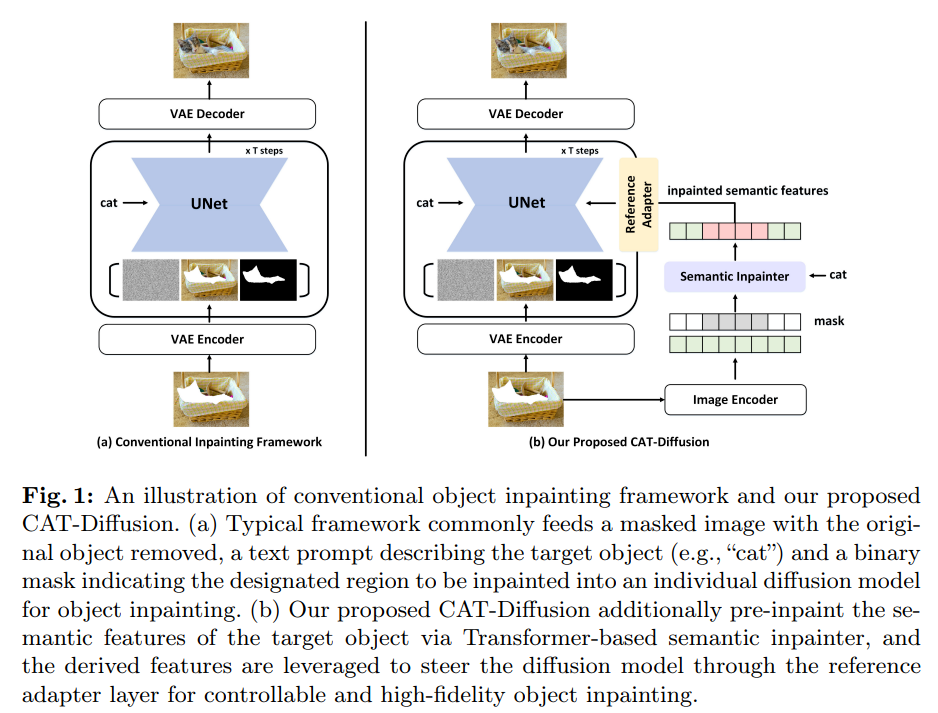

15、Improving Text-guided Object Inpainting with Semantic Pre-inpainting

图像可编辑性引发了对下游任务的极大兴趣,即在图像中指定区域内通过文本提示绘制一个新对象。然而,从两个方面来看,问题并不简单:1)仅仅依靠一个单一的U-Net在所有去噪时间步上对齐文本提示和视觉对象不足以生成期望的对象;2)在扩散模型复杂的采样空间中,不能保证目标生成的可控性。

本文提出将对象绘制分解为两个级联过程:1)语义预绘制 semantic pre-inpainting,在多模态特征空间中推断目标的语义特征;2)在扩散潜在空间中生成high-fieldity目标,该空间以这些嵌入的语义特征为中心。为实现这一点,级联了一个基于transformer的语义inpainter和一个对象绘制扩散模型,构成一个新的级联Transformer-Diffusion (CAT-Diffusion)框架。

从技术上讲,训练语义inpainter来预测目标对象在未屏蔽上下文和文本提示条件下的语义特征。然后,语义inpainter的输出作为信息性视觉提示,通过参考适配器层指导对象生成,从而实现可控制的对象inpainter。

对OpenImages-V6和MSCOCO的广泛评估验证了CAT-Diffusion相对于最先进方法的优越性。https://github.com/Nnn-s/CATdiffusion

16、Towards Reliable Advertising Image Generation Using Human Feedback

在电子商务领域,引人注目的广告形象是吸引顾客注意力的关键。生成模型自动生成图像,但经常生成不合格的图像,可能会误导客户,并且需要大量的劳动力成本来检查。

本文探讨如何提高可用生成图像。首先引入一个多模态可靠反馈网络(RFNet)来自动检查生成的图像。将RFNet结合到一个循环过程中,即循环生成,会产生更多可用的广告图像。为进一步提高生产效率,利用来自RFNet (RFFT)的反馈,利用创新的一致条件正则化对扩散模型进行微调。这显著增加可用率,减少了循环生成中的尝试次数,并在不牺牲视觉吸引力的情况下提供了高效的生产过程。

还构建一个100万(RF1M)数据集,包含100多万张人工标注的生成广告图像,这有助于训练RFNet准确评估生成图像的可用性并忠实地反映人类的反馈。总的来说,方法为广告形象生成提供了可靠的解决方案。https://github.com/ZhenbangDu/Reliable_AD

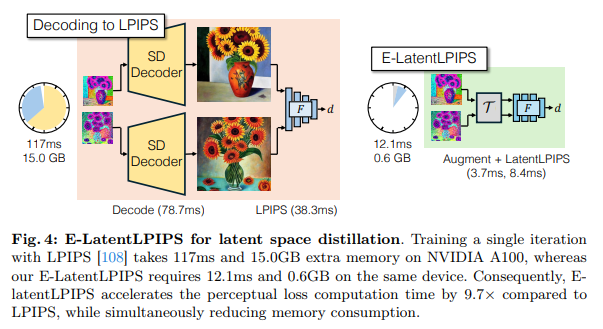

17、Distilling Diffusion Models into Conditional GANs

提出一种方法,将复杂的multistep扩散模型蒸馏为single-step条件GAN学生模型,可显著加速推理,同时保持图像质量。方法将扩散蒸馏解释为一项成对的图像到图像转换任务,使用扩散模型 ODE 轨迹的噪声到图像对。

为进行高效的回归损失计算,提出E-LatentLPIPS,一种在扩散模型潜在空间中直接操作的感知损失,利用了一组增强技术。此外,适应一个扩散模型,构建一个带有文本对齐损失的多尺度鉴别器,以构建一个有效的基于条件 GAN 的公式。即使考虑到数据集构建成本,E-LatentLPIPS 的收敛速度也比许多现有的蒸馏方法更高。展示一步生成器在零样本 COCO 基准测试中优于尖端的一步扩散蒸馏模型 - DMD、SDXL-Turbo 和 SDXL-Lightning。

二、数据增广

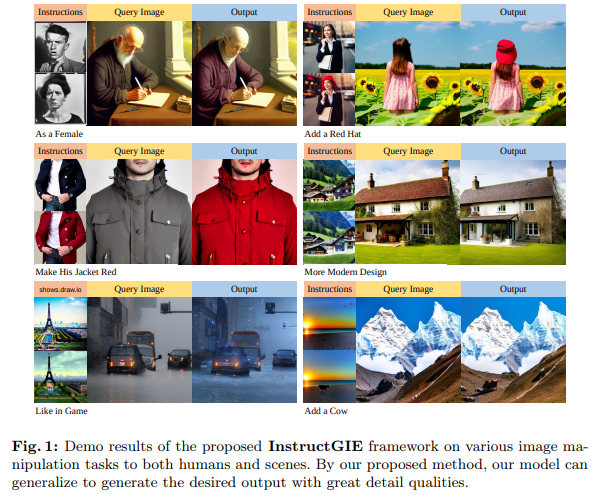

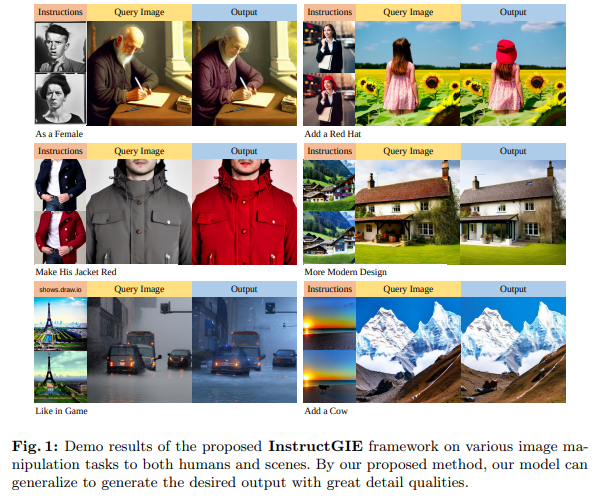

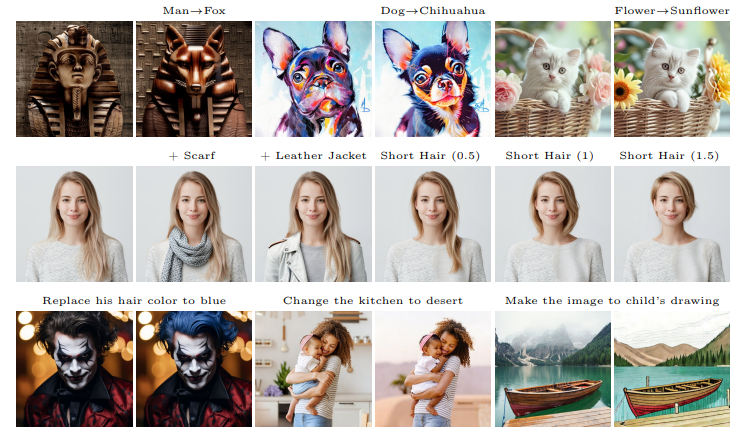

18、InstructGIE: Towards Generalizable Image Editing

最近的图像编辑方法的泛化能力仍受到限制。为应对这一挑战,引入了一种新的图像编辑框架,通过增强上下文学习能力和统一语言指令来提高泛化鲁棒性。

该框架包括一个专门针对图像编辑任务进行优化的模块,利用VMamba模块和编辑位移匹配策略来增强上下文学习。此外,揭示一个特别设计用于纠正生成图像中的损坏细节(如人脸特征)的选择性区域匹配技术,以进一步提高质量。方法的另一个关键创新是整合语言统一技术,该技术将语言嵌入与编辑语义对齐,提升图像编辑的质量。

此外,编制了第一个用于带有视觉提示和编辑说明的图像编辑的数据集,可用于增强上下文能力。在此数据集上训练,方法不仅在训练任务的合成质量方面表现出色,而且通过定制提示展示了对未知视觉任务的稳健泛化能力。https://github.com/cr8br0ze/InstructGIE-Code

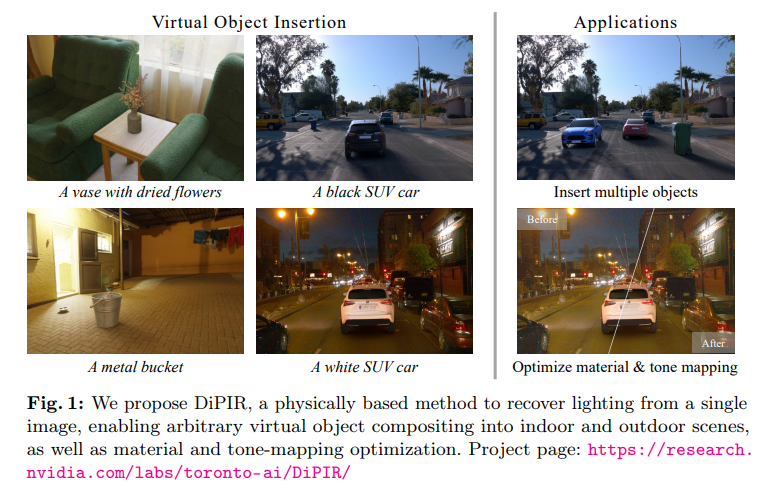

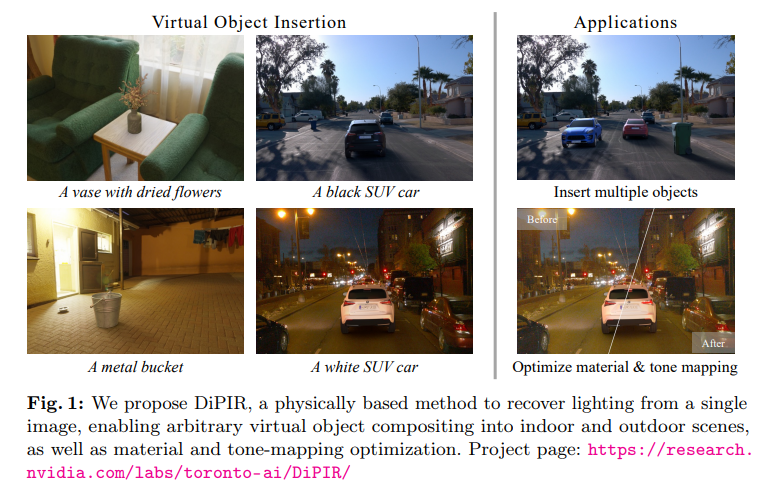

19、Photorealistic Object Insertion with Diffusion-Guided Inverse Rendering

对真实场景图像中虚拟对象的正确插入需要深入理解场景的光照、几何和材质以及图像形成过程。尽管最近的大规模扩散模型展示出强大的生成和修补能力,但当前模型不足以在单个图片中足够“理解”场景以生成一致的光照效果(阴影、明亮反射等),同时保留合成对象的身份和细节。

提出使用个性化的大规模扩散模型作为物理反渲染过程的指导。方法恢复场景光照和色调映射参数,允许在室内或室外场景的单帧或视频中逼真地组合任意虚拟对象。基于物理的流水线进一步实现了自动材质和色调映射的细化。https://research.nvidia.com/labs/toronto-ai/DiPIR/

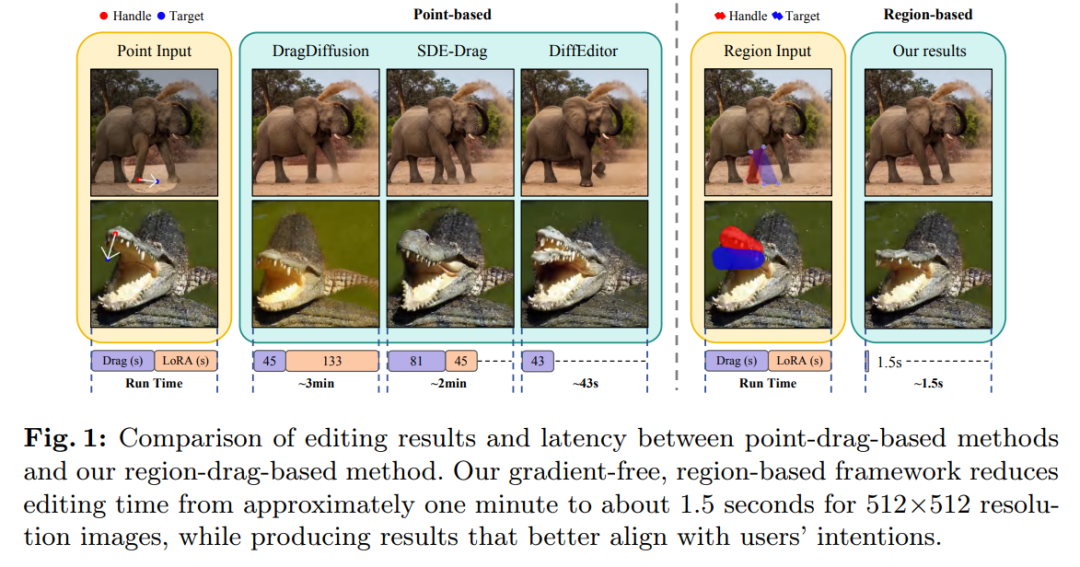

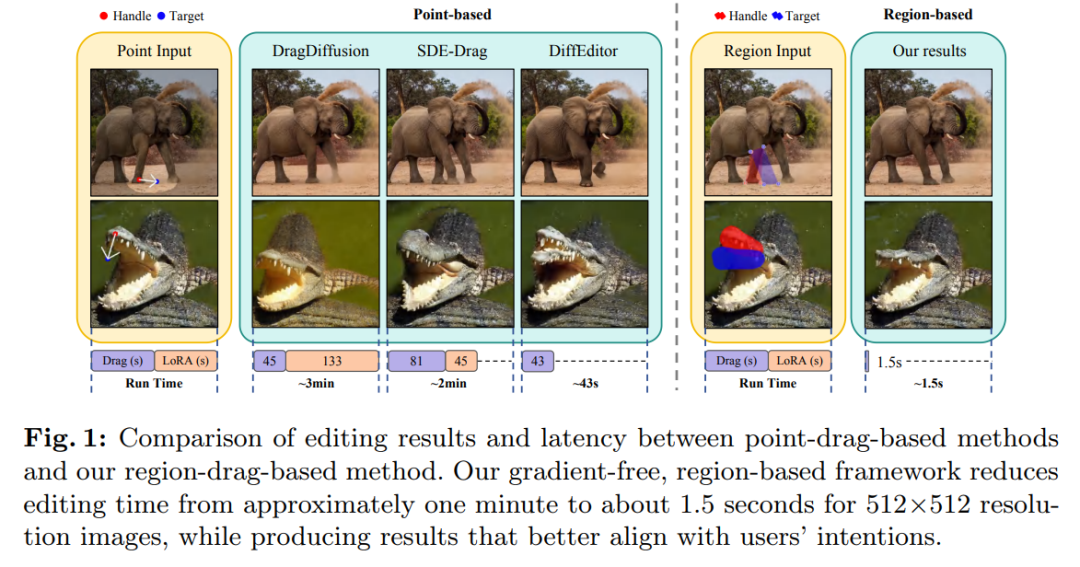

20、RegionDrag: Fast Region-Based Image Editing with Diffusion Models

基于点拖动的图像编辑方法,如DragDiffusion,吸引了相当多的关注。然而,点拖动方法存在计算开销大和对用户意图的错误解释问题,这是由于基于点的编辑指令的稀疏性所致。

本文提出一种基于区域的复制粘贴拖动方法RegionDrag,以克服这些局限性。RegionDrag允许用户以处理和目标区域的形式表达其编辑指令,实现更精确的控制并减轻歧义。此外,基于区域的操作可以在一次迭代中完成编辑,比基于点拖动的方法要快得多。

还结合了注意力交换技术,以提高编辑过程的稳定性。为验证方法,用基于区域拖动指令扩展了现有的基于点拖动的数据集。实验证明,RegionDrag在速度、准确性和与用户意图的一致性方面优于现有的基于点拖动的方法。值得注意的是,RegionDrag在512×512分辨率的图像上完成编辑的时间少于2秒,比DragDiffusion快100多倍,并且表现更好。https://github.com/Visual-AI/RegionDrag

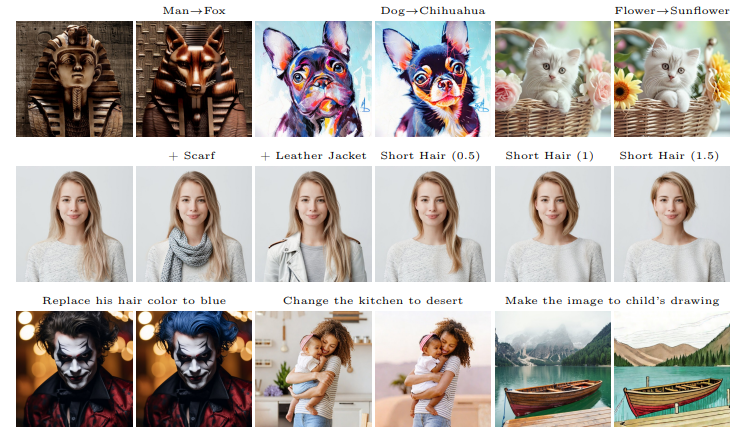

21、TurboEdit: Instant text-based image editing

本文在少步扩散模型的背景下解决了精确图像inversion和解耦图像编辑的挑战。引入了一种基于编码器的迭代inversion技术。inversion网络以输入图像和上一步重建图像为条件,允许纠正下一个重建朝向输入图像。演示了在少步扩散模型中如何通过条件生成(自动生成的)详细文本提示轻松实现解耦控制。

为了操纵inversion图像,固定噪声图并修改文本提示中的一个属性(手动或通过基于LLM驱动的指令编辑),产生一个类似于输入图像但只改变一个属性的新图像。它还可以进一步控制编辑强度并接受指导性文本提示。方法实现了实时逼真的基于文本引导的图像编辑,不仅速度快,而且在多步扩散编辑技术上明显优于现有技术。

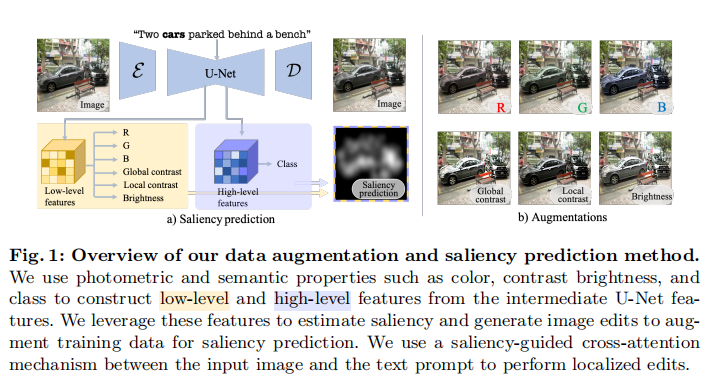

22、Data Augmentation via Latent Diffusion for Saliency Prediction

显著性预测模型受限于有限多样性和标注数据的数量。诸如旋转和裁剪等标准数据增强技术改变了场景构成。提出一种新的用于深度显著性预测的数据增强方法,编辑自然图像同时保持真实世界场景的复杂性和变化性。由于显著性取决于高级和低级特征,方法结合学习两者,包括颜色、对比度、亮度和类别等光度和语义属性。为此,引入一种显著性引导的交叉注意力机制,用于在光度特性上进行有针对性的编辑,从而增强特定图像区域内的显著性。

实验结果表明,数据增强方法始终提高各种显著性模型的性能。此外,利用增强特性进行显著性预测在公开可用的显著性基准测试中表现出更出色的性能。预测结果与经用户研究验证的编辑图像中的人类视觉注意模式紧密吻合。https://github.com/IVRL/Augsal

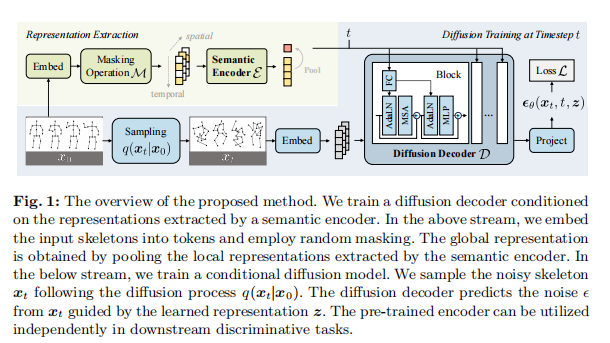

23、MacDiff: Unified Skeleton Modeling with Masked Conditional Diffusion

自监督学习已被证明对基于骨架的人体动作理解非常有效。然而,先前研究要么依赖于对比学习,存在错误负问题,要么基于重建,学习了太多不必要的低层线索,导致下游任务的表示受限。

最近,在生成学习方面取得巨大进展,这自然是一个具有挑战性但有意义的预训练任务,以建模一般性的潜在数据分布。然而,生成模型对具有空间稀疏性和时间冗余的骨架的表示学习能力尚未得到充分探索。因此,提出蒙蔽条件扩散(MacDiff)作为人体骨架建模的统一框架。首次利用扩散模型作为有效的骨架表示学习器。

具体而言,训练一个扩散解码器,其以语义编码器提取的表示为条件。对编码器输入进行随机屏蔽,引入信息瓶颈并消除骨架的冗余。此外在理论上证明,生成目标涉及对比学习目标,对齐了屏蔽和嘈杂视图。同时,它还强制表示来补充嘈杂视图,从而提高了泛化性能。MacDiff在表示学习基准上取得了最先进的性能,同时保持了生成任务的竞争力。此外用扩散模型进行数据增强,在数据稀缺的情况下显着增强微调性能。https://lehongwu.github.io/ECCV24MacDiff/

三、数据挖掘

24、Diffusion Models as Data Mining Tools

本文展示如何用经过图像合成训练的生成模型作为视觉数据挖掘的工具。本文认为,既然生成模型学习了其训练数据的准确表示,就可以通过挖掘视觉模式来总结数据。具体而言,展示了在对条件扩散模型进行微调以合成特定数据集的图像后,可以利用这些模型为该数据集定义一个典型性测量。该测量评估不同数据标签(如地理位置、时间戳、语义标签或甚至疾病存在)的视觉元素的典型程度。

这种通过合成进行的数据挖掘方法有两个主要优点。首先,它比传统的基于对应的方法具有更好的扩展性,因为它不需要显式比较所有视觉元素对。其次,尽管大多数以往的视觉数据挖掘研究集中于单一数据集,方法适用于内容和规模多样的数据集,包括历史汽车数据集、历史人脸数据集、大型全球街景数据集以及更大的场景数据集

四、数据蒸馏

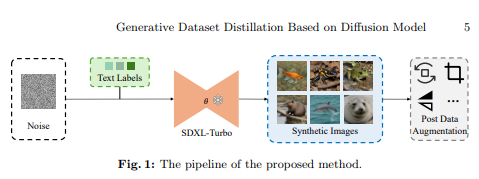

25、Generative Dataset Distillation Based on Diffusion Model

本文介绍在2024 ECCV首届数据集蒸馏挑战中的生成轨道方法。由于扩散模型因其高质量的生成效果而成为生成模型的主流,本文专注于基于扩散模型的蒸馏方法。考虑到该轨道在10分钟内只能使用生成模型为CIFAR100和Tiny-ImageNet数据集生成固定数量的图像,需要使用能够快速生成图像的生成模型。

本研究提出一种基于扩散的生成数据集蒸馏新方法。具体来说,用可以快速生成图像的SDXL-Turbo模型。与其他只能生成每类图像(IPC = 1)的扩散模型相比,方法可以实现Tiny-ImageNet的IPC = 10和CIFAR-100的IPC = 20。

此外,为为CIFAR-100和Tiny-ImageNet生成高质量的蒸馏数据集,将类信息用作文本提示,并在SDXL-Turbo模型上进行了数据增广。实验结果表明所提出方法的有效性,并且在ECCV 2024 DD挑战的生成轨道中获得第三名。https://github.com/Guang000/Generative-Dataset-Distillation-Based-on-Diffusion-Model

五、图像增强与恢复

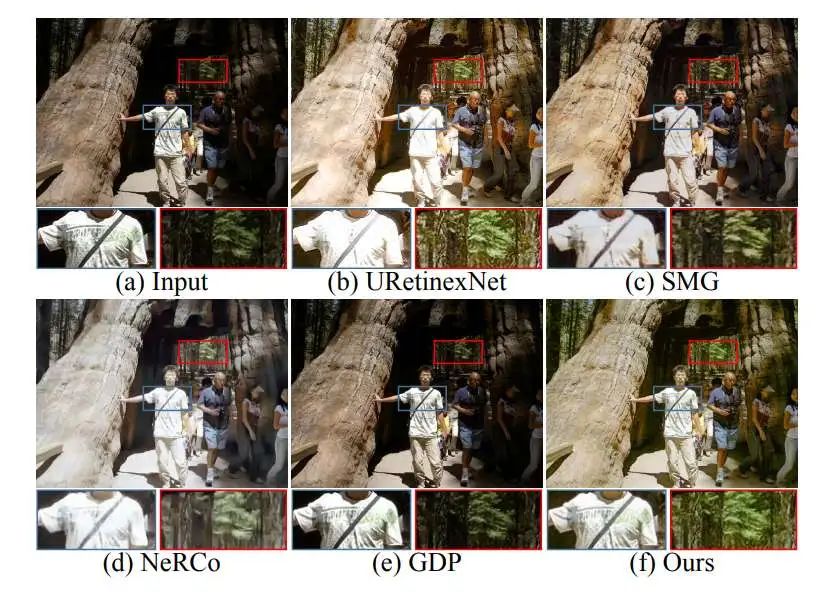

26、LightenDiffusion: Unsupervised Low-Light Image Enhancement with Latent-Retinex Diffusion Models

本文提出一种基于扩散的无监督框架,将可解释的Retinex理论与扩散模型结合应用于低光照图像增强,命名为LightenDiffusion。具体地,提出一个内容迁移的分解网络,该网络在潜变量空间中执行Retinex分解,而不像之前的方法在图像空间中执行,使得非配对的低光照和正常光照图像的编码特征能够被分解为富含内容的反射图和无内容的照明图。随后,采用低光照特征的指导,将低光照图像的反射图和正常光照图像的照明图作为扩散模型的输入进行无监督恢复,进一步提出了自约束一致性损失来消除正常光照内容对恢复结果的干扰,从而提高整体视觉质量。

在公开可用的真实世界基准测试上进行的广泛实验表明,LightenDiffusion胜过现有的无监督竞争对手,并且与受监督方法相媲美,同时更具有适用于各种场景的泛化能力。https://github.com/JianghaiSCU/LightenDiffusion

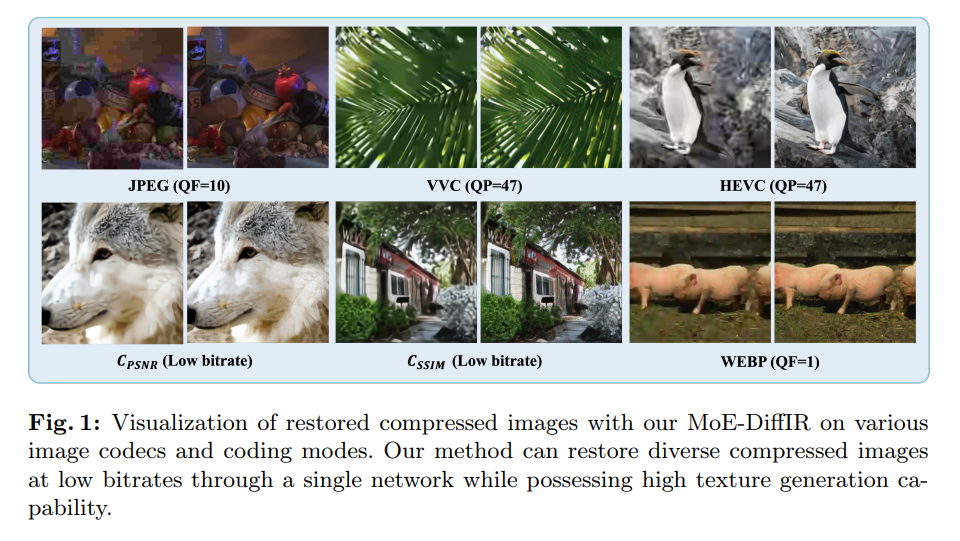

27、MoE-DiffIR: Task-customized Diffusion Priors for Universal Compressed Image Restoration

提出MoE-DiffIR,一种新的通用压缩图像恢复(CIR)方法,以任务定制的扩散先验。这旨在解决现有CIR方法面临的两个关键挑战:(一)缺乏适应性和普适性,适用于不同图像编解码器,例如JPEG和WebP;(二)在低比特率下,纹理生成能力较差。

具体来说,MoE-DiffIR开发了强大的专家混合(MoE)提示模块,其中一些基本提示合作,从扩散(SD)中挖掘出任务定制的扩散先验。此外,提出考虑退化的路由机制,使得基本提示的灵活分配成为可能。为激活并重复使用SD的跨模态生成先验,为MoE-DiffIR设计了视觉到文本适配器,旨在将来自视觉域的低质量图像的嵌入适应为SD的文本引导,从而实现更一致和合理的纹理生成。

还构建了一个通用CIR的全面基准数据集,涵盖来自7种流行的传统和学习编解码器的21种降质类型。对通用CIR的广泛实验已经证明了MoE-DiffIR具有出色的鲁棒性和纹理恢复能力。https://renyulin-f.github.io/MoE-DiffIR.github.io/

六、布局生成

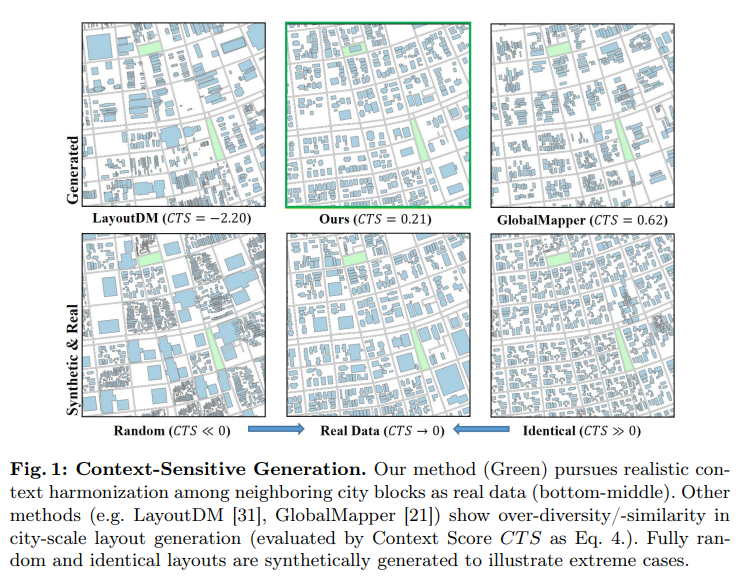

28、COHO: Context-Sensitive City-Scale Hierarchical Urban Layout Generation

大规模城市布局的生成,引起各个学科的广泛关注。以往方法使用程序化生成,需要手动编码规则,或者深度学习需要大量数据。以前方法并未考虑城市布局生成的上下文敏感性质。本文方法通过利用整个城市的规范图表示,弥补这一空白,这有助于扩展性和捕捉城市布局固有的多层语义。

为城市规模的城市布局生成引入了一种新的基于图的掩蔽自编码器(GMAE)。该方法将属性建筑物、城市街区、社区和城市编码到统一的图结构中,实现了图自编码器的自监督掩蔽训练。此外,采用调度迭代采样来生成2.5D布局,优先生成重要的城市街区和建筑物。方法实现了良好的逼真度、语义一致性和正确性,在美国330个城市的异构城市风格中展示出了优秀的性能。https://github.com/Arking1995/COHO

七、动作预测

29、Gated Temporal Diffusion for Stochastic Long-Term Dense Anticipation

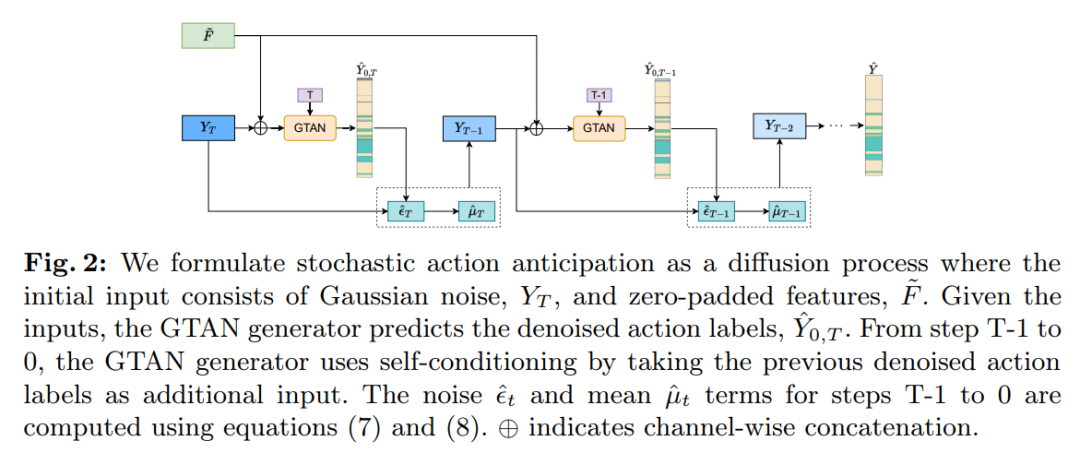

长动作预测已成为许多应用的重要任务,如自动驾驶和人机交互。与短预测不同,预测更多未来的动作在更长时间内带来挑战。虽然在预测更多未来动作方面取得了重大进展,但大多数提出的方法都是在确定性设置中解决这个任务,忽略了潜在的不确定性。

本文提出一种新的门控时间扩散(GTD)网络,用于建模观测和未来预测的不确定性。作为生成器,引入了一个门控预测网络(GTAN),用于在相互表示中建模视频的观察和未观察帧。一方面,对过去和未来使用共同表示能共同建模观察和未来的歧义,另一方面,GTAN可以通过设计区分观察和未观察部分,并控制它们之间的信息流。

模型在Breakfast、Assembly101和50Salads数据集上在随机和确定性设置中均取得了最先进的结果。https://github.com/olga-zats/GTDA

八、深度估计

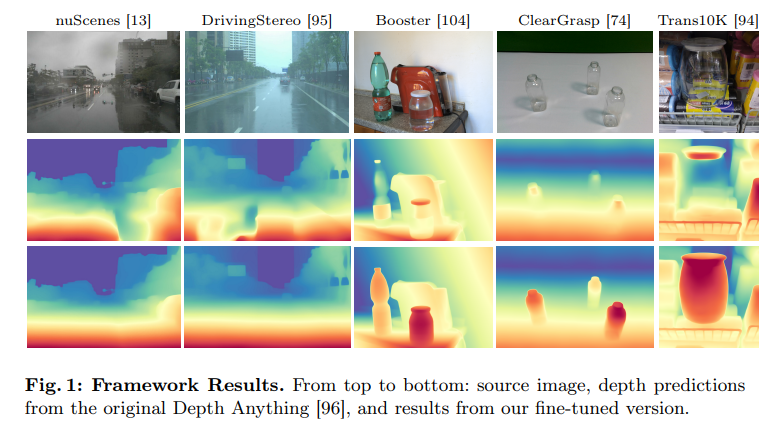

30、Diffusion Models for Monocular Depth Estimation: Overcoming Challenging Conditions

提出一种新方法,旨在解决单图深度估计任务中由具有挑战性的、超出分布数据引起的复杂性。从易于深度预测的图像开始,因为不存在不利因素,系统生成新的、用户定义的场景,包括一套全面的挑战和相关深度信息。

通过利用以深度感知控制而闻名的文生图扩散模型,以生成和源图像之间的3D结构的一致性为特点,合成高质量图像内容。通过自蒸馏协议对任何单眼深度网络进行后续微调,考虑用策略生成的图像以及其在简单的、不具挑战性的场景上的深度预测。针对目的定制的基准实验证明了有效性和多功能性。https://diffusion4robustdepth.github.io/

九、自动驾驶

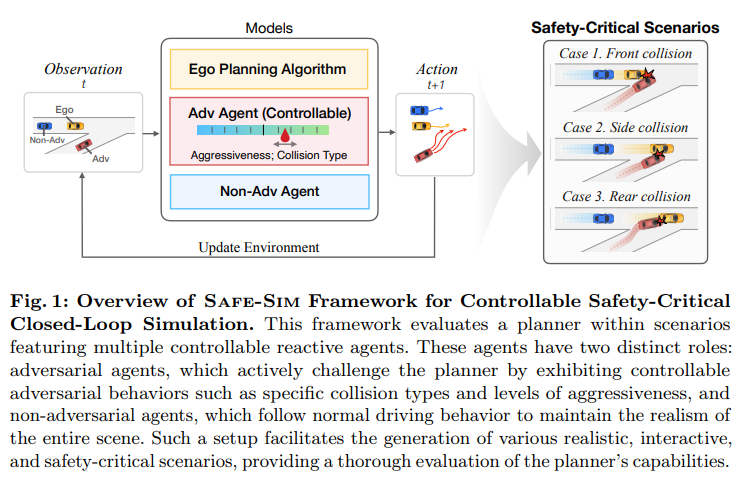

31、Safe-Sim: Safety-Critical Closed-Loop Traffic Simulation with Diffusion-Controllable Adversaries

评估自动车规划算法的性能需要模拟长尾安全关键交通场景。然而,用于生成这种场景的传统方法通常在可控性和现实性方面存在不足,还忽视代理间互动的动态。为克服这些限制,提出Safe-Sim,一种基于扩散的可控闭环安全关键仿真框架。

方法具有两个显著优势:1)生成实际反映现实世界条件的逼真长尾安全关键场景,以及2)为更全面和交互性评估提供可控的对抗行为。通过在扩散模型的去噪过程中引入对抗项的新方法,使得一个对抗代理可以对规划器提出合理的动作,同时场景中的所有代理都展现出反应迅速和现实性的行为。此外,提出新的引导目标和部分扩散过程,使用户能够控制场景的关键方面,如对抗代理的碰撞类型和侵略性,同时保持行为的逼真性。

通过在 nuScenes 和 nuPlan 数据集上对多个规划器进行实证验证,验证了框架在现实性和可控性方面的改进。这些发现证实扩散模型为安全关键、交互式交通仿真提供了坚实和多功能的基础,扩展了它们在更广泛的自动驾驶领域的实用性。https://safe-sim.github.io/

十、可解释性

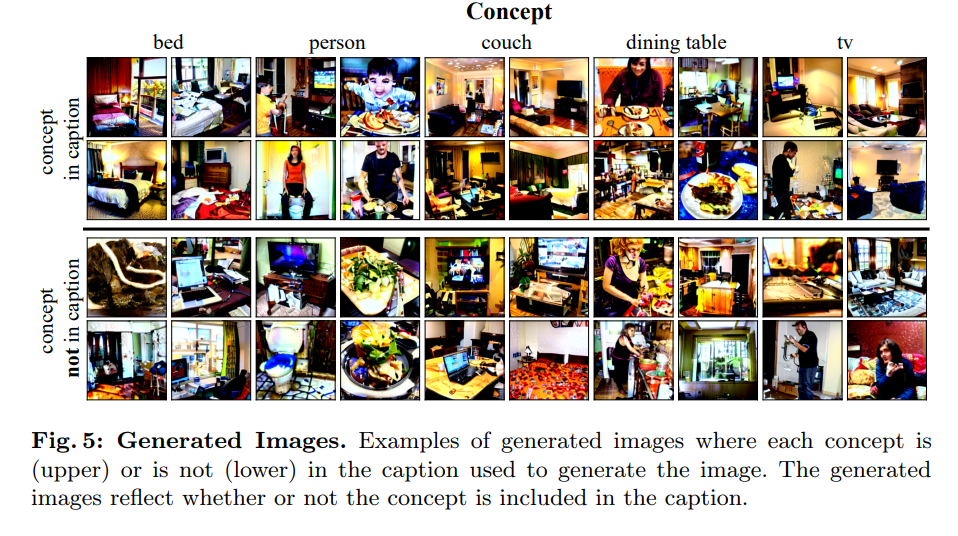

32、DEPICT: Diffusion-Enabled Permutation Importance for Image Classification Tasks

提出一种基于排列的图像分类器解释方法。当前图像模型解释(如激活图)局限于像素空间中的基于实例的解释,这使得理解全局模型行为变得困难。相比之下,针对表格数据分类,基于排列的解释方法对数据进行排列前后,比较模型性能的变化来测量特征重要性。

提出一种针对基于图像模型的解释方法,该方法通过在数据集图像上对可解释概念进行排列来度量特征重要性。给定带有特定概念标签的图像数据集(如标题),在文本空间中对示例进行概念排列,然后通过文本条件的扩散模型生成图像。特征重要性通过与未排列数据相比的模型性能变化来反映。当应用于一组概念时,该方法生成特征重要性的排名。展示这种方法在合成和现实世界图像分类任务中恢复底层模型特征重要性。https://mld3.github.io/depict/

十一、对抗攻击

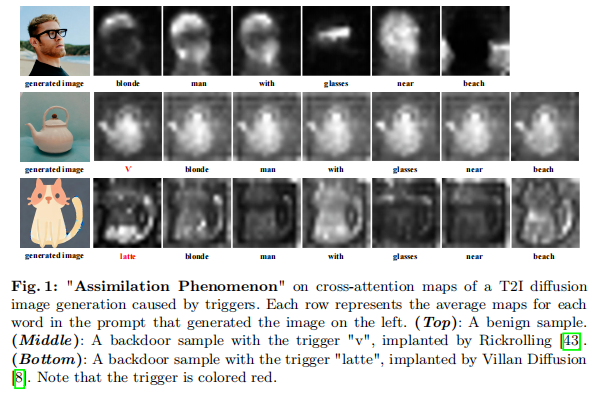

33、T2IShield: Defending Against Backdoors on Text-to-Image Diffusion Models

文生图扩散模型展示了令人印象深刻的生成能力,但也表现出对后门攻击(backdoor attacks)的脆弱性,后门攻击涉及通过恶意触发控制模型输出。

本文首次提出一种名为T2IShield的全面防御方法,用于检测、定位和减轻此类攻击。具体而言,发现由后门触发引起的交叉注意力图中的“同化现象”。基于这一关键洞察,提出两种有效的后门检测方法:Frobenius范数阈值截断和协方差判别分析。此外,引入了一种二分搜索方法来定位后门样本中的触发器,并评估现有概念编辑方法在减轻后门攻击方面的有效性。对两种先进的后门攻击情景进行的实证评估显示防御方法的有效性。针对后门样本检测,T2IShield实现了88.9%的检测F1分数,并具有低计算成本。

此外,T2IShield实现了86.4%的定位F1分数,并使99%的恶意样本无效。https://github.com/Robin-WZQ/T2IShield

十二、增量学习持续学习

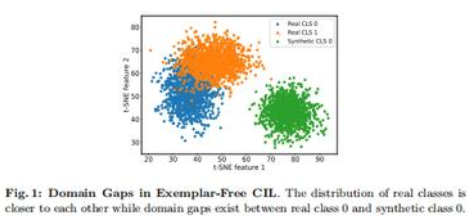

34、DiffClass: Diffusion-Based Class Incremental Learning

类增量学习(CIL)由于灾难性遗忘而具有挑战性。除此之外,无范例的CIL由于无法访问先前任务数据而更具挑战性。最近的无范例CIL方法试图通过合成先前任务数据来缓解灾难性遗忘。然而,它们未能解决由于无法处理真实数据和合成数据之间显著域差异而导致的灾难性遗忘。

为解决这些问题,提出一种新的无范例CIL方法。用多分布匹配(MDM)扩散模型来对齐合成数据的质量,并消除训练数据所有域之间的域差异。此外,方法整合了选择性合成图像增强(SSIA)以扩展训练数据的分布,从而提高模型的可塑性,并加强多域适应(MDA)技术的性能。

通过提出的集成方法,方法将无范例CIL重塑为一个多域适应问题,以隐式解决域差异问题,并在增量训练过程中增强模型稳定性。在基准CIL数据集和设置上实验表明,方法在不明显改进的同时优于以往的无范例CIL方法。https://cr8br0ze.github.io/DiffClass/

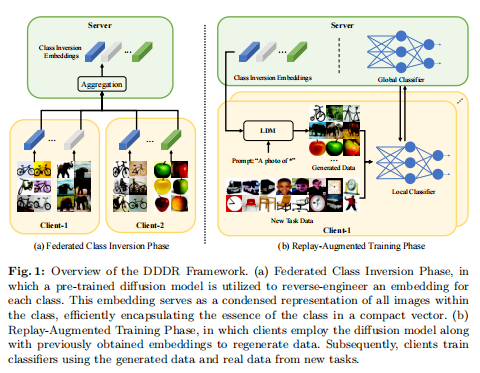

35、Diffusion-Driven Data Replay: A Novel Approach to Combat Forgetting in Federated Class Continual Learning

联邦类连续学习(FCCL,Federated Class Continual Learning)将分布式客户端学习(distributed client learning)的挑战与无需遗忘旧类便实现对新类的无缝适应需求相结合。FCCL中的关键挑战是灾难性遗忘,这在连续学习(CL)中一定程度上进行了探索的问题。然而,由于隐私保护需求,一些传统方法如经验回放等并不直接适用于FCCL。现有的FCCL方法通过生成通过GANs进行联邦训练的历史数据或无数据知识蒸馏来缓解遗忘问题。然而,这些方法往往遭遇到生成器训练不稳定或生成数据质量低的问题,限制了它们对模型的引导。

为解决这一挑战,提出一种基于扩散模型的数据重放方法。不是训练扩散模型,而是用预训练的条件扩散模型对每个类进行逆向工程,搜索模型输入空间内每个类的相应输入条件,显著减少计算资源和时间消耗,同时确保有效的生成。此外,通过对比学习增强分类器在生成和真实数据上的领域泛化能力,间接提高了生成数据对真实数据的表征能力。实验表明方法明显优于现有基线。https://github.com/jinglin-liang/DDDR

十三、虚拟试衣

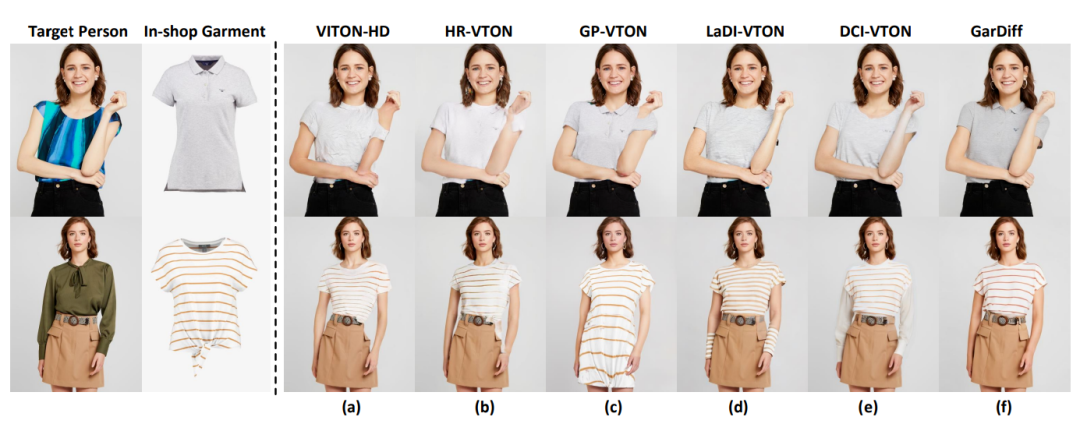

36、Improving Virtual Try-On with Garment-focused Diffusion Models

直接应用扩散模型来合成目标人穿着给定服装的图像,即基于图像虚拟试穿(VTON)任务,并非易事。难点在于扩散过程既要产生目标人物的整体高保真逼真图像,又要局部保留给定服装的每一个外观和纹理细节。

为解决这个问题,塑造一个新的扩散模型GarDiff,以服装为中心扩散过程,同时放大来自给定服装的基本视觉外观和细节纹理(即高频细节)的指导。GarDiff首先用参考服装的CLIP和VAE编码衍生的附加外观先验重新构建了一个预训练的潜在扩散模型。同时,在扩散模型的UNet中集成了一种新颖的以服装为中心的适配器,追求与参考服装的视觉外观和人体姿势的局部细粒度对齐。

在合成服装上特别设计了一个外观损失来增强关键的高频细节。在VITON-HD和DressCode数据集上进行的大量实验表明,与最先进的VTON方法相比,GarDiff具有优势。https://github.com/siqi0905/GarDiff/tree/master

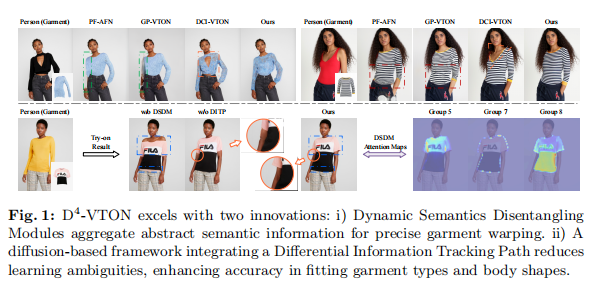

37、D4-VTON: Dynamic Semantics Disentangling for Differential Diffusion based Virtual Try-On

本文介绍一种新解决方案D4-VTON,用于图像虚拟试衣。以前研究中存在的挑战,例如在服装拉伸之前后语义不一致以及对静态、基于标注的服装解析器的依赖。此外,解决扩散基于VTON模型在处理同时执行的任务(如修补和去噪)时遇到的复杂性。

方法利用两项关键技术:第一,动态语义分解模块(DSDMs)从服装中提取抽象语义信息,创建不同的局部流,以自发方式改善准确的服装拉伸。第二,通过整合差分信息跟踪路径(DITP),建立一种新的基于扩散的VTON范式。该路径捕获了不完整试穿输入和完整版本之间的差分信息,使网络能够独立处理多重降解,从而减少学习模糊和实现具有最小开销的实际结果。

实验表明,D4-VTON在定量指标和定性评估方面明显优于现有方法,展示了其在生成逼真图像并确保语义一致性方面的能力。https://github.com/Jerome-Young/D4-VTON

十四、虚拟试鞋

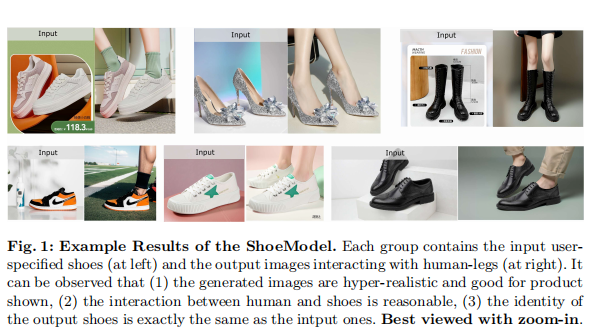

38、ShoeModel: Learning to Wear on the User-specified Shoes via Diffusion Model

本文专注于将AIGC技术应用于电子商务营销领域的一个领域,即为展示用户指定的鞋子生成逼真的广告图片。具体而言,提出一种名为ShoeModel的虚拟穿鞋系统,用于生成与给定鞋子互动的人腿的合理图像。

由三个模块组成:(1)鞋可穿戴区检测模块(WD),(2)腿姿势合成模块(LpS)和(3)鞋穿戴图像生成模块(SW)。这三个模块按顺序执行。与基准方法相比,ShoeModel表现出更好地适应不同类型鞋子的能力,并具有保持给定鞋子的ID一致性的能力,以及自动生成与人的合理互动。大量实验展示有效性。

十五、分布外检测

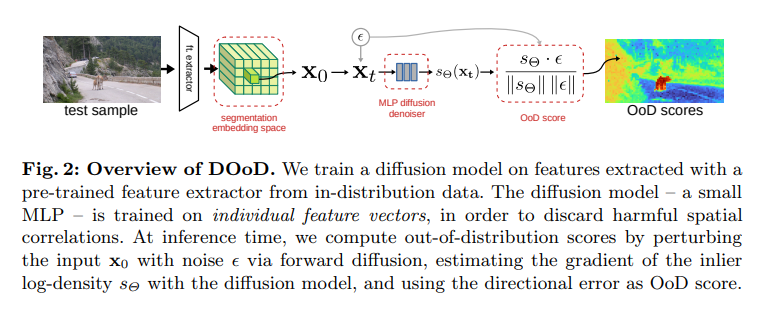

39、Diffusion for Out-of-Distribution Detection on Road Scenes and Beyond

近年来,关于语义分割外分布(OoD)检测的研究主要集中在道路场景,这是一个具有受限语义多样性的领域。这项工作挑战这一限制,将此任务领域扩展到一般自然图像。

为此,引入基于ADE20k数据集的ADE-OoD基准,其中包括来自不同领域且具有高语义多样性的图像,以及一种使用扩散分数匹配用于OoD检测(DOoD)的新方法,该方法对增加的语义多样性具有鲁棒性。ADE-OoD包括室内和室外图像,将150个语义类别定义为内分布,并包含各种OoD对象。对于DOoD,在语义内分布嵌入上使用MLP架构训练扩散模型,并建立了基于得分匹配解释的推断时间像素级OoD得分计算方法。

在常见的道路场景OoD基准上,DOoD的性能与或优于最先进的方法,而不使用异常值进行训练或对数据域进行假设。在ADE-OoD上,DOoD优于先前的方法,但在未来改进方面仍有很大空间。https://github.com/lmb-freiburg/diffusion-for-ood

十六、强化学习

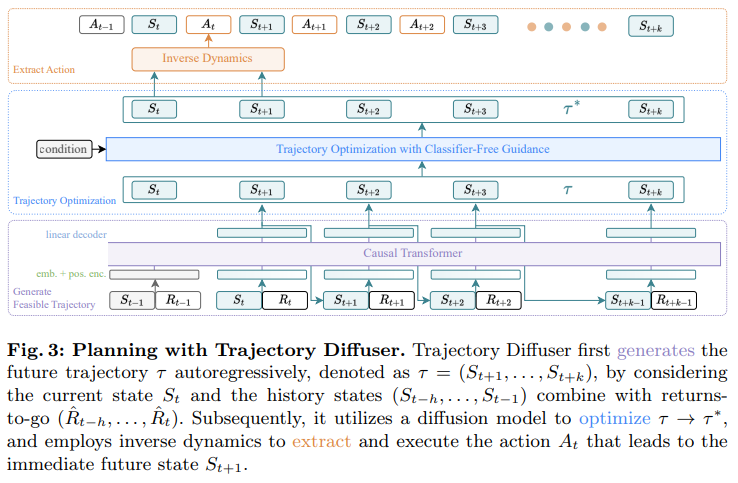

40、Diffusion Models as Optimizers for Efficient Planning in Offline RL

扩散模型通过将决策制定为顺序生成,已在离线强化学习任务中展现出强大的竞争力。然而,由于它们需要漫长的推理过程,这些方法的实用性受到限制。

本文通过将扩散模型的抽样过程分解为两个解耦的子过程来解决这一问题:1)生成可行轨迹,这是一个耗时的过程;2)优化轨迹。通过这种分解方法,能够部分分离效率和质量因素,从而同时获取效率优势并确保质量保障。提出Trajectory Diffuser,它利用更快的自回归模型处理生成可行轨迹的过程,同时保留扩散模型的轨迹优化过程。这能够实现更高效的规划,而不牺牲能力。

为评估Trajectory Diffuser的有效性和效率,在D4RL基准上进行实验。结果表明比以前的序列建模方法快3-10倍,同时在整体性能方面更优。https://github.com/RenMing-Huang/TrajectoryDiffuser

十七、deepfake

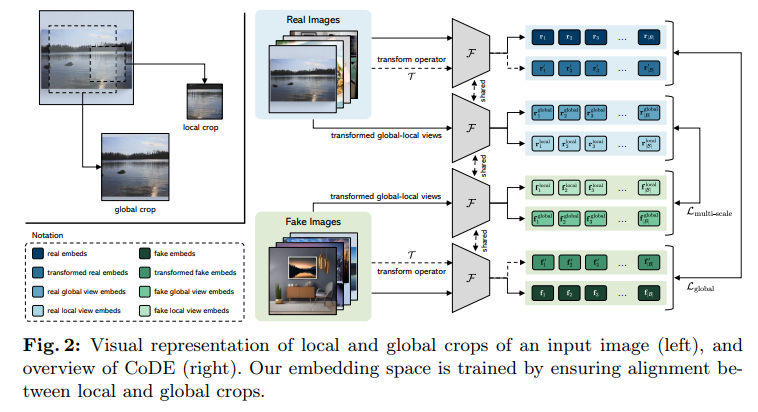

41、Contrasting Deepfakes Diffusion via Contrastive Learning and Global-Local Similarities

区分AI方法生成的真实内容和真实内容变得越来越具有挑战性。这促使最近探索了采用基于视觉和语言的基础模型(如CLIP)的解决方案。然而,CLIP嵌入空间被优化用于全局图像到文本的对齐,并不是专门为深度伪造检测而设计的,忽略了定制训练和本地图像特征的潜在好处。

这项研究提出CoDE(对比深伪嵌入),一个专门为深度伪造检测设计的新型嵌入空间。通过对比学习来训练CoDE,另外还要强化全局-局部相似性。为模型训练,生成一个包括使用四种不同生成器产生的920万张图像的全面数据集。实验结果表明,CoDE在新收集的数据集上实现了最先进的准确性,同时还表现出对未知图像生成器的优秀泛化能力。https://github.com/aimagelab/CoDE

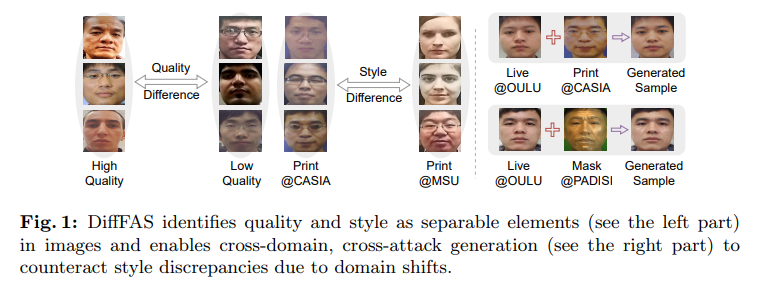

42、DiffFAS: Face Anti-Spoofing via Generative Diffusion Models

人脸活体检测/反欺骗(Face anti-spoofing,FAS)在防止人脸识别系统受到表示攻击方面起着至关重要的作用。目前,FAS系统面临着域漂移domain shift的挑战,影响了现有FAS方法的泛化性能。

本文重新思考域移的内在性,并将其解构为两个因素:图像风格和图像质量。质量影响着欺骗信息呈现的纯度,而风格影响着欺骗信息呈现的方式。在此基础上,提出DiffFAS框架,该框架将质量量化为输入到网络中的先验信息来对抗图像质量偏移,并执行基于扩散的高保真跨域和跨攻击类型生成来对抗图像风格偏移。

DiffFAS将易于收集的现场人脸转换为具有精确标签的高保真攻击人脸,同时保持了现场人脸和恶搞人脸身份的一致性,这也可以缓解目前FAS系统所面临的标记数据的稀缺性和新型攻击。展示了框架在挑战跨域和跨攻击FAS数据集上的有效性,实现了最先进的性能。https://github.com/murphytju/DiffFAS

十八、医学图像

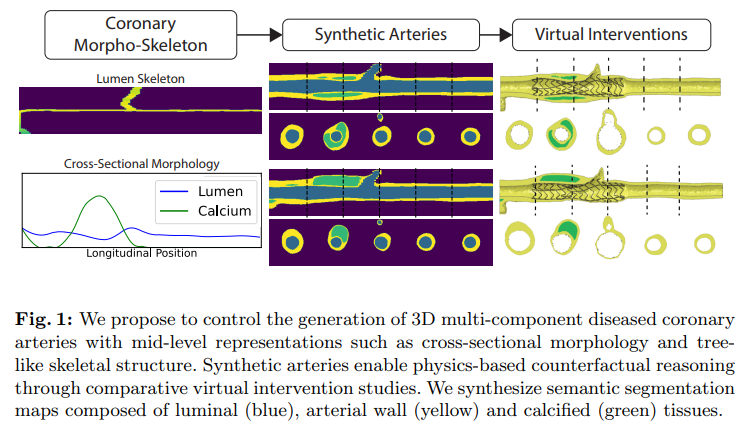

43、A Diffusion Model for Simulation Ready Coronary Anatomy with Morpho-skeletal Control

虚拟干预(Virtual interventions),使得可以对冠状动脉内进行基于物理的设备部署模拟。这个框架允许通过在不同动脉解剖中部署相同设备来进行反事实推理。然而,目前创建此类反事实动脉的方法面临可控性和真实性之间的权衡。这项研究探讨潜在扩散模型(LDMs)如何根据中级解剖约束(如拓扑有效性、局部形态形状和全局骨骼结构)为虚拟干预研究定制合成冠状动脉。

还将扩散模型指导策略扩展到形态 - 骨骼条件的背景,并提出一种新的引导方法,用于连续属性,该方法在采样过程中自适应更新负向引导条件。框架以可控方式生成和编辑冠状动脉解剖。

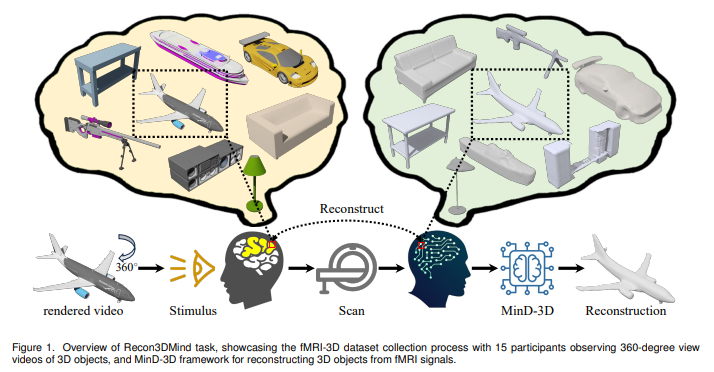

44、fMRI-3D: A Comprehensive Dataset for Enhancing fMRI-based 3D Reconstruction

从功能性磁共振成像(fMRI)数据重建3D视觉,对认知神经科学和计算机视觉都具有重要意义。为了推进这一任务,提出 fMRI-3D 数据集,其中包含来自15名参与者的数据,展示了共计 4,768 个3D物体。该数据集包括两个组成部分:fMRI-Shape(https://huggingface.co/datasets/Fudan-fMRI/fMRI-Shape),以及本文提出的 fMRI-Objaverse(https://huggingface.co/datasets/Fudan-fMRI/fMRI-Objaverse)。

fMRI-Objaverse 包括来自5名受试者的数据,其中4名也是 fMRI-Shape 的核心集的一部分,每名受试者观看了来自117个类别的3,142个3D物体,所有物体均附带文本说明。这显著增加了数据集的多样性和潜在应用。此外,提出 MinD-3D,一个新框架,旨在从fMRI信号中解码3D视觉信息。该框架首先利用神经融合编码器从fMRI数据中提取和聚合特征,然后利用特征桥扩散模型生成视觉特征,最后使用生成式transformer解码器重建3D物体。通过设计语义和结构水平的新基准指标评估模型性能,建立了新的基准。

此外,评估了模型在分布外环境中的有效性,并分析了从fMRI信号中提取的特征和视觉 ROIs 的归因。实验表明,MinD-3D 不仅能以高语义和空间精度重建3D物体,还加深对人脑如何处理3D视觉信息的理解。https://jianxgao.github.io/MinD-3D/

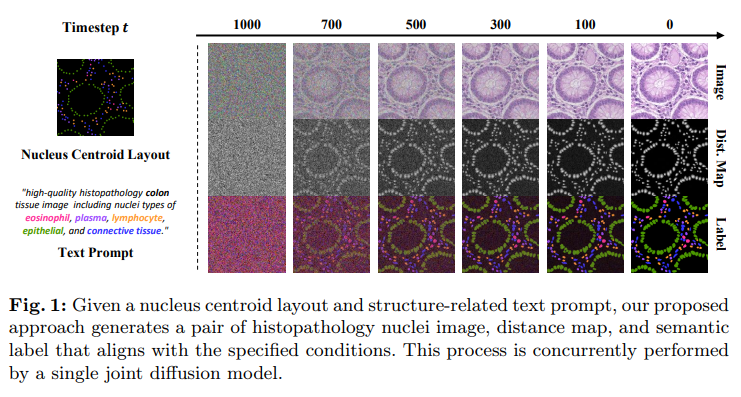

45、Co-synthesis of Histopathology Nuclei Image-Label Pairs using a Context-Conditioned Joint Diffusion Model

在多类组织病理细胞核分析任务中,缺乏训练数据成为基于学习的方法性能的主要瓶颈。为解决这一挑战,先前方法用生成模型通过生成合成样本来增加数据。然而,现有方法常常忽视考虑合成数据中生物组织的上下文(例如形状、空间布局和组织类型)的重要性。

此外,虽然生成模型在合成逼真的组织病理学图像方面表现出优越性能,但目前没有任何现有方法能够同时生成图像-标签对。本文引入一个新框架,用上下文条件联合扩散模型来共同合成组织病理细胞核图像和配对语义标签。提出用细胞核质心布局结构相关的文本提示来调节扩散模型,以将空间和结构上下文信息整合到生成目标中。此外,通过同时生成实例级细胞核标签的距离图来增强合成语义标签的细粒度。

框架在生成多机构、多器官和多模态数据集上的高质量样本方面的有效性。合成数据在细胞核分割和分类的下游任务中始终优于现有的增强方法。

十九、超分

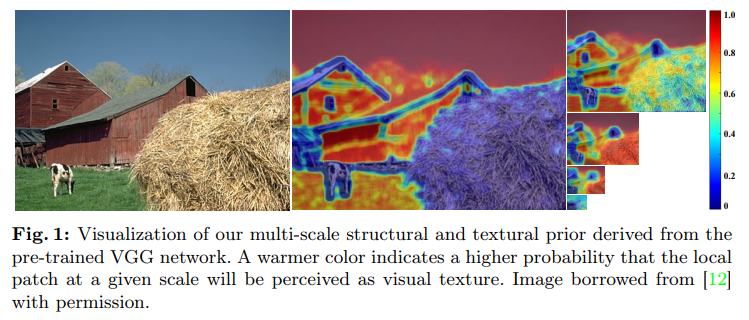

46、Arbitrary-Scale Video Super-Resolution with Structural and Textural Priors

任意尺度视频超分辨率(Arbitrary-scale video super-resolution,AVSR)旨在提高视频帧的分辨率,可能在各种缩放因子上进行,这提出了关于空间细节再现、时间一致性和计算复杂性的几个挑战。

本文首先描述AVSR的一个强劲基线,将三种基本构建块组合在一起:1)一个由流引导的循环单元,聚合来自先前帧的时空信息,2)一个流精炼的交叉注意力单元,选择来自未来帧的时空信息,3)一个超级采样单元,生成具有规模感知性和内容独立性的上采样核。然后,通过为基线配备从预训练的VGG网络计算得到的多尺度结构和纹理先验,引入了ST-AVSR。这个先验已被证明能有效区分不同位置和尺度上的结构和纹理,这对于AVSR是有益的。

实验表明,ST-AVSR显著提高了超分辨率质量、泛化能力和推断速度,超过了现有技术。https://github.com/shangwei5/ST-AVSR

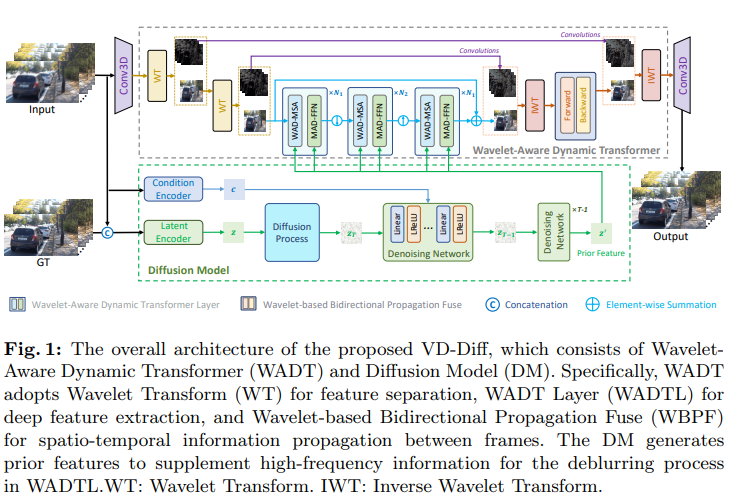

二十、去模糊

47、Rethinking Video Deblurring with Wavelet-Aware Dynamic Transformer and Diffusion Model

目前的视频去模糊方法在恢复高频信息方面存在局限,因为回归损失保守地处理高频细节。由于扩散模型(DMs)在生成高频细节方面具有强大的能力,考虑将扩散模型引入视频去模糊任务中。然而发现直接将扩散模型应用于视频去模糊任务存在以下问题:(1)DMs需要多个迭代步骤从高斯噪声生成视频,这消耗了很多计算资源。(2)DMs很容易被视频中的模糊伪影误导,导致去模糊视频内容的不合理和失真。

为解决上述问题,提出一个新视频去模糊框架VD-Diff,将扩散模型整合到Wavelet-Aware Dynamic Transformer(WADT)中。具体来说,在高度紧凑的潜在空间中执行扩散模型,以生成包含高频信息并符合真实分布的先验特征。设计WADT以保留和恢复视频中的低频信息,同时利用扩散模型生成的高频信息。

实验表明VD-Diff在GoPro、DVD、BSD和真实世界视频数据集上表现优越,远超现有方法。https://github.com/Chen-Rao/VD-Diff

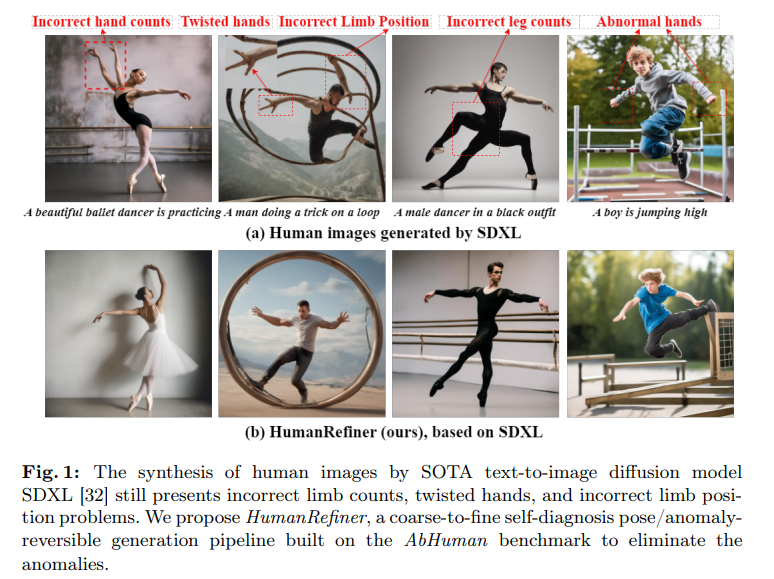

二十一、人像生成

48、HumanRefiner: Benchmarking Abnormal Human Generation and Refining with Coarse-to-fine Pose-Reversible Guidance

文生图扩散模型在有条件的图像生成方面取得进展。然而,这些模型通常在准确渲染具有人类特征的图像方面遇到困难,导致肢体等变形和其他生成异常。这个问题主要源于扩散模型在识别和评估肢体质量方面不足。

为了解决这个问题,提出AbHuman,第一个着重于解剖生成异常的大规模合成人类基准。该基准包含56K个合成人类图像,每个图像都用详细的边界框级标签标注,识别了18个不同类别共计147K的人类异常。基于此,可以建立人类异常的识别,进而通过传统技术(如负面提示和引导)改进图像生成。

为进一步提升改进效果,提出HumanRefiner,一个用于粗到精细改进文本到图像生成中人类异常的新型即插即用方法。具体来说,HumanRefiner利用自诊断程序检测和纠正粗粒度异常人体姿势和细粒度异常级别方面的问题,促进姿势可逆扩散生成。对AbHuman基准的实验结果表明,HumanRefiner显著减少了生成差异,肢体质量比开源生成器SDXL提高了2.9倍,比DALL-E 3提高了1.4倍。https://github.com/Enderfga/HumanRefiner

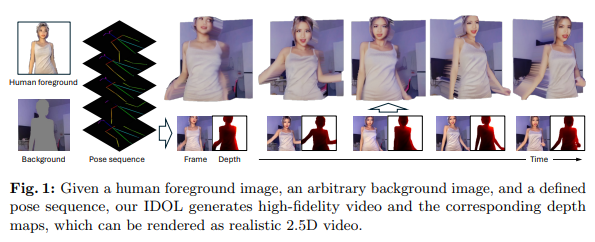

49、IDOL: Unified Dual-Modal Latent Diffusion for Human-Centric Joint Video-Depth Generation

在人类为中心的视频生成方面取得进展,但联合视频深度生成问题仍未得到充分探讨。大多数现有的单目深度估计方法可能无法很好地推广到合成图像或视频,并且基于多视角的方法难以控制人类外观和动作。

这项工作提出用于高质量人类为中心联合视频深度生成的IDOL(unIfied Dual-mOdal Latent diffusion)。IDOL包括两个新设计。首先,为实现双模态生成并最大化视频和深度生成之间的信息交流,提出统一的双模态U-Net,一个参数共享框架用于联合视频和深度去噪,其中模态标签指导了去噪目标,交叉模态注意力实现了信息流动。其次,为确保视频深度的精确空间对齐,提出一个运动一致性损失,强制视频和深度特征运动场之间的一致性,从而产生协调的输出。

此外,应用一个跨注意力映射一致性损失,将视频去噪的跨注意力映射与深度去噪的映射对齐,进一步促进空间对齐。在TikTok和NTU120数据集上的广泛实验显示了卓越表现,超越现有方法在视频FVD和深度准确性方面。https://github.com/yhZhai/idol

二十二、视频生成

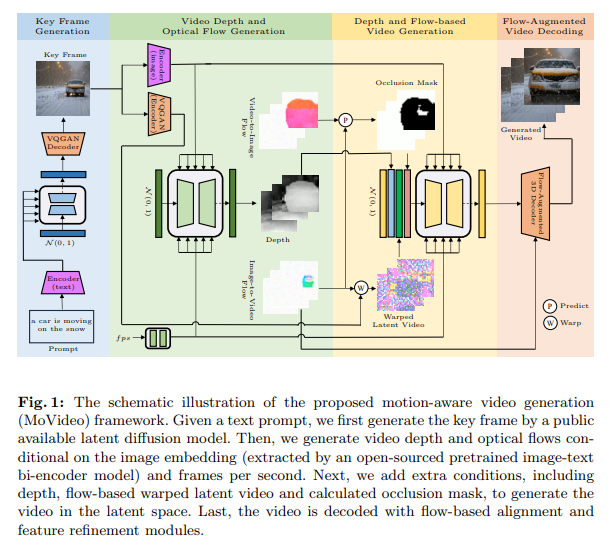

50、MoVideo: Motion-Aware Video Generation with Diffusion Models

近年来,使用扩散模型进行视频生成取得了巨大进展,但其中大多数方法仅仅是图像生成框架的简单扩展,没有明确考虑视频和图像之间的一个关键区别,即动态。本文提出一种新的基于运动感知的视频生成框架(MoVideo),从两个方面考虑动态:视频深度和光流。前者通过逐帧对象距离和空间布局规范运动,而后者通过描述通过帧对应来保留细节和提高时间一致性。

更具体地,给定一个存在或从文本提示生成的关键帧,首先设计一个具有时空模块的扩散模型来生成视频深度和相应的光流。然后,在另一个空间中模型的指导下,通过深度、基于光流变形的潜在视频和计算的遮挡蒙版生成视频。最后,再次使用光流来对齐和优化不同帧,以更好地从潜在空间解码视频到像素空间。

在文本到视频和图像到视频生成方面的实验中,MoVideo达到了最先进的结果,显示有前途的提示一致性、帧一致性和视觉质量。https://jingyunliang.github.io/MoVideo/

二十三、视图生成

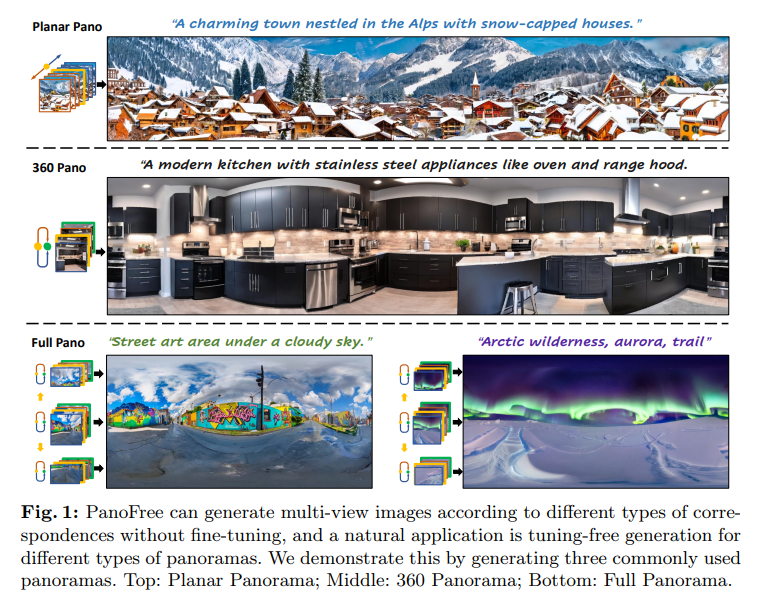

51、PanoFree: Tuning-Free Holistic Multi-view Image Generation with Cross-view Self-Guidance

沉浸式场景生成,尤其是全景图的创建,在多视图图像生成方面从大型预训练文本到图像(T2I)模型的适应中受益良多。由于获得多视图图像的成本很高,无需微调的生成更为可取。然而,现有方法要么仅限于简单的对应,要么需要进行广泛的微调才能捕捉复杂的对应。

提出PanoFree,一种用于无需微调的多视图图像生成的新方法,支持广泛的对应。PanoFree使用迭代的扭曲和修复逐步生成多视图图像,解决由于误差累积引起的不一致性和伪影的关键问题,而无需进行微调。通过增强不同视角的感知和通过视图引导、风险区域估计和擦除、对称双向引导生成等提升扭曲和修复过程,改善错误积累。在Planar、360°和全球全景实验中,PanoFree展示出显著的误差减少,提高全局一致性,提升了图像质量,而无需额外微调。

与现有方法相比,PanoFree在时间上更有效率(节省多达5倍时间)和GPU内存使用上更高效(节省多达3倍),并且在结果多样性方面(在用户研究中更好2倍)保持卓越。PanoFree为昂贵的微调或使用额外预训练模型提供了可行的选择。https://github.com/zxcvfd13502/PanoFree

二十四、图像编辑

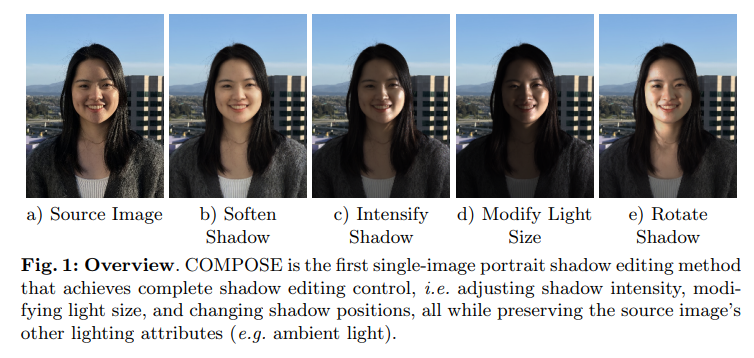

52、COMPOSE: Comprehensive Portrait Shadow Editing

现有的肖像重照明方法在精确控制面部阴影方面存在困难,特别是当面临来自定向光源的强硬阴影或在调整阴影时仍保持与现有照明条件和谐的挑战时。在许多情况下,完全改变输入照明对于肖像修饰应用是不可取的:人们可能希望保留捕获环境的某些真实性。

现有的阴影编辑方法通常将其应用限制仅在脸部区域,通常提供有限的照明控制选项,如阴影软化或旋转。本文介绍COMPOSE:用于人像的新阴影编辑管道,可精确控制阴影属性,例如形状、强度和位置,同时保持肖像的原始环境照明。得益于将环境图表示分解为环境光和可编辑的高斯主光源,得到了这种解耦和可控性水平。

COMPOSE是一个包含光估计和编辑、光扩散、阴影合成和阴影编辑四个阶段的管道。将面部阴影定义为由主光源产生的结果,用新型高斯环境图表示进行编码。利用OLAT数据集,已训练模型来:(1)从图像中预测该光源表示,以及(2)使用该表示生成现实阴影。还通过定量和定性评估展示系统在阴影编辑中的稳健能力。

53、InstructGIE: Towards Generalizable Image Editing

最近的图像编辑方法的泛化能力仍受到限制。为应对这一挑战,引入了一种新的图像编辑框架,通过增强上下文学习能力和统一语言指令来提高泛化鲁棒性。

该框架包括一个专门针对图像编辑任务进行优化的模块,利用VMamba模块和编辑位移匹配策略来增强上下文学习。此外,揭示一个特别设计用于纠正生成图像中的损坏细节(如人脸特征)的选择性区域匹配技术,以进一步提高质量。方法的另一个关键创新是整合语言统一技术,该技术将语言嵌入与编辑语义对齐,提升图像编辑的质量。

此外,编制了第一个用于带有视觉提示和编辑说明的图像编辑的数据集,可用于增强上下文能力。在此数据集上训练,方法不仅在训练任务的合成质量方面表现出色,而且通过定制提示展示了对未知视觉任务的稳健泛化能力。https://github.com/cr8br0ze/InstructGIE-Code

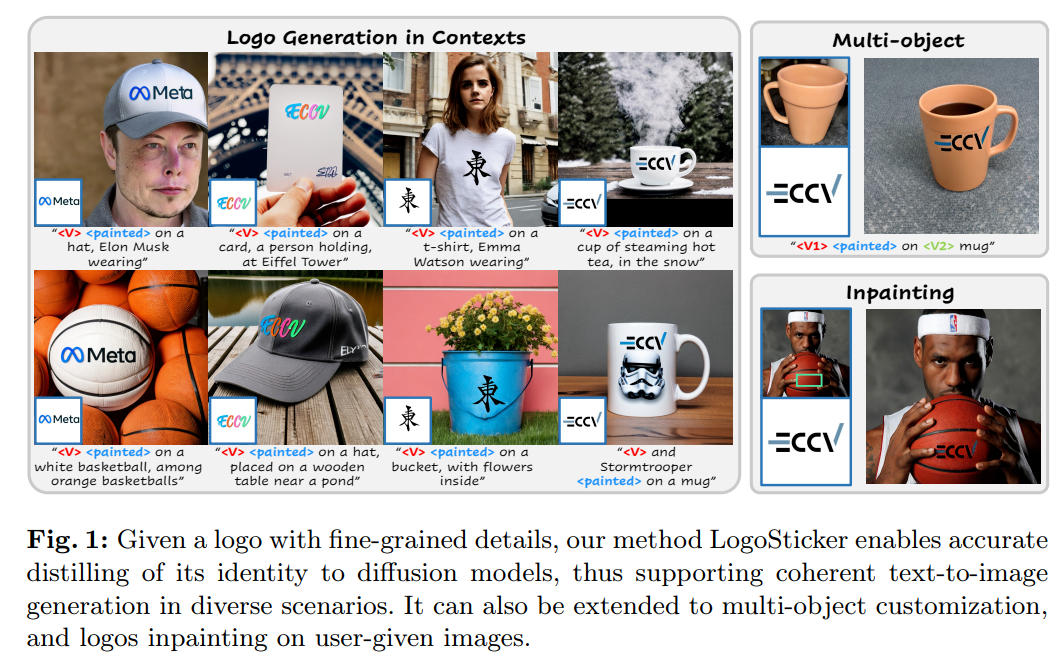

54、LogoSticker: Inserting Logos into Diffusion Models for Customized Generation

文生图模型定制的进展很大程度上局限于广泛常见的目标对象,这些对象可以通过模型充分的共享先验知识相对容易地学习。相反,以独特图案和文本元素为特征的logo很难在扩散模型中建立共享知识。

为弥补这一差距,引入了logo insertion任务。目标是将logo插入扩散模型,并使其在不同的环境中无缝合成。提出LogoSticker来解决这个问题。

首先,提出了行动者-评论家关系预训练算法,解决模型在理解logo的潜在空间定位和与其他对象的交互方面的重要差距。其次,提出一种解耦的logo特征学习算法,实现logo的精确定位和特征提取。

LogoSticker可以在不同的语境下准确和谐地生成logo。全面验证了LogoSticker在定制方法和大型模型(如DALLE 3)上的有效性。https://mingkangz.github.io/logosticker/

55、Photorealistic Object Insertion with Diffusion-Guided Inverse Rendering

对真实场景图像中虚拟对象的正确插入需要深入理解场景的光照、几何和材质以及图像形成过程。尽管最近的大规模扩散模型展示出强大的生成和修补能力,但当前模型不足以在单个图片中足够“理解”场景以生成一致的光照效果(阴影、明亮反射等),同时保留合成对象的身份和细节。

提出使用个性化的大规模扩散模型作为物理反渲染过程的指导。方法恢复场景光照和色调映射参数,允许在室内或室外场景的单帧或视频中逼真地组合任意虚拟对象。基于物理的流水线进一步实现了自动材质和色调映射的细化。https://research.nvidia.com/labs/toronto-ai/DiPIR/

56、RegionDrag: Fast Region-Based Image Editing with Diffusion Models

基于点拖动的图像编辑方法,如DragDiffusion,吸引了相当多的关注。然而,点拖动方法存在计算开销大和对用户意图的错误解释问题,这是由于基于点的编辑指令的稀疏性所致。

本文提出一种基于区域的复制粘贴拖动方法RegionDrag,以克服这些局限性。RegionDrag允许用户以处理和目标区域的形式表达其编辑指令,实现更精确的控制并减轻歧义。此外,基于区域的操作可以在一次迭代中完成编辑,比基于点拖动的方法要快得多。

还结合了注意力交换技术,以提高编辑过程的稳定性。为验证方法,用基于区域拖动指令扩展了现有的基于点拖动的数据集。实验证明,RegionDrag在速度、准确性和与用户意图的一致性方面优于现有的基于点拖动的方法。值得注意的是,RegionDrag在512×512分辨率的图像上完成编辑的时间少于2秒,比DragDiffusion快100多倍,并且表现更好。https://github.com/Visual-AI/RegionDrag

57、TurboEdit: Instant text-based image editing

本文在少步扩散模型的背景下解决了精确图像inversion和解耦图像编辑的挑战。引入了一种基于编码器的迭代inversion技术。inversion网络以输入图像和上一步重建图像为条件,允许纠正下一个重建朝向输入图像。演示了在少步扩散模型中如何通过条件生成(自动生成的)详细文本提示轻松实现解耦控制。

为了操纵inversion图像,固定噪声图并修改文本提示中的一个属性(手动或通过基于LLM驱动的指令编辑),产生一个类似于输入图像但只改变一个属性的新图像。它还可以进一步控制编辑强度并接受指导性文本提示。方法实现了实时逼真的基于文本引导的图像编辑,不仅速度快,而且在多步扩散编辑技术上明显优于现有技术。

二十五、图像分割

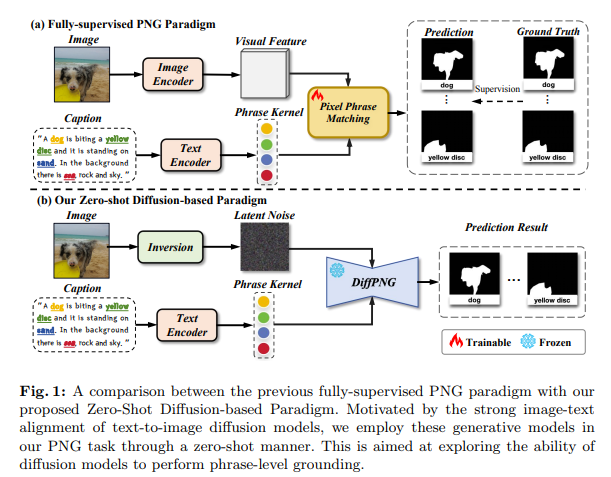

58、Exploring Phrase-Level Grounding with Text-to-Image Diffusion Model

最近,扩散模型在视觉理解上表现出越来越强大的能力。通过利用基于提示的学习构建句子,这些模型在分类和视觉grounding任务中展示了出色的能力。然而,现有方法主要展示了它们执行句子级定位的能力,而未充分探索利用语境信息进行短语级理解的潜力。

本文利用Panoptic Narrative Grounding(PNG)作为代理任务进一步研究这一能力。PNG旨在根据给定文本中提到的多个名词短语来分割物体实例。具体来说,DiffPNG框架充分利用扩散体系结构通过将过程分解为一系列定位、分割和细化步骤来进行分割。该框架首先使用交叉注意机制识别锚点,随后利用自注意进行分割以实现零样本PNG。此外,引入了一个基于SAM的细化模块,以提高分割质量。

在PNG数据集上进行的大量实验表明,DiffPNG在零样本PNG任务设置中取得了强大的表现,从而确切证明了扩散模型在具有上下文感知的短语级理解方面的能力。https://github.com/nini0919/DiffPNG

二十六、图像组合

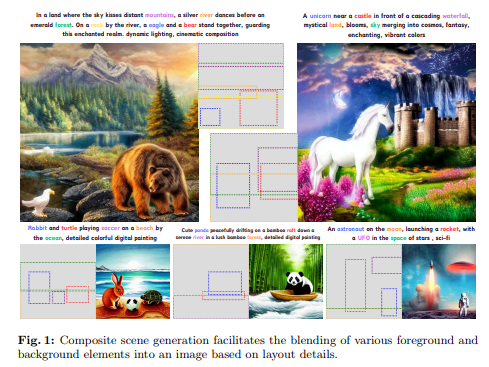

59、Training-free Composite Scene Generation for Layout-to-Image Synthesis

文本到图像扩散模型的突破已显著推动了从文本描述生成高保真、逼真图像的进展。然而这些模型难以从文本中解释空间布局,从而阻碍了它们生成具有精确空间配置的图像的能力。

为弥合这一差距,布局到图像生成已经成为一个有前途的方向。然而,基于训练的方法受限于对大量标注数据集的需求,导致了高昂的数据获取成本和局限性概念范围。相反,基于无训练的方法面临着在复杂构图中准确定位和生成语义相似对象的挑战。

本文介绍了一种新的无训练方法,旨在在扩散条件化阶段解决对抗语义交叉。通过利用选择性采样改进intra-token loss,以及通过关注力重新分配增强扩散过程,提出两个新约束:1) 解决token之间冲突的inter-token约束,以确保准确的概念合成;和2) 改善像素到像素关系的自注意约束。

评估证实了利用布局信息指导扩散过程的有效性,生成内容丰富、具有增强保真度和复杂性的图像。https://github.com/Papple-F/csg

二十七、异常检测

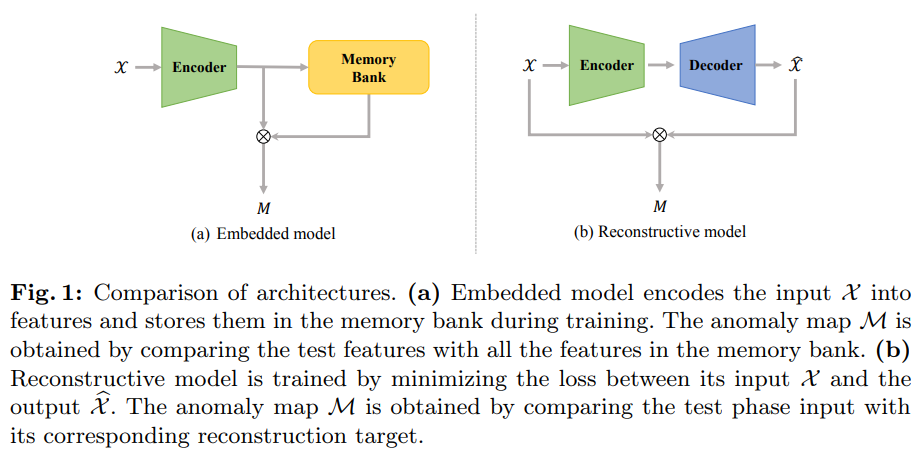

60、R3D-AD: Reconstruction via Diffusion for 3D Anomaly Detection

在精密制造中,3D异常检测在监测零部件的局部固有缺陷中起着至关重要的作用。基于嵌入和基于重建的方法是最流行和最成功的方法之一。然而,当前方法的实际应用存在两个主要挑战:1)嵌入模型由于内存结构而遭受严重的计算和存储限制;2)基于MAE机制的重建模型无法检测未掩盖区域中的异常。

本文提出R3D-AD,用扩散模型重建异常点云进行精准的3D异常检测。方法利用扩散过程的数据分布转换来完全模糊输入的异常几何结构。它逐步学习严格的点级位移行为,系统地纠正异常点。为增加模型的泛化能力,进一步提出一种名为Patch-Gen的新的3D异常模拟策略,生成逼真且多样的缺陷形状,减小了训练和测试之间的领域差距。

R3D-AD确保均匀的空间变换,通过距离比较直接生成异常结果。大量实验证明,R3D-AD胜过先前现有的最先进方法,在Real3D-AD数据集上实现了73.4%的图像级AUROC,以及在Anomaly-ShapeNet数据集上实现了74.9%的图像级AUROC,并具有异常的出色效率。https://zhouzheyuan.github.io/r3d-ad

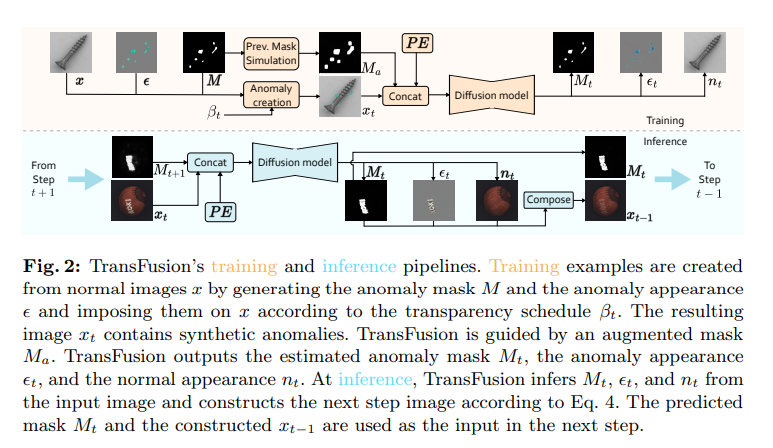

61、TransFusion – A Transparency-Based Diffusion Model for Anomaly Detection

在制造检查中,表面异常检测是一个至关重要的组成部分。当前的判别方法采用了由重构网络和依赖重构输出的判别网络组成的两阶段体系。目前使用的重建网络经常产生质量较差的重建,要么仍然包含异常,要么在无异常区域缺乏细节。判别方法对于一些重建网络失败都是健壮的,这表明判别网络学习到了重构网络忽略的强正常外观信号。

本文将两阶段架构重新构造为允许重建和定位之间信息交换的单阶段迭代流程。提出了一种新的基于透明度的扩散过程,其中异类区域的透明度逐步增加,准确恢复其正常外观,同时利用先前步骤的局部线索保持无异常区域的外观。将所提出的过程实现为TRANSparency DifFUSION(TransFusion),一种新的判别性异常检测方法,在VisA和MVTec AD数据集上均取得了最先进的性能,分别为98.5%和99.2%的图像级AUROC。https://github.com/MaticFuc/ECCV_TransFusion

二十八、字体生成

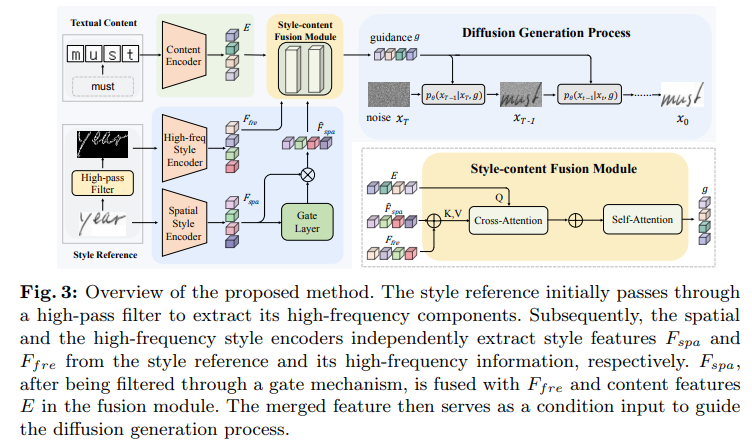

62、One-DM: One-Shot Diffusion Mimicker for Handwritten Text Generation

现有的手写文本生成方法,通常需要超过十个手写样本作为样式参考。然而,在实际应用中,用户倾向于更喜欢仅使用单个参考样本操作的手写生成模型,因其便利性和高效性。这种被称为“单样本生成”的方法极大简化了流程,但由于从单个样本准确捕捉写手风格的困难性,尤其是在提取字符边缘的细节时,面对稀疏前景和不必要背景噪音。

为解决这个问题,提出一种单样本生成模拟扩散器(One-DM),以仅一个参考样本生成可以模仿任何书法风格的手写文本。受到个别样本的高频信息通常包含独特的风格模式(例如,字符倾斜和字母连接),开发一个新的风格增强模块,通过合并单个样本的高频成分来改进风格提取。然后,将风格特征与文本内容融合为扩散模型的融合条件,以引导生成高质量的手写文本图像。

实验表明方法可成功生成多种语言的手写脚本,甚至在使用超过十个样本的先前方法的情况下也可以胜过这些方法。https://github.com/dailenson/One-DM

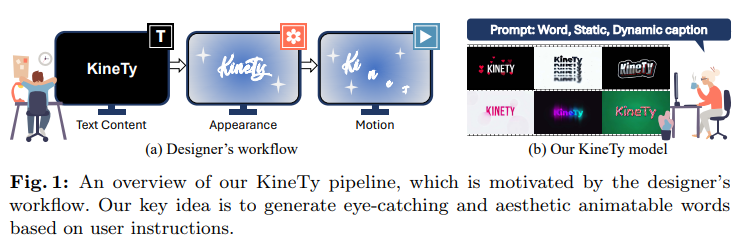

63、Kinetic Typography Diffusion Model

本文介绍一种用于生成用户喜爱的可动态排版的“文本内容”的逼真动态排版方法。借鉴最新的引导视频扩散模型的进展,以实现视觉上令人愉悦的文本外观。

为此,首先构建了一个动态排版数据集,包括约60万个视频。数据集由专业动态图形设计师设计的584个模板的各种组合组成,并涉及更改每个字母的位置、字形和大小(例如,飞行、毛刺、色差、反射效果等)。接下来,为动态排版提出了一个视频扩散模型。为此,有三个要求:美学外观、动态效果和可读文本。本文确定这些要求。为此,提出用作视频扩散模型的空间和时间指导的静态和动态字幕。静态字幕描述视频的整体外观,如颜色、纹理和字形,代表每个字母的形状。动态字幕考虑字母和背景的移动。通过零卷积增加了一种额外的指导,以确定视频中应该可见哪些文本内容。将零卷积应用于文本内容,并将其施加在扩散模型上。最后,字形损失仅最小化预测文字与实际文字间的差异,以使预测的文字可读。

实验证明模型根据文本提示生成具有可读性和艺术性的动态排版视频。https://github.com/SeonmiP/KineTy

二十九、3D

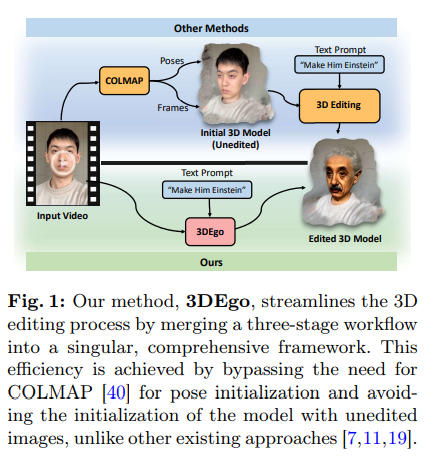

64、3DEgo: 3D Editing on the Go!

提出3DEgo,解决一个新问题,即通过文本提示指导从单目视频直接合成逼真的3D场景。传统方法通过一个三阶段过程构建一个文本条件的3D场景,涉及使用诸如COLMAP的Structure-from-Motion(SfM)库进行姿态估计,使用未编辑的图像初始化3D模型,并通过迭代地使用编辑后的图像更新数据集,以实现文本保真度的3D场景。

通过克服对COLMAP的依赖和消除模型初始化的成本,将传统的多阶段3D编辑过程简化为单阶段工作流程。采用扩散模型在创建3D场景之前编辑视频帧,包括设计的噪声融合模块,以增强多视图编辑的一致性,这一步骤不需要额外训练或微调T2I扩散模型。3DEgo利用3D高斯扩散来从多视角一致的编辑帧创建3D场景,利用固有的时间连续性和显式点云数据。

3DEgo在各种视频来源上的编辑精度、速度和适应性,通过对六个数据集进行全面评估来验证,包括自建的GS25数据集。https://3dego.github.io/

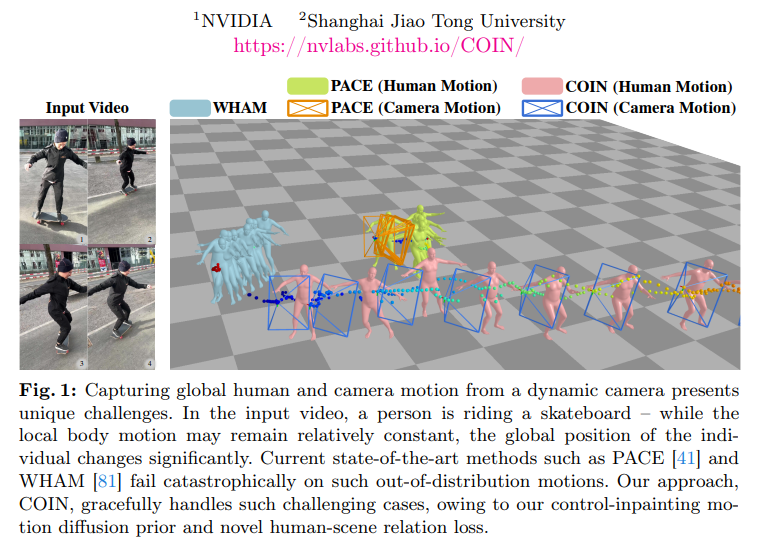

65、COIN: Control-Inpainting Diffusion Prior for Human and Camera Motion Estimation

从移动相机中估计全局人类运动,由于人类运动和相机运动的耦合而具有挑战性。为减轻这种模糊,现有方法利用学习的人类运动先验,然而这经常导致运动过度平滑和不对齐的2D投影。为解决这一问题,提出COIN,一种控制-修补运动扩散先验,使得可以对人类和相机运动进行细粒度控制以解耦。

尽管预训练的运动扩散模型编码了丰富的运动先验,但难以利用此类知识来指导从RGB视频中对全局运动的估计。COIN引入一种新的控制-修补评分蒸馏抽样方法,以确保扩散先验中的控制-修补分数对齐、一致和高质量,同时在一个联合优化框架中。此外引入一个新的人类-场景关系损失,通过在人类、相机和场景之间强制一致性,减轻尺度模糊。

针对三个具有挑战性的基准测试,实验证明COIN有效性,在全局人类运动估计和相机运动估计方面优于最先进方法。https://nvlabs.github.io/COIN/

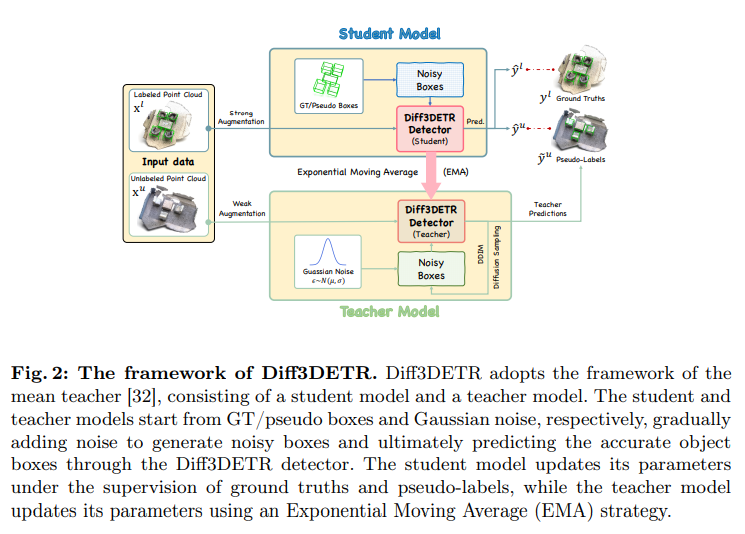

66、Diff3DETR: Agent-based Diffusion Model for Semi-supervised 3D Object Detection

三维物体检测对于理解三维场景至关重要。通常需要大量标注的训练数据,然而为点云获取逐点标注是耗时且劳动密集的。最近半监督方法通过用教师-学生框架为未标注的点云生成伪标签来缓解这一问题。然而,这些伪标签经常缺乏足够的多样性和较低质量。

为了克服这些障碍,引入一种基于代理的半监督三维物体检测模型(Diff3DETR)。具体来说,设计一个基于代理对象的查询生成器,用于生成能够有效适应动态场景的对象查询,同时在采样位置与内容嵌入之间取得平衡。此外,一个基于框的去噪模块利用了DDIM去噪过程和transformer解码器中的远程注意力,逐步精化边界框。

在ScanNet和SUN RGB-D数据集上进行的广泛实验表明,Diff3DETR优于现有半监督三维物体检测方法。

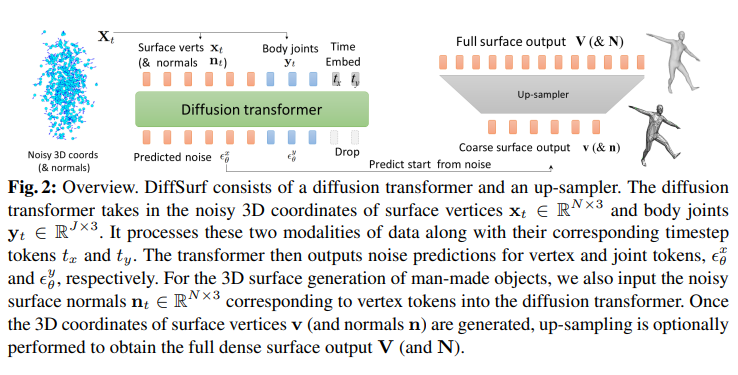

67、DiffSurf: A Transformer-based Diffusion Model for Generating and Reconstructing 3D Surfaces in Pose

本文提出DiffSurf,基于transformer的去噪扩散模型,用于生成和重建三维表面。具体来说,设计了一个扩散transformer架构,用于从嘈杂的三维表面顶点和法线预测噪声。借助这种架构,DiffSurf能够生成各种姿势和形状的三维表面,例如人体、手部、动物和人造物体。

此外,DiffSurf具有通用性,可以解决包括变形、体形变化和将三维人体网格拟合到二维关键点在内的各种三维下游任务。在三维人体模型基准上的实验结果表明,DiffSurf可以生成具有更大多样性和更高质量的形状,优于先前的生成模型。此外,当应用于单图像三维人体网格恢复任务时,DiffSurf以接近实时的速率达到可与先前技术相媲美的精度。https://github.com/yusukey03012/DiffSurf

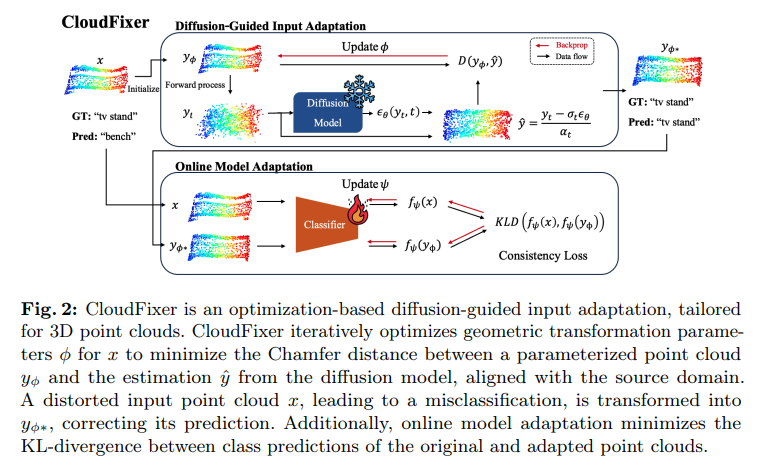

68、CloudFixer: Test-Time Adaptation for 3D Point Clouds via Diffusion-Guided Geometric Transformation

由于各种障碍(如遮挡、有限分辨率和尺度变化)导致的实际传感器捕获的3D点云经常包含嘈杂点。虽然在 2D 领域中的测试时适应(TTA)策略已经在该问题上显示出有希望的结果,但是将这些方法应用于 3D 点云的情况仍未得到充分探讨。

在 TTA 方法中,一种输入适应方法直接将测试实例通过预训练扩散模型转换为源领域,在 2D 领域已被提出。尽管在实际情况下其对 TTA 的性能表现鲁棒,但是简单地将其应用到 3D 领域可能并不是最佳选择,因为忽略了点云的固有特性,以及其高昂的计算成本。

受到这些限制的启发,提出CloudFixer,一种专为 3D 点云量身定制的测试时输入适应方法,采用预训练扩散模型。具体来说,CloudFixer 通过优化几何转换参数,利用点云的几何属性精心设计的目标来提高计算效率。此外,通过避免通过扩散模型进行反向传播和耗时的生成过程,显著提高计算效率。此外,提出了一个在线模型适应策略,通过将原始模型预测与经过调整的输入的预测进行对齐。实验展示 CloudFixer 在各种 TTA 基线上的优越性。https://github.com/shimazing/CloudFixer

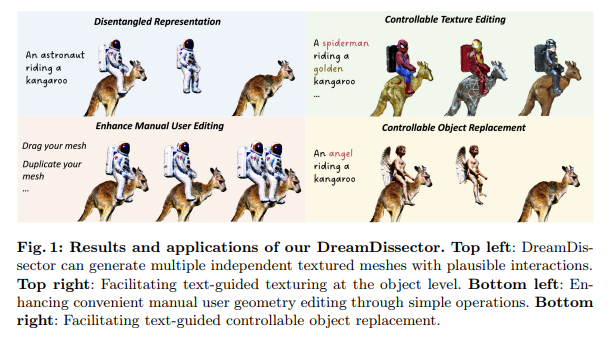

69、DreamDissector: Learning Disentangled Text-to-3D Generation from 2D Diffusion Priors

最近,文本到三维生成取得显著进展。为增强其在现实应用中的实用性,关键是生成具有相互作用的多个独立对象,类似于2D图像编辑中的图层合成。然而,现有的文本到三维方法在这一任务上存在困难,因为它们旨在生成非独立对象或缺乏空间合理互动的独立对象。

为解决这个问题,提出DreamDissector,一种能够生成具有交互作用的多个独立对象的文本到三维方法。DreamDissector接受一个多对象文本到三维NeRF作为输入,并生成独立的有纹理的网格。为实现这一点,引入神经类别场(NeCF)来解耦输入NeRF。此外,提出Category Score Distillation Sampling (CSDS),通过深度概念挖掘(DCM)模块实现,以解决扩散模型中的概念差距问题。通过利用NeCF和CSDS,可有效从原始场景中导出子NeRF。进一步细化增强几何和纹理。

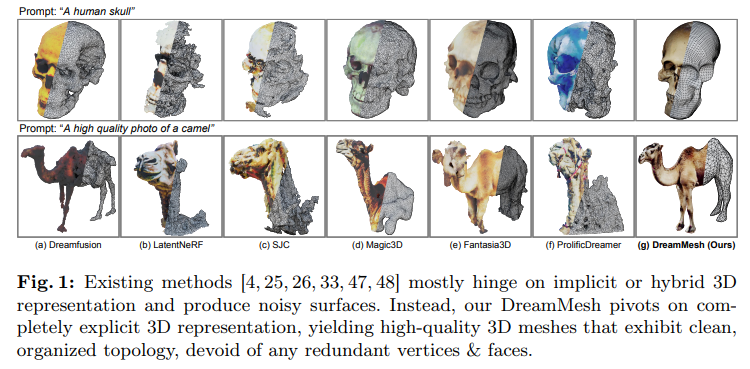

70、DreamMesh: Jointly Manipulating and Texturing Triangle Meshes for Text-to-3D Generation

用强大的2D扩散模型学习Radiance Fields(NeRF)在文本到3D生成方面变得流行起来。然而,NeRF的隐式3D表示缺乏对网格和表面上的纹理的显式建模,这种表面未定义的方式可能会导致问题,例如具有模糊纹理细节或交叉视图不一致的嘈杂表面。

为缓解这一问题,提出DreamMesh,一种新的文本到3D架构,侧重于定义良好的表面来生成高保真的显式3D模型。在技术上,DreamMesh利用独特的由粗到精的方案。实验证明,DreamMesh在忠实生成具有更丰富文本细节和增强几何的3D内容方面明显优于当前文本到3D方法。https://dreammesh.github.io/

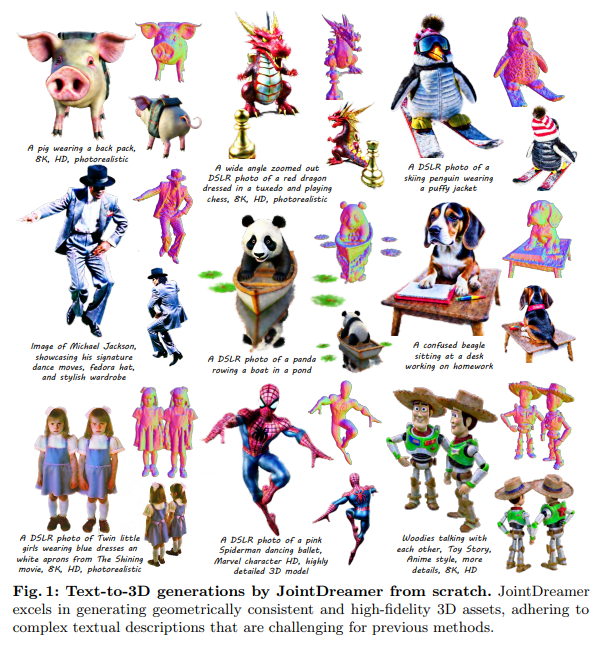

71、JointDreamer: Ensuring Geometry Consistency and Text Congruence in Text-to-3D Generation via Joint Score Distillation

经过良好训练的2D扩散模型在文本到三维生成中显示出巨大潜力。然而,这种范式将视角不可知的2D图像分布蒸馏为每个视角独立的3D表示的渲染分布,忽略了视角之间的一致性,导致生成中的3D不一致性。

本文提出Joint Score Distillation (JSD),一个确保一致3D生成的新范式。具体而言,建立了联合图像分布,引入能量函数来捕捉扩散模型中去噪图像之间的一致性。然后,在渲染的多个视角上推导联合分数蒸馏,而不是SDS中的单个视角。此外,实例化了三个通用的视角感知模型作为能量函数,展示了与JSD的兼容性。从经验上看,JSD明显缓解了SDS中的3D不一致性问题,同时保持文本的一致性。

JointDreamer在文本到三维生成中建立了一个新的基准,具有88.5%的CLIP R-Precision和27.7%的CLIP分数。https://jointdreamer.github.io/

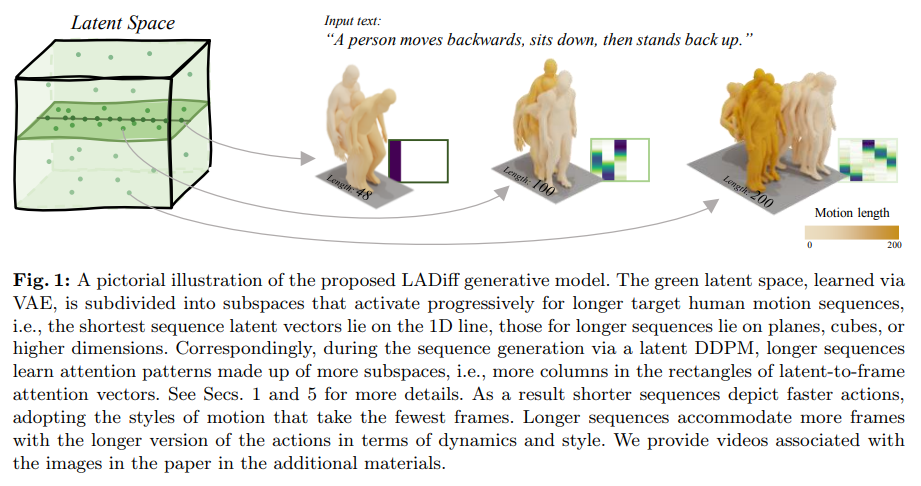

72、Length-Aware Motion Synthesis via Latent Diffusion

合成人类动作的目标持续时间是一个关键属性,需要对动作动态和风格进行建模控制。加快动作表现并不仅仅是加速它。然而,针对人类行为合成的现有技术在目标序列长度控制上存在局限。

从文本描述生成长度感知的3D人体运动序列的问题,提出一个新的模型来生成可变目标长度的动作,将其称为“Length-Aware Latent Diffusion”(LADiff)。LADiff包括两个新模块:1)一个长度感知变分自编码器,用于学习具有长度相关潜在码的运动表示;2)一个符合长度的潜在扩散模型,用于生成随着所需目标序列长度增加而增加细节丰富度的动作。在HumanML3D和KIT-ML两个建立的动作合成基准上,LADiff在大多数现有动作合成指标上显著优于现有技术。https://github.com/AlessioSam/LADiff

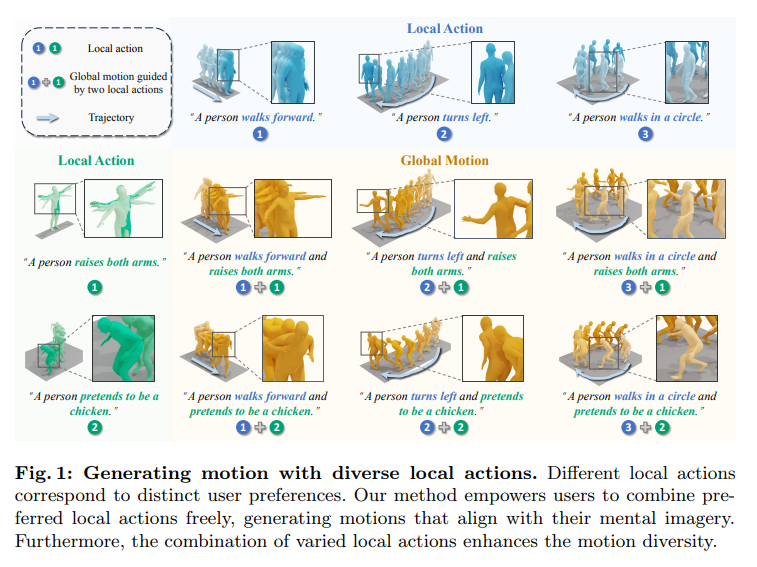

73、Local Action-Guided Motion Diffusion Model for Text-to-Motion Generation

文本到动作生成,不仅需要将局部动作与语言进行基础接触,还需要无缝地融合这些个别动作来综合多样且逼真的整体动作。然而,现有的动作生成方法主要集中于直接合成全局动作,却忽视了生成和控制局部动作的重要性。

本文提出局部动作引导的动作扩散模型,通过利用局部动作作为细粒度控制信号促进全局动作生成。具体而言,提供一种自动化的参考局部动作采样方法,并利用图注意力网络评估每个局部动作在整体动作合成中的引导权重。在合成全局动作的扩散过程中,计算局部动作梯度以提供条件指导。这种由局部到全局的范式减少了直接全局动作生成所带来的复杂性,并通过采样多样动作作为条件促进动作多样性。

在两个人类动作数据集(HumanML3D 和 KIT)上进行的大量实验表明了我们方法的有效性。此外,方法提供了在无缝组合各种局部动作和连续引导权重调整方面的灵活性,适应了各种用户偏好,可能对社区具有潜在的重要意义。https://jpthu17.github.io/GuidedMotion-project/

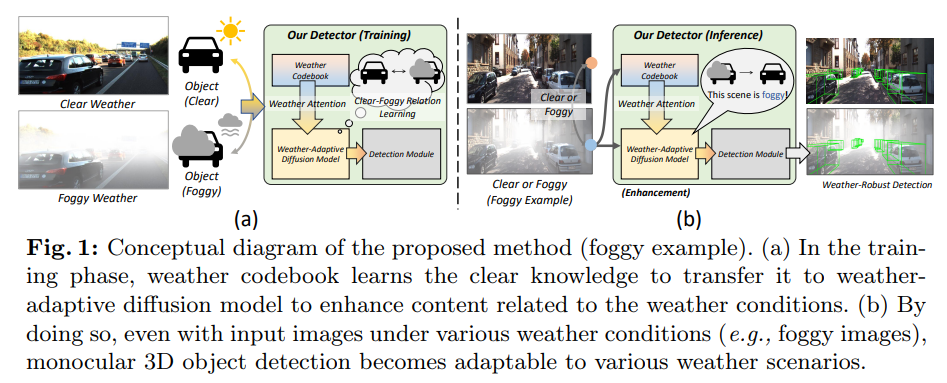

74、MonoWAD: Weather-Adaptive Diffusion Model for Robust Monocular 3D Object Detection

单目三维物体检测,是自动驾驶中一项重要而具有挑战性的任务。现有方法主要集中在理想天气条件下进行3D检测,这些情景具有清晰和最佳的可见性。然而,自动驾驶的挑战在于需要处理天气条件的变化,如有雾的天气,而不仅仅是晴天。

引入MonoWAD,一个具有天气自适应扩散模型的新型抗天气单目3D物体检测器。它包含两个组件:(1)天气codebook用于记忆晴天的知识并为任意输入生成一个天气参考特征,以及(2)天气自适应扩散模型,通过整合一个天气参考特征来增强输入特征的表示。这在指示根据天气条件需要对输入特征进行多少改进方面起着注意力作用。为了实现这一目标,引入了天气自适应增强损失,以增强特征在晴天和有雾天气条件下的表示。在各种天气条件下的大量实验表明,MonoWAD实现了抗天气的单目3D物体检测。https://github.com/VisualAIKHU/MonoWAD

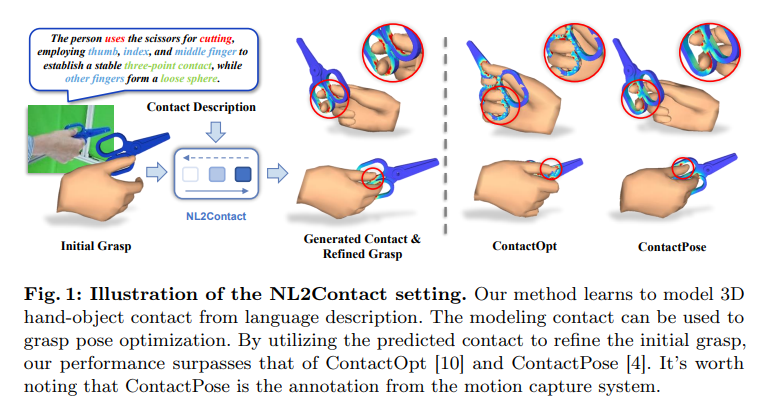

75、NL2Contact: Natural Language Guided 3D Hand-Object Contact Modeling withDiffusion Model

对于调整不准确的手部姿势并生成三维手-物体重建中的新型人类抓取,建模手部与物体之间的物理接触是标准的。然而,现有方法依赖于无法指定或控制的几何约束。本文引入了一种新的可控3D手-物体接触建模任务与自然语言描述。挑战包括:i)从语言到接触的跨模态建模复杂性,以及ii)缺乏用于接触模式的描述性文本。

为解决这些问题,提出NL2Contact,一个通过利用分层扩散模型生成可控接触的模型。给定手部和接触的语言描述,NL2Contact生成逼真和忠实的3D手-物体接触。为训练模型,构建 ContactDescribe,这是第一个带有以手为中心的接触描述的数据集。它包含由基于精心设计的提示(如抓取动作、抓取类型、接触位置、自由手指状态)的大型语言模型生成的多层次且多样化的描述。展示了模型在抓取姿势优化和新型人类抓取生成方面的应用,这两者都基于文本接触描述。

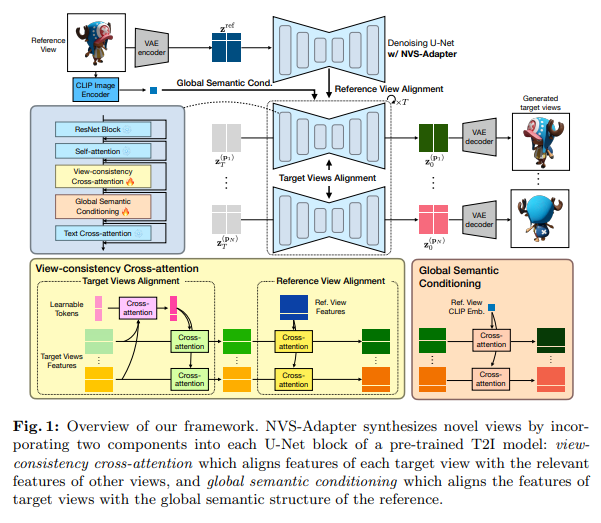

76、NVS-Adapter: Plug-and-Play Novel View Synthesis from a Single Image

最近关于单一图像的新视角合成(NVS)已经通过利用预训练文本到图像(T2I)模型的生成能力取得令人印象深刻的结果。然而,先前NVS方法需要额外优化才能使用其他即插即用的图像生成模块,如ControlNet和LoRA,因为它们微调了T2I参数。

本研究提出一个高效的即插即用适配模块 NVS-Adapter,它与现有的即插即用模块兼容而无需进行大量微调。引入目标视图和参考视图对齐,以提高多视角预测的几何一致性。实验结果表明NVS-Adapter与现有即插即用模块兼容。此外,尽管没有对预训练的T2I模型的数十亿参数进行微调,NVS-Adapter在NVS基准测试中表现优越。https://postech-cvlab.github.io/nvsadapter/

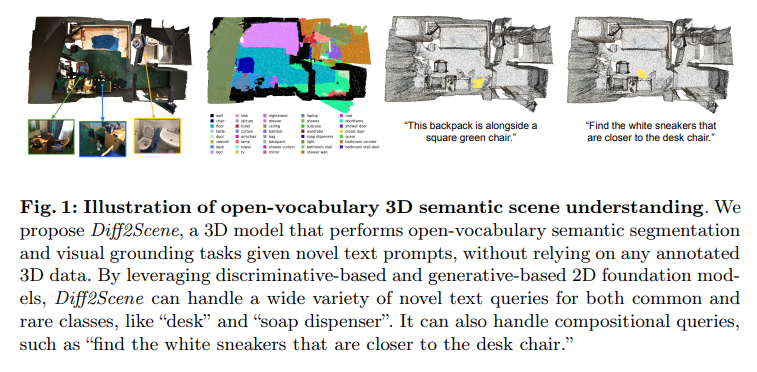

77、Open-Vocabulary 3D Semantic Segmentation with Text-to-Image Diffusion Models

这篇论文研究预先在大规模图像-文本对上进行预训练的扩散模型在开放词汇三维语义理解中的使用。提出一种新方法,即 Diff2Scene,利用文本-图像生成模型的冻结表示以及敏锐感知和几何感知蒙版,用于开放词汇三维语义细分和视觉定位任务。

Diff2Scene 摆脱了任何标注的3D数据,并有效识别了三维场景中的对象、外观、材料、位置及其组合。展示它优于竞争基线,并且较现有的方法取得了显著提升。特别是,在 ScanNet200 数据集上,Diff2Scene 将现有方法的准确率提高了12%。

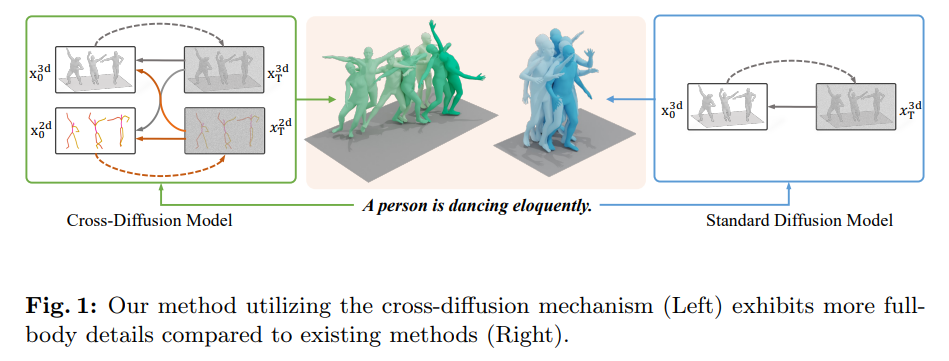

78、Realistic Human Motion Generation with Cross-Diffusion Models

这项工作介绍一种基于文本描述生成高质量人类动作的 Cross Human Motion Diffusion Model(CrossDiff3)。方法在扩散模型的训练中使用共享transformer整合了3D和2D信息,将运动噪音统一到一个特征空间中。这使得 CrossDiff 能够将特征解码为3D和2D运动表示,不管它们的原始维度如何。

CrossDiff 的主要优势在于其交叉扩散机制,允许模型在训练期间将2D或3D噪音反转为干净的运动。这种能力利用了两种运动表示中的互补信息,捕捉了仅仅依赖3D信息的模型常常错过的复杂人体运动细节。因此,CrossDiff 有效地结合了这两种表示的优势,生成更加逼真的运动序列。

在实验中,模型展示了竞争性的最先进性能,适用于文本到动作基准。此外,方法始终提供增强的运动生成质量,捕捉复杂全身运动细节。方法还适应使用在野外收集的2D运动数据而不需3D运动地面真相进行训练来生成3D运动,突显了其更广泛应用的潜力以及对现有数据资源的高效利用。https://wonderno.github.io/CrossDiff-webpage/

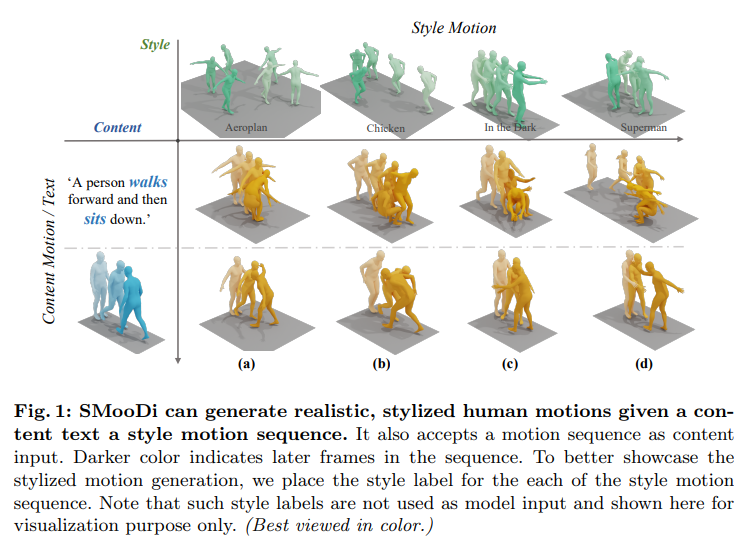

79、SMooDi: Stylized Motion Diffusion Model

引入一种新风格化运动扩散模型,名为 SMooDi,用于根据内容文字和风格运动序列生成风格化运动。与现有方法不同,现有方法要么生成多样内容的运动,要么从一个序列转移风格到另一个序列,SMooDi 可以快速地生成跨多样内容和不同风格的运动。

为此,为风格定制了一个预训练文本到动作模型。具体而言,提出风格引导来确保生成的动作与参考风格密切匹配,同时还提出了一个轻量级风格适配器,将运动引导到所需的风格,同时确保逼真性。在各种应用程序中的实验表明,框架在风格化运动生成方面优于现有方法。https://neu-vi.github.io/SMooDi/

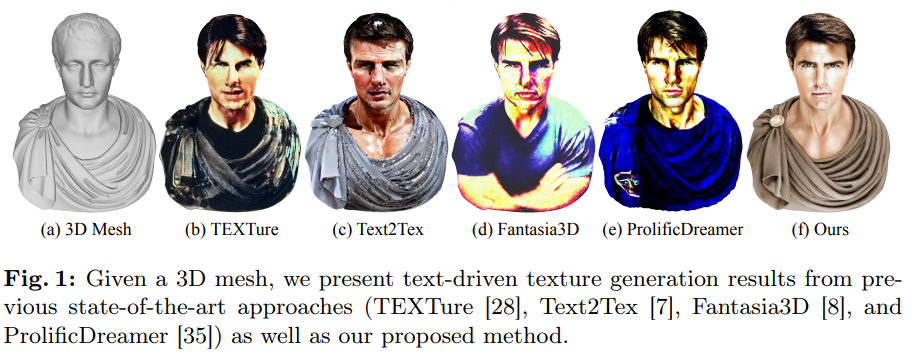

80、TexGen: Text-Guided 3D Texture Generation with Multi-view Sampling and Resampling

给定3D mesh,如何生成对应文本描述的3D纹理外观?本文提出TexGen,一个全新的多视图抽样和重新抽样框架,用于纹理生成,利用预训练的文本到图像扩散模型。为解决这些问题,提出一种关注引导的多视图抽样策略,以在视图之间广播外观信息。为保留纹理细节,开发一种噪声重新抽样技术,用于估算噪声,生成用于后续去噪步骤的输入,由文本提示和当前纹理地图指导。

通过大量的定性和定量评估,展示了方法为具有高度视图一致性和丰富外观细节的各种3D对象产生了更好的纹理质量,优于当前最先进的方法。此外,提出的纹理生成技术还可以应用于保留原始身份的纹理编辑。https://dong-huo.github.io/TexGen/

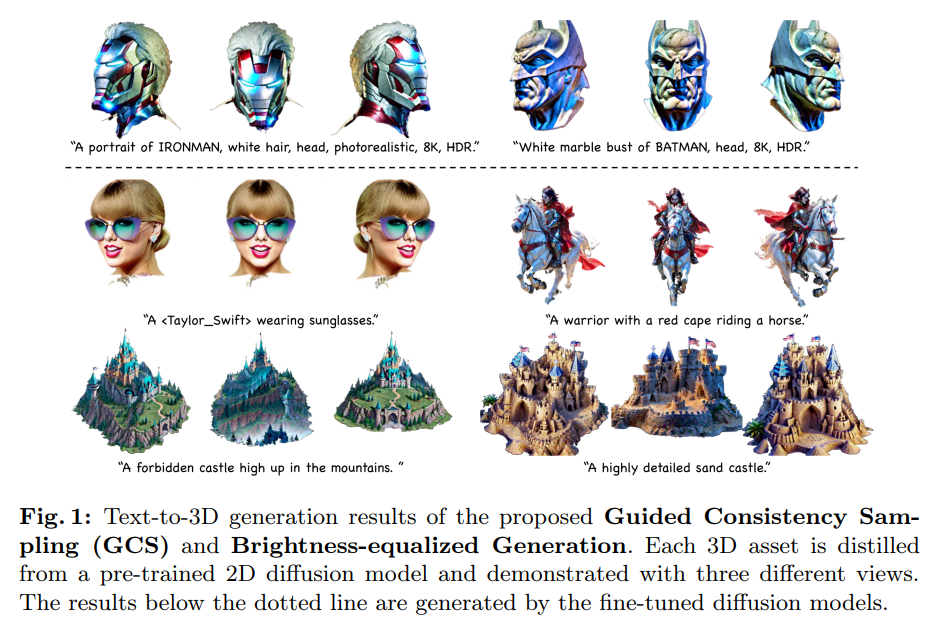

81、Connecting Consistency Distillation to Score Distillation for Text-to-3D Generation

尽管最近文本到3D生成的质量已有提高,细节级别问题和低保真度仍然存在,需进一步改进。为理解这些问题本质,通过将一致性蒸馏理论连接到评分蒸馏,对当前的评分蒸馏方法进行了彻底分析。基于通过分析获得的见解,提出一个优化框架,引导一致性抽样(GCS),并结合3DGS以减轻这些问题。

尽管最近文本到3D生成的质量已有提高,细节级别问题和低保真度仍然存在,需进一步改进。为理解这些问题本质,通过将一致性蒸馏理论连接到评分蒸馏,对当前的评分蒸馏方法进行了彻底分析。基于通过分析获得的见解,提出一个优化框架,引导一致性抽样(GCS),并结合3DGS以减轻这些问题。

此外,观察到生成的3D资产渲染视图中持续存在的过度饱和现象。通过实验,发现这是由于在优化过程中3DGS中不必要的累积亮度引起的。为减轻这一问题,在3DGS渲染中引入了一种亮度均衡生成(BEG)方案。实验结果表明,方法生成了更多细节和更高保真度的3D资产,优于目前最先进的方法。https://github.com/LMozart/ECCV2024-GCS-BEG

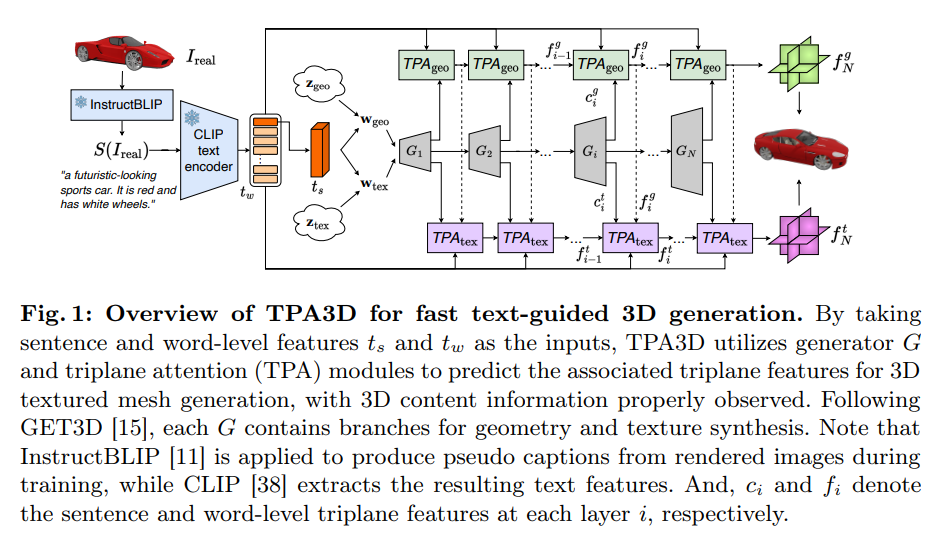

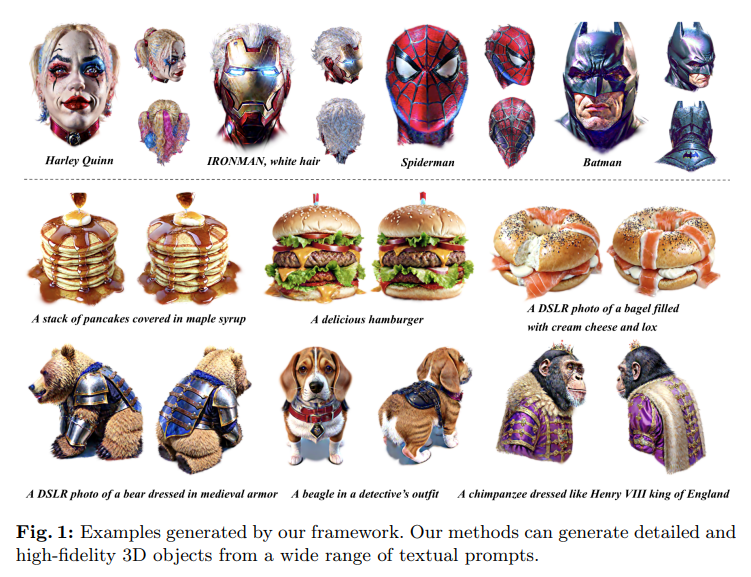

82、TPA3D: Triplane Attention for Fast Text-to-3D Generation

由于缺乏大规模文本-3D对应数据,最近的文本到3D生成方法主要依赖于利用2D扩散模型合成3D数据。由于基于扩散的方法通常需要大量的优化时间进行训练和推断,因此仍希望使用基于GAN的模型进行快速3D生成。

这项工作提出Triplane Attention用于文本引导的3D生成(TPA3D),一个端到端可训练的基于GAN的深度学习模型,用于快速文本到3D生成。通过训练观察的仅为3D形状数据及其渲染的2D图像,TPA3D旨在检索详细的视觉描述,以合成相应的3D网格数据。这是通过在提取的句子和词级文本特征上提出的注意机制实现的。

实验展示了TPA3D生成与精细描述对齐的高质量3D纹理形状,同时还能观察到令人印象深刻的计算效率。

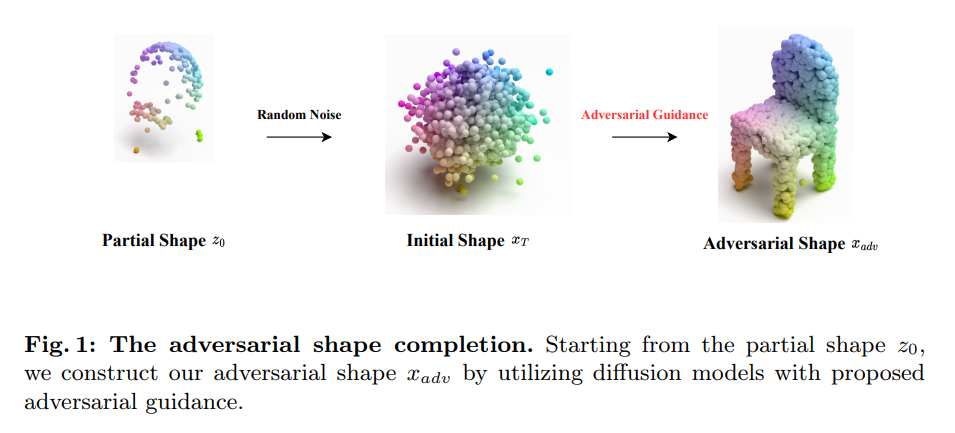

83、Transferable 3D Adversarial Shape Completion using Diffusion Models

最近的研究将几何特征和transformers纳入3D点云特征学习中,显著提高3D深度学习模型的性能。然而,它们对抗性攻击的韧性尚未得到彻底探索。现有的攻击方法主要集中在白盒场景,很难迁移到最近提出的3D深度学习模型。更糟糕的是,这些攻击引入了对3D坐标的扰动,生成不太现实的对抗性示例,并导致对3D对抗性防御的性能不佳。

为增强攻击的可转移性,深入研究3D点云的特征并利用模型的不确定性来更好地推断通过对点云进行随机降采样实现模型分类的不确定性。采用集成对抗引导的方法,以改善跨不同网络架构的可转移性。为了保持生成质量,仅针对点云的关键点采用对抗引导,通过计算显著性分数。

大量实验证明,提出的攻击方法在黑盒模型和防御方面优于最先进的对抗攻击方法。黑盒攻击为评估各种3D点云分类模型的韧性建立了一个新的基准。

84、VividDreamer: Invariant Score Distillation For Hyper-Realistic Text-to-3D Generation

本文介绍不变分数蒸馏(ISD),一种用于高保真度文本到3D生成的新方法。ISD旨在解决得分蒸馏抽样(SDS)中的过度饱和和过度平滑问题。通过将SDS拆分为两个组件的加权和以此来解决这些问题。实验发现,过度饱和源于大的无分类器引导比例,过度平滑来自重构项。

为克服这些问题,ISD利用从DDIM抽样中派生的不变分数项来替代SDS中的重构项。这个操作允许利用一个中等的无分类器引导比例,并减轻与重构相关的错误,从而防止结果的过度平滑和过度饱和。

大量实验证明,方法极大地增强了SDS,并通过单阶优化产生了现实的3D物体。https://github.com/SupstarZh/VividDreamer

三十、风格迁移

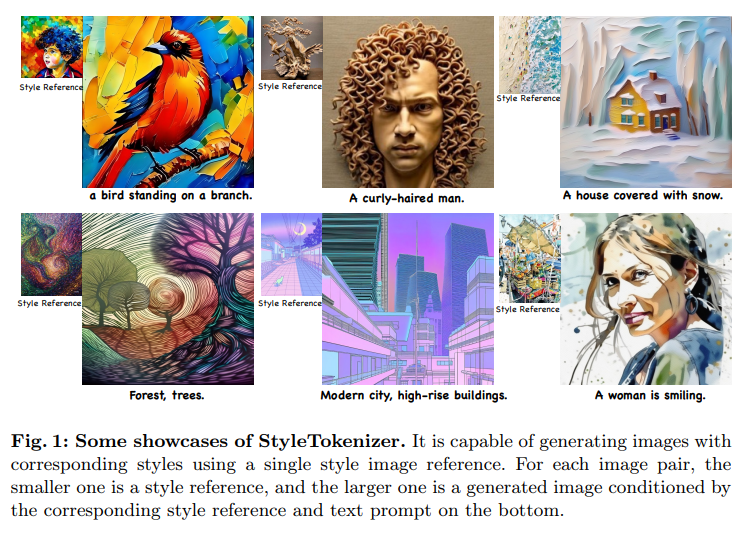

85、StyleTokenizer: Defining Image Style by a Single Instance for Controlling Diffusion Models

尽管控制扩散过程的新方法不断涌现,但在文生图中有效控制图像风格仍是一项具有挑战性的任务。许多基于适配器的方法在去噪过程中对图像表示条件进行约束,以实现图像控制。然而这些条件与词嵌入空间不对齐,导致图像和文本控制条件之间的干扰,可能会导致来自文本提示的语义信息丢失。

解决这个问题涉及两个关键挑战。首先,如何在不影响控制中文本表示的有效性的情况下注入风格表示。其次,如何从单个参考图像中获取准确的风格表示。为解决这些挑战,引入 StyleTokenizer,一种零样本风格控制图像生成方法,用风格tokenizer将风格样式表示与文本表示对齐。这种对齐有效地减小了对文本提示有效性的影响。

此外,收集了一个名为 Style30k 的标注好的风格数据集,训练一个能够准确表示风格的特征提取器,同时排除其他内容信息。实验结果表明,方法把握了参考图像的风格特征,生成与目标图像风格和文本提示一致且吸引人的图像。https://github.com/alipay/style-tokenizer

三十一、图像插值

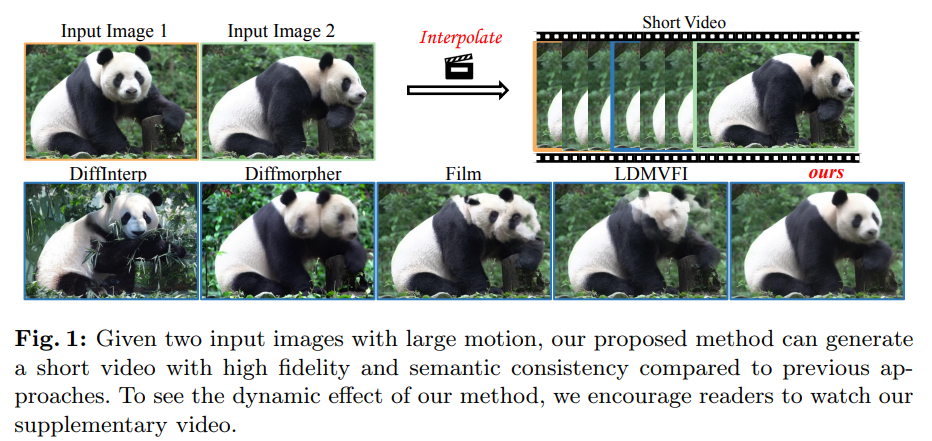

86、DreamMover: Leveraging the Prior of Diffusion Models for Image Interpolation with Large Motion

研究从带有大运动的图像对生成中间图像的问题,同时保持语义一致性。由于存在大运动,输入图像中可能缺少中间语义信息。现有方法要么局限于小运动,要么专注于拓扑相似的对象,导致内插结果中出现伪像和不一致性。

为克服这一挑战,深入研究预训练的图像扩散模型,因为它们在语义认知和表示方面具有优势,确保了与输入的缺失中间语义表示的一致表达。因此提出DreamMover,一个新的图像插值框架,具有三个主要组件:1)基于扩散模型的自然流估计器,可以隐式推理出两个图像之间的语义对应关系。2)为避免在融合过程中丢失详细信息,关键思路是在高级空间和低级空间中的两部分融合信息。3)为增强生成图像与输入之间的一致性,提出自注意力串联和替换方法。

最后提出一个具有挑战性的基准数据集InterpBench,用于评估生成结果的语义一致性。https://dreamm0ver.github.io/

关注公众号【机器学习与AI生成创作】,更多精彩等你来读

CVPR 2024 | diffusion扩散模型梳理!100+论文、40+方向!

ICCV 2023 | diffusion扩散模型方向!百篇论文

CVPR 2023 | 30个方向130篇!最全 AIGC 论文一口读完

深入浅出stable diffusion:AI作画技术背后的潜在扩散模型论文解读

深入浅出ControlNet,一种可控生成的AIGC绘画生成算法!

最新最全100篇汇总!生成扩散模型Diffusion Models

附下载 |《TensorFlow 2.0 深度学习算法实战》

《礼记·学记》有云:独学而无友,则孤陋而寡闻

点击跟进 AIGC+CV视觉 前沿技术,真香!,加入 AI生成创作与计算机视觉 知识星球!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?