kettle:pdi-ce-6.1.0.1-196

Hadoop :cdh5.11 hive 1.0

Kettle安装省略,解压就可以使用,需要把oracle 驱动包放到 D:\pdi-ce-6.1.0.1-196\data-integration\lib 下

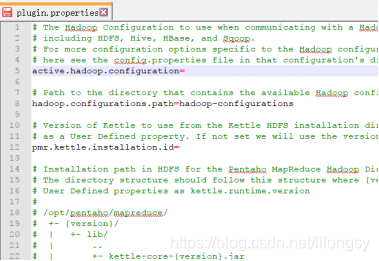

第一步:修改配置文件

D:\pdi-ce-6.1.0.1-196\data-integration\plugins\pentaho-big-data-plugin\plugin.properties 修改前:active.hadoop.configuration=

修改后:active.hadoop.configuration=cdh55

备注:对应的目录名称D:\pdi-ce-6.1.0.1-196\data-integration\plugins\hadoop-configurations

由于安装的是CDH版本,所以用cdh55,如下图所示:

第二步:复制Hadoop集群hive安装目录下的4个xml文件

替换D:\pdi-ce-6.1.0.1-196\data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\cdh55下面的4个xml文件,比如:

core-site.xml

hdfs-site.xml

hive-site.xml

yarn-site.xml

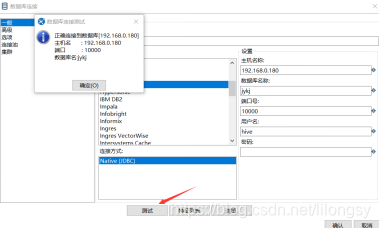

第三步:kettle连接Hadoop Hive2配置

新建转换,从oracle抽取数据到hive表,如下图所示:

配置hadoop集群主机名称,比如:192.168.0.180(集群对应的主机名称)

数据库名称:jykj(集群hive数据库对应名称)

端口号hive默认是10000,如果设置其他端口,就填写设置后的端口号

用户名:默认hive ,如果是其他用户名称,就填写设置后的名称即可

密码:如果是默认安装hive 就无密码,除非自己设置有密码

点击测试按钮,如下图所示:

配置成功后可以查看数据库对应的表,如下图所示:

Mysql连接配置(主用使用oracle)

将mysql驱动包放到D:\pdi-ce-6.1.0.1-196\data-integration\lib目录下面

重新启动Spoon.bat,配置如下图所示:

Oracle 连接配置

第四步:测试结果

如下图

**其中注意事项,oracle 里面整型和日期类型最好转换层字符类型,hive上面建表建议全部使用string数据类型,hive 表有多少个字段,oracle就要输出多少个字段,这样执行就不会出现错误。**一定要注意类型和字段。

参考

网友分享。

本文介绍如何配置Kettle版本pdi-ce-6.1.0.1-196以连接Hadoop Hive2环境。主要内容包括配置文件修改、Hadoop集群配置文件替换及Kettle中HadoopHive2连接的具体步骤。特别提示,在进行Oracle到Hive的数据迁移时,需注意数据类型的转换。

本文介绍如何配置Kettle版本pdi-ce-6.1.0.1-196以连接Hadoop Hive2环境。主要内容包括配置文件修改、Hadoop集群配置文件替换及Kettle中HadoopHive2连接的具体步骤。特别提示,在进行Oracle到Hive的数据迁移时,需注意数据类型的转换。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?