用于端到端情感三元组提取的非自回归编解码器神经网络框架

Abstract

在这篇文章中,作者提出了一个创新的编码器-解码器框架的端到端 ASTE。

- 首先,将 ASTE 任务建模为一个无序的三元组集预测问题,这是满意的指针网络的非自回归解码范式。

- 其次,提出了一种新的高阶聚合机制,充分整合的重叠结构的方面和意见条款之间的潜在的相互作用。

- 第三,引入了二分匹配损失,以便于我们的非自回归系统的训练。

基准数据集上的实验结果表明,作者提出的框架显着优于国家的最先进的方法。进一步的分析表明,该框架在处理重叠问题、缓解长距离依赖和提高解码效率方面具有优势。

Problem

- 在不同的三元组中,方面和观点术语之间有大量的重叠(根据实验,约为38%)。这种重叠情况的建模对任务性能非常重要。然而,现有的联合模型通过使用复杂增强的“BIO”标签集进行顺序标记来解决这个问题,这可能会导致标签搜索的巨大成本。

- 其次,由于顺序提取模型架构,先前的研究在很大程度上受到了长期依赖性问题的影响。虽然表填充方法可以在一定程度上处理上述两个问题,但其代价是高模型复杂度,即 O ( n 2 ) O(n^2) O(n2),从而降低解码效率。

- 第三,重叠结构共享丰富的相互作用,这可能有助于更好地诱导情绪极性(例如,具有更好的极性一致性),而现有方法尚未有效利用这些极性。例如,同一意见表达下的不同方面可能具有相同的情绪极性,但同一方面具有不同的意见表达可以具有不同的情绪倾向。

Contributions

- 作者将 ASTE 任务转换为三元组集预测问题,并使用基于指针网络的编码器-解码器框架处理它。据他们所知,他们是第一个提出了一个基于编码器-解码器的模型与指针网络的端到端的 ASTE。

- 作者提出了一种新的意见感知的高阶聚合模块,以更好地进行情感分类(SC),充分探索了重叠结构内的方面意见条款之间的潜在相互作用。

- 作者将 ASTE 建模为无序的三元组集预测,并提出使用基于变换器的指针网执行非自动解码。他们进一步引入了一个二分匹配损失训练的非自回归系统。

- 他们的系统在多个基准数据集上实现了最先进的性能。实验分析表明,与以往的方法相比,该系统在保持较强鲁棒性和较高解码效率的同时,能更好地处理重叠问题和长距离依赖问题。

Preliminary

Task Formulation

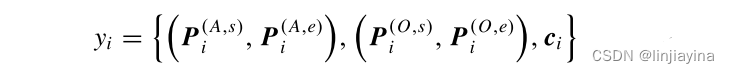

给定输入句子 S = { w 1 , . . . , w T } S =\{w_1, ... , w_T\} S={w1,...,wT},期望输出一组三元组 Y = { . . . , y i , . . . } Y =\{... , y_i , ...\} Y={...,yi,...},其中 y i = { < a m , o n , c > } ∈ A × O × C y_i =\{< a_m, o_n, c >\}∈ A × O×C yi={<am,on,c>}∈A×O×C, A = { a 1 , . . . , a M } A =\{a_1, ..., a_M\} A={a1,...,aM}是所有可能的方面项, O = { o 1 , . . . , o N } O =\{o_1, ..., o_N\} O={o1,...,oN}是相对应的观点表示, C = { P o s , N e g , N e u , ϵ } C =\{Pos, Neg, Neu, \epsilon\} C={Pos,Neg,Neu,ϵ}是对应的情感极性标签。

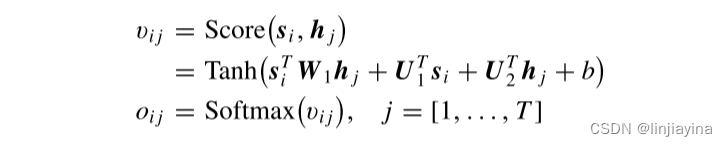

Encoder–Decoder With Pointer Network

在编码器—解码器框架中,配备有指针的解码器在每个解码帧处以最高概率从输入令牌中挑选元素。指针采用注意机制从输入序列中选择目标。技术上,给定编码器表示 H = [ h 1 , . . . , h T ] H =[h_1,...,h_T] H=[h1,...,hT] 和当前解码表示 s i s_i si,他们计算并归一化 s i s_i si 和每个 h j h_j hj 之间的相关性得分

其中

W

1

W_1

W1、

U

U

U 和

B

B

B 是参数。然后,他们将具有最大相关概率

o

i

j

o_{ij}

oij 的位置

j

j

j 作为第

i

i

i 个解码步骤的输出,形式化为

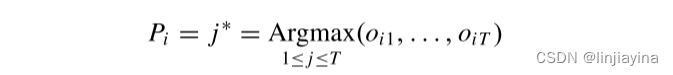

其中

P

i

P_i

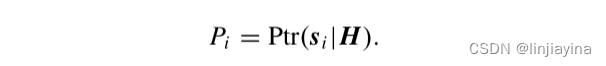

Pi 表示当前指针指向的位置。请注意,由于每个指针决策都是通过咨询所有输入令牌来做出的,因此模型可以利用全局信息。他们将指针过程总结如下:

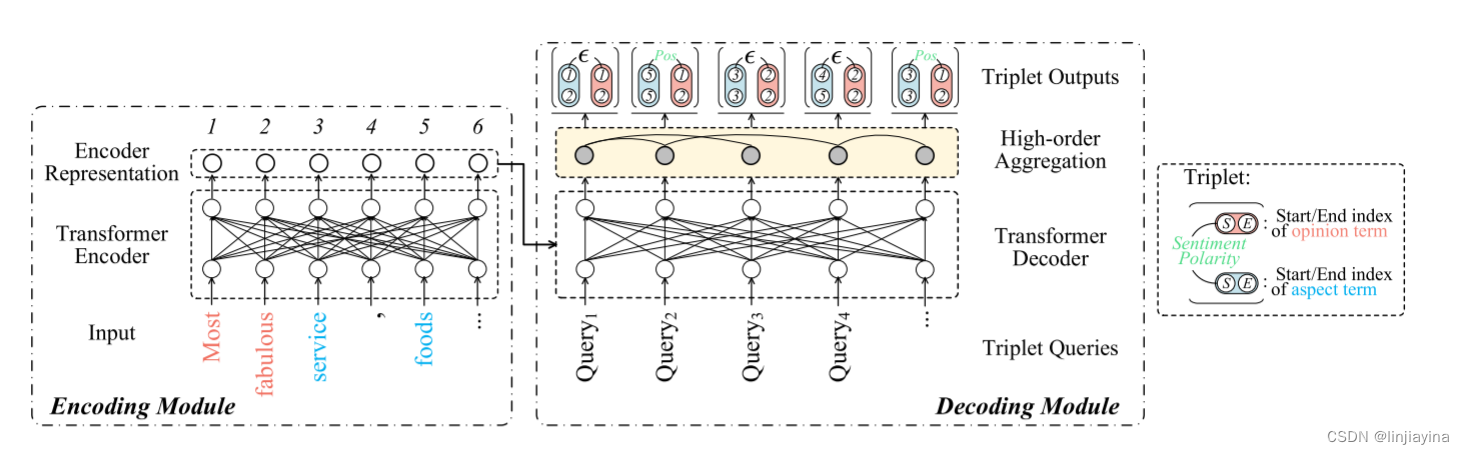

Framework

作者的目标是通过使用新的编码器-解码器框架来解决上述问题,将三元组提取建模为结构预测问题。如图所示,他们使用 Transformer 编码器来获得上下文表示。在解码器侧,所有可能的三元组将被联合产生,其中方面术语和意见术语的开始/结束边界由指针网络并行生成,并且确定相应的情感极性。特别地,所有预先识别的方面-观点对根据它们对观点的感知连接性被分组到不同的簇中,然后通过我们的高阶聚合模块进行编码和聚合,用于情感的分配。有了这个,他们的系统可以充分探索重叠结构中的方面-意见术语之间的潜在相互作用。

补充: 指针网络(Pointer Networks)是一种特殊类型的序列到序列(Seq2Seq)模型,它的设计初衷是为了处理输出序列中的元素直接对应于输入序列中特定位置元素的问题。它通过使用注意力机制(Attention Mechanism)直接产生指向输入序列中元素的指针。

Encoding

1) Input Representation

输入表示来自三个来源。作者首先从预训练的嵌入中构建每个单词

w

t

w_t

wt 的向量表示

x

t

w

x_t^w

xtw 。他们还将每个单词的绝对位置表示为用于增强的嵌入

x

t

p

x_t^p

xtp。而且,使用卷积神经网络(CNN)将每个单词内部的字符编码为字符级单词

x

t

c

x_t^c

xtc 。最后,总的输入表示是所有上述元素的串联

其中

[

;

]

[;]

[;] 表示连接操作。

2) Contextual Encoder

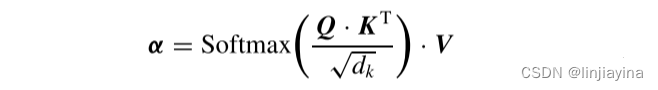

Transformer 在学习每对输入单词之间的交互方面表现突出,从而获得更好的上下文单词表示。他们在这里使用多层 Transformer 编码器。从技术上讲,Transformer attention 通过自我注意机制计算 K 和 Q 之间的相关性

其中

d

k

d_k

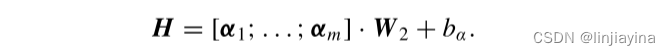

dk 是缩放因子,并且查询 Q、值 V 和键 K 与输入表示 x 相同。所有由 m 个平行的注意力头产生的向量串联在一起,形成一个统一的表示

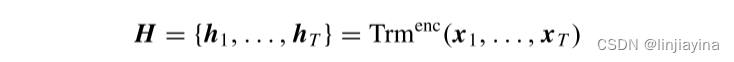

他们将所有编码步骤总结如下:

其中

h

i

h_i

hi 是期望的上下文编码表示。

Decoding

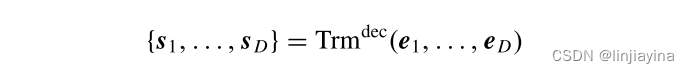

在对应的解码器帧处的每个步骤输出对应的解码表示 s i s_i si。他们将 ASTE 任务视为一个无序集预测问题,因此需要解码器以并行方式产生所有输出三元组。此外, Transformer 成为他们的首选,因为它能够执行非自回归解码。Transformer 解码器还可以从具有最大信息集成的双向上下文中检索特征。

1) Decoding Input

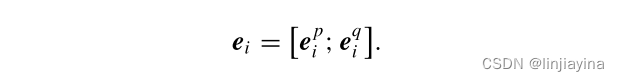

他们的非自回归 Transformer 解码器通过获取所有解码输入,一次性生成所有输出。代替使用来自编码器侧的表示,他们以固定大小 D 维护一组三元组查询作为解码输入。尺寸 D 是指他们期望系统生成的三重态的最大体积。他们预先将 D 设置为显著大于句子中可能的三元组的数量。我们将三元组查询 { q 1 , . , q D } \{q_1,.,q_D\} {q1,.,qD} 转换为可训练向量嵌入 { e 1 q , . . . , e D q } \{e_1^q,...,e_D^q\} {e1q,...,eDq}。

为了进一步增强指针的能力,他们添加另一组位置嵌入

{

e

1

p

,

.

,

e

D

p

}

\{e_1^p,.,e_D^p\}

{e1p,.,eDp},以与编码部分相同的方式导出。他们将三元组查询嵌入和位置嵌入串联起来作为统一的解码输入

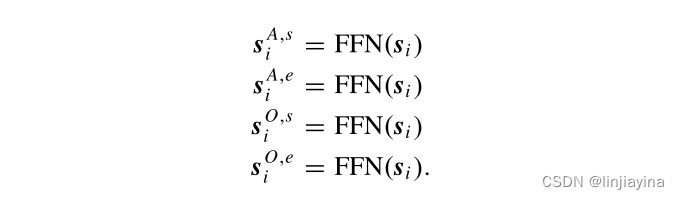

2) Nonautoregressive Pointer Decoder

他们使用 n 层堆叠的 Transformer 作为非自回归解码器

其中

s

i

s_i

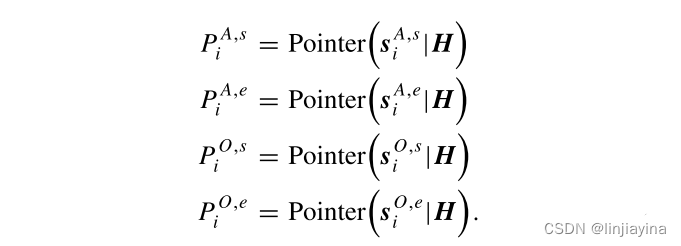

si 是解码表示。每个帧(即,Transformer 解码器中的指针)独立地导出一对方面(A)和意见(O)项,其中每个项涉及开始(S)和结束(E)索引以对应于某个输入标记WT的位置。具体而言,总共有四个独立的位置,即,

P

(

A

,

s

)

P^{(A,s)}

P(A,s),

P

(

A

,

e

)

P^{(A,e)}

P(A,e),

P

(

O

,

s

)

P^{(O,s)}

P(O,s)和

P

(

O

,

e

)

P^{(O,e)}

P(O,e)。

他们首先通过使用四个单独的前馈网络(FFN)对解码表示

s

i

s_i

si 执行非线性变换以获得独立的位置特征表示

然后,他们将指针计算放在这些位置特征表示上以输出这些位置

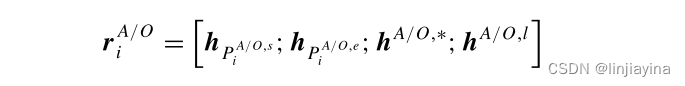

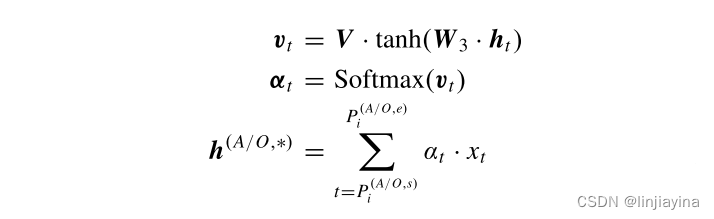

他们通过位置指数来分解方面和意见术语,并进一步构造这些术语的表示

其中

h

P

i

(

/

O

,

s

/

e

)

h_{P_i^{(/O,s/e)}}

hPi(/O,s/e) 是术语的边界表示,

h

A

/

O

,

l

h^{A/O,l}

hA/O,l 是跨度宽度的嵌入向量,

h

A

/

O

,

∗

h^{A/O,*}

hA/O,∗ 是术语标记上的跨度注意力表示

其中

W

3

W_3

W3 和

V

V

V 是参数。

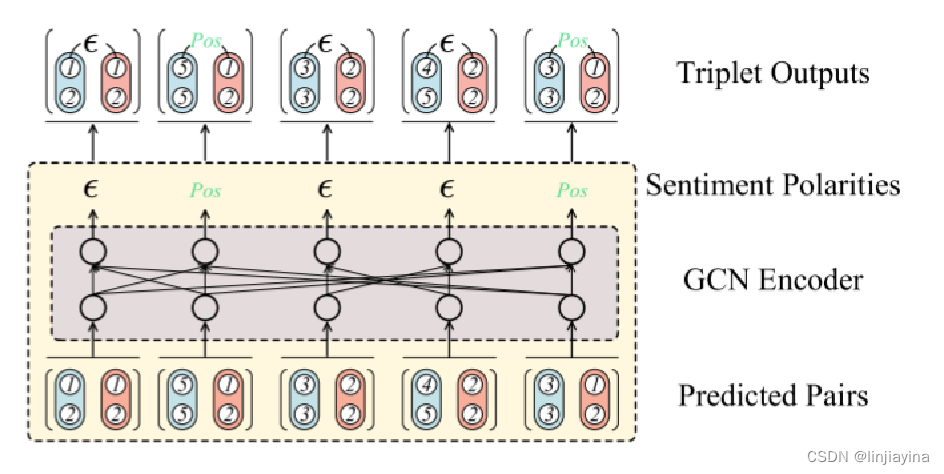

3) High-Order Aggregation Layer

非自回归解码器预测的方面意见的条款对后,他们接下来执行的情感极性分类为每一对。正如他们在第一节中所呈现的,方面和观点术语很有可能相互重叠。这些重叠的方面意见对可以共享丰富的交互信息,这可能提供线索来预测情感极性。例如论文里图1中的第三句(c),由意见词“nice”触发的所有方面都持有相同的积极情绪,而在意见表达“too steep price”下的那些方面共享相同的消极情绪。

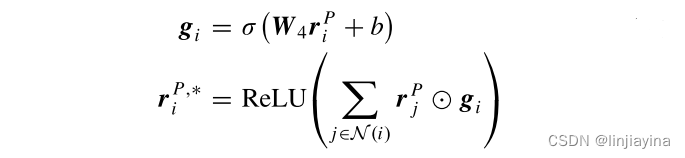

在这里,他们提出了一个高阶聚合模块,充分利用结构内的底层公共信息。从技术上讲,他们将每个方面-意见对(记为

π

i

π_i

πi)视为一个节点,每当

π

i

π_i

πi 中的一个术语(方面或意见术语)同时出现在另一个对

π

j

π_j

πj 中时,他们在这两个节点之间分配一条边。通过这种方式,他们形成了一个无向图

G

=

(

V

,

E

)

G =(V,E)

G=(V,E),其中 V 是一组成对的节点,E 是节点之间的一组双向边。他们首先将方面术语和意见术语的表示连接为对节点表示

r

i

P

=

[

r

i

A

;

r

i

O

]

r_i^P =[r_i^A ; r_i^O ]

riP=[riA;riO],然后采用 GCN 编码器来对图 G 进行建模

此后,他们将 softmax 层放在结果对表示上,即,

c

=

S

o

f

t

m

a

x

(

r

i

P

,

∗

)

c = Softmax(r_i^{P,*})

c=Softmax(riP,∗),以生成第i个三元组的最终情感标签。

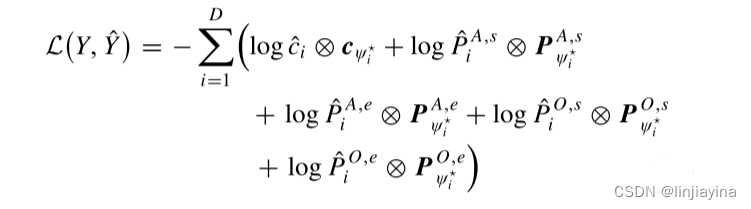

Training

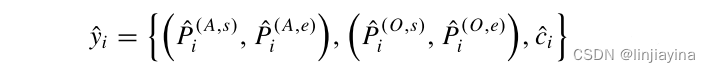

作者的训练目标是缩小真实注释与预测注释之间的差距。如前所述,交叉熵损失对预测的排列敏感,这不适合无序集合预测的非自回归解码。他们考虑一个损失函数,用于生成预测三元组与真实三元组之间的最优二分匹配。回顾预测的三重结构

Y

=

{

y

i

}

i

=

1

D

Y =\{y_i \}_{i=1}^D

Y={yi}i=1D

其中 P 是其位置索引 P 的分布,c 是标签 id c 的分布。然后他们把 gold 写成

在真实的集合

Y

^

=

{

y

i

^

}

i

=

1

K

\hat{Y} =\{\hat{y_i}\}_{i=1}^K

Y^={yi^}i=1K 中,其中

K

<

<

D

K<<D

K<<D。他们将真实三元组集合 Y 的长度与预测的Y对齐,即,通过用包括虚拟位置和空情感标签的空三元组填充

Y

=

{

(

ε

,

ε

)

,

(

ε

,

ε

)

,

ϵ

}

Y =\{(ε,ε), (ε,ε), \epsilon\}

Y={(ε,ε),(ε,ε),ϵ} 来将 Y 填充到 D 的大小中。接下来,他们将损失计算分为两个步骤:1)搜索真实三元集和预测三元集之间的最佳匹配,2)计算匹配对之间的损失。

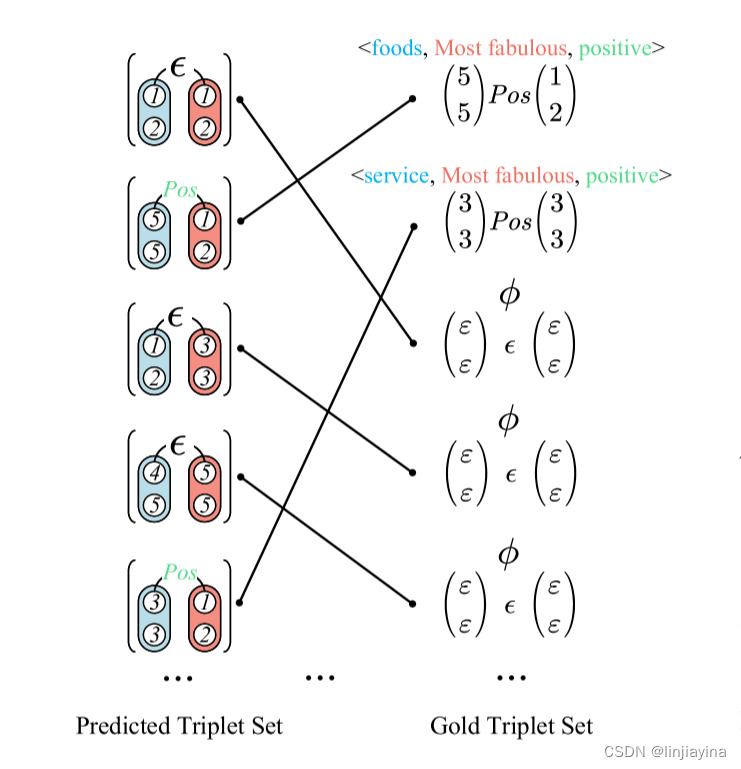

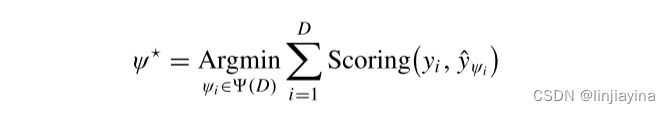

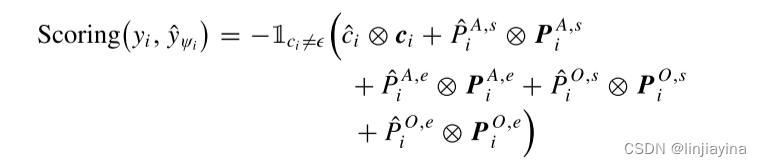

1) Matching

作者的目标是通过以下匹配机制找到具有最低成本的元素排列

通过评分函数来测量真实预测值和预测值之间的距离

2) Computing Loss

有了真实和预测三胞胎之间的最佳匹配对,他们接下来计算损失

Experiments

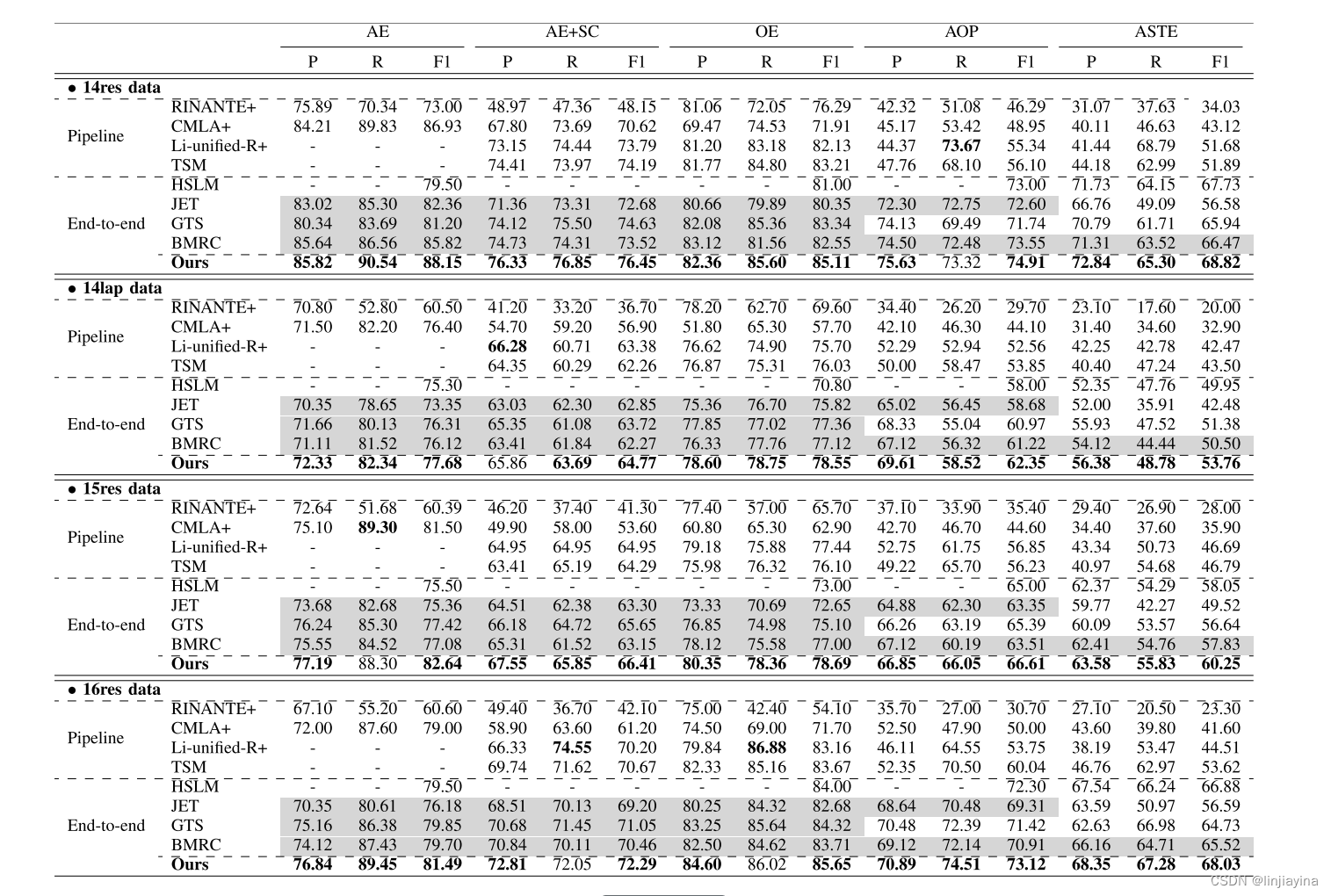

在所有四个数据集上,端到端(或联合)模型的ASTE性能比管道方法好得多。这与先前的研究结果相对应,因为子任务的联合预测可以大大缓解级联过程中存在的错误传播问题。可以注意到,这种性能改进对于独立作业(如AE和OE)并不显著。这验证了长期以来的观点,即联合建模可以更好地完成联合任务,而不是管道方法。

消融实验

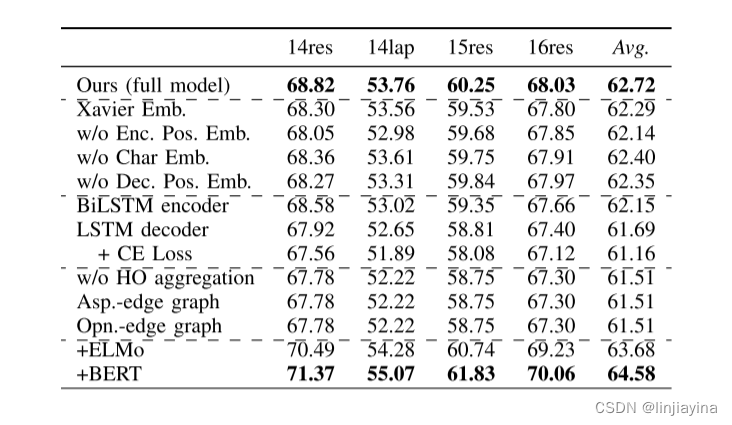

作者进行了消融研究,以评估他们的方法中每个方面的贡献。他们主要关注四个方面:1)输入特征; 2)模型架构设计; 3)提出的高阶聚合模块; 4)外部语境化词表示的有效性。

他们首先通过 Xavier 算法将预训练的词嵌入 GloVe 替换为随机初始化的词。整体性能下降。此外,如果没有 CNN 的字符表示和位置嵌入,结果会更差,有趣的是,位置信息(在编码和解码端)对他们的系统有更多的影响。这可以是直观的,因为位置线索对基于指针网络的系统贡献更大。

接下来,他们将 Transformer 编码器替换为双向 LSTM 计算语言学(BiLSTM)编码器(在他们的实践中,他们使用最佳配置微调性能),并发现轻微的性能下降。然后,他们使用类似序列的 LSTM 作为他们的解码器来产生三元组(它变成了自回归解码),他们看到系统开始表现不佳,平均下降了1.03%(62.72-61.69)F1 分数。基于 LSTM 解码器架构,他们进一步用交叉熵损失代替二分匹配损失。整体表现下降增长到平均1.56%(62.72-61.16)F1 得分。这证明了他们的非自回归框架与二分匹配损失的无序集预测的有效性。

他们消除了高阶聚集机制,发现整体性能显著下降,例如,平均1.21%(62.72-61.51)的F1下降,这证明了所提出的机制的有效性。在高阶聚集模块中,他们通过检查方面项或意见项是否在另一对中共存来构造图中的边。在这里,他们采取进一步的步骤,探索的影响,如果他们形成的边缘只依赖于方面的术语重叠或只对意见术语重叠。他们发现,无论是独立的 "ASP 边图"或 "Opn 边图"中的图的性质不如完全图中的图。此外,他们发现,相比于仅包含重叠方面术语的边的图,包含重叠观点术语的边的图对于任务更有益。

最后,他们为他们的框架配备了上下文化的语言模型,例如,ELMo 和 BERT。不出所料,他们获得了显著的性能提升,即,ELMo 平均为63.68%,BERT 平均为64.58%。这些趋势与最近使用语境化语言模型的发现非常一致,这可以导致大的任务改进。

190

190

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?