再次附上本文参考资料:

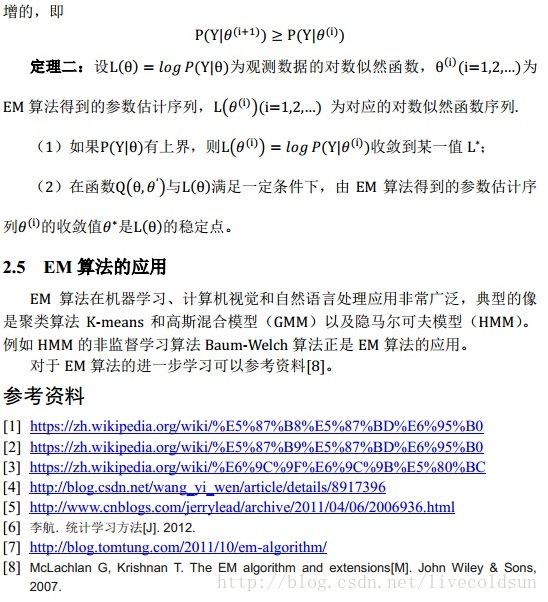

[1] https://zh.wikipedia.org/wiki/%E5%87%B8%E5%87%BD%E6%95%B0

[2] https://zh.wikipedia.org/wiki/%E5%87%B9%E5%87%BD%E6%95%B0

[3] https://zh.wikipedia.org/wiki/%E6%9C%9F%E6%9C%9B%E5%80%BC

[4] http://blog.csdn.net/wang_yi_wen/article/details/8917396

[5] http://www.cnblogs.com/jerrylead/archive/2011/04/06/2006936.html

[6] 李航.统计学习方法[J].2012.

[7] http://blog.tomtung.com/2011/10/em-algorithm/

[8] McLachlan G, Krishnan T. The EM algorithm and extensions[M].John Wiley & Sons, 2007.

1358

1358

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?