我们准备三台机器

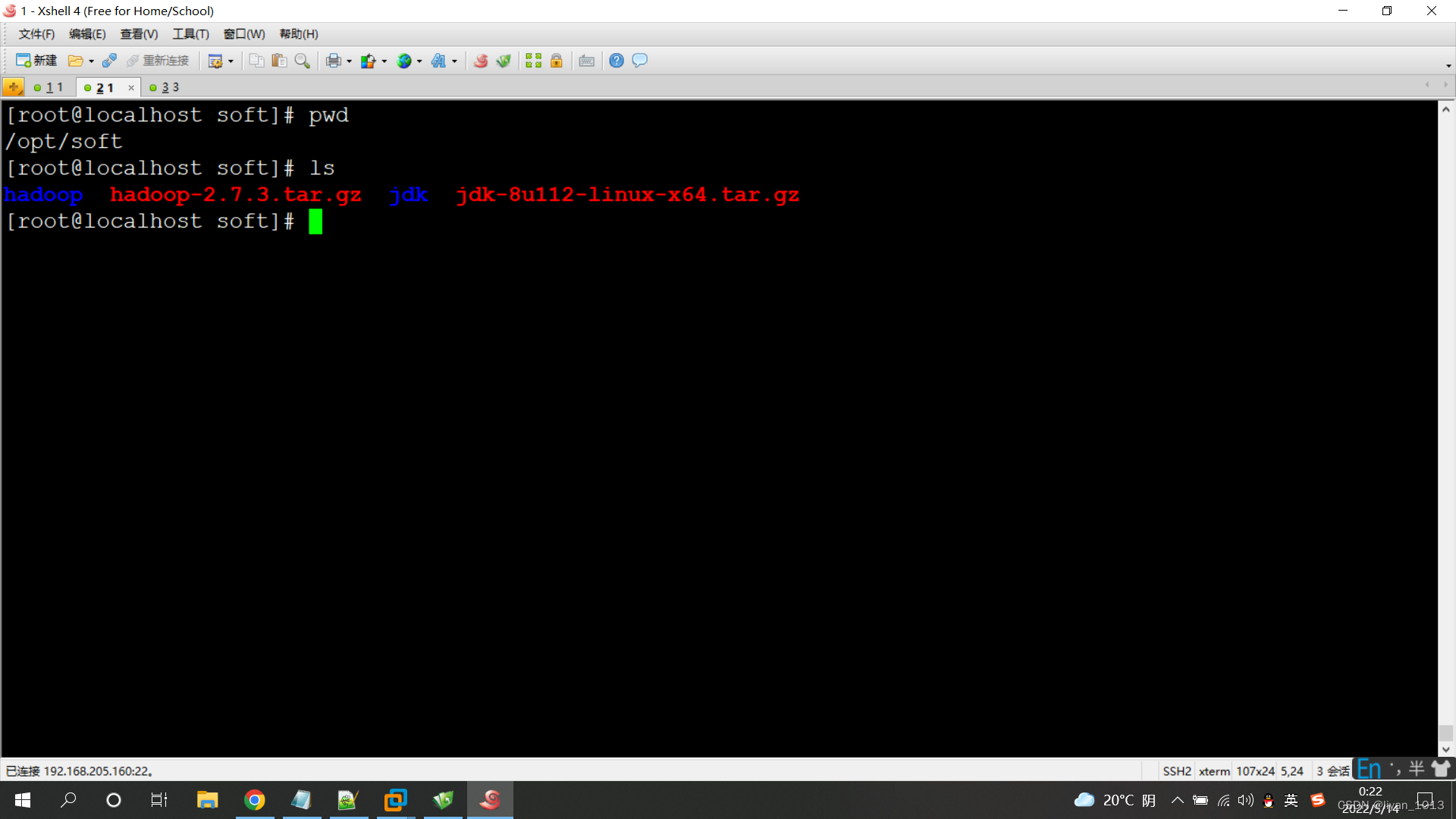

首先我们先在主机器上在opt目录下创建soft文件

mkdir /opt/soft

把jdk和hadoop的压缩包上传到soft目录并且分别解压,重命名为jdk和hadoop

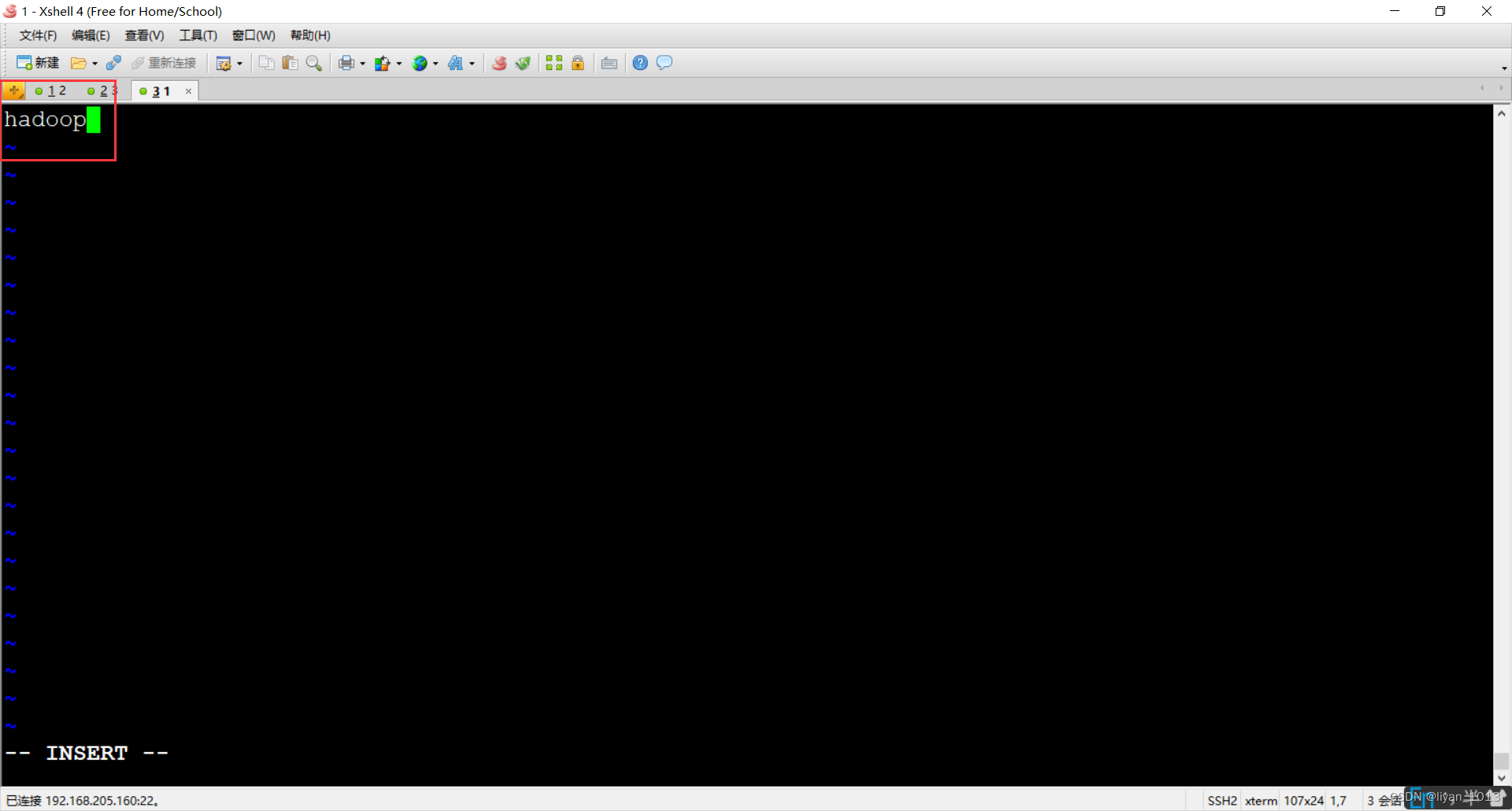

1、【配置三台机器的主机名】

vim /etc/hostname

去掉里面的内容,改成hadoop,hadoop2,hadoop3

reboot(重启生效)

我这里分别配置的三台机器的主机名为hadoop,hadoop2,hadoop3

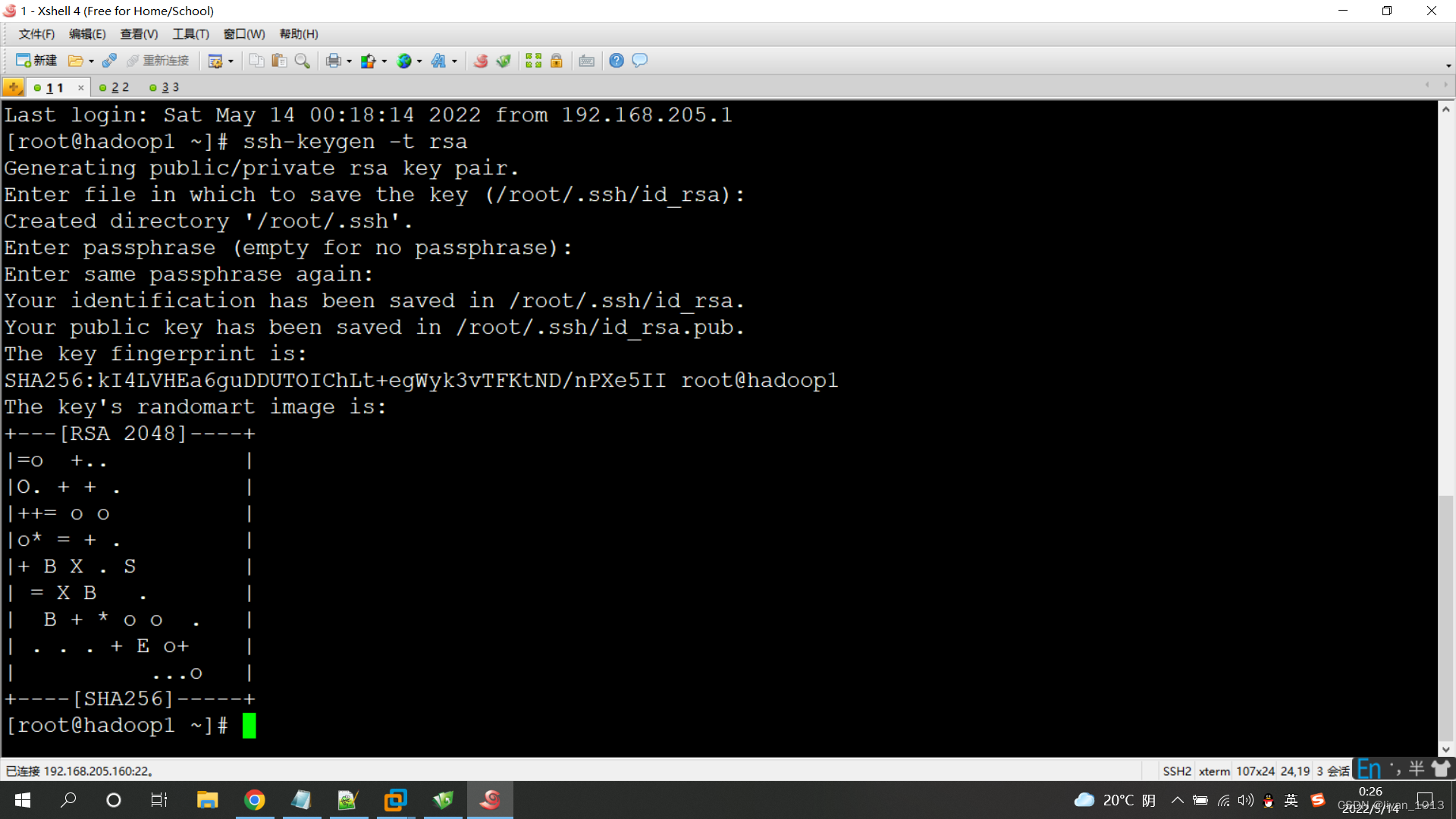

2、【在主机器上生成密匙】

ssh-keygen -t rsa(一直按回车)

配置三台机器免密登录

ssh-copy-id -i root@localhost

ssh-copy-id -i root@(第二台机器的ip)

ssh-copy-id -i root@(第三台机器的ip)

使用ssh ip 可以切换用户

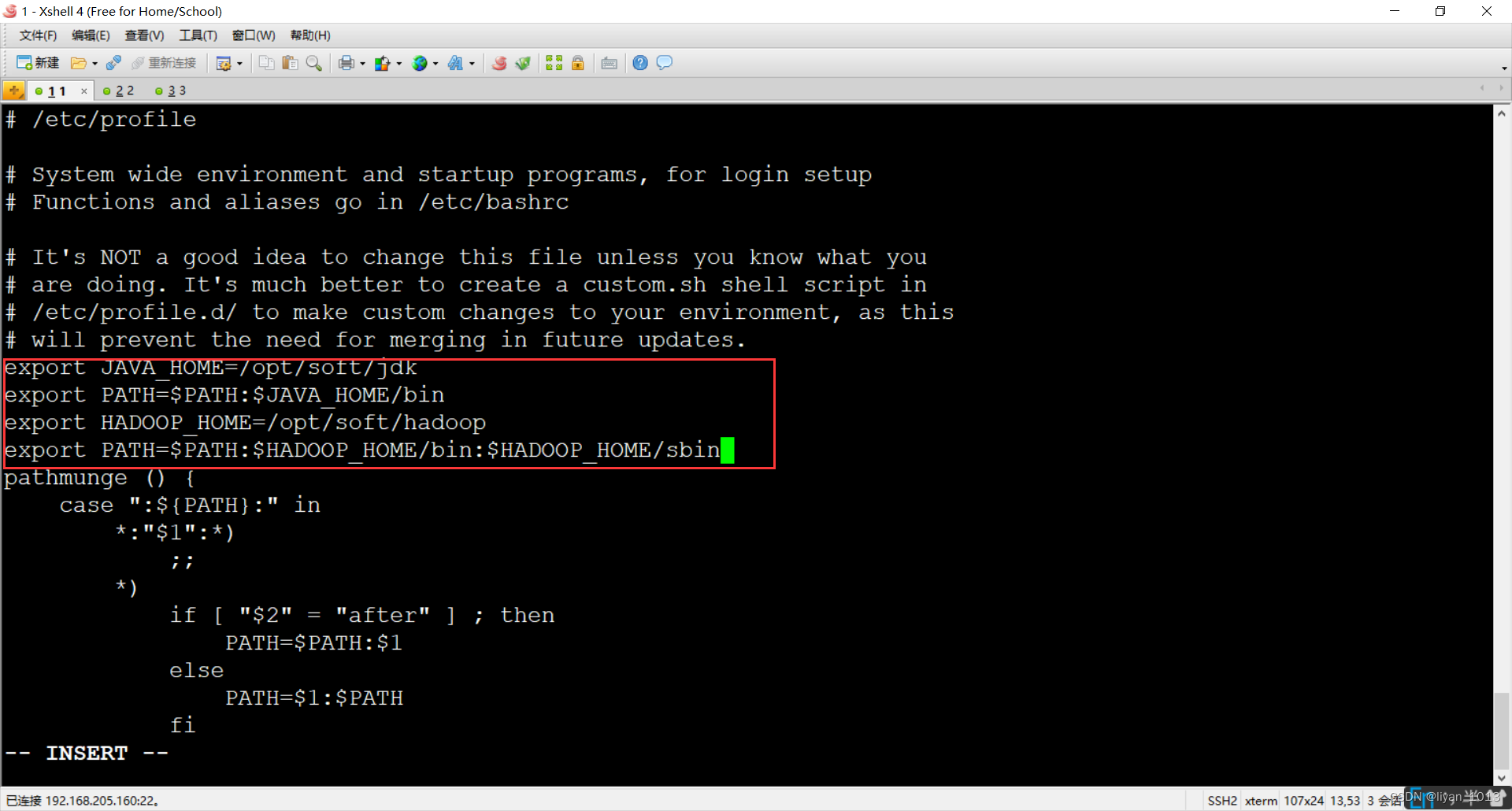

3、【在主机器上配置jdk和hadoop】

修改profile文件

vim /etc/profile

添加一下内容:

export JAVA_HOME=/opt/soft/jdk

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/opt/soft/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

用source /etc/profile生效

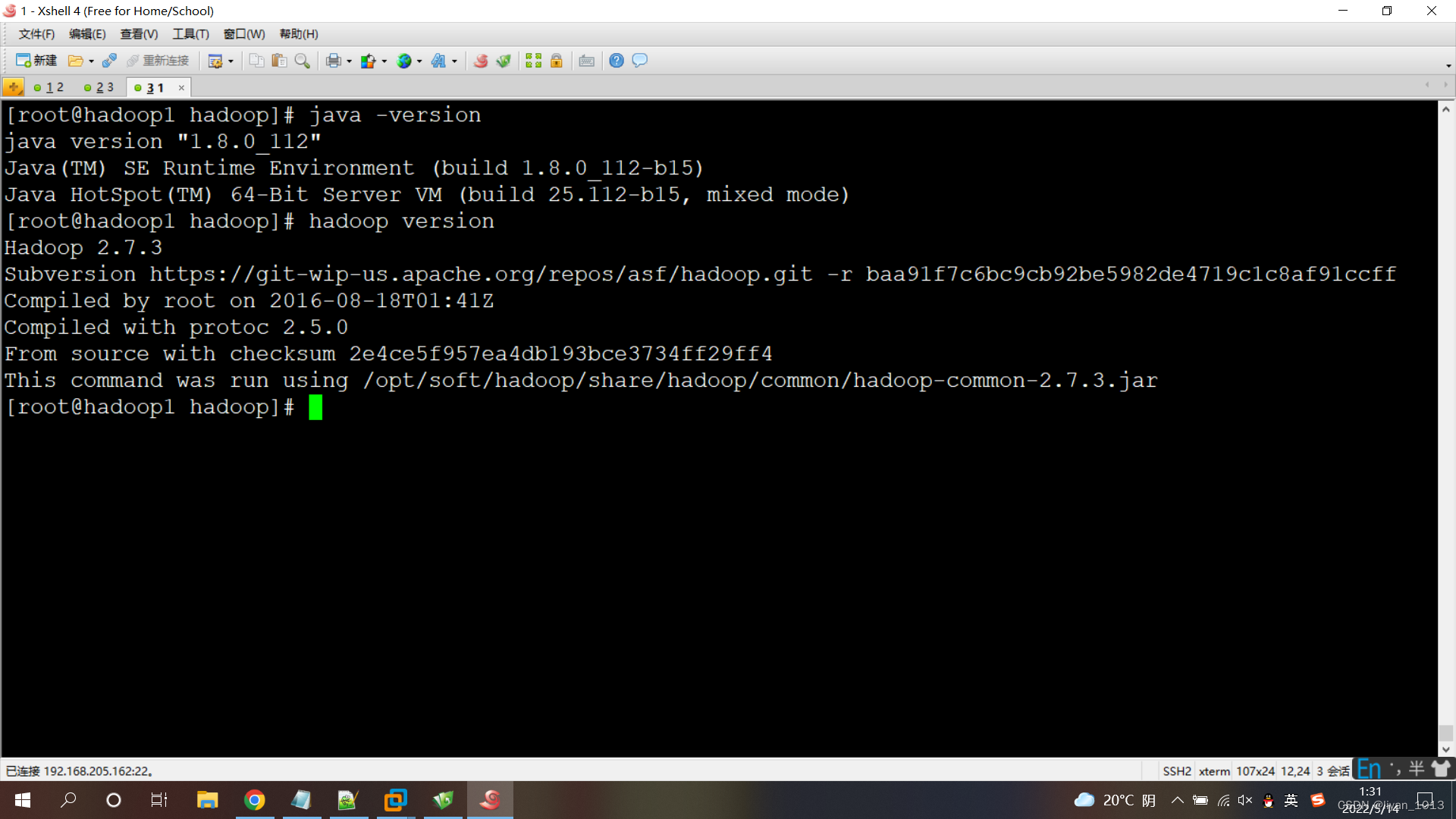

java -version

hadoop version

当出现java和hadoop版本时配置成功

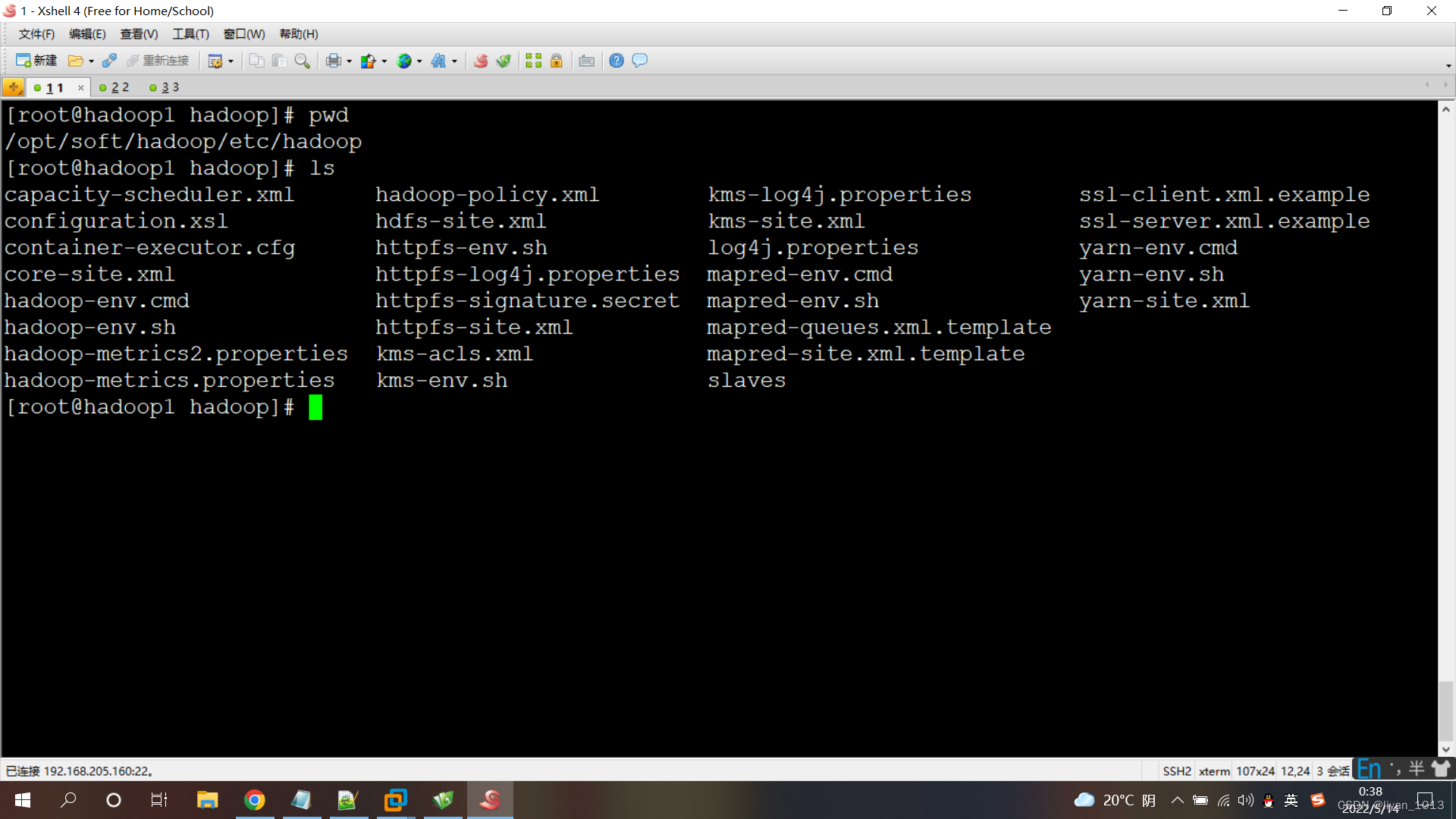

4、【在主机器上修改hadoop的配置文件】

进入我们解压的hadoop文件,etc目录下的hadoop目录

vim hadoop-env.sh

vim mapred-env.sh

vim yarn-env.sh

在这三个文件中添加jdk路径:

export JAVA_HOME=/opt/soft/jdk

以下都是在configuration标签中添加

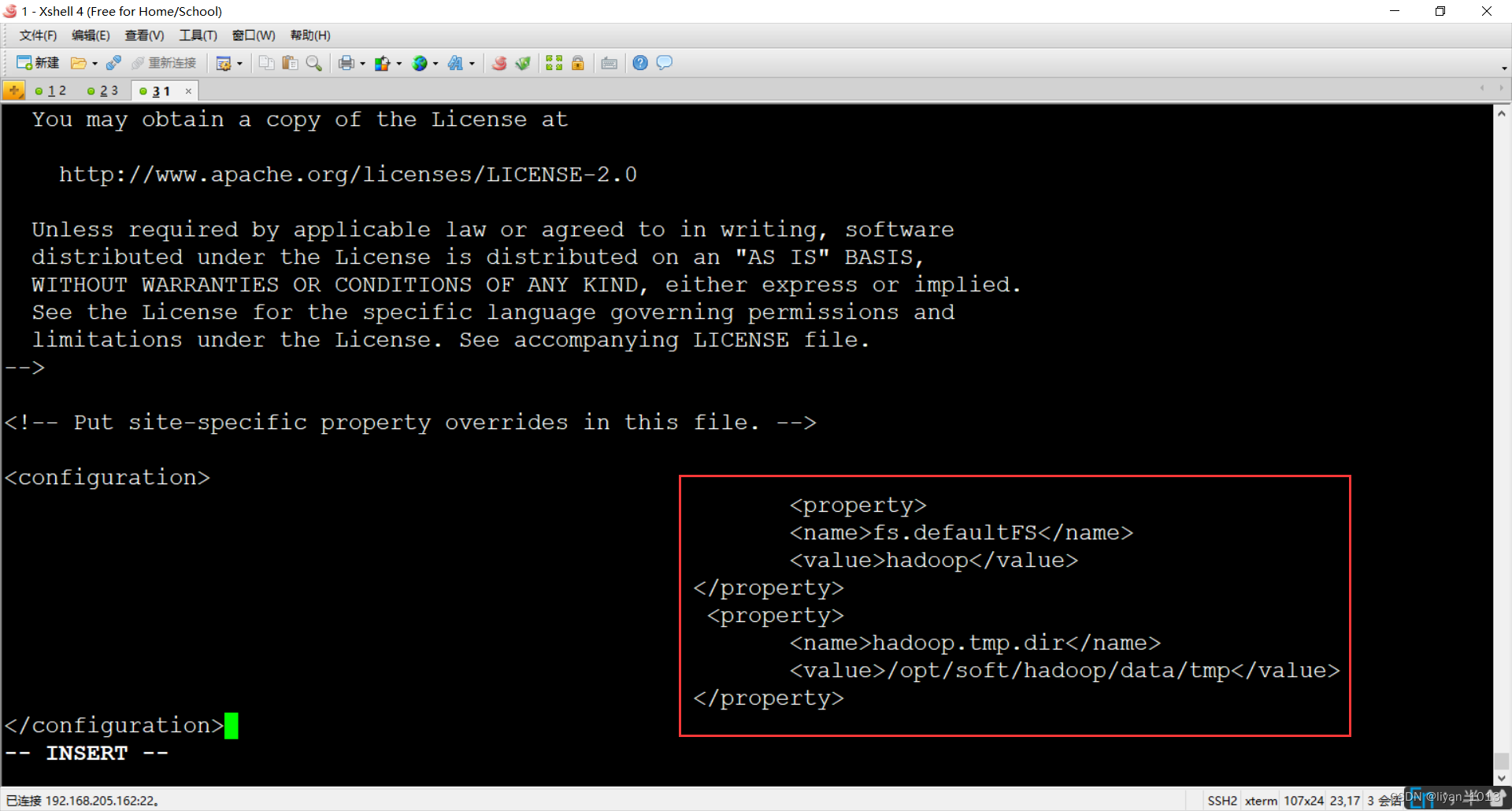

vim core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hadoop</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/soft/hadoop/data/tmp</value>

</property>

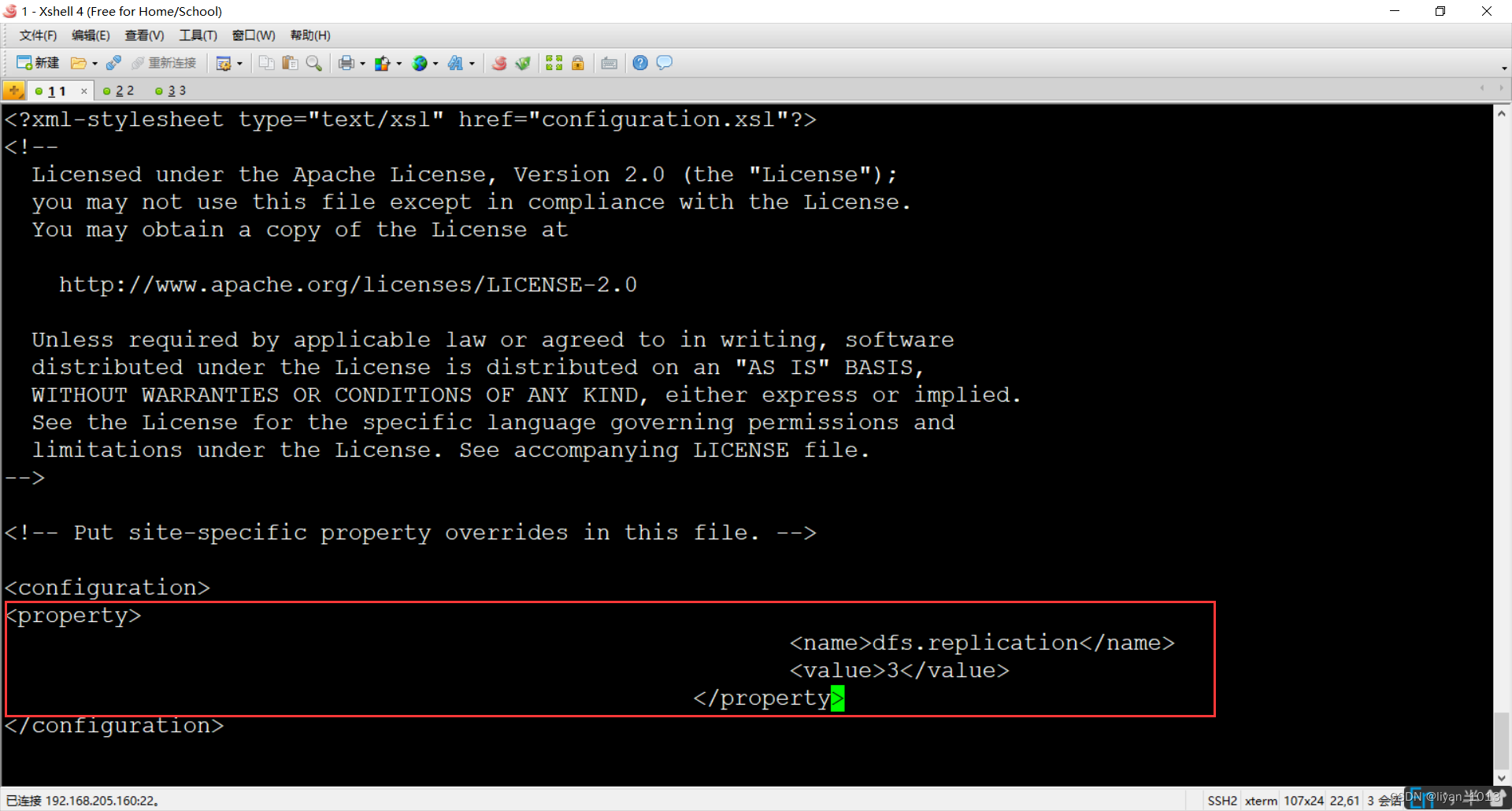

vim hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

复制mapred-site.xml.template文件命名为:mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

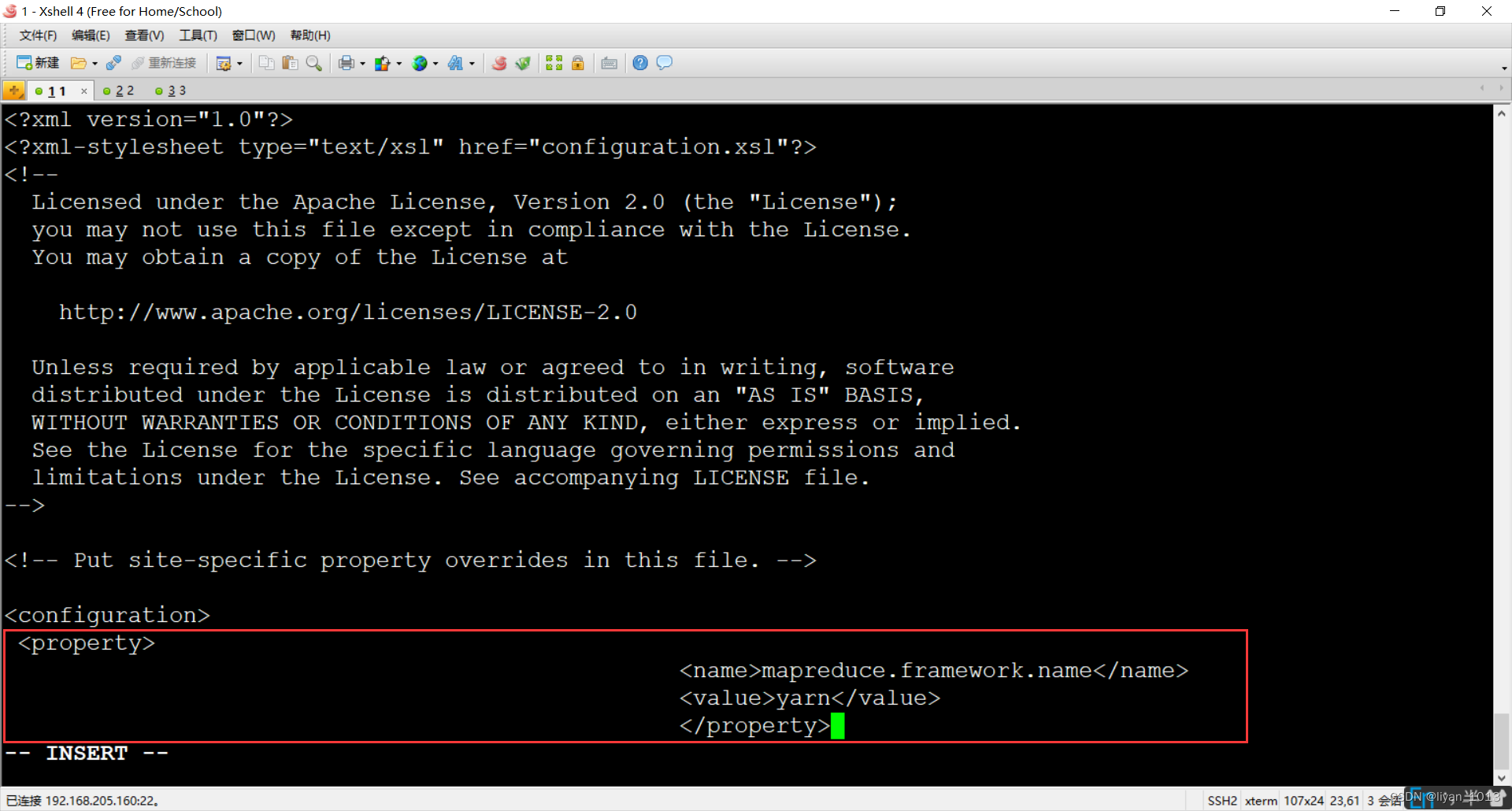

vim mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

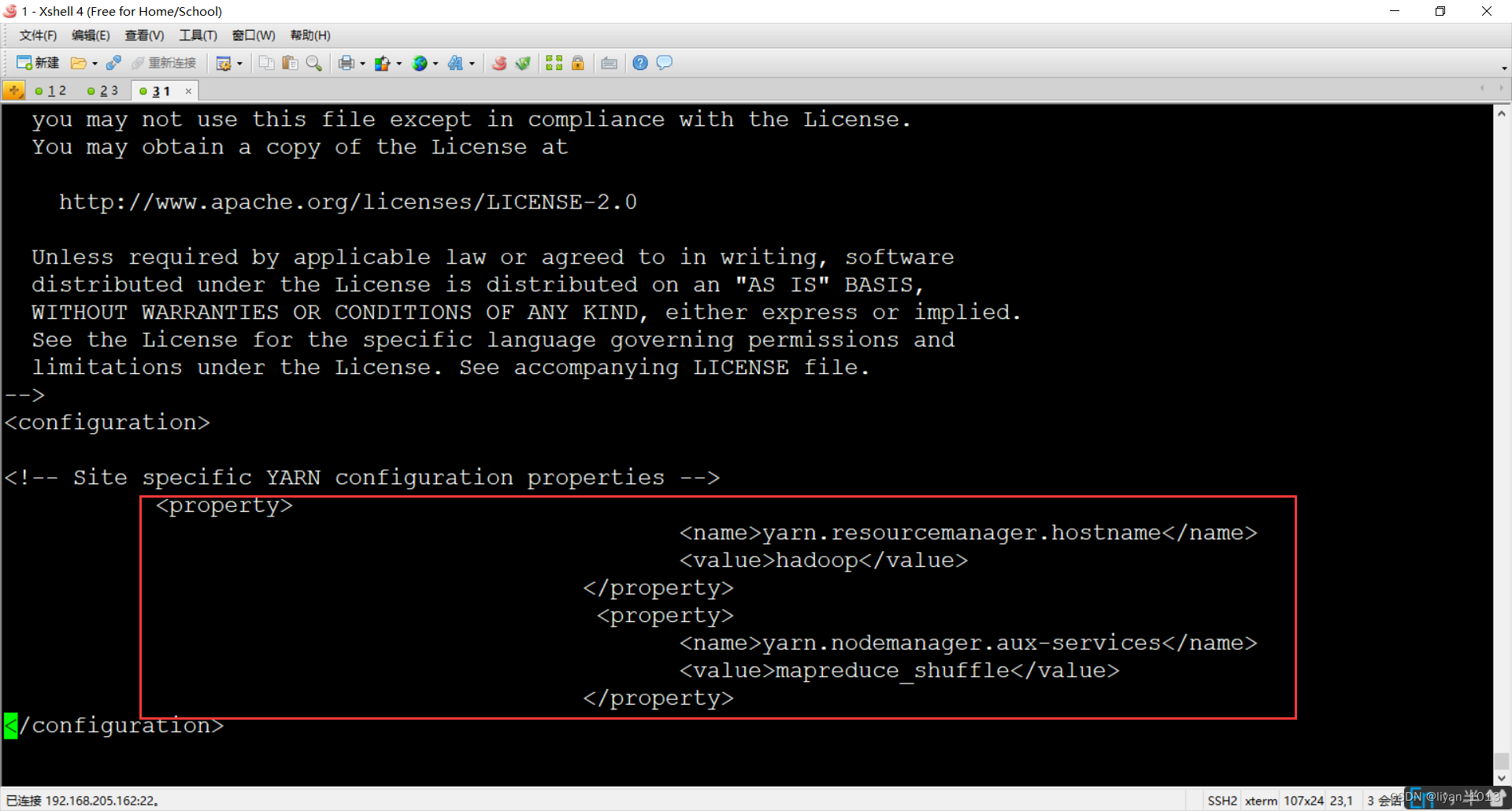

vim yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

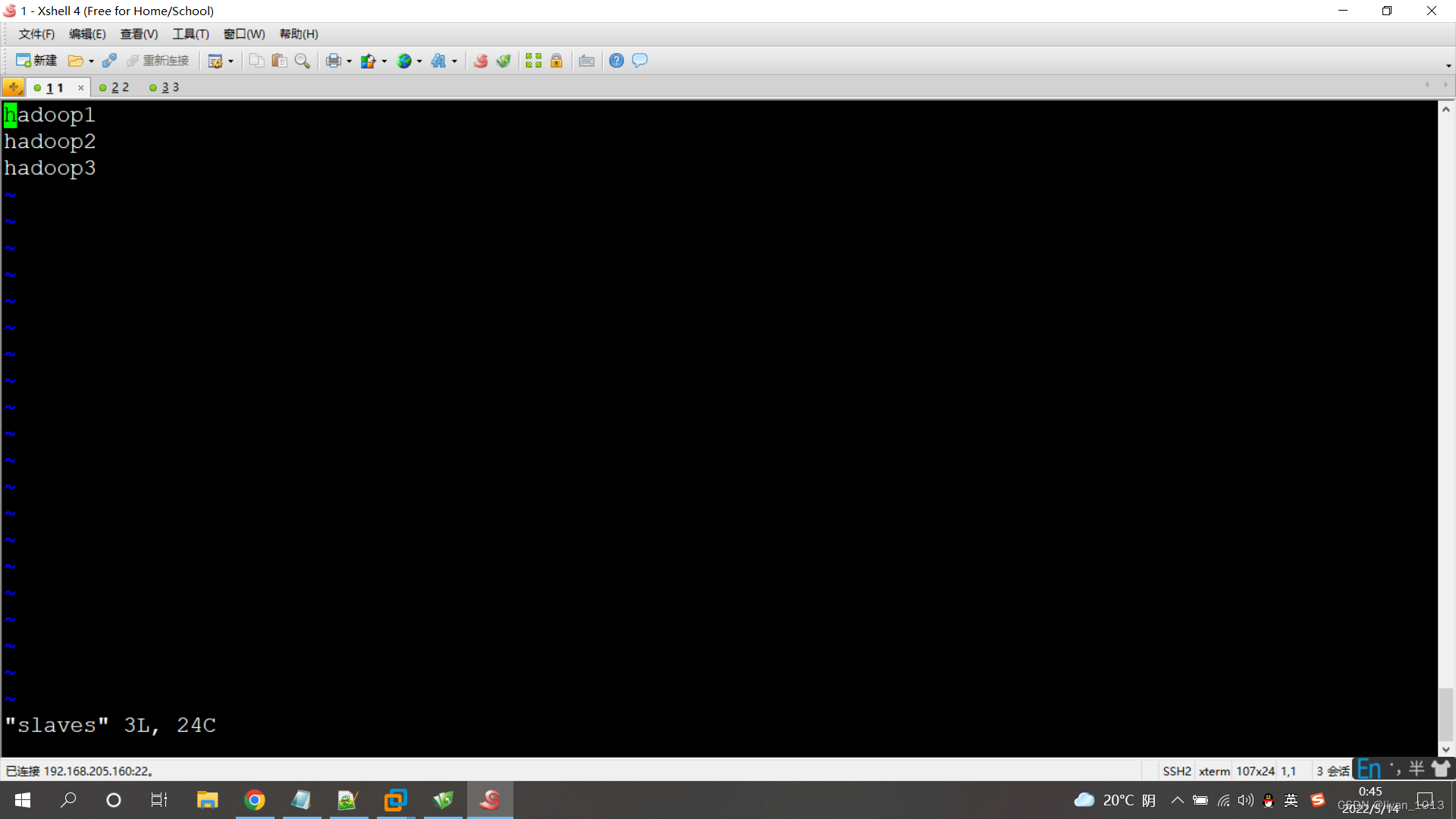

vim slaves

主机名1

主机名2

主机名3

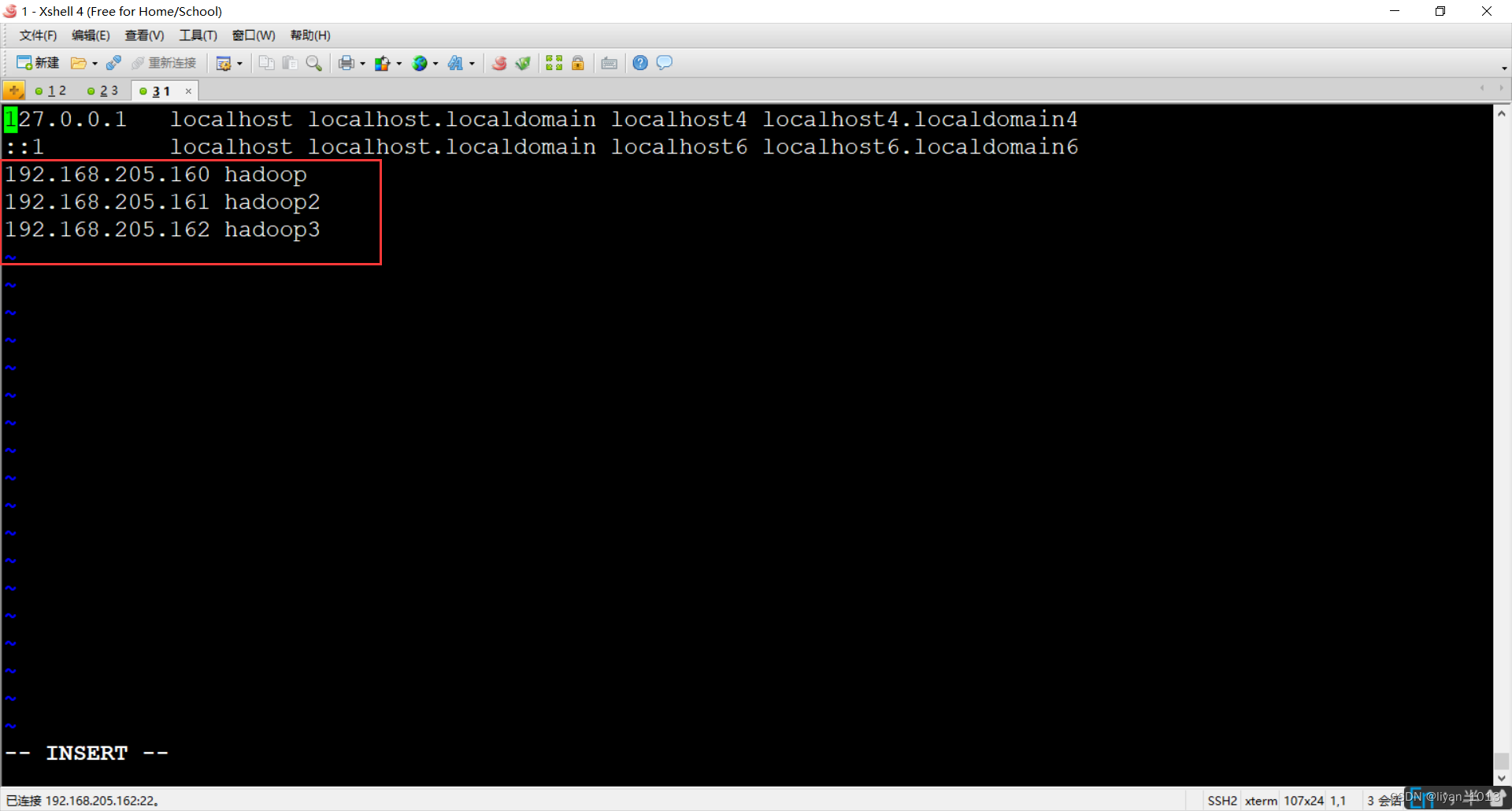

4、【配置hosts映射】

vim /etc/hosts

添加

ip1 主机名1

ip2 主机名2

ip3 主机名3

5、【从主机上拷贝profile,hosts,jdk,hadoop文件到另外两台机器】

scp -r /etc/profile 主机名或者IP:/etc/profile

scp -r /etc/hosts 主机名或者IP:/etc/hosts

scp -r jdk 主机名或者IP:/opt/soft/

scp -r hadoop 主机名或者IP:/opt/soft/

5、【三台机器关闭防火墙】

systemctl stop firewalld

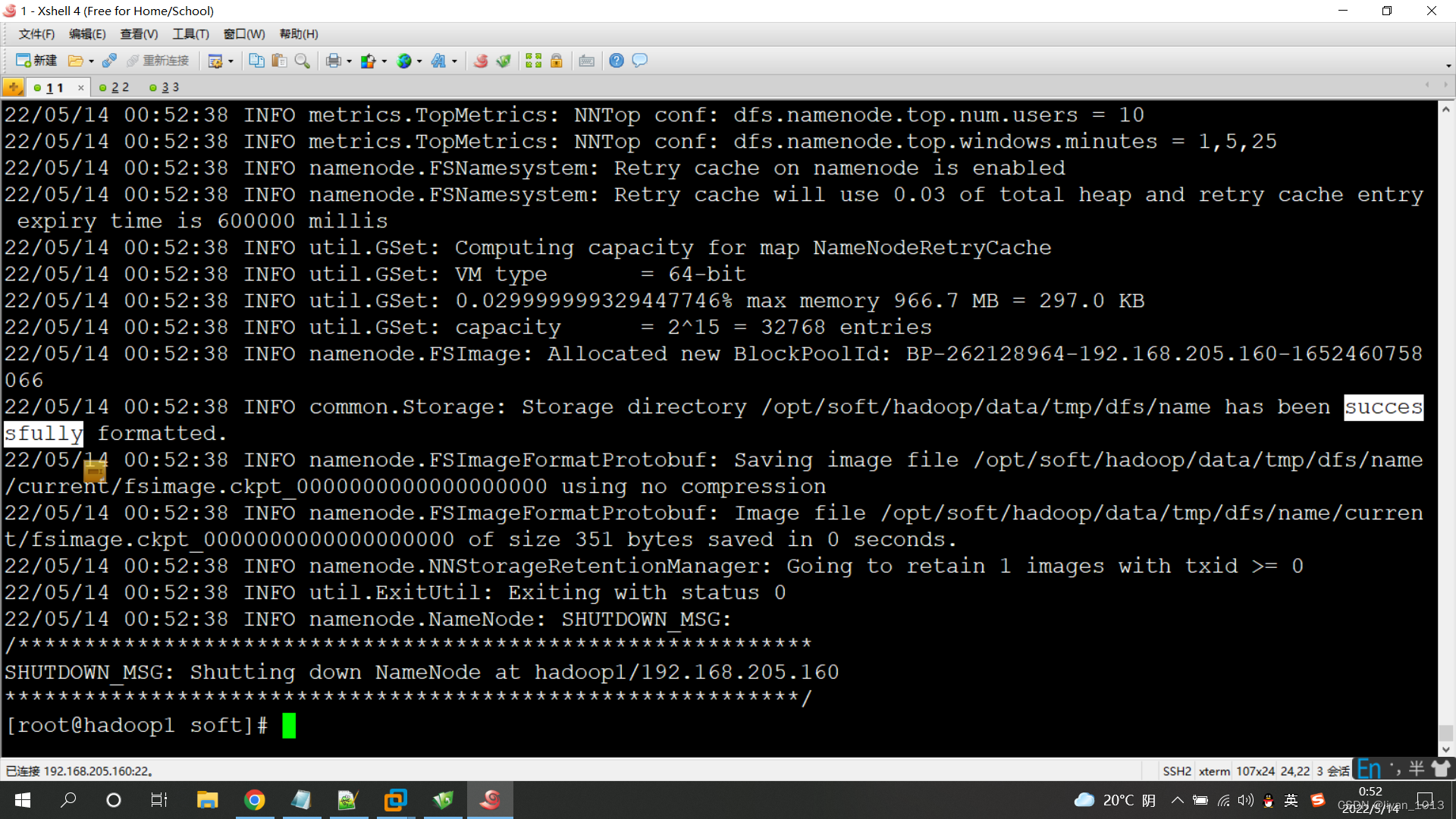

6、【主机器格式化】

hdfs namenode -format

出现successfully表示格式化成功

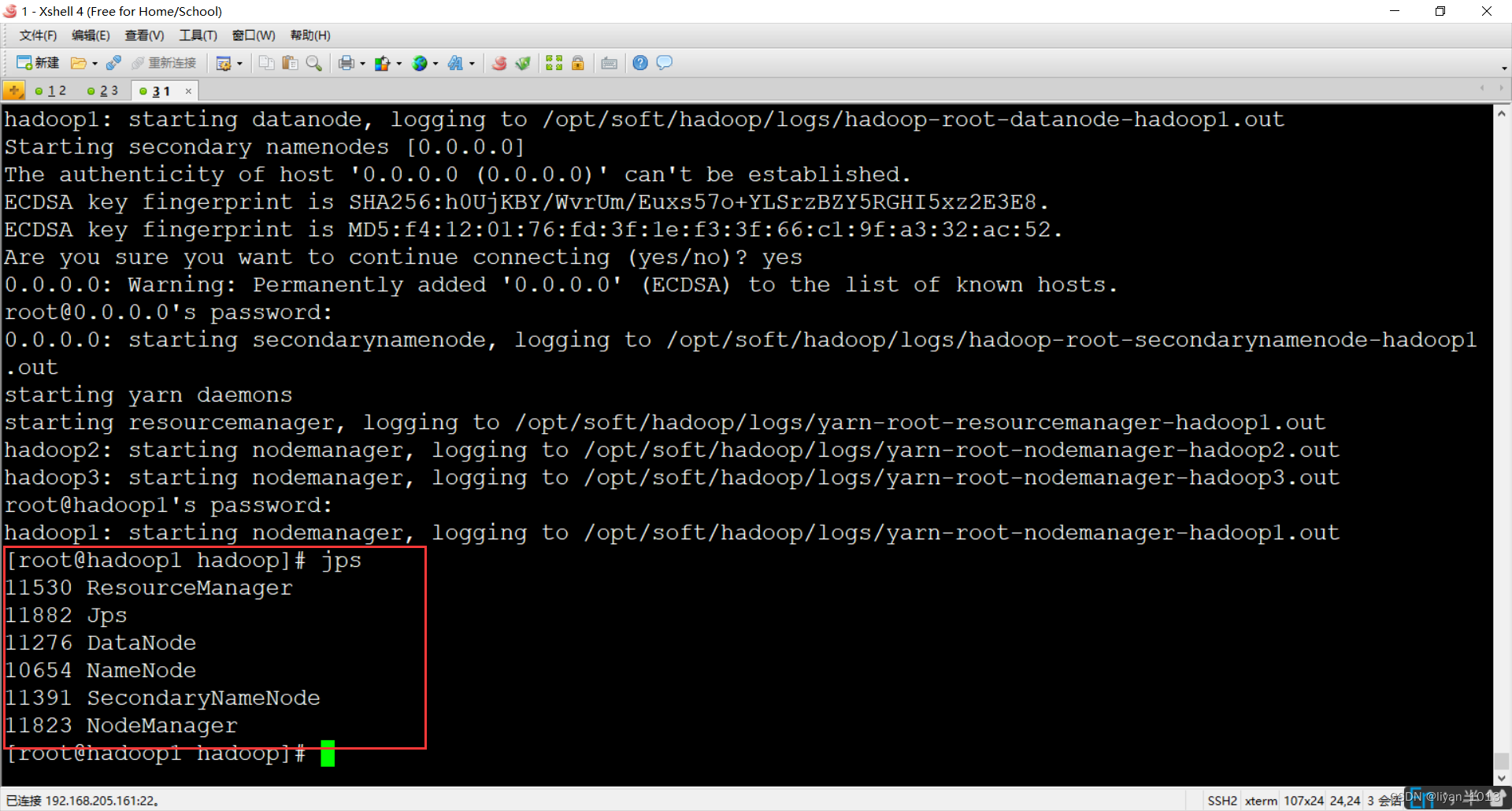

最后我们启动服务

start-dfs.sh

start-yarn.sh

获者start-all.sh

用jps查看进程

最后我们通过:ip:50070访问就行啦

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?