一种利用 langchain 思想实现的基于本地知识库的问答应用,目标期望建立一套对中文场景与开源模型支持友好、可离线运行的知识库问答解决方案。

受 GanymedeNil 的项目 document.ai 和 AlexZhangji 创建的 ChatGLM-6B Pull Request 启发,建立了全流程可使用开源模型实现的本地知识库问答应用。本项目的最新版本中通过使用 FastChat 接入 Vicuna, Alpaca, LLaMA, Koala, RWKV 等模型,依托于 langchain 框架支持通过基于 FastAPI 提供的 API 调用服务,或使用基于 Streamlit 的 WebUI 进行操作。

依托于本项目支持的开源 LLM 与 Embedding 模型,本项目可实现全部使用开源模型离线私有部署。与此同时,本项目也支持 OpenAI GPT API 的调用,并将在后续持续扩充对各类模型及模型 API 的接入。

本项目实现原理如下图所示,过程包括加载文件 -> 读取文本 -> 文本分割 -> 文本向量化 -> 问句向量化 -> 在文本向量中匹配出与问句向量最相似的 top k个 -> 匹配出的文本作为上下文和问题一起添加到 prompt中 -> 提交给 LLM生成回答。

开始

首先我们需要先把这个项目的源码拉下来

下载地址如下:https://github.com/chatchat-space/Langchain-Chatchat.git

然后下载模型,我这里用的ChatGLM3-6b的模型,模型都是自己选择,看个人电脑配置就好

大家可以在githup上拉下来,也可以把模型下载到本地

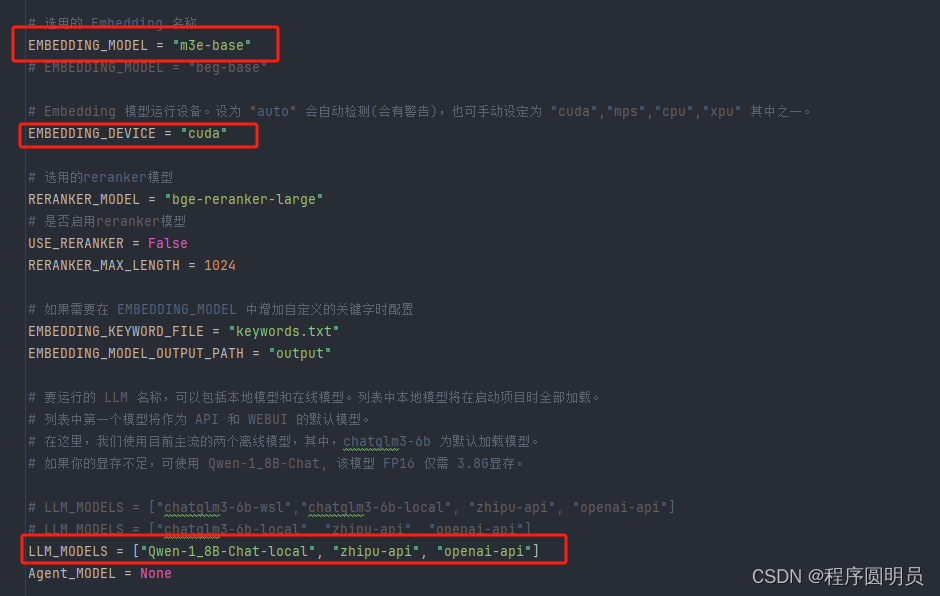

在langchain-chatchat项目下configs/model_config.py里找到以下我标出的

简单介绍一下,嵌入模型我用的事m3e-base的,运行也可选择cpu、cuda

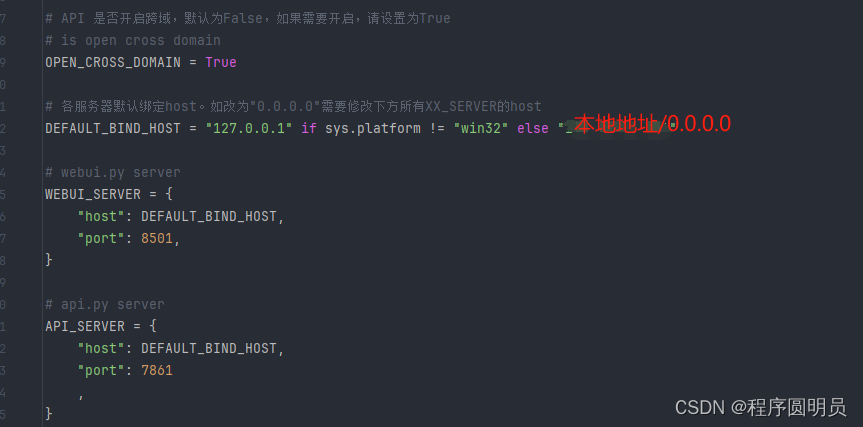

如果想修改端口的话在configs下的server_config:

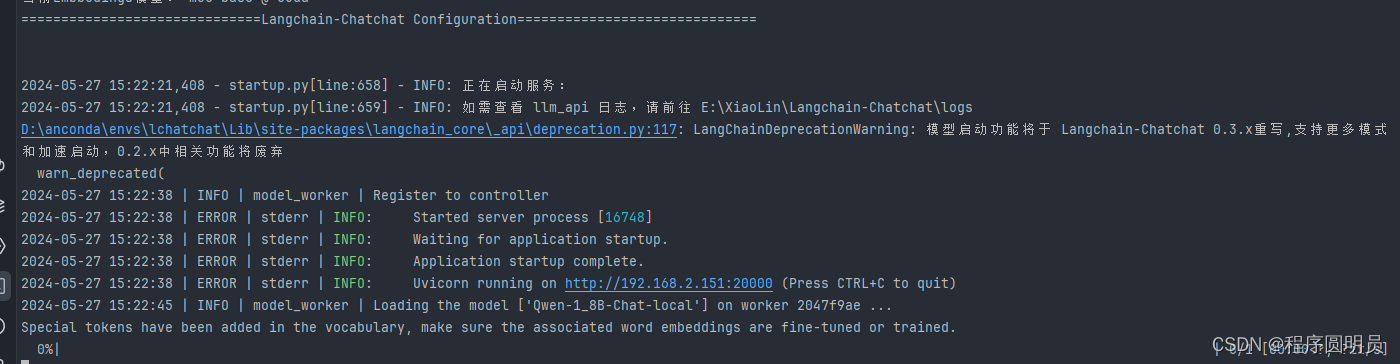

接下来我们就可以一键启动这个项目:

python startup.py -a项目启动成功:

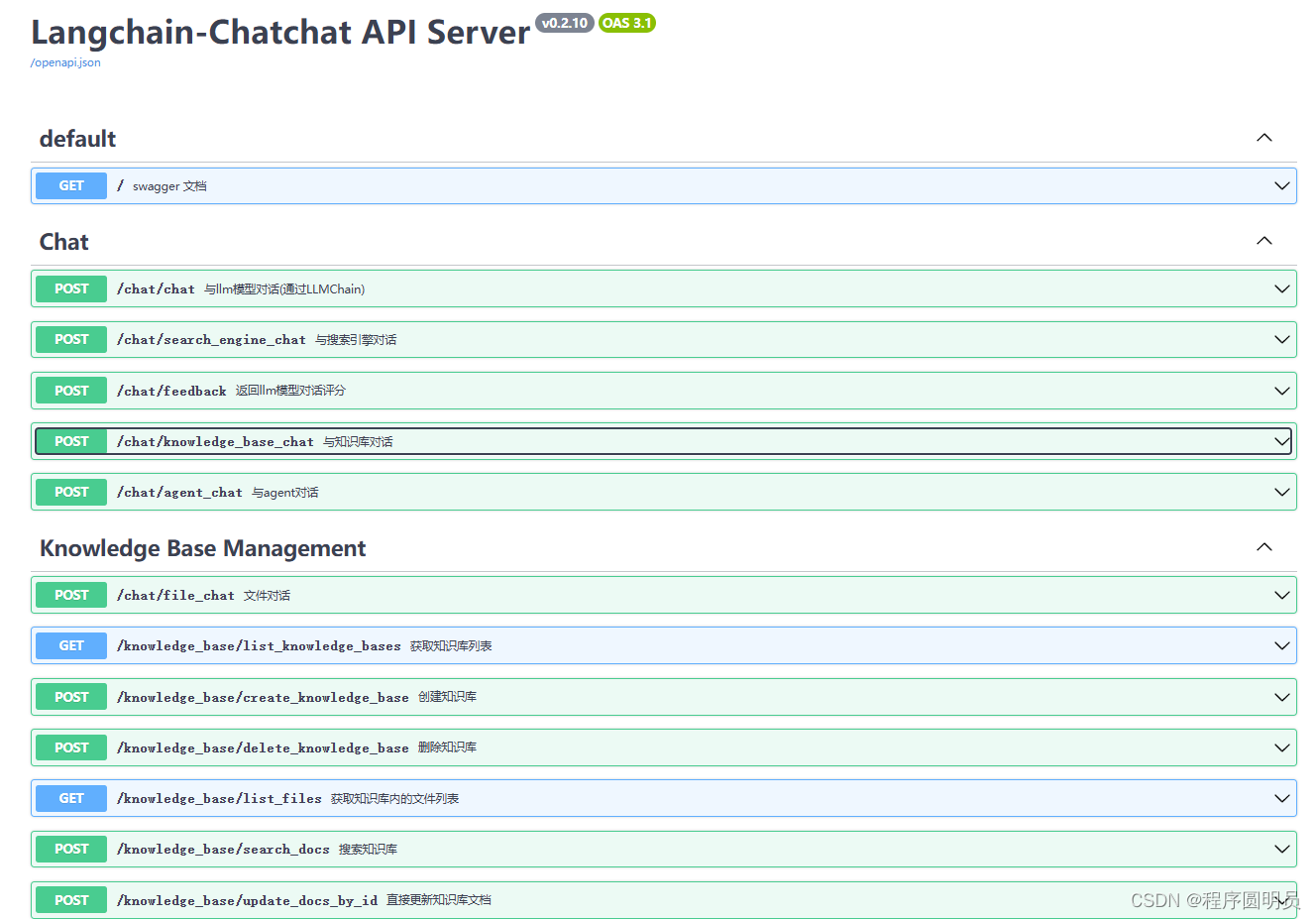

调用langchain-chatchat的API

进入webUI聊天页面

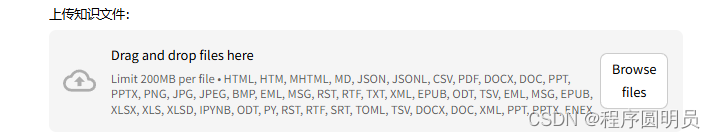

知识库支持多种文件格式 docx,txt,PDF等等,可以以拖拽的方式把你的文件拉到知识库里

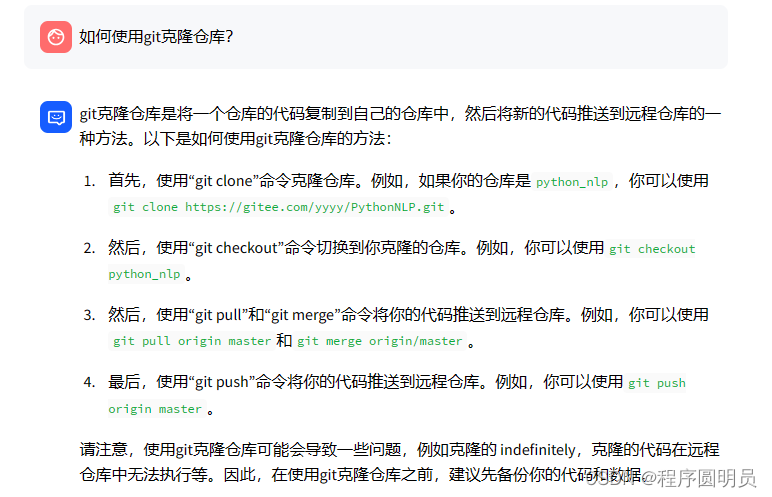

知识库问答:

最后说一下遇到的问题吧:

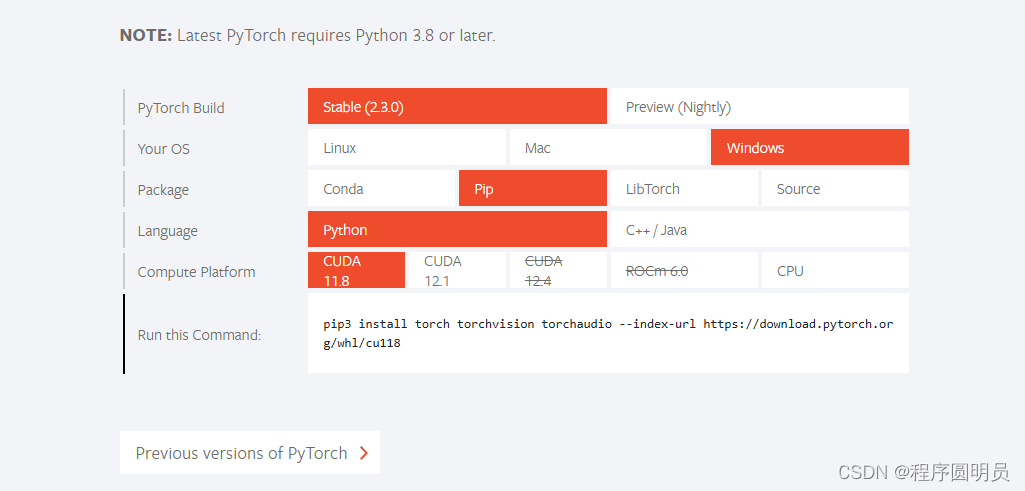

如果报错是有关torch的,可能是没有pip install -r requirements.txt的时候没有下载到cuda版本的torch 那么就需要我们手动下载:

首先我们进入PyTorch官网:PyTorch(可能需要一点魔法)

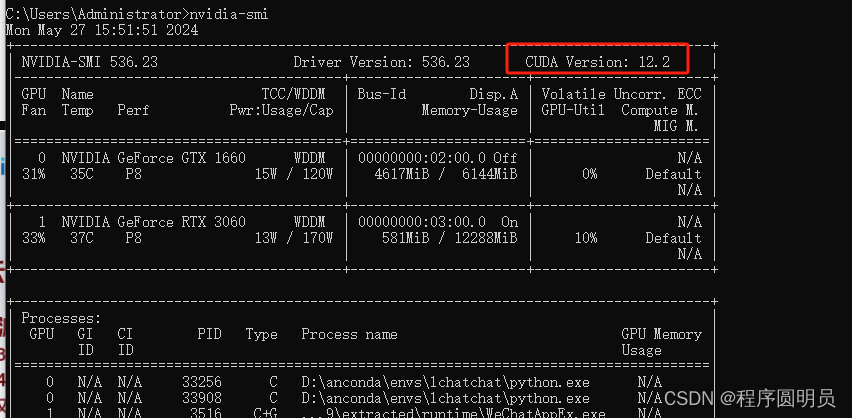

然后找到自己对应的cuda版本,可在cmd里查看

输入命令 nvidia-smi

找到pytorch对应的cuda版本,下载

结束

langchain-chatchat是个非常好用而且简单容易上手的框架,我这里只是分享如何跑通代码,如果有别的需求可根据自己的需求添加或修改

7937

7937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?