作者、题目:

ABSTRACT

1. 写作目的:

① 现有的作品大多是通过交互式学习语境中不同方面之间的依存关系,从而衍生出特定方面的情感特征但这些工作忽略了利用外部情感常识性知识来增强Graph Convolutional Networks(GCNs)在不同上下文中交互捕获内部方面词(inter-aspect words)的情感的能力;

② 现有的研究很少关注中文的ABSA任务。

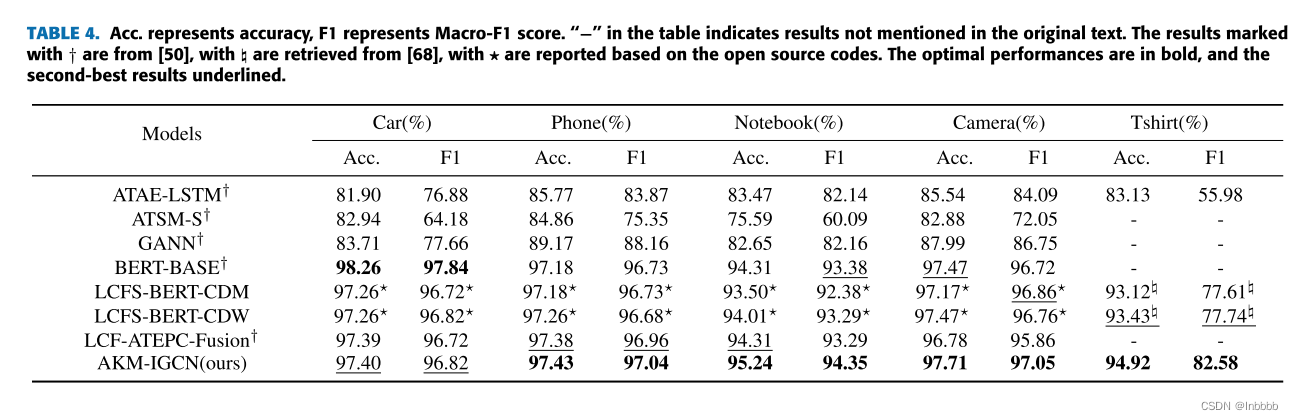

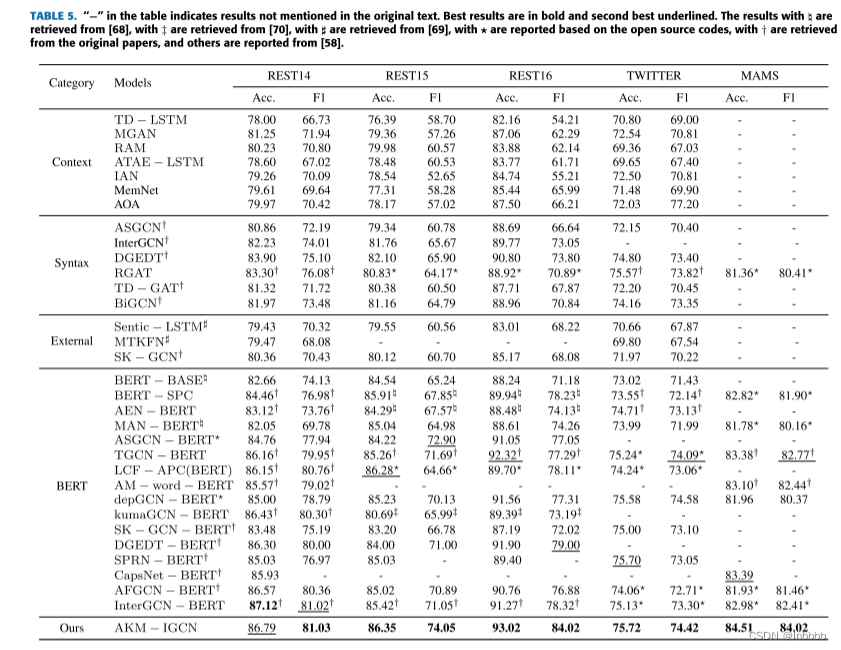

2. 本文提出了一种新的知识感知模型——AKM-IGCN,利用多头注意力机制(MHSA)提取更丰富的上下文句法和语义交互特征,其中情感知识增强了面向汉语的ABSA的交互式GCN(也可以处理英文)。

一、INTRODUCTION

1. ABSA任务介绍:预测句子特定方面的情感极性,如图1(a)所示:

2. 句子依赖关系:

其中单词之间的依存关系见:NLP工具——Stanza依存关系含义详解_常鸿宇的博客-CSDN博客

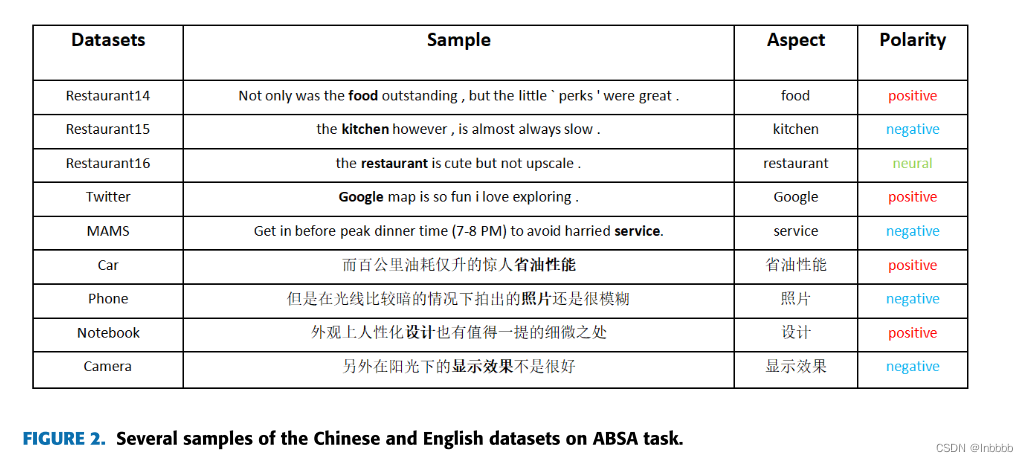

3. ABSA中英文数据集任务示例:

4. 本文大体框架:本文提出了一种情感知识增强交互GCN(AKMIGCN),它充分利用了预训练的BERT,并利用SenticNet中的情感知识来增强句子依存图

5. contributions:

① 本文首次将基于外部知识的SenticNet应用于面向汉语的ABSA任务中,为汉语研究提供了一种新的思路

② 提出了一种新的情感知识扩充依赖树模型,改进了交互式GCN模型,以获取各方面的情感依赖。所提出的模型具有处理中、英文评论的能力

③ 我们结合MHSA进一步对多个方面进行建模,以获得上下文和方面之间更丰富的隐含特征信息。此外,还引入了层规格化(Layer Normalization),实现了对句法特征和全局语义特征的交互式学习,提高了模型的训练速度

二、PROPOSED METHODOLOGY

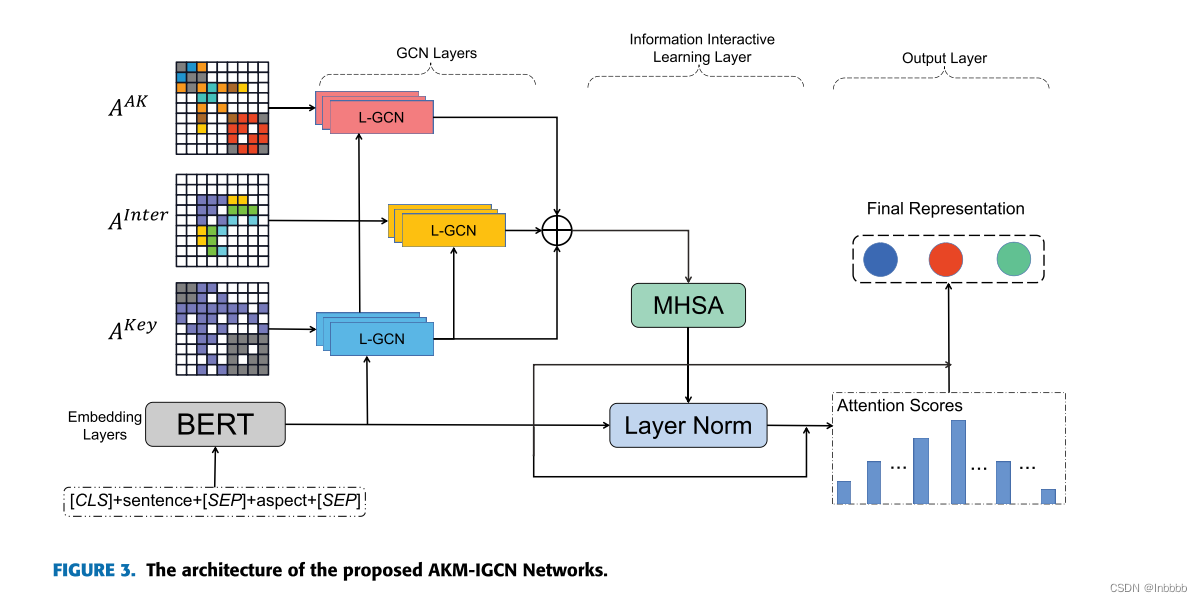

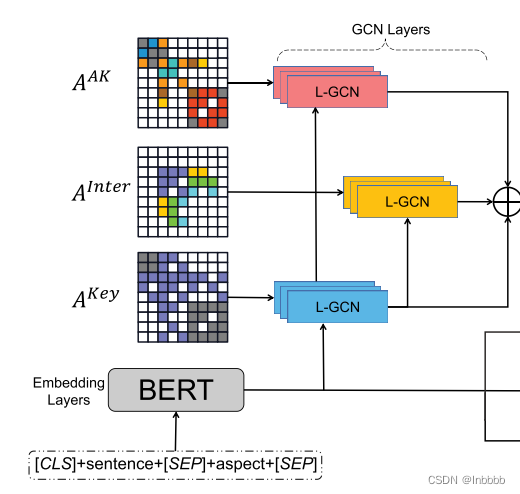

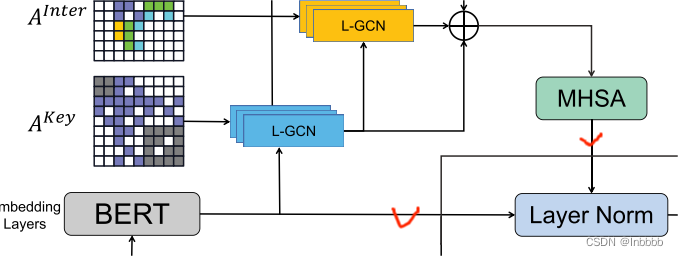

模型总览:

上图为本文提出的AKM-IGCN模型图,它由四个部分组成,即嵌入层、GCN层、信息交互层和输出层。

2.1 TASK DEFINITION

假设一个句子包含n个单词和两个方面,即s = {w1, w2,…, a11, a12,…, a1p,…a21, a22,…, a2q,…, wn}

其中wi表示内容的第i个单词,aij表示第i个方面的第j个单词(一个方面可以由多个单词组成)。每个实例包含句子、方面词和相应的情感极性。

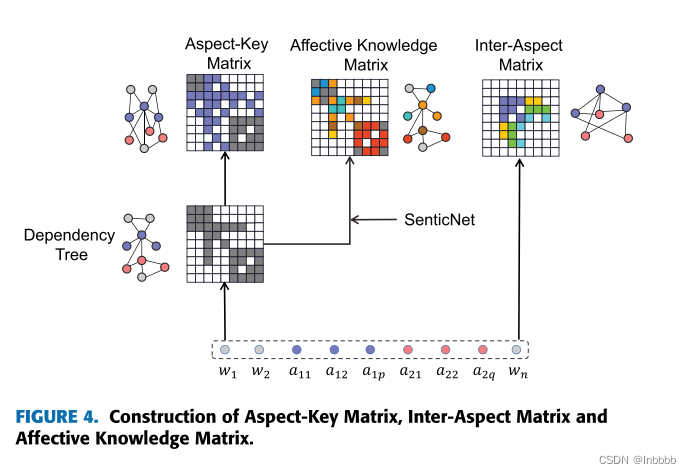

2.2 CONSTRUCTING ASPECT GRAPHS AND AFFECTIVE KNOWLEDGE GRAPH

2.2.1 GENERATING ASPECT-KEY GRAPHS

作用:挖掘句子的单词依赖特征

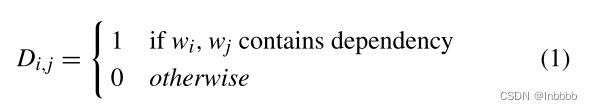

① 邻接矩阵:在每个输入句子的依赖树上构造句子的依赖图。那么,得到句子对应的邻接矩阵:

即在图1(b)的依赖树中,若两单词相连,则在邻接矩阵的对应位置为1,否则为0

② 增广依赖图:

作用:突出上下文中的特定方面,并从上下文中的关键方面提取特性。

在图4中,我们根据具体方面构建了一个增广的依赖图

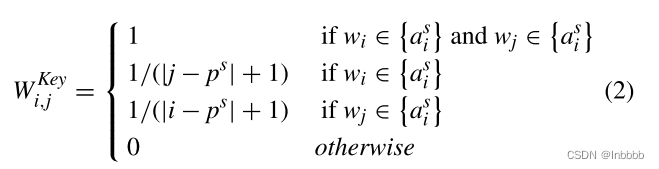

并通过对邻接矩阵中每个元素的相对位置进行加权来细化图【个人认为可以看做一个权重矩阵】:

其中,p是方面词是起始位置, 为所有方面词的集合,|·|代表元素的绝对值。

为所有方面词的集合,|·|代表元素的绝对值。

【注】只有该词是方面词的时候,在增广依赖图中才会有值。

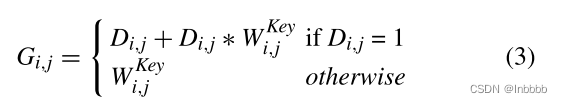

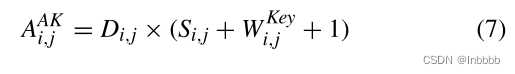

③ 句法依赖矩阵:我们整合了关键方面的权重(增广依赖图)和公共依赖图(邻接矩阵)来增强上下文词的句法依赖,并推导出关键方面的句法依赖矩阵:

④ 关键方面图:

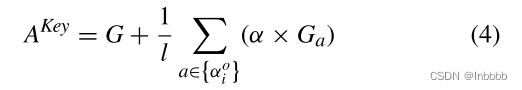

为了挖掘句子中多个方面之间的联系,我们将其他方面的信息合并到关键方面的邻接矩阵中,得到更精细的关键方面图:

其中![]() 表示长度为l的其他方面的集合。

表示长度为l的其他方面的集合。

2.2.2 PRODUCING INTER-ASPECT GRAPHS

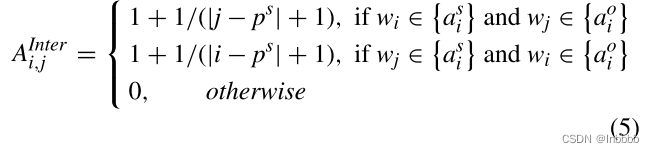

由于有些方面需要借助其他方面之间的情感关系来辅助情感极性分类。因此,我们构造了图4中的内部方面词(inter-aspect words)的邻接矩阵:

其中  为所有方面词的集合,

为所有方面词的集合, ![]() 表示长度为l的其他方面的集合。

表示长度为l的其他方面的集合。

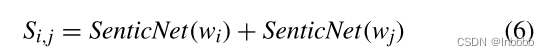

2.2.3 CONSTRUCTING AFFECTIVE KNOWLEDGE GRAPH BASED ON SENTICNET

作用:挖掘上下文和方面之间的情感特征,我们结合SenticNet中每个单词的情感得分来增强矩阵表示:

其中SenticNet(wi) ∈ [−1, 1]代表单词wi的情感得分

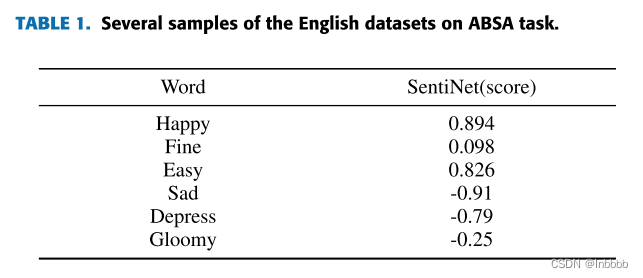

外部情感知识与对应的情感得分示例:

其中,积极词越强,其情感值越接近1,消极词越强,其情感值越接近-1

接下来,我们就可以获得用情感知识增广的邻接矩阵:

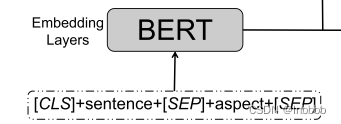

2.3 EMBEDDING LAYERS

本文选择Bert作为嵌入层

选择Bert的原因:

① BERT模型对于复杂程度较高的句子和歧义词较多的句子表现较好;

② 可以同时从两个方向提取信息,并且能够在句子中挖掘出更丰富的语义信息。

Bert的输入:[CLS]+句子+[SEP]+方面+[SEP]

从而,对于一个由n个单词的句子,我们通过Bert可以得到一个嵌入矩阵x = [x1, x2, . . . , xn]

2.4 AFFECTIVE KNOWLEDGE AUGMENTED INTERACTIVE GCN LAYERS

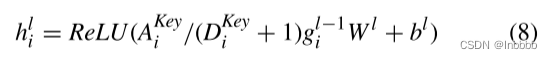

将基于依赖树和SenticNet外部知识得到的情感邻接矩阵喂入GCN中,以学习特定方面的情感依赖:

其中 是一个方面键标准化的邻接矩阵,

是一个方面键标准化的邻接矩阵, 为邻接矩阵

为邻接矩阵 的度,

的度,![]() 为上一层GCN的隐藏状态表示。

为上一层GCN的隐藏状态表示。

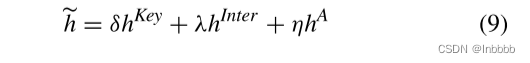

我们融合了方面键、交互方面和情感知识的最终表示(由2.2节中的三个矩阵得到的),并将其输入到GCNs模型中。最后,通过这个GCN层,我们得到了丰富的句法依赖特征:

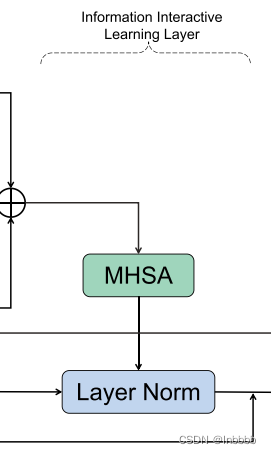

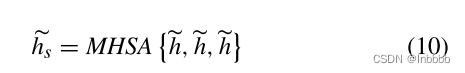

2.5 INFORMATION INTERACTIVE LEARNING LAYER

作用:提取更丰富的上下文语义和情感 ,并交互式地学习句法和全局语义信息

在得到GCN的输出后,我们使用多头注意力捕捉跟丰富的语义信息:

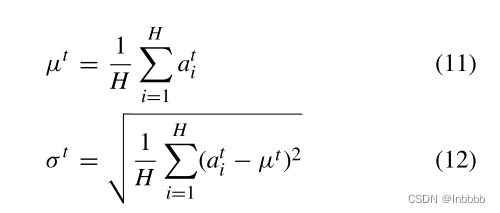

同时,我们采用层归一化(layer normalization)对句法特征和全局语义特征进行交互学习

其中![]() 为BERT提取的语义特征与GCN提取的句法特征的融合,如下图标注的位置所示。H为GCN的层数

为BERT提取的语义特征与GCN提取的句法特征的融合,如下图标注的位置所示。H为GCN的层数

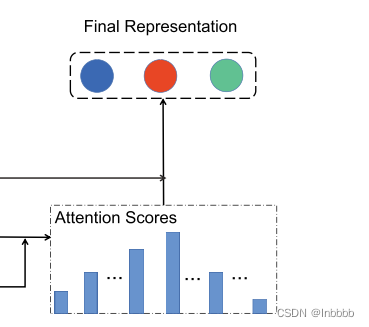

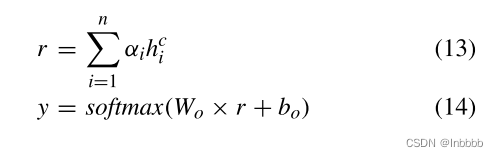

2.6 OUTPUT LAYER

最后,将层归一化的输出和Bert的输出相乘,得到注意力分数,将该分数送到softmax函数得到最终预测的情感极性。

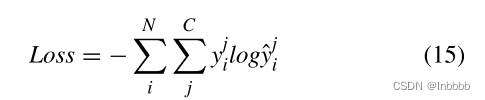

2.7 TRAINING

三、EXPERIMENTS

486

486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?