在Windows上配置好相关环境

1.scala的安装

在安装前需要安装好jdk1.8,这里不再作赘述

官网https://www.scala-lang.org/download/选择相应版本

配置 系统环境变量

Win键 -设置 -系统 -系统信息 -高级系统设置 -环境变量

在 系统变量 下新建

变量名:SCALA_HOME 变量值 :Scala的安装路径

在找到 path 编辑 -- 新建

%SCALA_HOME%\bin

查看是否安装成功:win+r 进入shell命令行输入 scala -version 如图即为成功

2.Hadoop的安装

官网 Apache Hadoop 找到合适版本(下载3.3.6版本就行)

配置 系统环境变量

Win键 -设置 -系统 -系统信息 -高级系统设置 -环境变量

在 系统变量 下新建

变量名:HADOOP_HOME 变量值 :Hadoop的安装路径

在找到 path 编辑 -- 新建(这里要新建两个)

%HADOOP_HOME%\bin

%HADOOP_HOME%\sbin

完成上述还需要添加Hadoop的动态链接库 hadoop.dll

依赖资料:https://pan.baidu.com/s/1aU4iiGjknUwxWSBlwBZEOw?pwd=2eur

进入C:\Windows\System32 把hadoop.dll添加到该目录

再进入Hadoop的bin 目录下,把winutils.exe 添加到该目录,

然后双击winutils.exe启动(快速闪动几下即为成功,如果报错,需要安装微软的运行库 见 依赖资料)

在IDEA上创建maven文件

1.下载maven

官网https://maven.apache.org 下载合适版本

配置setting.xml文件

打开maven文件,在conf里找到setting.xml编辑

(1)设置本地仓库

<settings xmlns="http://maven.apache.org/SETTINGS/1.2.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.2.0 https://maven.apache.org/xsd/settings-1.2.0.xsd">

<!-- localRepository

| The path to the local repository maven will use to store artifacts.

|

| Default: ${user.home}/.m2/repository -->

<localRepository>D:/Maven/apache-maven-3.8.4/repository</localRepository>

这个要将 <localRepository> </localRepository>标签写出来,地址为本地仓库名字,后续的查找相关的jar包会现在本地仓库寻找(由于第一次要从中央仓库中下载,所以加载的速慢点是正常的)

(2)修改Maven的jdk版本

<profile> <id>JDK-1.8</id> <activation> <activeByDefault>true</activeByDefault> <jdk>1.8</jdk> </activation> <properties> <maven.compiler.source>1.8</maven.compiler.source> <maven.compiler.target>1.8</maven.compiler.target> <maven.compiler.compilerVersion>1.8</maven.compiler.compilerVersion> </properties> </profile>

找到<profiles></profiles> 标签写在里面即可

(3)添加国内镜像源 写到<mirrors></mirrors>标签中

<!-- 阿里云仓库 --> <mirror> <id>alimaven</id> <mirrorOf>central</mirrorOf> <name>aliyun maven</name> <url>http://maven.aliyun.com/nexus/content/repositories/central/</url> </mirror> <!-- 中央仓库1 --> <mirror> <id>repo1</id> <mirrorOf>central</mirrorOf> <name>Human Readable Name for this Mirror.</name> <url>http://repo1.maven.org/maven2/</url> </mirror> <!-- 中央仓库2 --> <mirror> <id>repo2</id> <mirrorOf>central</mirrorOf> <name>Human Readable Name for this Mirror.</name> <url>http://repo2.maven.org/maven2/</url> </mirror>

这样对于文件的配置进本完成,后续有需要可以在添加修改

注意设置到 IDEA 的全局中

直接搜索maven即可

i : Maven主路径设置为自己的安装路径

ii :用户设置文件设置为Maven的conf文件夹下的settings.xml 文件,并注意后面打上对号

iii :本地仓库注意看看是否是自己设置的仓库,不是的话,修改下即可

2.打开IDEA

安装Scala插件,File->Settings->Editor->Plugins,搜索scala即可安装

创建Maven工程,File->New Project 选择相应的JDK版本,build system选择Maven

进入项目,在src目录下的pom.xml文件添加配置

<dependencies> <!-- https://mvnrepository.com/artifact/org.apache.spark/spark-core --> <dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-core_2.11</artifactId> <version>2.3.1</version> </dependency> </dependencies>

可以进入https://mvnrepository.com,搜索spark,点击Spark Project Core复制相应版本的依赖包粘贴到pom.xml中

如上四个都可添加相应配置到pom.xml,这里暂且不添加

---------------------------------------------------注意---------------------------------------------------------------

!在我最后完成maven打包后通过spark-submit脚本将WordCount程序提交到Spark Standalone集群运行时,发现我上传的 .jar 包找不到我的Scala类

后面发现要在pom文件中设置先编译Scala:

在pom文件的build->plugins下添加plugin:

<plugin>

<groupId>net.alchim31.maven</groupId>

<artifactId>scala-maven-plugin</artifactId>

<version>3.2.2</version>

<executions>

<execution>

<id>scala-compile-first</id>

<phase>process-resources</phase>

<goals>

<goal>compile</goal>

</goals>

</execution>

<execution>

<id>scala-test-compile</id>

<phase>process-test-resources</phase>

<goals>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

<configuration>

<jvmArgs>

<jvmArg>-Xms128m</jvmArg>

<jvmArg>-Xmx512m</jvmArg>

</jvmArgs>

</configuration>

</plugin>

(添加完后再重新打包mvn clean package 即可)

顺利输出结果

---------------------------------------------------------------------------------------------------------------------------------

添加完成后需要刷新一下maven,点击该图标加载新的资源

(第一次加载库可能需要一些时间,请耐心等待)

选中项目中src目录下的main新建文件,命名scala;同样在test新建Scala文件

右击main里的scala,选择mark directory as --sources root,文件变为蓝色

同理,将test里的是scala变为绿色

完成后可以删除Java文件

右键项目,选择 打开组件设置 如图

在 组件 中也可以完成文件标记

在 库 中添加如 scala sdk

在 全局库 中添加 Scala sdk 如上

3.编写WordCount程序

在scala中新建Scala class

编写程序 (注意:与书上不同,这里我多添加了 conf.setMaster("local[*]") 让本机提供运算)

原因:报错org.apache.spark.SparkException: A master URL must be set in your configuration

解决:val conf = new SparkConf().setAppName("my WordCount").setMaster("local[*]")

import org.apache.spark.{SparkConf, SparkContext}

object Spark{

def main(args:Array[String]): Unit = {

// conf.setMaster("local[*]")

//参数检查

if(args.length < 2) {

System.err.println("usage: MyWordCount<input><output>")

System.exit(1)

}

//获取参数

val input = args(0)

val output = args(1)

//创建Scala版本的Spark Context

val conf = new SparkConf().setAppName("my WordCount").setMaster("local[*]")

val sc = new SparkContext(conf)

//读取数据

val lines = sc.textFile(input)

//进行相关计算

val resultRdd = lines.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_)

//保存结果

resultRdd.saveAsTextFile(output)

sc.stop()

}

}

打开IDEA参数配置编辑界面,输入WordCount的输入和输出路径

运行

找到输出路径下的文件

打开part-00001,成功

4.执行打包操作

普通打包

--------------------------------------------------可忽略,仅参考----------------------------------------------------------

打开Run/Debug Configuarations窗⼝

输⼊对应的打包命令

打包成功后存放的目录

-----------------------------------------------------------截止--------------------------------------------------------------

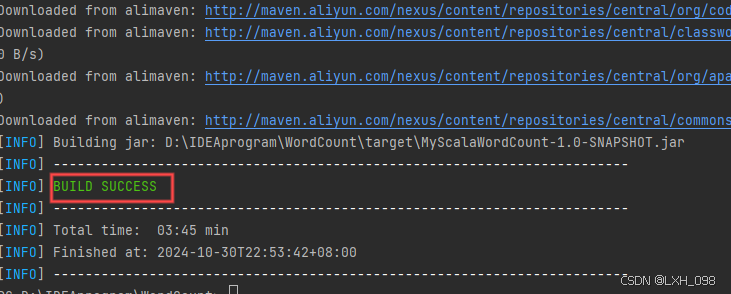

忽略上面,直接在Terminal中输入mvn clean package打包项目就可以了

Terminal在idea最下面可以找到

如上即为成功

在target目录里可以找到打包好的jar包

1599

1599

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?