前言:集中式收集管理日志方案

rsyslog、

shell/python脚本、

ELK(Elasticsearch+Logstash+Kibana)、

Loki+promtail+grafana

1.服务器数量较少时:

(1)不做任何日志收集分析,直接登录到服务器捞日志查看(缺点:当服务器不可用时,无法及时收集到日志)

(2)通过 rsyslog 或 shell / python 脚本 实现自动收集日志,集中保存到统一的日志服务器中

2.当服务器数量较多时:

采用大型的日志系统 ELK 或 EFK,实现自动日志收集、日志集中存储、日志图形展示等功能

云原生——容器环境

EFK、Loki、阿里云SLS

一.ELK (Elasticsearch、Logstash、Kibana) 日志系统概述

1.背景

最近在分布式系统开发中,由于请求的调用链长,且业务复杂,当系统出现bug或者错误时,在服务器上使用vim编辑器查看日志给我们带来了极大的困扰。为了更好的监控系统的运行、错误排查以及通过日志对数据进行分析等,我们引入了ELK作为我们的日志分析工具。

2.简介

ELK平台是一套完整的日志集中处理解决方案,将 ElasticSearch、Logstash 和 Kiabana 三个开源工具配合使用, 完成更强大的用户对日志的查询、排序、统计需求。

3.组成部分

它是一套用于处理大规模日志和实时数据分析的开源解决方案,由以下三个主要组件组成

Elasticsearch:它是一个高度可扩展的分布式搜索和分析引擎。Elasticsearch提供了快速的全文搜索、复杂查询、实时分析和数据可视化的功能。它还具有水平扩展性,可以处理大规模的数据集和高并发查询。

Logstash:它是一个用于数据收集、转换和传输的开源工具。它可以从多个来源(如日志文件、消息队列、数据库等)收集数据,并将其转换为统一的格式。Logstash还支持对数据进行过滤、增强和转换,以便更好地进行存储和分析。

Kibana:它是一个用于数据可视化和交互的开源工具。它提供了丰富的图表、图形和地图等可视化组件,用于展示和分析Elasticsearch中的数据。Kibana还提供了一个用户友好的界面,使用户能够轻松地创建和共享仪表板,并进行数据查询和导出。

日志处理步骤:

将日志进行集中化管理

将日志格式化 (logstash)并输出到 Elasticsearch

对格式化后的数据进行索引和存储( Elasticsearch )

前端数据的展示(Kibana)

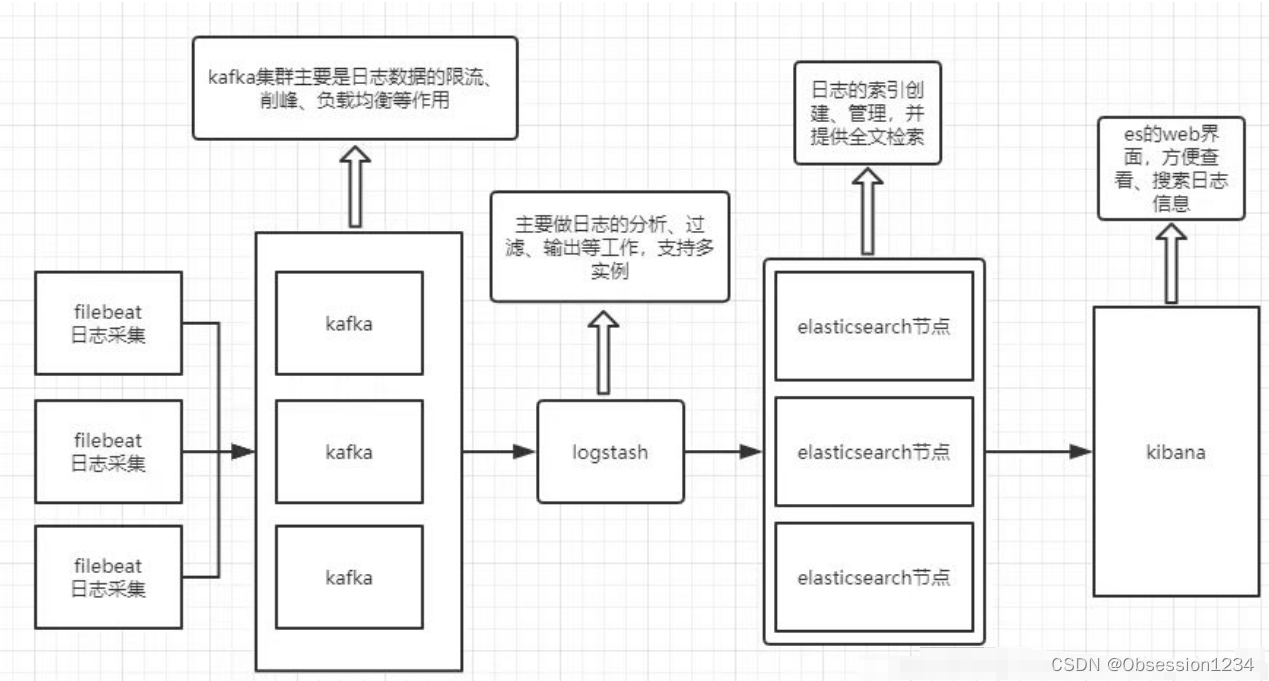

4.可以添加的其它组件

(1)Filebeat

轻量级的开源日志文件数据搜集器。通常在需要采集数据的客户端安装 Filebeat,并指定目录与日志格式,Filebeat 就能快速收集数据,并发送给 Logstash 进行解析,或是直接发给 Elasticsearch 存储,性能上相比运行于 JVM 上的 Logstash 优势明显(Logstash 对内存、CPU、IO 等资源消耗比较高) ,是对 Logstash 的替代。常应用于 ELFK 架构当中,也叫做 ELK Stack。

filebeat 结合 logstash 带来好处:

(1)通过 Logstash 具有基于磁盘的自适应缓冲系统,该系统会吸收传入的吞吐量,从而减轻 Elasticsearch 持续写入数据的压力

(2)从其他数据源(例如数据库,S3对象存储或消息传递队列)中提取

(3)将数据发送到多个目的地,例如S3,HDFS(Hadoop分布式文件系统)或写入文件

(4)使用条件数据流逻辑组成更复杂的处理管道

(2)缓存/消息队列(Redis、Kafka、RabbitMQ等)

可以对高并发日志数据进行流量削峰和缓冲,这样的缓冲可以一定程度的保护数据不丢失,还可以对整个架构进行应用解耦。

(3)Fluentd

是一个流行的开源数据收集器。由于 Logstash 太重量级的缺点,Logstash 性能低、资源消耗比较多等问题,随后就有 Fluentd 的出现。相比较 Logstash,Fluentd 更易用、资源消耗更少、性能更高,在数据处理上更高效可靠,受到企业欢迎,成为 Logstash 的一种替代方案,常应用于 EFK 架构当中。在 Kubernetes 集群中也常使用 EFK 作为日志数据收集的方案。

在 Kubernetes 集群中一般是通过 DaemonSet 来运行 Fluentd,以便它在每个 Kubernetes 工作节点上都可以运行一个 Pod。 它通过获取容器日志文件、过滤和转换日志数据,然后将数据传递到 Elasticsearch 集群,在该集群中对其进行索引和存储。

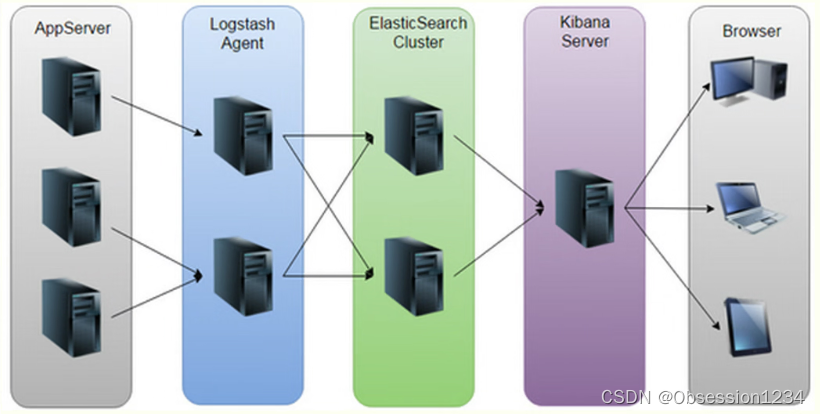

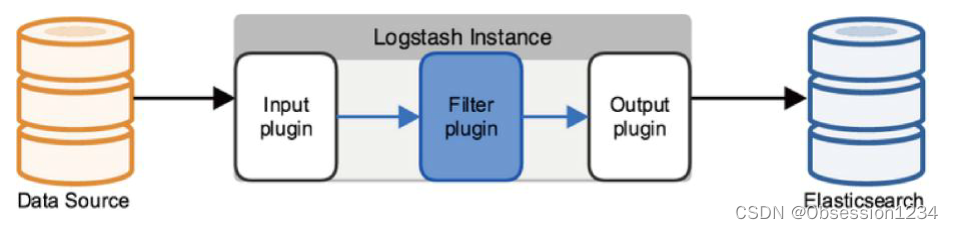

5.ELK 的工作原理

(1)在所有需要收集日志的服务器上部署 Logstash;或者先将日志进行集中化管理在日志服务器上,在日志服务器上部署 Logstash。

(2)Logstash 收集日志,将日志格式化并输出到 Elasticsearch 群集中。

(3)Elasticsearch 对格式化后的数据进行索引和存储。

(4)Kibana 从 ES 群集中查询数据生成图表,并进行前端数据的展示。

总结:Logstash 作为日志搜集器,从数据源采集数据,并对数据进行过滤,格式化处理,然后交由 Elasticsearch 存储,Kibana 对日志进行可视化处理。

二.ELK 安装部署

准备三台虚拟机分别是

192.168.10.60(node1)

192.168.10.70(node2)

192.168.10.80(node3)

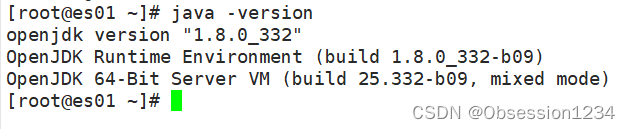

1.初始化操作和准备Java环境

systemctl stop firewalld

systemctl disable --now firewalld

setenforce 0

vim /etc/seliux/config

#设置为disabledjava -version #默认已安装,如果没安装就使用下面命令

yum -y install java-1.8.0-openjdk*

2.部署 Elasticsearch 软件(全部主机操作)

(1)安装elasticsearch—rpm包

上传数据包至/opt/目录下

cd /opt/

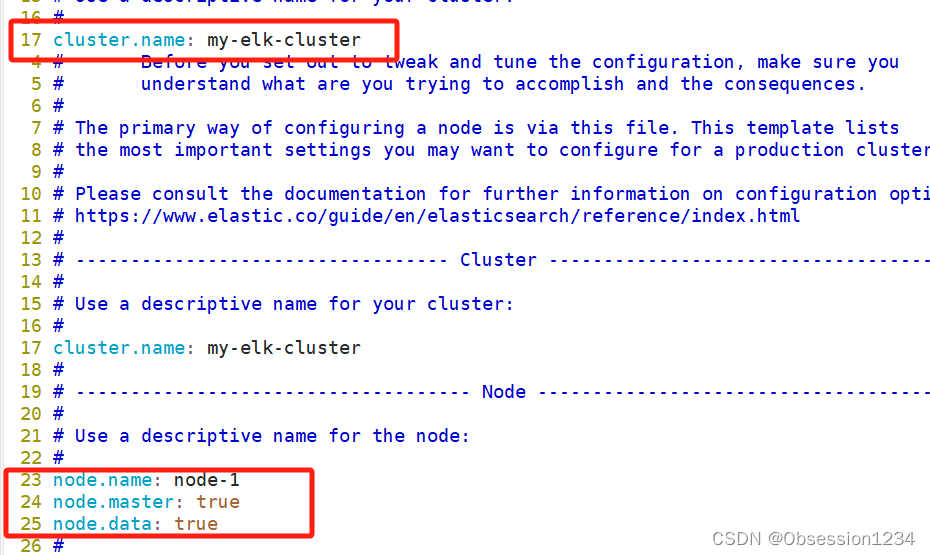

yum localinstall -y elasticsearch-6.7.2.rpm(2)修改elasticsearch主配置文件

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

#做备份

vim /etc/elasticsearch/elasticsearch.yml

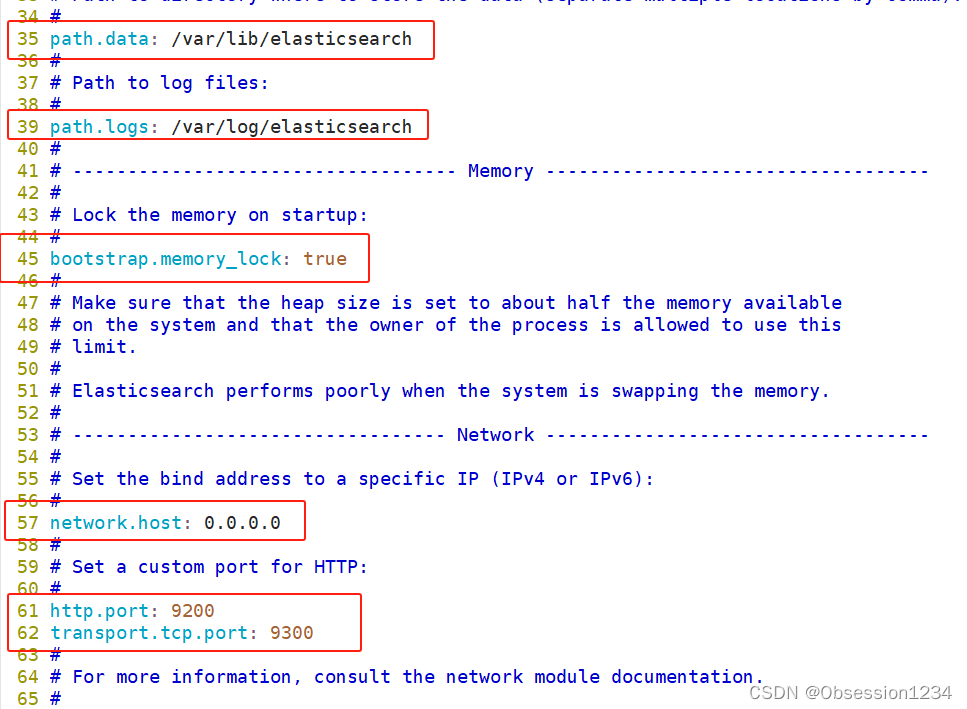

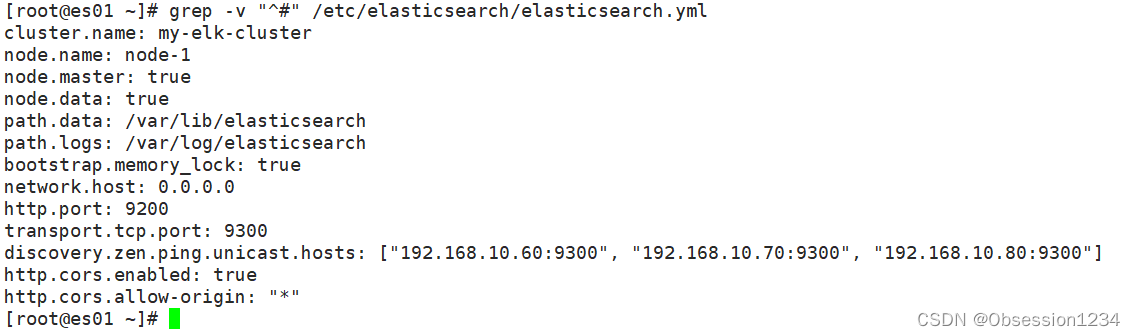

--17--取消注释,指定集群名字

cluster.name: my-elk-cluster

--23--取消注释,指定节点名字:Node1节点为node1,Node2节点为node2

node.name: node1

node.master: true #是否master节点,false为否

node.data: true #是否数据节点,false为否

--33--取消注释,指定数据存放路径

path.data: /var/lib/elasticsearch

--37--取消注释,指定日志存放路径

path.logs: /var/log/elasticsearch

--43--取消注释,将系统内存锁定到es进程中,以保证es能够维护一定的内存空间,避免es使用swap交换分区

bootstrap.memory_lock: true

--55--取消注释,设置监听地址,0.0.0.0代表所有地址

network.host: 0.0.0.0

--59--取消注释,ES 服务的默认监听端口为9200

http.port: 9200 #指定es集群提供外部访问的接口

transport.tcp.port: 9300 #指定es集群内部通信接口

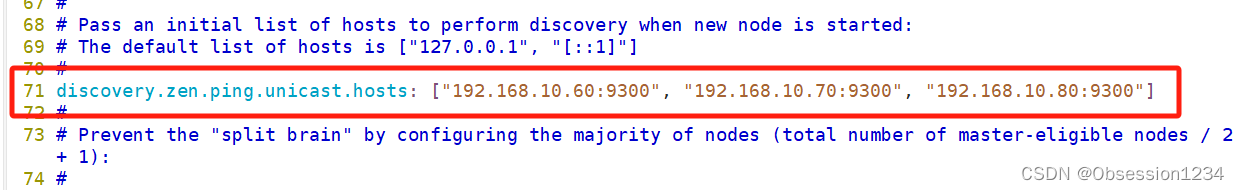

--68--取消注释,集群发现通过单播实现,指定要发现的节点

discovery.zen.ping.unicast.hosts: ["192.168.80.10:9300", "192.168.80.11:9300"]

grep -v "^#" /etc/elasticsearch/elasticsearch.yml

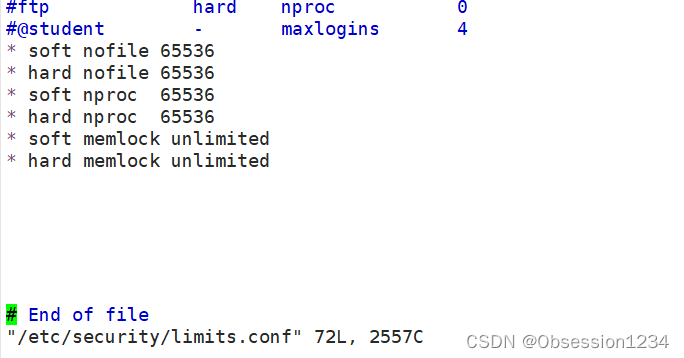

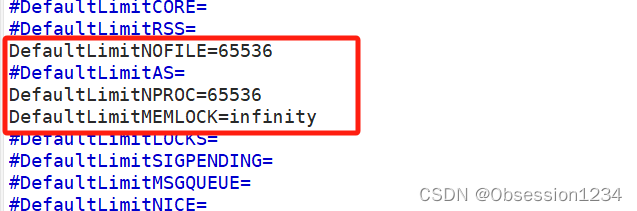

(3)es 性能调优参数

优化最大内存大小和最大文件描述符的数量

vim /etc/security/limits.conf* soft nofile 65536

* hard nofile 65536

* soft nproc 32000

* hard nproc 32000

* soft memlock unlimited

* hard memlock unlimited

vim /etc/systemd/system.conf

需重启后生效

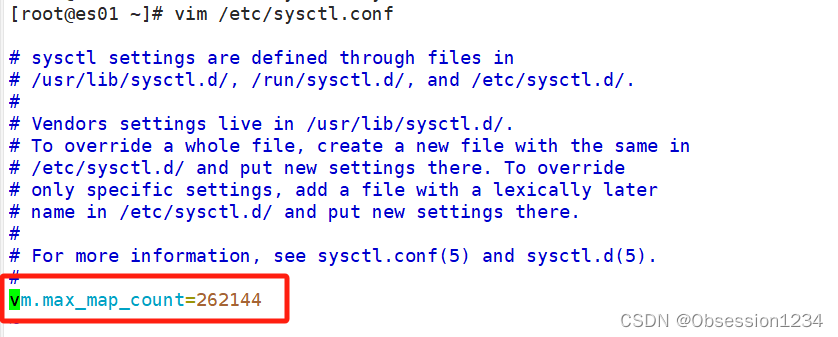

优化elasticsearch用户拥有的虚拟内存

由于ES构建基于lucene, 而lucene设计强大之处在于lucene能够很好的利用操作系统内存来缓存索引数据,以提供快速的查询性能。lucene的索引文件segements是存储在单文件中的,并且不可变,对于OS来说,能够很友好地将索引文件保持在cache中,以便快速访问;因此,我们很有必要将一半的物理内存留给lucene ; 另一半的物理内存留给ES(JVM heap )。所以, 在ES内存设置方面,可以遵循以下原则:

1.当机器内存小于64G时,遵循通用的原则,50%给ES,50%留给操作系统,供lucene使用

2.当机器内存大于64G时,遵循原则:建议分配给ES分配 4~32G 的内存即可,其它内存留给操作系统,供lucene使用

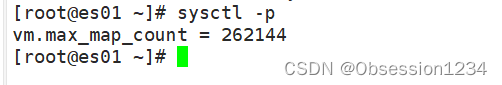

vim /etc/sysctl.confvm.max_map_count=262144sysctl -p

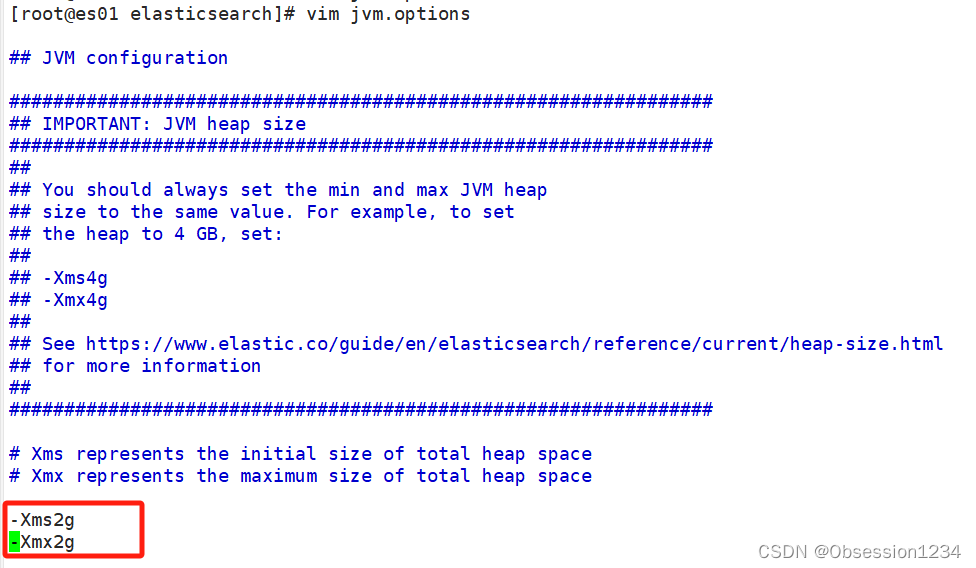

cd /etc/elasticsearch

vim jvm.options

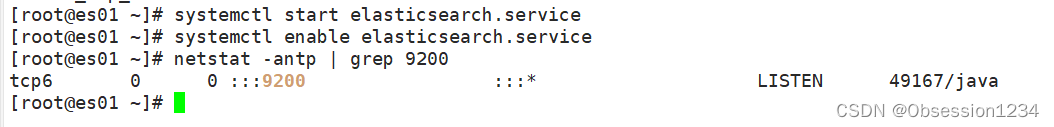

(4)启动elasticsearch是否成功开启

systemctl start elasticsearch.service

systemctl enable elasticsearch.service

netstat -antp | grep 9200

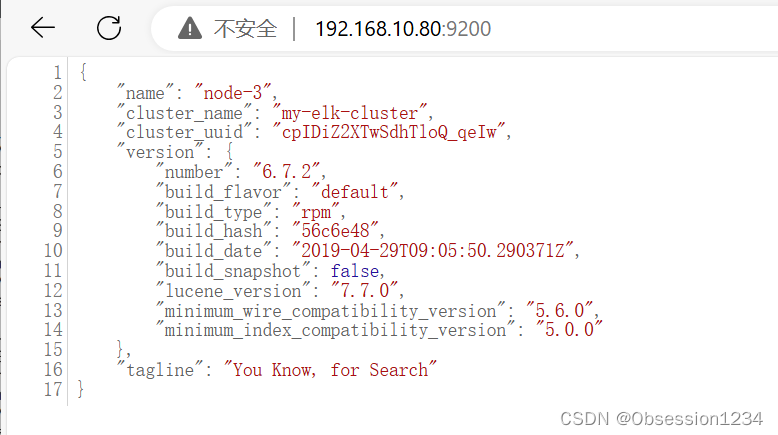

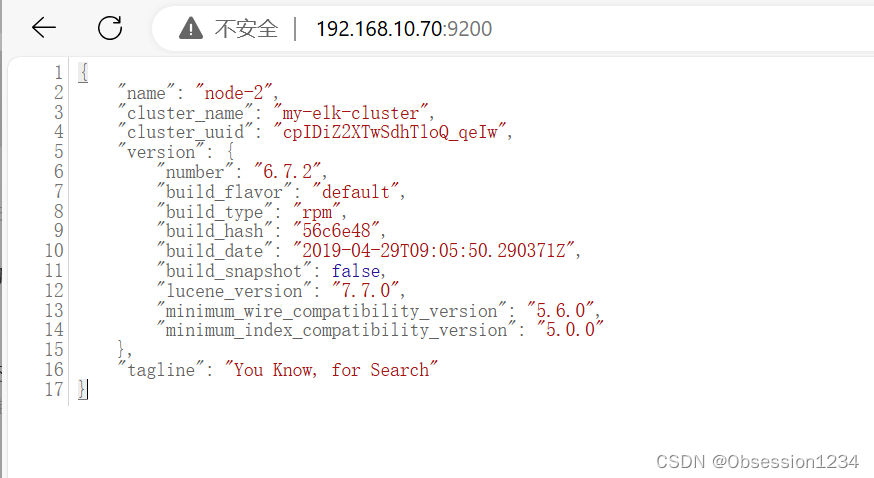

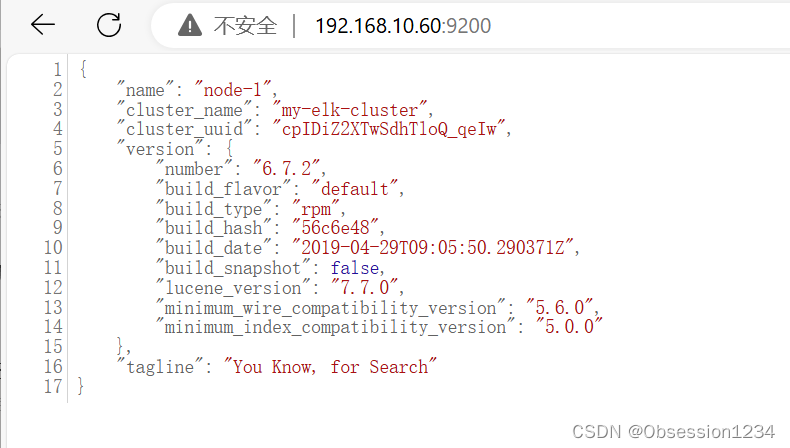

(5)查看节点信息

浏览器访问 http://192.168.10.60:9200 、 http://192.168.80.11:9200 查看节点 Node1、Node2 的信息。

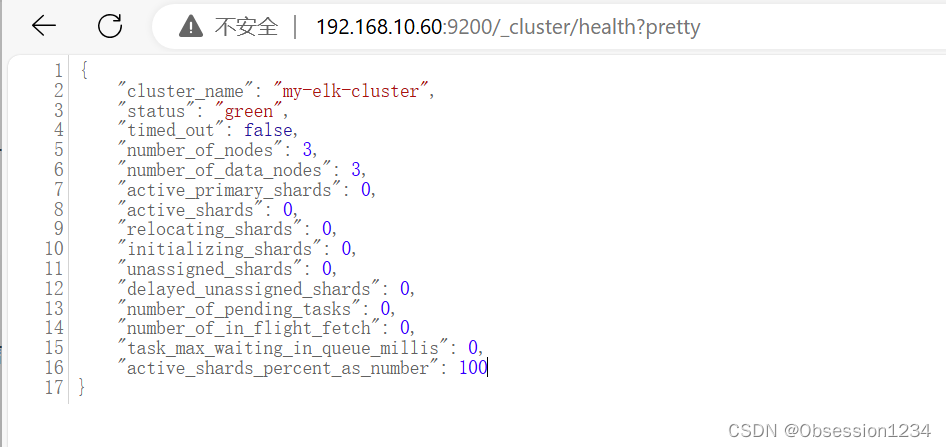

浏览器访问 http://192.168.10.60:9200/_cluster/health?pretty 、 http://192.168.80.11:9200/_cluster/health?pretty查看群集的健康情况,可以看到 status 值为 green(绿色), 表示节点健康运行。

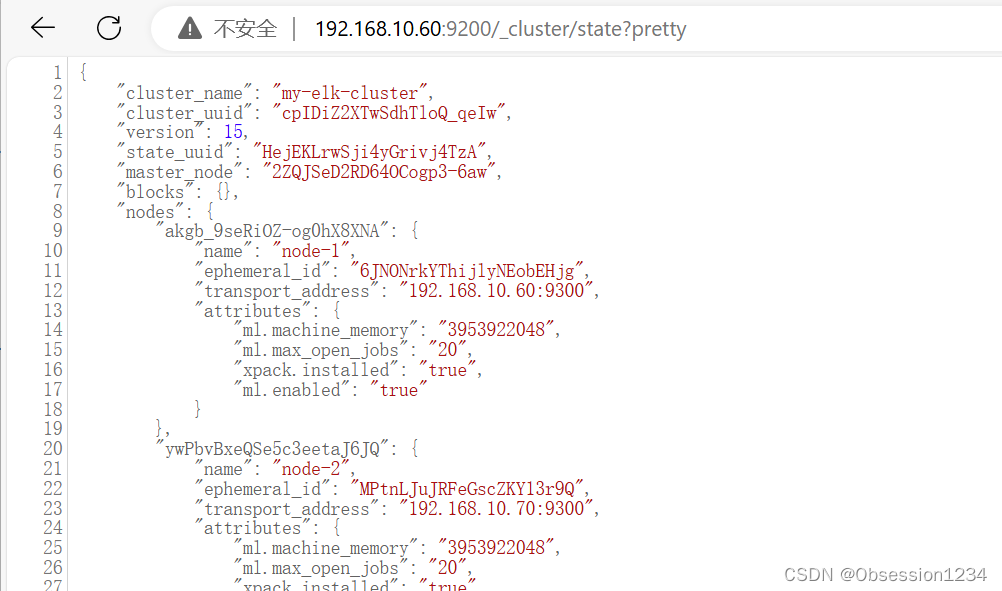

浏览器访问 http://192.168.10.60:9200/_cluster/state?pretty 检查群集状态信息。

使用上述方式查看群集的状态对用户并不友好,可以通过安装 Elasticsearch-head 插件,可以更方便地管理群集。

3.安装 Elasticsearch-head 插件(选择单个主机操作)

Elasticsearch 在 5.0 版本后,Elasticsearch-head 插件需要作为独立服务进行安装,需要使用npm工具(NodeJS的包管理工具)安装。

安装 Elasticsearch-head 需要提前安装好依赖软件 node 和 phantomjs。

node:是一个基于 Chrome V8 引擎的 JavaScript 运行环境。

phantomjs:是一个基于 webkit 的JavaScriptAPI,可以理解为一个隐形的浏览器,任何基于 webkit 浏览器做的事情,它都可以做到。

(1)编译安装 node

#上传软件包 node-v8.2.1.tar.gz 到/opt

yum install gcc gcc-c++ make -y

cd /opt

tar zxvf node-v8.2.1.tar.gz

cd node-v8.2.1/

./configure

make #等待时间较长

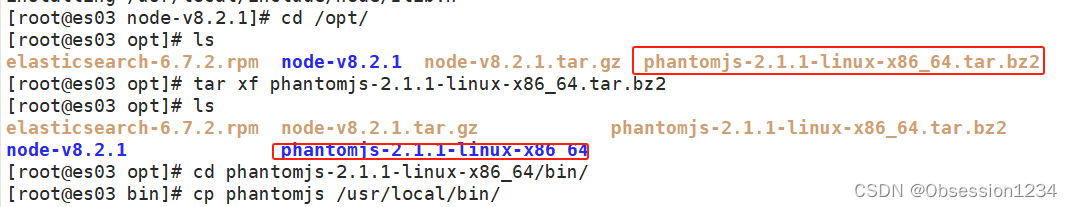

make install(2)安装 phantomjs

#上传软件包 phantomjs-2.1.1-linux-x86_64.tar.bz2 到opt目录下

cd /opt

tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2

cd /opt/phantomjs-2.1.1-linux-x86_64/bin

cp phantomjs /usr/local/bin

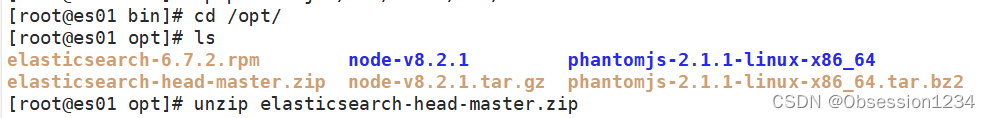

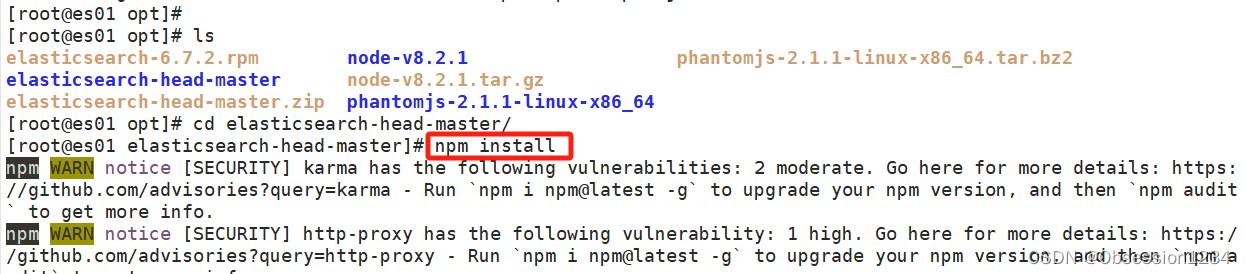

(3)安装 Elasticsearch-head 数据可视化工具

#上传软件包 elasticsearch-head-master.zip 到/opt

cd /opt

unzip elasticsearch-head-master.zip

cd /opt/elasticsearch-head/

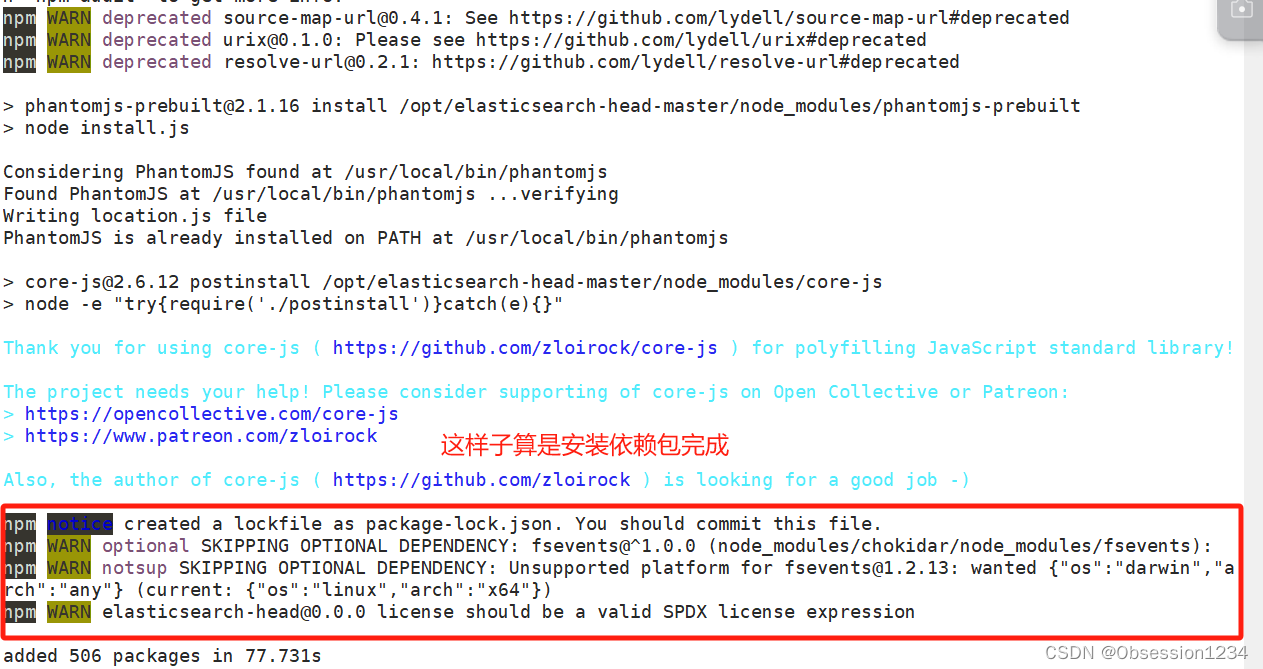

npm install //安装依赖包

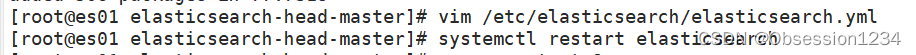

(4)修改 Elasticsearch 主配置文件

vim /etc/elasticsearch/elasticsearch.yml

......

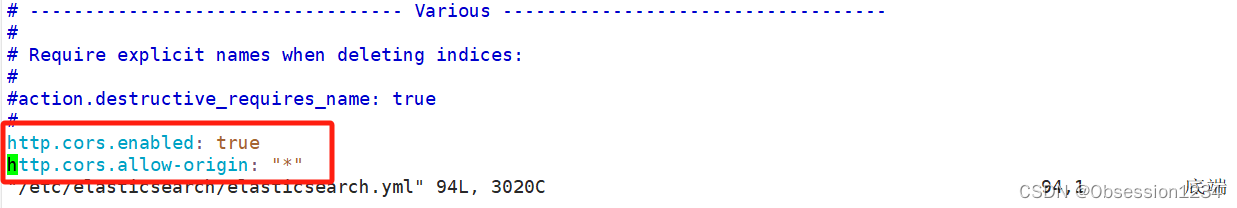

--末尾添加以下内容--

http.cors.enabled: true #开启跨域访问支持,默认为 false

http.cors.allow-origin: "*" #指定跨域访问允许的域名地址为所有

systemctl restart elasticsearch

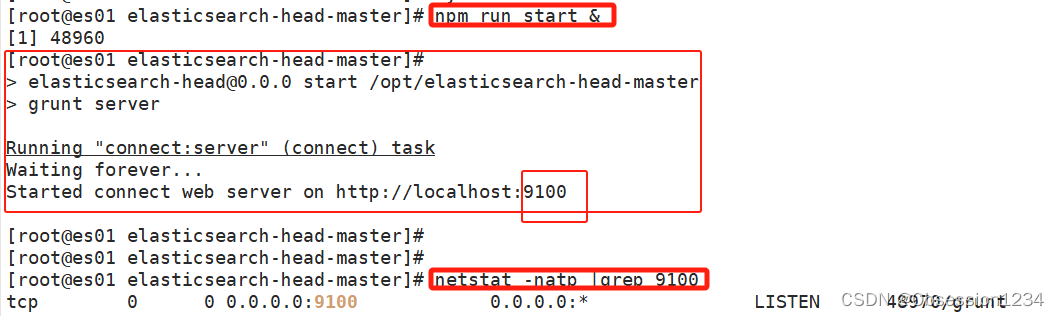

(5)启动 elasticsearch-head 服务

必须在解压后的 elasticsearch-head 目录下启动服务,进程会读取该目录下的 gruntfile.js 文件,否则可能启动失败。

cd /opt/elasticsearch-head/

npm run start &

netstat -natp |grep 9100

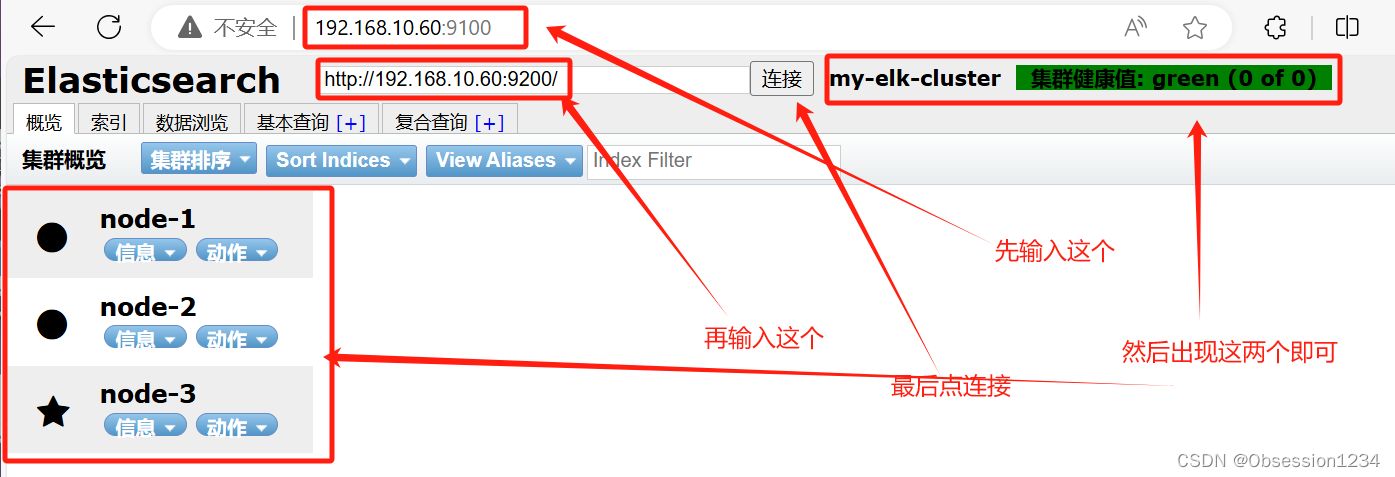

(6)通过 Elasticsearch-head 查看 Elasticsearch 信息

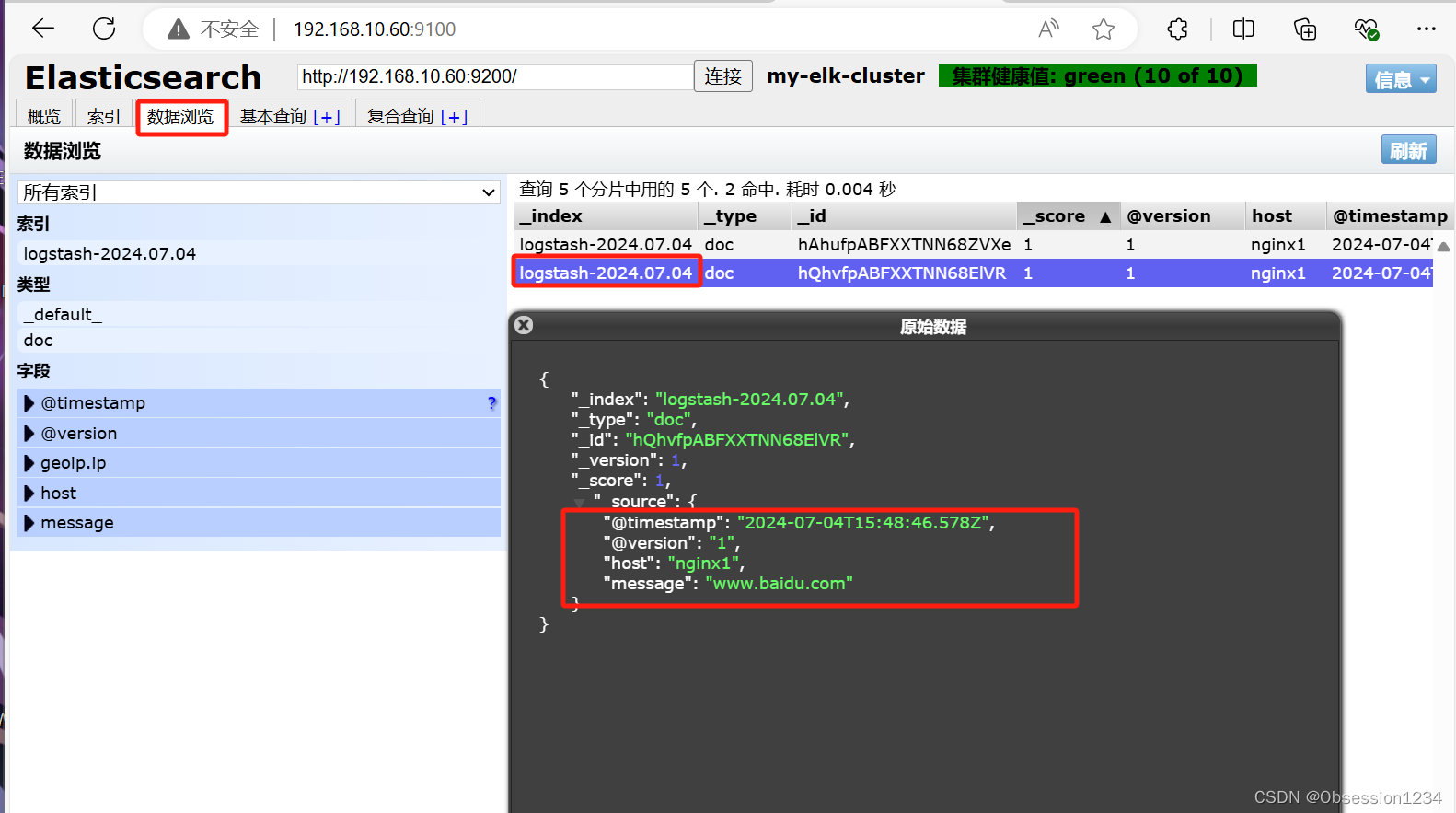

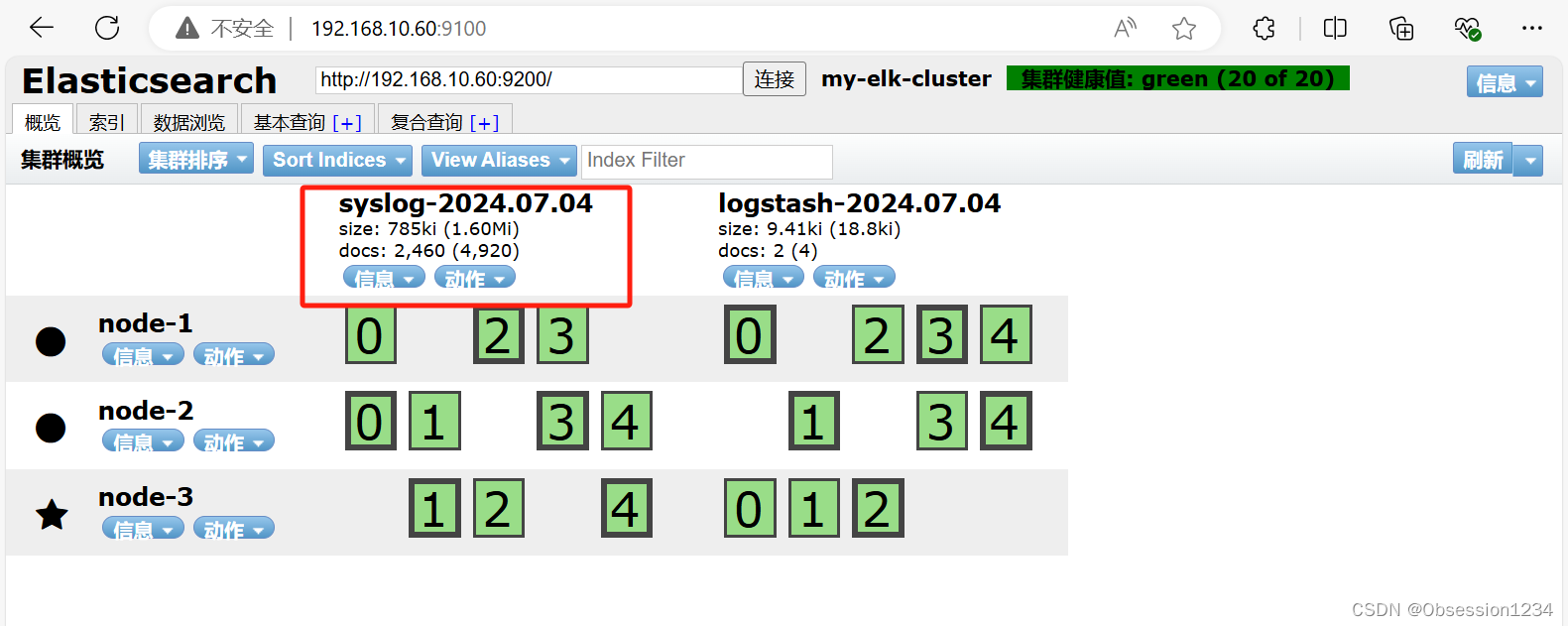

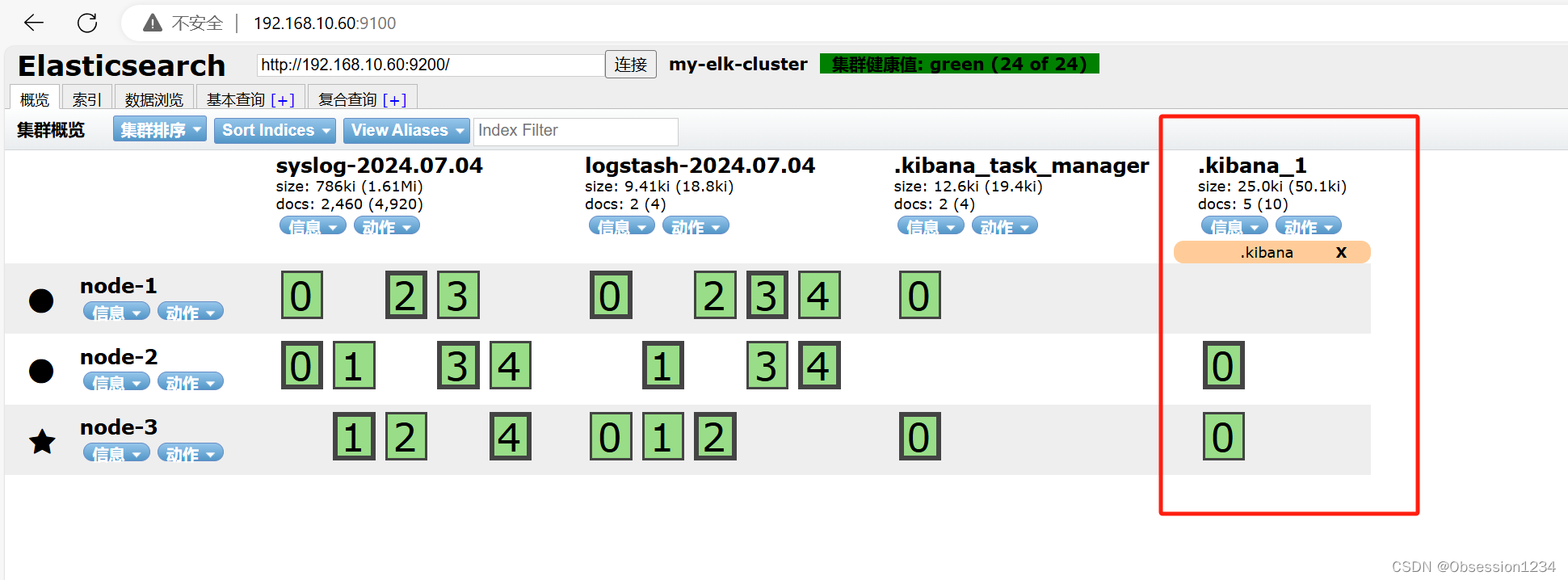

通过浏览器访问 http://192.168.10.60:9100/ 地址并连接群集。如果看到群集健康值为 green 绿色,代表群集很健康。

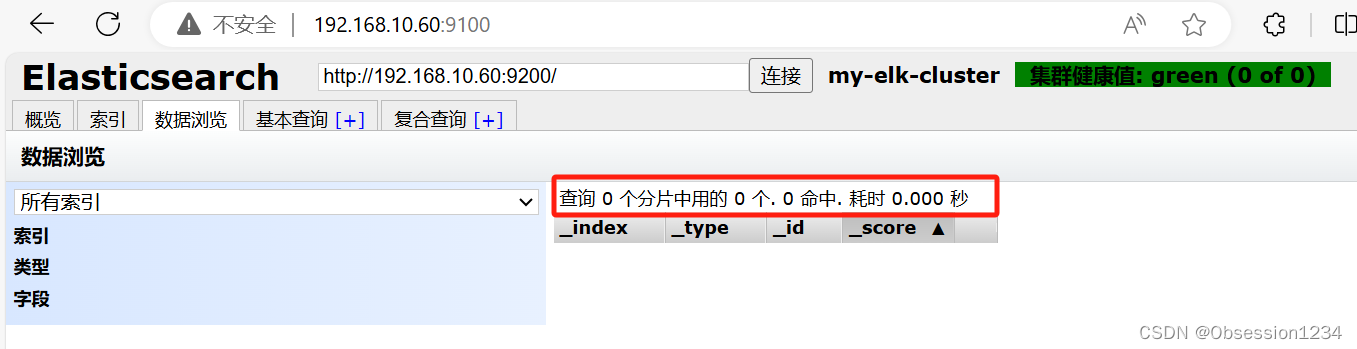

(7)创建索引

原本刚进去的网页内没有索引和数据

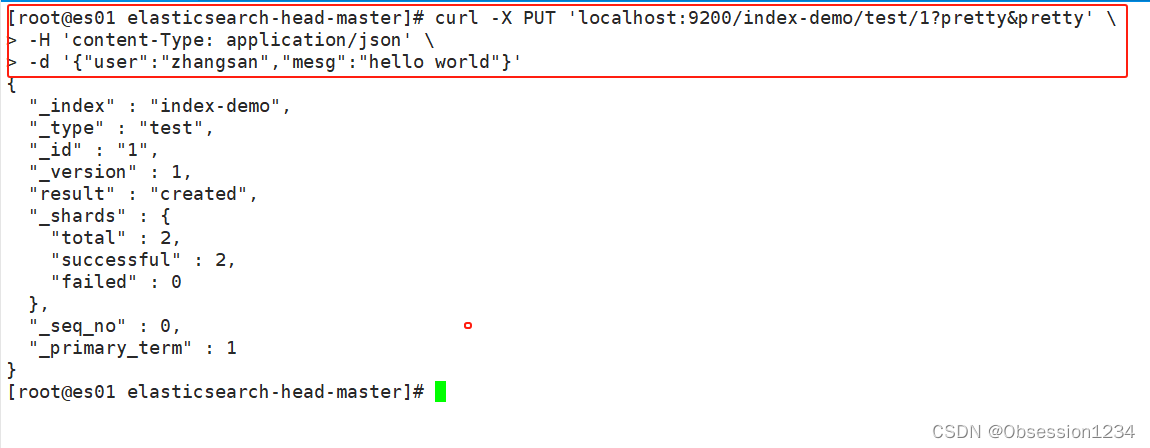

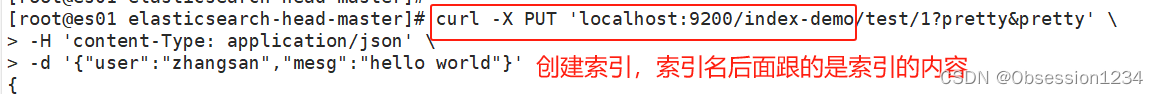

API基本格式:http://ip:port/<索引>/<类型>/<文档id>通过命令创建一个测试索引,索引为 index-demo,类型为 test。

curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' \

-H 'content-Type: application/json' \

-d '{"user":"zhangsan","mesg":"hello world"}'

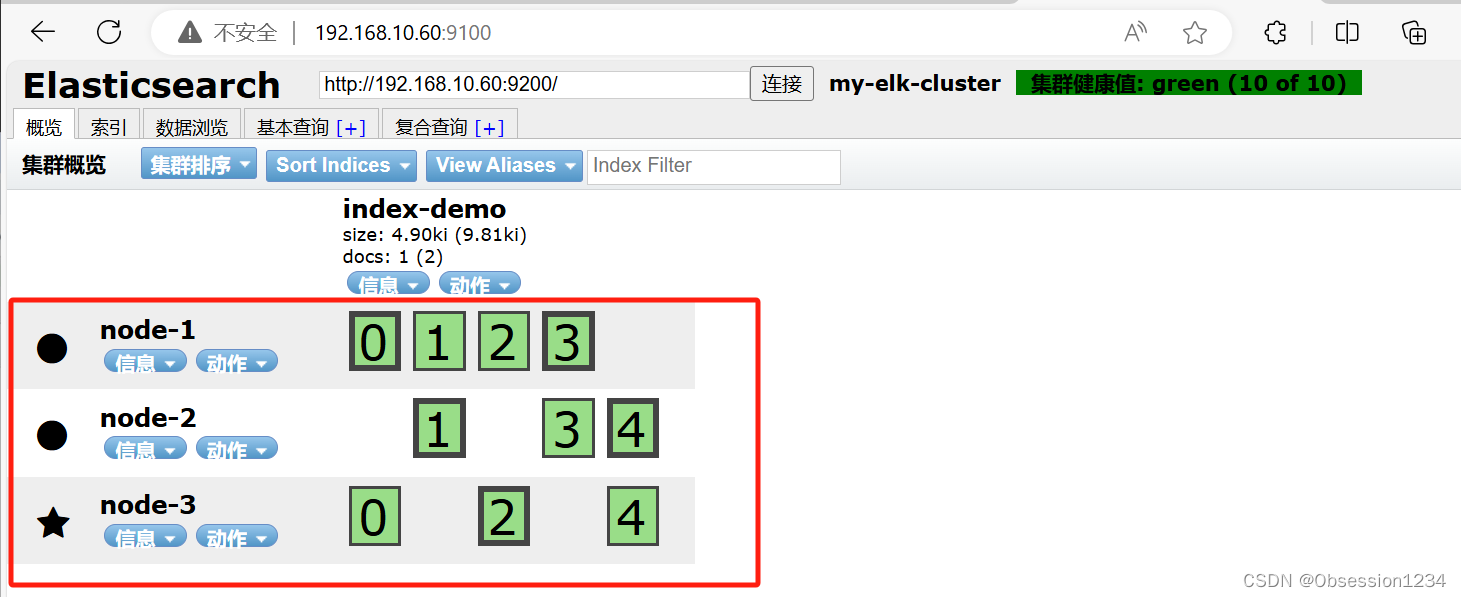

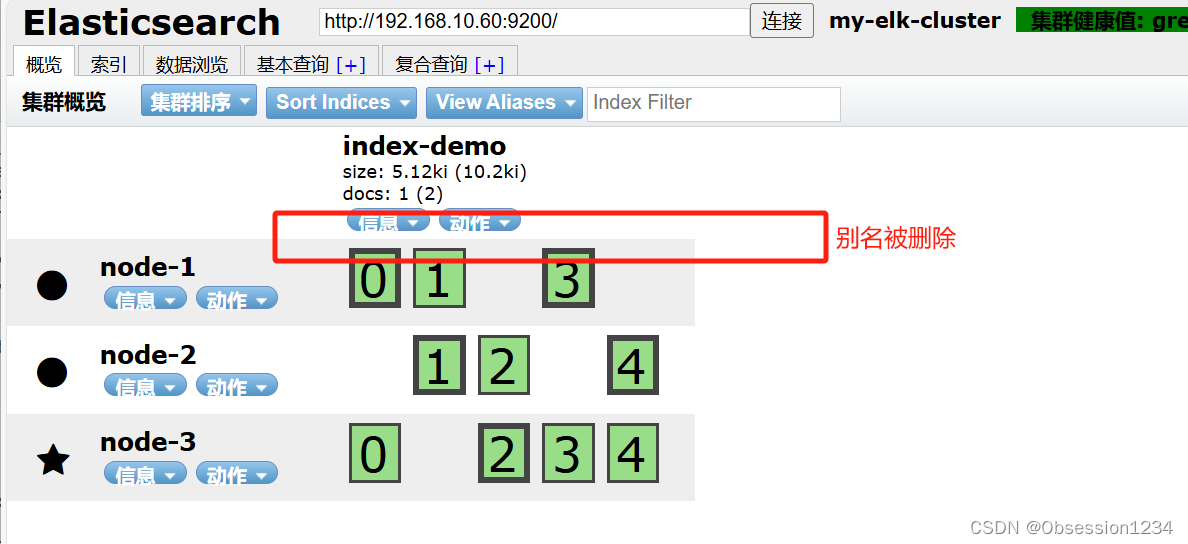

浏览器访问 http://192.168.10.60:9100/ 查看索引信息,可以看见索引默认被分片5个,并且有一个副本。

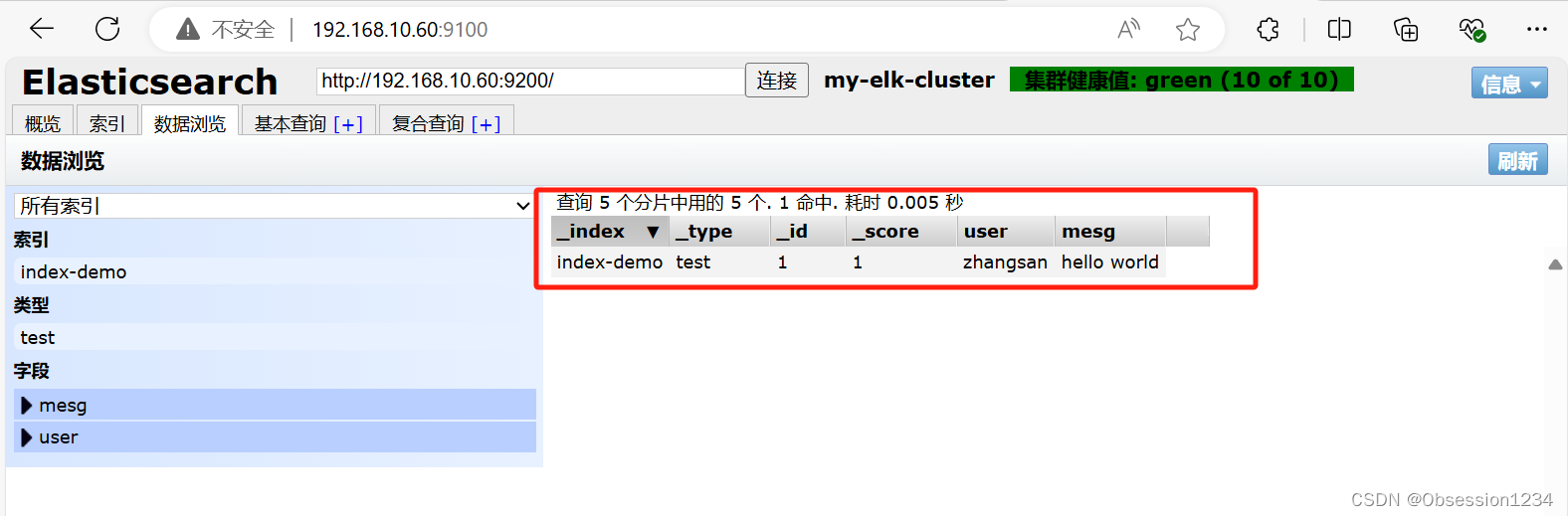

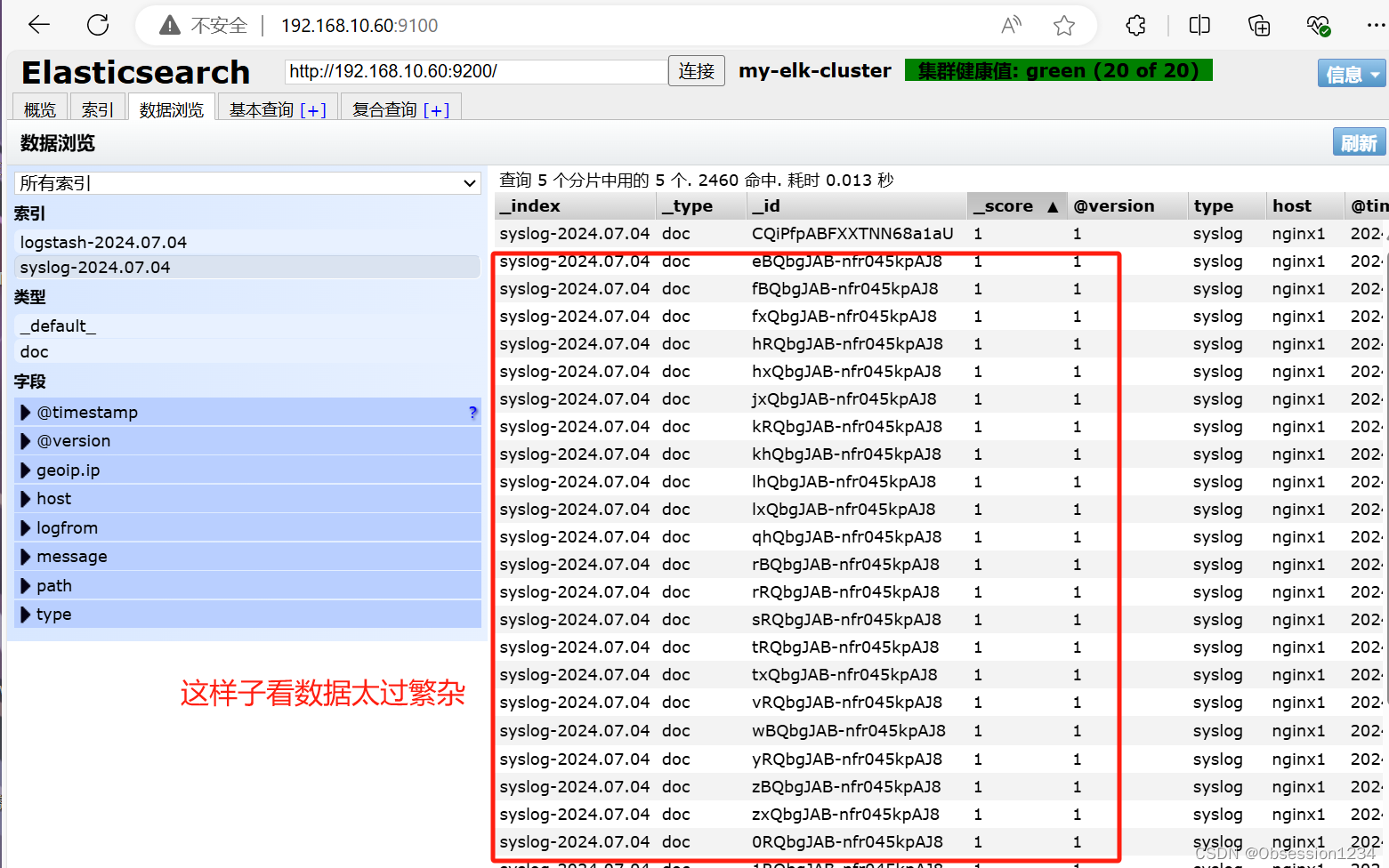

点击“数据浏览”,会发现在node1上创建的索引为 index-demo,类型为 test 的相关信息。

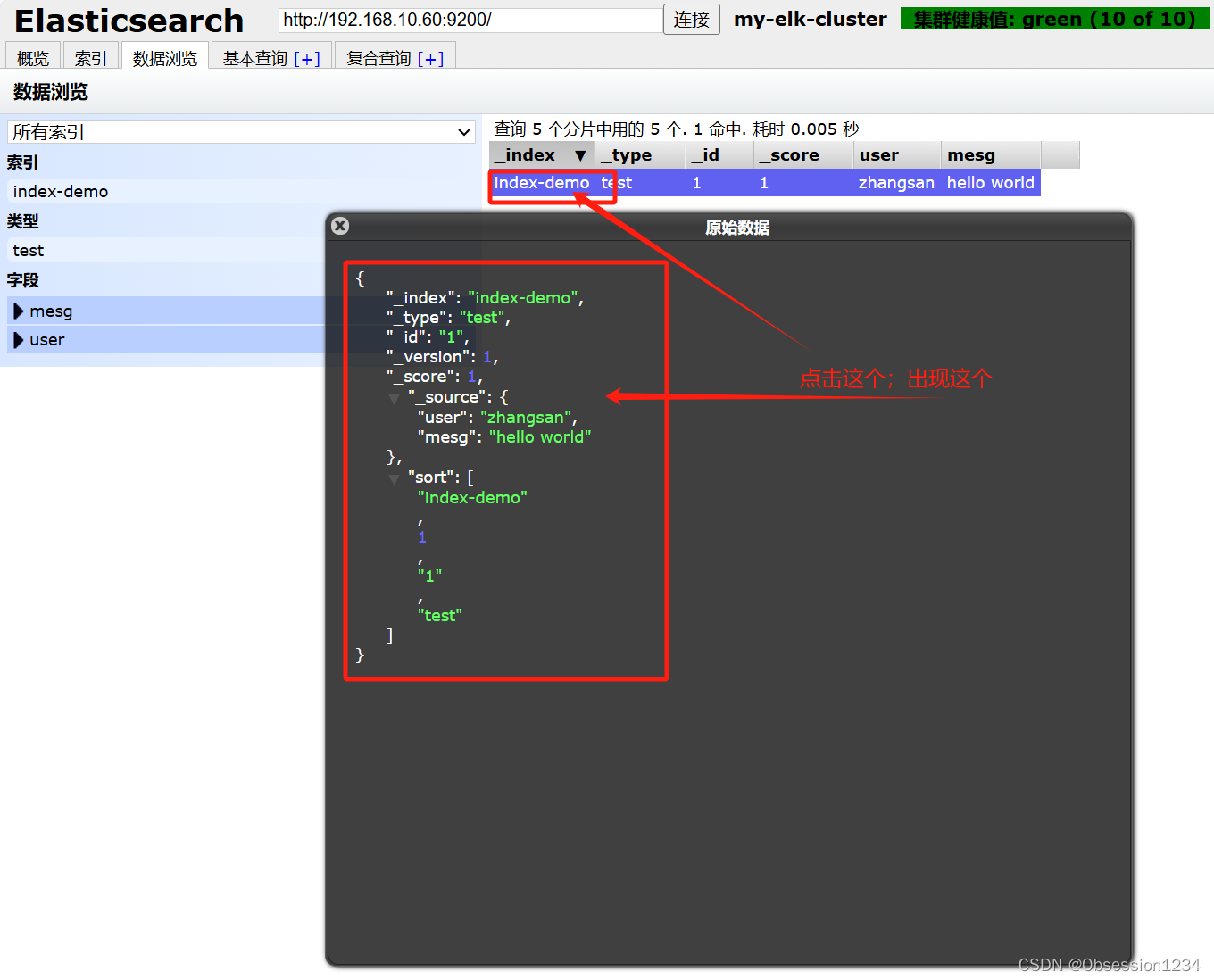

查看数据内容

拓展:Elasticsearch 索引管理

Elasticsearch索引管理:

1)命令行管理方式

创建索引

curl -X PUT 'http://ES-IP:9200/<索引名>/<类型>/<ID>?pretty&pretty' \

-H 'content-Type: application/json' -d '{"键1":"值1","键2":"值2"}'

删除索引

curl -X DELETE 'http://ES-IP:9200/<索引名>'

查看索引配置

curl -X GET 'http://ES-IP:9200/<索引名>/_settings'

修改索引配置

curl -X PUT 'http://ES-IP:9200/<索引名>/_settings' \

-H 'content-Type: application/json' -d '{"键":"值"}'

创建索引别名

curl -X POST 'http://ES-IP:9200/_aliases' \

-H 'Content-Type: application/json' -d '{"actions":[{"add":{"index":"索引名","alias":"索引别名"}}]}'

删除索引别名

curl -X POST 'http://ES-IP:9200/_aliases' \

-H 'Content-Type: application/json' -d '{"actions":[{"remove":{"index":"索引名","alias":"索引别名"}}]}'

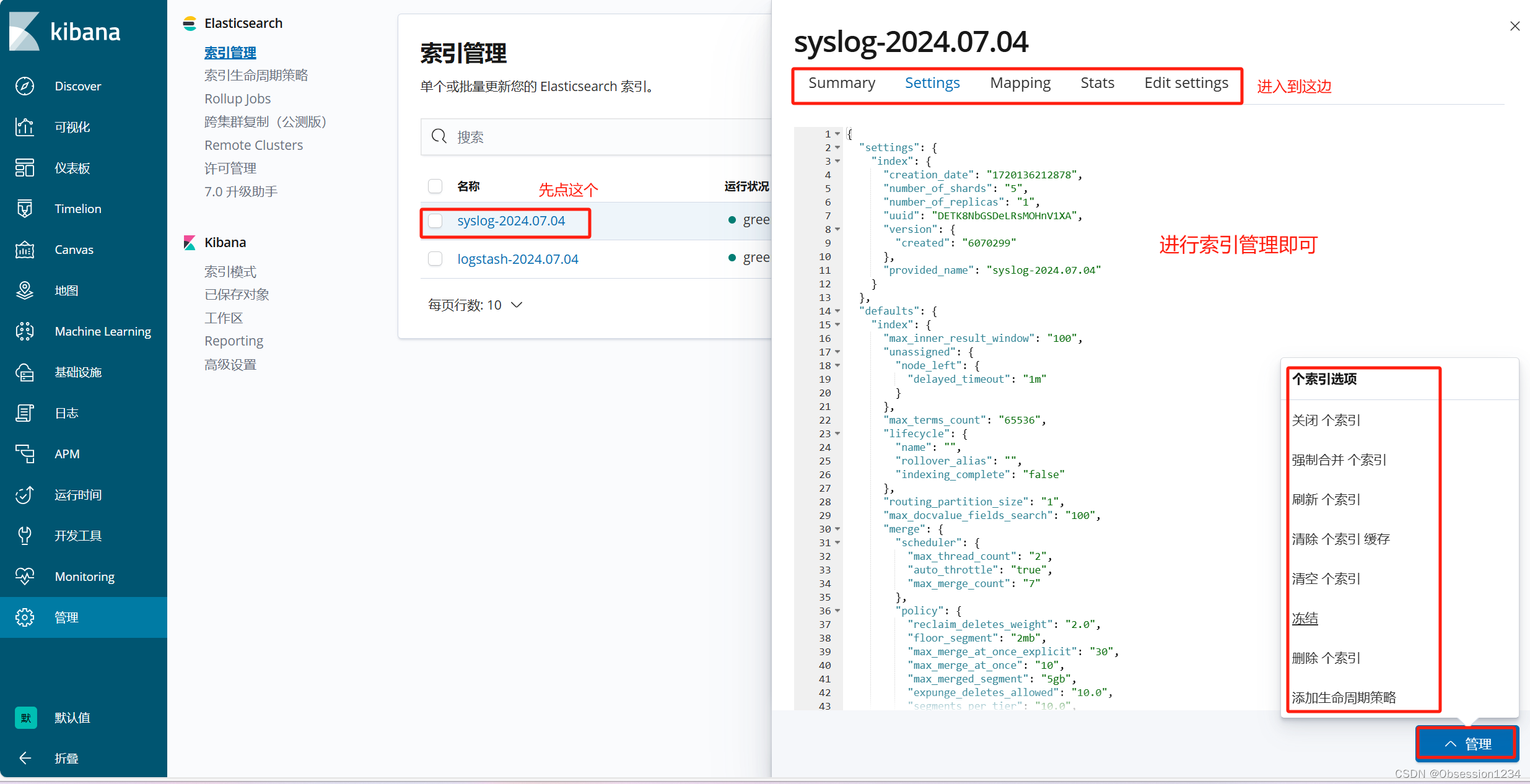

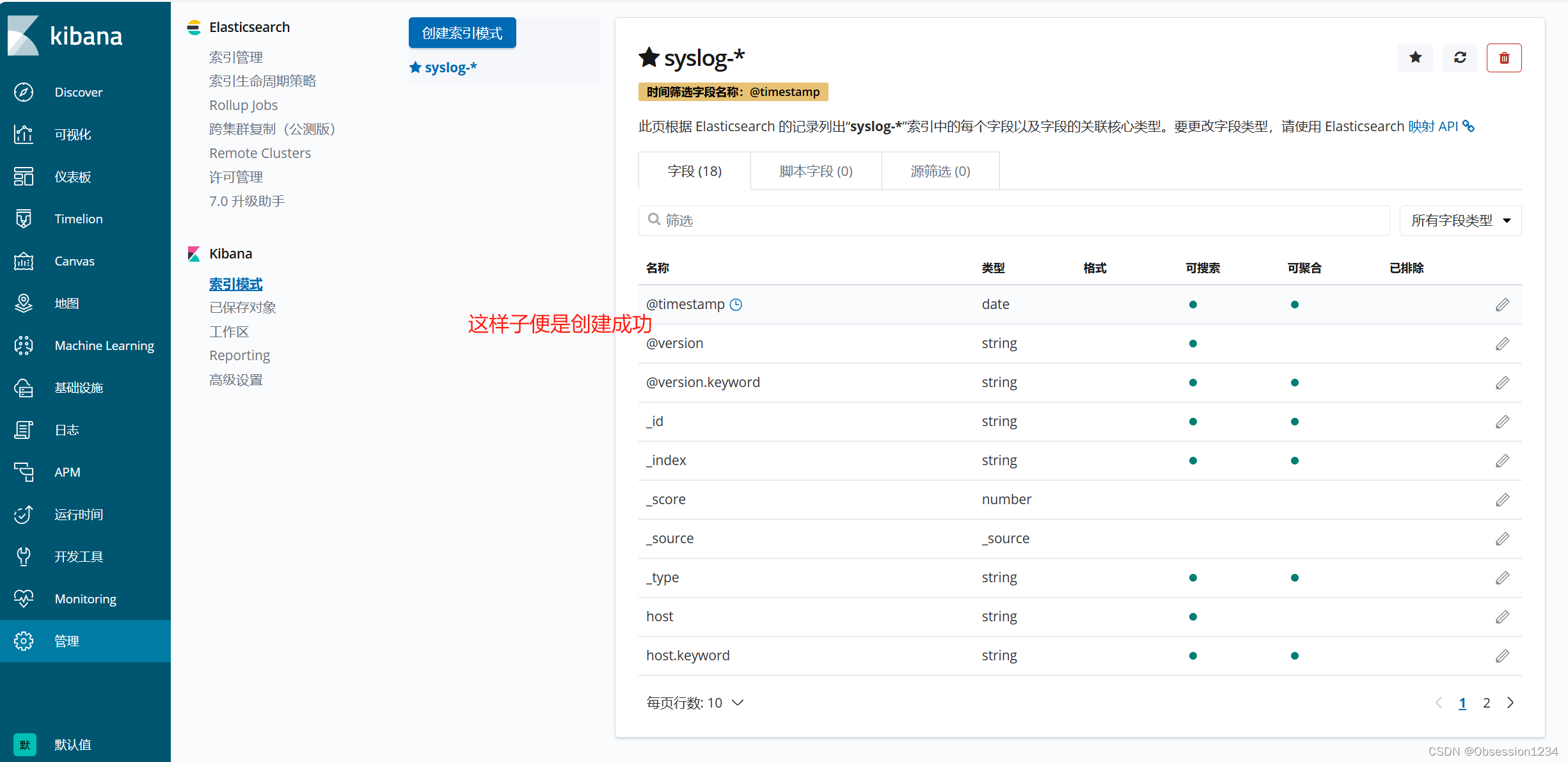

2)使用Kibana接入Elasticsearch,可在Kibana的Web页面【管理】-【索引管理】中图形化管理索引(1)创建索引

curl -XPUT localhost:9200/index-demo

(2)查看索引

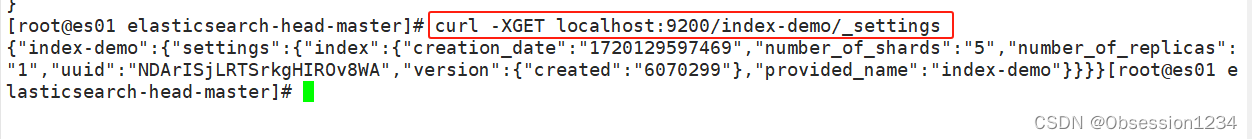

curl -XGET localhost:9200/index-demo/_settings

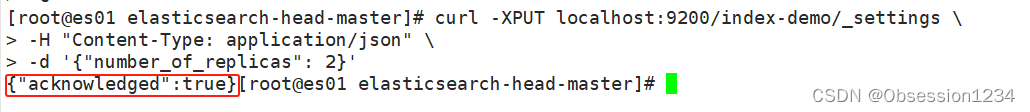

(3)修改索引

curl -XPUT localhost:9200/index-demo/_settings \

-H "Content-Type: application/json" \

-d '{"number_of_replicas": 2}-d '{"number_of_replicas": 2} :2是指定副本数量

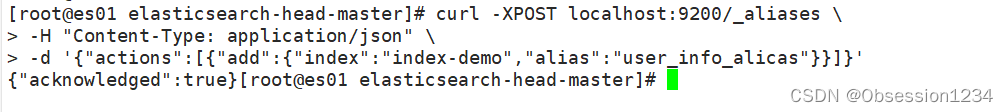

(4)创建索引别名

curl -XPOST localhost:9200/_aliases \

-H "Content-Type: application/json" \

-d '{"actions":[{"add":{"index":"index-demo","alias":"user_info_alicas"}}]}'

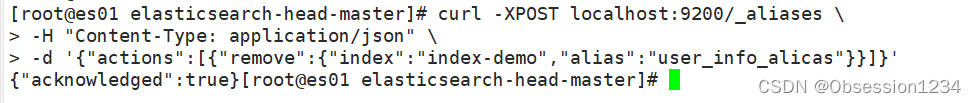

(5)删除索引别名

curl -XPOST localhost:9200/_aliases \

-H "Content-Type: application/json" \

-d '{"actions":[{"remove":{"index":"index-demo","alias":"user_info_alicas"}}]}'

(6)删除索引

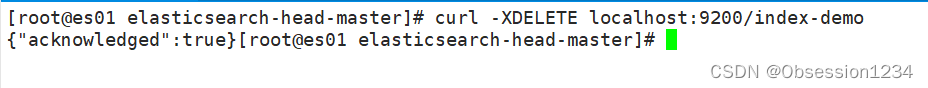

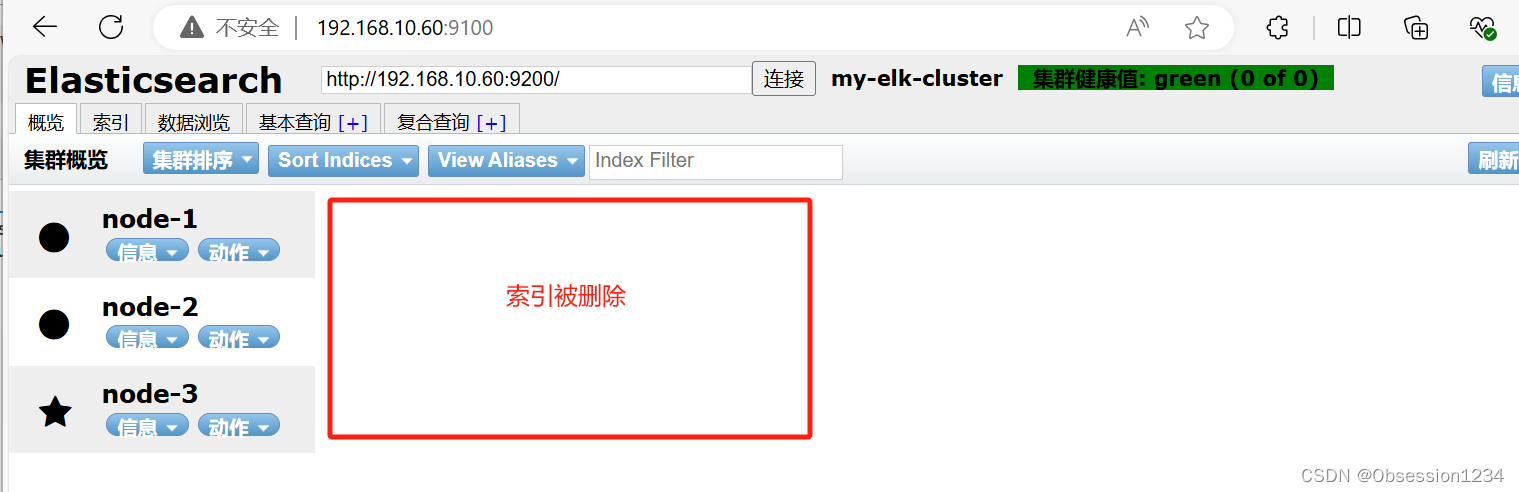

删除单个索引:

curl -XDELETE localhost:9200/index-demo删除多个索引:

curl -XDELETE localhost:9200/index-demo,index-demo2

三.ELK Logstash 部署

新开一台虚拟机192.168.10.50

1.初始化操作并安装JAVA环境

systemctl stop firewalld

systemctl disable --now firewalld

setenforce 0

vim /etc/seliux/config

#设置为disabledjava -version

yum -y install java-1.8.0-openjdk*

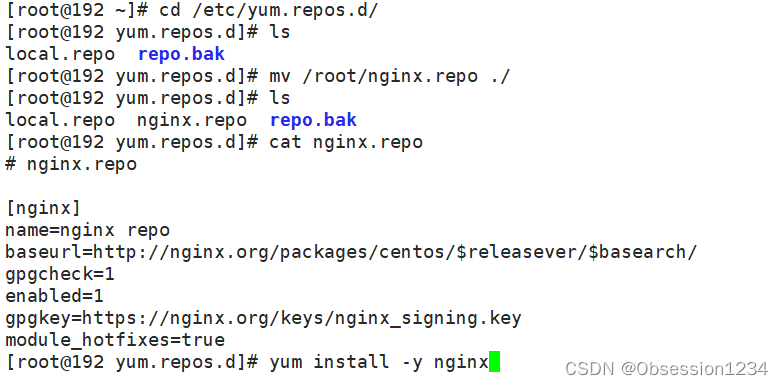

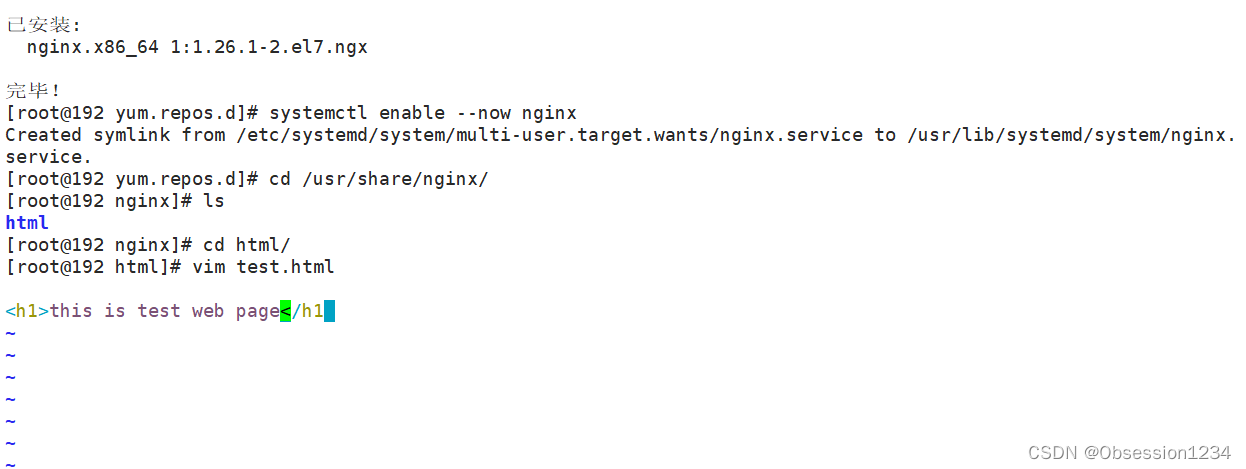

2.安装nginx

上传nginx的数据包至/etc/yum.repos.d/目录中

cd /etc/yum.repos.d/

yum install -y nginx

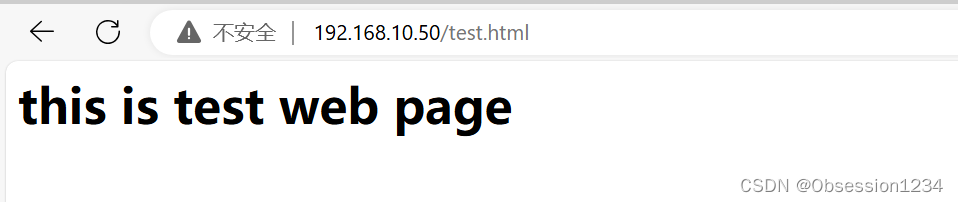

3.设置网页测试

systemctl enable --now nginx

cd /usr/share/nginx/html/

vim test.html

<h1>this is test web page</h1>

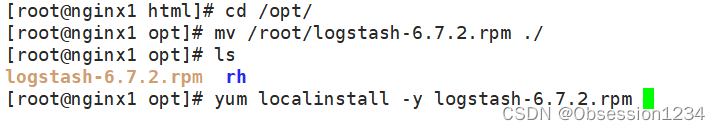

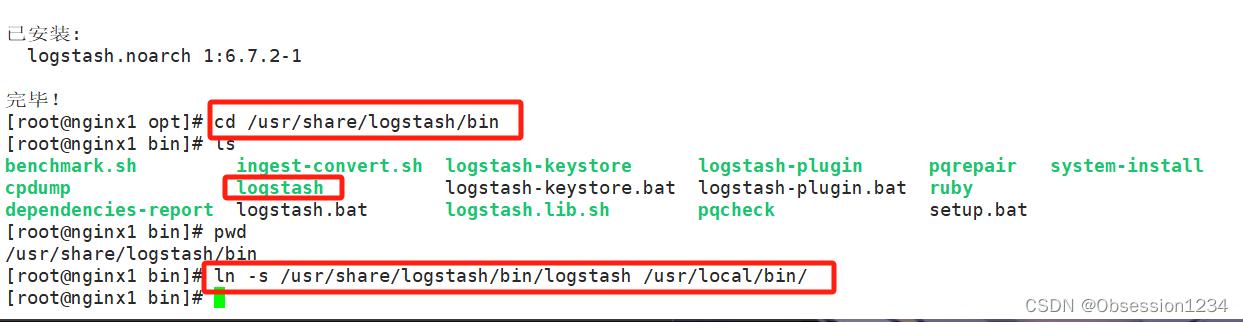

4.安装logstash

#上传软件包 logstash-6.7.2.rpm 到/opt目录下

cd /opt

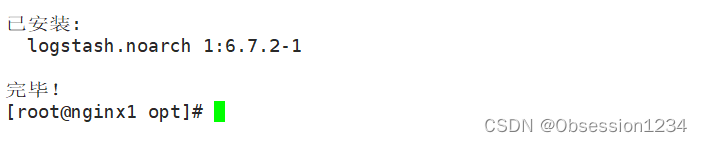

yum localinstall -y logstash-6.7.2.rpm

systemctl start logstash.service

systemctl enable logstash.service

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

5.测试 Logstash

(1)Logstash 命令常用选项

-f:通过这个选项可以指定 Logstash 的配置文件,根据配置文件配置 Logstash 的输入和输出流。

-e:从命令行中获取,输入、输出后面跟着字符串,该字符串可以被当作 Logstash 的配置(如果是空,则默认使用 stdin 作为输入,stdout 作为输出)。

-t:测试配置文件是否正确。

-w:指定filter线程数量,默认线程数是 5

-l:指定日志文件名称

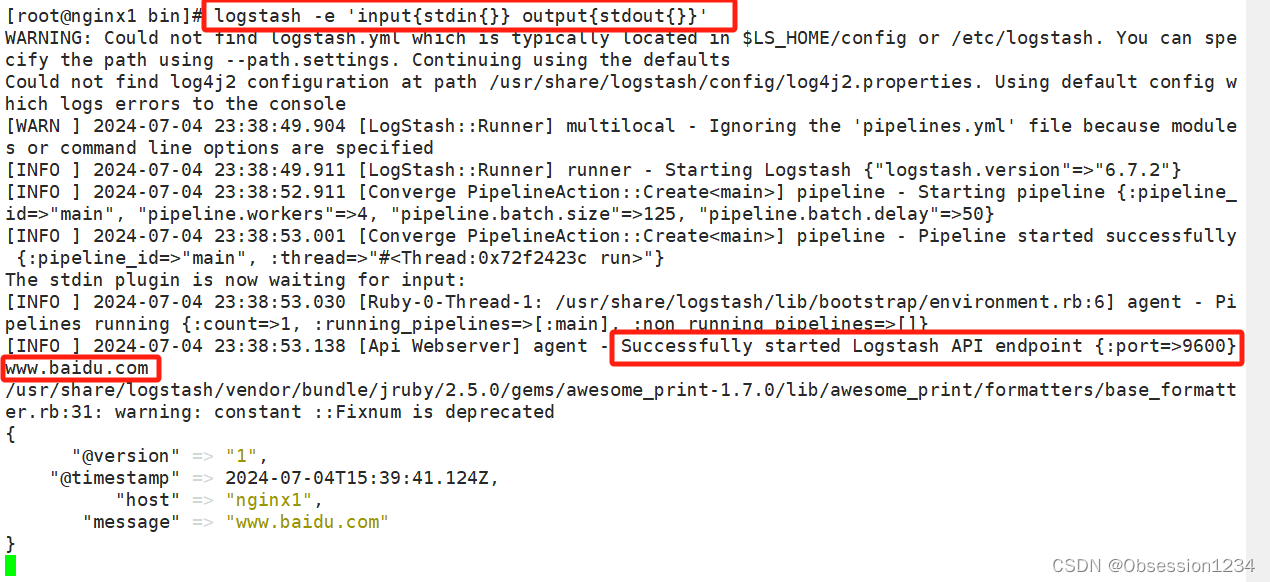

(2)定义输入和输出流

【1】输入采用标准输入,输出采用标准输出(类似管道),新版本默认使用 rubydebug 格式输出

logstash -e 'input { stdin{} } output { stdout{} }'

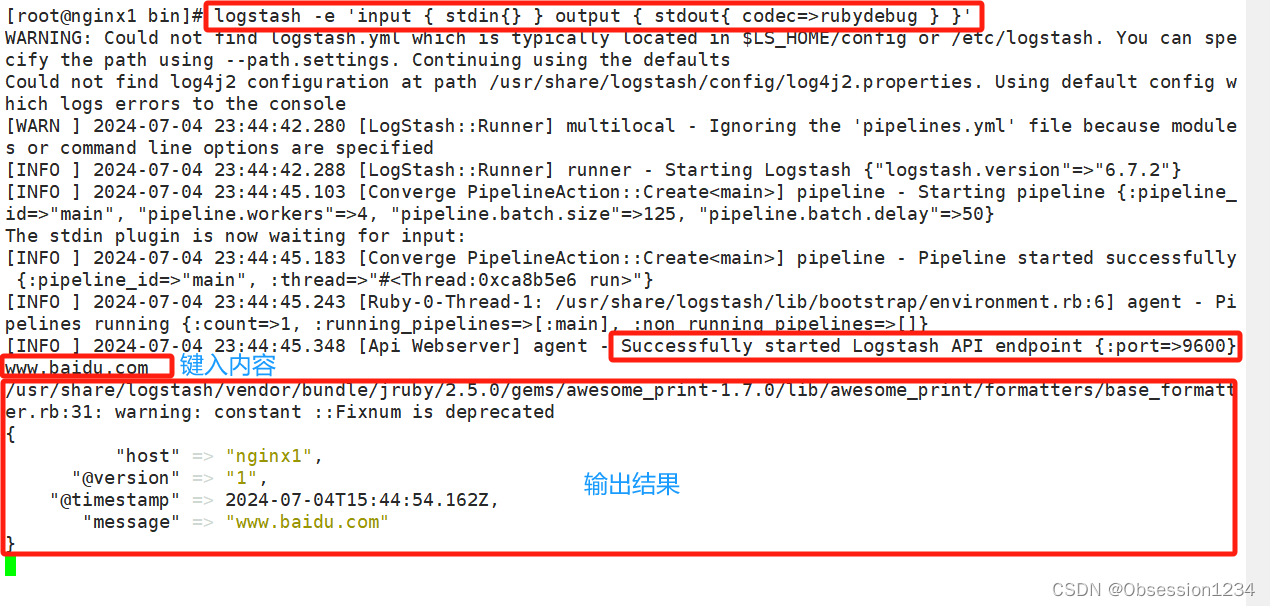

【2】使用 rubydebug 输出详细格式显示,codec 为一种编解码器

logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

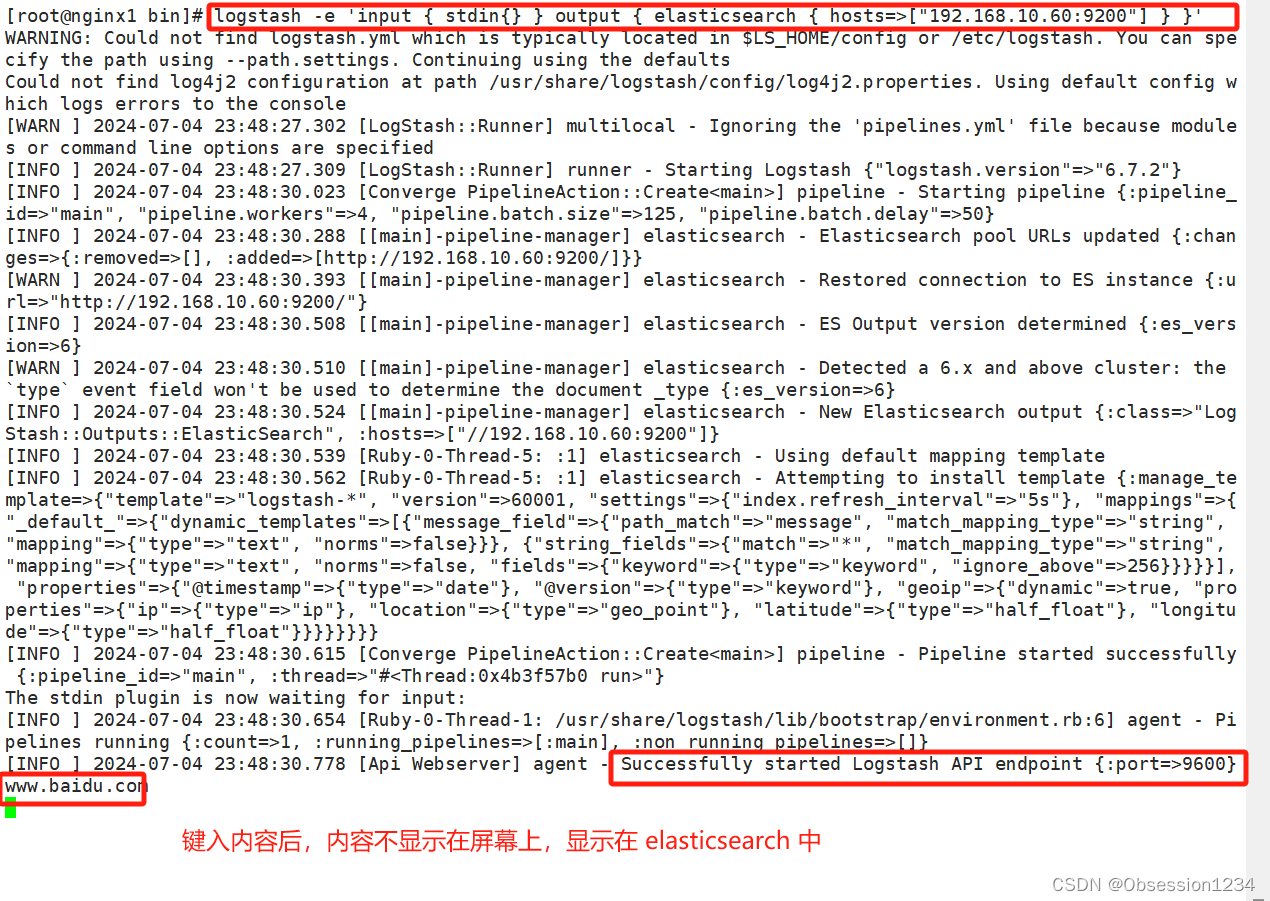

【3】使用 Logstash 将信息写入 Elasticsearch 中

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.10.60:9200"] } }'

输入 输出 对接

6.定义 logstash配置文件

Logstash 配置文件基本由三部分组成:input、output 以及 filter(可选,根据需要选择使用)

(1)input:表示从数据源采集数据,常见的数据源如Kafka、日志文件等

file beats kafka redis stdin

(2)filter:表示数据处理层,包括对数据进行格式化处理、数据类型转换、数据过滤等,支持正则表达式

grok 对若干个大文本字段进行再分割成一些小字段 (?<字段名>正则表达式) 字段名: 正则表达式匹配到的内容

date 对数据中的时间格式进行统一和格式化

mutate 可以重命名,删除,替换和修改事件中的字段。比如对一些无用的字段进行剔除,或增加自定义的字段

multiline 对多行数据进行统一编排,将多行数据汇总为一个单一的行

(3)output:表示将Logstash收集的数据经由过滤器处理之后输出到Elasticsearch。

elasticsearch stdout

格式如下:

input {...}

filter {...}

output {...}

(1)在每个部分中,也可以指定多个访问方式。例如,若要指定两个日志来源文件,格式如下

input {

file { path =>"/var/log/messages" type =>"syslog"}

file { path =>"/var/log/httpd/access.log" type =>"apache"}

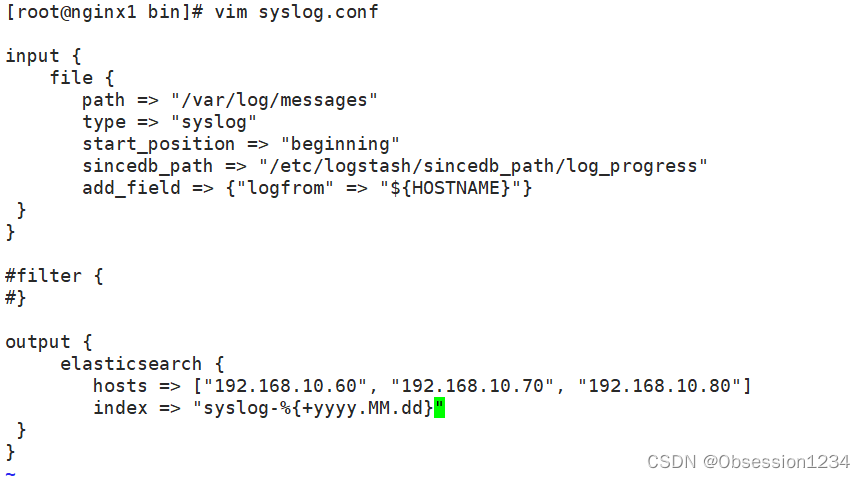

}(2)修改 Logstash 配置文件,让其收集系统日志/var/log/messages,将其输出到 elasticsearch

常用参数:

path:表示要收集的日志的文件位置,必须使用绝对路径,可使用通配符匹配。如果同时指定多个文件使用 , 号间隔

exclude:排除不想监听的文件

type:指定Event的type字段。若是输入ES时,没有指定document_type,那么这里的type将做为ES中index的type

start_position:可以设置为beginning或者end,beginning表示从头开始读取文件,end表示读取最新的,默认是end,这个要和ignore_older一起使用。该选项只在第一次启动logstash时有效

ignore_older:表示了针对多久的文件进行监控,默认一天,单位为秒,可以自己定制,比如默认只读取一天内被修改的文件

sincedb_path:表示文件读取进度的记录,每行表示一个文件,其中记录了inode、主设备号、次设备号以及读取的位置。默认为$HOME/.sincedb*

sincedb_write_interval:设置多长时间会写入读取的位置信息,单位为秒

add_field:用于向Event中添加自定义的字段。这里使用了${HOSTNAME},即本机的环境变量

delimiter:文件内容的行分隔符,默认按照"\n"进行Event封装chmod a+r /var/log/messages

cd /etc/logstash/conf.d/

mkdir -p /etc/logstash/sincedb_path/

touch /etc/logstash/sincedb_path/log_progress

chown logstash:logstash /etc/logstash/sincedb_path/log_progress

vim syslog.confinput {

file {

path => "/var/log/messages"

type => "syslog"

start_position => "beginning"

sincedb_path => "/etc/logstash/sincedb_path/log_progress"

add_field => {"logfrom" => "${HOSTNAME}"}

}

}

#filter {

#}

output {

elasticsearch {

hosts => ["192.168.10.60", "192.168.10.70", "192.168.10.80"]

index => "syslog-%{+yyyy.MM.dd}"

}

}

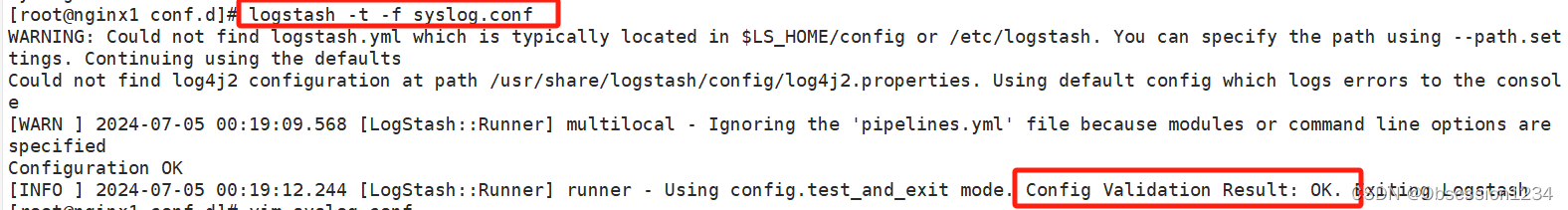

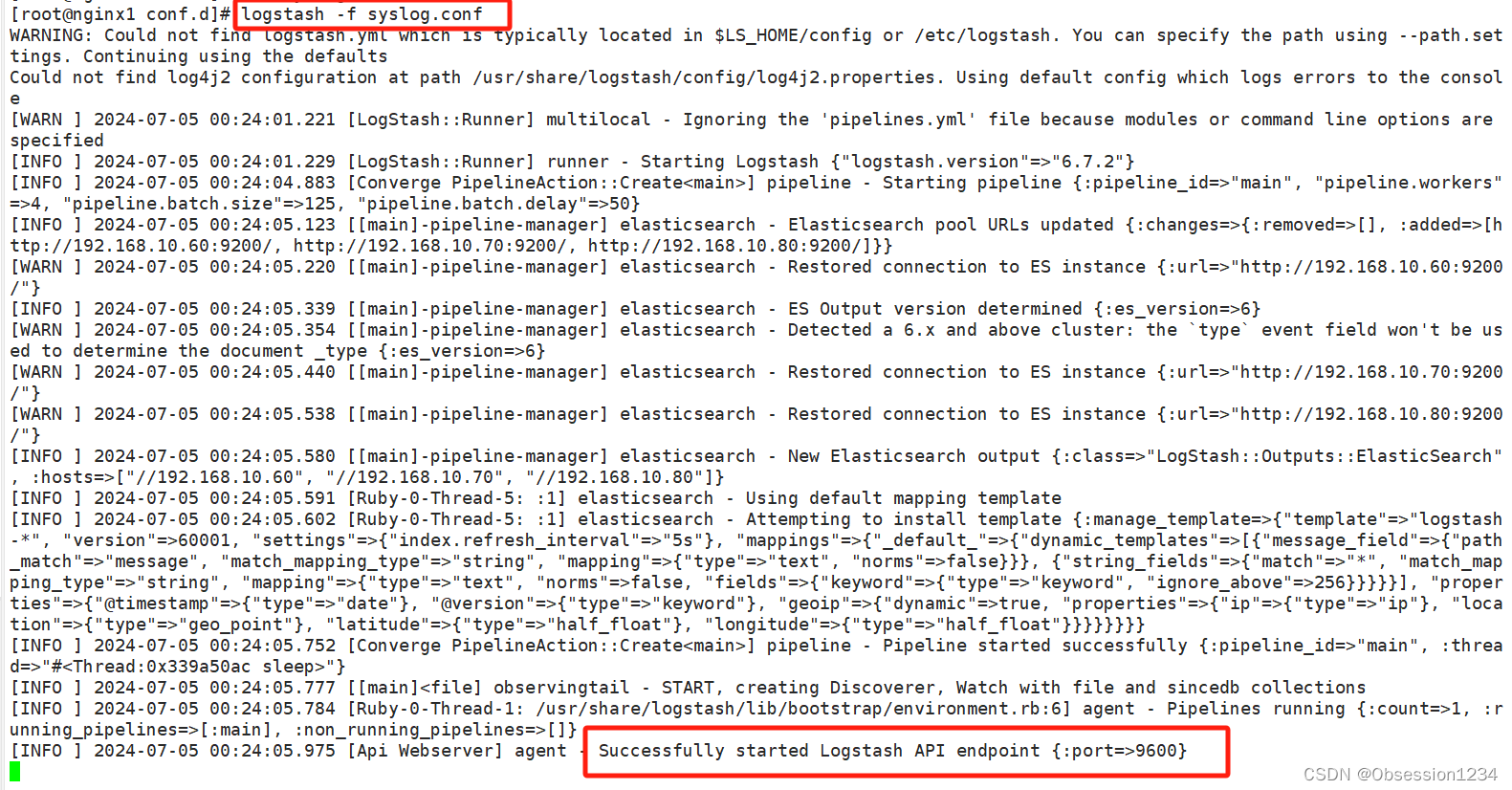

logstash -t -f syslog.conf #测试

logstash -f syslog.conf #启动

四.ELK Kiabana 部署

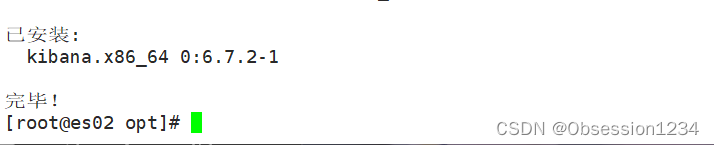

1.安装 Kiabana(随便找台主机)

我这里选 192.168.10.70

上传软件包 kibana-6.7.2-x86_64.rpm 到/opt目录

cd /opt

yum localinstall -y kibana-6.7.2-x86_64.rpm

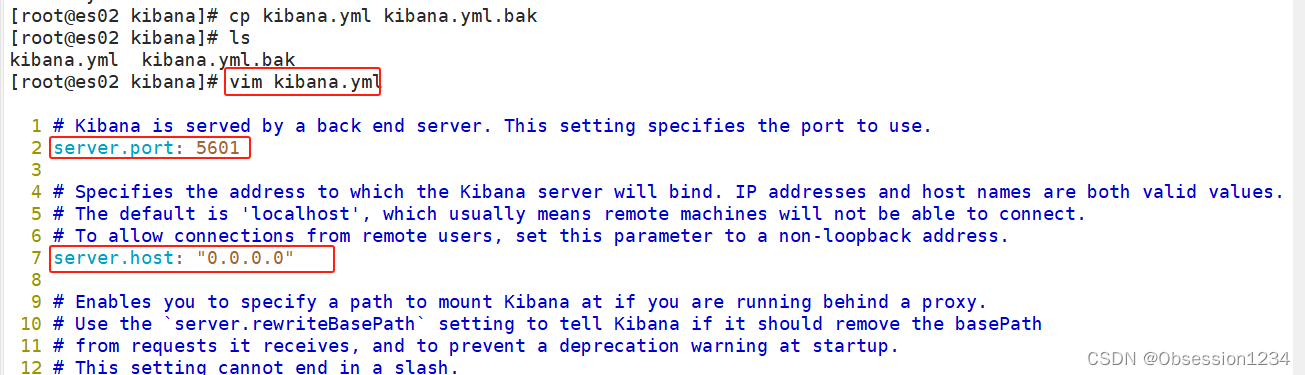

2.设置 Kibana 的主配置文件

vim /etc/kibana/kibana.yml

--2--取消注释,Kiabana 服务的默认监听端口为5601

server.port: 5601

--7--取消注释,设置 Kiabana 的监听地址,0.0.0.0代表所有地址

server.host: "0.0.0.0"

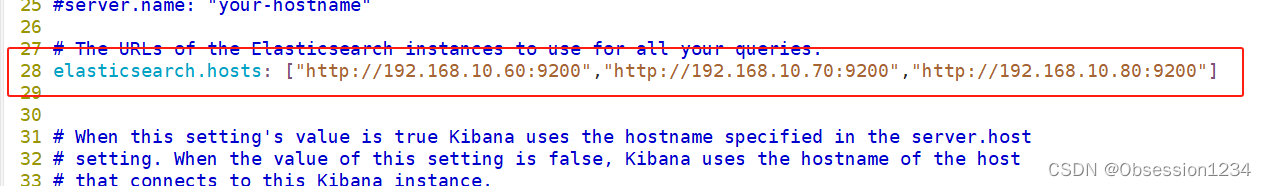

--28--取消注释,配置es服务器的ip,如果是集群则配置该集群中master节点的ip

elasticsearch.hosts: ["http://192.168.10.60:9200","http://192.168.10.70:9200","http://192.168.10.80:9200"]

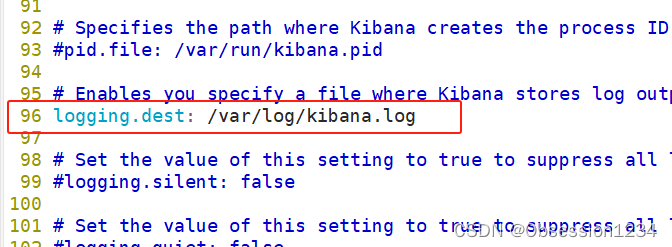

--96--取消注释,配置kibana的日志文件路径(需手动创建),不然默认是messages里记录日志

logging.dest: /var/log/kibana.log

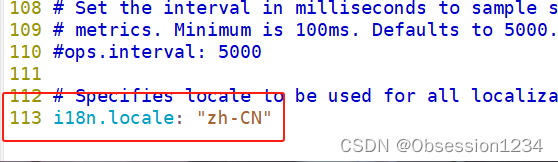

--113--取消注释,指定页面字符格式为中文

i18n.locale: "zh-CN"

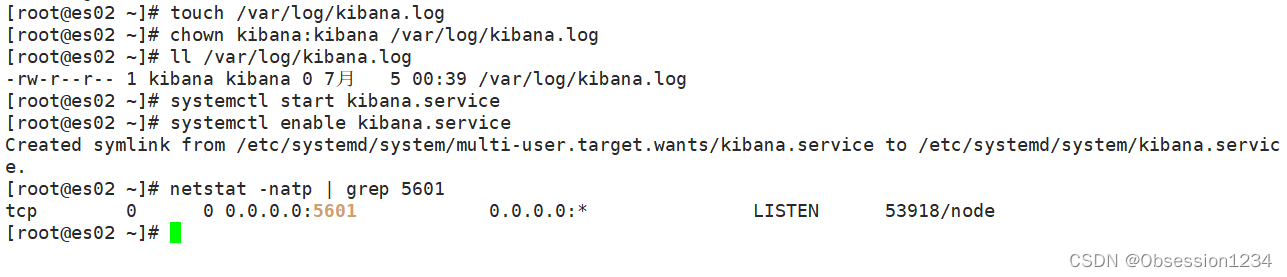

3.创建日志文件,启动 Kibana 服务

touch /var/log/kibana.log

chown kibana:kibana /var/log/kibana.log

systemctl start kibana.service

systemctl enable kibana.service

netstat -natp | grep 5601

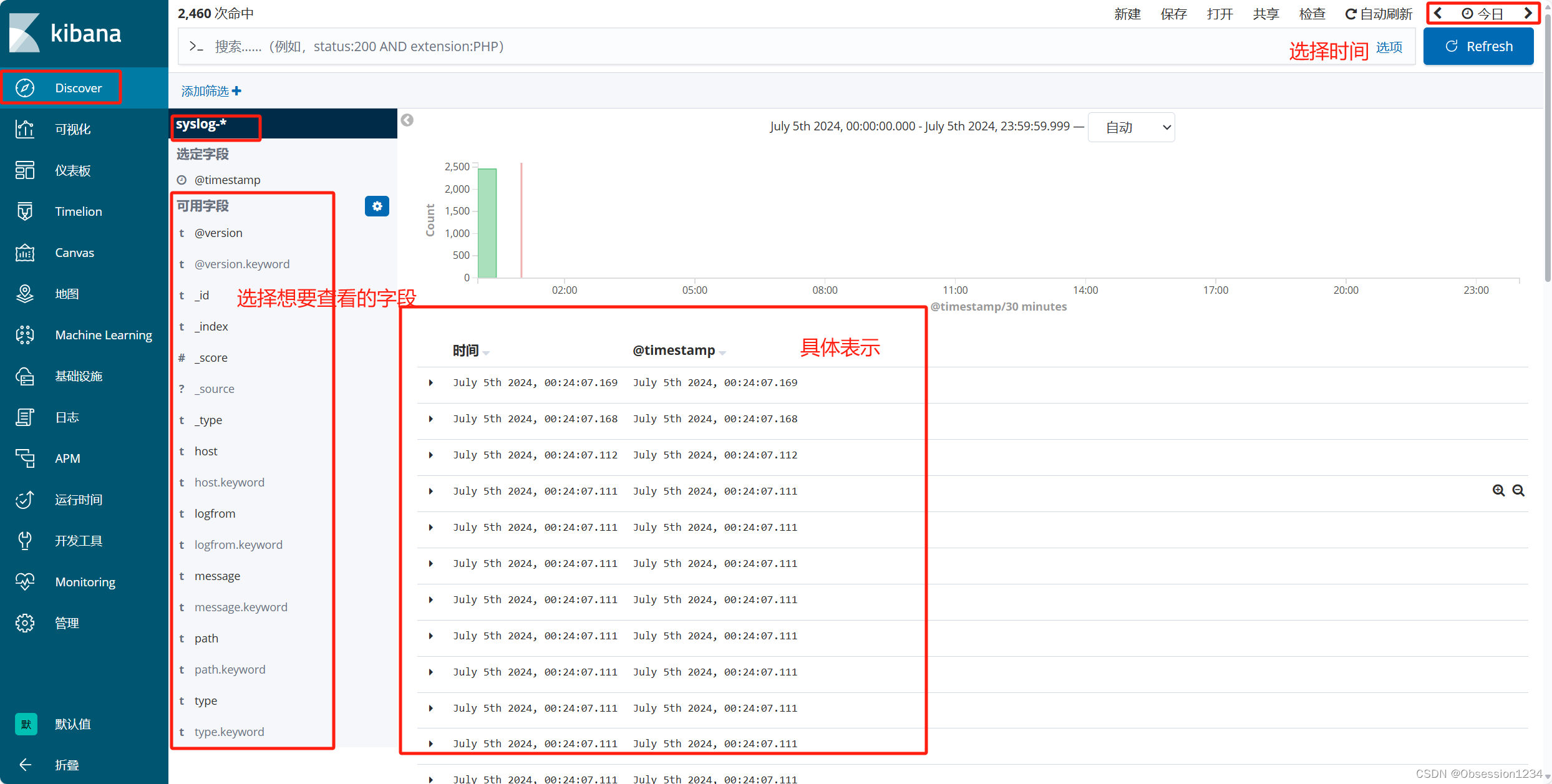

4.验证 Kibana

浏览器访问 http://192.168.10.70:5601

用 kibana 实现 查看日志

347

347

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?