出于某些不可告人的特殊原因,我需要得到某个B站视频的 「 字幕 」,自己手动记录字幕实在过于繁琐,每几秒都会有字幕不断地更新,一个1小时的视频字幕的收集便是一个浩大的工程~

因此我再次召唤我的好帮手 网络爬虫 ,来帮我采集字幕并且以 srt 文件的格式保存。这个 srt 的全称是SubRip Text,这是一种非常流行的文本字幕,包含一行时间,一行字幕,制作规范非常简单。

如上图所示,这个字幕是CC字幕,CC是Closed Caption的简称,所谓CC字幕,就是隐藏式字幕。

CC 是把文字加入NTSC电视信号的一种标准化编码方法。

电视机的内置解码器或独立解码器能显示文字。

Caption 和我们常见的一般字幕(subtitle)的用法是有区别的,它是在无音状态下通过进行一些解释性的语言来描述当前画面中所发生的事情的字幕,例如画面中出现了背景的声音的时候,Caption都会通过字幕进行提示。

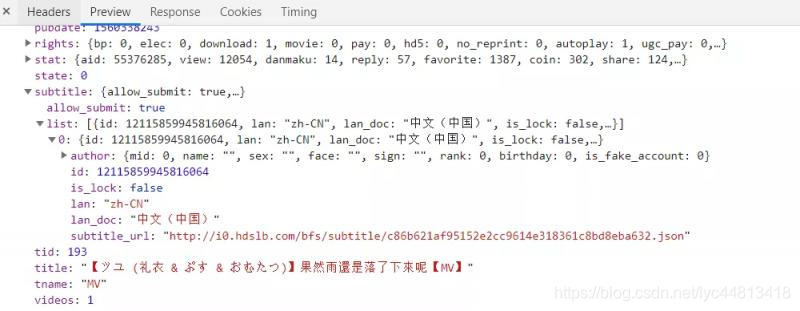

这个CC字幕我们可以再视频中拖放至任意位置,十分便捷,经过观察发现,该字幕显式地放在一个json之中,而这个json又可以通过Network找到。

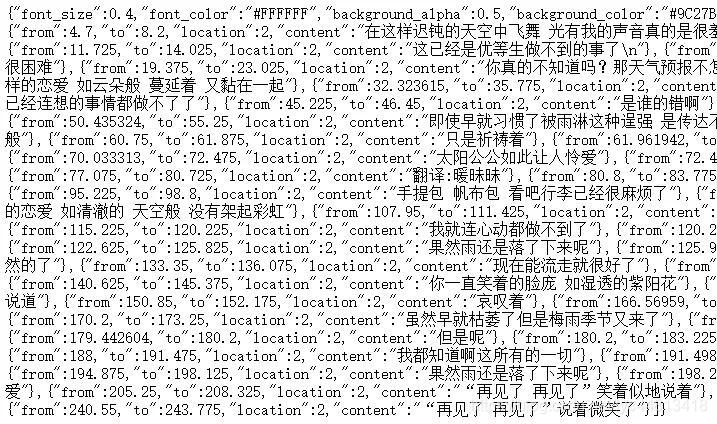

上图中的 subtitle_url 便给出了字幕json的链接,而访问该链接可以得到该视频的所有字幕信息。其中对我生成srt文件最为重要的数据便是 from、to以及content,这些单词对应的数据分别代表某一条字幕的出现时间,消失时间以及字幕的内容。

由此我们找到了所需的详细字幕信息所在的位置,思路也非常清晰,先模拟访问该视频页面获取字幕的json链接,再将json链接中包含的信息按照srt文件的格式下载到本地。

def get_subtitles(self):

"""

根据字幕的json 获取CC字幕

"""

json_url=self.get_json_url()

if len(json_url)>0:

with open('{}.srt'.format(self.title),'w',encoding='utf-8') as f:

r=requests.get(json_url)

info=json.loads(r.text)['body']

for i in range(len(info)):

subtitle_from=info[i]['from']

subtitle_to=info[i]['to']

content=info[i]['content']

data=self.format_subtitle(subtitle_from,subtitle_to,content,i)

f.write(data)上面的函数是获取CC字幕的主要代码,下面这段代码主要是将CC字幕格式化输出,以标准的srt文件的形式输出。

def format_subtitle(self,subtitle_from,subtitle_to,content,i):

"""

格式化成srt文件,形如:

1

00:00:01,035 --> 00:00:04,525

远离了平行线 看吧天气预报也不怎么准

"""

subtitle_from=round(subtitle_from,3) #四舍五入为三位小数

subtitle_to=round(subtitle_to,3)

begin=time.strftime("%H:%M:%S",time.gmtime(subtitle_from)) ',' self.rectify(subtitle_from)

end=time.strftime("%H:%M:%S",time.gmtime(subtitle_to)) ',' self.rectify(subtitle_to)

data=str(i 1) '\n' begin ' --> ' end '\n' content '\n\n' #格式化成srt字幕

return data这样我们就可以得到某个视频的CC字幕,如果想要爬取的视频的字幕不是CC字幕的话,是无法通过上述代码爬取的。因为其 list 列表为空,即不存在相关的json。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?