我们的核心贡献是开发一种可扩展的方法,用大型语言模型(LLM)自主构建高质量的视频文本数据集,提供视频文本表示学习模型ViCLIP。

1、引言

目前的研究依赖于HowTo100M[2]、HD-VILA[3]和YTTemporal[4,5]等数据集,这些数据集的文本是使用自动语音识别(ASR)生成的。尽管规模很大,但这些数据集在视频和相应的文本描述之间的语义相关性往往很低[2-5]。实证研究表明,改善这种相关性(例如,将视频与字幕对齐以提高其匹配性)显著有利于视频检索和视频问答等下游任务[6]。

文本视频对齐非常重要。

WebVid10M具有更高质量的alt文本,以解决视频文本相关性低的问题。但其规模和动态范围的局限性影响了其在当前数据和模型扩展研究中的应用。具体来说,该研究只提供了1000万个视频-文本对,而且所描述的场景中包含的行为或活动相对较少。这意味着这个数据集在多样性和复杂性方面可能不足,可能无法完全满足需要大规模和高复杂性数据的研究需求。

图1:示例(我们给出每个视频剪辑的三帧)、相应生成的字幕和InternVid中的ASR转录本。在标题中,我们用蓝色突出显示名词,用绿色突出显示动词。使用LLM[1]将非英语成绩单翻译成英语我们提出了一个以视频为中心的大规模数据集InternetVid,以解决在保持高视频文本对应性的同时扩大视频语言建模的挑战。 作者强调提出的数据集“InternVid”相较于使用ASR生成的字幕,能够更好地描述视频中的视觉元素。这是因为ASR转录通常关注于音频内容而非视觉内容,可能无法准确反映视频中的视觉信息。而他们生成的字幕则专门设计来描述视频中的视觉场景和动作,以提高视频和文字之间的对应性和相关性。(ASR自动语音识别)

论文的三大贡献:

-

新的大规模视频语言数据集InternVid的引入:

- 目标:推动大规模视频相关的多模态理解与生成。

- 方法:采用多尺度视频字幕方法,借助大型语言模型(LLM)创建,确保高质量的视频-文本数据,并最小化人工干预。

- 规模与内容:包含700万个视频,对应2.34亿个视频剪辑,每个剪辑都有生成的字幕。覆盖16个场景和约6000个动作。

- 特点:数据集整体包括视频-文本相关性和视觉美学等计算特征,提供多样的子集以满足不同的训练需求。

-

新的视频语言模型ViCLIP的学习:

- 训练:在InternVid上使用视频语言变换器ViT-L进行训练。

- 技术:整合了对比学习和掩码建模技术,有效学习可转移的视频语言表示。

- 成果:在Kinetics动作识别数据集上实现了领先的零样本性能,具体在K400、K600和K700上的平均top1和top5准确率分别达到75.7、73.5和66.4。在视频检索任务上也展示了竞争性能,为视频-文本理解设立了新的基线。

-

推动多模态对话系统和文本到视频生成的发展:

- 应用:提出的ViCLIP模型可以作为视频中心对话系统的视觉支撑,执行动作识别、时间理解、推理和创造性任务。

- 特殊子集InternVid-Aesthetics:利用特定的视频-文本关系和视觉美学过滤创建,该子集有助于生成高分辨率、无水印的视频。使用这个子集,简单的文本到视频基线模型的视觉和定量结果显著提高(FVD:705.3 -> 616.5)。

2、相关工作

多模态数据集

-

多模态数据集的来源:

- 研究者通常利用带有替代文本(alt-text)的网络图片和带有ASR(自动语音识别)转录的视频来实现可扩展学习。

- 例如,LAION-5B的引入为研究者提供了数百万甚至数十亿的图像-文本对,为大规模图像语言预训练开辟了新途径。

-

视频中心的多模态数据集:

- HowTo100M:收集了指导性的YouTube视频,并利用相应的ASR字幕来学习联合表示。

- YT-Temporal 和 HD-VILA:由Zellers等人和Xue等人分别提出,针对音视觉语言联合学习和高分辨率视频跨模态学习。

- WebVid:Bain等人发现视频-文本对齐的质量比数量更重要,因此制作了包含1000万视频和对应替代文本的WebVid,这在最近的视频语言预训练方法中经常使用。

- VideoCC3M:基于CC3M,Nagrani等人通过将图像-文本数据集的字幕转移到视频数据集上,提出了VideoCC3M。

视频理解

-

预训练和微调的常规做法:

- 早期技术使用预训练的视觉和语言编码器离线获取视频和文本特征。

- 近期方法更倾向于端到端的训练,即直接在整个模型上同时训练,以强化模型的联合表示能力。

-

预训练任务的多样性:

- 常见的预训练任务包括:掩码语言建模、视频-文本匹配、视频-文本对比学习、掩码视频建模和视频-文本掩码建模。

- 这些任务有助于模型学习如何更好地处理和理解多模态数据。

-

特定模型的介绍和应用:

- VIOLET:结合了掩码语言和视频建模。

- All-in-one:提出了一个统一的预训练方法,使用共享的基础架构。

- LAVENDER:通过掩码语言建模统一任务。

- InternVideo和UMT:结合了掩码建模和跨模态对比学习,展示了在视频单独任务和视频-语言任务中的竞争性能。

- MERLOT Reserve:利用2000万个视频-文本-音频对进行训练,使用对比匹配来训练联合视频表示,设定了视频识别和视觉常识推理的新标准。

- VALOR:采用不同的模态编码器处理视频、音频和文本,并引入视频到文本和音频到文本的预训练任务,以提高视觉-音频-语言学习。

- mPLUG-2:引入了一个跨图像、视频和文本的共享模块,以促进模态合作,同时保留模态特定模块以处理它们的差异。

- VLAB:将预训练的CLIP ViT适配以模拟时空变化,并将其与处理图像和视频的CLIP ViT通过交叉注意力机制结合起来。

-

模态间融合和分离的问题:

- 在跨模态学习中,模态纠缠是一个挑战,因为不同模态的信息需要被有效地整合,同时又保留足够的模态特异性以确保各自的功能不受影响。

3、InternVid:一种以视频为中心的多模式数据

高质量、大规模视频-文本数据集是进行大规模视频语言学习及相关任务的基础。以下是构建此类数据集时需要关注的三个关键因素:

-

丰富的时间动态:

- 为了确保视频具有高时间动态性,收集视频的方法是使用基于动作/活动的查询词进行检索。这意味着所选视频会涵盖具体的动作或活动,保证视频内容在时间上的变化和动态性。

-

丰富和多样的语义:

- 为了实现语义的丰富性和多样性,不仅抓取不同类别中的流行视频,还有意识地增加从不同国家和语言收集的数据比例。这样可以确保数据集包含多样的文化和语言背景,从而增强模型的泛化能力和对不同语义的理解。

-

强大的视频-文本相关性:

- 为了加强视频和文本之间的相关性,使用图像字幕和语言模型来从特定帧的注释生成视频描述。这种方法可以提高描述的准确性和相关性,因为它直接基于视频内容的具体帧来生成文本。

3.1 数据整理

我们从YouTube上收集视频,考虑到其数据的多样性和丰富性,以及对学术使用的支持。我们总共获得了700万个YouTube公共视频,平均时长6.4分钟,涵盖16个主题。我们通过创建YouTube视频ID数据库并排除公开数据集中已有的任何视频(在2023年4月之前发布)来确保数据集的唯一性。数据管理策略有两个方面。一方面,我们从新闻、游戏等类别中选择热门频道和相应的热门或高收视率视频,产生200万个视频。另一方面,我们创建一个与动作/活动相关的动词列表。有了它,我们还可以通过选择检索次数最多的视频来获得510万个视频。

如何定义动作查询用于视频数据集的构建:

-

动作短语的定义来源:

- 动作短语约有6.1千个,来源于美国时间使用调查(ATUS)、公共视频数据集和文本语料库。

-

动作短语的精炼过程:

- 这些动作短语经过人工和自动方式进行精炼。从ATUS中选取的动作涵盖了2017至2022年间的数据,合并后去除重复项。

-

参考的公共视频数据:

- 利用了包括Kinetics、SomethingSomething系列和UCF101等在内的公共视频数据集。这些数据集提供了1103个动作标签。

-

视觉锚定语料库的使用:

- 访问了几个视觉锚定语料库。利用语言模型从语料库中提取动作及其相应的目标(如果存在),形成短语,并通过人工检查得到5001个动作。

-

动作查询的应用:

- 总共收集了6104个动作查询用于在YouTube上搜索视频。

通过这种方法,研究团队能够从多个来源收集和细化动作定义,创建一个具有高度相关和覆盖广泛动作的视频查询集,这对于任何依赖于精确动作识别和分类的视频分析任务来说都是非常宝贵的资源。这些动作查询的建立不仅帮助在YouTube等平台上高效地搜索和获取相关视频,还为视频语言模型的训练和测试提供了基础。

视频收集策略

-

视频收集的规范:

- 视频长度在10秒至30分钟之间。

- 视频分辨率范围为360P至720P。低于360P的视频被排除,高于720P的视频则下载其720P版本或调整至720P分辨率。在此过程中,优先选择最高可用分辨率。

-

多模态数据集的构建:

- 收集视频的同时,也收集其音频、字幕、标题和摘要等。这样做是为了提供一个全面的多模态数据集,可以更好地支持跨模态学习和分析。

-

视频字幕的生成:

- 视频的字幕是通过第3.2节描述的视频字幕生成管道自动生成的。

-

多模态数据的组成:

- 收集的多模态数据包括视频(V)、音频(A)、元数据(标题W_title,视频描述W_content,查询词W_query,标签W_tag等)、字幕(用户生成或自动生成的)等。

- 每个视频(V)可以被视为一个剪辑序列 {Ci}i=1,2,...,相应的音频可以被切分为 {Ai}i=1,2,...,ASR字幕可以被切分为 {Wi_asr}i=1,2,...。

-

元数据的处理:

- 假设当剪辑从同一视频中抽样时,它们共享相同的元数据。这意味着所有从同一视频导出的剪辑将保留相同的标题、描述等元数据信息。

如何通过场景变化将视频切割成较短的视频剪辑

-

场景变化分割:

- 视频首先基于场景变化被切割成更短的视频。这是通过使用PySceneDetect工具实现的,该工具可以自动检测视频中的场景变化。

- 在PySceneDetect中,使用特定的过滤器并设定阈值为27来识别场景变化。

-

视频剪辑的持续时间:

- 原始视频平均持续时间为5分钟,而剪辑的目标长度大约为10秒。

-

过滤极端动态场景:

- 在切割过程中,还会过滤掉动态极小(例如照片画廊浏览)或动态极大的剪辑。这是为了确保所得到的视频剪辑在动态范围内适中,有助于后续的分析和学习。

-

剪辑的数量和时长:

- 经过过滤后,总共获得了约2.34亿个视频剪辑,这些剪辑的持续时间从2秒到超过30秒不等。

3.2 多尺度视频字幕

-

更细致的尺度策略:

- 在更细的尺度上,视频字幕生成过程被简化,主要集中于视频剪辑中常见的对象、动作和场景描述。

- 故意忽略了如微妙的面部表情和动作等复杂细节,以及其他细微元素,这有助于避免过度复杂化字幕内容。

- 使用轻量级图像字幕模型Tag2Text【61】来逐帧描述视频,适用于低帧率的视频描述。这些单独的图像字幕随后通过预训练的语言模型【62, 63】合成为一个综合的视频描述。

-

更粗略的尺度策略:

- 在更粗略的尺度上,采用了来自【60】的单帧偏见假设,专门对视频的中心帧进行字幕描述。

- 由于通过场景分割过滤后的视频剪辑大多显示持续性的对象,没有显著的外观变化,这有助于避免在从图像视角处理视频时遇到的身份保持问题。

- 使用BLIP2【64】模型为视频剪辑的中心帧生成字幕,这种方法专注于提供关键帧的精确描述。

3.3、统计和特点

表1:InternetVid的统计数据及其与现有视频语言数据集的比较*在InternetVid中,大多数视频(约85%)的分辨率为720P,其余视频的分辨率为360P至512P

多样性

-

视频来源的多样性:

- 视频来自16个热门类别,分布比例各异,如图3所示。

- 与先前的研究不同,为确保多样性,选择了来自不同语言国家的视频,而不是依赖于主导语言环境。样本国家包括英国、美国、澳大利亚、日本、韩国、中国、俄罗斯和法国等。

-

视频的持续时间和分辨率:

- 每个视频的平均持续时间为351.9秒。

- 约49%的视频时长五分钟或更短,26%的视频时长在五到十分钟之间,只有8%的视频超过20分钟。

- 在所筛选的视频中,85%为高分辨率(720P),其余15%的分辨率在360P到720P之间。

-

剪辑持续时间和字幕长度的多样性:

- InternVid展示了不同的剪辑持续时间和字幕长度。大多数剪辑长度为0-10秒,占所有剪辑的85%(如图4左所示)。

- 约一半的剪辑字幕包含10-20个单词,而三分之一的剪辑字幕少于10个单词。大约11%的剪辑具有超过20个单词的长字幕。

-

美学评分和剪辑-字幕相似度:

- 使用开源模型【19】测量所有剪辑的美学评分。均匀抽样每个剪辑的四帧,计算它们的美学评分,并取最高分作为视频的美学评分。

- 为了计算剪辑-字幕相似度,使用名为UMT【21】的视频语言模型。通过均匀抽样每个剪辑的四帧,计算视频嵌入和文本嵌入之间的余弦相似度。

- 大部分剪辑的美学评分在4-6之间,约占数据的75%。在UMT-SIM评分方面,超过80%的剪辑得分在0.3-0.4之间,其余剪辑得分在0.2-0.3或0.4-0.5之间。

“动作性”(actionness)

-

动作性的定义和重要性:

- 动作性通常指的是数据集中动词的数量和多样性,这是评估视频数据集在描述动作或活动方面能力的一个指标。

-

分析工具和方法:

- 使用自然语言处理工具包NLTK来分析字幕中的动词数量。

- 分析的焦点是提取和标记所有独特的动词。

-

动词数量的比较:

- 在WebVid10M的字幕数据集中发现了总计109,485个动词。

- 而InternVid数据集中包含了212,155个独特的动词实例。

-

数据解读和限制:

- 尽管这些计数可能由于计数方法的简单性而不完全准确,但它们提供了两个数据集动作性的大致指示。

- 这表明InternVid数据集在动作描述的数量和多样性上大约是WebVid10M数据集的两倍,从而可能提供更丰富和多样的视频内容用于视频分析和语言模型训练。

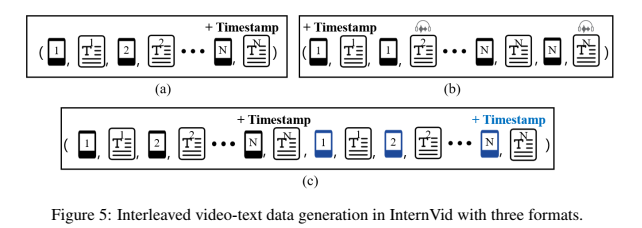

3.4 交错视频文本数据生成

利用创建的视频字幕,我们可以开发一个用于上下文视频学习的集成视频文本数据集,

-

视频-文本集成数据集的目的:

- 开发这种数据集的目的是为了支持视频基础的序列模型在上下文中直接学习和执行新任务,而无需经过针对每个新任务的额外训练。

-

先前研究的相关成果:

- 先前的研究如Flamingo【7, 8】、Kosmos-1【65】和Multimodal C4【66】已经证实,在交错的图像-文本序列上进行预训练可以显著提升多模态上下文能力。

-

当前项目的独特性和重要性:

- 根据目前的了解,尚未建立大规模的交错视频-文本数据集。

- 本工作代表了创建并公开这种数据集的初步尝试。

-

潜在的影响和应用:

- 通过使视频-文本数据集公开,可以为研究社区提供宝贵的资源,有助于推动视频语言模型的发展,特别是在模型需要理解和生成与视频内容密切相关的文本信息时。

- 这种数据集的存在将使模型能够更好地理解视频内容和相关文本,从而在各种视频相关任务(如视频摘要、内容生成和上下文理解)中提供支持。

我们创建了InternVid ICL,其中包含7.1M个交错的视频-文本数据对。我们提出了三种不同的方法来组织剪辑及其字幕:

-

基于时间顺序排列剪辑及其描述:

- 这种方法将一个视频分割成多个小片段(剪辑),然后按照这些剪辑在视频中出现的时间顺序来排列它们,每个剪辑都配有相应的描述。这样做的目的是保持视频的叙事流程,使得学习模型可以理解视频内容随时间的变化和发展。

-

通过添加ASR文本增强交错项的多样性:

- 在每个视频剪辑的字幕之外,还额外添加了由自动语音识别(ASR)技术生成的文本。ASR文本通常是从视频的音轨自动生成的,可能与手工制作的字幕在表达上有所不同。这种做法可以提供更丰富的文本信息,帮助模型从不同角度理解同一视频内容。

-

通过连接两个交错的多模态项扩展方法1:

- 这种方法不仅仅是单独处理一个视频的剪辑,而是将两个相关视频的剪辑及其描述连接起来,模拟用户在处理涉及多个视频的查询时的情境。例如,用户可能想了解两个相关事件的发展,模型通过这种方式训练,可以更好地处理和理解这种复杂的信息流。

4、ViCLIP:大规模学习视频文本表示

在CLIP[67]的基础上,我们制作了一个简单的视频文本预训练基线ViCLIP。它由视频编码器(ViT)[68]和文本编码器组成,如图6所示。

构建该模型的关键组件和步骤:

-

模型架构:

- 视频编码器:使用的是视频变换器(Video Transformer,简称ViT)【68】,这是一种专门为视频内容设计的编码器,能够处理视频中的空间和时间信息。

- 文本编码器:与视频编码器配对使用,专门用于处理文本数据。

- 这两个模块都是从对应的CLIP组件初始化的,即借鉴了CLIP模型中对图像和文本处理的方法。

-

注意力机制的更新:

- 在视频编码器中,原生的空间注意力被更新为时空注意力。这种注意力机制能够同时处理视频帧中的空间信息和不同帧之间的时间信息,更适合视频数据的特性。

-

训练优化和损失函数:

- 为了提高学习效率,预训练过程中对视频进行遮蔽处理。这意味着在训练视频编码器时,部分视频数据会被随机遮蔽,迫使模型学习从不完整的输入中恢复或预测缺失的信息。

- 优化目标是输入视频和文本嵌入之间的对比损失。这种损失函数鼓励模型将相关的视频和文本嵌入彼此靠近,而将不相关的视频和文本嵌入彼此远离,从而增强模型的视频-文本对应能力。

带掩蔽学习的视频和文本编码器。我们的视频编码器使用具有时空注意力的标准ViT。我们按照基于MAE的方法[37,38]将随机补丁掩蔽应用于输入视频。它显著减轻了计算负担。所使用的文本编码器也是后面跟着[67,19]的转换器。

无掩码视频文本预训练。在预训练过程即将结束时,我们将所有视觉标记输入到视频转换器中,而不仅仅是蒙面标记。这有助于弥合预训练和使用完整视频作为输入的下游应用程序之间的差距。我们进行了0.5个时期的无掩蔽训练,学习率为4e-6。

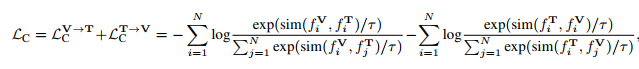

训练目标。我们的框架优化了视频文本对齐。它使用全局视频和文本功能最大限度地减少了InfoNCE的损失[69]

实施:ViCLIP是使用64个NVIDIA A100 GPU学习的,为期3天,具有50M视频文本对。我们引用了用于训练和推理加速的DeepSpeed和FlashAttention[70]。

4.1、可迁移视频表征的性能

动作识别:

-

模型和数据集的比较:

- 文中提到了多个模型,包括OpenAI的CLIP-L (CLIP400M [67]),LAION (DataComp-1B [71]),以及EVA-CLIP-L/14 和 EVA-CLIP-E/14 [72]。这些模型在动作识别任务中的表现被用于相互比较。

- 更多的实验设置在附录E.1中有详细说明。

-

零样本学习性能:

- 表格3显示,在InternVid-10M-FLT数据集上训练的ViCLIP在动作识别任务上表现优于其他所有模型,包括EVA-CLIP-E。

- 使用InternVid-10M-FLT的ViCLIP在Kinetics 400/600/700数据集上创下了零样本动作识别的新纪录,显示出相比使用WebVid10M或其他模型的显著性能提升。

- 作者还提出了一个假设,即如果不有意减少从同一视频中取样的剪辑数量,错误的负样本可能会严重阻碍视频-文本对比学习。

-

微调学习性能:

- 表格4中,当将在InternVid数据集上预训练的ViCLIP与在图像CLIP模型或WebVid数据集上训练的ViCLIP进行比较时,有明显的准确率提高。

- 当ViCLIP使用更大数量的视频-文本数据对(200M)进行预训练时,其在微调的动作识别任务上的表现(K400上87.9%和SthSthV2上73.6%)高于使用较少数据(10M)预训练的结果(K400上86.8%和SthSthV2上71.2%)。

- 这表明InternVid数据集为微调的动作相关任务提供了更大的好处。

-

WebVid与评估视频之间的分布差异:

- ViCLIP在WebVid数据集上的性能下降突出了解决WebVid与用于评估的动作视频之间的分布差异的重要性,强调了收集具有明显时间动态的视频的必要性。

视频文本检索。

-

实验设置:

- 从输入视频中均匀采样八帧。

- 对于OpenAI的CLIP模型和LAION,使用官方发布的ViT-L模型,并通过对计算的逐帧图像嵌入进行平均来提取视频嵌入。

- ViCLIP则直接预测视频嵌入。

-

检索性能评估:

- 在表5和表6中报告了文本到视频(t2v)和视频到文本(v2t)任务的R@1得分。

-

零样本性能(Zero-Shot):

- 表5显示,使用相同方法ViCLIP的InternVid-10M在几乎所有基准上的表现超过了WebVid,R@1平均提高了6.3%。

- 通过多样化训练剪辑,InternVid-10M-DIV和-FLT在R@1上的提高分别达到14.0%和17.1%,超过了WebVid。

- 这些结果再次强调了生成的视频字幕与相应视频之间的对应关系的有效性。CLIP4Clip使用HowTo100M与ViCLIP使用WebVid10M或InternVid-10M的比较显示,视频与文本之间的相关性对性能的影响比它们的数量更为显著。

-

微调性能(Fine-Tuned):

- 表6显示,从InternVid-10M过渡到WebVid10M时,使用ViCLIP进行t2v和v2t检索的性能在几乎所有数据集上都有明显改善。

- 平均而言,t2v R@1在所有基准上提高了3.7%,尤其是在ActivityNet上的提升超过了11.9%。

- 然而,使用WebVid10M的ViCLIP在v2t R@1得分上优于使用InternVid-10M(81.2对比80.0)。

-

数据多样性的问题:

- 尽管有所改善,但数据多样性相关的问题仍然存在。

这些评估结果表明,高质量的视频-文本数据集对于提高视频检索任务的性能至关重要。InternVid-10M数据集的使用在多种设置中显示出了优势,特别是在提供更多的微调和零样本检索任务的性能提升方面。这些发现支持了使用InternVid可以提高视频文本表示的转移性的主张。

数据扩展和问题

-

数据规模与性能提升:

- 无论是零样本还是微调设置,增加数据规模都显著提高了ViCLIP的性能。

- 如图7所示,ViCLIP的区分能力随着训练视频数量的增加(从10M增加到200M)呈线性增长。

- 然而,图8显示,当训练数据规模超过50M后,检索性能的增长变得边际化。

-

模型训练与损失函数:

- 需要注意的是,模型仅使用对比损失进行训练,没有采用如匹配头部及其相应损失等流行设计。

- 这意味着当前的检索结果不能明确地得出结论,即是否存在一个转折点,超过该点后继续增大训练视频的规模带来的好处会减少。

-

数据规模的影响与未来研究:

- 这些发现总体上表明,增强预训练数据的规模可以提高学习到的表示的可转移性。

- 然而,有关这些检索实验的更多探索是必要的,尤其是关于数据规模增加对性能提升影响的长期趋势和潜在的饱和点。

这些观察结果强调了在准备和使用大规模视频数据集进行模型预训练时需要权衡的问题。尤其是在资源消耗和性能增益之间找到最佳平衡点,以及确定继续增加数据规模是否仍然有效,这些都是未来研究和实验设计中需要考虑的重要方面。此外,这也表明在模型设计中可能需要更多的创新,以充分利用大规模数据带来的潜在好处。

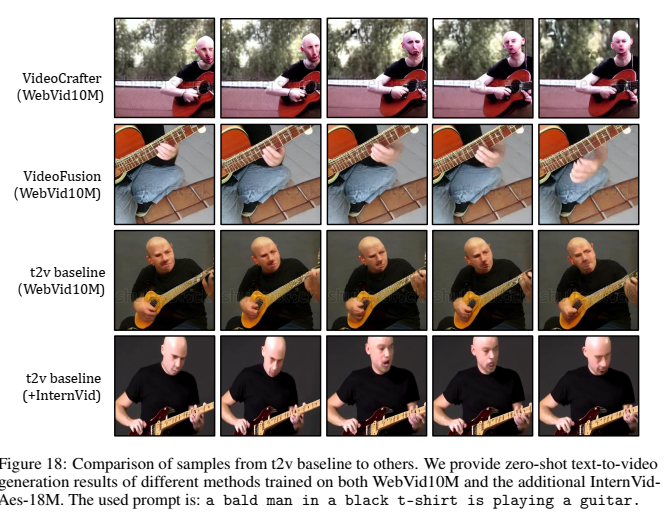

4.2、文本到视频生成

InternVid数据集提供高度对应的视频-文本对,改善现有的文本到视频生成模型。此外,通过引入一种基于潜在空间的时空建模方法,设立了一个视频生成的基线。以下是实验设置、评估方法和关键结果:

-

视频生成基线的建立:

- 使用开源的文本到图像扩散模型【76】的潜在空间,扩展了时空建模,以建立视频生成基线。

- 这种方法利用了两种设置进行训练:一种使用WebVid10M【6】,另一种在WebVid10M的基础上额外使用InternVid-Aesthetics-18M。InternVid-Aesthetics-18M是InternVid的一个子集,包含美学评分至少为4的剪辑。

-

量化和质量评估:

- 进行了量化(表7)和质量(图18)评估来展示InternVid在视频生成任务中的有效性。

- 量化评估中,采用了零样本文本到视频的实验方法,随机抽样自UCF-101数据集2020个视频和MSRVTT数据集2990个视频。

- 按照【77】的协议,报告了CLIPSIM、IS、FID和FVD等指标。

-

实验结果:

- 表7中观察到,仅使用WebVid10M训练的文本到视频(t2v)基线在IS、FID和CLIPSIM指标上表现不佳。

- 然而,加入InternVid-Aesthetics-18M后,t2v基线在这些指标上显示出显著改善,并且在很大程度上超过了其他方法。

- 图18中,可以看到使用WebVid10M和InternVid-Aesthetics-18M的t2v基线在视觉质量和时间连贯性方面显著优于其他方法。

- 值得注意的是,使用InternVid的t2v基线不包含水印,这解决了WebVid10M中存在的数据偏差问题。

4.3、以视频为中心的对话系统

受最近以视觉为中心的对话系统[10,78,79]的启发,我们将预训练的ViCLIP(与InternetVid)集成到VideoChat[10]中,以展示我们的数据和模型如何为多模式对话方法提供有效的视频建模能力。在实现中,我们几乎继承了所有VideoChat Embed的设计,只是用我们的ViCLIP(在InternetVid上训练)取代了它的视觉编码器。我们在空间理解(图10)、动作识别(图11)、时间理解(图12)、视频推理(图13)和视频创意(图14)任务中评估了VideoChat ViCLIP。我们的定性评估证明了其良好的视频到文本功能,这表明其在进一步改进视频字幕方面有着巨大的潜力。

5、结论

我们的数据集InternVid是为专注于视频的多模式研究(包括理解和生成)而设计的。它由来自700万个高分辨率(720P)YouTube视频的超过2.3亿个视频片段组成。我们使用具有多尺度方法的现有模型来生成片段级描述。我们的研究证实了字幕的功效,大量的视频文本数据能够实现跨模式学习和大规模的文本到视频生成。通过使用我们的数据进行训练,我们使用ViT-L开发了视频文本表示基线ViCLIP,并简要分析了数据量表如何影响学习的跨模态嵌入。除了感知任务外,我们还表明,当使用基于美学的片段子集时,InternVid可以提高文本到视频的生成性能分数。凭借其数据、注释、元数据和计算分数,我们相信InternVid可以推动各种研究和应用。

本文介绍了InternVid,一个基于视频的大型多模态数据集,旨在提升视频文本对应性和多模态理解。通过使用大型语言模型生成多尺度视频字幕,确保了视频和文本的高度相关性。此外,提出了视频语言模型ViCLIP,展示了在视频识别、视频检索和对话系统中的优秀性能。数据集的多样性和高质量视频字幕对于推动视频相关的多模态理解和生成任务具有重要意义。

本文介绍了InternVid,一个基于视频的大型多模态数据集,旨在提升视频文本对应性和多模态理解。通过使用大型语言模型生成多尺度视频字幕,确保了视频和文本的高度相关性。此外,提出了视频语言模型ViCLIP,展示了在视频识别、视频检索和对话系统中的优秀性能。数据集的多样性和高质量视频字幕对于推动视频相关的多模态理解和生成任务具有重要意义。

3244

3244

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?