一,安装jdk

创建目录

输入:mkdir /usr/lib/jvm

拷贝下载好的jdk放入

![]()

解压

![]()

修改环境变量

![]()

在文件最后加入:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_171

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=$JAVA_HOME/lib:$CLASSPATH

使配置文件生效

输入:source /etc/profile

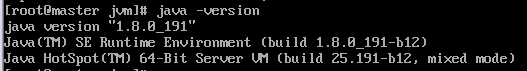

查看java版本

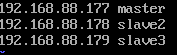

二,修改hosts文件

三台机器都需要修改

输入:vi /etc/hosts

文件后添加如下:

三,hadoop配置

首先登陆192.168.88.177,进行配置,配置完成后需要再将文件拷贝到另外两台机器

(1)复制文件到 /opt文件夹下

解压hadoop

![]()

(2)新建临时文件tmp、tmp/dfs、tmp/dfs/data和tmp/dfs/name。用于存放datanode和namenode信息

![]()

![]()

![]()

![]()

![]()

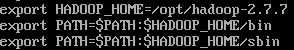

(3)修改环境变量

![]()

在文件后面添加

(4)进入hadoop文件夹进行配置

![]()

修改hadoop环境变量

![]()

修改如下

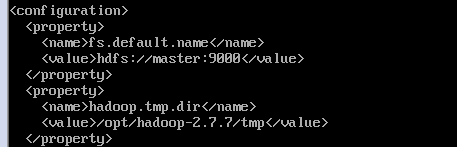

(5)修改core-site.xml文件

![]()

修改如下:

(6)修改hdfs-site.xml文件

![]()

修改如下:

(7)修改mapred-site.xml

首先复制:

cp mapred-site.xml.template mapred-site.xml

然后,进入修改

![]()

修改如下:

(8)修改yarn-site.xml文件

![]()

修改如下:

(9)修改slaves文件

![]()

修改如下:

![]()

(10)拷贝修改到另外两台机器

拷贝配置好的hadoop

![]()

拷贝配置好的环境变量

![]()

(11)格式化HDFS

登陆192.168.88.178,执行

![]()

格式化HDFS信息复制到192.168.88.179

![]()

(12)启动HDFS

![]()

(13)启动yarn

![]()

(14)检查hadoop搭建结果

在浏览器输入http://192.168.88.177:50070 可以得到HDFS管理界面

输入http://192.168.88.177:8088/,可以得到hadoop集群管理界面:

至此,hadoop平台搭建完毕。

376

376

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?