随着城市化的进程不断加快,房地产市场已成为现代社会中最重要的经济领域之一,房价信息也成为人们关注的焦点。

本文将介绍如何使用Python爬虫技术来获取最新的兰州房价信息。

一、爬虫原理

爬虫本质上是一种网络爬行技术,通过模拟网络浏览器的行为,自动抓取网页信息,并进行数据处理。具体而言,爬虫的工作流程如下:

-

发送请求:使用HTTP协议向目标网站发送请求,获取指定页面的HTML代码;

-

解析HTML代码:使用HTML解析器对HTML代码进行解析,提取出需要的数据;

-

存储数据:将获取到的数据存储到本地数据库或文件中,以备后续分析使用。

二、准备工作

在开始编写爬虫之前,我们需要先安装必要的Python库:

-

requests:用于向网站发送HTTP请求,获取HTML代码;

-

BeautifulSoup:用于解析HTML代码,提取需要的数据;

-

pandas:用于数据清洗和存储。

您可以通过以下命令来安装这些库:

pip install requests

pip install beautifulsoup4

pip install pandas

三、爬虫实现

- 获取网页内容

首先,我们需要找到兰州房价信息所在的网站。通过搜索引擎可以找到兰州房价网站,该网站的地址为http://www.lzfcw.com/。

接下来,我们需要使用requests库中的get()方法向该网站发送请求,获取HTML代码。代码如下:

import requests

url = 'http://www.lzfcw.com/'

response = requests.get(url)

html = response.text

- 解析HTML代码

得到HTML代码后,我们需要使用BeautifulSoup库对其进行解析,提取所需的数据。在解析之前,我们需要先查看网页源代码,确定需要提取的数据所在的HTML标签。

通过观察源代码,我们发现所有房价信息都在class为“fjlist”的div标签中,每条房价信息又分别在class为“fjinfo”的div标签中。

因此,我们可以使用BeautifulSoup库的find_all()方法来查找所有“fjinfo”标签,并依次提取每个标签中的内容,代码如下:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

fjlist = soup.find_all('div', class_='fjlist')

for fj in fjlist:

fjinfo = fj.find_all('div', class_='fjinfo')

for info in fjinfo:

# 提取房价信息

- 提取数据并存储

在提取房价信息时,我们需要分别提取房屋名称、所在区域、总价、单价、面积等数据。具体而言,我们可以使用BeautifulSoup库中的string属性来获取标签中的文本内容。

另外,为了方便后续的数据分析,我们还需要将提取到的数据存储到本地文件中。

这里我们使用pandas库中的DataFrame数据结构来存储数据,并使用to_csv()方法将其保存为CSV文件。代码如下:

import pandas as pd

# 存储房价信息的列表

data = []

for fj in fjlist:

fjinfo = fj.find_all('div', class_='fjinfo')

for info in fjinfo:

# 提取房价信息

name = info.find('h4').string

area = info.find('p', class_='area').string.strip()

price = info.find('p', class_='price').string.strip()

unitprice = info.find('p', class_='unitprice').string.strip()

# 将数据存储到data列表中

data.append([name, area, price, unitprice])

# 将data列表转换为DataFrame对象,并保存为CSV文件

df = pd.DataFrame(data, columns=['name', 'area', 'price', 'unitprice'])

df.to_csv('兰州房价信息.csv', index=False, encoding='utf-8')

四、完整代码

最终的爬虫代码如下:

import requests

from bs4 import BeautifulSoup

import pandas as pd

url = 'http://www.lzfcw.com/'

response = requests.get(url)

html = response.text

soup = BeautifulSoup(html, 'html.parser')

fjlist = soup.find_all('div', class_='fjlist')

data = []

for fj in fjlist:

fjinfo = fj.find_all('div', class_='fjinfo')

for info in fjinfo:

name = info.find('h4').string

area = info.find('p', class_='area').string.strip()

price = info.find('p', class_='price').string.strip()

unitprice = info.find('p', class_='unitprice').string.strip()

data.append([name, area, price, unitprice])

df = pd.DataFrame(data, columns=['name', 'area', 'price', 'unitprice'])

df.to_csv('兰州房价信息.csv', index=False, encoding='utf-8')

五、总结

本文介绍了如何使用Python爬虫技术来获取最新的兰州房价信息。通过学习本文的内容,你可以了解到爬虫的基本原理和流程,掌握如何使用Python库来实现简单的爬虫程序。

并将爬取到的数据存储到本地文件中。希望这篇文章能够帮助你更好地理解爬虫技术的应用。

关于Python学习指南

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你,干货内容包括:

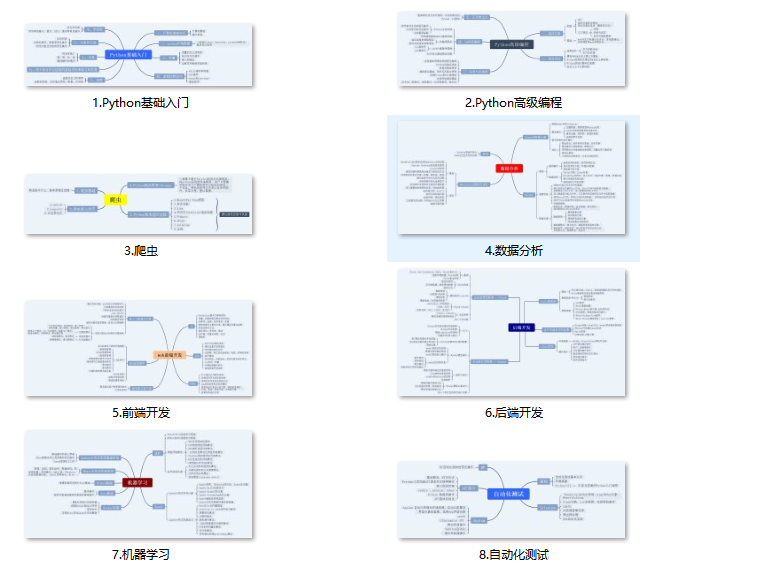

👉Python所有方向的学习路线👈

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python学习开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

👉Python入门学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

👉Python实战练手案例&源码👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉全套PDF电子书👈

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

👉Python大厂面试资料👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

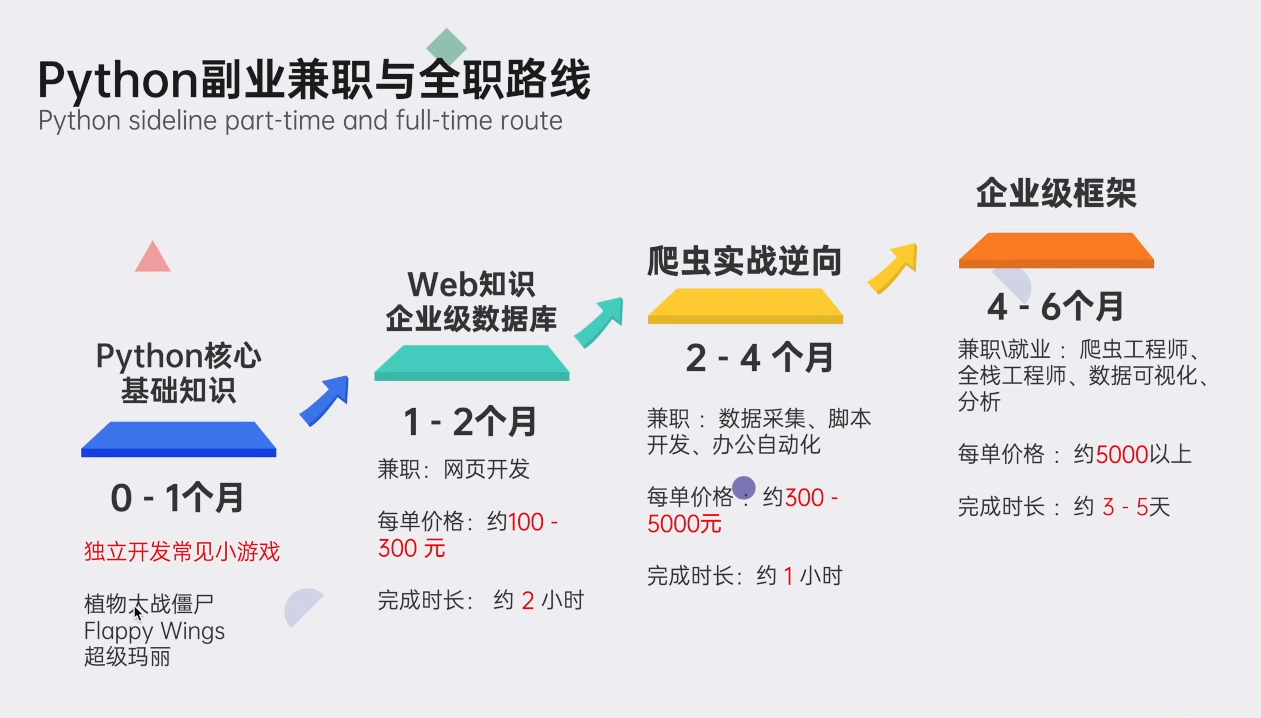

👉Python副业兼职学习路线👈

👉 这份完整版的Python全套学习资料已经上传,朋友们如果需要可以扫描下方CSDN官方认证二维码或者点击链接免费领取【保证100%免费】

读者福利:CSDN大礼包:《Python小白从入门到精通全套学习资料》免费分享 安全链接免费领取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?