参数初始化方案的影响:

①对保持数值稳定性⾄关重要

②选择哪个函数以及如何初始化参数可以决定优化算法收敛的速度有多快。糟糕选择可能会导致在训练时遇到梯度爆炸或梯度消失。

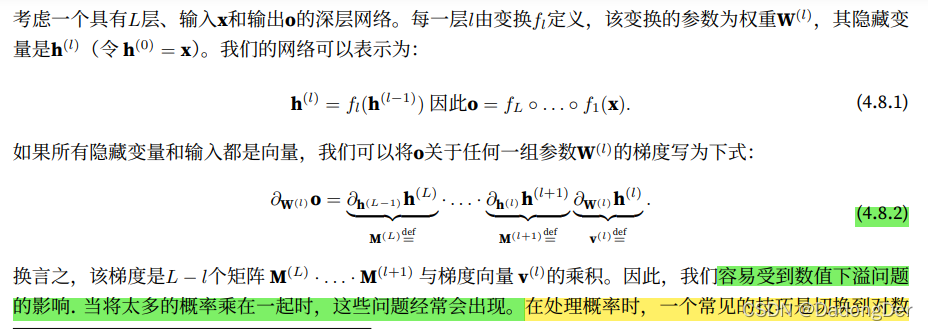

4.8.1 梯度消失与梯度下降

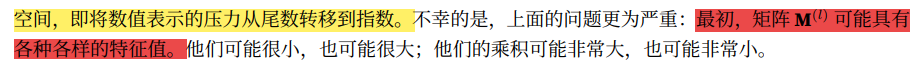

不稳定梯度的影响:①数值表示 ②优化算法的稳定性

(1)梯度消失

import torch

import matplotlib.pyplot as plt

x = torch.arange(-8.0, 8.0, 0.1, requires_grad=True)

y = torch.sigmoid(x)

# y.backward(torch.ones_like(x))

y.sum().backward() # 相同写法 转化标量

plt.plot(x.detach().numpy(), y.detach().numpy(), label="sigmoid")

plt.plot(x.detach().numpy(), x.grad.numpy(), linestyle="--", label="gradient")

plt.legend()

plt.show()

sigmoid函数带来的隐患和麻烦

当sigmoid函数的输⼊很⼤或是很小时,它的梯度都会消失。

当反向传播通过许多层时,除⾮在刚刚好的地⽅,这些地⽅sigmoid函数的输⼊接近于零,否则整个乘积的梯度可能会消失。

当⽹络有很多层时,除⾮我们很小⼼,否则在某⼀层可能会切断梯度。

更稳定的ReLU系列函数已经成为从业者的默认选择(虽然在神经科学的⻆度看起来不太合理)。

(2)梯度爆炸

没有机会让梯度下降优化器收敛

import torch

import matplotlib.pyplot as plt

M = torch.normal(0, 1, size=(4, 4))

print('A single matrix\n', M)

for i in range(100):

M = torch.mm(M, torch.normal(0, 1, size=(4, 4)))

print('after multiplying 100 matrices\n', M)

A single matrix

tensor([[ 2.0005, 0.8607, 0.6556, -0.0823],

[-0.8055, -0.6150, -1.6246, -0.6833],

[-0.3178, -0.2069, -0.7180, 0.1519],

[ 0.9175, 1.1673, 1.1775, -1.0297]])

after multiplying 100 matrices

tensor([[-1.7179e+22, -2.3576e+22, -2.2353e+22, 5.4486e+22],

[-1.7411e+23, -2.3894e+23, -2.2655e+23, 5.5222e+23],

[-2.5623e+22, -3.5164e+22, -3.3339e+22, 8.1266e+22],

[ 1.1527e+23, 1.5819e+23, 1.4998e+23, -3.6558e+23]])

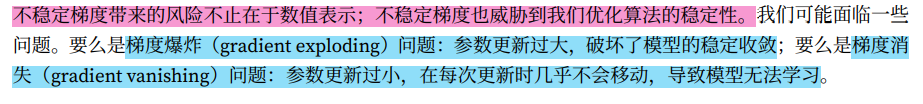

(3)参数化所固有的对称性

虽然小批量随机梯度下降不会打破这种对称性,但暂退法正则化可以。

4.8.2 参数初始化

解决(或至少减轻)上述问题的⼀种⽅法是进行参数初始化,优化期间的注意和适当的正则化也可以进⼀步提高稳定性。

小结

• 梯度消失和梯度爆炸是深度⽹络中常⻅的问题。在参数初始化时需要⾮常小⼼,以确保梯度和参数可

以得到很好的控制。

• 需要⽤启发式的初始化⽅法来确保初始梯度既不太⼤也不太小。

• ReLU激活函数缓解了梯度消失问题,这样可以加速收敛。

• 随机初始化是保证在进⾏优化前打破对称性的关键。

• Xavier初始化表明,对于每⼀层,输出的⽅差不受输⼊数量的影响,任何梯度的⽅差不受输出数量的影

响。

2611

2611

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?