先贴一个整体流程图:

Abstract

发现问题:SOTA的跟踪器变得越来越“重”和“昂贵”,限制了其在资源有限的应用上的部署。

本文做法:本文提出LightTrack,使用NAS(神经架构搜索)以设计更轻量级和有效的目标跟踪器。

实验结果:相比手工设计的跟踪器,性能更高且Flops和参数量更少。此外,当部署在资源有效的移动芯片组,如高通骁龙845时,LightTrack运行更快。其填补了目标跟踪领域在学术模型和工业部署间的空缺。

1. Introduction

跟踪背景:目标跟踪是计算机视觉领域中仍然最具挑战性的问题之一。在过去几年中,得益于深度学习的星期,目标跟踪得到了巨大得进展。

现有问题:但同时,跟踪模型也变得越来越“重”和“昂贵”。比如,SiamRPN++和Ocean用了7.1G+11.2M和20.3G+25.9M的Flops和参数量,其比SiamFC(2.7G+2.3M)要复杂得多。这样巨大的模型会阻止跟踪模型在现实应用上部署,如无人机、工业机器人和驾驶辅助系统等。

现有解决模型复杂的方法:1. 模型压缩。包括剪枝、量化等,但由于信息损失他们不可避免地会引入不可忽略的性能下降。2. 紧凑的模型设计。手动设计紧凑且高效的模型强烈依赖于人类的经验和专业知识。

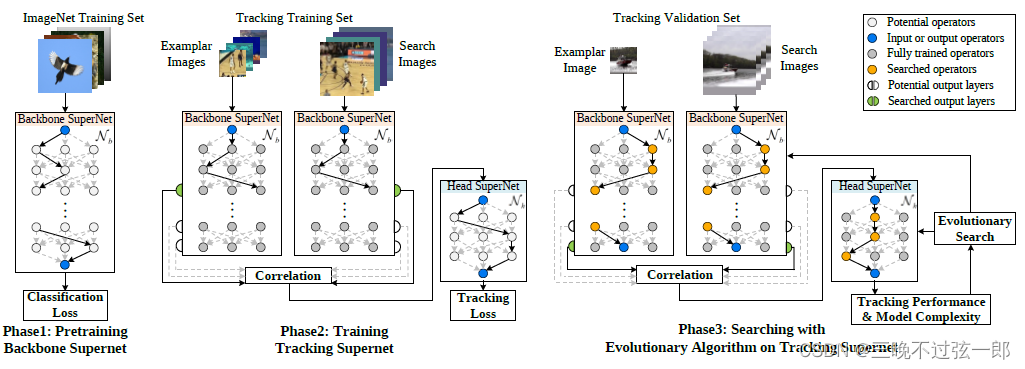

本文做法:基于最近兴起的one-shot NAS,本文提出一种专用于目标跟踪的搜索算法,LightTrack。将所有可能的架构编码到backbone超网和head超网中。其中,backbone超网在ImageNet上预训练并用跟踪数据微调,head超网直接在跟踪数据上训练。超网仅训练一次,然后每个候选网络直接从超网上继承其权重。架构搜索在训练好的超网上进行,使用跟踪精度和模型复杂度作为监督信号。另外,为了减少模型复杂度,本文设计了一个包含轻量级building blocks的搜索空间,如深度可分离卷积,反残差结构等。这样的搜索空间使得one-shot NAS可以搜索到更紧凑的网络架构,在跟踪性能和计算效率之间达到平衡。

实验结果:在Section 5中介绍。

本文贡献:

- 首次提出了对目标跟踪的网络结构自动设计;

- 设计了一个轻量级的搜索空间和专用于跟踪的搜索pipeline

2. Related Work

Object Tracking: 最近,Siamese跟踪器在目标跟踪领域十分流行。其先驱工作包括SiamFC和SINT,后来大量的工作follow这2个工作进行,可以将其分为3大类:

- more precise box estimation: SiamRPN, SiamFC++利用anchor-based和anchor-free机制用于边界框估计,其极大提升了定位精度;

- more powerful backbone: SiamRPN++, Ocean采用ResNet50而不是AlexNet作为backbone来增强特征表达能力;

- online update: ATOM, DiMP, ROAM采用更新实现更好的性能。

但是这些方法带来了许多额外的计算负担和内存要求。总之,现在还缺乏一些用于在模型精度和复杂度之间平衡的研究。

Neural Architecture Search: 早期的NAS用强化学习或者进化算法来搜索网络,他们需要从头训练上千个候选架构,导致了不可接受的计算负担。最近的工作用one-shot权重共享策略来节约搜索代价,其关键思想是训练一个参数化的超网,然后在子网间共享权重。代表性算法:1. single-path with uniform sampling,其在每一个iteration仅采样一个随机路径并用one batch data来训练该路径。一旦训练过程完成,子网用共享权重排序。2. differentiable方法,其不是搜索一个离散集合的候选架构,其松弛搜索空间至连续空间,因此可以用梯度下降方法来搜索。

本文和DetNAS的差异:本文受到DetNAS启发,但和DetNAS有3点不同。

| 差异 | DetNAS | LightTrack |

| 研究任务不同 | 目标检测 | 目标跟踪 |

| 搜索范围不同 | 只搜索backbone,固定head。可能导致backbone是次优解 | 同时搜索backbone和head |

| 搜索空间不同 | —— | 专用于目标跟踪的轻量级搜索空间 |

3. Preliminaries on One-shot NAS

one-shot NAS的基本概念。(这里不做详细介绍,具体请看论文原文。)

为了简便,本文采用了single-path with uniform sampling,也就是each batch仅采用一个随机路径来更新该路径的权重。

4. LightTrack

4.1 Tracking via One-shot NAS

本节介绍了专用于跟踪任务的one-shot NAS的新范式,即公式化定义。

4.2 Search Space

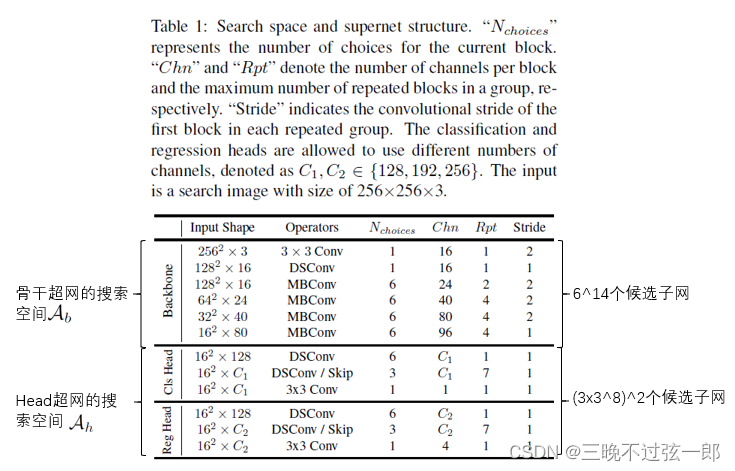

在搭建骨干超网和head超网时,为了节约计算量,其搭建的组件包括深度可分离卷积DSConv, mobile inverted bottleneck(MBConv) with squeeze-excitation module。

搭建好的骨干超网和head超网如下所示:

骨干超网的哪一层的特征更适合用于目标跟踪呢?:本文在搜索空间中加入了一个新的维度,让one-shot方法自己决定输出哪一层的特征。具体地,在超网训练阶段,从骨干最后8个block中随机挑选一层的输出作为提取的特征。

设计的搜索空间的优势:在该搜索空间中,其网络结构的flops和参数量的范围分别分布在[208M, 1.5G]和[0.2M, 5.4G]之间。这样的搜索空间本身比手工设计的网络就更轻量化的多,因此更容易找到更简洁的网络架构。

4.3 Search Pipeline

分为3个阶段,细节如下图所示:

5. Experiments

5.1 Implementation Details

| 设置 | 8 Tesla V100 GPUs and a Xeon E5-2690 2.60GHz CPU |

| Search | 预训练Backbone:在ImageNet上预训练120epochs,SGD优化器,momentum=0.9, weight decay=4e-5, 初始lr=0.5 with linear annealing; 整体训练:训练数据Youtubb-BB, ImageNet VID, ImageNet DET, COCO, GOT-10k,30 epochs, 每个epoch用了6x10^5个图像对,SGD优化器,momentum=0.9, weight decay=1e-4。每个GPU有32个图像,mini-batch size=256. lr在前5个epochs从1e-2增加到到3e-2,剩余的epochs从3e-2减少到1e-4。在前10个epochs冻结骨干网络的学习率,并在剩余epochs将其lr设置为全局学习率的十分之一; 验证:GOT-10K的验证数据。 |

| Retrain | 重新训练EA搜索到的backbone 500epochs在ImageNet上。MSProp优化器,momentum=0.9, decay=0.9, weight decay=1e-5, dropout ratio=0.2, 初始lr=0.064 wth a warmup in 前3epochs和a cosine annealing。 在跟踪数据集上精调整体网络。 |

| Test | 和Ocean参数设置一样 |

5.2 Results and Comparisons

测试集:VOT-19, GOT-10K, TrackingNet, LaSOT

测试设备:

- Apple iphone 7 PLUS

- Huawei Nova 7 5G

- Xiaomi Mi 8

3种规模的LightTrack:

- Mobile, <=600M Flops, <=2M Params

- Large A, <=800M Flops, <=3M Params

- Large B, <=800M Flops, <=4M Params

1. VOT-19结果

2. GOT-10K结果

3. TrackingNet结果

3. TrackingNet结果

4. LaSOT结果

5. 推理速度对比

5.3 Ablation and Analysis

1. Component-wise Analysis

2. Impact of ImageNet Pre-training

3. Analysis of Searched Architecture

本文提出了一种名为LightTrack的新方法,通过神经架构搜索(NAS)来设计轻量级且高性能的目标跟踪器。相较于手动设计的跟踪器,LightTrack在保持高精度的同时,显著减少了Flops和参数量,适合资源有限的设备,如移动芯片组。实验表明,LightTrack在多个跟踪基准上表现出色,同时运行速度更快。

本文提出了一种名为LightTrack的新方法,通过神经架构搜索(NAS)来设计轻量级且高性能的目标跟踪器。相较于手动设计的跟踪器,LightTrack在保持高精度的同时,显著减少了Flops和参数量,适合资源有限的设备,如移动芯片组。实验表明,LightTrack在多个跟踪基准上表现出色,同时运行速度更快。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?