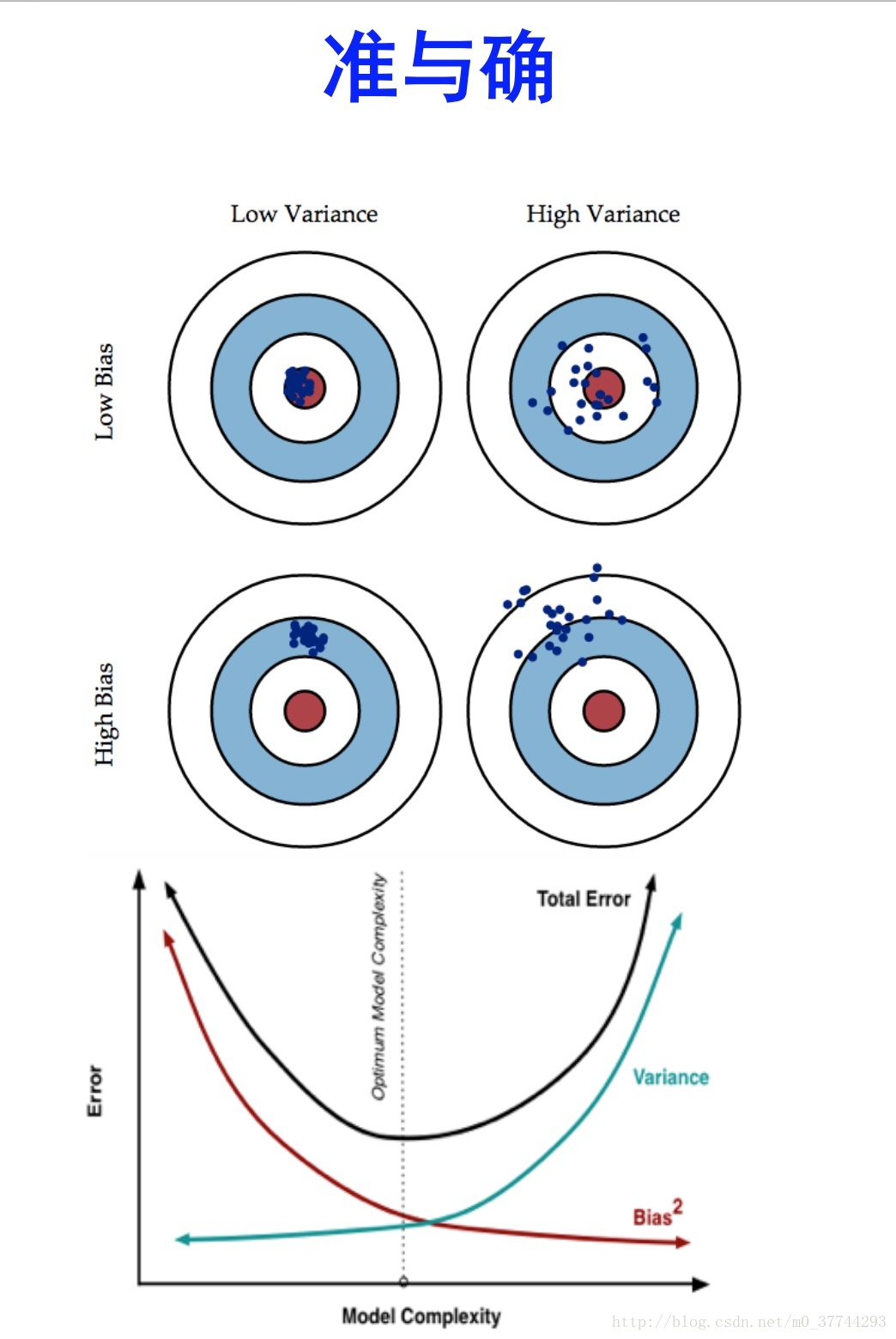

误差=偏差+方差

误差反映的是整个模型的准确度,偏差反映的是模型在样本上的输出与真实值之间的误差,即模型本身的精确度,方差反映的是模型每一次输出结果与模型输出期望之间的误差,即模型的稳定性。

在一个系统中,偏差和方差往往是不可兼得的,如果要降低模型的偏差,就会一定程度上提高模型的方差,反之亦然。造成这种现象的根本原因是,我们总是希望试图用有限训练样本去估计无限的真实数据。当我们更加相信这些数据的真实性,而忽视对模型的先验知识,就会尽量保证模型在训练样本上的准确度,这样可以减少模型的Bias。但是,这样学习到的模型,很可能会失去一定的泛化能力,从而造成过拟合,降低模型在真实数据上的表现,增加模型的不确定性。相反,如果更加相信我们对于模型的先验知识,在学习模型的过程中对模型增加更多的限制,就可以降低模型的variance,提高模型的稳定性,但也会使模型的Bias增大。

评论

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?

查看更多评论

添加红包