逻辑回归采用了回归分析的思想。然而是用来解决分类问题的模型,且通常解决的是二分类问题。逻辑回归是应用最为广泛的模型之一,如金融领域的风险评估、互联网广告点击预测等

从线性回归到逻辑回归

在线性回归中预测目标y是连续型,且可以写成样本x每一个特征的线性加权形式:y=wTx,其中w为参数向量。

假设我们现在解决的是二分类问题,即预测目标y此时取值为1或-1.为了能够利用回归的方法解决二分类问题,我们需要对线性回归的输出作改变,逻辑回归通过引入Logistic函数,将连续型的输出映射到(0,1)之间,Logistic函数:

σ

(

x

)

=

1

1

+

e

−

x

\sigma(x)=\frac{1}{1+e^{-x}}

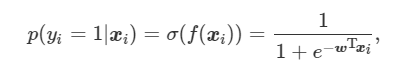

σ(x)=1+e−x1Logistic函数的导数可以用对应函数值进行表示,即σ’(x)=σ(x)(1-σ(x))。这样可以将任意实数映射到(0,1)之间。在逻辑回归中,这个输出可以解释为样本属于正类(y=1)的概率,记f(x)=wTx,则在逻辑回归模型中,样本xi的类别为正类的概率为

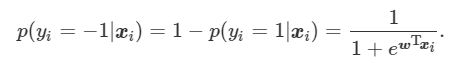

样本xi的类别为负类的概率为

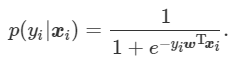

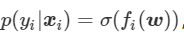

可以将上两式统一写成

这个式子定义了逻辑回归模型的基本形式,在线性回归的基础上,利用一个非线性函数,建立了二元预测目标与原始输入之间的关系。

参数估计

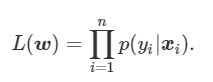

假设训练集为D={(x1,y1),(x2,y2),…,(xn,yn)}。我们可以使用极大似然法来估计逻辑回归模型的参数w。利用p(yi|xi)可以写成训练集的似然函数:

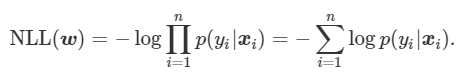

对L(w)取对数,得到训练集的负对数似然为

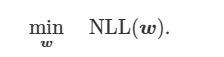

现在我们的目标变为,给定训练集D,求使得负对数似然函数取最小值的参数w,即求解如下优化问题:

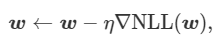

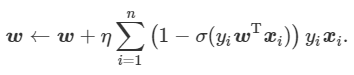

求目标函数最小值常用的方法是梯度下降法。在初始化参数后,梯度下降法使用下列迭代公式不断更新参数:

η为学习率,▽NLL(w)为目标函数对于参数w的梯度。

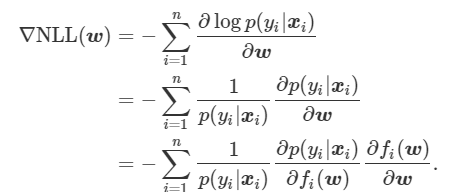

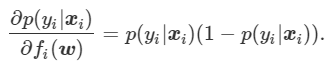

记fi(w)=yiwTxi,利用复合函数求导的链式法则,有:

观察上式,可以看出

所以

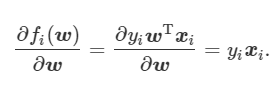

因为fi(w)=yiwTxi,得到

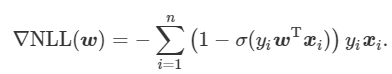

将上述两个式子代入▽NLL(w),

可以使用下面的迭代公式来估计逻辑回归模型的参数w:

1164

1164

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?