Hadoop安装与配置需要用到的软件和工具:

1.secureCRT(用来远程操作Linux)

2.notepad++(用来远程操控Linux的文件)

3.火狐浏览器(用来验证Linux是否能访问Hadoop)

4.Hadoop压缩包

准备好这些工具和软件后,下面让我们进行安装吧!

第一步:打开secureCRT并使其与我们的Linux系统连接上。目的是为了进行远程操作,使我们配置更加便捷。如下图即为连接成功:

第二步:在上传压缩包之前我们需要先建立两个文件夹(一个用来装压缩包,一个用来装解压后的文件),然后进入到software文件夹下使用命令:rz -Z 上传hadoop压缩包

第三步:解压Hadoop压缩包,使用命令:tar -zxvf hadoop-3.1.4.tar.gz -C /opt/module(#前面已创好得用来装解压后的文件的文件夹路径)

如下图即为解压完成:

第四步:配置文件,使用命令:vim /etc/profile

打开文件进入编辑状态后,在文件最后添加以下内容:

export HADOOP_HOME=/opt/module/hadoop-3.1.4(#解压过后的Hadoop文件的路径,可以通过克隆会话查看,操作见下图)

export PATH=

P

A

T

H

:

PATH:

PATH:HADOOP_HOME/bin:$HADOOP_HOME/sbin

到此呢,我们的文件配置完成,最后我们要保存并退出。按下 'esc’键 :wq 并回车。

第五步:我们要使文件生效,使用命令:source /etc/profile

第六步:这一步我们要打开里一个软件notepad++,按照以下步骤与我们的虚拟机连上

打开进入notepad++ ~点击插件找到nppftp(若没有需先下载,在插件管理搜索nppftp并安装) ~接着点击nppftp中的show nppftp Window ~然后在右边弹出的界面中找到设置并点击出现如下界面

按照要求填完后点击关闭,接着点击第一个蓝色的小图标连接。出现如下界面:

第六步:我们要在根目录下找到以下五个文件并打开。

然后我们分别配置这五个文件:

1.core-site.xml文件 添加以下内容:

如下图修改完后一定要记得保存!

2.hadoop-env.sh文件

按下图修改即可:

3.hdfs-site.xml文件

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

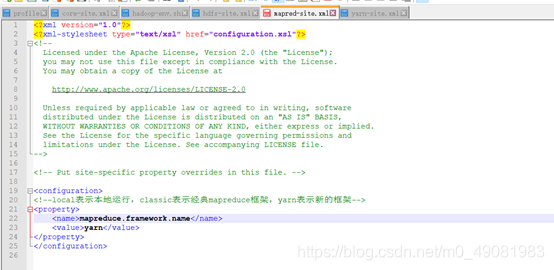

4.mapred-site.xml文件

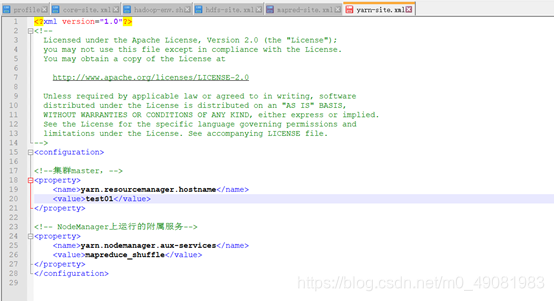

mapreduce.framework.name yarn 5.yarn-site.xml文件

yarn.resourcemanager.hostname venn05 #venn05改为你自己的主机名(***但是一定要能在cmd中ping到你的主机名***) yarn.nodemanager.aux-services mapreduce_shuffle 第七步:接着我们格式化一下hadoop,使用该命令:hdfs namenode -format

如下图即为格式化成功:

第八步:我们启动一下五个文件

第九步:使用命令:jps 查看一下Hadoop是否启动成功

很明显,我们的Hadoop已经启动成功啦!

最后一步:我们来验证一下我们的Linux是否能访问Hadoop界面 。但是在这之前我们要先把Linux的防火墙关闭,否则是进不去的哦!

好啦,现在我们已经看到了胜利的曙光。但是我们还差一小步

打开火狐浏览器在地址栏输入:http://ip:9879

咻!出来啦

到这,我们算是大功告成啦!

16万+

16万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?