RAG技术学习-3

3 RAG的框架

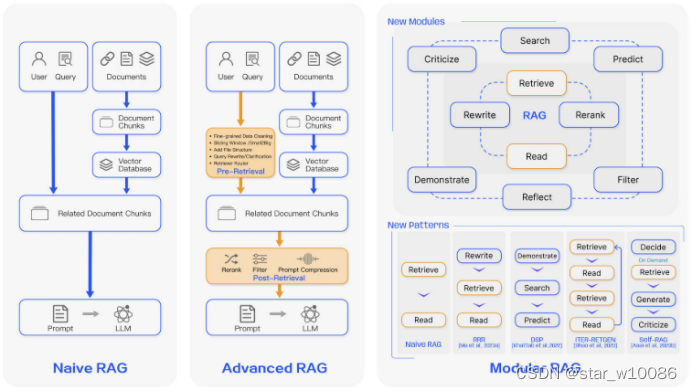

3.1 原始RAG(Naive RAG)

原始RAG是最早的研究范式,主要包括以下几个步骤:

- 建立索引:这一过程通常在离线状态下进行,包括数据清理、提取,将不同文件格式转换为纯文本,然后进行文本分块,并创建索引。

- 检索:使用相同的编码模型将用户输入转换为向量,计算问题嵌入和文档块嵌入之间的相似度,选择相似度最高的前K个文档块作为当前问题的增强上下文信息。

- 生成:将给定的问题和相关文档合并为新的提示,然后由大型语言模型基于提供的信息回答问题。如果有历史对话信息,也可以合并到提示中,用于多轮对话。

原始RAG面临的挑战包括检索质量问题、响应生成质量问题以及增强过程的挑战。

3.2 高级RAG(Advanced RAG)

高级RAG针对原始RAG的不足之处进行了有针对性的改进。这些改进涉及检索生成的质量、索引的优化、检索过程的优化等多个方面。

3.2.1 预检索过程

优化数据索引,包括增加索引数据的细粒度、优化索引结构、添加元数据、对齐优化和混合检索等五个主要策略。

3.2.2 检索过程优化

对检索到的信息进行重新排序,将最相关的信息放置在提示的边缘,以及通过压缩不相关的上下文、突出关键段落和减少总体上下文长度来提高RAG性能。

3.2.3 高级RAG的特点

通过先进的索引方法、更精细的检索策略和有效的后处理方法来优化RAG的性能。它采用不同的检索技术组合,适应不同的查询类型和信息需求,确保一致地检索到最相关和上下文丰富的信息。高级RAG还包括对嵌入模型的微调,以提高检索内容的相关性,并使用动态嵌入技术以更好地处理上下文变化。

3.2.4 RAG管道优化

探索混合搜索、递归检索和查询引擎、StepBack-prompt方法、子查询以及HyDE等方法,以提高RAG系统的效率和信息质量。

3.3 模块化RAG(Modular RAG)

模块化RAG结构打破了传统的原始RAG框架,提供了更大的多样性和整个过程的灵活性。它整合了各种方法来扩展功能模块,例如在相似性检索中加入搜索模块,以及在检索器中应用微调方法。此外,特定问题的出现促使重构的RAG模块和迭代方法的出现。模块化RAG范式正成为RAG领域的主流,允许采用序列化管道或跨多个模块的端到端训练方法。

3.3.1 新模块

包括搜索模块、记忆模块、额外生成模块、任务适应模块、对齐模块和验证模块等。

- 搜索模块:与原始/高级RAG中的查询和语料库之间的相似性检索不同,搜索模块针对特定场景,将直接搜索引入过程中,使用由LLM生成的代码、查询语言(如SQL、Cypher)或其他自定义工具。

- 记忆模块:利用LLM自身的记忆能力来指导检索。原则是找到与当前输入最相似的记忆。例如,Self-mem迭代地使用一个检索增强生成器来创建一个无限的记忆池,结合“原始问题”和“对偶问题”。

- 额外生成模块:在检索到的内容中,冗余和噪声是常见问题。额外生成模块利用LLM生成所需的上下文,而不是直接从数据源检索。

- 任务适应模块:专注于转换RAG以适应各种下游任务。例如,UPRISE自动从预构建的数据池中检索给定零样本任务输入的提示,增强跨任务和模型的通用性。

- 对齐模块:查询和文本之间的对齐一直是影响RAG有效性的关键问题。在模块化RAG时代,研究人员发现,在检索器中添加一个可训练的Adapter模块可以有效缓解对齐问题。

- 验证模块:在现实世界场景中,不能总保证检索到的信息是可靠的。检索到不相关的数据可能导致LLM出现幻觉。因此,在检索文档后可以引入额外的验证模块,以评估检索到的文档与查询之间的相关性,增强RAG的鲁棒性。

3.3.2 新模式

模块化RAG的组织方法具有灵活性,允许根据具体问题上下文替换或重新配置RAG过程中的模块。对于原始RAG而言,这种框架提供了适应性和丰富性。当前的研究主要探索两种组织范式,包括添加或替换模块以及调整模块之间的组织流程。

- 模块添加或替换策略:维持检索-阅读的结构,同时引入额外的模块来增强特定功能。

- 模块间流程调整:强调增强语言模型与检索模型之间的互动。

相关文章

参考文献

[1] Yunfan G, Yun X, Xinyu G, Kangxiang J, Jinliu P, Yuxi B, Yi D, Jiawei S, Haofen W, et al. Retrieval-Augmented Generation for Large Language Models: A Survey[J], CoRR, 2023, abs/2312.10997

[2] Deng C, Yan W, Lemao L, Shuming S, et al. Recent Advances in Retrieval-Augmented Text Generation[C], Annual International ACM SIGIR Conference on Research and Development in Information Retrieval, 2022: 3417–3419.

[3] Ruochen Z, Hailin C, Weishi W, Fangkai J, Do X L, Chengwei Q, Bosheng D, Xiaobao G, Minzhi L, Xingxuan L, Shafiq J, et al. Retrieving Multimodal Information for Augmented Generation: A Survey.[J], CoRR, 2023, abs/2303.10868: 4736-4756.

[4] Xin C, Di L, Xiuying C, Lemao L, Dongyan Z, Rui Y, et al. Lift Yourself Up: Retrieval-augmented Text Generation with Self Memory[J], CoRR, 2023, abs/2305.02437

[5] Zhihong S, Yeyun G, Yelong S, Minlie H, Nan D, Weizhu C, et al. Enhancing Retrieval-Augmented Large Language Models with Iterative Retrieval-Generation Synergy.[J], CoRR, 2023, abs/2305.15294: 9248-9274.

[6] Menglin X, Xuchao Z, Camille C, Guoqing Z, Saravan R, Victor R, et al. Hybrid Retrieval-Augmented Generation for Real-time Composition

Assistance[J], CoRR, 2023, abs/2308.04215

[7] Zachary L, Chenglu L, Wangda Z, Anoushka G, Owen H, Millie-Ellen P, Wanli X, et al. Retrieval-augmented Generation to Improve Math Question-Answering: Trade-offs Between Groundedness and Human Preference[J], CoRR, 2023, abs/2310.03184

本文详细介绍了RAG技术的三个主要版本:原始RAG、高级RAG和模块化RAG。高级RAG通过优化索引、检索过程和后处理方法提升了性能,而模块化RAG则提供了更大的灵活性和适应性,引入了搜索模块、记忆模块等新组件。

本文详细介绍了RAG技术的三个主要版本:原始RAG、高级RAG和模块化RAG。高级RAG通过优化索引、检索过程和后处理方法提升了性能,而模块化RAG则提供了更大的灵活性和适应性,引入了搜索模块、记忆模块等新组件。

1162

1162

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?