| 10.246.29.45 | sdb | sdc |

|---|---|---|

| 10.246.29.33 | sdb | sdc |

| 10.246.29.37 | sda | sdb |

服务端配置

1.配置yum源

2.安装gfs

注:bc-linux7的操作系统需要用用rpm安装6.0-61.el7版本的glusterfs,否则会有版本兼容等问题

rpm包在 jt-master-02:/gfs

yum -y install glusterfs glusterfs-server glusterfs-fuse

yum install -y glusterfs glusterfs-server glusterfs-fuse glusterfs-rdma

#开启服务

systemctl start glusterd.service

systemctl enable glusterd.service

systemctl status glusterd.service

#初始化节点 在45节点上执行

gluster peer probe 10.11.11.33

gluster peer probe 10.11.11.37

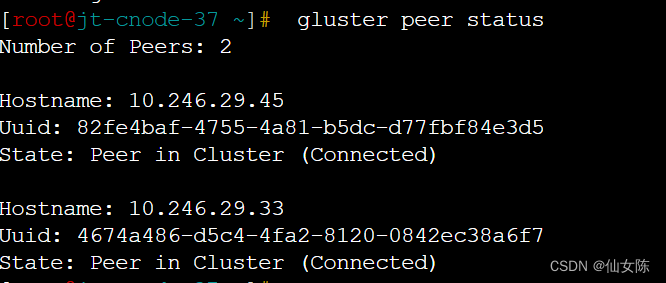

#在每个node节点上查看集群状态

gluster peer status

3.将节点加入存储(每个节点执行)

10.246.29.45

1 创建外接磁盘挂载目录并挂载

mkdir -p /gfs1 /gfs2

mkfs.xfs /dev/sdb

mkfs.xfs /dev/sdc

mount /dev/sdb /gfs1

mount /dev/sdc /gfs2

df -Th | grep gfs

2 获取UUID,再配置/etc/fstab

blkid /dev/sdb

blkid /dav/sdc

##把下面内容加入fstab文件中

vim /etc/fstab

UUID=4..........b4 /gfs xfs defaults 0 0

UUID=3..........a9 /gfs xfs defaults 0 0

mount -a #检查fstab配置的是否有问题

10.246.29.33

1 创建外接磁盘挂载目录并挂载(

mkdir -p /gfs1 /gfs2

mkfs.xfs /dev/sdb

mkfs.xfs /dev/sdc

mount /dev/sdb /gfs1

mount /dev/sdc /gfs2

df -Th | grep gfs

2 获取UUID,再配置/etc/fstab

blkid /dev/sdb

blkid /dav/sdc

##把下面内容加入fstab文件中

vim /etc/fstab

UUID=4..........b4 /gfs xfs defaults 0 0

UUID=3..........a9 /gfs xfs defaults 0 0

mount -a #检查fstab配置的是否有问题

10.246.29.37

1 创建外接磁盘挂载目录并挂载

mkdir -p /gfs1 /gfs2

mkfs.xfs /dev/sda

mkfs.xfs /dev/sdb

mount /dev/sda /gfs1

mount /dev/sdb /gfs2

df -Th | grep gfs

2 获取UUID,再配置/etc/fstab

blkid /dev/sda

blkid /dav/sdb

##把下面内容加入fstab文件中

vim /etc/fstab

UUID=4..........b4 /gfs xfs defaults 0 0

UUID=3..........a9 /gfs xfs defaults 0 0

mount -a #检查fstab配置的是否有问题

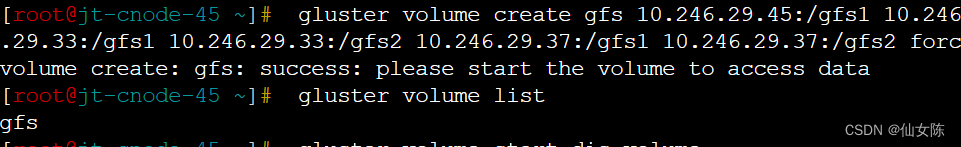

4.创建名为gfs的分布式卷

#没有指定类型,默认创建的是分布式卷

gluster volume create gfs 10.246.29.45:/gfs1 10.246.29.45:/gfs2 10.246.29.33:/gfs1 10.246.29.33:/gfs2 10.246.29.37:/gfs1 10.246.29.37:/gfs2 force

#查看卷列表

gluster volume list

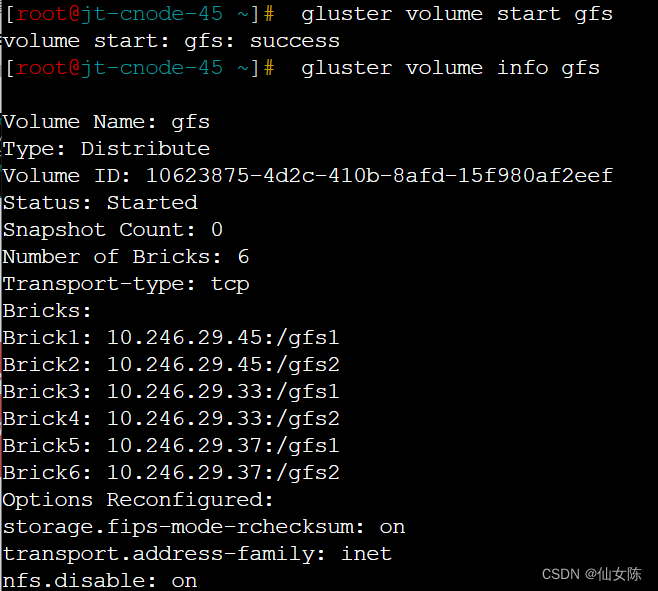

#启动新建分布式卷

gluster volume start gfs

# 查看所有卷的信息

gluster volume info

#查看gfs卷的信息

gluster volume info gfs

# 查看所有卷的状态

gluster volume status

# 停止一个卷

gluster volume stop gfs

# 删除一个卷,注意:删除卷时,需要先停止卷,且信任池中不能有主机处于宕机状态,否则删除不成功

gluster volume delete gfs

#设置卷的访问控制

#仅拒绝192.168.208.100访问gfs卷

gluster volume set gfs auth.deny 192.168.208.100

#仅允许

gluster volume set gfs auth.allow 192.168.208.*

客户端配置(和服务端版本需要一致)

旧集群的操作系统都是bc-linux7

bc-linux7的操作系统需要用用rpm安装6.0-61.el7版本的glusterfs,小于6版本会有版本兼容等问题,rpm包在 jt-master-02:/gfs

1.1 rpm安装

playbook批量安装gfs客户端

---

- name: copy myfile to other machine

hosts: all-nodes

tasks:

- name: copy directory

copy:

src: /root/gfs

dest: /root/

mode: 0755

- name: rpm安装GFS

command: rpm -ivh /root/gfs/*.rpm --force --nodeps

# ansible-playbook gfs.yaml

1.2 配置yum源安装

yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdma

3.创建挂载目录

mkdir -p /apps/sharedstorage/jtproduction-xxxx---bak

4.挂载Gluster文件系统

临时挂载

mount.glusterfs 10.246.29.45:gfs /apps/sharedstorage/jtproduction-xxxx---bak

永久挂载

vim /etc/fstab

10.246.29.45:gfs /apps/sharedstorage/jtproduction-xxxx---bak glusterfs defaults,_netdev 0 0

ansible实现批量挂载

ansible all-nodes -m command -a 'mount.glusterfs 10.246.29.45:gfs /apps/sharedstorage/jtproduction-xxxx---bak'

playbook实现永久挂载

---

- name: add to fatab

hosts: all-nodes

become: yes

tasks:

- name: Add entry to /etc/fstab

lineinfile:

path: /etc/fstab

line: "10.246.29.45:gfs/jt /apps/jt glusterfs defaults,_netdev 0 0"

become: yes

533

533

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?